Web-Frontend

Web-Frontend

js-Tutorial

js-Tutorial

Lassen Sie uns darüber sprechen, wie Sie mithilfe von Node einen einfachen Prozess- und Thread-Pool implementieren

Lassen Sie uns darüber sprechen, wie Sie mithilfe von Node einen einfachen Prozess- und Thread-Pool implementieren

Lassen Sie uns darüber sprechen, wie Sie mithilfe von Node einen einfachen Prozess- und Thread-Pool implementieren

I. 前言

本文论点主要面向 Node.js 开发语言

>> Show Me Code,目前代码正在 dev 分支,已完成单元测试,尚待测试所有场景。

>> 建议通读 Node.js 官方文档 -【不要阻塞事件循环】

Node.js 即服务端 Javascript,得益于宿主环境的不同,它拥有比在浏览器上更多的能力。比如:完整的文件系统访问权限、网络协议、套接字编程、进程和线程操作、C++ 插件源码级的支持、Buffer 二进制、Crypto 加密套件的天然支持。【相关教程推荐:nodejs视频教程】

Node.js 的是一门单线程的语言,它基于 V8 引擎开发,v8 在设计之初是在浏览器端对 JavaScript 语言的解析运行引擎,其最大的特点是单线程,这样的设计避免了一些多线程状态同步问题,使得其更轻量化易上手。

一、名词定义

1. 进程

学术上说,进程是一个具有一定独立功能的程序在一个数据集上的一次动态执行的过程,是操作系统进行资源分配和调度的一个独立单位,是应用程序运行的载体。我们这里将进程比喻为工厂的车间,它代表 CPU 所能处理的单个任务。任一时刻,CPU 总是运行一个进程,其他进程处于非运行状态。

进程具有以下特性:

- 进程是拥有资源的基本单位,资源分配给进程,同一进程的所有线程共享该进程的所有资源;

- 进程之间可以并发执行;

- 在创建或撤消进程时,系统都要为之分配和回收资源,与线程相比系统开销较大;

- 一个进程可以有多个线程,但至少有一个线程;

2. 线程

在早期的操作系统中并没有线程的概念,进程是能拥有资源和独立运行的最小单位,也是程序执行的最小单位。任务调度采用的是时间片轮转的抢占式调度方式,而进程是任务调度的最小单位,每个进程有各自独立的一块内存,使得各个进程之间内存地址相互隔离。

后来,随着计算机的发展,对 CPU 的要求越来越高,进程之间的切换开销较大,已经无法满足越来越复杂的程序的要求了。于是就发明了线程,线程是程序执行中一个单一的顺序控制流程,是程序执行流的最小单元。这里把线程比喻一个车间的工人,即一个车间可以允许由多个工人协同完成一个任务,即一个进程中可能包含多个线程。

线程具有以下特性:

- 线程作为调度和分配的基本单位;

- 多个线程之间也可并发执行;

- 线程是真正用来执行程序的,执行计算的;

- 线程不拥有系统资源,但可以访问隶属于进程的资源,一个线程只能属于一个进程;

Node.js 的多进程有助于充分利用 CPU 等资源,Node.js 的多线程提升了单进程上任务的并行处理能力。

在 Node.js 中,每个 worker 线程都有他自己的 V8 实例和事件循环机制 (Event Loop)。但是,和进程不同,workers 之间是可以共享内存的。

二、Node.js 异步机制

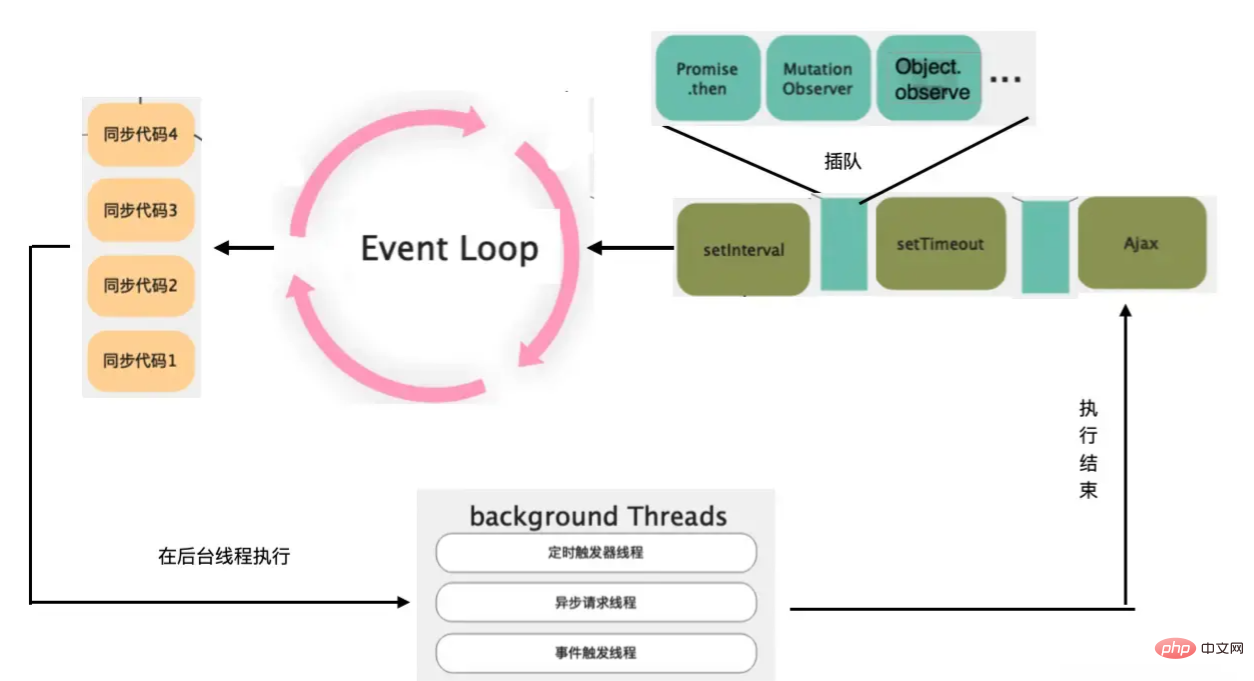

1. Node.js 内部线程池、异步机制以及宏任务优先级划分

Node.js 的单线程是指程序的主要执行线程是单线程,这个主线程同时也负责事件循环。而其实语言内部也会创建线程池来处理主线程程序的 网络 IO / 文件 IO / 定时器 等调用产生的异步任务。一个例子就是定时器 Timer 的实现:在 Node.js 中使用定时器时,Node.js 会开启一个定时器线程进行计时,计时结束时,定时器回调函数会被放入位于主线程的宏任务队列。当事件循环系统执行完主线程同步代码和当前阶段的所有微任务时,该回调任务最后再被取出执行。所以 Node.js 的定时器其实是不准确的,只能保证在预计时间时我们的回调任务被放入队列等待执行,而不是直接被执行。

Der Multithreading-Mechanismus in Kombination mit dem Ereignisschleifen-Ereignisschleifensystem von Node.js ermöglicht Entwicklern die Verwendung asynchroner Mechanismen in einem Thread, einschließlich Timer, E/A und Netzwerkanforderungen. Um jedoch einen äußerst reaktionsschnellen und leistungsstarken Server zu erreichen, priorisiert die Ereignisschleife von Node.js Makroaufgaben weiter.

Node.js Priorisierung zwischen Makroaufgaben: Timer > Umfrage >

- Timer-Rückruf: Wenn es um die Zeit geht, gilt: Je früher die Ausführung, desto genauer ist sie. Daher hat dies die höchste Priorität und ist leicht zu verstehen.

- Ausstehender Rückruf: Rückruf bei der Behandlung von Netzwerk-, E/A- und anderen Ausnahmen. Einige Unix-Systeme warten auf die Meldung von Fehlern und müssen daher behandelt werden.

- Poll Callback: Verarbeitet IO-Daten und Netzwerkverbindungen. Dies ist, was der Server hauptsächlich verarbeitet.

- Rückruf prüfen: Der Rückruf zum Ausführen von setImmediate. Die Besonderheit besteht darin, dass dieser unmittelbar nach der Ausführung des IO zurückgerufen werden kann.

- Rückruf schließen: Ein Rückruf zum Schließen von Ressourcen hat keine Auswirkungen darauf und hat die niedrigste Priorität.

Node.js-Optimierung und Aufteilung zwischen Mikrotasks: process.nextTick >

2. Ausführungszeitpunkt von Makroaufgaben und Mikroaufgaben in Node.js

Vor Node.js war die Ereignisschleife von Node.js nicht wie der Browser, der jeweils eine Makroaufgabe und dann alle Mikroaufgaben ausführt Führen Sie nach der Ausführung einer bestimmten Anzahl von Timer-Makrotasks alle Mikrotasks aus, führen Sie dann eine bestimmte Anzahl ausstehender Makrotasks aus und führen Sie dann alle Mikrotasks aus. Das Gleiche gilt für die verbleibenden Makrotasks „Abfragen“, „Prüfen“ und „Schließen“. Nach Knoten 11 wurde auf jede Makroaufgabe umgestellt, um alle Mikroaufgaben auszuführen.

Die Makroaufgaben von Node.js haben auch Prioritäten. Wenn die Ereignisschleife von Node.js alle Makroaufgaben mit der aktuellen Priorität ausführt, bevor die Makroaufgabe mit der nächsten Priorität ausgeführt wird, führt dies zum Auftreten von „Hunger“. Zustand. Wenn in einer bestimmten Phase zu viele Makrotasks vorhanden sind, wird die nächste Phase nie ausgeführt. Daher verfügt jede Art von Makrotask über einen Mechanismus zur Begrenzung der Anzahl der Ausführungen, und der Rest wird zur weiteren Ausführung an die nachfolgende Ereignisschleife übergeben .

Die endgültige Leistung besteht darin, eine bestimmte Anzahl von Timer-Makroaufgaben auszuführen, alle Mikroaufgaben zwischen den einzelnen Makroaufgaben auszuführen und dann eine bestimmte Anzahl von Makroaufgaben für ausstehende Rückrufe auszuführen und alle Mikroaufgaben zwischen den einzelnen Makroaufgaben auszuführen.

3. Multiprozess von Node.js

1. Verwenden Sie die Methode child_process, um einen Prozess manuell zu erstellen. Das Node.js-Programm bietet die Möglichkeit, untergeordnete Prozesse über das Modul child_process zu erzeugen die Erstellung mehrerer untergeordneter Prozesse. Methode:

spawn- Erstellen Sie einen neuen Prozess und die Ausführungsergebnisse werden in Form eines Streams zurückgegeben. Die Ergebnisdaten können nur über Ereignisse abgerufen werden, was mühsam zu bedienen ist.

const spawn = require('child_process').spawn; const ls = spawn('ls', ['-lh', '/usr']); ls.stdout.on('data', (data) => { console.log(`stdout: ${data}`); }); ls.stderr.on('data', (data) => { console.log(`stderr: ${data}`); }); ls.on('close', (code) => { console.log(`child process exited with code ${code}`); });Nach dem Login kopieren

- Erstellen Sie einen neuen Prozess und führen Sie eine ausführbare Datei entsprechend dem Dateinamen dahinter aus. Sie können Optionen einbringen und das Aufrufergebnis in Form eines Rückrufs zurückgeben viel bequemer.

execFile('/path/to/node', ['--version'], function(error, stdout, stderr){ if(error){ throw error; } console.log(stdout); });Nach dem Login kopieren

- Erstellt einen neuen Prozess, der Shell-Befehle direkt ausführen kann, wodurch die Ausführung von Shell-Befehlen vereinfacht wird und die Ausführungsergebnisse in Form von Rückrufen zurückgegeben werden.

exec('ls -al', function(error, stdout, stderr){ if(error) { console.error('error:' + error); return; } console.log('stdout:' + stdout); console.log('stderr:' + typeof stderr); });Nach dem Login kopieren

- Erstellen Sie einen neuen Prozess und führen Sie das Knotenprogramm aus. Nach der Erstellung wird die IPC-Kommunikation vom Hauptprozess zum untergeordneten Prozess automatisch aktiviert, was die meisten Ressourcen verbraucht.

-

Unter diesen ist Spawn die Basis aller Methoden, und die unterste Ebene von Exec ruft ExecFile auf.

var child = child_process.fork('./anotherSilentChild.js', { silent: true }); child.stdout.setEncoding('utf8'); child.stdout.on('data', function(data){ console.log(data); });Nach dem Login kopieren

2. Verwenden Sie die Cluster-Methode, um halbautomatisch einen Prozess zu erstellen

Das Folgende ist ein einfaches Beispiel für die Verwendung des Cluster-Moduls zum Erstellen eines http-Dienstclusters. Im Beispiel wird beim Erstellen eines Clusters dieselbe Js-Ausführungsdatei verwendet: cluster.isPrimary wird in der Datei verwendet, um zu bestimmen, ob sich die aktuelle Ausführungsumgebung im Hauptprozess oder in einem untergeordneten Prozess befindet Ist der Hauptprozess, wird die aktuelle Ausführungsdatei zum Erstellen einer untergeordneten Instanz verwendet. Wenn es sich um einen untergeordneten Prozess handelt, tritt sie in den Geschäftsverarbeitungsfluss des untergeordneten Prozesses ein. /*

简单示例:使用同一个 JS 执行文件创建子进程集群 Cluster

*/

const cluster = require('node:cluster');

const http = require('node:http');

const numCPUs = require('node:os').cpus().length;

const process = require('node:process');

if (cluster.isPrimary) {

console.log(`Primary ${process.pid} is running`);

// Fork workers.

for (let i = 0; i {

console.log(`worker ${worker.process.pid} died`);

});

} else {

// Workers can share any TCP connection

http.createServer((req, res) => {

res.writeHead(200);

res.end('hello world\n');

}).listen(8000);

console.log(`Worker ${process.pid} started`);

}Nach dem Login kopieren

/*

简单示例:使用同一个 JS 执行文件创建子进程集群 Cluster

*/

const cluster = require('node:cluster');

const http = require('node:http');

const numCPUs = require('node:os').cpus().length;

const process = require('node:process');

if (cluster.isPrimary) {

console.log(`Primary ${process.pid} is running`);

// Fork workers.

for (let i = 0; i {

console.log(`worker ${worker.process.pid} died`);

});

} else {

// Workers can share any TCP connection

http.createServer((req, res) => {

res.writeHead(200);

res.end('hello world\n');

}).listen(8000);

console.log(`Worker ${process.pid} started`);

}Cluster-Modul ermöglicht die Einrichtung eines Hauptprozesses und mehrerer Unterprozesse. Verwenden Sie child_process.fork(), um intern implizit Unterprozesse und den Hauptprozess zu erstellen überwacht und koordiniert die Teilprozesse. Cluster 模块创建一个 http 服务集群的简单示例。示例中创建 Cluster 时使用同一个 Js 执行文件,在文件内使用 cluster.isPrimary 判断当前执行环境是在主进程还是子进程,如果是主进程则使用当前执行文件创建子进程实例,如果时子进程则进入子进程的业务处理流程。

$: npm install -g pm2

Cluster 模块允许设立一个主进程和若干个子进程,使用 child_process.fork() 在内部隐式创建子进程,由主进程监控和协调子进程的运行。

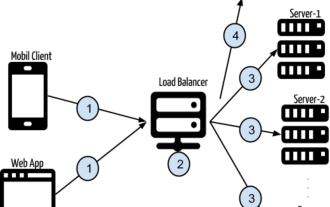

子进程之间采用进程间通信交换消息,Cluster 模块内置一个负载均衡器,采用 Round-robin 算法(轮流执行)协调各个子进程之间的负载。运行时,所有新建立的连接都由主进程完成,然后主进程再把 TCP 连接分配给指定的子进程。

使用集群创建的子进程可以使用同一个端口,Node.js 内部对 http/netInterprozesskommunikation wird verwendet, um Nachrichten zwischen Unterprozessen auszutauschen. Das Cluster-Modul verfügt über einen integrierten Lastausgleicher und verwendet den Round-Robin-Algorithmus (nacheinander ausgeführt), um die Last zwischen Unterprozessen zu koordinieren. Bei der Ausführung werden alle neu hergestellten Verbindungen vom Hauptprozess abgeschlossen, und dann weist der Hauptprozess die TCP-Verbindung dem angegebenen untergeordneten Prozess zu.

http/net. Der Node.js-Hauptprozess ist für das Abhören des Zielports verantwortlich und verteilt die Anforderung nach Erhalt der Anforderung gemäß der Lastausgleichsrichtlinie an einen untergeordneten Prozess. 🎜3. 使用基于 Cluster 封装的 PM2 工具全自动创建进程

PM2 是常用的 node 进程管理工具,它可以提供 node.js 应用管理能力,如自动重载、性能监控、负载均衡等。

其主要用于 独立应用 的进程化管理,在 Node.js 单机服务部署方面比较适合。可以用于生产环境下启动同个应用的多个实例提高 CPU 利用率、抗风险、热加载等能力。

由于是外部库,需要使用 npm 包管理器安装:

$: npm install -g pm2

pm2 支持直接运行 server.js 启动项目,如下:

$: pm2 start server.js

即可启动 Node.js 应用,成功后会看到打印的信息:

┌──────────┬────┬─────────┬──────┬───────┬────────┬─────────┬────────┬─────┬───────────┬───────┬──────────┐ │ App name │ id │ version │ mode │ pid │ status │ restart │ uptime │ cpu │ mem │ user │ watching │ ├──────────┼────┼─────────┼──────┼───────┼────────┼─────────┼────────┼─────┼───────────┼───────┼──────────┤ │ server │ 0 │ 1.0.0 │ fork │ 24776 │ online │ 9 │ 19m │ 0% │ 35.4 MB │ 23101 │ disabled │ └──────────┴────┴─────────┴──────┴───────┴────────┴─────────┴────────┴─────┴───────────┴───────┴──────────┘

pm2 也支持配置文件启动,通过配置文件 ecosystem.config.js 可以定制 pm2 的各项参数:

module.exports = {

apps : [{

name: 'API', // 应用名

script: 'app.js', // 启动脚本

args: 'one two', // 命令行参数

instances: 1, // 启动实例数量

autorestart: true, // 自动重启

watch: false, // 文件更改监听器

max_memory_restart: '1G', // 最大内存使用亮

env: { // development 默认环境变量

// pm2 start ecosystem.config.js --watch --env development

NODE_ENV: 'development'

},

env_production: { // production 自定义环境变量

NODE_ENV: 'production'

}

}],

deploy : {

production : {

user : 'node',

host : '212.83.163.1',

ref : 'origin/master',

repo : 'git@github.com:repo.git',

path : '/var/www/production',

'post-deploy' : 'npm install && pm2 reload ecosystem.config.js --env production'

}

}

};pm2 logs 日志功能也十分强大:

$: pm2 logs

II. Node.js 中进程池和线程池的适用场景

一般我们使用计算机执行的任务包含以下几种类型的任务:

-

计算密集型任务:任务包含大量计算,CPU 占用率高。

const matrix = {}; for (let i = 0; iNach dem Login kopieren -

IO 密集型任务:任务包含频繁的、持续的网络 IO 和磁盘 IO 的调用。

const {copyFileSync, constants} = require('fs'); copyFileSync('big-file.zip', 'destination.zip');Nach dem Login kopieren 混合型任务:既有计算也有 IO。

一、进程池的适用场景

使用进程池的最大意义在于充分利用多核 CPU 资源,同时减少子进程创建和销毁的资源消耗。

进程是操作系统分配资源的基本单位,使用多进程架构能够更多的获取 CPU 时间、内存等资源。为了应对 CPU-Sensitive 场景,以及充分发挥 CPU 多核性能,Node 提供了 child_process 模块用于创建子进程。

子进程的创建和销毁需要较大的资源成本,因此池化子进程的创建和销毁过程,利用进程池来管理所有子进程。

除了这一点,Node.js 中子进程也是唯一的执行二进制文件的方式,Node.js 可通过流 (stdin/stdout/stderr) 或 IPC 和子进程通信。

通过 Stream 通信

const {spawn} = require('child_process');

const ls = spawn('ls', ['-lh', '/usr']);

ls.stdout.on('data', (data) => {

console.log(`stdout: ${data}`);

});

ls.stderr.on('data', (data) => {

console.error(`stderr: ${data}`);

});

ls.on('close', (code) => {

console.log(`child process exited with code ${code}`);

});通过 IPC 通信

const cp = require('child_process');

const n = cp.fork(`${__dirname}/sub.js`);

n.on('message', (m) => {

console.log('PARENT got message:', m);

});

n.send({hello: 'world'});二、线程池的适用场景

使用线程池的最大意义在于多任务并行,为主线程降压,同时减少线程创建和销毁的资源消耗。单个 CPU 密集性的计算任务使用线程执行并不会更快,甚至线程的创建、销毁、上下文切换、线程通信、数据序列化等操作还会额外增加资源消耗。

但是如果一个计算机程序中有很多同一类型的阻塞任务需要执行,那么将他们交给线程池可以成倍的减少任务总的执行时间,因为在同一时刻多个线程在并行进行计算。如果多个任务只使用主线程执行,那么最终消耗的时间是线性叠加的,同时主线程阻塞之后也会影响其它任务的处理。

特别是对 Node.js 这种单主线程的语言来讲,主线程如果消耗了过多的时间来执行这些耗时任务,那么对整个 Node.js 单个进程实例的性能影响将是致命的。这些占用着 CPU 时间的操作将导致其它任务获取的 CPU 时间不足或 CPU 响应不够及时,被影响的任务将进入 “饥饿” 状态。

因此 Node.js 启动后主线程应尽量承担调度的角色,批量重型 CPU 占用任务的执行应交由额外的工作线程处理,主线程最后拿到工作线程的执行结果再返回给任务调用方。另一方面由于 IO 操作 Node.js 内部作了优化和支持,因此 IO 操作应该直接交给主线程,主线程再使用内部线程池处理。

Node.js 的异步能不能解决过多占用 CPU 任务的执行问题?

答案是:不能,过多的异步 CPU 占用任务会阻塞事件循环。

Node.js 的异步在 网络 IO / 磁盘 IO 处理上很有用,宏任务微任务系统 + 内部线程调用能分担主进程的执行压力。但是如果单独将 CPU 占用任务放入宏任务队列或微任务队列,对任务的执行速度提升没有任何帮助,只是一种任务调度方式的优化而已。

我们只是延迟了任务的执行或是将巨大任务分散成多个再分批执行,但是任务最终还是要在主线程被执行。如果这类任务过多,那么任务分片和延迟的效果将完全消失,一个任务可以,那十个一百个呢?量变将会引起质变。

以下是 Node.js 官方博客中的原文:

“如果你需要做更复杂的任务,拆分可能也不是一个好选项。这是因为拆分之后任务仍然在事件循环线程中执行,并且你无法利用机器的多核硬件能力。 请记住,事件循环线程只负责协调客户端的请求,而不是独自执行完所有任务。 对一个复杂的任务,最好把它从事件循环线程转移到工作线程池上。”

场景:间歇性让主进程 瘫痪

每一秒钟,主线程有一半时间被占用

// this task costs 100ms

function doHeavyTask() { ...}

setInterval(() => {

doHeavyTask(); // 100ms

doHeavyTask(); // 200ms

doHeavyTask(); // 300ms

doHeavyTask(); // 400ms

doHeavyTask(); // 500ms

}, 1e3);场景:高频性让主进程 半瘫痪

每 200ms,主线程有一半时间被占用

// this task costs 100ms

function doHeavyTask() { ...}

setInterval(() => {

doHeavyTask();

}, 1e3);

setInterval(() => {

doHeavyTask();

}, 1.2e3);

setInterval(() => {

doHeavyTask();

}, 1.4e3);

setInterval(() => {

doHeavyTask();

}, 1.6e3);

setInterval(() => {

doHeavyTask();

}, 1.8e3);以下是官方博客的原文摘录:

“因此,你应该保证永远不要阻塞事件轮询线程。换句话说,每个 JavaScript 回调应该快速完成。这些当然对于 await,Promise.then 也同样适用。”

III. 进程池

进程池是对进程的创建、执行任务、销毁等流程进行管控的一个应用或是一套程序逻辑。之所以称之为池是因为其内部包含多个进程实例,进程实例随时都在进程池内进行着状态流转,多个创建的实例可以被重复利用,而不是每次执行完一系列任务后就被销毁。因此,进程池的部分存在目的是为了减少进程创建的资源消耗。

此外进程池最重要的一个作用就是负责将任务分发给各个进程执行,各个进程的任务执行优先级取决于进程池上的负载均衡运算,由算法决定应该将当前任务派发给哪个进程,以达到最高的 CPU 和内存利用率。常见的负载均衡算法有:

- POLLING - 轮询:子进程轮流处理请求

- WEIGHTS - 权重:子进程根据设置的权重来处理请求

- RANDOM - 随机:子进程随机处理请求

- SPECIFY - 指定:子进程根据指定的进程 id 处理请求

- WEIGHTS_POLLING - 权重轮询:权重轮询策略与轮询策略类似,但是权重轮询策略会根据权重来计算子进程的轮询次数,从而稳定每个子进程的平均处理请求数量。

- WEIGHTS_RANDOM - 权重随机:权重随机策略与随机策略类似,但是权重随机策略会根据权重来计算子进程的随机次数,从而稳定每个子进程的平均处理请求数量。

- MINIMUM_CONNECTION - 最小连接数:选择子进程上具有最小连接活动数量的子进程处理请求。

- WEIGHTS_MINIMUM_CONNECTION - 权重最小连接数:权重最小连接数策略与最小连接数策略类似,不过各个子进程被选中的概率由连接数和权重共同决定。

一、要点

「 对单一任务的控制不重要,对单个进程宏观的资源占用更需关注 」

二、流程设计

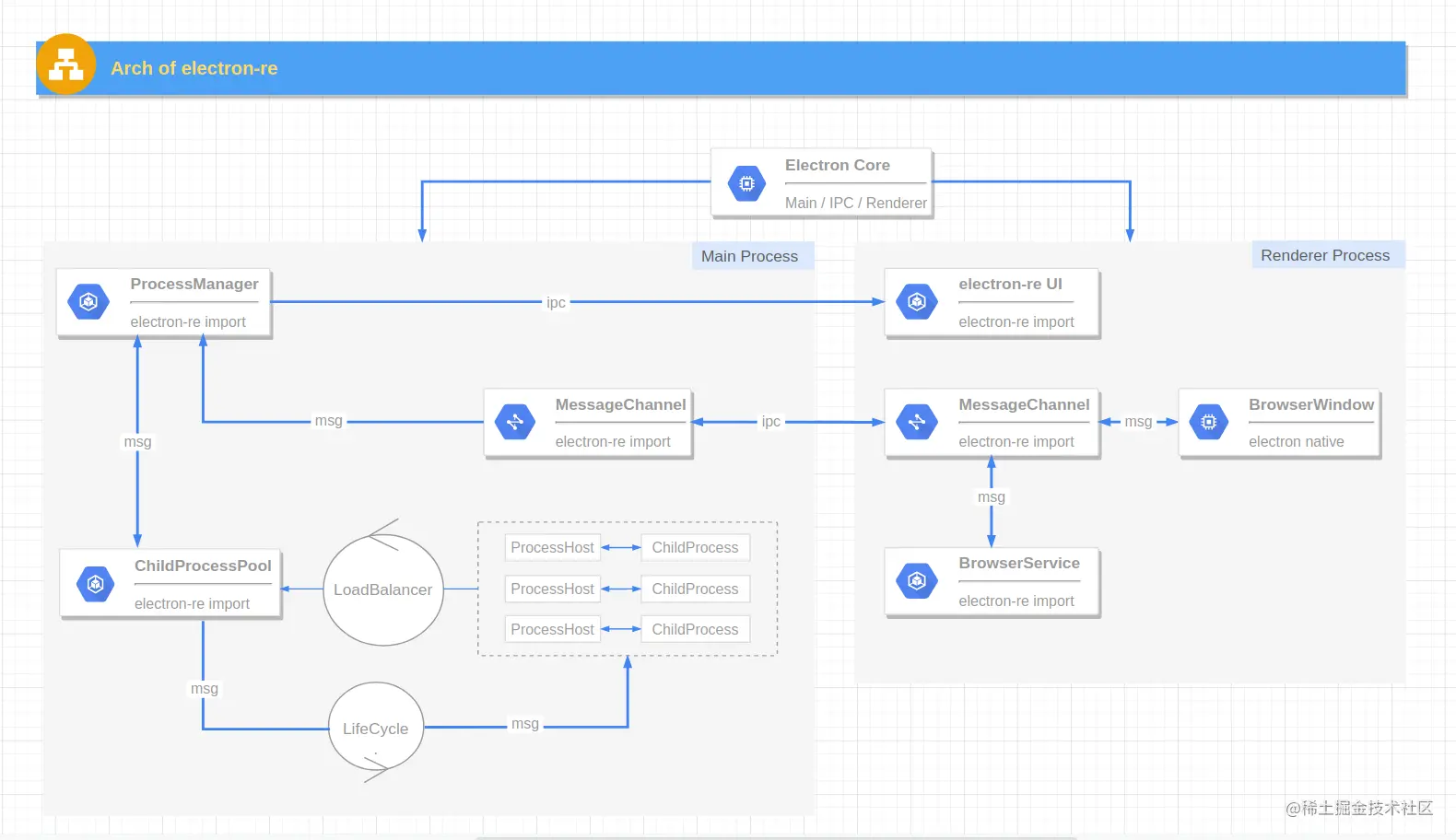

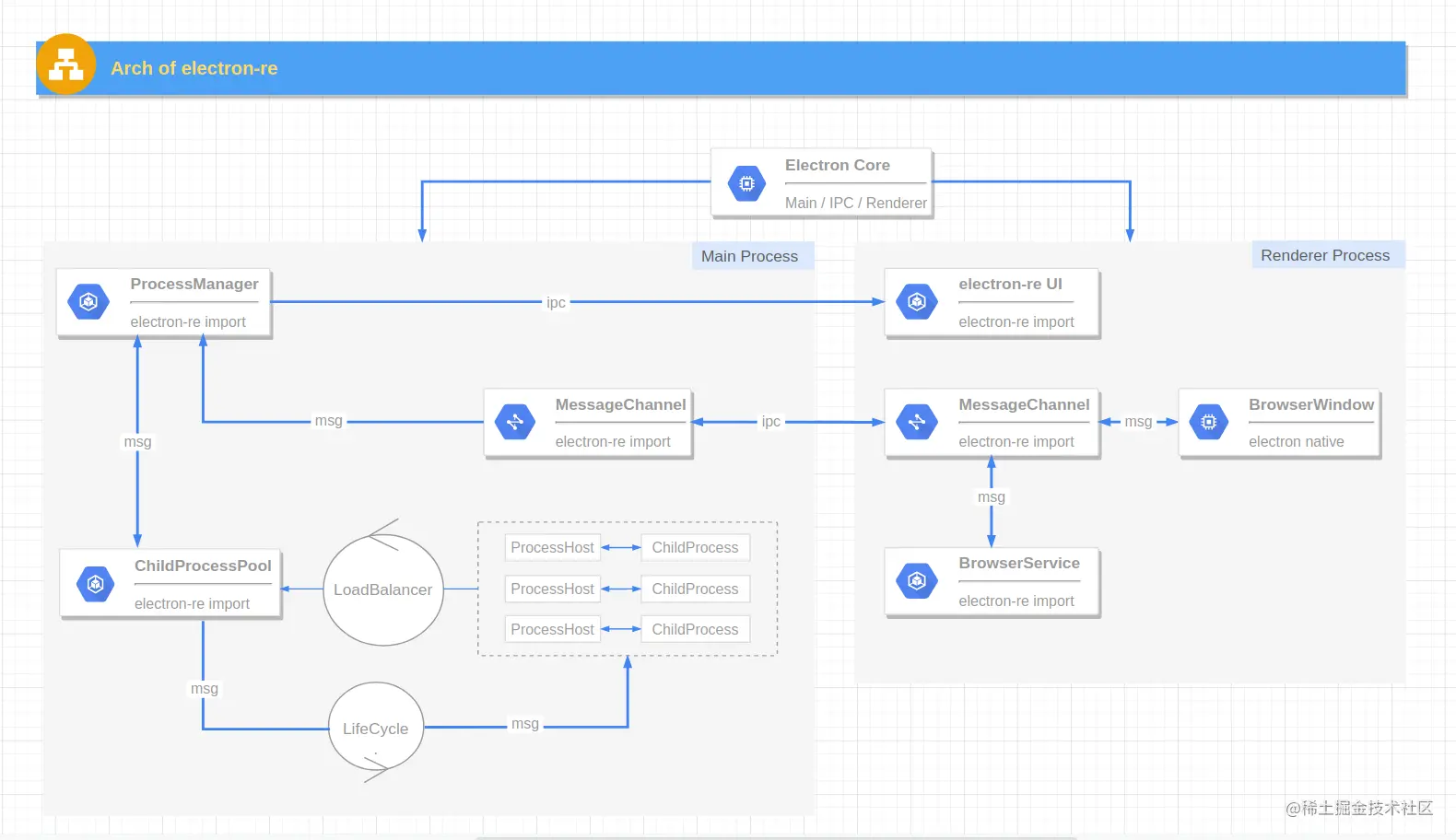

进程池架构图参考之前的进程管理工具开发相关 文章,本文只需关注进程池部分。

1. 关键流程

- 进程池创建进程时会初始化进程实例内的 ProcessHost 事务对象,进程实例向事务对象注册多种任务监听器。

- 用户向进程池发起单个任务调用请求,可传入进程绑定的 ID 和指定的任务名。

- 判断用户是否传入 ID 参数指定使用某个进程执行任务,如果未指定 ID:

- 进程池判断当前进程池进程数量是否已超过最大值,如果未超过则创建新进程,用此进程处理当前任务,并将进程放入进程池。

- 如果进程池进程数量已达最大值,则根据负载均衡算法选择一个进程处理当前任务。

- 指定 ID 时:

- 通过用户传入的 ID 参数找到对应进程,将任务分发给此进程执行。

- 如果未找到 ID 所对应的进程,则向用户抛出异常。

- 任务由进程池派发给目标进程后,ProcessHost 事务对象会根据该任务的任务名触发子进程内的监听器。

- 子进程内的监听器函数可执行同步任务和异步任务,异步任务返回 Promise 对象,同步任务返回值。

- ProcessHost 事务对象的监听器函数执行完毕后,会将任务结果返回给进程池,进程池再将结果通过异步回调函数返回给用户。

- 用户也可向进程池所有子进程发起个任务调用请求,最终将会通过 Promise 的返回所有子进程的任务执行结果。

2. 名词解释

- ProcessHost 事务中心:运行在子进程中,用于事件触发以及和主进程通信。开发者在子进程执行文件中向其注册多个具有特定任务名的任务事件,主进程会向某个子进程发送任务请求,并由事务中心调用指定的事件监听器处理请求。

- LoadBalancer 负载均衡器:用于选择一个进程处理任务,可根据不同的负载均衡算法实现不同的选择策略。

- LifeCycle: 设计之初用于管控子进程的智能启停,某个进程在长时间未被使用时进入休眠状态,当有新任务到来时再唤醒进程。目前还有些难点需要解决,比如进程的唤醒和休眠不好实现,进程的使用情况不好统计,该功能暂时不可用。

三、进程池使用方式

1. 创建进程池

main.js

const { ChildProcessPool, LoadBalancer } = require('electron-re');

const processPool = new ChildProcessPool({

path: path.join(__dirname, 'child_process/child.js'),

max: 4,

strategy: LoadBalancer.ALGORITHM.POLLING,

);child.js

const { ProcessHost } = require('electron-re');

ProcessHost

.registry('test1', (params) => {

console.log('test1');

return 1 + 1;

})

.registry('test2', (params) => {

console.log('test2');

return new Promise((resolve) => resolve(true));

});2. 向一个子进程发送任务请求

processPool.send('test1', { value: "test1"}).then((result) => {

console.log(result);

});3. 向所有子进程发送任务请求

processPool.sendToAll('test1', { value: "test1"}).then((results) => {

console.log(results);

});四、进程池实际使用场景

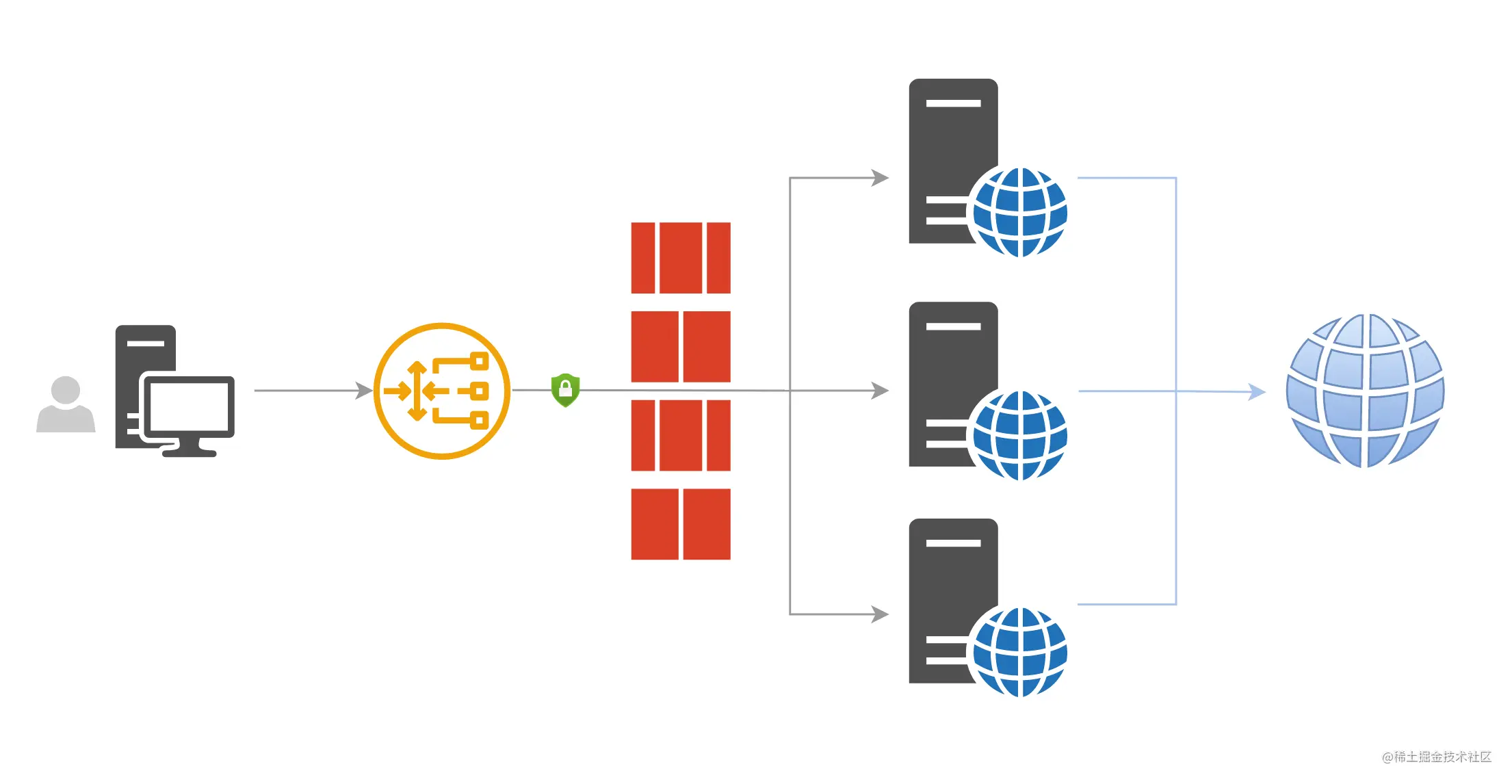

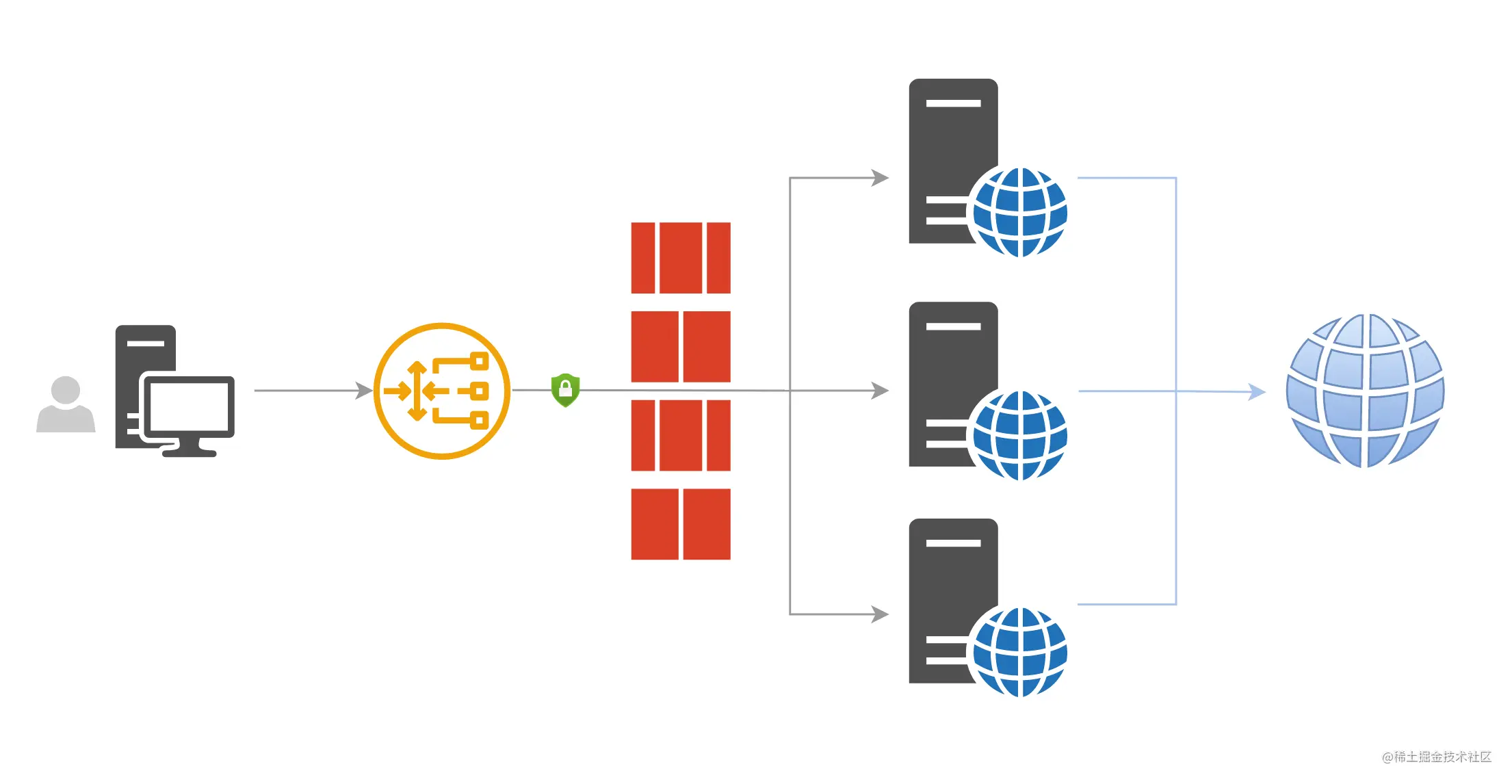

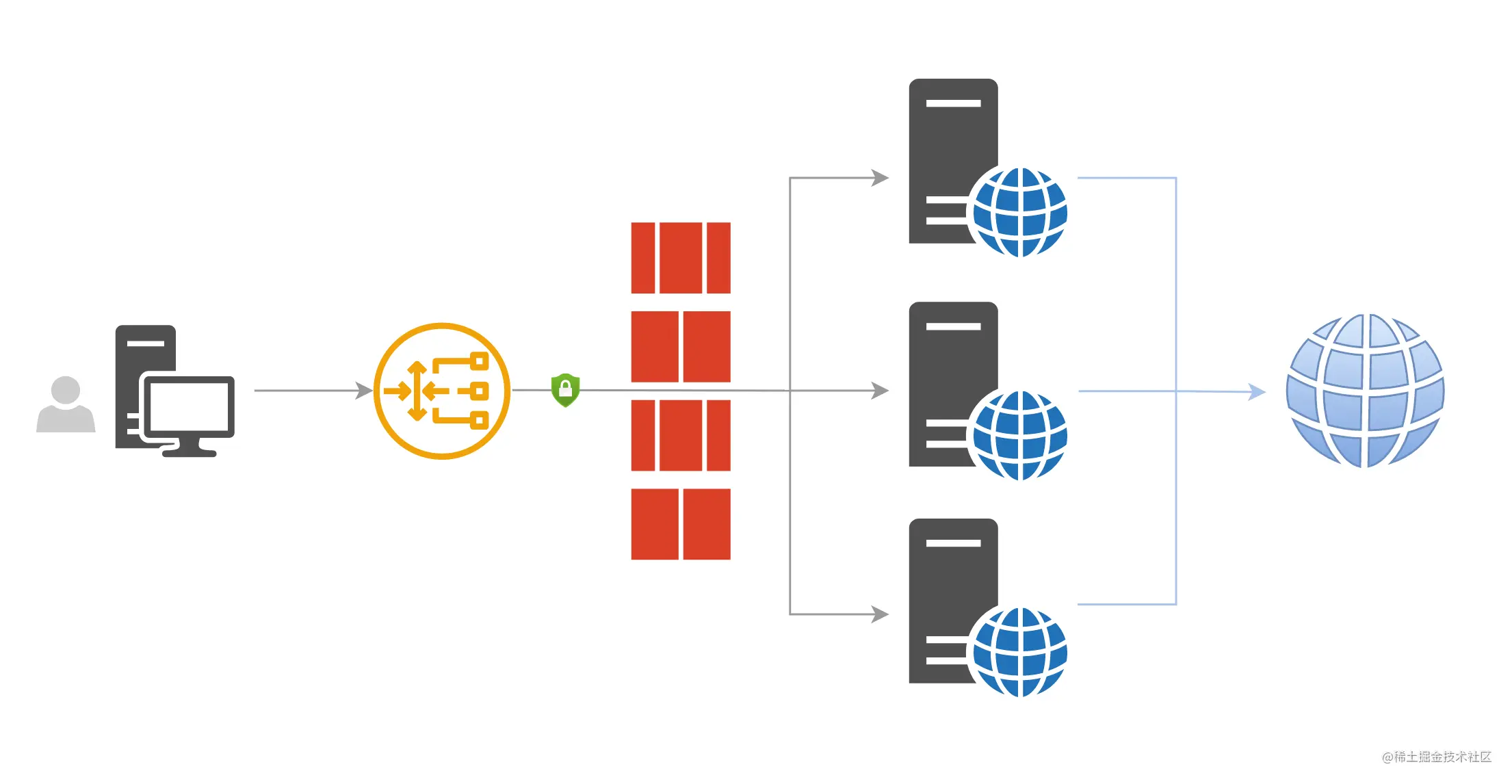

1. Electron 网页代理工具中多进程的应用

1)基本代理原理:

2)单进程下客户端执行原理:

- 通过用户预先保存的服务器配置信息,使用 node.js 子进程来启动 ss-local 可执行文件建立和 ss 服务器的连接来代理用户本地电脑的流量,每个子进程占用一个 socket 端口。

- 其它支持 socks5 代理的 proxy 工具比如:浏览器上的 SwitchOmega 插件会和这个端口的 tcp 服务建立连接,将 tcp 流量加密后通过代理服务器转发给我们需要访问的目标服务器。

3)多进程下客户端执行原理:

以上描述的是客户端连接单个节点的工作模式,节点订阅组中的负载均衡模式需要同时启动多个子进程,每个子进程启动 ss-local 执行文件占用一个本地端口并连接到远端一个服务器节点。

每个子进程启动时选择的端口是会变化的,因为某些端口可能已经被系统占用,程序需要先选择未被使用的端口。并且浏览器 proxy 工具也不可能同时连接到我们本地启动的子进程上的多个 ss-local 服务上。因此需要一个占用固定端口的中间节点接收 proxy 工具发出的连接请求,然后按照某种分发规则将 tcp 流量转发到各个子进程的 ss-local 服务的端口上。

2. Segmentierter Multiprozess-Datei-Upload Electron-Client

Ich habe zuvor einen Client erstellt, der das SMB-Protokoll zum segmentierten Hochladen mehrerer Dateien unterstützt. Die Upload-Aufgabenverwaltung, E/A-Vorgänge usw. waren alle auf der Node.js-Seite mit mehreren Prozessen implementiert, aber ich habe es selbst im experimentellen Zweig von Gitlab erstellt (entkommen).

IV. Thread-Pool

Um den Systemaufwand für CPU-intensive Aufgabenberechnungen zu reduzieren, hat Node.js eine neue Funktion eingeführt: Worker-Thread worker_threads, die erstmals in v10.5.0 veröffentlicht wurde Erscheint als experimentelle Funktion. Über worker_threads können innerhalb des Prozesses mehrere Threads erstellt werden. Der Hauptthread und die Worker-Threads kommunizieren über parentPort, und Worker-Threads können direkt über MessageChannel kommunizieren. Als wichtige Funktion für Entwickler zur Verwendung von Threads können worker_threads in der Produktionsumgebung in der stabilen Version von v12.11.0 normal verwendet werden. v10.5.0 作为实验性功能出现。通过 worker_threads 可以在进程内创建多个线程,主线程与 worker 线程使用 parentPort 通信,worker 线程之间可通过 MessageChannel 直接通信。worker_threads 做为开发者使用线程的重要特性,在 v12.11.0 稳定版已经能正常在生产环境使用了。

但是线程的创建需要额外的 CPU 和内存资源,如果要多次使用一个线程的话,应该将其保存起来,当该线程完全不使用时需要及时关闭以减少内存占用。想象我们在需要使用线程时直接创建,使用完后立刻销毁,可能线程自身的创建和销毁成本已经超过了使用线程本身节省下的资源成本。Node.js 内部虽然有使用线程池,但是对于开发者而言是完全透明不可见的,因此封装一个能够维护线程生命周期的线程池工具的重要性就体现了。

为了强化多异步任务的调度,线程池除了提供维护线程的能力,也提供维护任务队列的能力。当发送请求给线程池让其执行一个异步任务时,如果线程池内没有空闲线程,那该任务就会被直接丢弃了,显然这不是想要的效果。

因此可以考虑为线程池添加一个任务队列的调度逻辑:当线程池没有空闲线程时,将该任务放入待执行任务队列 (FIFO),线程池在某个时机取出任务交由某个空闲线程执行,执行完成后触发异步回调函数,将执行结果返回给请求调用方。但是线程池的任务队列内的任务数量应该考虑限制到一个特殊值,防止线程池负载过大影响 Node.js 应用整体运行性能。

一、要点

「 对单一任务的控制重要,对单个线程的资源占用无需关注 」

二、详细设计

任务流转过程

-

调用者可通过

Die Erstellung von Threads erfordert jedoch zusätzliche CPU- und Speicherressourcen. Wenn ein Thread mehrmals verwendet werden soll, muss er rechtzeitig geschlossen werden, um die Speichernutzung zu reduzieren . Stellen Sie sich vor, wir erstellen einen Thread direkt, wenn wir ihn verwenden müssen, und zerstören ihn sofort nach der Verwendung. Möglicherweise übersteigen die Kosten für die Erstellung und Zerstörung des Threads selbst die Kosten für die durch die Verwendung des Threads selbst eingesparten Ressourcen. Obwohl Node.js intern einen Thread-Pool verwendet, ist dieser für Entwickler völlig transparent und unsichtbar. Daher ist es wichtig, ein Thread-Pool-Tool zu kapseln, das den Thread-Lebenszyklus aufrechterhalten kann.StaticPool/StaticExcutor/DynamicPool/DynamicExcutor - Um die Planung mehrerer asynchroner Aufgaben zu verbessern, bietet der Thread-Pool nicht nur die Möglichkeit, Threads zu verwalten, sondern auch die Möglichkeit, Aufgabenwarteschlangen zu verwalten. Wenn beim Senden einer Anforderung an den Thread-Pool zur Ausführung einer asynchronen Aufgabe keine inaktiven Threads im Thread-Pool vorhanden sind, wird die Aufgabe direkt verworfen. Dies ist offensichtlich nicht der gewünschte Effekt. Sie können also erwägen, dem Thread-Pool eine Planungslogik für die Aufgabenwarteschlange hinzuzufügen: Wenn der Thread-Pool keine inaktiven Threads hat, legen Sie die Aufgabe in die Warteschlange für auszuführende Aufgaben (FIFO) und der Thread-Pool nimmt sie heraus Aufgabe zu einem bestimmten Zeitpunkt und übergeben Sie sie an einen inaktiven Thread. Nach Abschluss der Ausführung wird die asynchrone Rückruffunktion ausgelöst und das Ausführungsergebnis an den Anforderungsaufrufer zurückgegeben. Allerdings sollte die Anzahl der Aufgaben in der Aufgabenwarteschlange des Thread-Pools auf einen speziellen Wert begrenzt werden, um zu verhindern, dass eine übermäßige Belastung des Thread-Pools die Gesamtleistung der Node.js-Anwendung beeinträchtigt.

- 1. Wichtige Punkte「 Die Kontrolle einer einzelnen Aufgabe ist wichtig, Es besteht keine Notwendigkeit, auf die Ressourcennutzung von Threads zu achten

-

Aufgabenflussprozess

Der Aufrufer kann den

StaticPool/StaticExcutor/DynamicPool/ übergeben DynamicExcutor-Instanz an den Thread Der Pool verteilt Aufgaben (Schlüsselbegriffe werden unten erläutert). Der größte Unterschied zwischen verschiedenen Instanzen ist die dynamische Parameterfähigkeit.Aufgaben werden intern vom Thread-Pool generiert. Nach der Generierung wird die Aufgabe zum einen als Hauptzirkulationsträger verwendet. Zum einen werden die vom Benutzer übergebenen Aufgabenberechnungsparameter verwendet zeichnet die Statusänderungen während des Aufgabenumlaufprozesses auf, z. B.: Aufgabenstatus, Startzeit, Endzeit, Aufgaben-ID, Anzahl der Aufgabenwiederholungen, ob die Aufgabe Wiederholungsversuche unterstützt, Aufgabentyp usw.

Bestimmen Sie nach der Generierung der Aufgabe zunächst, ob die Anzahl der Threads im aktuellen Thread-Pool die Obergrenze erreicht hat. Wenn die Obergrenze nicht erreicht ist, erstellen Sie einen neuen Thread und legen Sie ihn im Thread-Speicherbereich ab. und verwenden Sie dann diesen Thread, um die aktuelle Aufgabe direkt auszuführen.

-

Wenn die Anzahl der Threads im Thread-Pool den Grenzwert überschreitet, ermitteln Sie, ob es inaktive Threads gibt, die keine Aufgaben ausgeführt haben. Verwenden Sie diesen Thread nach dem Abrufen der inaktiven Threads, um die aktuelle Aufgabe direkt auszuführen.

🎜🎜🎜Wenn kein inaktiver Thread vorhanden ist, wird beurteilt, ob die aktuell wartende Aufgabenwarteschlange voll ist. Wenn die Aufgabenwarteschlange voll ist, wird ein Fehler ausgegeben, sodass der Aufrufer erkennen kann, dass die Aufgabe nicht erfolgreich ausgeführt wurde erstmals. 🎜🎜🎜🎜Wenn die Aufgabenwarteschlange nicht voll ist, stellen Sie die Aufgabe in die Aufgabenwarteschlange und warten Sie, bis das Aufgabenzyklussystem sie herausnimmt und ausführt. 🎜🎜🎜🎜Nachdem die Aufgabe in den drei Fällen der Schritte 4/5/6 oben ausgeführt wurde, wird beurteilt, ob die Aufgabe erfolgreich ausgeführt wurde. Bei Erfolg wird die erfolgreiche Rückruffunktion ausgelöst und der Promise-Status gefüllt. Wenn dies fehlschlägt, stellen Sie fest, ob ein Wiederholungsversuch unterstützt wird. Wenn ein Wiederholungsversuch unterstützt wird, wird die Aufgabe wiederholt + 1 und dann wieder an das Ende der Aufgabenwarteschlange gestellt. Wenn die Aufgabe keine Wiederholung unterstützt, schlägt sie direkt fehl und löst die fehlgeschlagene asynchrone Rückruffunktion aus, und der Promise-Status wird abgelehnt. 🎜🎜🎜🎜Während des gesamten Thread-Pool-Lebenszyklus gibt es ein Task-Zyklussystem, das in einer bestimmten periodischen Häufigkeit Aufgaben vom Kopf der Task-Warteschlange abruft, inaktive Threads aus dem Thread-Speicherbereich abruft und diesen Thread dann verwendet Dieser Prozess entspricht auch Abschnitt 7 Beschreibung der Schritte. 🎜 任务循环系统除了取任务执行,如果线程池设置了任务超时时间的话,也会判断正在执行中的任务是否超时,超时后会终止该线程的所有运行中的代码。

-

StaticPool

- 定义:静态线程池,可使用固定的

execFunction/execString/execFile执行参数来启动工作线程,执行参数在进程池创建后不能更改。 - 进程池创建之后除了执行参数不可变外,其它参数比如:任务超时时间、任务重试次数、线程池任务轮询间隔时间、最大任务数、最大线程数、是否懒创建线程等都可以通过 API 随时更改。

- 定义:静态线程池,可使用固定的

-

StaticExcutor

- 定义:静态线程池的执行器实例,继承所属线程池的固定执行参数

execFunction/execString/execFile且不可更改。 - 执行器实例创建之后除了执行参数不可变外,其它参数比如:任务超时时间、任务重试次数、transferList 等都可以通过 API 随时更改。

- 静态线程池的各个执行器实例的参数设置互不影响,参数默认继承于所属线程池,参数在执行器上更改后具有比所属线程池同名参数更高的优先级。

- 定义:静态线程池的执行器实例,继承所属线程池的固定执行参数

-

DynamicPool

- 定义:动态线程池,无需使用

execFunction/execString/execFile执行参数即可创建线程池。执行参数在调用exec()方法时动态传入,因此执行参数可能不固定。 - 线程池创建之后执行参数默认为

null,其它参数比如:任务超时时间、任务重试次数、transferList 等都可以通过 API 随时更改。

- 定义:动态线程池,无需使用

-

DynamicExcutor

- 定义:动态线程池的执行器实例,继承所属线程池的其它参数,执行参数为

null。 - 执行器实例创建之后,其它参数比如:任务超时时间、任务重试次数、transferList 等都可以通过 API 随时更改。

- 动态线程池的各个执行器实例的参数设置互不影响,参数默认继承于所属线程池,参数在执行器上更改后具有比所属线程池同名参数更高的优先级。

- 动态执行器实例在执行任务之前需要先设置执行参数

execFunction/execString/execFile,执行参数可以随时改变。

- 定义:动态线程池的执行器实例,继承所属线程池的其它参数,执行参数为

-

ThreadGenerator

- 定义:线程创建的工厂方法,会进行参数校验。

-

Thread

- 定义:线程实例,内部简单封装了

worker_threadsAPI。

- 定义:线程实例,内部简单封装了

-

TaskGenerator

- 定义:任务创建的工厂方法,会进行参数校验。

-

Task

- 定义:单个任务,记录了任务执行状态、任务开始结束时间、任务重试次数、任务携带参数等。

-

TaskQueue

- 定义:任务队列,在数组中存放任务,以先入先出方式 (FIFO) 向线程池提供任务,使用 Map 来存储 taskId 和 task 之间的映射关系。

-

Task Loop

- 任务循环,每个循环的默认时间间隔为 2S,每次循环中会处理超时任务、将新任务派发给空闲线程等。

模块说明

三、线程池使用方式

1. 创建静态线程池

main.js

const { StaticThreadPool } = require(`electron-re`);

const threadPool = new StaticThreadPool({

execPath: path.join(__dirname, './worker_threads/worker.js'),

lazyLoad: true, // 懒加载

maxThreads: 24, // 最大线程数

maxTasks: 48, // 最大任务数

taskRetry: 1, // 任务重试次数

taskLoopTime: 1e3, // 任务轮询时间

});

const executor = threadPool.createExecutor();worker.js

const fibonaccis = (n) => {

if (n {

return fibonaccis(value);

}2. 使用静态线程池发送任务请求

threadPool.exec(15).then((res) => {

console.log(+res.data === 610)

});

executor

.setTaskRetry(2) // 不影响 pool 的全局设置

.setTaskTimeout(2e3) // 不影响 pool 的全局设置

.exec(15).then((res) => {

console.log(+res.data === 610)

});3. 动态线程池和动态执行器

const { DynamicThreadPool } = require(`electron-re`);

const threadPool = new DynamicThreadPool({

maxThreads: 24, // 最大线程数

maxTasks: 48, // 最大任务数

taskRetry: 1, // 任务重试次数

});

const executor = threadPool.createExecutor({

execFunction: (value) => { return 'dynamic:' + value; },

});

threadPool.exec('test', {

execString: `module.exports = (value) => { return 'dynamic:' + value; };`,

});

executor.exec('test');

executor

.setExecPath('/path/to/exec-file.js')

.exec('test');四、线程池实际使用场景

暂未在项目中实际使用,可考虑在前端图片像素处理、音视频转码处理等 CPU 密集性任务中进行实践。

这里有篇文章写了 web_worker 的一些应用场景,web_worker 和 worker_threads 是类似的,宿主环境不同,一些权限和能力的不同而已。

V. Ende

Das anfängliche Projekt ist ein Tool-Set für die Electron-Anwendungsentwicklung, das Funktionen wie BrowserService / ChildProcessPool / Simple Process Monitoring UI / Inter-Process Communication und den Zusatz bereitstellt von Thread-Pools Tatsächlich war dies zu Beginn nicht geplant, und der Thread-Pool selbst ist unabhängig und nicht auf andere Modulfunktionen in Electron-Re angewiesen. Es sollte in Zukunft unabhängig sein. BrowserService / ChildProcessPool / 简易进程监控 UI / 进程间通信 等功能,线程池的加入其实是当初没有计划的,而且线程池本身是独立的,不依赖 electron-re 中其它模块功能,之后应该会被独立出去。

进程池和线程池的实现方案上还需完善。

比如进程池未支持子进程空闲时自动退出以解除资源占用,当时做了另一版监听 ProcessHost 的任务执行情况来让子进程空闲时休眠,想通过此方式节省资源占用。不过由于没有 node.js API 级别的支持以分辨子进程空闲的情况,并且子进程的休眠 / 唤醒功能比较鸡肋 (有尝试通过向子进程发送 SIGSTOP/SIGCONT 信号实现),最终这个特性被废除了。

后面可以考虑支持 CPU/Memory 的负载均衡算法,目前已经通过项目中的 ProcessManager 模块来实现资源占用情况采集了。

线程池方面相对的可用度还是较高,提供了 pool/excutor 两个层级的调用管理,支持链式调用,在一些需要提升数据传输性能的场景支持 transferList

ProcessManager im Projekt implementiert. 🎜🎜Die relative Verfügbarkeit des Thread-Pools ist immer noch relativ hoch. Er bietet zwei Ebenen der Anrufverwaltung: pool/excutor, unterstützt Kettenaufrufe und unterstützt in einigen Szenarien, in denen die Datenübertragungsleistung erforderlich ist Die Methode transferList vermeidet das Klonen von Daten. Im Vergleich zu anderen Open-Source-Node-Thread-Pool-Lösungen liegt der Schwerpunkt auf der Stärkung der Aufgabenwarteschlangenfunktion und unterstützt Funktionen wie Aufgabenwiederholung und Aufgabenzeitüberschreitung. 🎜🎜Weitere Informationen zu Knoten finden Sie unter: 🎜nodejs-Tutorial🎜! 🎜Das obige ist der detaillierte Inhalt vonLassen Sie uns darüber sprechen, wie Sie mithilfe von Node einen einfachen Prozess- und Thread-Pool implementieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So löschen Sie einen Knoten in NVM

Dec 29, 2022 am 10:07 AM

So löschen Sie einen Knoten in NVM

Dec 29, 2022 am 10:07 AM

So löschen Sie einen Knoten mit nvm: 1. Laden Sie „nvm-setup.zip“ herunter und installieren Sie es auf dem Laufwerk C. 2. Konfigurieren Sie Umgebungsvariablen und überprüfen Sie die Versionsnummer mit dem Befehl „nvm -v“. install“-Befehl Knoten installieren; 4. Löschen Sie den installierten Knoten über den Befehl „nvm uninstall“.

So verwenden Sie Express für den Datei-Upload im Knotenprojekt

Mar 28, 2023 pm 07:28 PM

So verwenden Sie Express für den Datei-Upload im Knotenprojekt

Mar 28, 2023 pm 07:28 PM

Wie gehe ich mit dem Datei-Upload um? Der folgende Artikel stellt Ihnen vor, wie Sie Express zum Hochladen von Dateien im Knotenprojekt verwenden. Ich hoffe, er ist hilfreich für Sie!

Eine ausführliche Analyse des Prozessmanagement-Tools „pm2' von Node

Apr 03, 2023 pm 06:02 PM

Eine ausführliche Analyse des Prozessmanagement-Tools „pm2' von Node

Apr 03, 2023 pm 06:02 PM

In diesem Artikel stellen wir Ihnen das Prozessmanagement-Tool „pm2“ von Node vor und sprechen darüber, warum PM2 benötigt wird und wie Sie PM2 installieren und verwenden. Ich hoffe, dass es für alle hilfreich ist!

PI -Knotenunterricht: Was ist ein PI -Knoten? Wie installiere und richte ich einen PI -Knoten ein?

Mar 05, 2025 pm 05:57 PM

PI -Knotenunterricht: Was ist ein PI -Knoten? Wie installiere und richte ich einen PI -Knoten ein?

Mar 05, 2025 pm 05:57 PM

Detaillierte Erläuterungs- und Installationshandbuch für Pinetwork -Knoten In diesem Artikel wird das Pinetwork -Ökosystem im Detail vorgestellt - PI -Knoten, eine Schlüsselrolle im Pinetwork -Ökosystem und vollständige Schritte für die Installation und Konfiguration. Nach dem Start des Pinetwork -Blockchain -Testnetzes sind PI -Knoten zu einem wichtigen Bestandteil vieler Pioniere geworden, die aktiv an den Tests teilnehmen und sich auf die bevorstehende Hauptnetzwerkveröffentlichung vorbereiten. Wenn Sie Pinetwork noch nicht kennen, wenden Sie sich bitte an was Picoin ist? Was ist der Preis für die Auflistung? PI -Nutzung, Bergbau und Sicherheitsanalyse. Was ist Pinetwork? Das Pinetwork -Projekt begann 2019 und besitzt seine exklusive Kryptowährung PI -Münze. Das Projekt zielt darauf ab, eine zu erstellen, an der jeder teilnehmen kann

Lassen Sie uns darüber sprechen, wie Sie mit pkg Node.js-Projekte in ausführbare Dateien packen.

Dec 02, 2022 pm 09:06 PM

Lassen Sie uns darüber sprechen, wie Sie mit pkg Node.js-Projekte in ausführbare Dateien packen.

Dec 02, 2022 pm 09:06 PM

Wie packe ich die ausführbare Datei von nodejs mit pkg? Im folgenden Artikel erfahren Sie, wie Sie mit pkg ein Node-Projekt in eine ausführbare Datei packen. Ich hoffe, dass er Ihnen weiterhilft!

Was tun, wenn npm node gyp ausfällt?

Dec 29, 2022 pm 02:42 PM

Was tun, wenn npm node gyp ausfällt?

Dec 29, 2022 pm 02:42 PM

npm node gyp schlägt fehl, weil „node-gyp.js“ nicht mit der Version von „Node.js“ übereinstimmt. Die Lösung ist: 1. Löschen Sie den Knotencache über „npm cache clean -f“ 2. Über „npm install -“ g n“ Installieren Sie das n-Modul. 3. Installieren Sie die Version „node v12.21.0“ über den Befehl „n v12.21.0“.

Was ist ein Single-Sign-On-System? Wie implementiert man es mit NodeJS?

Feb 24, 2023 pm 07:33 PM

Was ist ein Single-Sign-On-System? Wie implementiert man es mit NodeJS?

Feb 24, 2023 pm 07:33 PM

Was ist ein Single-Sign-On-System? Wie implementiert man es mit NodeJS? Im folgenden Artikel erfahren Sie, wie Sie mit Node ein Single-Sign-On-System implementieren. Ich hoffe, dass er Ihnen weiterhilft!

Tokenbasierte Authentifizierung mit Angular und Node

Sep 01, 2023 pm 02:01 PM

Tokenbasierte Authentifizierung mit Angular und Node

Sep 01, 2023 pm 02:01 PM

Die Authentifizierung ist einer der wichtigsten Teile jeder Webanwendung. In diesem Tutorial werden tokenbasierte Authentifizierungssysteme und ihre Unterschiede zu herkömmlichen Anmeldesystemen erläutert. Am Ende dieses Tutorials sehen Sie eine voll funktionsfähige Demo, die in Angular und Node.js geschrieben wurde. Traditionelle Authentifizierungssysteme Bevor wir zu tokenbasierten Authentifizierungssystemen übergehen, werfen wir einen Blick auf traditionelle Authentifizierungssysteme. Der Benutzer gibt seinen Benutzernamen und sein Passwort im Anmeldeformular ein und klickt auf „Anmelden“. Nachdem Sie die Anfrage gestellt haben, authentifizieren Sie den Benutzer im Backend, indem Sie die Datenbank abfragen. Wenn die Anfrage gültig ist, wird eine Sitzung mit den aus der Datenbank erhaltenen Benutzerinformationen erstellt und die Sitzungsinformationen werden im Antwortheader zurückgegeben, sodass die Sitzungs-ID im Browser gespeichert wird. Bietet Zugriff auf Anwendungen, die unterliegen