Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Li Zhifei: Acht Beobachtungen zu GPT-4, der multimodale Großmodellwettbewerb beginnt

Li Zhifei: Acht Beobachtungen zu GPT-4, der multimodale Großmodellwettbewerb beginnt

Li Zhifei: Acht Beobachtungen zu GPT-4, der multimodale Großmodellwettbewerb beginnt

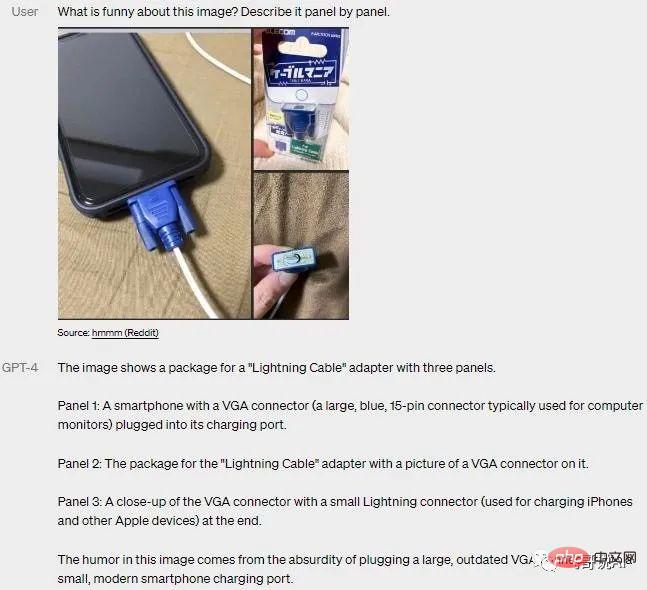

In standardisierten Tests und anderen Benchmarks übertrifft GPT-4 frühere Modelle, funktioniert in Dutzenden von Sprachen und kann auch Bilder als Eingabeobjekte verwenden, was bedeutet, dass es Fotos oder die Absicht und Logik des Diagramms verstehen kann.

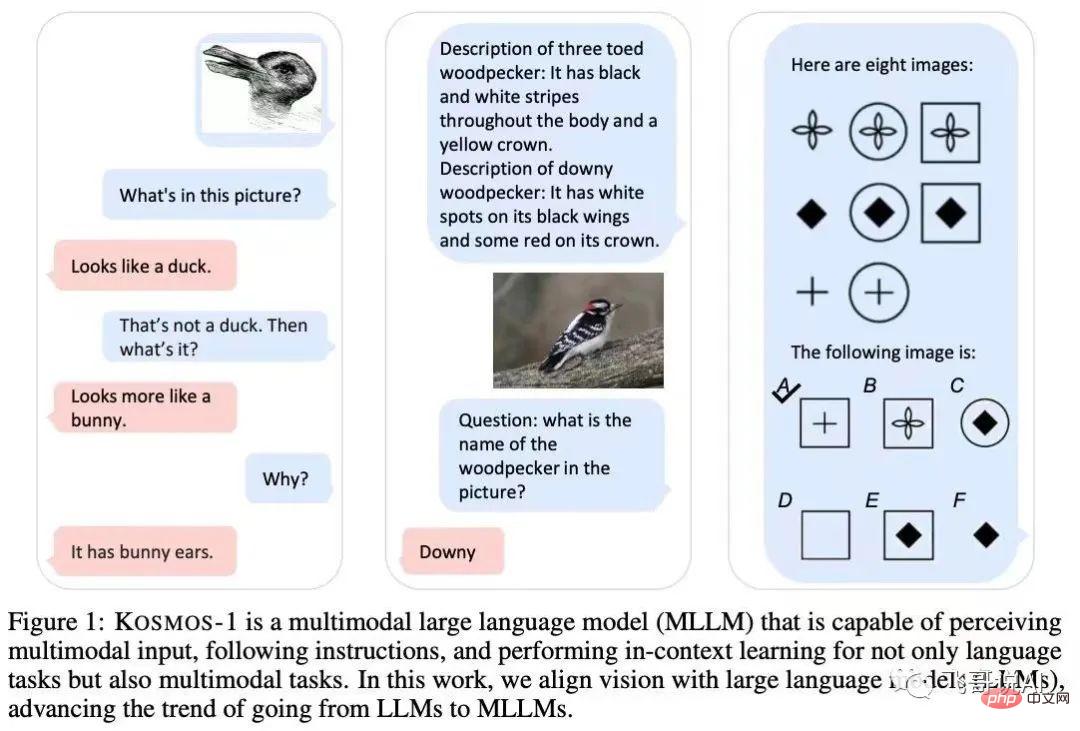

Seit Microsoft Anfang März das multimodale Modell Kosmos-1 veröffentlicht hat, testet und passt das Unternehmen das multimodale Modell von OpenAI an und macht es besser kompatibel mit Microsofts eigenen Produkten.

Wie erwartet hat Microsoft mit der Veröffentlichung von GPT-4 auch offiziell gezeigt, dass New Bing GPT-4 bereits verwendet hat.

Das von ChatGPT verwendete Sprachmodell ist GPT-3.5 Als OpenAI darüber sprach, dass GPT-4 leistungsfähiger ist als die Vorgängerversion, sagte OpenAI, dass die beiden Versionen in lockeren Gesprächen zwar ähnlich aussehen, aber „der Unterschied deutlich wird.“ die Komplexität der Aufgabe erreicht einen ausreichenden Schwellenwert.“ GPT-4 ist zuverlässiger, kreativer und in der Lage, differenziertere Anweisungen zu verarbeiten.

Der König ist gekrönt? Acht Beobachtungen zu GPT-4

1. Wiederumwerfend, besser als Menschen

Wenn die Modelle der GPT-3-Serie allen beweisen, dass KI mehrere Aufgaben in einem Modell erledigen kann und den Weg zur Erreichung von AGI, GPT-4, aufzeigen hat bei vielen Aufgaben die Leistung eines Menschen erreicht oder ist sogar besser als der Mensch. GPT-4 hat in vielen professionellen akademischen Prüfungen 90 % der Menschen übertroffen. Bei der Schein-Bar-Prüfung liegt seine Punktzahl beispielsweise unter den besten 10 % der Testteilnehmer. Wie sollten verschiedene Grund- und weiterführende Schulen, Universitäten und Berufsschulen darauf reagieren?

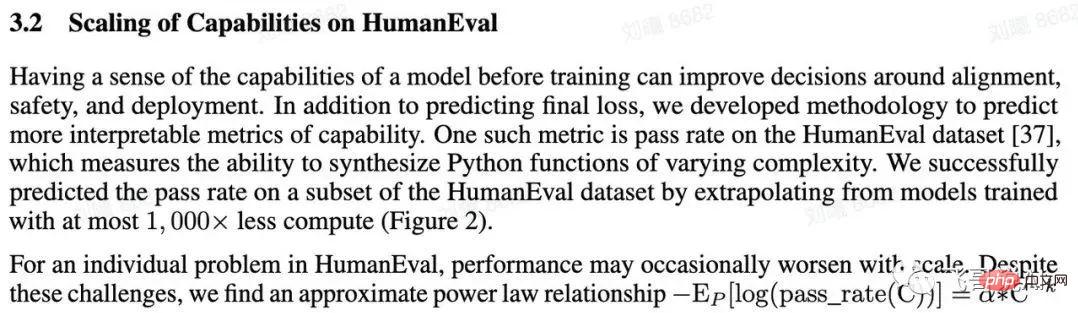

2. „Wissenschaftliche“ Alchemie

Obwohl OpenAI dieses Mal keine spezifischen Parameter bekannt gegeben hat, kann man davon ausgehen, dass das GPT-4-Modell ziemlich groß sein muss, was hohe Trainingskosten bedeutet. Gleichzeitig ähnelt das Training eines Modells auch stark dem „Verfeinern eines Elixiers“ und erfordert viele Experimente. Wenn diese Experimente in einer realen Umgebung trainiert werden, kann nicht jeder den hohen Kostendruck ertragen.

Zu diesem Zweck hat OpenAI auf geniale Weise eine sogenannte „vorhersehbare Skalierung“ entwickelt. Kurz gesagt, es verwendet ein Zehntausendstel der Kosten, um die Ergebnisse jedes Experiments (Verlust und menschliche Bewertung) vorherzusagen. Auf diese Weise wurde die ursprünglich groß angelegte „Glücks“-Alchemieausbildung zur „halbwissenschaftlichen“ Alchemie aufgewertet.

3. Crowdsourcing-Evaluierung, die zwei Fliegen mit einer Klappe schlägt

Dieses Mal bieten wir eine Open-Source-OpenAI-Evaluierung auf sehr „intelligente“ Weise an, die allen Entwicklern oder Enthusiasten durch Crowdsourcing offen steht, und laden alle ein, Evals zu nutzen Testmodell zu entwickeln und gleichzeitig das Entwickler-Ökosystem anzulocken. Diese Methode gibt nicht nur jedem das Gefühl, mitzumachen, sondern ermöglicht es auch jedem, kostenlos bei der Bewertung und Verbesserung des Systems mitzuhelfen. OpenAI erhält direkt Fragen und Feedback und schlägt so zwei Fliegen mit einer Klappe.

4. Technische Leckreparatur

Dieses Mal haben wir auch eine Systemkarte veröffentlicht, ein offenes „Patch“-Tool, das Lücken finden und das „Unsinn“-Problem des Sprachmodells reduzieren kann. Zur Vor- und Nachbearbeitung wurden verschiedene Patches auf das System angewendet, und der Code wird später geöffnet, um die Patch-Funktionen für alle zugänglich zu machen. Möglicherweise kann OpenAI in Zukunft jedem dabei helfen. Dies markiert, dass LLM endlich von einer eleganten und einfachen Aufgabe zur Vorhersage des nächsten Tokens zu verschiedenen chaotischen technischen Hacks übergegangen ist.

5. Multimodal

Seit Microsoft in Deutschland letzte Woche bekannt gegeben hat, dass GPT-4 multimodal ist, wurde die Öffentlichkeit mit Spannung erwartet.

GPT-4 gibt es schon seit langem. Die Multimodalität, die als „vergleichbar mit dem menschlichen Gehirn“ bezeichnet wird, unterscheidet sich eigentlich nicht wesentlich von den in vielen aktuellen Veröffentlichungen beschriebenen multimodalen Fähigkeiten Der Textmodell-Shot wird mit der logischen Kette (COT) kombiniert. Dabei wird davon ausgegangen, dass ein Text-LLM mit guten Grundfähigkeiten und Multimodalität erforderlich ist, der gute Ergebnisse liefert.

6. „King Explosion“ auf geplante Weise veröffentlichen

Laut dem Demovideo von OpenAI, das GPT-4 demonstriert, hat GPT-4 das Training bereits im August letzten Jahres abgeschlossen, es wurde jedoch erst heute veröffentlicht Der Rest der Zeit wird für umfangreiche Tests, verschiedene Fehlerbehebungen und vor allem für die Entfernung gefährlicher Inhalte aufgewendet.

Während alle immer noch in die erstaunlichen Generierungsfunktionen von ChatGPT vertieft sind, hat OpenAI GPT-4 bereits gelöst. Diese Welle von Google-Ingenieuren muss wahrscheinlich lange aufbleiben, um wieder aufzuholen?

7. OpenAI ist nicht mehr offen

OpenAI erwähnt in der öffentlichen Veröffentlichung keine Modellparameter und Datenskalen (die online übertragenen GPT-4-Parameter haben 100 Billionen erreicht), und es gibt kein technisches Prinzip erklärte, dass es zum Wohle der Öffentlichkeit sei, und ich befürchte, dass jeder, nachdem er gelernt hat, wie man GPT-4 herstellt, es dazu nutzen wird, Böses zu tun und einige unkontrollierbare Dinge auszulösen. Ich persönlich bin mit so etwas nicht einverstanden überhaupt kein silberfreier Ansatz.

8. Konzentrieren Sie sich auf große Dinge

Neben verschiedenen „Angeberfähigkeiten“ listet das Papier auf drei Seiten auch alle Personen auf, die zu verschiedenen Systemen von GPT-4 beigetragen haben. Eine grobe Schätzung dürfte bei mehr als hundert Personen liegen, was noch einmal die Einigkeit widerspiegelt und ein hohes Maß an Zusammenarbeit zwischen den internen Teammitgliedern von OpenAI. Liegt es im Vergleich zu den Teamkampffähigkeiten anderer Unternehmen in Bezug auf die gemeinsamen Anstrengungen etwas weit zurück?

Derzeit sind multimodale große Modelle zum Trend und zur wichtigen Richtung für die Entwicklung des gesamten großen KI-Modells geworden. In diesem großen KI-„Wettrüsten“ starten Technologiegiganten wie Google, Microsoft und DeepMind aktiv multimodale große Modelle (MLLM) oder großes Modell (LLM).

Eröffnung einer neuen Runde des Wettrüstens: Multimodale große Modelle

Microsoft: Kosmos-1

Microsoft hat Anfang März das multimodale Modell Kosmos-1 mit 1,6 Milliarden Parametern veröffentlicht basiert auf dem kausalen Sprachmodell von Transformer. Unter anderem wird der Transformer-Decoder als universelle Schnittstelle für multimodale Eingaben verwendet.

Zusätzlich zu verschiedenen Aufgaben in natürlicher Sprache ist das Kosmos-1-Modell in der Lage, eine Vielzahl wahrnehmungsintensiver Aufgaben nativ zu bewältigen, wie z. B. visueller Dialog, visuelle Erklärung, visuelle Beantwortung von Fragen, Bilduntertitel, einfache mathematische Gleichungen, OCR und Null -Shot-Bildklassifizierung mit Beschreibung.

Google: PaLM-E

Anfang März startete das Forschungsteam von Google und der Technischen Universität Berlin das derzeit größte visuelle Sprachmodell – PaLM-E, mit einem Parametervolumen von bis zu 562 Milliarden (PaLM-540B+ViT-22B).

PaLM-E ist ein großes Nur-Decoder-Modell, das in der Lage ist, Textvervollständigungen auf autoregressive Weise mit einem Präfix oder einer Eingabeaufforderung zu generieren. Durch das Hinzufügen eines Encoders zum Modell kann das Modell Bild- oder Sensordaten in eine Reihe von Vektoren mit der gleichen Größe wie die Sprach-Tags codieren und diese als Eingabe für die nächste Token-Vorhersage für ein End-to-End-Training verwenden.

DeepMind: Flamingo

DeepMind hat im April letzten Jahres das visuelle Sprachmodell Flamingo eingeführt. Das Modell verwendet Bilder, Videos und Texte als Eingabeaufforderungen und gibt relevante Sprachen aus Lösen Sie viele Probleme, ohne dass eine zusätzliche Schulung erforderlich ist.

Trainieren Sie das Modell durch die gegenseitige Eingabe von Bildern (Videos) und Text, sodass das Modell über Funktionen zur multimodalen Sequenzbegründung mit wenigen Schüssen verfügt und verschiedene Aufgaben wie „Vervollständigung der Textbeschreibung, VQA / Text-VQA“ ausführt.

Derzeit haben multimodale große Modelle mehr Anwendungsmöglichkeiten gezeigt. Neben dem relativ ausgereiften Vincentian-Diagramm sind nacheinander zahlreiche Anwendungen wie Mensch-Computer-Interaktion, Robotersteuerung, Bildsuche und Spracherzeugung entstanden .

Zusammengenommen wird GPT-4 kein AGI sein, aber multimodale große Modelle sind bereits eine klare und eindeutige Entwicklungsrichtung. Die Etablierung eines einheitlichen, szenarioübergreifenden, multimodalen Basismodells mit mehreren Aufgaben wird zu einem der Mainstream-Trends in der Entwicklung künstlicher Intelligenz werden.

Hugo sagte: „Wissenschaft trifft im Endstadium auf Vorstellungskraft.“ Die Zukunft multimodaler Großmodelle könnte jenseits der menschlichen Vorstellungskraft liegen.

Das obige ist der detaillierte Inhalt vonLi Zhifei: Acht Beobachtungen zu GPT-4, der multimodale Großmodellwettbewerb beginnt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen

Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

Apr 26, 2024 am 10:19 AM

Docker schließt die lokale Bereitstellung des großen Open-Source-Modells LLama3 in drei Minuten ab

Apr 26, 2024 am 10:19 AM

Übersicht LLaMA-3 (LargeLanguageModelMetaAI3) ist ein groß angelegtes Open-Source-Modell für generative künstliche Intelligenz, das von Meta Company entwickelt wurde. Im Vergleich zur Vorgängergeneration LLaMA-2 gibt es keine wesentlichen Änderungen in der Modellstruktur. Das LLaMA-3-Modell ist in verschiedene Maßstabsversionen unterteilt, darunter kleine, mittlere und große, um unterschiedlichen Anwendungsanforderungen und Rechenressourcen gerecht zu werden. Die Parametergröße kleiner Modelle beträgt 8 B, die Parametergröße mittlerer Modelle beträgt 70 B und die Parametergröße großer Modelle erreicht 400 B. Beim Training besteht das Ziel jedoch darin, multimodale und mehrsprachige Funktionalität zu erreichen, und die Ergebnisse werden voraussichtlich mit GPT4/GPT4V vergleichbar sein. Ollama installierenOllama ist ein Open-Source-Großsprachenmodell (LL