Um das Design, die Einschränkungen und die Entwicklung zeitgenössischer groß angelegter Sprachmodelle zu verstehen, können Sie der Leseliste dieses Artikels folgen.

Groß angelegte Sprachmodelle haben die Aufmerksamkeit der Öffentlichkeit auf sich gezogen und in nur fünf Jahren haben Modelle wie Transforme den Bereich der Verarbeitung natürlicher Sprache fast vollständig verändert. Darüber hinaus beginnen sie, Bereiche wie Computer Vision und Computational Biology zu revolutionieren.

Angesichts der Tatsache, dass Transformer einen so großen Einfluss auf den Forschungsprozess aller haben, stellt Ihnen dieser Artikel eine kurze Leseliste für Forscher und Praktiker des maschinellen Lernens vor, die den Einstieg erleichtern sollen.

Die folgende Liste wird hauptsächlich in chronologischer Reihenfolge erweitert, hauptsächlich einige wissenschaftliche Forschungsarbeiten. Natürlich gibt es noch viele weitere hilfreiche Ressourcen. Zum Beispiel:

Wenn Sie neu bei Transformers und großen Sprachmodellen sind, dann sind diese Artikel am besten für Sie geeignet.

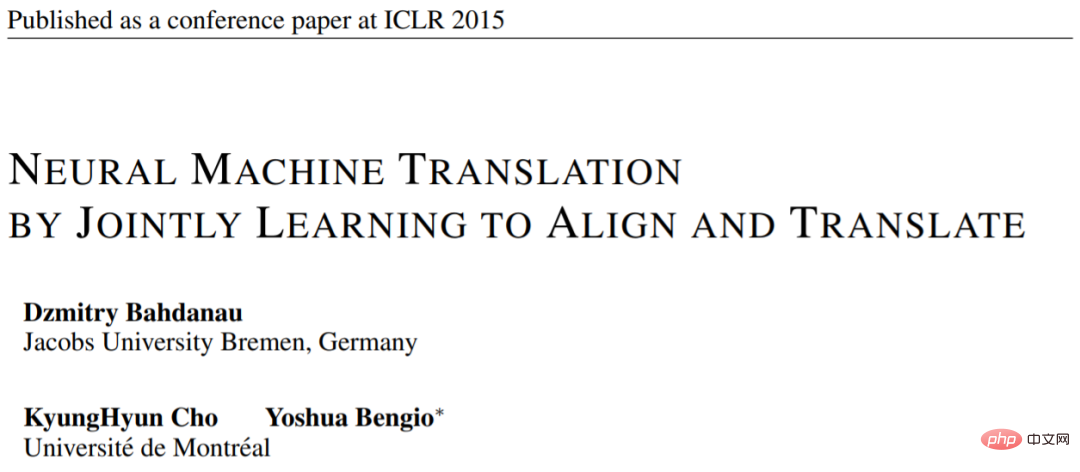

Aufsatz 1: „Neural Machine Translation by Jointly Learning to Align and Translate“

Aufsatzadresse: https://arxiv.org/pdf/1409.0473.pdf

Dieser Artikel stellt eine wiederkehrende neuronale The vor Der Aufmerksamkeitsmechanismus des Netzwerks (RNN) verbessert die Langstrecken-Sequenzmodellierungsfunktionen des Modells. Dadurch können RNNs längere Sätze genauer übersetzen – die Motivation hinter der Entwicklung der ursprünglichen Transformer-Architektur.

Bildquelle: https://arxiv.org/abs/1409.0473

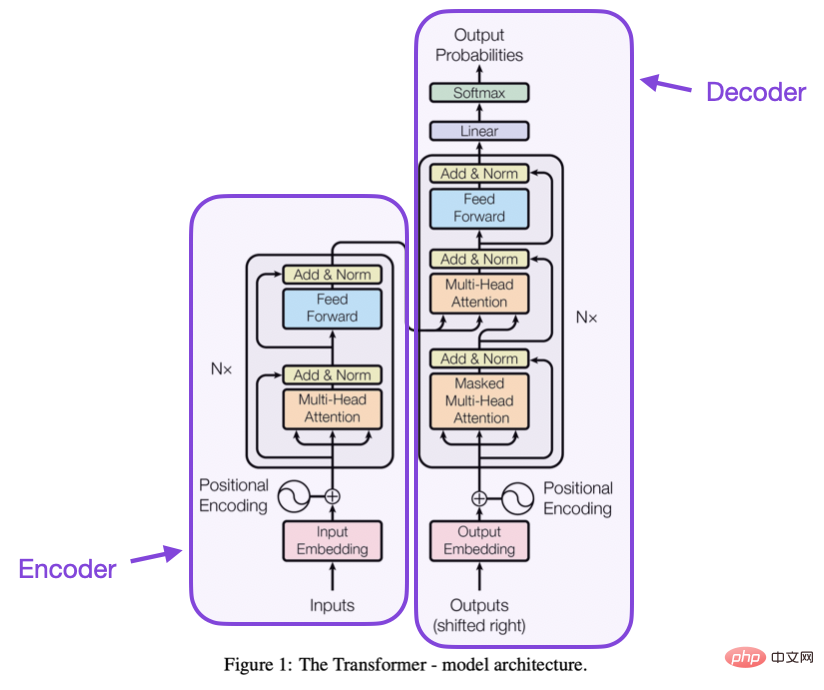

Papier 2: „Attention Is All You Need“

Papieradresse: https://arxiv.org /abs/1706.03762

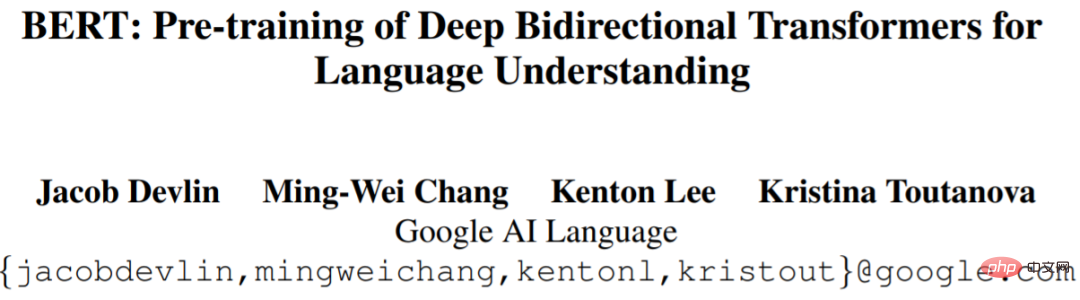

In diesem Artikel wird die ursprüngliche Transformer-Architektur bestehend aus Encoder und Decoder vorgestellt. Diese Teile werden in Zukunft als separate Module eingeführt. Darüber hinaus werden in diesem Artikel Konzepte wie Skalierungs-Punktprodukt-Aufmerksamkeitsmechanismen, Mehrkopf-Aufmerksamkeitsblöcke und Positionseingabekodierung vorgestellt, die nach wie vor die Grundlage moderner Transformer sind. Bildquelle: https://arxiv.org/abs/1706.03762 : https://arxiv.org/abs/1810.04805

Groß angelegte Sprachmodellforschung folgte der ursprünglichen Transformer-Architektur und begann sich dann in zwei Richtungen zu erweitern: Transformer für prädiktive Modellierungsaufgaben (z. B. Textklassifizierung) und Transformer für generative Konstruktionstransformator für modulare Aufgaben wie Übersetzung, Zusammenfassung und andere Formen der Texterstellung.

Bildquelle: https://arxiv.org/abs/1810.04805

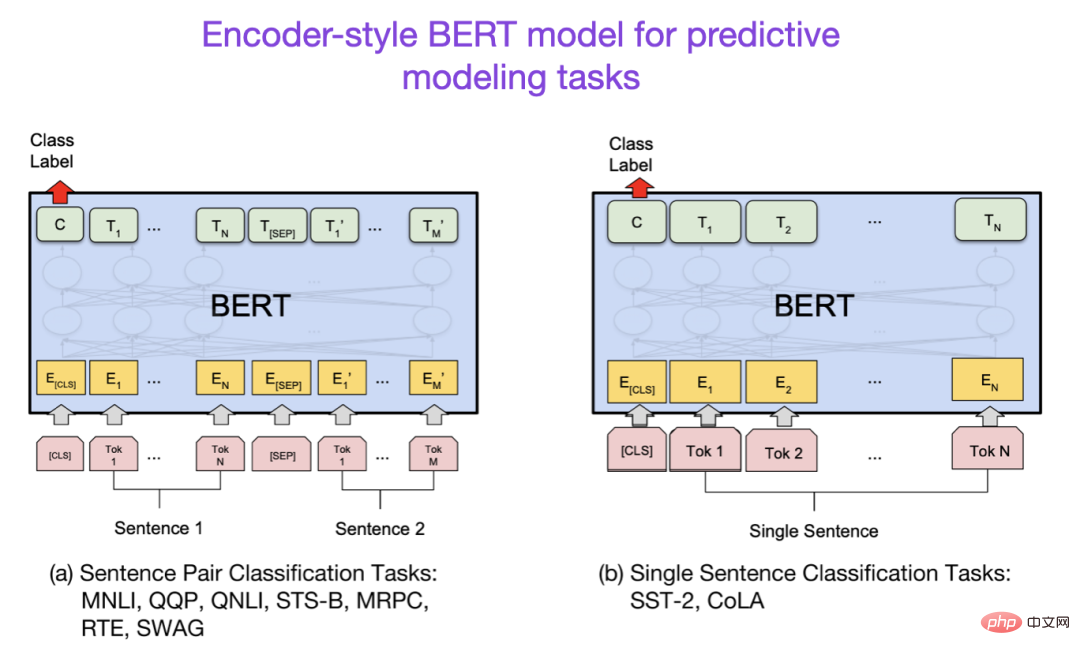

Papier 4: „Verbesserung des Sprachverständnisses durch generatives Pre-Training“

Papier 4: „Verbesserung des Sprachverständnisses durch generatives Pre-Training“

Papieradresse: https:// www.semanticsscholar.org/paper/Improving-Language-Understanding-by-Generative-Radford-Narasimhan/cd18800a0fe0b668a1cc19f2ec95b5003d0a5035

Das ursprüngliche GPT-Papier stellte die beliebte Decoder-Architektur und das Vortraining mit der Vorhersage des nächsten Wortes vor. BERT kann aufgrund seines maskierten Sprachmodells vor dem Training als ein bidirektionaler Transformer betrachtet werden, während GPT ein einseitig autoregressives Modell ist. Obwohl GPT-Einbettungen auch zur Klassifizierung verwendet werden können, bilden GPT-Methoden den Kern der heute einflussreichsten LLMs wie ChatGPT.

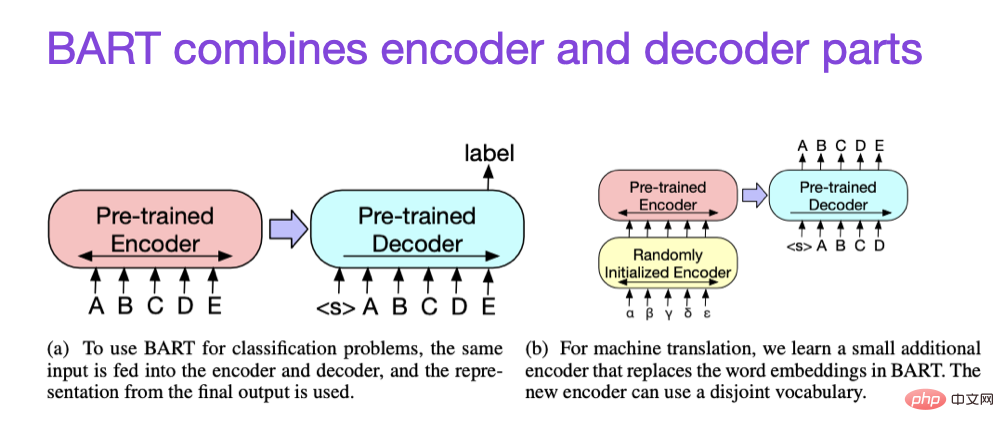

Papier 5: „BART: Denoising Sequence-to-Sequence Pre-training for Natural Language Generation, Translation, and Comprehension“

Papieradresse https://arxiv.org/abs/1910.13461.

Wie oben erwähnt, wird LLM im Encoder-Stil vom BERT-Typ normalerweise für prädiktive Modellierungsaufgaben bevorzugt, während LLM im Decoder-Stil vom GPT-Typ besser für die Textgenerierung geeignet ist. Um das Beste aus beiden Welten herauszuholen, kombiniert das obige BART-Papier die Encoder- und Decoder-Teile.

Wenn Sie mehr über die Technologie zur Verbesserung der Transformatoreffizienz erfahren möchten, können Sie sich das folgende Papier ansehen

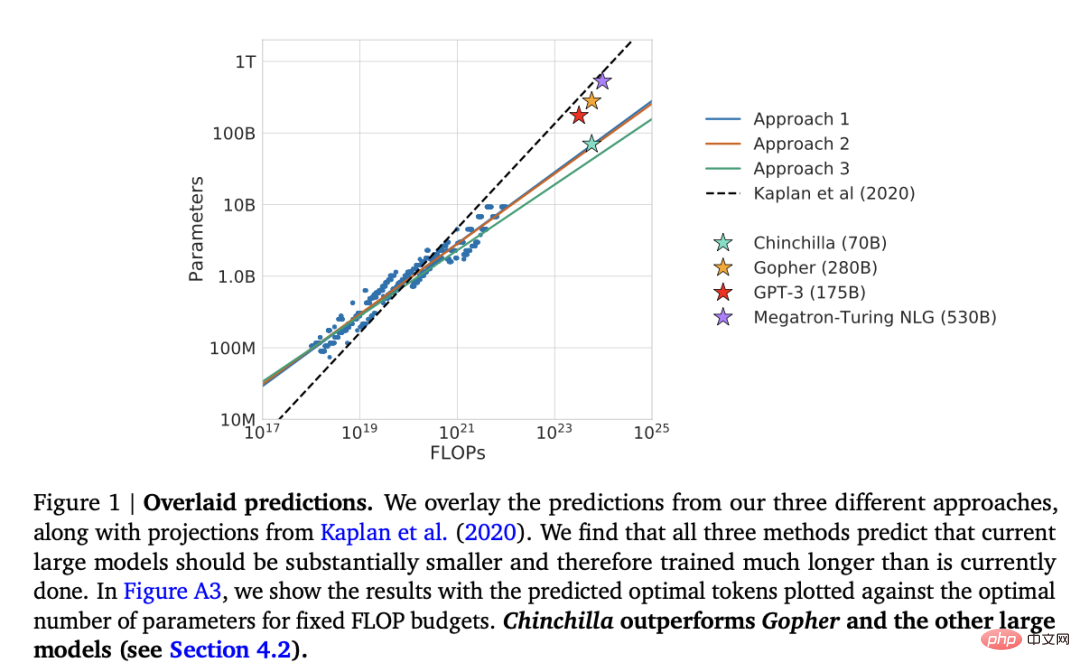

Darüber hinaus gibt es auch das Papier „Training Compute-Optimal Große Sprachmodelle“

Papieradresse: https://arxiv.org/abs/2203.15556

In diesem Papier wird das Chinchilla-Modell mit 70 Milliarden Parametern vorgestellt, das das beliebte GPT-3-Modell mit 175 Milliarden Parametern bei generativen Modellierungsaufgaben übertrifft. Das Hauptaugenmerk liegt jedoch darauf, dass zeitgenössische groß angelegte Sprachmodelle stark untertrainiert sind.

Dieser Artikel definiert das lineare Skalierungsgesetz für das Training großer Sprachmodelle. Obwohl Chinchilla beispielsweise halb so groß ist wie GPT-3, übertrifft es GPT-3, da es auf 1,4 Billionen (statt 300 Milliarden) Token trainiert wird. Mit anderen Worten: Die Anzahl der Trainingstoken ist genauso wichtig wie die Modellgröße.

Ausrichtung – Steuerung großer Sprachmodelle auf gewünschte Ziele und Interessen

In den letzten Jahren sind viele relativ leistungsstarke große Sprachmodelle entstanden, die echten Text generieren können (wie GPT-3 und Chinchilla). In Bezug auf häufig verwendete Paradigmen vor dem Training scheint eine Obergrenze erreicht zu sein.

Um das Sprachmodell für den Menschen hilfreicher zu machen und Fehlinformationen und schlechte Sprache zu reduzieren, haben Forscher zusätzliche Trainingsparadigmen entwickelt, um das vorab trainierte Grundmodell zu verfeinern, einschließlich der folgenden Artikel.

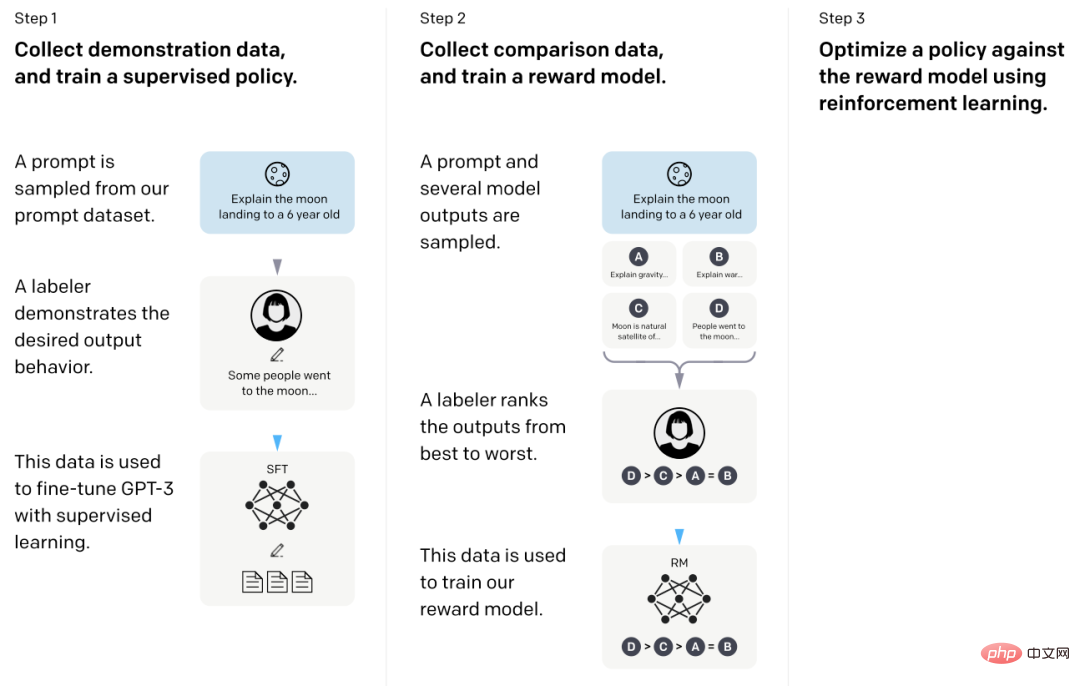

In diesem sogenannten InstructGPT-Aufsatz verwendeten Forscher RLHF (Reinforcement Learning). aus menschlichem Feedback). Sie begannen mit einem vorab trainierten GPT-3-Basismodell und verfeinerten es mithilfe von überwachtem Lernen weiter auf von Menschen generierte Hinweis-Antwort-Paare (Schritt 1). Als nächstes baten sie Menschen, die Modellergebnisse zu ordnen, um das Belohnungsmodell zu trainieren (Schritt 2). Schließlich verwenden sie das Belohnungsmodell, um das vorab trainierte und fein abgestimmte GPT-3-Modell mithilfe von Reinforcement Learning durch proximale Richtlinienoptimierung zu aktualisieren (Schritt 3).

Übrigens ist dieses Papier auch als das Papier bekannt, das die Ideen hinter ChatGPT beschreibt – aktuellen Gerüchten zufolge handelt es sich bei ChatGPT um eine erweiterte Version von InstructGPT, die auf einen größeren Datensatz abgestimmt ist.

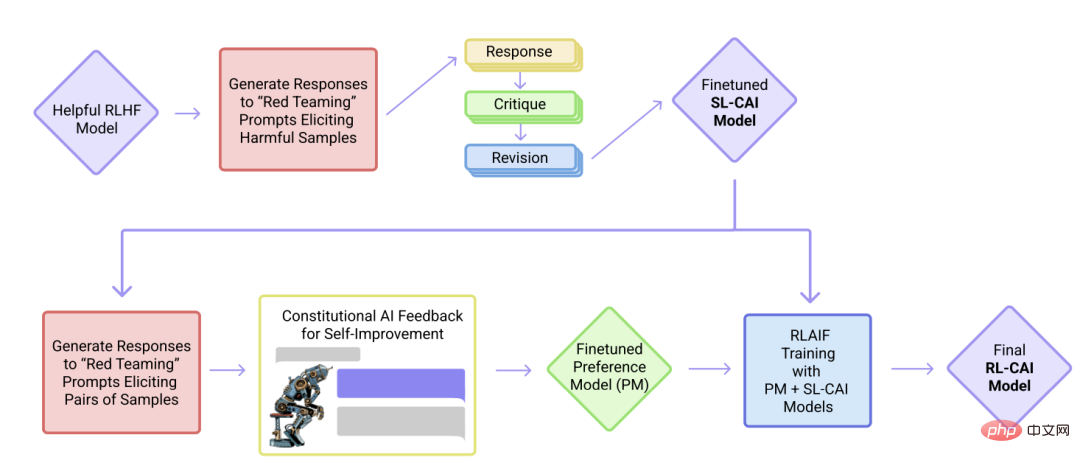

In diesem Papier treiben Forscher die Idee der Ausrichtung weiter voran und schlagen ein Training vor Mechanismus zur Schaffung „harmloser“ KI-Systeme. Die Forscher schlugen einen Selbsttrainingsmechanismus vor, der auf einer Liste von Regeln (von Menschen bereitgestellt) und nicht auf direkter menschlicher Aufsicht basiert. Ähnlich wie das oben erwähnte InstructGPT-Papier verwendet die vorgeschlagene Methode Methoden des verstärkenden Lernens.

In diesem Artikel wird versucht, die Anordnung der obigen Tabelle so einfach und schön wie möglich zu halten. Es wird empfohlen, sich auf die ersten 10 Artikel zu konzentrieren, um das Design, die Einschränkungen und die Entwicklung hinter zeitgenössischen Großformaten zu verstehen Sprachmodelle.

Wenn Sie ausführlicher lesen möchten, empfiehlt es sich, auf die Referenzen im obigen Artikel zu verweisen. Alternativ finden Sie hier einige zusätzliche Ressourcen, mit denen Leser weiter recherchieren können:

Open-Source-Alternativen zu GPT

Alternativen zu ChatGPT

Das obige ist der detaillierte Inhalt vonFür ein umfassendes Verständnis großer Sprachmodelle finden Sie hier eine Leseliste. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

die Funktionsnutzung

die Funktionsnutzung

Der Unterschied zwischen der Win10-Home-Version und der Professional-Version

Der Unterschied zwischen der Win10-Home-Version und der Professional-Version

Mindestkonfigurationsanforderungen für das Win10-System

Mindestkonfigurationsanforderungen für das Win10-System

Wie man Go-Sprache von Grund auf lernt

Wie man Go-Sprache von Grund auf lernt

So verwenden Sie die Dekodierfunktion

So verwenden Sie die Dekodierfunktion

Metasuchmaschine

Metasuchmaschine

Sequenznummer der zusammengeführten Zellenfüllung

Sequenznummer der zusammengeführten Zellenfüllung

Was soll ich tun, wenn sich mein Computer nicht einschalten lässt?

Was soll ich tun, wenn sich mein Computer nicht einschalten lässt?

ERR_CONNECTION_REFUSED

ERR_CONNECTION_REFUSED