Die Forschungsergebnisse zur Invers-Rendering-Technologie wurden zwei Jahre in Folge für die Top-Computer-Vision-Konferenz CVPR ausgewählt, und von der Verarbeitung eines einzelnen Bildes bis hin zur Abdeckung der gesamten Innenszene hat Rushis visuelle Algorithmus-Technologie-Grundlage im Bereich der dreidimensionalen Rekonstruktion Bestand anschaulich demonstriert worden.

Die dreidimensionale Rekonstruktion ist eines der aktuellen Themen in der Computer Vision (CV) und Computergrafik (CG). Dabei wird die CV-Technologie verwendet, um zweidimensionale Bilder realer Objekte und Szenen zu verarbeiten, die von Sensoren wie Kameras erfasst werden, um deren dreidimensional zu erhalten -dimensionale Modelle. Da verwandte Technologien immer ausgereifter werden, wird die 3D-Rekonstruktion zunehmend in vielen verschiedenen Bereichen eingesetzt, beispielsweise in Smart Homes, AR-Tourismus, autonomem Fahren und hochpräzisen Karten, Robotern, Stadtplanung, Rekonstruktion kultureller Relikte und Filmunterhaltung.

Typische 3D-Gesichtsrekonstruktion basierend auf 2D-Bildern. Bildquelle: 10.1049/iet-cvi.2013.0220

Die traditionelle dreidimensionale Rekonstruktion kann grob in fotometrische und geometrische Methoden unterteilt werden, während letztere die Helligkeitsänderungen von Pixeln analysiert, während letztere zur vollständigen Rekonstruktion auf Parallaxe basiert. In den letzten Jahren wurde maschinelles Lernen, insbesondere Deep-Learning-Technologie, eingesetzt und erzielte gute Ergebnisse bei der Merkmalserkennung, Tiefenschätzung usw. Obwohl einige aktuelle Methoden räumliche geometrische Modelle und Texturkarten verwenden, sieht die Szene fast genauso aus wie die reale Welt.

Es ist jedoch zu beachten, dass diese Methoden immer noch einige Einschränkungen aufweisen. Sie können nur die Erscheinungsbildeigenschaften der Szene wiederherstellen und keine tieferen Attribute wie Beleuchtung, Reflexionsvermögen und Rauheit in der Szene digitalisieren, geschweige denn diese tiefgreifend abfragen und bearbeiten Informationen. Aufgestanden. Dies führt auch dazu, dass sie nicht in PBR-Rendering-Assets konvertiert werden können, die von der Rendering-Engine verwendet werden können, und daher keine realistischen Rendering-Effekte erzeugen können. Wie können diese Probleme gelöst werden? Die Inverse-Rendering-Technologie ist nach und nach in das Blickfeld der Menschen gelangt.

Die Aufgabe des inversen Renderns wurde erstmals 1978 von der älteren Generation der Informatiker Barrow und Tenenbaum vorgeschlagen. Basierend auf der dreidimensionalen Rekonstruktion werden die intrinsischen Attribute der Szene wie Beleuchtung, Reflexionsvermögen, Rauheit und Metallizität weiter wiederhergestellt, um zu erreichen eine realistischere Darstellung. Die Zerlegung dieser Attribute aus Bildern ist jedoch äußerst instabil und unterschiedliche Attributkonfigurationen führen häufig zu ähnlichen Erscheinungsbildern. Mit der Weiterentwicklung des differenzierbaren Renderings und der impliziten neuronalen Darstellung haben einige Methoden gute Ergebnisse in kleinen objektzentrierten Szenen mit expliziten oder impliziten Prioritäten erzielt.

Allerdings ist die inverse Darstellung großer Innenszenen nicht gut gelöst. Es ist nicht nur schwierig, physikalisch sinnvolle Materialien in realen Szenen wiederherzustellen, sondern es ist auch schwierig, die Konsistenz mehrerer Perspektiven innerhalb der Szene sicherzustellen. Es gibt ein solches inländisches Technologieunternehmen, das sich intensiv mit der unabhängigen Forschung und Entwicklung von Kernalgorithmen beschäftigt und sich auf groß angelegte industrielle Anwendungen im Bereich der 3D-Rekonstruktion konzentriert – Realsee. Es hat das schwierige Thema des inversen Renderings im großen Maßstab vorangetrieben Innenszenen. Ein effizientes Multi-View-Inverse-Rendering-Framework. Das Papier wurde für die CVPR 2023-Konferenz angenommen. ?? Daten kann diese Methode umgekehrt spekulieren, um die intrinsischen Attribute der Szene wie Beleuchtung, Reflexionsvermögen, Rauheit usw. zu erhalten und die Beleuchtungs- und Materialleistung basierend auf der dreidimensionalen Rekonstruktion nahe an der realen Szene wiederherzustellen, was die Rekonstruktion verbessert Wirkung, Kosteneffizienz und Anwendungsdimensionen wie Anwendungsbereich wurden umfassend verbessert.

Dieser Artikel wird  Rushis Multi-View-Inverse-Rendering-Technologie für großformatige Innenszenen im Detail verstehen und eine detaillierte Analyse ihrer Vorteile liefern

Rushis Multi-View-Inverse-Rendering-Technologie für großformatige Innenszenen im Detail verstehen und eine detaillierte Analyse ihrer Vorteile liefern

Für großformatige Innenszenen

vor, die aus 3D-Netzen und HDR-Texturen besteht und jede Position der gesamten großen Innenszene effizient modelliert Beleuchtung für direkte und indirekte Beleuchtung mit unbegrenzter Helligkeit. Basierend auf TBL schlug Rushi außerdem eine „Mischbeleuchtungsdarstellung mit vorberechneter Bestrahlungsstärke“ vor, die die Effizienz erheblich verbesserte und das Rendering-Rauschen bei der Materialoptimierung reduzierte. Schließlich stellte Rushi eine „dreistufige Materialoptimierungsstrategie basierend auf Segmentierung“ vor, die die physikalische Mehrdeutigkeit von Materialien in komplexen, groß angelegten Innenszenen gut bewältigen kann.

Texturbasierte Beleuchtung (TBL)

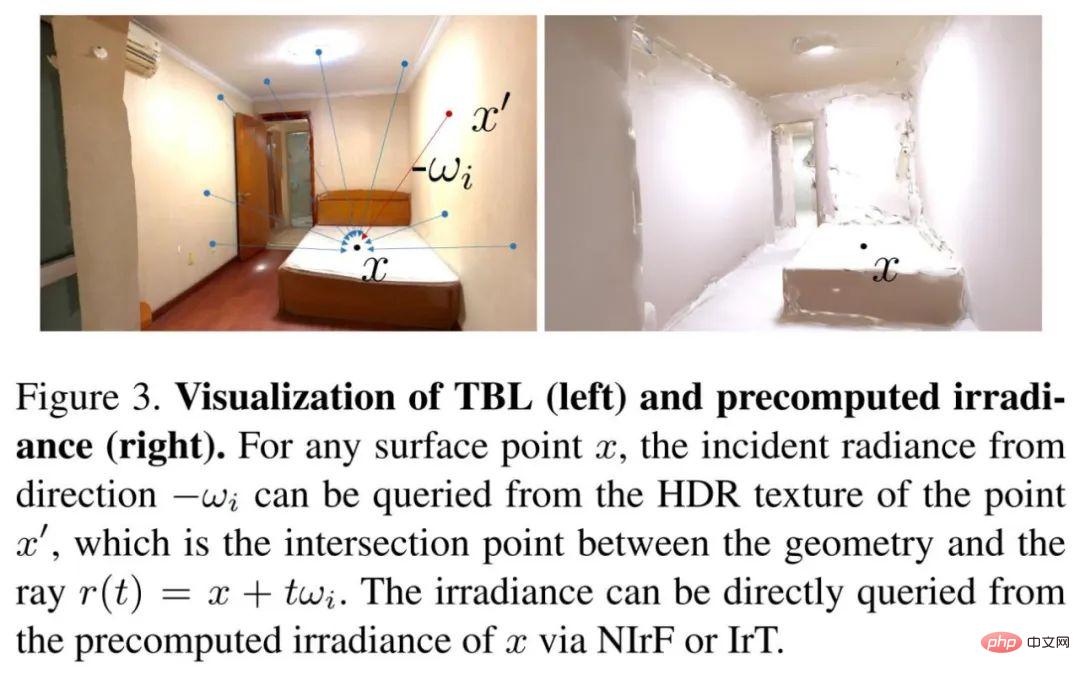

Bei der Darstellung der Beleuchtung großräumiger Innenszenen zeigen sich die Vorteile von TBL in der Kompaktheit der neuronalen Darstellung, der Interpretierbarkeit und räumlichen Konsistenz der globalen IBL-Beleuchtung und des parametrischen Lichts . Die TBL ist eine globale Darstellung der gesamten Szene und definiert die emittierte Bestrahlungsstärke aller Oberflächenpunkte. Die emittierte Bestrahlungsstärke eines Oberflächenpunkts entspricht normalerweise dem Wert der HDR-Textur, d. h. der beobachteten HDR-Bestrahlungsstärke des entsprechenden Pixels im eingegebenen HDR-Bild.

Rushi verwendet eine selbst entwickelte hochwertige 3D-Rekonstruktionstechnologie, um das Netzmodell der gesamten großen Szene zu rekonstruieren. Abschließend wird die HDR-Textur basierend auf dem eingegebenen HDR-Bild rekonstruiert und die globale Beleuchtung aus jeder Position und jeder Richtung durch die HDR-Textur abgefragt. Abbildung 3 unten (links) zeigt eine Visualisierung von TBL.

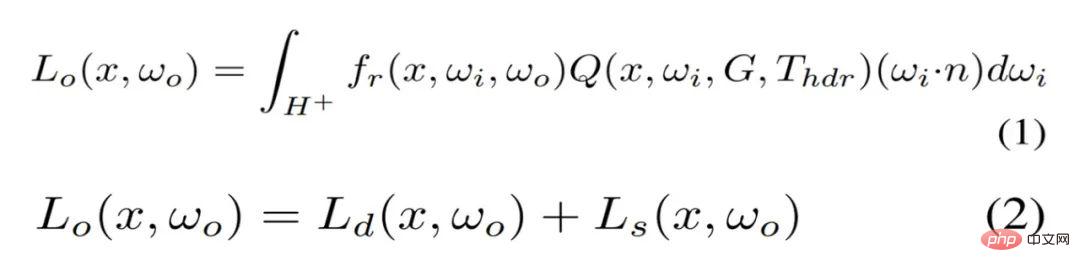

Gemischte Beleuchtungsdarstellung

In der Praxis gibt es Nachteile bei der direkten Verwendung von TBL zur Optimierung von Materialien. Die hohe Anzahl von Monte-Carlo-Proben führt zu hohen Rechen- und Speicherkosten. Da das meiste Rauschen in der diffusen Komponente auftritt, wird die Bestrahlungsstärke von Oberflächenpunkten für die diffuse Komponente vorberechnet. Die Einstrahlungsstärke kann so effizient abgefragt werden und ersetzt aufwändige Online-Berechnungen, wie in Abbildung 3 (rechts) dargestellt. Die TBL-basierte Rendering-Gleichung wird von Gleichung (1) in Gleichung (2) umgeschrieben.

Rushi schlägt zwei Darstellungen vor, um die vorberechnete Bestrahlungsstärke zu modellieren. Eines ist das Neural Irradiance Field (NIrF), ein flaches mehrschichtiges Perzeptron (MLP), das Oberflächenpunkte als Eingabe verwendet und die Bestrahlungsstärke p ausgibt. Die andere ist die Irradiance Texture (IrT), die der in der Computergrafik üblicherweise verwendeten Lichtkarte ähnelt.

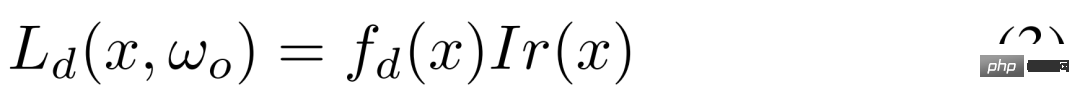

Wie Sie sehen können, diese gemischte Beleuchtungsdarstellung enthält eine vorberechnete Bestrahlungsstärke für die diffuse Komponente und eine Quell-TBL für die spiegelnde Komponente, wodurch das Rendering-Rauschen erheblich reduziert und eine effiziente Materialoptimierung erreicht wird. Die diffuse Komponente in Gleichung (2) wird wie in Gleichung (3) dargestellt modelliert.

Dreistufige Materialschätzung basierend auf Segmentierung

Für neuronale Materialien ist es schwierig, groß angelegte Szenen mit extrem komplexen Materialien zu modellieren, und es ist nicht für herkömmliche Grafik-Engines geeignet. Anstatt sich für eine explizite Materialtextur zu entscheiden, die die Geometrie direkt optimiert, wurde eine vereinfachte Version des Disney BRDF-Modells mit SV-Albedo und SV-Rauheit als Parametern verwendet. Aufgrund der spärlichen Beobachtungen führt die direkte Optimierung expliziter Materialtexturen jedoch zu inkonsistenter und nicht konvergenter Rauheit.

In diesem Zusammenhang nutzt Rushi Semantik- und Raumsegmentierungs-Prioritäten, um dieses Problem zu lösen, wobei semantische Bilder durch ein lernbasiertes Modell vorhergesagt werden und die Raumsegmentierung durch das Belegungsraster berechnet wird. Im Umsetzungsprozess verfolgt Rushi eine dreistufige Strategie.

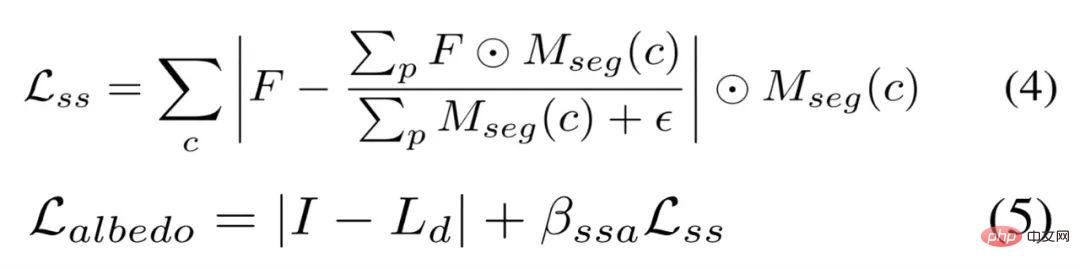

Die erste Stufe optimiert die spärliche Albedo basierend auf der Lambertschen Annahme, anstatt die Albedo wie in kleinen objektzentrierten Szenen auf eine Konstante zu initialisieren. Obwohl die diffuse Albedo direkt mit der Formel (3) berechnet werden kann, wird sie im hellen Bereich zu hell, was in der nächsten Stufe zu einer übermäßigen Rauheit führt. Daher verwenden wir, wie in Gleichung (4) unten gezeigt, semantische Glättungsbeschränkungen, um eine ähnliche Albedo bei derselben semantischen Segmentierung zu stimulieren. Die spärliche Albedo wird durch Gleichung (5) optimiert.

Sampling der zweiten Stufe auf Basis von Virtual Highlight (VHL) und semantikbasierter Ausbreitung. In Bildern mit mehreren Ansichten können nur spärliche spiegelnde Hinweise beobachtet werden, was zu einer insgesamt inkonsistenten Rauheit führt, insbesondere in großformatigen Szenen. Durch vorherige semantische Segmentierung kann jedoch eine angemessene Rauheit in den Hervorhebungsbereichen auf Bereiche mit derselben Semantik übertragen werden.

Rushi rendert das Bild zunächst basierend auf der Eingabepose mit einer Rauheit von 0,01, um die VHL-Regionen für jede Semantikklasse zu finden, und optimiert dann die Rauheit dieser VHLs basierend auf der eingefrorenen spärlichen Albedo und Beleuchtung. Eine angemessene Rauheit kann über Gleichung (6) in die gleiche semantische Segmentierung übertragen werden, und diese Rauheit kann über Gleichung (7) optimiert werden.

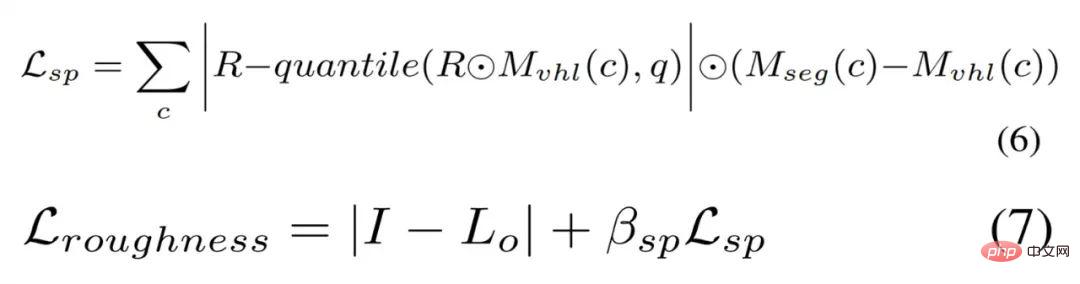

Die dritte Stufe der segmentierungsbasierten Feinabstimmung. RuShi optimiert alle Materialtexturen basierend auf semantischer Segmentierung und Raumsegmentierung. Insbesondere verwendet Rushi eine Glättungsbeschränkung ähnlich Gleichung (4) und eine Raumglättungsbeschränkung für Rauheit, um die Rauheit in verschiedenen Räumen weicher und glatter zu machen. Die Raumglättungsbeschränkung wird durch Gleichung (8) definiert, während keine Glättungsbeschränkung für die Albedo verwendet wird, wird der Gesamtverlust durch Gleichung (9) definiert.

Experimentelle Einstellungen und Effektvergleich

In Bezug auf den Datensatz verwendete Rushi zwei Datensätze: synthetischer Datensatz und realer Datensatz. Für Ersteres verwendete Rushi einen Pfadfinder, um eine zusammengesetzte Szene mit verschiedenen Materialien und Lichtern zu erstellen, wobei 24 Ansichten zur Optimierung und 14 neue Ansichten gerendert wurden, wobei für jede Ansicht Ground Truth-Materialbilder gerendert wurden. Aufgrund des Mangels an Full-HDR-Bildern in realen Datensätzen häufig verwendeter großformatiger Szenen wie Scannet, Matterport3D und Replica sammelte Rushi für Letzteres 10 Full-HDR-Realdatensätze und erfasste 10 bis 20 durch Zusammenführen von 7 Belichtungsreihen. Ein Full-HDR-Panoramabild.

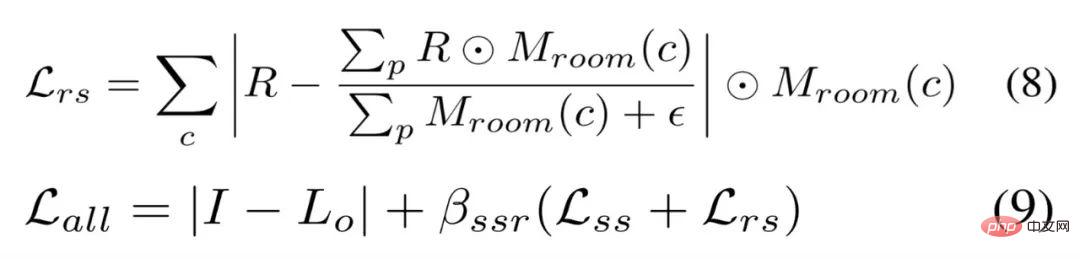

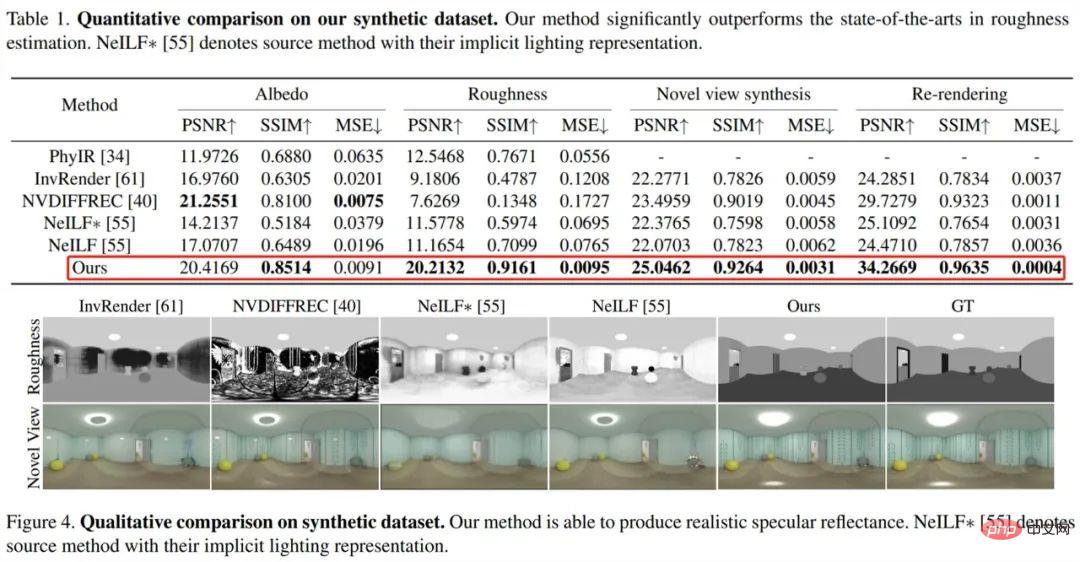

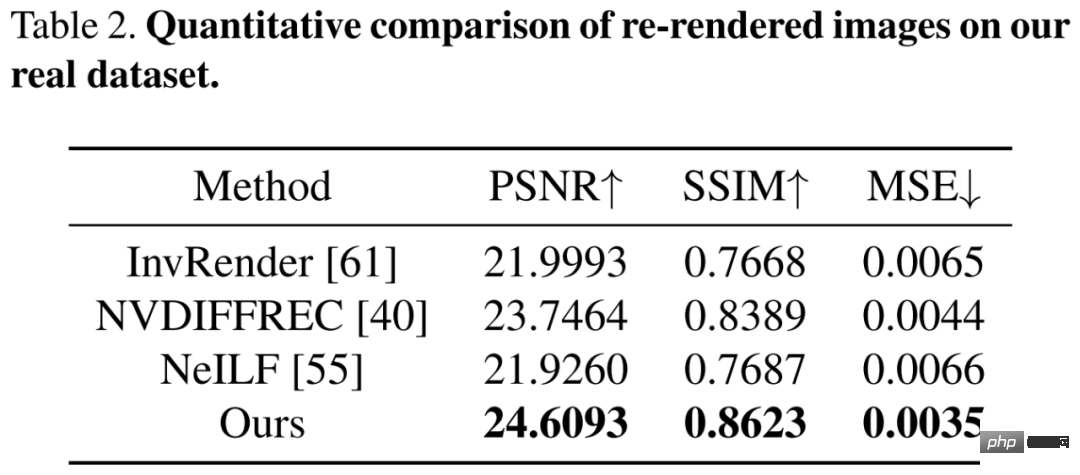

Über die Baseline-Methode. Zur Wiederherstellung von SVBRDFs aus Multi-View-Bildern großer Szenen gehören zu den aktuellen inversen Rendering-Methoden die lernbasierte Einzelbild-SOTA-Methode PhyIR, die objektzentrierte SOTA-Neural-Rendering-Methode mit mehreren Ansichten InvRender, NVDIFFREC und NeILF. In Bezug auf die „Bewertungsmetriken“ verwenden wir PSNR, SSIM und MSE, um Materialvorhersagen und neu gerenderte Bilder für einen quantitativen Vergleich auszuwerten, und verwenden MAE und SSIM, um neu beleuchtete Bilder zu bewerten, die durch verschiedene Beleuchtungsdarstellungen gerendert wurden. Sehen Sie sich zunächst die Auswertung des synthetischen Datensatzes an, wie in Tabelle 1 und Abbildung 4 unten dargestellt:

Die As-View-Methode übertrifft die SOTA-Methode bei der Rauheitsschätzung deutlich, und die Rauheit kann ein physikalisch vernünftiges Spiegelreflexionsvermögen erzeugen. Darüber hinaus reduziert NeILF mit visueller Hybridbeleuchtungsdarstellung im Vergleich zur ursprünglichen impliziten Darstellung die Mehrdeutigkeit zwischen Materialien und Beleuchtung.

Anschließend anhand eines anspruchsvollen realen Datensatzes mit komplexen Materialien und Beleuchtung ausgewertet. Die

Anschließend anhand eines anspruchsvollen realen Datensatzes mit komplexen Materialien und Beleuchtung ausgewertet. Die

. Obwohl diese Methoden ungefähre Fehler beim erneuten Rendern aufweisen, entkoppelt nur die visuelle Methode global konsistente und physikalisch einwandfreie Materialien.

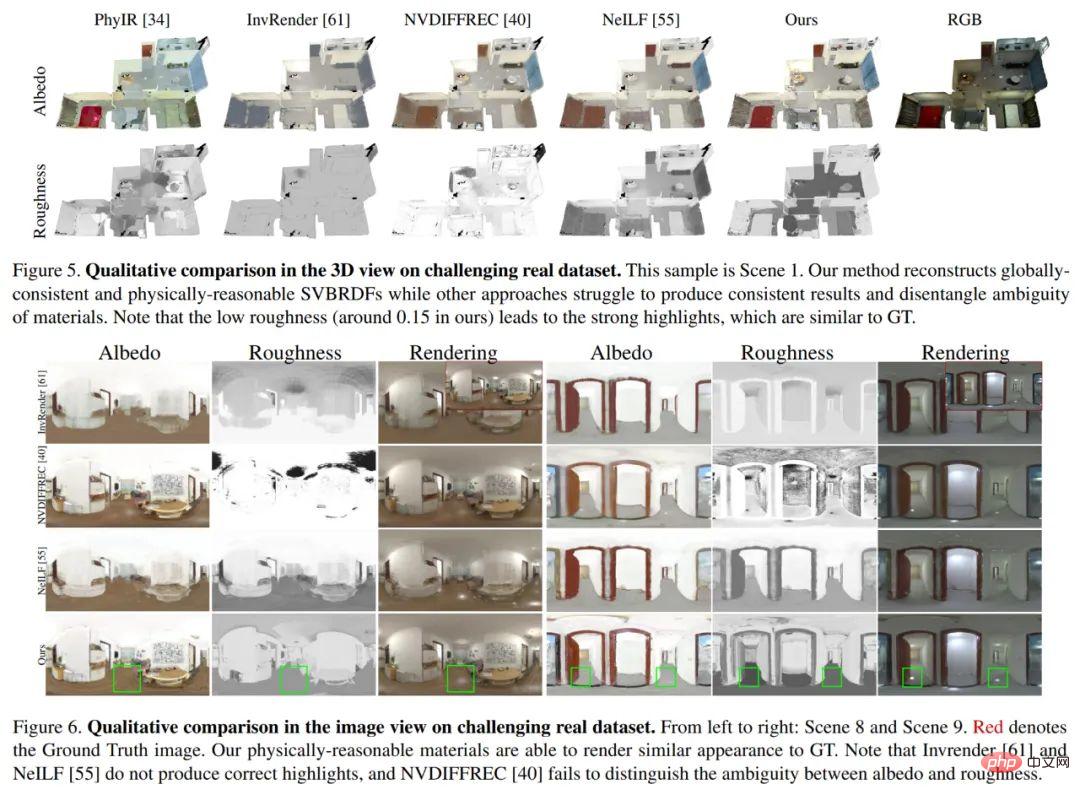

Abbildung 5 und Abbildung 6 unten zeigen einen qualitativen Vergleich

Abbildung 5 und Abbildung 6 unten zeigen einen qualitativen Vergleich

Ablationsexperimente

Ablationsexperimente

Um die Wirksamkeit seiner Beleuchtungsdarstellung und Materialoptimierungsstrategien zu demonstrieren, wie z. B. TBL, gemischte Beleuchtungsdarstellung, Albedo-Initialisierung in der ersten Stufe und Rauheitsschätzung in der zweiten Stufe. Die VHL-Probenahme und Die semantische Ausbreitung und die dritte Stufe der segmentierungsbasierten Feinabstimmung wurden für Ablationsexperimente durchgeführt.

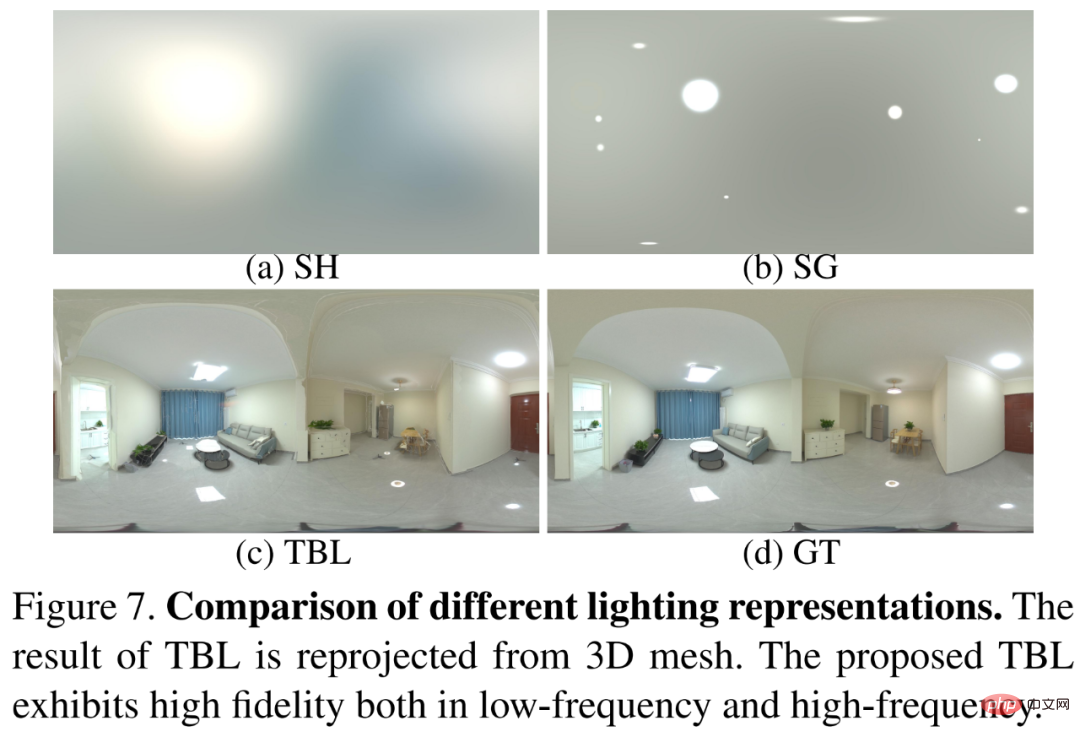

Zuerst wurde TBL mit den SH-Beleuchtungs- und SG-Beleuchtungsmethoden verglichen, die in früheren Methoden weit verbreitet sind. Die Ergebnisse sind in Abbildung 7 dargestellt. Wie in Abbildung 7 gezeigt, zeigt TBL eine hohe Wiedergabetreue sowohl im Niederfrequenz- als auch im Hochfrequenzbereich. Frequenzmerkmale.

Zweitens überprüfen Sie die Wirksamkeit der Darstellung mit gemischter Beleuchtung. Vergleichen Sie die Darstellung mit gemischter Beleuchtung mit der ursprünglichen TBL. Die Ergebnisse sind in Abbildung 8 unten dargestellt. Ohne eine gemischte Beleuchtungsdarstellung kann die Albedo Rauschen verursachen und langsam konvergieren. Die Einführung einer vorberechneten Bestrahlungsstärke ermöglicht die Verwendung hochauflösender Eingaben zur Rückgewinnung feiner Materialien und beschleunigt den Optimierungsprozess erheblich. Gleichzeitig erzeugt IrT im Vergleich zu NIrF eine feinere und artefaktfreie Albedo.

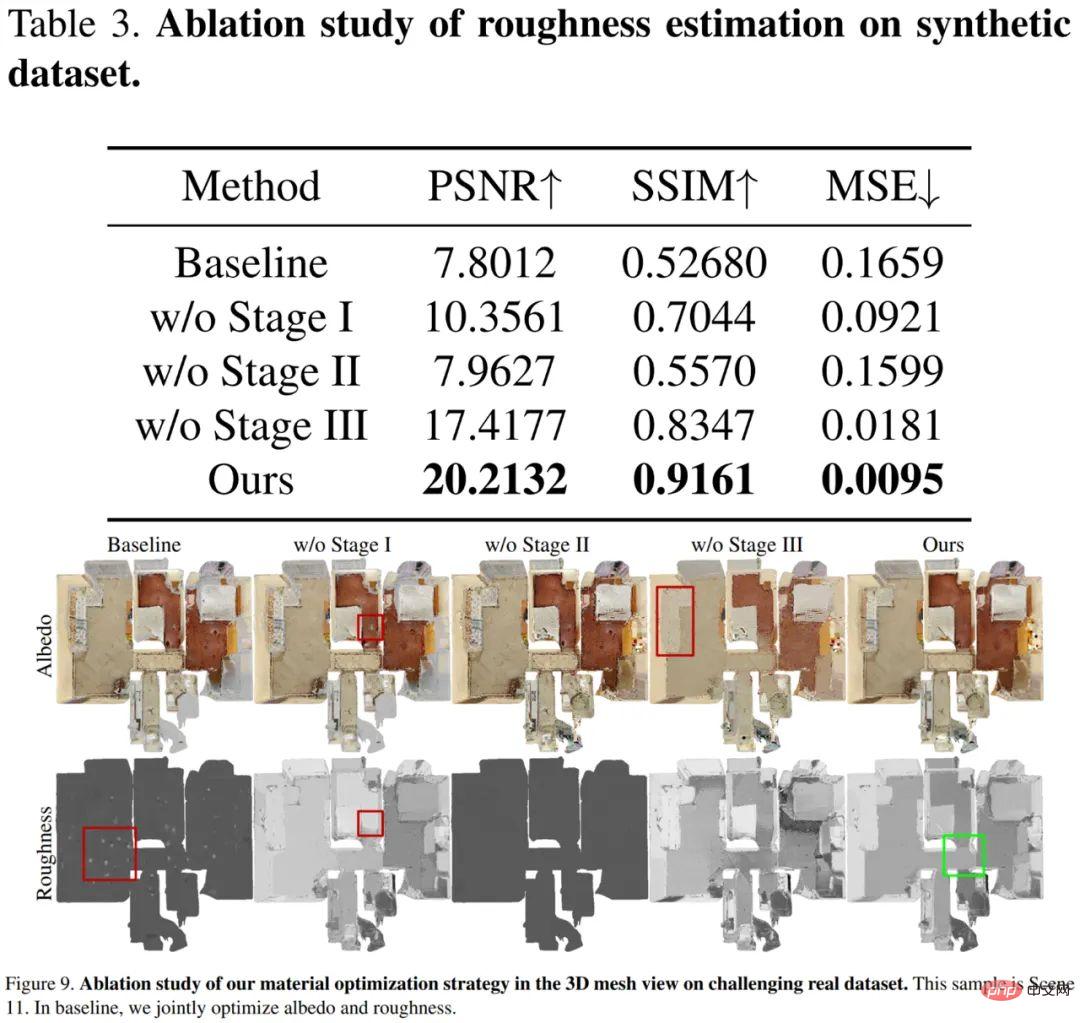

Schließlich wurde die Wirksamkeit der dreistufigen Strategie überprüft, und die Ergebnisse sind in Tabelle 3 und Abbildung 9 unten dargestellt. Die Grundlinienrauheit konvergiert nicht und nur die hervorgehobenen Bereiche werden aktualisiert. Ohne Albedo-Initialisierung in der ersten Stufe werden die hervorgehobenen Bereiche zu hell und führen zu einer falschen Rauheit. Die zweite Stufe der VHL-basierten Abtastung und der semantikbasierten Ausbreitung ist entscheidend, um eine angemessene Rauheit in Bereichen wiederherzustellen, in denen keine Glanzlichter beobachtet werden. Die dritte Stufe der segmentierungsbasierten Feinabstimmung erzeugt eine feine Albedo, wodurch die endgültige Rauheit glatter wird und eine Fehlerausbreitung der Rauheit zwischen verschiedenen Materialien verhindert wird.

Tatsächlich erzielte Rushi SOTA-Ergebnisse bei der Aufgabe des inversen Renderns eines einzelnen Bildes, indem er in seinem CVPR 2022-Artikel „PhyIR: Physics-based Inverse Rendering for Panoramic Indoor Images“ eine Trainingsmethode für neuronale Netze vorschlug. Jetzt erreicht das neue Inverse-Rendering-Framework nicht nur mehrere Perspektiven, das gesamte Haus, den gesamten Raum und die Szene, sondern behebt auch viele wesentliche Mängel früherer Inverse-Rendering-Methoden.

Zuallererst: Frühere Methoden, die auf dem Training synthetischer Daten basierten, zeigten in realen Szenarien keine gute Leistung. Rushis neues Deep-Inverse-Rendering-Framework führt zum ersten Mal eine „hierarchische Szene-Priorität“ ein. Durch mehrstufige Materialoptimierung und Kombination mit der weltweit größten dreidimensionalen räumlichen Datenbank werden im digitalen Raum von Rushi die Beleuchtung, das Reflexionsvermögen und das Licht kombiniert Der Raum wird analysiert. Physikalische Eigenschaften wie die Rauheit ermöglichen hierarchische und genaue Vorhersagen.

Die VorhersageergebnisseDie endgültige Ausgabe ist eine physikalisch sinnvolle und global konsistente Materialkarte mit mehreren Typen, die die tatsächlich von Rushi-Geräten erfassten Innenszenendaten nahtlos in digitale Rendering-Assets umwandelt und sich an alle aktuellen Mainstream-Rendering-Engines wie Unity und anpasst Blender, Dies ermöglicht die automatische Generierung von Szenen-Assets und physikalisch basierten MR-Anwendungen, wie z. B. Materialbearbeitung, Synthese neuer Ansichten, Neubeleuchtung, Einfügen virtueller Objekte usw. Dieses äußerst vielseitige digitale Asset trägt dazu bei, in Zukunft noch mehr unterschiedliche Anwendungen und Produkte zu unterstützen. Materialbearbeitung Um das Problem des inversen Renderings besser zu lösen und die Abhängigkeit von Trainingsdaten zu verringern, wurde in den letzten Jahren die differenzierbare Rendering-Methode vorgeschlagen, d. Geben Sie den Gradienten an die Rendering-Parameter weiter, und schließlich werden die zu lösenden Parameter auf der Grundlage der Physik durch Optimierung erhalten. Zu diesen Methoden gehören sphärisch-harmonische (SH) Beleuchtung [1] und dreidimensionale sphärische Gaußsche (VSG) Beleuchtung.

Allerdings weisen großflächige Innenszenen eine große Anzahl komplexer optischer Effekte wie Verdeckung und Schatten auf. Die Modellierung globaler Beleuchtung in differenzierbarer Darstellung bringt hohe Rechenkosten mit sich. Beispielsweise kann die diesmal vorgeschlagene TBL die globale Beleuchtung von Innenszenen effizient und genau darstellen und benötigt nur etwa 20 MB Speicher, während die dichte gitterbasierte VSG-Beleuchtung [2] etwa 1 GB Speicher und die spärliche gitterbasierte Beleuchtung benötigt SH-Beleuchtungsmethode Plenoxels [3] Es werden ca. 750 MB Speicher benötigt, und die Datenspeicherkapazität wurde Dutzende Male reduziert.

30 Minuten abschließen, während die herkömmliche Methode [4] etwa 12 Stunden

dauern kann, was einer vollständigen24-fachen Verbesserung entspricht. Die erhebliche Steigerung der Rechengeschwindigkeit bedeutet eine Reduzierung der Kosten und einen deutlichen Kosten-Leistungs-Vorteil, der uns der großtechnischen Praxisanwendung einen Schritt näher bringt.

Verbesserung entspricht. Die erhebliche Steigerung der Rechengeschwindigkeit bedeutet eine Reduzierung der Kosten und einen deutlichen Kosten-Leistungs-Vorteil, der uns der großtechnischen Praxisanwendung einen Schritt näher bringt.

Schließlich sind frühere NeRF-ähnliche neuronale Invers-Rendering-Methoden (wie PS-NeRF [5], NeRFactor [6] usw.) hauptsächlich auf kleine, auf Objekten zentrierte Szenen ausgerichtet und scheinen nicht in der Lage zu sein, große Szenen zu modellieren. skalierte Innenszenen. Basierend auf Rushis genauem digitalen Raummodell und der effizienten und genauen Darstellung gemischter Beleuchtung löst das neue Inverse-Rendering-Framework dieses Problem durch die Einführung semantischer Segmentierung und Raumsegmentierung Priors. In Bezug auf dieses neue Deep-Inverse-Rendering-Framework sagte Rushi-Chefwissenschaftler Pan Cihui: „Es erreicht wirklich eine tiefere Digitalisierung der realen Welt und löst das Problem, dass es mit früheren Inverse-Rendering-Methoden schwierig war, physikalisch vernünftige Materialien und Texturen in realen Szenen wiederherzustellen.“ Die Probleme der Beleuchtung und der Multi-View-Konsistenz haben der Anwendung von 3D-Rekonstruktion und MR mehr Fantasie verliehen. „

Erfassen Sie die Vorteile der Inverse-Rendering-Technologie hat eine Menge Technologie im Bereich der 3D-Rekonstruktion angesammelt und viel Energie in den Feinschliff und die Arbeit an der Implementierung verwandter Algorithmen investiert. Gleichzeitig leistet es große Unterstützung für die Forschung und Entwicklung von Spitzentechnologien und legt großen Wert auf die Eroberung führender Technologien in der Branche. Diese sind zu einer wichtigen Grundlage für RuShis 3D-Rekonstruktion realer Modelle und MR-Forschung, einschließlich dieser neuen Invers-Rendering-Technologie, geworden, haben Anerkennung in der internationalen akademischen Gemeinschaft gefunden und haben dazu beigetragen, dass RuShis Algorithmusfähigkeiten das weltweit führende Niveau in theoretischer Forschung und Technik erreicht haben Anwendungen. Diese Algorithmen und technischen Vorteile werden eine tiefere Digitalisierung der realen Welt erreichen und den Aufbau des digitalen Raums weiter beschleunigen. Derzeit hat Rushi Digital Space durch selbst entwickelte Sammelgeräte mehr als 27 Millionen Sammlungssätze in verschiedenen Ländern und unterschiedlichen Anwendungsszenarien gesammelt und eine Fläche von 2,274 Milliarden Quadratmetern abgedeckt. Rushi Digital Space wird auch seine Entwicklungsrichtung VR + Branchenintegration unterstützen und neue Entwicklungsmöglichkeiten für digitale Anwendungs-Upgrades für den gewerblichen Einzelhandel, Industrieanlagen, Kulturausstellungen, öffentliche Angelegenheiten, Heimdekoration, Immobilientransaktionen und andere Branchen wie VR-Hausbesichtigungen bieten , VR-Museum und mehr. Der von Rushi entwickelte KI-Marketingassistent Für die Integration von VR + Industrie liegt Rushis größter Vorteil im sich ständig weiterentwickelnden digitalen Rekonstruktionsalgorithmus und der Ansammlung massiver realer Daten, die ihm ein hohes technisches Niveau verleihen Barrieren und große Datenbarrieren. Teilweise können diese Algorithmen und Daten auch untereinander zirkulieren und so ihre Vorteile stetig erweitern. Gleichzeitig erleichtern die Barrieren von Daten und Algorithmen es Rushi, die Schwachstellen verschiedener Branchen anzugehen, einige technische Lösungen einzubringen und neue Modelle der Branchenentwicklung zu entwickeln. Die Errungenschaften der Inverse-Rendering-Technologie wurden zwei Jahre in Folge in CVPR aufgenommen, vor allem weil Rushi einen Unterschied in der MR-Richtung bewirken und eine gewisse Umsetzung in der Branche erreichen möchte. Rushi hofft, in Zukunft die Lücke zwischen realer VR und rein virtueller Simulation zu öffnen, die Integration von virtuell und real wirklich zu erreichen und mehr Branchenanwendungen zu entwickeln.

Das obige ist der detaillierte Inhalt vonDie Geschwindigkeit wird um das 24-fache erhöht und die inverse Darstellung großer Innenszenen kann in 30 Minuten abgeschlossen werden. Rushis Forschungsergebnisse wurden für CVPR 2023 ausgewählt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Welche Fähigkeiten sind erforderlich, um in der PHP-Branche zu arbeiten?

Einführung in die Bedeutung eines ungültigen Passworts

Einführung in die Bedeutung eines ungültigen Passworts

Vergleichende Analyse von iqooneo8 und iqooneo9

Vergleichende Analyse von iqooneo8 und iqooneo9

Eigenschaft mit linearem Gradienten

Eigenschaft mit linearem Gradienten

Einführung in das xmpp-Protokoll

Einführung in das xmpp-Protokoll

WirelessKeyview

WirelessKeyview

Was ist eine Fil-Münze?

Was ist eine Fil-Münze?

Was ist der Unterschied zwischen Sonnenfinsternis und Idee?

Was ist der Unterschied zwischen Sonnenfinsternis und Idee?