Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der Typ von Hangzhou Electronics ist der erste, der die GPT-Bildlesefunktion erhält. Eine einzige Karte kann den neuen SOTA-Code realisieren

Der Typ von Hangzhou Electronics ist der erste, der die GPT-Bildlesefunktion erhält. Eine einzige Karte kann den neuen SOTA-Code realisieren

Der Typ von Hangzhou Electronics ist der erste, der die GPT-Bildlesefunktion erhält. Eine einzige Karte kann den neuen SOTA-Code realisieren

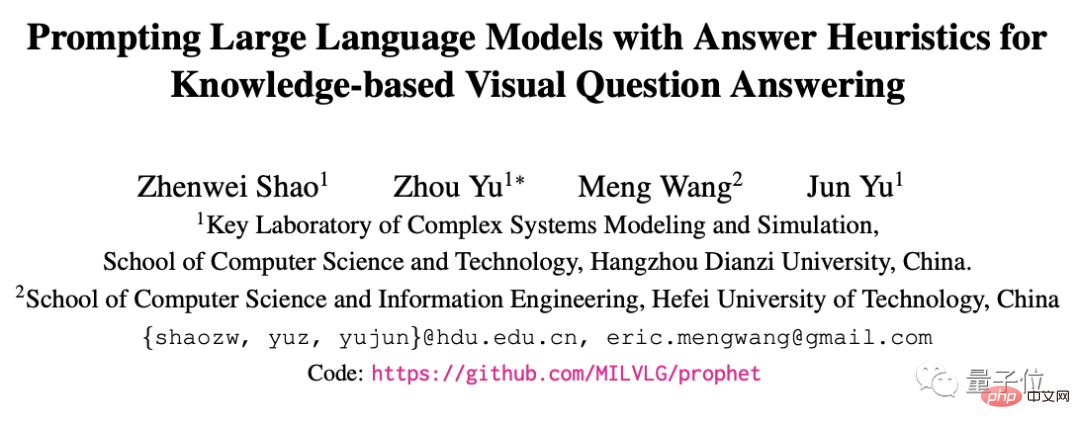

Dieses Papier wurde von CVPR2023 angenommen.

GPT-4, das Bilder lesen kann, wurde veröffentlicht! Aber man muss sich anstellen, um es nutzen zu können. . .

Warum probieren Sie das nicht zuerst aus?

Fügen Sie ein kleines Modell hinzu. Sie können große Sprachmodelle wie ChatGPT und GPT-3 erstellen, die nur Text leicht verstehen, Bilder lesen und alle Arten von kniffligen Details lösen können Kann mit einer Hand gekniffen werden. Und das Training dieses kleinen Modellskann mit einer einzigen Karte (einer RTX 3090) durchgeführt werden.

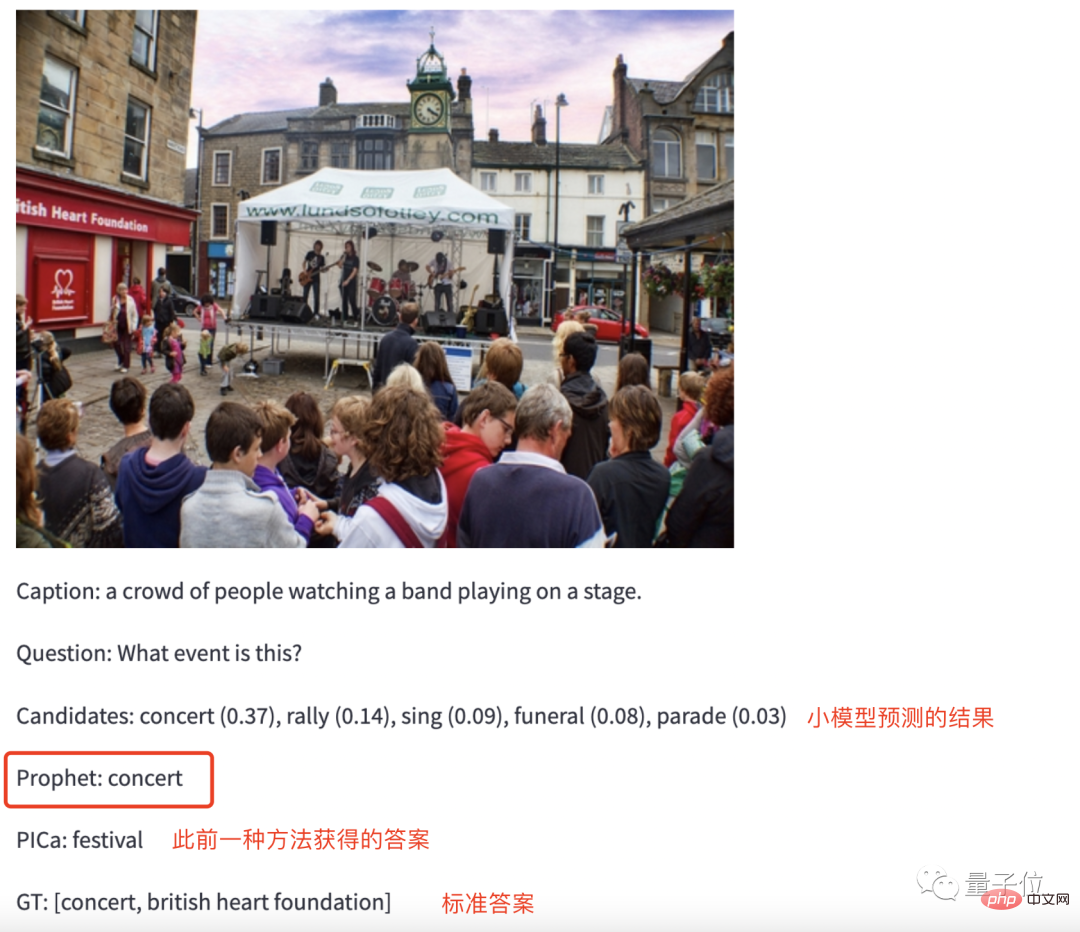

Für die Wirkung schauen Sie sich einfach das Bild an. Geben Sie beispielsweise ein Bild einer „Musikszene“ in den trainierten GPT-3 ein und fragen Sie ihn: Welche Aktivitäten finden am Tatort statt?

Ohne zu zögern gab GPT-3 die Antwort aufKonzert .

.

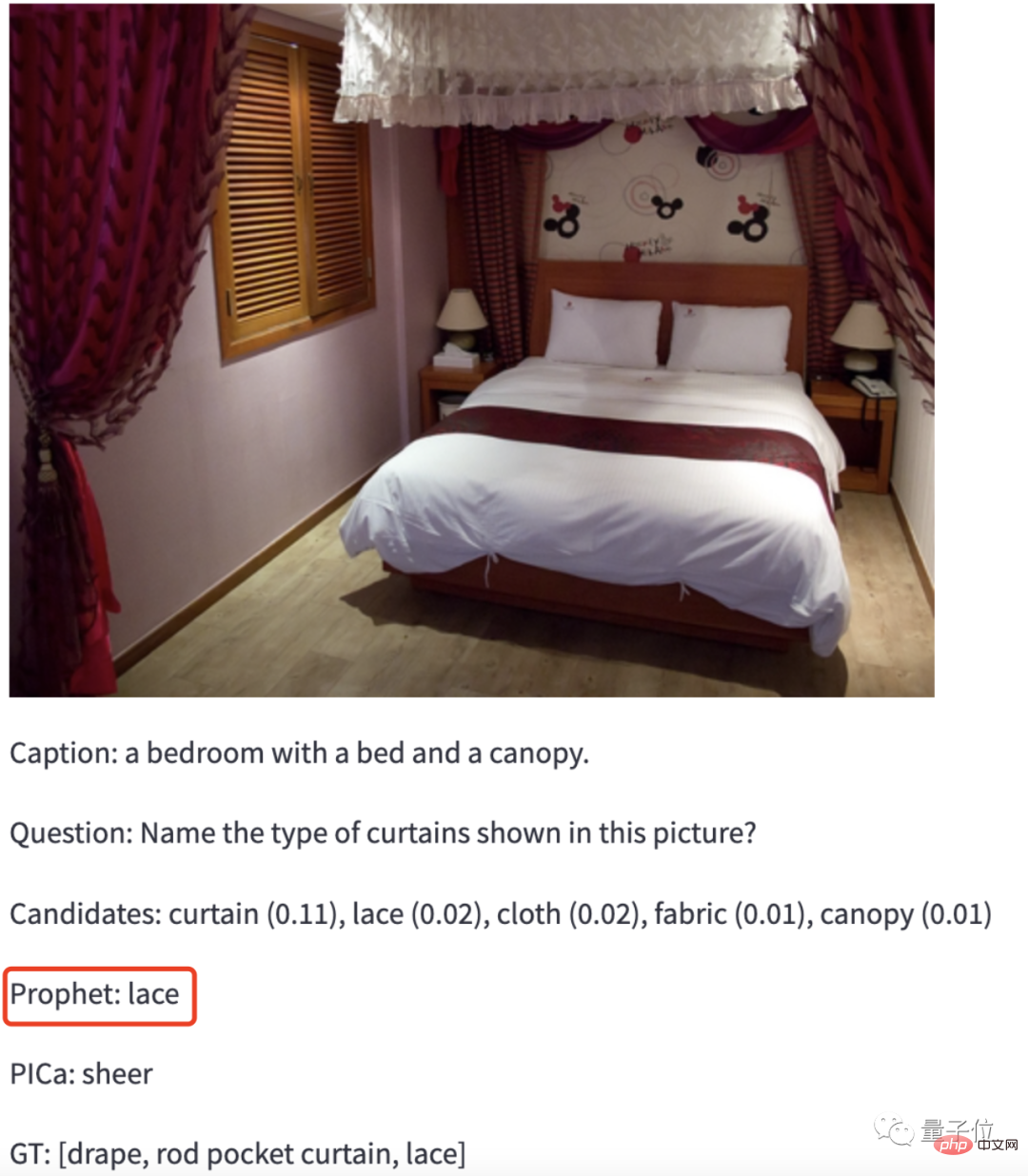

Um es schwieriger zu machen, geben Sie GPT-3 ein Foto von Jiang Zi und lassen Sie es erkennen, um welche Art von Material es sich bei dem Vorhang auf dem Foto handelt.

GPT-3:Spitze .

.

Bingo! (Es sieht so aus, als wäre etwas an ihm) Diese Methode ist die neueste Errungenschaft eines Teams der Hangzhou University of Electronic Science and Technology und der Hefei University of Technology:

ProphetSie haben diese Arbeit vor einem halben Jahr begonnen.

Der erste Autor der Arbeit ist der Absolvent der Hangzhou Dianzi University, als er 1 Jahr alt war. Er verpasste leider die Zhejiang University und entschied sich für die Hangzhou Dianzi University. das in der Nähe von zu Hause liegt. Dieses Papier wurde von CVPR2023 angenommen.

Erzielung neuer SOTA bei modalübergreifenden Aufgaben Schauen wir uns ohne weitere Umschweife direkt die Bildlesefunktionen von GPT-3 mit Unterstützung der Prophet-Methode an.

Schauen wir uns ohne weitere Umschweife direkt die Bildlesefunktionen von GPT-3 mit Unterstützung der Prophet-Methode an.

Werfen wir zunächst einen Blick auf die Testergebnisse des Datensatzes.

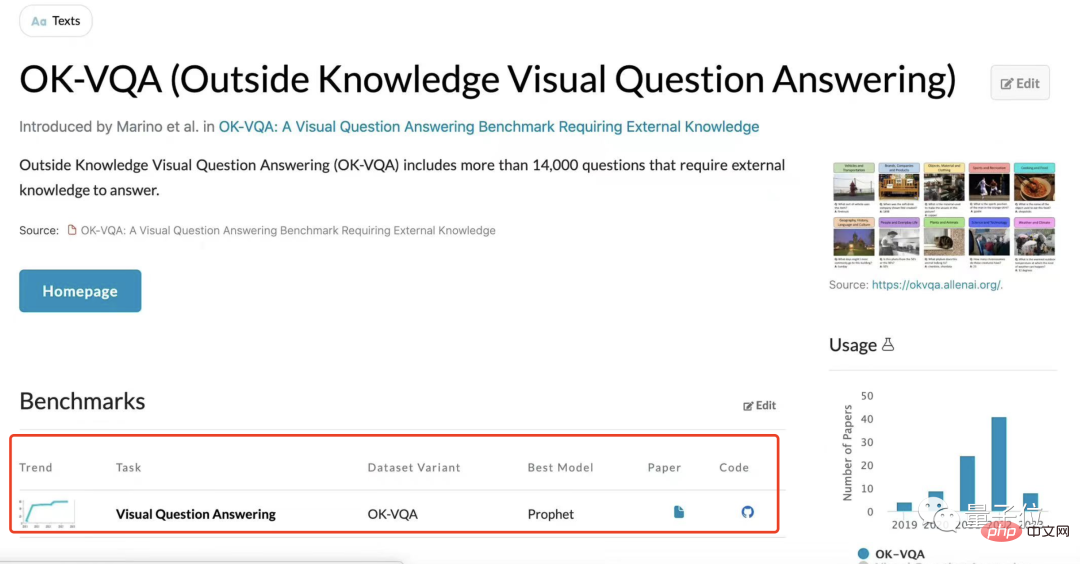

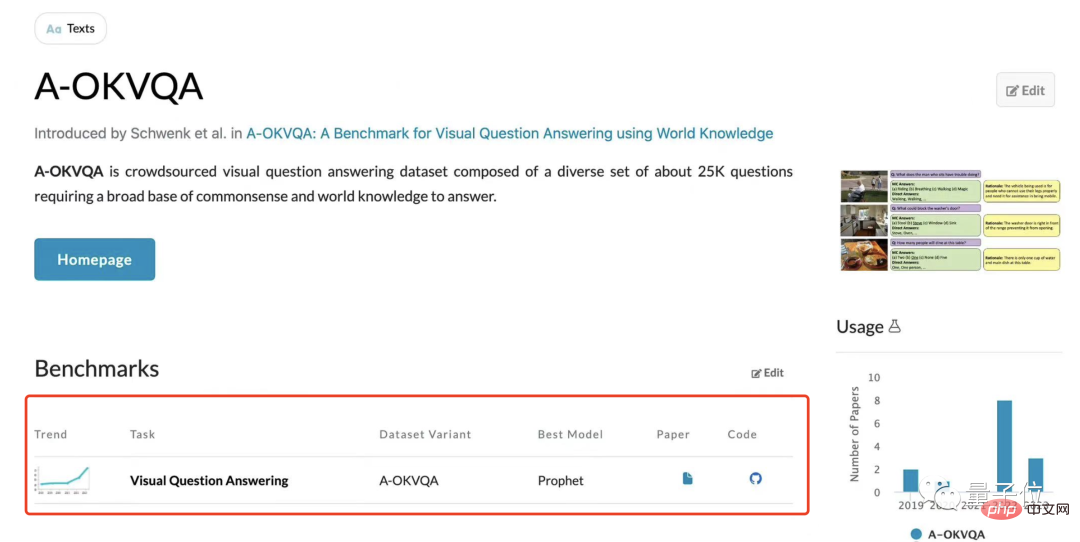

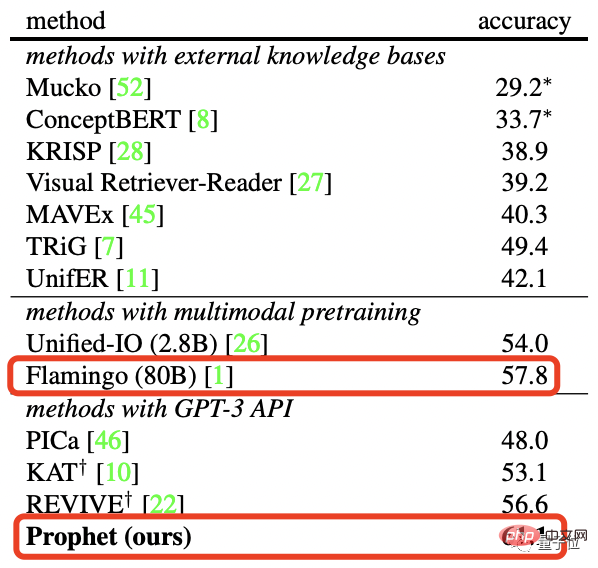

Das Forschungsteam testete Prophet anhand von zwei visuellen Frage- und Antwortdatensätzen, die auf externem Wissen basierten, OK-VQA und A-OKVQA, und beide erstellten „neues SOTA“.

Genauer gesagt erreichte Prophet im OK-VQA-Datensatz im Vergleich zu Deepminds großem Flamingo-Modell mit 80B-Parametern eine Genauigkeit von 61,1 % und schlug damit erfolgreich Flamingo (57,8 %).

Flamingo-80B muss

Flamingo-80B muss

auf

1536 TPUv4-Grafikkartentrainiert werden, während Prophet nur

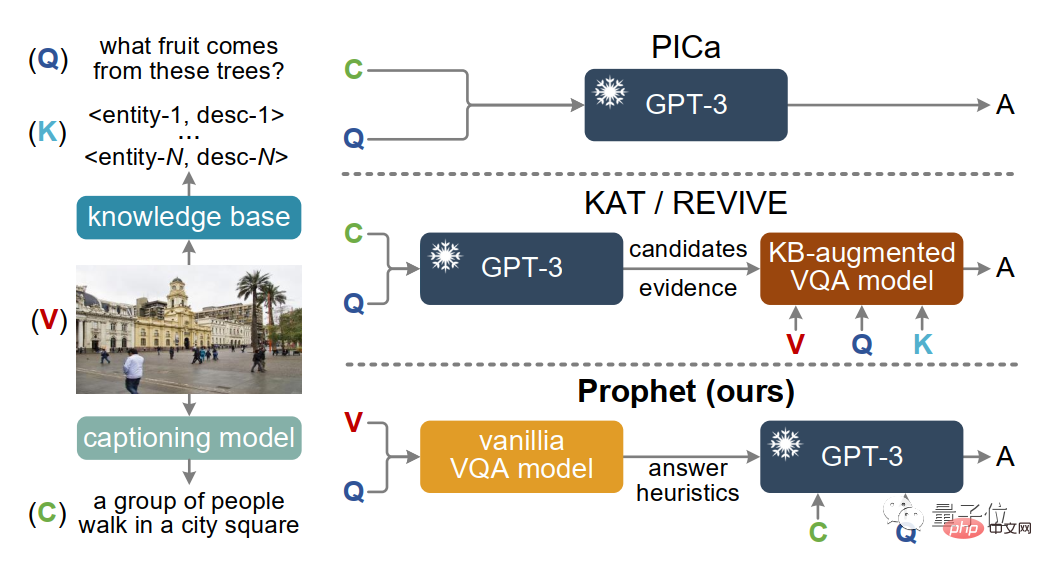

eine RTX-3090-Grafikkartebenötigt, um das VQA-Modell 4 Tage zu trainieren und dann die OpenAI-API aufzurufen bestimmte Anzahl von Malen. Tatsächlich wurden Methoden wie Prophet bereits früher verwendet, um GPT-3 bei der Bewältigung modalübergreifender Aufgaben wie PICa und später KAT und REVIVE zu unterstützen.

Allerdings kann es sein, dass sie mit einigen Details nicht zufriedenstellend umgehen können. Geben Sie mir eine Kastanie, lassen Sie sie gemeinsam das Bild unten lesen und beantworten Sie dann die Frage: Welche Art von Früchten wird der Baum auf dem Bild tragen?

Geben Sie mir eine Kastanie, lassen Sie sie gemeinsam das Bild unten lesen und beantworten Sie dann die Frage: Welche Art von Früchten wird der Baum auf dem Bild tragen?

Um dies zu erreichen, verlässt sich Prophet auf sein einzigartiges

Um dies zu erreichen, verlässt sich Prophet auf sein einzigartiges

.

Auch diese beiden Phasen haben eine klare Arbeitsteilung:

- Phase 1: Geben Sie auf der Grundlage der Fragen einige aufschlussreiche Antworten.

- Phase 2: Diese Antworten schränken den Spielraum ein, um GPT-3 ausreichend Raum zu geben, sein Potenzial auszuschöpfen.

Zunächst trainierte das Forschungsteam in der ersten Phase ein verbessertes MCAN-Modell (ein VQA-Modell) anhand eines spezifischen externen Wissens-VQA-Datensatzes.

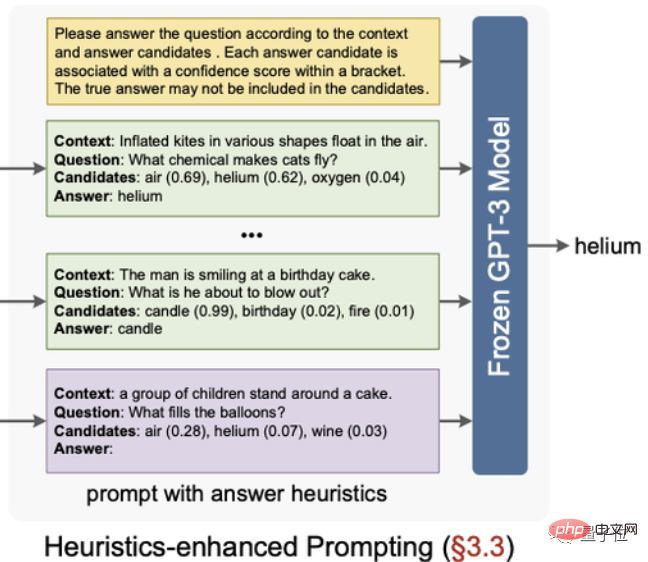

Extrahieren Sie nach dem Training des Modells zwei heuristische Antworten daraus: Antwortkandidaten und antwortbewusste Beispiele.

Unter diesen werden Antwortkandidaten basierend auf dem von der Modellklassifizierungsschicht ausgegebenen Konfidenzniveau sortiert und die Top 10 ausgewählt.

Antwortbewusstseinsbeispiel bezieht sich auf die Verwendung der Merkmale vor der Modellklassifizierungsschicht als potenzielle Antwortmerkmale der Stichprobe, der am ähnlichsten gekennzeichneten Stichprobe in diesem Merkmalsraum.

Der nächste Schritt ist die zweite Stufe. Dieser Schritt ist relativ einfach und grob.

Organisieren Sie die im vorherigen Schritt erhaltenen „inspirierenden Antworten“ in Eingabeaufforderungen, geben Sie die Eingabeaufforderungen dann in GPT-3 ein und vervollständigen Sie die visuellen Fragen und Antworten unter bestimmten Eingabeaufforderungen.

Obwohl im vorherigen Schritt einige Antworthinweise gegeben wurden, bedeutet dies nicht, dass GPT-3 auf diese Antworten beschränkt ist.

Wenn die Zuverlässigkeit der durch die Eingabeaufforderung gegebenen Antwort zu gering ist oder die richtige Antwort nicht in diesen Eingabeaufforderungen enthalten ist, ist es für GPT-3 durchaus möglich, eine neue Antwort zu generieren.

Forschungsteam

Natürlich muss neben den Forschungsergebnissen auch das Team hinter dieser Studie erwähnt werden.

Der erste AutorShao Zhenwei wurde mit „Progressiver spinaler Muskelatrophie“ diagnostiziert. Es handelt sich um eine Behinderung ersten Grades der Gliedmaßen. Er braucht alles Fürs Leben und Studium kümmerte er sich um seine Mutter.

Trotz seiner körperlichen Einschränkungen hat Shao Zhenweis Wissensdurst jedoch nicht nachgelassen.

Bei der Hochschulaufnahmeprüfung 2017 erzielte er eine hohe Punktzahl von 644 Punkten und wurde mit dem ersten Platz in das Hauptfach Computer der Hangzhou University of Electronic Science and Technology aufgenommen.

Während dieser Zeit gewann er auch Auszeichnungen wie den Chinese College Student Self-improvement Star 2018, das National Scholarship 2020 und den Outstanding Graduate der Zhejiang Province 2021.

Bereits während seines Grundstudiums hatte Shao Zhenwei begonnen, bei Professor Yu Zhou wissenschaftliche Forschungsaktivitäten durchzuführen.

Im Jahr 2021 hatte Shao Zhenwei eine zufällige Begegnung mit der Zhejiang-Universität, als er sich auf die Beförderung zur Graduiertenschule vorbereitete, also blieb er an der Schule und schloss sich der Forschungsgruppe von Professor Yu Zhou an, um einen Master-Abschluss zu machen Jahr der Graduiertenschule, und seine Forschungsrichtung ist modalübergreifendes Lernen.

Professor Yu Zhou ist der zweite Autor und korrespondierende Autor dieser Forschungsarbeit. Er ist der jüngste Professor an der School of Computer Science der Hangzhou Dianping University und stellvertretender Direktor des Labors „Complex System Modeling and Simulation“. Ministerium für Bildung.

Yu Zhou ist seit langem auf die Richtung „multimodale Intelligenz“ spezialisiert und hat das Forschungsteam viele Male zum Gewinn der Meisterschaft und des zweiten Platzes im internationalen visuellen Frage-Antwort-Wettbewerb VQA Challenge geführt.

sind im Hangzhou Electronics Media Intelligence Laboratory (MIL). Das Labor wird von Professor Yu Jun geleitet, einem landesweit herausragenden Wissenschaftler. In den letzten Jahren hat das Labor eine Reihe hochrangiger Konferenzbeiträge (TPAMI, IJCV, CVPR usw.) veröffentlicht, die sich auf multimodales Lernen konzentrieren. und hat mehrfach die beste Auszeichnung bei IEEE-Journalkonferenzen gewonnen.

Das Labor war Gastgeber von mehr als 20 nationalen Projekten wie dem National Key R&D Plan und der National Natural Science Foundation of China. Es hat den ersten Preis des Zhejiang Province Natural Science Award und den zweiten Preis des Educational Natural Science Award gewonnen.

Das obige ist der detaillierte Inhalt vonDer Typ von Hangzhou Electronics ist der erste, der die GPT-Bildlesefunktion erhält. Eine einzige Karte kann den neuen SOTA-Code realisieren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Mark Cerny, Chefarchitekt von SonyInteractiveStonterment (Siey Interactive Entertainment), hat weitere Hardware-Details der Host-PlayStation5pro (PS5PRO) der nächsten Generation veröffentlicht, darunter ein auf Performance verbessertes Amdrdna2.x-GPU und ein maschinelles Lernen/künstliches Intelligenzprogramm Code-genannt "Amethylst" mit Amd. Der Fokus der PS5PRO-Leistungsverbesserung liegt immer noch auf drei Säulen, darunter eine leistungsstärkere GPU, eine fortschrittliche Ray-Tracing und eine von KI betriebene PSSR-Superauflösung. GPU nimmt eine maßgeschneiderte AMDRDNA2 -Architektur an, die Sony RDNA2.x nennt, und es hat eine rDNA3 -Architektur.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Die Zookeper -Leistungsstimmung auf CentOS kann von mehreren Aspekten beginnen, einschließlich Hardwarekonfiguration, Betriebssystemoptimierung, Konfigurationsparameteranpassung, Überwachung und Wartung usw. Hier finden Sie einige spezifische Tuning -Methoden: SSD wird für die Hardwarekonfiguration: Da die Daten von Zookeeper an Disk geschrieben werden, wird empfohlen, SSD zu verbessern, um die I/O -Leistung zu verbessern. Genug Memory: Zookeeper genügend Speicherressourcen zuweisen, um häufige Lesen und Schreiben von häufigen Festplatten zu vermeiden. Multi-Core-CPU: Verwenden Sie Multi-Core-CPU, um sicherzustellen, dass Zookeeper es parallel verarbeiten kann.

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Effizientes Training von Pytorch -Modellen auf CentOS -Systemen erfordert Schritte, und dieser Artikel bietet detaillierte Anleitungen. 1.. Es wird empfohlen, YUM oder DNF zu verwenden, um Python 3 und Upgrade PIP zu installieren: Sudoyumupdatepython3 (oder sudodnfupdatepython3), PIP3Install-upgradepip. CUDA und CUDNN (GPU -Beschleunigung): Wenn Sie Nvidiagpu verwenden, müssen Sie Cudatool installieren

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Endlich verändert! Microsoft Windows -Suchfunktion wird ein neues Update einleiten

Apr 13, 2025 pm 11:42 PM

Endlich verändert! Microsoft Windows -Suchfunktion wird ein neues Update einleiten

Apr 13, 2025 pm 11:42 PM

Die Verbesserungen von Microsoft an Windows -Suchfunktionen wurden auf einigen Windows -Insider -Kanälen in der EU getestet. Zuvor wurde die integrierte Windows -Suchfunktion von Benutzern kritisiert und hatte schlechte Erfahrung. Dieses Update teilt die Suchfunktion in zwei Teile auf: lokale Suche und Bing-basierte Websuche, um die Benutzererfahrung zu verbessern. Die neue Version der Suchschnittstelle führt standardmäßig lokale Dateisuche durch. Wenn Sie online suchen müssen, müssen Sie auf die Registerkarte "Microsoft Bingwebsearch" klicken, um zu wechseln. Nach dem Umschalten wird in der Suchleiste "Microsoft Bingwebsearch:" angezeigt, in dem Benutzer Keywords eingeben können. Dieser Schritt vermeidet effektiv das Mischen lokaler Suchergebnisse mit Bing -Suchergebnissen