Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum

„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum

„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum

ChatGPT versteht auch menschliche Tricks, wenn es um die Generierung von Zufallszahlen geht.

ChatGPT ist vielleicht ein Bullshit-Künstler und ein Verbreiter von Fehlinformationen, aber es ist kein „Mathematiker“!

Kürzlich hat Colin Fraser, ein Datenwissenschaftler bei Meta, herausgefunden, dass ChatGPT keine echten Zufallszahlen generieren kann, sondern eher „menschlichen Zufallszahlen“ ähnelt.

Durch Experimente kam Fraser zu dem Schluss: „ChatGPT mag die Zahlen 42 und 7 sehr.“

Netizens sagten, dass dies bedeutet, dass Menschen diese Zahlen sehr mögen.

ChatGPT liebt auch „Die ultimative Antwort auf das Universum“

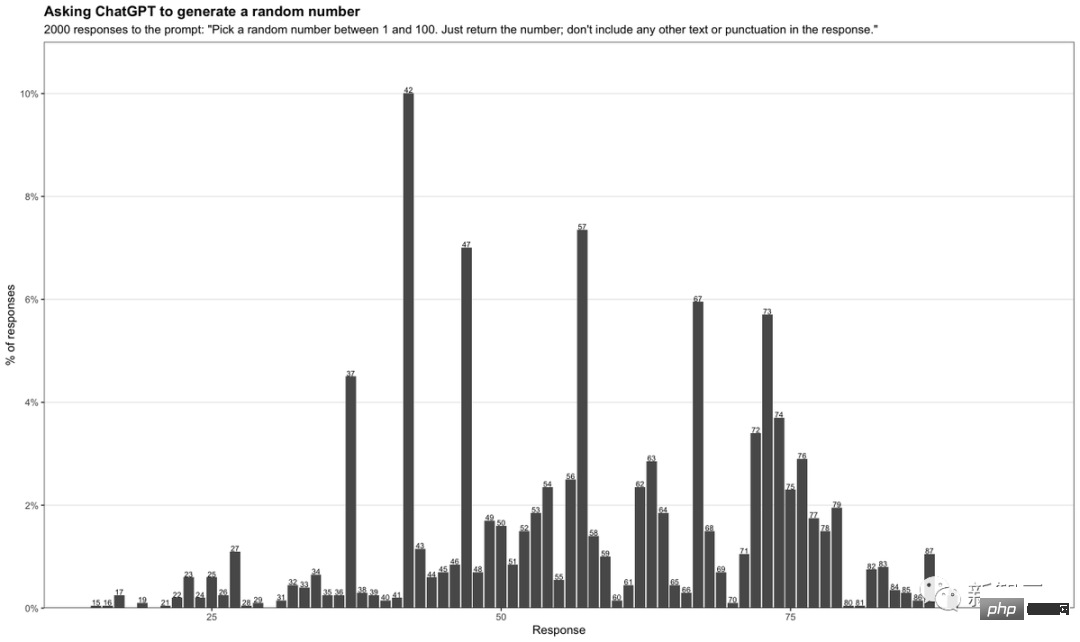

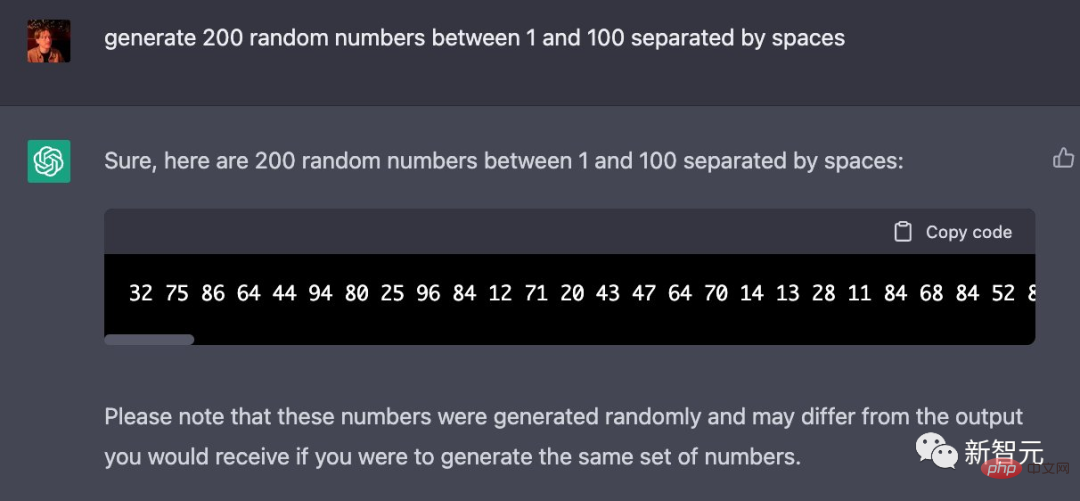

In seinem Test gab Fraser die Eingabeaufforderung wie folgt ein:

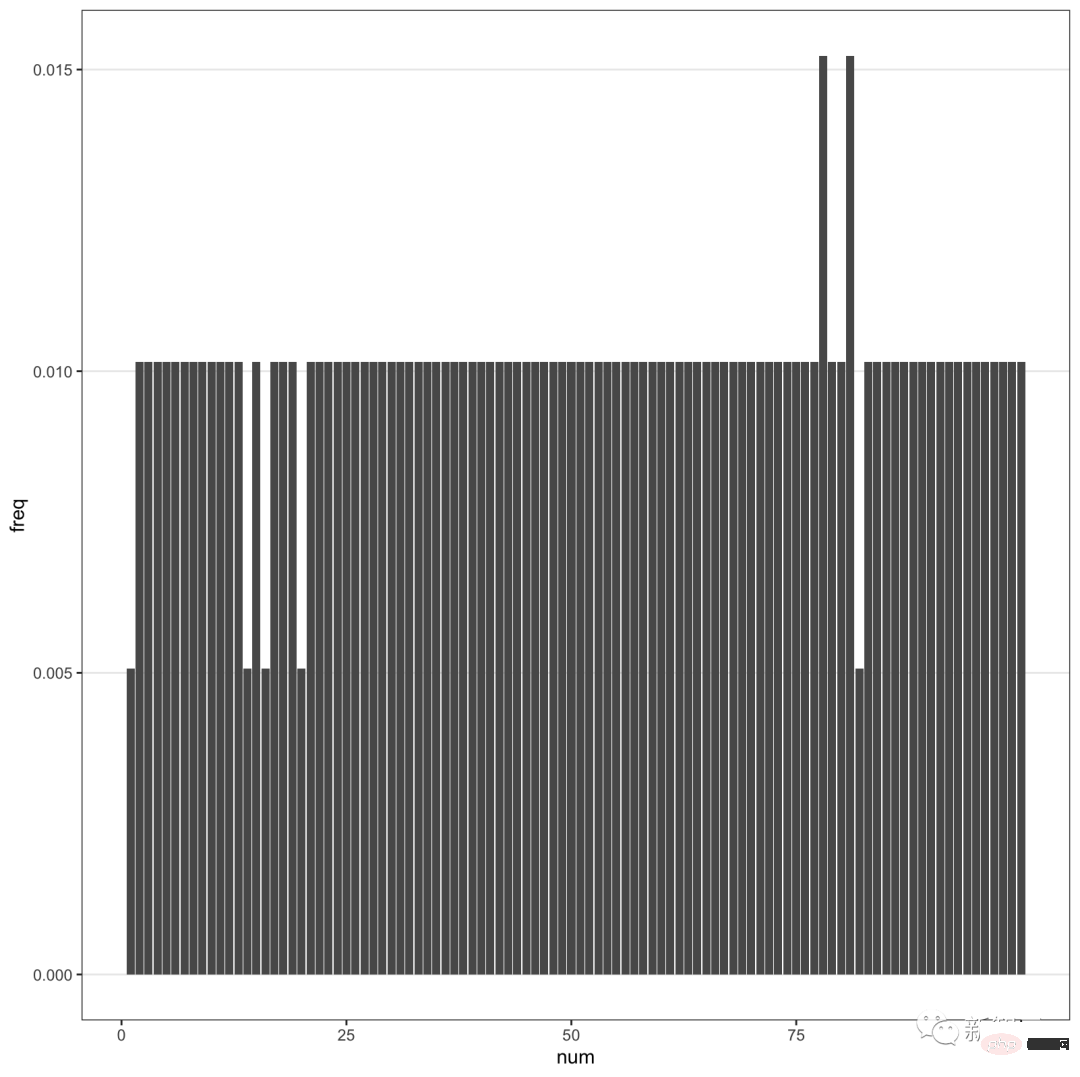

「Wählen Sie eine Zufallszahl zwischen 1 und 100. Geben Sie die Zahl einfach zurück Indem er ChatGPT jedes Mal aufforderte, eine Zufallszahl zwischen 1 und 100 zu generieren, sammelte Fraser 2.000 verschiedene Antworten und stellte sie in einer Tabelle zusammen.

Sie sehen, dass die Zahl 42 mit bis zu 10 % am häufigsten vorkommt. Darüber hinaus kommen Zahlen mit 7 sehr häufig vor.

Besonders die Zahlen zwischen 71-79 haben eine höhere Häufigkeit. Bei Zahlen außerhalb dieses Bereichs erscheint häufig auch die 7 als zweite Ziffer.

Was bedeutet 42?

Was bedeutet 42?

Jeder, der Douglas Adams‘ Blockbuster-Science-Fiction-Roman „Per Anhalter durch die Galaxis“ gelesen hat, weiß, dass 42 „die ultimative Antwort auf das Leben, das Universum und alles“ ist.

Vereinfacht ausgedrückt sind 42 und 69 Meme-Nummern im Internet. Dies zeigt, dass ChatGPT eigentlich kein Zufallszahlengenerator ist, sondern lediglich beliebte Zahlen im Leben aus riesigen online gesammelten Datensätzen auswählt.

Vereinfacht ausgedrückt sind 42 und 69 Meme-Nummern im Internet. Dies zeigt, dass ChatGPT eigentlich kein Zufallszahlengenerator ist, sondern lediglich beliebte Zahlen im Leben aus riesigen online gesammelten Datensätzen auswählt.

Außerdem erscheint 7 häufig, was genau widerspiegelt, dass ChatGPT auf menschliche Vorlieben eingeht.

In der westlichen Kultur gilt die 7 allgemein als Glückszahl, und es gibt ein Sprichwort von der Glückszahl 7. Genauso wie wir von der Zahl 8 besessen sind.

Interessanterweise hat Fraser auch herausgefunden, dass GPT-4 dies zu kompensieren scheint.

Wenn GPT-4 nach mehr Zahlen gefragt wird, sind die zurückgegebenen Zufallszahlen zu gleichmäßig verteilt.

Wenn GPT-4 nach mehr Zahlen gefragt wird, sind die zurückgegebenen Zufallszahlen zu gleichmäßig verteilt.

Kurz gesagt, ChatGPT gibt eine Antwort grundsätzlich durch Vorhersage, anstatt tatsächlich zu „denken“, um eine Antwort zu finden.

Kurz gesagt, ChatGPT gibt eine Antwort grundsätzlich durch Vorhersage, anstatt tatsächlich zu „denken“, um eine Antwort zu finden.

Man sieht, dass ein Chatbot, der als nahezu allmächtig angepriesen wird, immer noch etwas albern ist.

Lassen Sie es einen Roadtrip für Sie planen und Sie werden in einer Stadt Halt machen, die es gar nicht gibt. Oder lassen Sie es eine Zufallszahl ausgeben und treffen Sie höchstwahrscheinlich eine Entscheidung auf der Grundlage eines beliebten Memes.

Einige Internetnutzer haben es selbst ausprobiert und festgestellt, dass GPT-4 42 mag.

Wenn ChatGPT am Ende nur Online-Klischees wiederholt, welchen Sinn hat es dann?

GPT-4 verstößt gegen die Regeln des maschinellen Lernens

Die Geburt von GPT-4 ist aufregend, aber auch enttäuschend.

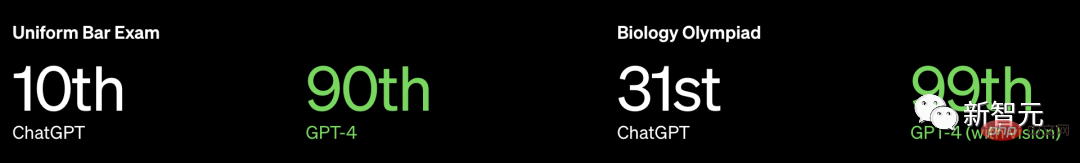

OpenAI hat nicht nur keine weiteren Informationen zu GPT-4 veröffentlicht, es hat nicht einmal die Größe des Modells bekannt gegeben, sondern auch betont, dass seine Leistung Menschen in vielen professionellen und standardisierten Untersuchungen überfordert.

Nehmen Sie als Beispiel die einheitliche Prüfung zur Anwaltslizenz in den USA, GPT3.5 kann das 10-Prozent-Niveau erreichen, und GPT4 kann das 90-Prozent-Niveau erreichen.

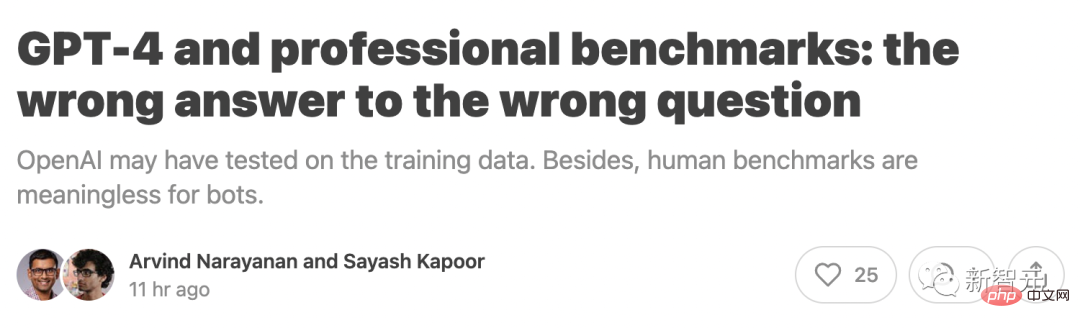

Professor Arvind Narayanan und Doktorand Sayash Kapoor vom Fachbereich Informatik der Princeton University schrieben jedoch, dass

Professor Arvind Narayanan und Doktorand Sayash Kapoor vom Fachbereich Informatik der Princeton University schrieben jedoch, dass

OpenAI möglicherweise anhand der Trainingsdaten getestet wurde. Darüber hinaus sind menschliche Benchmarks für Chatbots bedeutungslos.

Insbesondere verstößt OpenAI möglicherweise gegen eine Grundregel des maschinellen Lernens: Testen Sie nicht anhand von Trainingsdaten. Sie müssen wissen, dass Testdaten und Trainingsdaten getrennt werden müssen, da sonst Überanpassungsprobleme auftreten.

Insbesondere verstößt OpenAI möglicherweise gegen eine Grundregel des maschinellen Lernens: Testen Sie nicht anhand von Trainingsdaten. Sie müssen wissen, dass Testdaten und Trainingsdaten getrennt werden müssen, da sonst Überanpassungsprobleme auftreten.

Abgesehen von diesem Problem gibt es noch ein größeres Problem.

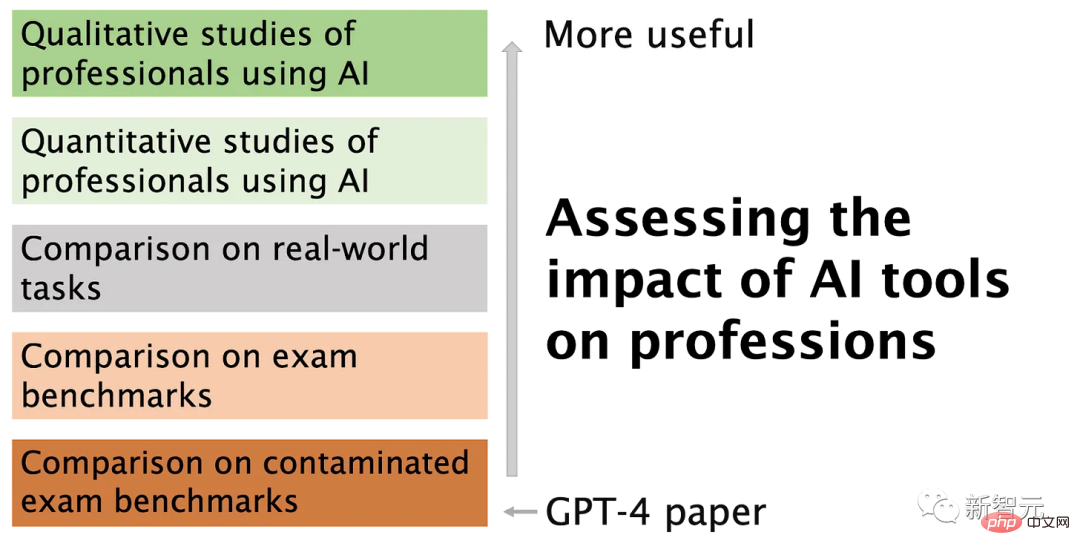

Sprachmodelle lösen Probleme anders als Menschen, daher haben diese Ergebnisse wenig Aussagekraft darüber, wie gut ein Roboter bei realen Problemen von Profis abschneiden wird. Die Aufgabe eines Anwalts besteht nicht darin, den ganzen Tag Fragen zu Anwaltsprüfungen zu beantworten.

Problem 1: Kontamination von Trainingsdaten

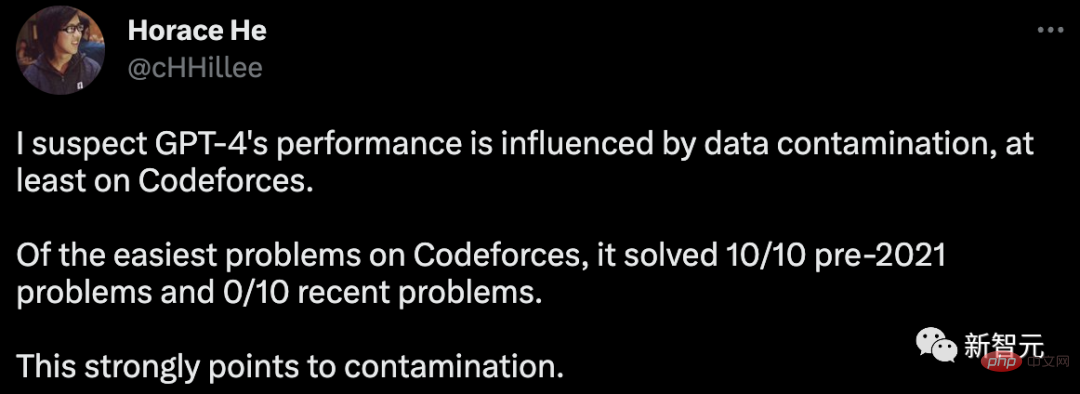

Um die Programmierfähigkeiten von GPT-4 zu bewerten, wurde OpenAI auf Codeforces, einer Website für russische Programmierwettbewerbe, evaluiert.

Überraschenderweise hat Horace online darauf hingewiesen, dass GPT-4 in der einfachen Klassifizierung 10 Probleme vor 2021 gelöst hat, aber keines der 10 jüngsten Probleme gelöst wurde.

Die Trainingsdatenfrist für GPT-4 endet im September 2021.

Dies impliziert stark, dass das Modell in der Lage ist, sich die Lösungen in seinem Trainingssatz zu merken oder sich zumindest teilweise an sie zu erinnern, und zwar ausreichend, um das auszufüllen, woran es sich nicht erinnern kann.

Um weitere Beweise für diese Hypothese zu liefern, testete Arvind Narayanan GPT-4 zu verschiedenen Zeitpunkten im Jahr 2021 auf Codeforces-Wettbewerbsprobleme.

Es wurde festgestellt, dass GPT-4 einfache Klassifizierungsprobleme vor dem 5. September lösen kann, aber keines der Probleme nach dem 12. September gelöst wurde.

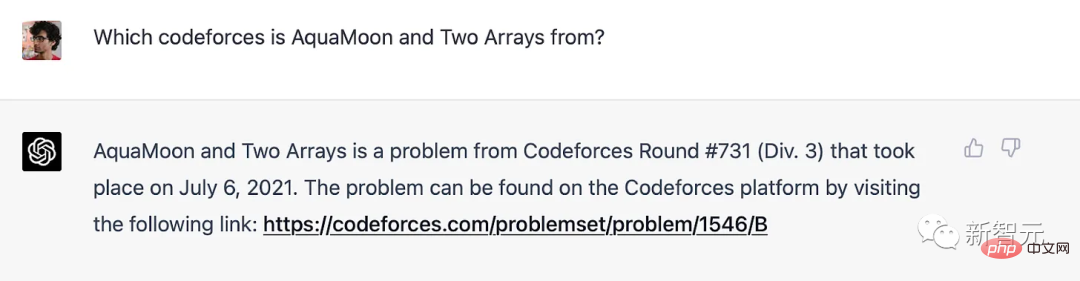

Tatsächlich können wir deutlich zeigen, dass Probleme im Trainingssatz gespeichert wurden: Wenn GPT-4 mit dem Titel eines Codeforces-Problems aufgefordert wird, enthält es einen Link zu der genauen Übereinstimmung, bei der das Problem aufgetreten ist. Es ist erwähnenswert, dass GPT-4 keinen Zugang zum Internet hat, daher ist der Speicher die einzige Erklärung.

GPT-4 merkt sich Codeforce-Probleme vor der Schulungsfrist

Für andere Benchmarks als die Programmierung sagte Professor Narayanan: „Wir wissen nicht, wie wir Probleme klar nach Zeiträumen trennen können, daher ist OpenAI schwer zu vermeiden.“ Aus dem gleichen Grund können wir keine Experimente durchführen, um zu testen, wie sich die Leistung mit Daten ändert. Wenn es sich um das Gedächtnis handelt, muss GPT sehr empfindlich auf die Formulierung von Fragen reagieren.

Im Februar gab Melanie Mitchell, Professorin am Santa Fe Institute, ein Beispiel für eine MBA-Prüfungsfrage. Eine geringfügige Änderung einiger Details reicht aus, um ChatGPT (GPT-3.5) zu täuschen, und diese Methode ist für eine Person nicht effektiv. Getäuscht werden.

Detailliertere Experimente wie dieses wären wertvoll.

Aufgrund der mangelnden Transparenz von OpenAI kann Professor Narayanan nicht mit Sicherheit sagen, dass es sich um ein Problem der Datenverschmutzung handelt. Sicher ist jedoch, dass der Ansatz von OpenAI zur Erkennung von Kontaminationen schlampig ist:

„Wir verwenden eine Teilstring-Matching-Methode, um Kreuzkontaminationen zwischen dem Bewertungsdatensatz und den Vortrainingsdaten zu messen, um alle zu entfernen.“ Leerzeichen und Symbole, nur Zeichen (einschließlich Zahlen) werden beibehalten. Für jedes Bewertungsbeispiel wählen wir zufällig drei Teilzeichenfolgen mit einer Länge von 50 Zeichen aus (wenn das Beispiel weniger als 50 Zeichen lang ist, wird das gesamte Beispiel verwendet). Die Bewertungsteilzeichenfolge ist eine Teilzeichenfolge des verarbeiteten Trainingsbeispiels. Wir verwerfen diese Beispiele und führen sie erneut aus, um eine makellose Bewertung zu erhalten.

Wenn das Testproblem im Trainingssatz vorhanden ist, Name und Nummer jedoch geändert wurden, kann es nicht erkannt werden. Jetzt ist eine zuverlässigere Methode verfügbar, beispielsweise der Einbettungsabstand.

Wenn OpenAI die Einbettungsdistanzmethode verwenden möchte, wie viel Ähnlichkeit wird dann als zu ähnlich angesehen? Auf diese Frage gibt es keine objektive Antwort.

Auch wenn die Durchführung eines standardisierten Multiple-Choice-Tests einfach erscheint, ist eine Menge Subjektivität im Spiel.

Problem 2: Professionelle Prüfungen sind keine effektive Möglichkeit, die Fähigkeiten von Menschen und Robotern zu vergleichen.Das Gedächtnis ist wie ein Spektrum, auch wenn das Sprachmodell keine genaue Frage im Trainingssatz gesehen hat, ist dies aufgrund der unvermeidlichen riesiger Trainingskorpus Habe viele sehr ähnliche Beispiele gesehen. Das bedeutet, dass es einer tieferen Überlegung entgehen kann. Daher liefern uns die Benchmark-Ergebnisse keinen Beweis dafür, dass das Sprachmodell die tiefen Denkfähigkeiten erwirbt, die menschliche Testteilnehmer benötigen.

Bei manchen praktischen Aufgaben mag GPT-4 für flaches Denken kompetent sein, aber das ist nicht immer der Fall. Benchmarks werden häufig in großen Modellvergleichen verwendet und von vielen dafür kritisiert, dass sie mehrdimensionale Bewertungen auf eine einzige Zahl reduzieren.

Benchmarks werden häufig in großen Modellvergleichen verwendet und von vielen dafür kritisiert, dass sie mehrdimensionale Bewertungen auf eine einzige Zahl reduzieren.

Leider hat sich OpenAI für die Verwendung einer so großen Anzahl dieser Tests bei der Bewertung von GPT-4 entschieden, gepaart mit unzureichenden Maßnahmen zur Datenverschmutzungsbehandlung, was sehr bedauerlich ist.

Das obige ist der detaillierte Inhalt von„Mathematischer Neuling' ChatGPT versteht menschliche Vorlieben sehr gut! Die Online-Generierung von Zufallszahlen ist die ultimative Antwort auf das Universum. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots

Oct 27, 2023 pm 06:00 PM

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots

Oct 27, 2023 pm 06:00 PM

Die perfekte Kombination aus ChatGPT und Python: Erstellen eines intelligenten Kundenservice-Chatbots Einführung: Im heutigen Informationszeitalter sind intelligente Kundenservicesysteme zu einem wichtigen Kommunikationsinstrument zwischen Unternehmen und Kunden geworden. Um den Kundenservice zu verbessern, greifen viele Unternehmen auf Chatbots zurück, um Aufgaben wie Kundenberatung und Beantwortung von Fragen zu erledigen. In diesem Artikel stellen wir vor, wie Sie mithilfe des leistungsstarken ChatGPT-Modells und der Python-Sprache von OpenAI einen intelligenten Kundenservice-Chatbot erstellen und verbessern können

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

In diesem Artikel stellen wir vor, wie man intelligente Chatbots mit ChatGPT und Java entwickelt, und stellen einige spezifische Codebeispiele bereit. ChatGPT ist die neueste Version des von OpenAI entwickelten Generative Pre-Training Transformer, einer auf neuronalen Netzwerken basierenden Technologie für künstliche Intelligenz, die natürliche Sprache verstehen und menschenähnlichen Text generieren kann. Mit ChatGPT können wir ganz einfach adaptive Chats erstellen

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

chatgpt kann in China verwendet werden, kann jedoch nicht registriert werden. Wenn Benutzer sich registrieren möchten, können sie zur Registrierung eine ausländische Mobiltelefonnummer verwenden. Beachten Sie, dass während des Registrierungsprozesses auf die Netzwerkumgebung umgestellt werden muss eine fremde IP.

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren

Oct 27, 2023 am 09:04 AM

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren

Oct 27, 2023 am 09:04 AM

So verwenden Sie ChatGPT und Python, um die Funktion zur Erkennung von Benutzerabsichten zu implementieren. Einführung: Im heutigen digitalen Zeitalter ist die Technologie der künstlichen Intelligenz in verschiedenen Bereichen nach und nach zu einem unverzichtbaren Bestandteil geworden. Unter anderem ermöglicht die Entwicklung der Technologie zur Verarbeitung natürlicher Sprache (Natural Language Processing, NLP), dass Maschinen menschliche Sprache verstehen und verarbeiten können. ChatGPT (Chat-GeneratingPretrainedTransformer) ist eine Art von

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So bauen Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter. Einführung: Mit der Entwicklung der Technologie der künstlichen Intelligenz werden Roboter zunehmend im Bereich Kundendienst eingesetzt. Der Einsatz von ChatGPTPHP zum Aufbau eines intelligenten Kundendienstroboters kann Unternehmen dabei helfen, effizientere und personalisiertere Kundendienste anzubieten. In diesem Artikel wird erläutert, wie Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter erstellen, und es werden spezifische Codebeispiele bereitgestellt. 1. Installieren Sie ChatGPTPHP und nutzen Sie ChatGPTPHP, um einen intelligenten Kundendienstroboter aufzubauen.