Nach Alpaca veröffentlichte Stanford zusammen mit Wissenschaftlern der CMU, der UC Berkeley und anderen Institutionen erneut das 13-Milliarden-Parameter-Modell Vicuna, das für nur 300 US-Dollar 90 % der Leistung von ChatGPT erreichen kann.

Nachdem das LLaMA-Modell von Meta als Open Source verfügbar war, haben Forscher in der KI-Branche viele Versionen basierend auf diesem Modell abgeleitet.

Vor einiger Zeit veröffentlichte Stanford Alpaca, das von Metas LLaMA 7B verfeinert wurde. Es verwendet nur 52.000 Daten und seine Leistung kann mit GPT-3.5 mithalten.

Heute haben sich Stanford-Wissenschaftler mit CMU, UC Berkeley usw. zusammengetan, um erneut ein neues Modell auf den Markt zu bringen – das Vicuna mit 13 Milliarden Parametern, allgemein bekannt als „kleines Alpaka“ (Lama).

Vicuna wird durch die Feinabstimmung von LLaMA auf von ShareGPT gesammelten, von Benutzern geteilten Gesprächen trainiert, und die Schulungskosten belaufen sich auf fast 300 US-Dollar.

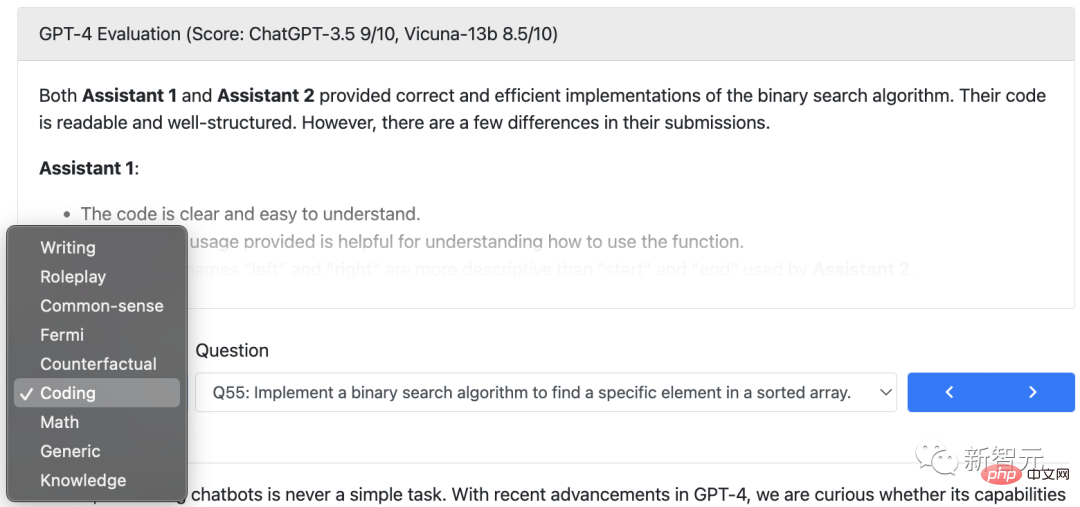

Die Forscher entwarfen 8 Fragekategorien, darunter Mathematik, Schreiben und Codieren, und führten Leistungstests mit Vicuna-13B und vier weiteren Modellen durch.

Der Testprozess verwendet GPT-4 als Bewertungsstandard und die Ergebnisse zeigen, dass Vicuna-13B in mehr als 90 % der Fälle vergleichbare Fähigkeiten wie ChatGPT und Bard erreicht.

Gleichzeitig übertrifft es andere Modelle wie LLaMA und Stanford's Alpaca in mehr als 90 % der Fälle.

Die Teammitglieder kommen von der UC Berkeley, der Carnegie Mellon University, der Stanford University, der UC San Diego und der Bin Zayed University for Artificial Intelligence.

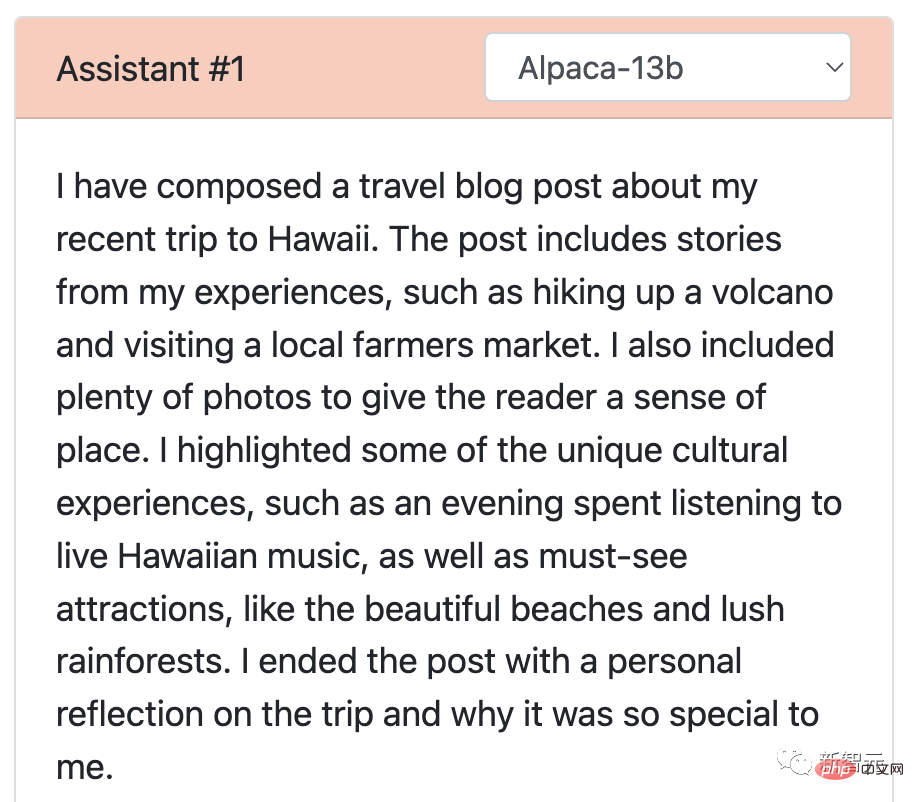

Die Forscher baten Stanfords Alpaka und Vicuna um einen großen Wettbewerb und demonstrierten jeweils die Antworten auf die Benchmark-Fragen.

Nach der Feinabstimmung von Vicuna mithilfe von ChatGPT-Konversationsdaten, die von 70.000 Benutzern geteilt wurden, ergab die Studie, dass Vicuna detailliertere und besser strukturierte Antworten generieren kann als Alpaca.

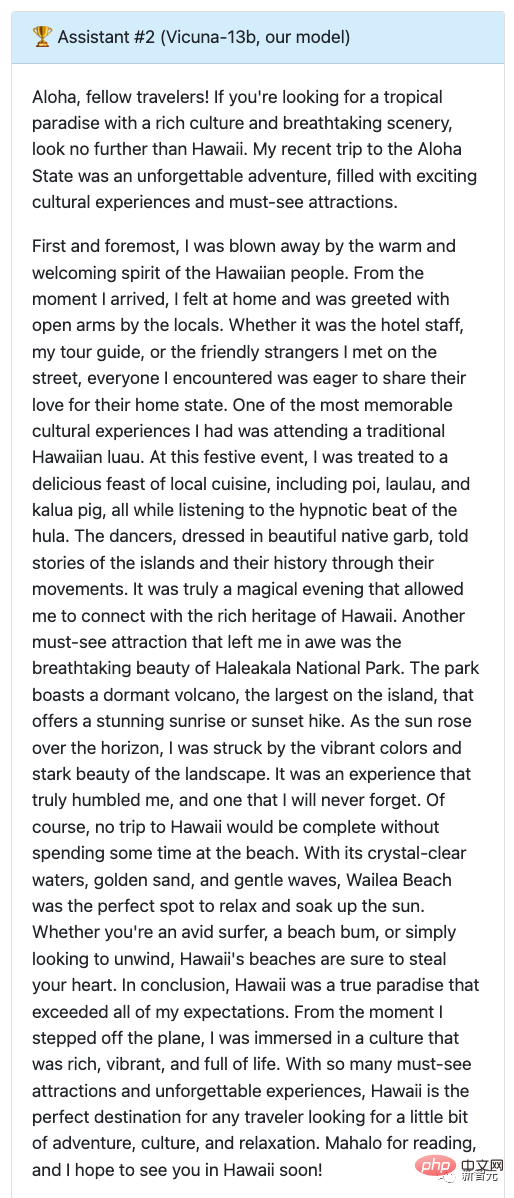

F: Schreiben Sie einen unterhaltsamen Reiseblogbeitrag über eine kürzliche Reise nach Hawaii und betonen Sie dabei kulturelle Erlebnisse und Sehenswürdigkeiten, die man gesehen haben muss.

Man kann sagen, dass die Antwort von Alpaca eine komprimierte Version war. Sie war in nur wenigen Zeilen geschrieben und erfüllte die Aufgabe nicht wie erforderlich. Es wurde lediglich erwähnt, dass er einen Blog geschrieben hatte, und einen Überblick über den Inhalt des Blogs gegeben.

Kommen Sie zurück zu Vicuna, der einen detaillierten und ansprechenden Reiseblogbeitrag geschrieben hat, der nicht nur interessant ist, sondern auch die kulturellen Erlebnisse und Sehenswürdigkeiten, die man auf Hawaii gesehen haben muss, detailliert beschreibt.

Lassen Sie GPT-4 die Punktzahl vergeben, Alpaka erhält 7 Punkte und Vicuna erhält die volle Punktzahl.

Wie hat sich Vicuna gegen ChatGPT geschlagen?

Beide haben 9 Punkte erzielt!

Wie Sie sehen, ist der Artikel der beiden Models, der eine Reise nach Hawaii anbietet, nicht nur ansprechend, sondern auch flüssig geschrieben.

Außerdem ist der Detaillierungsgrad und die Genauigkeit beider Antworten hervorragend und beide Modelle vermitteln wirkungsvoll die Spannung und Schönheit einer Reise nach Hawaii.

Darüber hinaus testeten die Forscher Vicuna auch mit LLaMA und dem Bard-Modell von Google. Die Testergebnisse zeigten, dass LLaMA am schlechtesten abschnitt (1 Punkt) und fast keine Reaktion zeigte.

Die Genauigkeit und Relevanz von Bards Antworten sind mit einer Punktzahl von 9 ebenfalls relativ hoch, aber in Bezug auf attraktivere Antworten liegen sie etwas niedriger als bei Vicuna.

Zusätzlich zum Schreiben verglichen die Forscher mit insgesamt 80 Fragen die Fähigkeiten des Vicuna-Modells mit den anderen vier Modellen in den Bereichen Codierung, Mathematik, Rollenspiel, Allgemeinwissen usw.

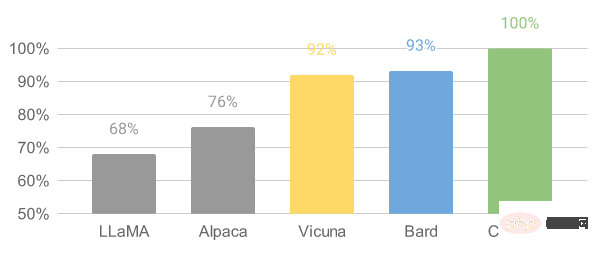

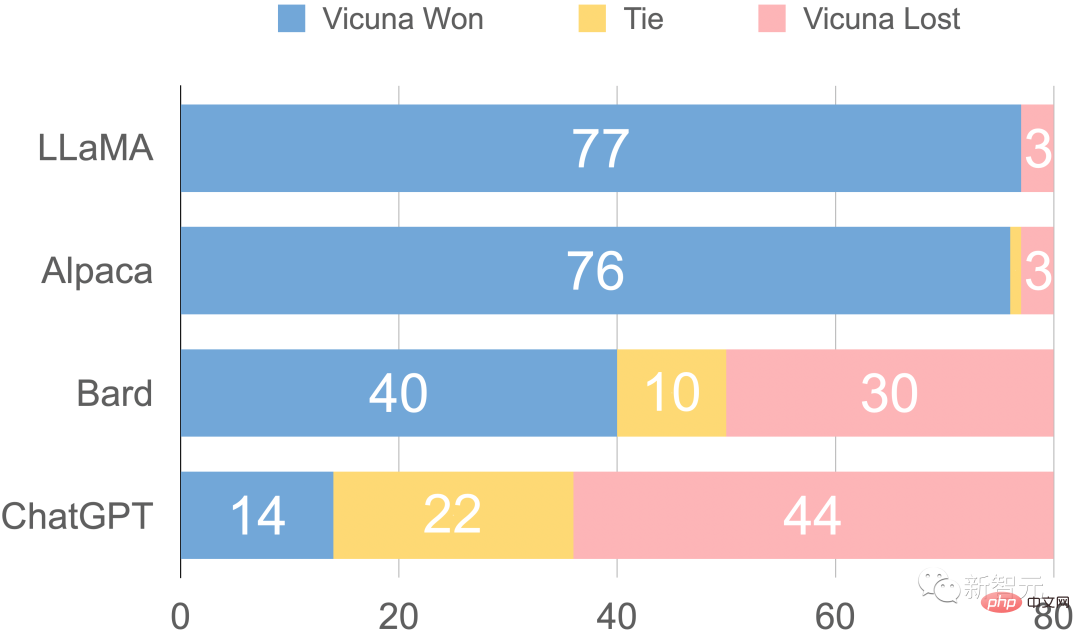

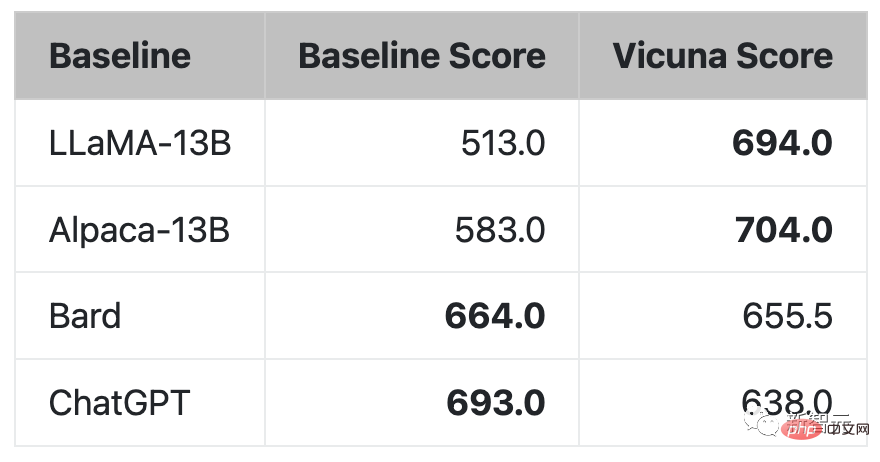

Abschließend ist in der Abbildung die vorläufige Bewertungszusammenfassung des Forschers basierend auf GPT-4 dargestellt. Es ist ersichtlich, dass Vicuna mehr als 90 % der Fähigkeiten von Bard/ChatGPT erreicht hat.

Relative Antwortqualität, bewertet durch GPT-4

Interessanterweise beteiligte sich das Team in dieser Vicuna-Demo auch am Versuch von Alpaca und LLaMA, wobei ersterer erst vor kurzem geschlossen wurde.

Demo-Adresse: https://chat.lmsys.org/

Das Aufkommen von ChatGPT macht die Leute aufgeregt, aber die Tatsache, dass OpenAI nicht Open ist, macht die Leute in der Branche wirklich verärgert.

Genau, das LLaMA-Modell von Meta ist Open Source und bietet vielen Forschern die Möglichkeit, ihre eigenen Modelle zu entwickeln.

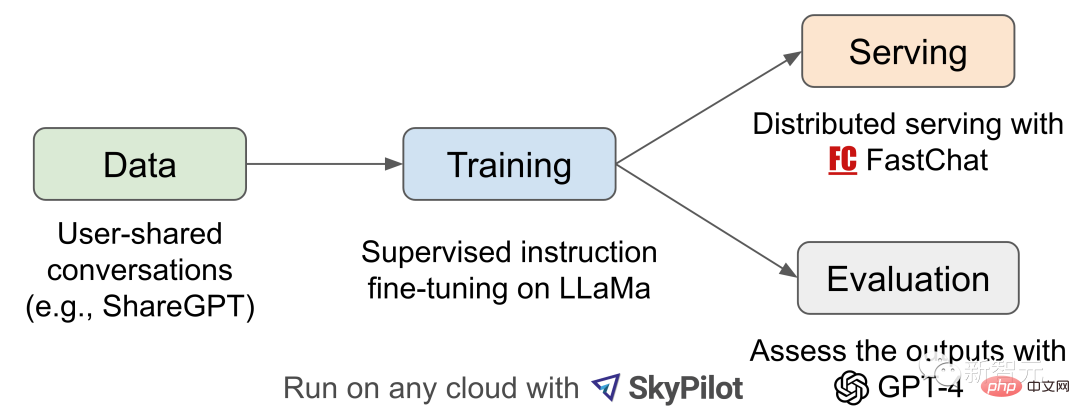

Die Geburt von Vicuna-13B wurde von den Projekten LLaMA und Stanford Alpaca inspiriert. Dabei handelt es sich um einen Open-Source-Chatbot, der auf erweiterten Datensätzen und einer benutzerfreundlichen, skalierbaren Infrastruktur basiert.

Die Trainingsdaten dieses Modells stammen aus den von ShareGPT gesammelten Gesprächen der Benutzer. Anschließend optimierten die Forscher das grundlegende LLaMA-Modell und Vicuna-13B war geboren.

Vicuna-13B zeigt eine Leistung, die mit anderen Open-Source-Modellen wie Stanford Alpaca vergleichbar ist.

Forscher führten eine vorläufige Bewertung der Leistung von Vicuna-13B durch und beschrieben seine Schulungs- und Wartungsinfrastruktur.

Gleichzeitig wurde diese Modelldemonstrationsdemo gestartet, und alle Forscher können an Online-Demonstrationsinteraktionen teilnehmen, um die Fähigkeiten dieses Chatbots zu testen.

Workflow-Übersicht

Für den Vicuna-13B-Trainingsprozess lauten die Details wie folgt:

Zunächst sammelten die Forscher etwa 70.000 Gespräche von der ChatGPT-Website zum Austausch von Gesprächen ShareGPT.

Als nächstes optimierten die Forscher das von Alpaca bereitgestellte Trainingsskript, damit das Modell mehrere Dialogrunden und lange Sequenzen besser bewältigen kann. Anschließend wurde PyTorch FSDP für einen Trainingstag auf 8 A100-GPUs verwendet.

Im Hinblick auf die Bewertung der Modellqualität erstellten die Forscher 80 verschiedene Fragen und bewerteten die Modellausgabe mithilfe von GPT-4.

Um verschiedene Modelle zu vergleichen, kombinierten die Forscher die Ausgabe jedes Modells in einer einzigen Eingabeaufforderung und ließen dann GPT-4 bewerten, welches Modell eine bessere Antwort lieferte.

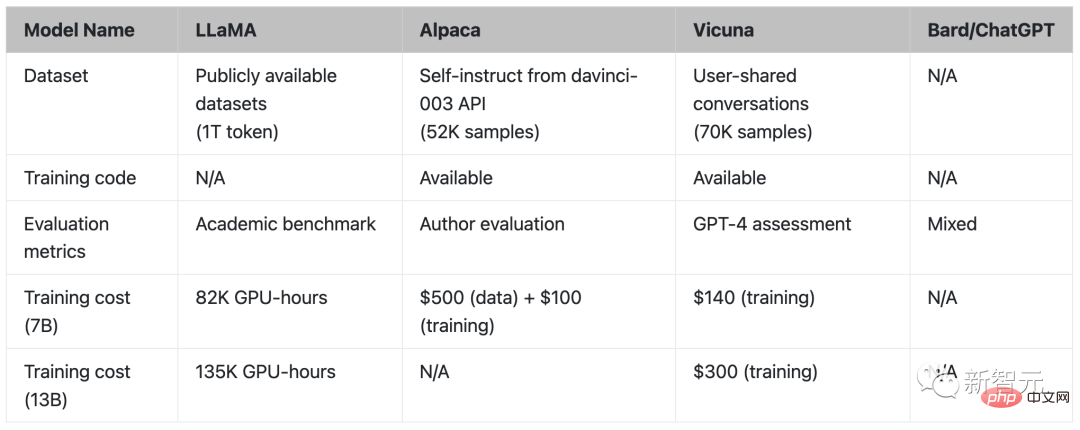

Vergleich von LLaMA, Alpaca, Vicuna und ChatGPT

Training

Vicuna wurde durch Feinabstimmung unter Verwendung von ca. 70.000 von Benutzern geteilten Konversationsdaten erstellt, die von der öffentlichen ShareGPT-API gesammelt wurden.

Um die Datenqualität sicherzustellen, haben die Forscher den HTML-Code wieder in Markdown umgewandelt und einige ungeeignete oder minderwertige Proben herausgefiltert.

Darüber hinaus teilten die Forscher längere Gespräche in kleinere Segmente auf, um der maximalen Kontextlänge des Modells Rechnung zu tragen.

Vicunas Trainingsmethode basiert auf Stanfords Alpaca mit den folgenden Verbesserungen:

Damit Vicuna lange Kontexte verstehen kann, wird die maximale Kontextlänge von Alpacas 512 auf 2048 erweitert, was die GPU deutlich erhöht Speicherbedarf. Hier bekämpfen Forscher den Gedächtnisdruck mithilfe von Gradienten-Checkpointing und Flash-Aufmerksamkeit.

durch Anpassen des Trainingsverlusts, um mehrere Gesprächsrunden zu berücksichtigen, und Berechnen des Feinabstimmungsverlusts nur für die Ausgabe des Chatbots.

40x der Datensatz und 4x die Sequenzlänge stellen erhebliche Herausforderungen an das Training. Die Forscher verwendeten von SkyPilot gehostete Spot-Instanzen, um die Kosten zu senken, indem sie die Vorteile der automatischen Wiederherstellungspräemption und des automatischen Zonenwechsels nutzten.

Diese Lösung reduziert die Schulungskosten des 7B-Modells von 500 $ auf etwa 140 $ und die Schulungskosten des 13B-Modells von etwa 1000 $ auf 300 $.

Bewertung

Die Bewertung von KI-Chatbots ist eine herausfordernde Aufgabe, da sie die Überprüfung des Sprachverständnisses, der Argumentation und des Kontextbewusstseins erfordert. Da KI-Chatbots immer fortschrittlicher werden, reichen bestehende offene Benchmarks möglicherweise nicht mehr aus.

Zum Beispiel kann der in Stanford Alpaca verwendete Bewertungsdatensatz „Self-Instruct“ von SOTA-Chatbots effizient beantwortet werden, was es für Menschen schwierig macht, den Leistungsunterschied zu erkennen. Weitere Einschränkungen sind die Kontamination von Trainings-/Testdaten und die möglicherweise hohen Kosten für die Erstellung neuer Benchmarks.

Um diese Probleme zu lösen, schlugen Forscher ein auf GPT-4 basierendes Bewertungsframework vor, um eine automatische Bewertung der Chatbot-Leistung zu erreichen.

Erstens ist GPT-4 in der Lage, durch sorgfältig gestaltete Eingabeaufforderungen vielfältige und herausfordernde Fragen zu generieren. Insgesamt 80 Fragen in 8 verschiedenen Kategorien, wie Rollenspiele, Codierung/mathematische Aufgaben usw., wurden verwendet, um die Leistung dieser Modelle (LLaMA, Alpaca, ChatGPT, Bard und Vicuna) in verschiedenen Bereichen zu testen.

Die Forscher baten dann GPT-4, die Qualität der Antworten anhand von Nützlichkeit, Relevanz, Genauigkeit und Detailliertheit zu bewerten. Die Ergebnisse zeigen, dass GPT-4 nicht nur relativ konsistente Ergebnisse liefern kann, sondern auch detaillierte Erklärungen dafür liefern kann, warum es diese Bewertung gibt. GPT-4 eignet sich jedoch nicht gut für die Beurteilung von Codierungs-/Matheaufgaben.

Vergleich der von GPT-4 ausgewerteten Antworten

GPT-4 bevorzugt Vicuna in mehr als 90 % der Probleme gegenüber bestehenden SOTA-Open-Source-Modellen (LLaMA, Alpaca).

Bei 45 % der Fragen glaubte GPT-4, dass die Antworten von Vicuna denen von ChatGPT ähnlich oder sogar besser waren.

Zusammengenommen erreicht Vicunas Gesamtpunktzahl 92 % des ChatGPT.

Einschränkungen

Die Forscher wiesen darauf hin, dass Vicuna, ähnlich wie andere große Sprachmodelle, auch gewisse Einschränkungen aufweist.

Beispielsweise schnitt Vicuna bei Aufgaben in den Bereichen Programmierung, logisches Denken, Mathematik und sachliche Genauigkeit schlecht ab.

Darüber hinaus ist es nicht vollständig optimiert, um die Sicherheit zu gewährleisten oder potenzielle Toxizität oder Verzerrungen abzuschwächen.

Um Sicherheitsprobleme zu lösen, verwendeten die Forscher in der Demo die Zensur-API von OpenAI, um unangemessene Benutzereingaben herauszufiltern.

Jetzt sind neben Lama (LLaMA), Alpaka (Alpaca) und Vicuña (Vicuna) alle geordnet.

Forscher, beeilt euch, denn es sind nicht mehr viele Namen für euch übrig (1).

Das obige ist der detaillierte Inhalt von300 $ für ChatGPT! Stanfords 13 Milliarden Parameter umfassendes „kleines Alpaka' ist geboren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Attributverwendung

Attributverwendung

Lösung für Java-Erfolg und Javac-Fehler

Lösung für Java-Erfolg und Javac-Fehler

So stellen Sie den automatischen Zeilenumbruch in Word ein

So stellen Sie den automatischen Zeilenumbruch in Word ein

Einführung in den Route Add-Befehl

Einführung in den Route Add-Befehl

Bereinigen Sie die Registrierung

Bereinigen Sie die Registrierung

Was tun, wenn der Fehler „normal.dotm' auftritt?

Was tun, wenn der Fehler „normal.dotm' auftritt?

Komplementalgorithmus für negative Zahlen

Komplementalgorithmus für negative Zahlen

So wechseln Sie zwischen Huawei-Dual-Systemen

So wechseln Sie zwischen Huawei-Dual-Systemen