Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die neue Methode AIO-P überwindet NAS-Engpässe und sagt die Architekturleistung über alle Aufgaben hinweg vorher

Die neue Methode AIO-P überwindet NAS-Engpässe und sagt die Architekturleistung über alle Aufgaben hinweg vorher

Die neue Methode AIO-P überwindet NAS-Engpässe und sagt die Architekturleistung über alle Aufgaben hinweg vorher

Das Huawei HiSilicon Canada Research Institute und die University of Alberta haben gemeinsam ein Framework zur Vorhersage der Leistung neuronaler Netze eingeführt, das auf Vortraining und Wissensinjektion basiert.

Die Leistungsbewertung neuronaler Netze (Präzision, Rückruf, PSNR usw.) erfordert viel Ressourcen und Zeit und ist der Hauptengpass bei der Struktursuche neuronaler Netze (NAS). Frühe NAS-Methoden erforderten umfangreiche Ressourcen, um jede neu gesuchte Struktur von Grund auf zu trainieren. In den letzten Jahren haben Netzwerkleistungsprädiktoren als effiziente Methode zur Leistungsbewertung immer mehr Beachtung gefunden.

Allerdings sind aktuelle Prädiktoren in ihrem Einsatzbereich begrenzt, da sie nur Netzwerkstrukturen aus einem bestimmten Suchraum modellieren und nur die Leistung neuer Strukturen bei bestimmten Aufgaben vorhersagen können. Beispielsweise enthalten die Trainingsbeispiele nur Klassifizierungsnetzwerke und deren Genauigkeit, sodass die trainierten Prädiktoren nur zur Bewertung der Leistung neuer Netzwerkstrukturen bei Bildklassifizierungsaufgaben verwendet werden können.

Um diese Grenze zu durchbrechen und es dem Prädiktor zu ermöglichen, die Leistung einer bestimmten Netzwerkstruktur bei mehreren Aufgaben vorherzusagen und über aufgaben- und datenübergreifende Generalisierungsfunktionen zu verfügen, haben das Huawei HiSilicon Canada Research Institute und die University of Alberta gemeinsam ein Programm ins Leben gerufen Ein Framework zur Vorhersage der Leistung neuronaler Netze, das auf Vortraining und Wissensinjektion basiert. Dieses Framework kann die Leistung verschiedener Strukturen und Arten von Netzwerken bei vielen verschiedenen Arten von CV-Aufgaben wie Klassifizierung, Erkennung, Segmentierung usw. für die Struktursuche neuronaler Netzwerke schnell bewerten. Forschungspapier wurde von AAAI 2023 angenommen.

- Papier-Link: https://arxiv.org/abs/2211.17228

- Code-Link: https://github.com/Ascend-Research/AIO-P

AIO-P (All-in Der Ansatz „One Predictors“ zielt darauf ab, den Anwendungsbereich neuronaler Prädiktoren auf Computer-Vision-Aufgaben über die Klassifizierung hinaus auszudehnen. AIO-P nutzt die K-Adapter-Technologie, um aufgabenbezogenes Wissen in das Prädiktormodell einzuspeisen, und entwirft außerdem einen Label-Skalierungsmechanismus basierend auf FLOPs (Floating Point Operanden), um sich an verschiedene Leistungsindikatoren und -verteilungen anzupassen. AIO-P verwendet ein einzigartiges Pseudo-Labeling-Schema zum Trainieren von K-Adaptern und generiert so in nur wenigen Minuten neue Trainingsbeispiele. Experimentelle Ergebnisse zeigen, dass AIO-P starke Leistungsvorhersagefähigkeiten aufweist und bei mehreren Computer-Vision-Aufgaben hervorragende MAE- und SRCC-Ergebnisse erzielt. Darüber hinaus kann AIO-P die Leistung noch nie dagewesener Netzwerkstrukturen direkt migrieren und vorhersagen und mit NAS zusammenarbeiten, um das Rechenvolumen bestehender Netzwerke ohne Leistungseinbußen zu optimieren.

Einführung in die Methode

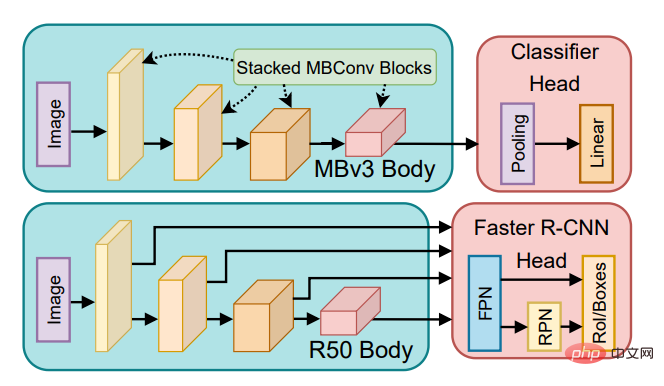

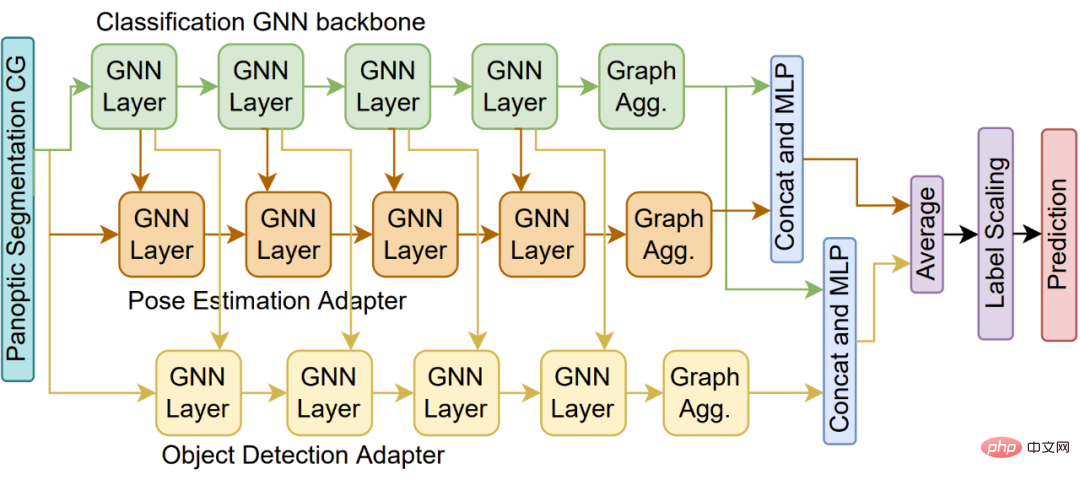

AIO-P ist ein allgemeiner Netzwerkleistungsprädiktor, der auf mehrere Aufgaben verallgemeinert werden kann. AIO-P erreicht Leistungsvorhersagefunktionen über Aufgaben und Suchräume hinweg durch Prädiktor-Vorschulung und domänenspezifische Wissensinjektion. AIO-P verwendet die K-Adapter-Technologie, um aufgabenbezogenes Wissen in den Prädiktor einzuspeisen, und stützt sich auf ein gemeinsames Computational Graph (CG)-Format zur Darstellung einer Netzwerkstruktur, was es ihm letztendlich ermöglicht, Netzwerke aus verschiedenen Suchräumen und Aufgaben zu unterstützen, wie gezeigt in Abbildung 1 unten dargestellt.

Abbildung 1. Wie AIO-P Netzwerkstrukturen darstellt, die für verschiedene Aufgaben verwendet werden

Darüber hinaus ermöglicht die Verwendung eines Pseudo-Labeling-Mechanismus es AIO-P, schnell neue Trainingsbeispiele zum Trainieren von K-Adaptern zu generieren. Um die Lücke zwischen Leistungsmessbereichen für verschiedene Aufgaben zu schließen, schlägt AIO-P eine Label-Skalierungsmethode auf Basis von FLOPs vor, um eine aufgabenübergreifende Leistungsmodellierung zu erreichen. Umfangreiche experimentelle Ergebnisse zeigen, dass AIO-P in der Lage ist, genaue Leistungsvorhersagen für eine Vielzahl verschiedener CV-Aufgaben, wie etwa Posenschätzung und Segmentierung, ohne Trainingsbeispiele oder mit nur geringem Feinabstimmungsaufwand zu treffen. Darüber hinaus kann AIO-P die Leistung in noch nie dagewesenen Netzwerkstrukturen korrekt einordnen und wird in Kombination mit einem Suchalgorithmus zur Optimierung des Huawei-Gesichtserkennungsnetzwerks verwendet, wodurch seine Leistung unverändert bleibt und die FLOPs um mehr als 13,5 % reduziert werden. Das Papier wurde von AAAI-23 angenommen und der Code wurde auf GitHub als Open Source bereitgestellt.

Computer-Vision-Netzwerke bestehen normalerweise aus einem „Rückgrat“, das die Merkmalsextraktion durchführt, und einem „Kopf“, der die extrahierten Merkmale verwendet, um Vorhersagen zu treffen. Die Struktur des „Rückgrats“ wird normalerweise auf der Grundlage einer bestimmten bekannten Netzwerkstruktur (ResNet, Inception, MobileNet, ViT, UNet) entworfen, während der „Kopf“ für eine bestimmte Aufgabe wie Klassifizierung, Posenschätzung, Segmentierung usw. entworfen wird. usw. entworfen. Herkömmliche NAS-Lösungen passen den Suchraum manuell basierend auf der Struktur des „Backbone“ an. Wenn der „Backbone“ beispielsweise MobileNetV3 ist, kann der Suchraum die Anzahl der MBConv-Blöcke und die Parameter jedes MBConv (Kernelgröße, Erweiterung) umfassen ), die Anzahl der Kanäle usw. Dieser angepasste Suchraum ist jedoch nicht universell, wenn es ein anderes „Backbone“ gibt, das auf ResNet basiert. Er kann nicht über das vorhandene NAS-Framework optimiert werden, sondern der Suchraum muss neu gestaltet werden.

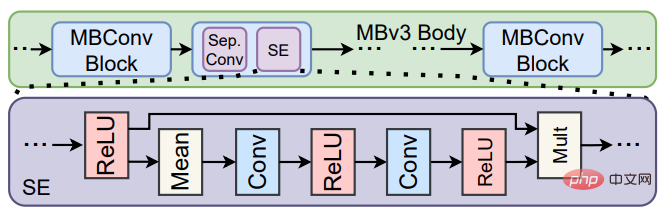

Um dieses Problem zu lösen, entschied sich AIO-P dafür, verschiedene Netzwerkstrukturen auf der Ebene des Rechengraphen darzustellen und so eine einheitliche Darstellung jeder Netzwerkstruktur zu erreichen. Wie in Abbildung 2 dargestellt, ermöglicht das Computational Graph-Format AIO-P, den Header und das Backbone zusammen zu kodieren, um die gesamte Netzwerkstruktur darzustellen. Dies ermöglicht es AIO-P auch, die Leistung von Netzwerken aus verschiedenen Suchräumen (wie MobileNets und ResNets) bei verschiedenen Aufgaben vorherzusagen.

Abbildung 2. Darstellung des Squeeze-and-Excite-Moduls in MobileNetV3 auf der Ebene des Rechengraphen

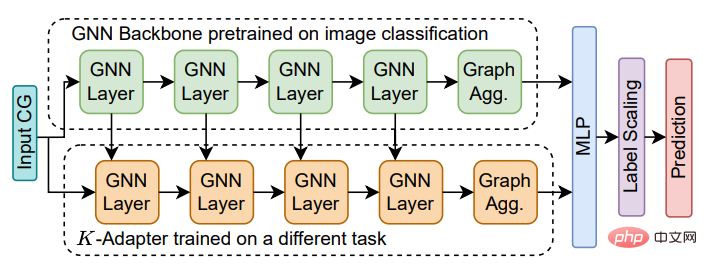

Die in AIO-P vorgeschlagene Prädiktorstruktur geht von einem einzelnen GNN-Regressionsmodell aus (Abbildung 3, grüner Block) Es sagt die Leistung von Bildklassifizierungsnetzwerken voraus. Um das Wissen über andere CV-Aufgaben wie Erkennung oder Segmentierung zu ergänzen, fügte die Studie dem ursprünglichen Regressionsmodell einen K-Adapter (Abb. 3, orangefarbener Block) hinzu. Der K-Adapter wird anhand von Beispielen aus der neuen Aufgabe trainiert, während die ursprünglichen Modellgewichte eingefroren werden. Daher trainiert diese Studie mehrere K-Adapter (Abbildung 4) separat, um Wissen aus mehreren Aufgaben hinzuzufügen.

Abbildung 3. AIO-P-Prädiktor mit einem K-Adapter

Abbildung 4. AIO-P-Prädiktor mit mehreren K-Adaptern

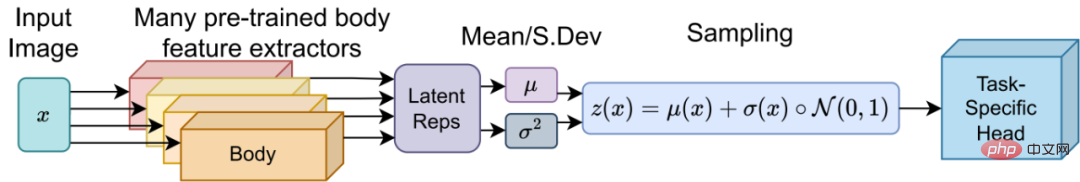

Um die Trainingszeit weiter zu reduzieren Overhead eines K-Adapters schlägt diese Studie eine clevere Pseudo-Labeling-Technologie vor. Diese Technik verwendet ein latentes Stichprobenschema, um ein „Kopf“-Modell zu trainieren, das von verschiedenen Aufgaben gemeinsam genutzt werden kann. Der Shared Head kann dann mit jedem Netzwerk-Backbone im Suchraum gekoppelt und feinabgestimmt werden, um in 10–15 Minuten Pseudo-Labels zu generieren (Abbildung 5).

Abbildung 5. Training eines „Kopf“-Modells, das zwischen verschiedenen Aufgaben geteilt werden kann

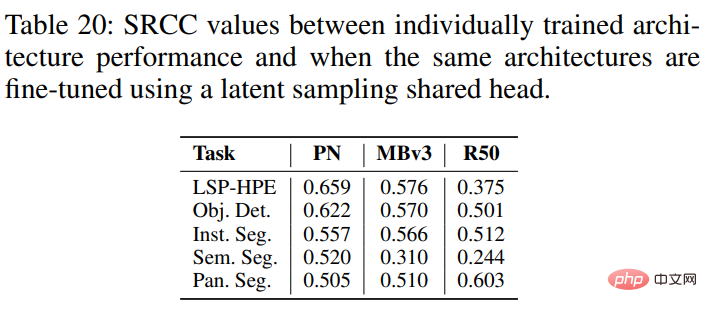

Es wurde experimentell bewiesen, dass die Verwendung von Pseudo-Labels, die durch das Teilen von Köpfen erhalten werden, dem Training eines Netzwerks von Grund auf für einen Tag entspricht oder mehr Die tatsächlich erzielte Leistung korreliert positiv, manchmal mit Rangkorrelationskoeffizienten über 0,5 (Spearman-Korrelation).

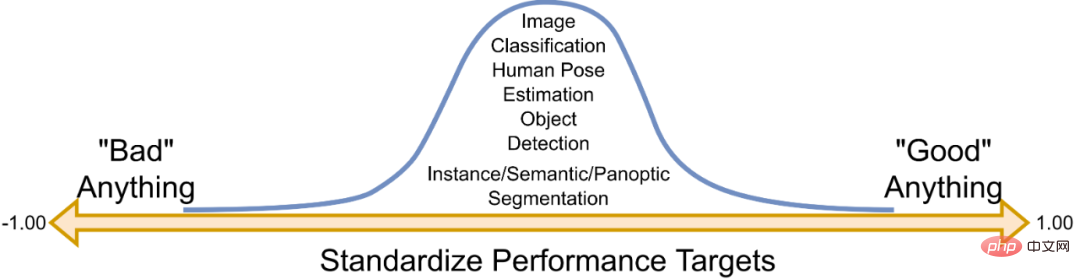

Darüber hinaus haben unterschiedliche Aufgaben unterschiedliche Leistungsindikatoren. Diese Leistungsindikatoren haben normalerweise ihren eigenen spezifischen Verteilungsbereich. Beispielsweise kann ein Klassifizierungsnetzwerk, das ein bestimmtes Backbone verwendet, bei ImageNet eine Klassifizierungsgenauigkeit von etwa 75 % aufweisen, während der mAP bei der MS-COCO-Objekterkennungsaufgabe 30–35 % betragen kann. . Um diese unterschiedlichen Intervalle zu berücksichtigen, schlägt diese Studie eine Methode vor, um die Netzwerkleistung anhand einer Normalverteilung basierend auf dem Normalisierungskonzept zu verstehen. Für Laien ausgedrückt: Wenn der vorhergesagte Wert 0 ist, ist die Netzwerkleistung durchschnittlich; wenn > 0, entspricht es einer schlechten Leistung, unabhängig von Aufgabe, Datensatz oder Indikator, wie in Abbildung 6 dargestellt unten anzeigen.

Abbildung 6. So normalisieren Sie die Netzwerkleistung

Die FLOPs eines Netzwerks hängen von der Modellgröße und den Eingabedaten ab und weisen im Allgemeinen einen positiven Trend zur Leistung auf. Diese Studie verwendet FLOPs-Transformationen, um die Etiketten zu verbessern, von denen AIO-P lernt.

Experimente und Ergebnisse

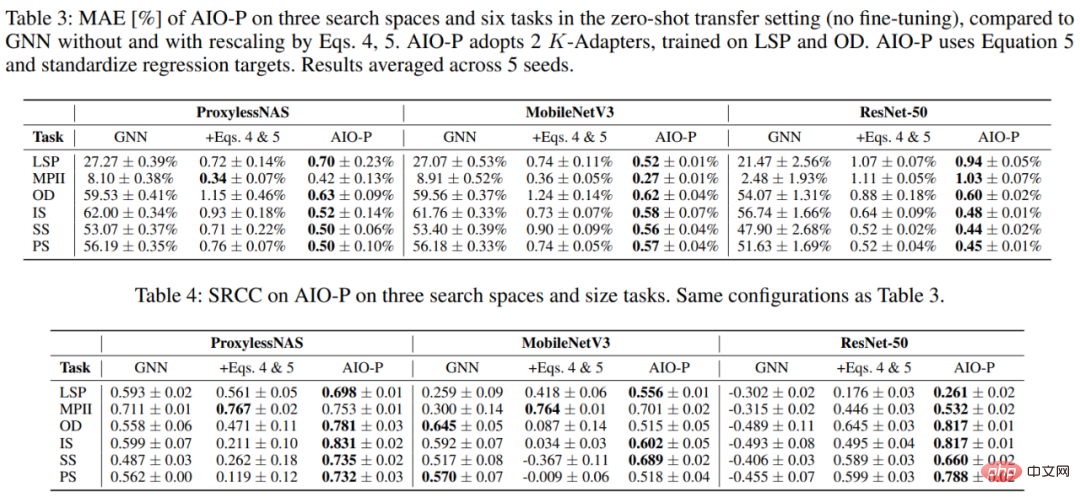

Diese Studie trainierte AIO-P zunächst auf menschliche Posenschätzung und Objekterkennungsaufgaben und nutzte es dann, um die Leistung von Netzwerkstrukturen bei mehreren Aufgaben vorherzusagen, einschließlich Posenschätzung (LSP und MPII), Erkennung (OD). ) ), Instanzsegmentierung (IS), semantische Segmentierung (SS) und Panoramasegmentierung (PS). Selbst im Fall einer Zero-Shot-Direktmigration können Sie mit AIO-P die Leistung von Netzwerken aus dem Once-for-All (OFA)-Suchraum (ProxylessNAS, MobileNetV3 und ResNet-50) für diese Aufgaben und die endgültige Vorhersage vorhersagen Ergebnisse Es wurde ein MAE von weniger als 1,0 % und eine Ranking-Korrelation von über 0,5 erreicht.

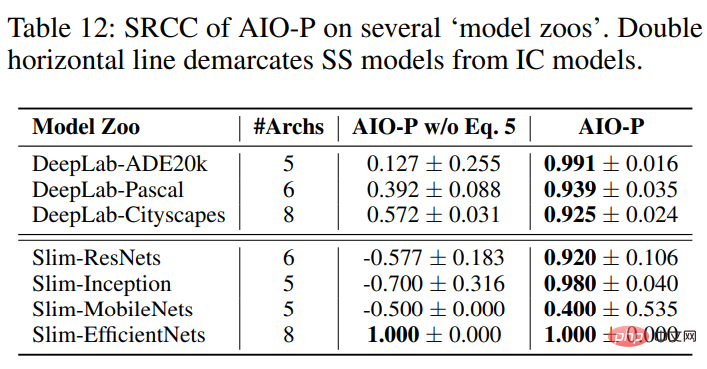

Darüber hinaus wurde in dieser Studie auch AIO-P verwendet, um die Leistung von Netzwerken in der Open-Source-Modellbibliothek TensorFlow-Slim vorherzusagen (z. B. das semantische Segmentierungsmodell DeepLab, ResNets, Inception-Netze, MobileNets und EfficientNets). Erscheint möglicherweise noch nicht in den Trainingsbeispielen von AIO-P.

AIO-P ist in der Lage, durch die Nutzung der FLOPs-Transformation einen nahezu perfekten SRCC für drei semantische Segmentierungsmodellbibliotheken von DeepLab zu erreichen, während gleichzeitig ein positiver SRCC für alle vier Klassifizierungsmodellbibliotheken und SRCC=1,0 für das EfficientNet-Modell erreicht werden.

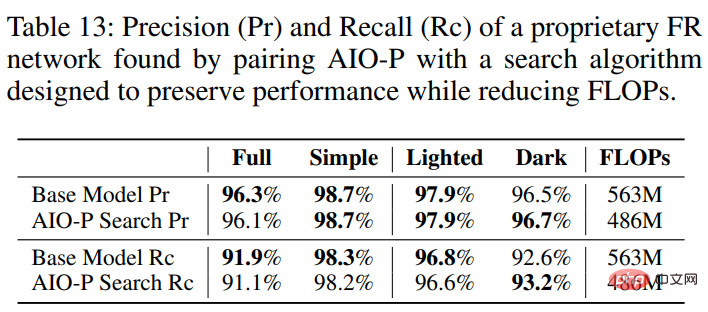

Schließlich besteht die Kernmotivation von AIO-P darin, es mit einem Suchalgorithmus koppeln und damit beliebige Netzwerkstrukturen optimieren zu können, die unabhängig und nicht Teil eines Suchraums oder einer bekannten Modellbibliothek sein können. Es könnte sich sogar um eine Struktur für eine Aufgabe handeln, für die sie noch nie trainiert wurde. Diese Studie verwendet AIO-P und den Zufallsmutationssuchalgorithmus, um das auf Huawei-Mobiltelefonen verwendete Gesichtserkennungsmodell (FR) zu optimieren. Die Ergebnisse zeigen, dass AIO-P die Modellberechnungs-FLOPs um mehr als 13,5 % reduzieren kann, während die Leistung (Präzision) erhalten bleibt (Pr) und Recall (Rc)).

Interessierte Leser können das Originalpapier lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonDie neue Methode AIO-P überwindet NAS-Engpässe und sagt die Architekturleistung über alle Aufgaben hinweg vorher. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

Die Bewertung des Kosten-/Leistungsverhältnisses des kommerziellen Supports für ein Java-Framework umfasst die folgenden Schritte: Bestimmen Sie das erforderliche Maß an Sicherheit und Service-Level-Agreement-Garantien (SLA). Die Erfahrung und das Fachwissen des Forschungsunterstützungsteams. Erwägen Sie zusätzliche Services wie Upgrades, Fehlerbehebung und Leistungsoptimierung. Wägen Sie die Kosten für die Geschäftsunterstützung gegen Risikominderung und Effizienzsteigerung ab.

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Die Lernkurve eines PHP-Frameworks hängt von Sprachkenntnissen, Framework-Komplexität, Dokumentationsqualität und Community-Unterstützung ab. Die Lernkurve von PHP-Frameworks ist im Vergleich zu Python-Frameworks höher und im Vergleich zu Ruby-Frameworks niedriger. Im Vergleich zu Java-Frameworks haben PHP-Frameworks eine moderate Lernkurve, aber eine kürzere Einstiegszeit.

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Das leichte PHP-Framework verbessert die Anwendungsleistung durch geringe Größe und geringen Ressourcenverbrauch. Zu seinen Merkmalen gehören: geringe Größe, schneller Start, geringer Speicherverbrauch, verbesserte Reaktionsgeschwindigkeit und Durchsatz sowie reduzierter Ressourcenverbrauch. Praktischer Fall: SlimFramework erstellt eine REST-API, nur 500 KB, hohe Reaktionsfähigkeit und hoher Durchsatz

Leistungsvergleich von Java-Frameworks

Jun 04, 2024 pm 03:56 PM

Leistungsvergleich von Java-Frameworks

Jun 04, 2024 pm 03:56 PM

Laut Benchmarks sind Quarkus (schneller Start, geringer Speicher) oder Micronaut (TechEmpower ausgezeichnet) für kleine, leistungsstarke Anwendungen die ideale Wahl. SpringBoot eignet sich für große Full-Stack-Anwendungen, weist jedoch etwas langsamere Startzeiten und Speichernutzung auf.

Best Practices für die Dokumentation des Golang-Frameworks

Jun 04, 2024 pm 05:00 PM

Best Practices für die Dokumentation des Golang-Frameworks

Jun 04, 2024 pm 05:00 PM

Das Verfassen einer klaren und umfassenden Dokumentation ist für das Golang-Framework von entscheidender Bedeutung. Zu den Best Practices gehört die Befolgung eines etablierten Dokumentationsstils, beispielsweise des Go Coding Style Guide von Google. Verwenden Sie eine klare Organisationsstruktur, einschließlich Überschriften, Unterüberschriften und Listen, und sorgen Sie für eine Navigation. Bietet umfassende und genaue Informationen, einschließlich Leitfäden für den Einstieg, API-Referenzen und Konzepte. Verwenden Sie Codebeispiele, um Konzepte und Verwendung zu veranschaulichen. Halten Sie die Dokumentation auf dem neuesten Stand, verfolgen Sie Änderungen und dokumentieren Sie neue Funktionen. Stellen Sie Support und Community-Ressourcen wie GitHub-Probleme und Foren bereit. Erstellen Sie praktische Beispiele, beispielsweise eine API-Dokumentation.

So wählen Sie das beste Golang-Framework für verschiedene Anwendungsszenarien aus

Jun 05, 2024 pm 04:05 PM

So wählen Sie das beste Golang-Framework für verschiedene Anwendungsszenarien aus

Jun 05, 2024 pm 04:05 PM

Wählen Sie das beste Go-Framework basierend auf Anwendungsszenarien aus: Berücksichtigen Sie Anwendungstyp, Sprachfunktionen, Leistungsanforderungen und Ökosystem. Gängige Go-Frameworks: Gin (Webanwendung), Echo (Webdienst), Fiber (hoher Durchsatz), gorm (ORM), fasthttp (Geschwindigkeit). Praktischer Fall: Erstellen einer REST-API (Fiber) und Interaktion mit der Datenbank (gorm). Wählen Sie ein Framework: Wählen Sie fasthttp für die Schlüsselleistung, Gin/Echo für flexible Webanwendungen und gorm für die Datenbankinteraktion.

Detaillierte praktische Erklärung der Golang-Framework-Entwicklung: Fragen und Antworten

Jun 06, 2024 am 10:57 AM

Detaillierte praktische Erklärung der Golang-Framework-Entwicklung: Fragen und Antworten

Jun 06, 2024 am 10:57 AM

Bei der Go-Framework-Entwicklung treten häufige Herausforderungen und deren Lösungen auf: Fehlerbehandlung: Verwenden Sie das Fehlerpaket für die Verwaltung und Middleware zur zentralen Fehlerbehandlung. Authentifizierung und Autorisierung: Integrieren Sie Bibliotheken von Drittanbietern und erstellen Sie benutzerdefinierte Middleware zur Überprüfung von Anmeldeinformationen. Parallelitätsverarbeitung: Verwenden Sie Goroutinen, Mutexe und Kanäle, um den Ressourcenzugriff zu steuern. Unit-Tests: Verwenden Sie Gotest-Pakete, Mocks und Stubs zur Isolierung sowie Code-Coverage-Tools, um die Angemessenheit sicherzustellen. Bereitstellung und Überwachung: Verwenden Sie Docker-Container, um Bereitstellungen zu verpacken, Datensicherungen einzurichten und Leistung und Fehler mit Protokollierungs- und Überwachungstools zu verfolgen.

Was sind die häufigsten Missverständnisse im Lernprozess des Golang-Frameworks?

Jun 05, 2024 pm 09:59 PM

Was sind die häufigsten Missverständnisse im Lernprozess des Golang-Frameworks?

Jun 05, 2024 pm 09:59 PM

Beim Go-Framework-Lernen gibt es fünf Missverständnisse: übermäßiges Vertrauen in das Framework und eingeschränkte Flexibilität. Wenn Sie die Framework-Konventionen nicht befolgen, wird es schwierig, den Code zu warten. Die Verwendung veralteter Bibliotheken kann zu Sicherheits- und Kompatibilitätsproblemen führen. Die übermäßige Verwendung von Paketen verschleiert die Codestruktur. Das Ignorieren der Fehlerbehandlung führt zu unerwartetem Verhalten und Abstürzen.