Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Bei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker

Bei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker

Bei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker

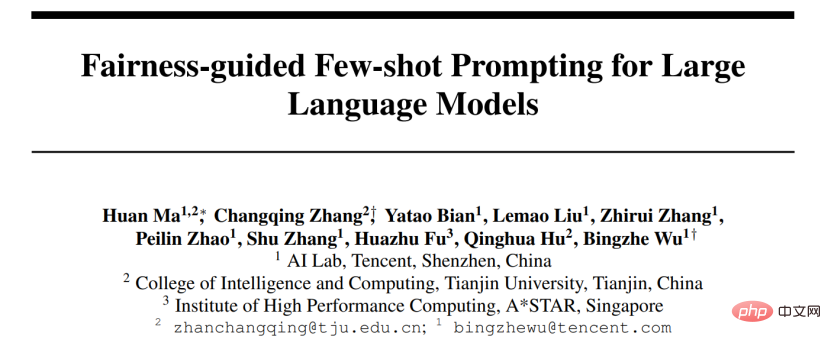

LLMs haben beim Lernen im Kontext gute Leistungen erzielt, aber die Auswahl verschiedener Beispiele führt zu völlig unterschiedlichen Leistungen. Eine aktuelle Forschungsarbeit schlägt eine schnelle Suchstrategie aus der Perspektive der Vorhersageverzerrung vor und findet ungefähr die optimale Kombination von Beispielen. ?? Aufgrund der erstaunlichen Fähigkeit können diese Modelle aus dem Kontext lernen, der aus einigen Eingabe- und Ausgabebeispielen erstellt wurde, und ohne Feinabstimmung der Optimierung direkt auf viele nachgelagerte Aufgaben angewendet werden. Frühere Untersuchungen haben jedoch gezeigt, dass kontextuelles Lernen aufgrund von Änderungen in den Trainingsbeispielen, der Beispielreihenfolge und den Aufforderungsformaten ein hohes Maß an Instabilität aufweisen kann. Daher ist die Erstellung geeigneter Eingabeaufforderungen von entscheidender Bedeutung, um die Leistung des kontextuellen Lernens zu verbessern.

Frühere Untersuchungen untersuchen dieses Problem normalerweise aus zwei Richtungen: (1) sofortige Optimierung im Codierungsraum (prompte Abstimmung), (2) Suche im ursprünglichen Raum (prompte Suche).

- Ein praktikablerer und effizienterer Ansatz besteht darin, die Eingabeaufforderungen zu optimieren, indem der ursprüngliche Textbereich nach ungefähren Demonstrationsbeispielen und -sequenzen durchsucht wird. Einige funktionieren beim Erstellen von Eingabeaufforderungen aus der „Globalen Ansicht“ oder der „Lokalen Ansicht“. Auf globalen Ansichten basierende Methoden optimieren normalerweise die verschiedenen Elemente der Eingabeaufforderung als Ganzes, um eine bessere Leistung zu erzielen. Diversitätsgesteuerte Ansätze [1] nutzen beispielsweise die Gesamtvielfalt der Demonstrationen für die Suche aus oder versuchen, die gesamte Reihenfolge der Stichprobenkombinationen zu optimieren [2], um eine bessere Leistung zu erzielen. Im Gegensatz zur globalen Ansicht funktionieren auf der lokalen Ansicht basierende Methoden, indem sie unterschiedliche heuristische Auswahlkriterien entwerfen, wie z. B. KATE [3].

- Aber diese Methoden haben ihre eigenen Grenzen: (1) Die meisten aktuellen Forschungen konzentrieren sich hauptsächlich auf die Suche nach Hinweisen entlang eines einzelnen Faktors, wie z. B. Beispielauswahl oder -reihenfolge. Der Gesamteinfluss jedes Faktors auf die Leistung ist jedoch unklar. (2) Diese Methoden basieren in der Regel auf heuristischen Kriterien und erfordern eine einheitliche Perspektive, um die Funktionsweise dieser Methoden zu erklären. (3) Noch wichtiger ist, dass vorhandene Methoden Hinweise global oder lokal optimieren, was zu einer unbefriedigenden Leistung führen kann.

Darüber hinaus ermöglicht diese voreingenommene Metrik der Methode, „lokal bis global“ nach geeigneten Eingabeaufforderungen zu suchen. Ein realistisches Problem besteht jedoch darin, dass es nicht möglich ist, durch Durchlaufen aller Kombinationen nach der optimalen Lösung zu suchen, da ihre Komplexität O (N!) überschreiten würde.

Diese Arbeit schlägt zwei neuartige Strategien vor, um auf effiziente Weise nach qualitativ hochwertigen Eingabeaufforderungen zu suchen: (1) T-fair-Prompting (2) G-fair-Prompting. T-fair-Prompting verwendet einen intuitiven Ansatz, bei dem zunächst die Abweichung jedes einzelnen Beispiels berechnet wird, das einen Prompt bildet, und dann die Top-k-fairsten Beispiele ausgewählt werden, um sie zum endgültigen Prompt zu kombinieren. Diese Strategie ist mit einer Komplexität von O (N) recht effizient. Es sollte jedoch beachtet werden, dass T-fair-Prompting auf der Annahme basiert, dass der optimale Prompt normalerweise aus den am wenigsten verzerrten Beispielen konstruiert wird. Dies trifft jedoch in der Praxis möglicherweise nicht zu und führt oft zu lokal optimalen Lösungen. Daher wird G-fair-Prompting im Artikel weiter vorgestellt, um die Suchqualität zu verbessern. G-fair-Prompting folgt dem regulären Prozess der gierigen Suche, um die optimale Lösung zu finden, indem bei jedem Schritt lokal optimale Entscheidungen getroffen werden. Bei jedem Schritt des Algorithmus werden Beispiele so ausgewählt, dass die aktualisierte Eingabeaufforderung optimale Fairness mit einer Zeitkomplexität im ungünstigsten Fall von O (N^2) erreicht, was die Suchqualität erheblich verbessert. G-fair-Prompting funktioniert aus einer lokal-globalen Perspektive, wobei die Verzerrung einzelner Stichproben in den frühen Phasen berücksichtigt wird, während sich die späteren Phasen auf die Reduzierung der globalen Vorhersageverzerrung konzentrieren.

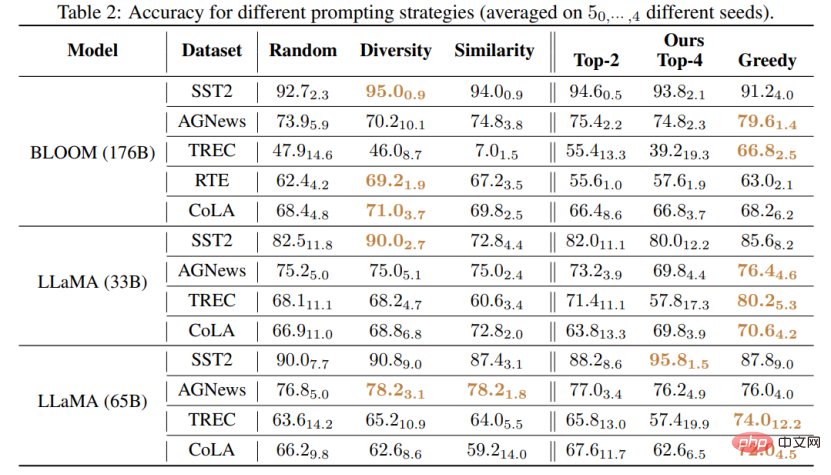

Experimentelle Ergebnisse

Diese Studie schlägt eine effektive und interpretierbare Methode zur Verbesserung der Kontextlernleistung von Sprachmodellen vor, die auf verschiedene nachgelagerte Aufgaben angewendet werden kann. Der Artikel überprüft die Wirksamkeit dieser beiden Strategien bei verschiedenen LLMs (einschließlich der GPT-Modellreihe und der kürzlich veröffentlichten LMaMA-Reihe). Im Vergleich zur SOTA-Methode erzielte G-fair-Prompting mehr als 10 % bei verschiedenen nachgelagerten Aufgaben .

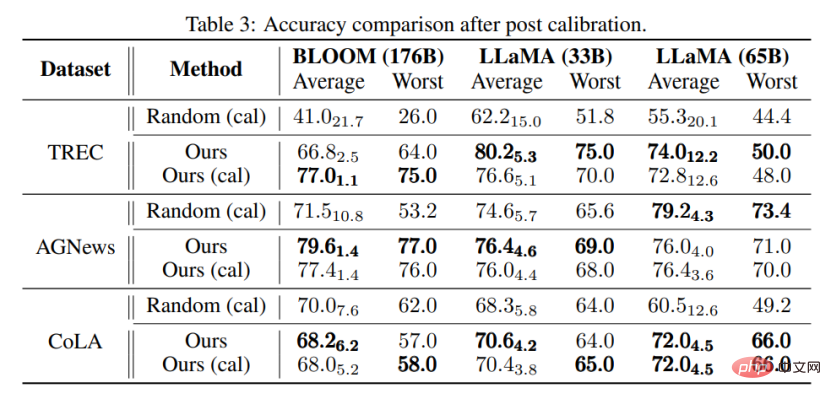

Am nächsten kommt dieser Forschung die Methode „Kalibrierung vor der Verwendung“ [4], die beide „inhaltsfreie“ Eingaben verwenden, um die Modellleistung zu verbessern. Die Methode „Kalibrierung vor der Verwendung“ ist jedoch darauf ausgelegt, diesen Standard zur Kalibrierung der Ausgabe zu verwenden, was jedoch immer noch von der Qualität der verwendeten Beispiele abhängt. Im Gegensatz dazu zielt dieser Artikel darauf ab, den ursprünglichen Raum zu durchsuchen, um eine nahezu optimale Eingabeaufforderung zur Verbesserung der Leistung des Modells zu finden, ohne dass die Modellausgabe nachbearbeitet werden muss. Darüber hinaus ist dieser Artikel der erste, der durch umfangreiche Experimente den Zusammenhang zwischen Vorhersageverzerrung und endgültiger Aufgabenleistung demonstriert, der bei Methoden zur Kalibrierung vor der Verwendung noch nicht untersucht wurde.

Durch Experimente kann auch festgestellt werden, dass die mit der in diesem Artikel vorgeschlagenen Methode ausgewählten Eingabeaufforderungen auch ohne Kalibrierung besser sein können als die kalibrierten, zufällig ausgewählten Eingabeaufforderungen. Dies zeigt, dass die Methode in praktischen Anwendungen praktisch und effektiv sein und Inspiration für zukünftige Forschung zur Verarbeitung natürlicher Sprache liefern kann.

Das obige ist der detaillierte Inhalt vonBei einer erneuten Untersuchung des Prompt-Optimierungsproblems macht die Vorhersageverzerrung das Lernen im Kontext des Sprachmodells stärker. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

In den letzten Jahren hat multimodales Lernen große Aufmerksamkeit erhalten, insbesondere in den beiden Richtungen der Text-Bild-Synthese und des kontrastiven Bild-Text-Lernens. Einige KI-Modelle haben aufgrund ihrer Anwendung bei der kreativen Bilderzeugung und -bearbeitung große öffentliche Aufmerksamkeit erregt, wie beispielsweise die von OpenAI eingeführten Textbildmodelle DALL・E und DALL-E 2 sowie GauGAN und GauGAN2 von NVIDIA. Um nicht zu übertreffen, hat Google Ende Mai sein eigenes Text-zu-Bild-Modell Imagen veröffentlicht, das die Grenzen der untertitelbedingten Bildgenerierung offenbar noch weiter erweitert. Mit nur einer Beschreibung einer Szene kann Imagen eine hohe Qualität und Auflösung erzeugen

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

3-nm-Prozess, Leistung übertrifft H100! Kürzlich brachten die ausländischen Medien DigiTimes die Nachricht, dass Nvidia die GPU der nächsten Generation, die B100, mit dem Codenamen „Blackwell“ entwickelt, angeblich als Produkt für Anwendungen im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC). Der B100 wird den 3-nm-Prozess von TSMC sowie ein komplexeres Multi-Chip-Modul (MCM)-Design nutzen und im vierten Quartal 2024 erscheinen. Nvidia, das mehr als 80 % des GPU-Marktes für künstliche Intelligenz monopolisiert, kann mit dem B100 zuschlagen, solange das Eisen heiß ist, und in dieser Welle des KI-Einsatzes weitere Herausforderer wie AMD und Intel angreifen. Nach Schätzungen von NVIDIA wird erwartet, dass der Produktionswert dieses Bereichs bis 2027 ungefähr erreicht

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! Es wurde von sieben chinesischen Forschern bei Microsoft verfasst und umfasst 119 Seiten. Es geht von zwei Arten multimodaler Forschungsrichtungen für große Modelle aus, die abgeschlossen wurden und immer noch an der Spitze stehen, und fasst fünf spezifische Forschungsthemen umfassend zusammen: visuelles Verständnis und visuelle Generierung Der vom einheitlichen visuellen Modell LLM unterstützte multimodale Großmodell-Multimodalagent konzentriert sich auf ein Phänomen: Das multimodale Grundmodell hat sich von spezialisiert zu universell entwickelt. Ps. Aus diesem Grund hat der Autor am Anfang des Artikels direkt ein Bild von Doraemon gezeichnet. Wer sollte diese Rezension (Bericht) lesen? Mit den ursprünglichen Worten von Microsoft: Solange Sie daran interessiert sind, das Grundwissen und die neuesten Fortschritte multimodaler Grundmodelle zu erlernen, egal ob Sie ein professioneller Forscher oder ein Student sind, ist dieser Inhalt sehr gut für Sie geeignet.

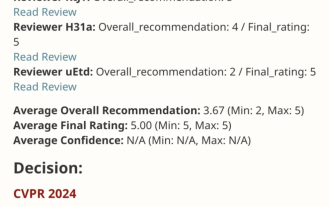

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

Diese Arbeit von EfficientSAM wurde mit einer perfekten Bewertung von 5/5/5 in CVPR2024 aufgenommen! Der Autor teilte das Ergebnis in den sozialen Medien mit, wie im Bild unten gezeigt: Der Gewinner des LeCun Turing Award hat dieses Werk ebenfalls wärmstens empfohlen! In einer aktuellen Forschung haben Meta-Forscher eine neue, verbesserte Methode vorgeschlagen, nämlich das Mask Image Pre-Training (SAMI) unter Verwendung von SAM. Diese Methode kombiniert MAE-Vortrainingstechnologie und SAM-Modelle, um hochwertige vorab trainierte ViT-Encoder zu erhalten. Durch SAMI versuchen Forscher, die Leistung und Effizienz des Modells zu verbessern und bessere Lösungen für Sehaufgaben bereitzustellen. Der Vorschlag dieser Methode bringt neue Ideen und Möglichkeiten zur weiteren Erforschung und Entwicklung der Bereiche Computer Vision und Deep Learning. durch die Kombination verschiedener

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

Die Aufgabe der Bild-zu-Video-Generierung (I2V) ist eine Herausforderung im Bereich Computer Vision, die darauf abzielt, statische Bilder in dynamische Videos umzuwandeln. Die Schwierigkeit dieser Aufgabe besteht darin, dynamische Informationen in der zeitlichen Dimension aus einem einzelnen Bild zu extrahieren und zu generieren und dabei die Authentizität und visuelle Kohärenz des Bildinhalts zu wahren. Bestehende I2V-Methoden erfordern häufig komplexe Modellarchitekturen und große Mengen an Trainingsdaten, um dieses Ziel zu erreichen. Kürzlich wurde ein neues Forschungsergebnis „I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels“ unter der Leitung von Kuaishou veröffentlicht. Diese Forschung stellt eine innovative Bild-zu-Video-Konvertierungsmethode vor und schlägt ein leichtes Adaptermodul vor, d. h.

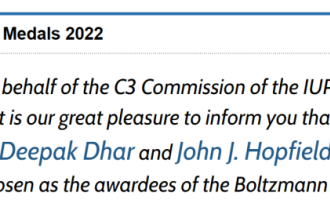

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Die beiden Wissenschaftler, die den Boltzmann-Preis 2022 gewonnen haben, wurden bekannt gegeben. Diese Auszeichnung wurde vom IUPAP-Komitee für statistische Physik (C3) ins Leben gerufen, um Forscher zu würdigen, die herausragende Leistungen auf dem Gebiet der statistischen Physik erbracht haben. Der Gewinner muss ein Wissenschaftler sein, der zuvor weder einen Boltzmann-Preis noch einen Nobelpreis gewonnen hat. Dieser Preis wurde 1975 ins Leben gerufen und wird alle drei Jahre zum Gedenken an Ludwig Boltzmann, den Begründer der statistischen Physik, verliehen. Grund für die Auszeichnung: In Anerkennung der bahnbrechenden Beiträge von Deepak Dharistheoriginalstatement auf dem Gebiet der statistischen Physik, einschließlich der exakten Lösung selbstorganisierter Systeme kritisches Modell, Schnittstellenwachstum, Störung

Der aufstrebende Google-KI-Star wechselt zu Pika: Video-Generation Lumiere fungiert als Gründungswissenschaftler

Feb 26, 2024 am 09:37 AM

Der aufstrebende Google-KI-Star wechselt zu Pika: Video-Generation Lumiere fungiert als Gründungswissenschaftler

Feb 26, 2024 am 09:37 AM

Die Videoproduktion schreitet auf Hochtouren voran und Pika hat einen großartigen General begrüßt: den Google-Forscher Omer Bar-Tal, der als Gründungswissenschaftler von Pika fungiert. Vor einem Monat veröffentlichte Google als Co-Autor das Videogenerierungsmodell Lumiere, und der Effekt war erstaunlich. Damals sagten Internetnutzer: Google beteiligt sich am Kampf um die Videogenerierung und es gibt eine weitere gute Show, die man sich ansehen kann. Einige Leute aus der Branche, darunter der CEO von StabilityAI und ehemalige Kollegen von Google, sandten ihren Segen. Lumieres erstes Werk, Omer Bar-Tal, der gerade seinen Master-Abschluss gemacht hat, schloss 2021 sein Studium an der Fakultät für Mathematik und Informatik der Universität Tel Aviv ab und ging dann zum Weizmann Institute of Science, um einen Master-Abschluss in Computer zu machen Wissenschaft mit Schwerpunkt auf der Forschung im Bereich der Bild- und Videosynthese. Die Ergebnisse seiner Abschlussarbeiten wurden mehrfach veröffentlicht