Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

30-seitiges Papier! Neue Arbeit von Yu Shiluns Team: AIGC umfassende Umfrage, Entwicklungsgeschichte von GAN bis ChatGPT

30-seitiges Papier! Neue Arbeit von Yu Shiluns Team: AIGC umfassende Umfrage, Entwicklungsgeschichte von GAN bis ChatGPT

30-seitiges Papier! Neue Arbeit von Yu Shiluns Team: AIGC umfassende Umfrage, Entwicklungsgeschichte von GAN bis ChatGPT

2022 kann man als das erste Jahr der generativen KI bezeichnen. Kürzlich veröffentlichte das Team von Yu Shilun eine umfassende Umfrage zu AIGC, in der die Entwicklungsgeschichte von GAN bis ChatGPT vorgestellt wurde.

Das gerade vergangene Jahr 2022 ist zweifellos der einzigartige Punkt der Explosion generativer KI.

Seit 2021 wurde generative KI zwei Jahre in Folge in den „Artificial Intelligence Technology Hype Cycle“ von Gartner aufgenommen und gilt als wichtiger KI-Technologietrend der Zukunft.

Kürzlich veröffentlichte das Team von Yu Shilun eine umfassende Umfrage zu AIGC, in der die Entwicklungsgeschichte von GAN bis ChatGPT vorgestellt wurde.

Papieradresse: https://arxiv.org/pdf/2303.04226.pdf

Dieser Artikel ist ein Auszug aus einem Teil des Papiers zur Einführung.

Die Singularität ist angekommen?

In den letzten Jahren haben durch künstliche Intelligenz generierte Inhalte (AIGC, auch bekannt als generative KI) große Aufmerksamkeit außerhalb der Informatik-Community auf sich gezogen.

Die gesamte Gesellschaft hat begonnen, großes Interesse an verschiedenen Produkten zur Content-Generierung zu zeigen, die von großen Technologieunternehmen wie ChatGPT und DALL-E-2 entwickelt wurden.

AIGC bezieht sich auf den Einsatz generativer künstlicher Intelligenz (GAI)-Technologie zur Generierung von Inhalten und kann in kurzer Zeit automatisch eine große Menge an Inhalten erstellen.

ChatGPT ist ein von OpenAI entwickeltes KI-System zum Aufbau von Gesprächen. Das System ist in der Lage, menschliche Sprache effektiv zu verstehen und sinnvoll darauf zu reagieren.

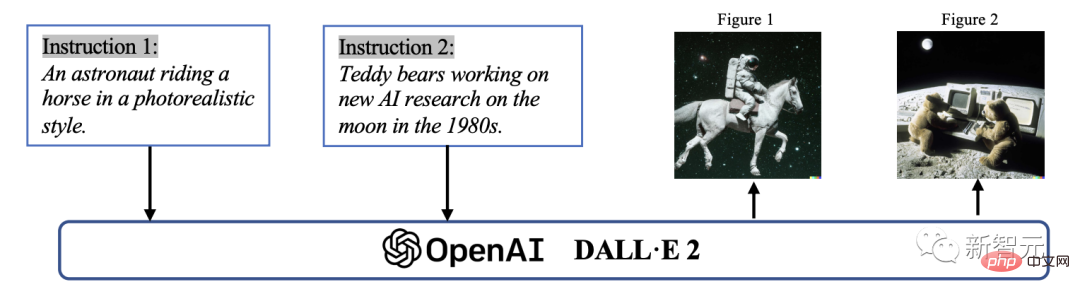

Darüber hinaus ist DALL-E-2 ein weiteres hochmodernes GAI-Modell, das von OpenAI entwickelt wurde und in der Lage ist, innerhalb von Minuten einzigartige, hochwertige Bilder aus Textbeschreibungen zu erstellen.

Beispiel für AIGC bei der Bildgenerierung

Technisch gesehen bezieht sich AIGC auf vorgegebene Anweisungen, die das Modell bei der Erledigung der Aufgabe anleiten können, wobei GAI verwendet wird, um Inhalte zu generieren, die den Anweisungen entsprechen. Dieser Generierungsprozess besteht normalerweise aus zwei Schritten: Extrahieren von Absichtsinformationen aus Anweisungen und Generieren von Inhalten basierend auf der extrahierten Absicht.

Wie frühere Studien jedoch gezeigt haben, ist das Paradigma des GAI-Modells, das die beiden oben genannten Schritte enthält, nicht völlig neu.

Im Vergleich zu früheren Arbeiten besteht der Kernpunkt der jüngsten AIGC-Fortschritte darin, komplexere generative Modelle auf größeren Datensätzen zu trainieren, größere Basismodell-Frameworks zu verwenden und Zugriff auf eine breite Palette von Computerressourcen zu haben.

Zum Beispiel ist das Hauptframework von GPT-3 dasselbe wie GPT-2, aber die Datengröße vor dem Training erhöht sich von WebText (38 GB) auf CommonCrawl (570 GB nach dem Filtern) und die Basismodellgröße erhöht sich von 1,5 B bis 175B.

Daher verfügt GPT-3 über eine bessere Generalisierungsfähigkeit als GPT-2 bei verschiedenen Aufgaben.

Zusätzlich zu den Vorteilen, die erhöhte Datenmengen und Rechenleistung mit sich bringen, erforschen Forscher auch Möglichkeiten, neue Technologien mit GAI-Algorithmen zu kombinieren.

ChatGPT nutzt beispielsweise Reinforcement Learning with Human Feedback (RLHF), um die am besten geeignete Reaktion auf eine bestimmte Anweisung zu ermitteln und so die Zuverlässigkeit und Genauigkeit des Modells im Laufe der Zeit zu verbessern. Dieser Ansatz ermöglicht es ChatGPT, menschliche Vorlieben in langen Gesprächen besser zu verstehen.

Gleichzeitig hat im Lebenslauf die von Stability AI im Jahr 2022 vorgeschlagene Stable Diffusion auch große Erfolge bei der Bilderzeugung erzielt.

Im Gegensatz zu früheren Methoden können generative Diffusionsmodelle dabei helfen, hochauflösende Bilder zu erzeugen, indem sie das Gleichgewicht zwischen Erkundung und Nutzung steuern und so eine harmonische Kombination aus Vielfalt in den generierten Bildern und Ähnlichkeiten mit den Trainingsdaten erreichen.

Durch die Kombination dieser Fortschritte hat das Modell erhebliche Fortschritte bei der Mission von AIGC gemacht und wurde von so unterschiedlichen Branchen wie Kunst, Werbung und Bildung übernommen.

In naher Zukunft wird AIGC weiterhin ein wichtiger Bereich der maschinellen Lernforschung werden.

Generell können GAI-Modelle in zwei Typen unterteilt werden: Single-Modal-Modelle und Multi-Modal-Modelle

Daher ist es von entscheidender Bedeutung, eine umfassende Überprüfung der bisherigen Forschung durchzuführen und bestehende Probleme in diesem Bereich zu identifizieren. Dies ist die erste Umfrage, die sich auf Kerntechnologien und -anwendungen im AIGC-Bereich konzentriert.

Dies ist das erste Mal, dass AIGC eine umfassende Umfrage zu GAI in Bezug auf Technologie und Anwendungen zusammenfasst.

Frühere Umfragen führten GAI hauptsächlich aus verschiedenen Perspektiven ein, darunter die Generierung natürlicher Sprache, die Bildgenerierung und die Generierung multimodalen maschinellen Lernens. Diese früheren Arbeiten konzentrierten sich jedoch nur auf bestimmte Teile von AIGC.

In dieser Umfrage haben wir zunächst die grundlegenden Technologien untersucht, die üblicherweise in AIGC verwendet werden. Anschließend wird eine umfassende Zusammenfassung fortgeschrittener GAI-Algorithmen bereitgestellt, einschließlich der unimodalen und multimodalen Generierung. Darüber hinaus untersucht das Papier die Anwendungen und potenziellen Herausforderungen von AIGC.

Abschließend wird die zukünftige Ausrichtung dieses Bereichs hervorgehoben. Zusammenfassend sind die Hauptbeiträge dieses Papiers wie folgt:

– Nach unserem besten Wissen sind wir die ersten, die eine formale Definition und einen umfassenden Überblick über AIGC und KI-gestützte generative Prozesse liefern.

-Wir haben die Geschichte und die Basistechnologie von AIGC überprüft und eine umfassende Analyse der neuesten Fortschritte bei GAI-Aufgaben und -Modellen aus der Perspektive der unimodalen und multimodalen Generierung durchgeführt.

-In diesem Artikel werden die wichtigsten Herausforderungen für AIGC und zukünftige Forschungstrends erörtert.

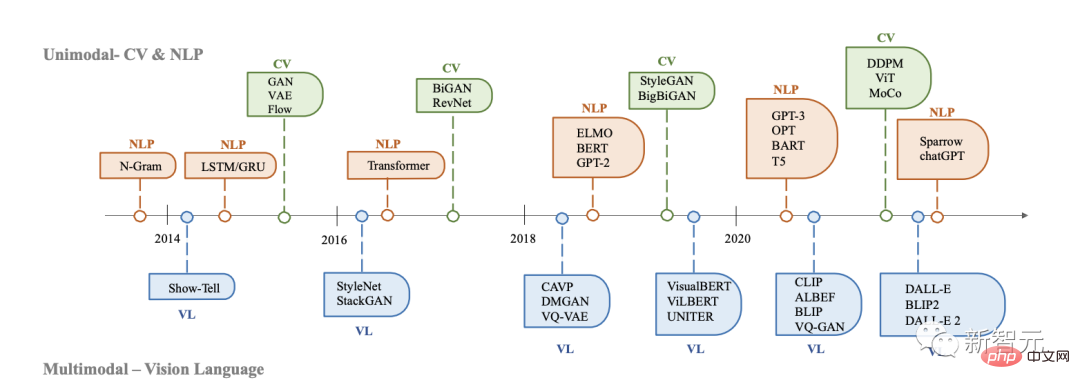

Geschichte der generativen KI

Generative Modelle haben eine lange Geschichte in der künstlichen Intelligenz, die bis zur Entwicklung von Hidden-Markov-Modellen (HMMs) und Gaußschen Mischungsmodellen (GMMs) in den 1950er Jahren zurückreicht.

Diese Modelle generieren kontinuierliche Daten wie Sprache und Zeitreihen. Allerdings verbesserte sich die Leistung generativer Modelle erst mit dem Aufkommen von Deep Learning deutlich.

In frühen tiefen generativen Modellen gab es in verschiedenen Domänen normalerweise keine großen Überschneidungen.

Geschichte der Entwicklung generativer KI in CV, NLP und VL

In NLP besteht die traditionelle Methode zur Satzgenerierung darin, ein N-Gramm-Sprachmodell zu verwenden, um die Verteilung von Wörtern zu lernen und dann nach den besten zu suchen Sequenz. Diese Methode kann sich jedoch nicht effektiv an lange Sätze anpassen.

Um dieses Problem zu lösen, wurden später wiederkehrende neuronale Netze (RNNs) in Sprachmodellierungsaufgaben eingeführt, die die Modellierung relativ langer Abhängigkeiten ermöglichen.

Zweitens ist die Entwicklung von Long Short-Term Memory (LSTM) und Gated Recurrent Units (GRU), die Gating-Mechanismen nutzen, um das Gedächtnis während des Trainings zu steuern. Diese Methoden sind in der Lage, etwa 200 Token in einer Stichprobe zu verarbeiten, was eine deutliche Verbesserung im Vergleich zu N-Gramm-Sprachmodellen darstellt.

Vor dem Aufkommen von Deep-Learning-basierten Methoden nutzten traditionelle Bilderzeugungsalgorithmen im Lebenslauf Techniken wie Textursynthese (PTS) und Texturabbildung.

Diese Algorithmen basieren auf manuell entwickelten Funktionen und verfügen nur über begrenzte Möglichkeiten zur Generierung komplexer und vielfältiger Bilder.

Generative Adversarial Networks (GANs) wurden 2014 erstmals vorgeschlagen und wurden aufgrund ihrer beeindruckenden Ergebnisse in verschiedenen Anwendungen zu einem Meilenstein auf dem Gebiet der künstlichen Intelligenz.

Variant Autoencoder (VAEs) und andere Methoden, wie z. B. generative Diffusionsmodelle, wurden ebenfalls entwickelt, um eine detailliertere Kontrolle über den Bilderzeugungsprozess zu ermöglichen und die Erzeugung hochwertiger Bilder zu ermöglichen.

Die Entwicklung generativer Modelle in verschiedenen Bereichen verläuft auf unterschiedlichen Wegen, aber am Ende gibt es einen Schnittpunkt: Transformer-Architektur.

Im Jahr 2017 wurde Transformer von Vaswani et al. in NLP-Aufgaben eingeführt, später auf CV angewendet und wurde dann zur vorherrschenden Architektur für viele generative Modelle in verschiedenen Bereichen.

Im Bereich NLP verwenden viele bekannte große Sprachmodelle wie BERT und GPT die Transformer-Architektur als Hauptbaustein. Vorteile im Vergleich zu früheren Bausteinen, nämlich LSTM und GRU.

In CV entwickelten Vision Transformer (ViT) und Swin Transformer dieses Konzept später weiter, indem sie die Transformer-Architektur mit einer Vision-Komponente kombinierten und so die Anwendung auf bildbasierte Downlink-Systeme ermöglichten.

Zusätzlich zu den Verbesserungen, die Transformer an einer einzelnen Modalität mit sich bringt, ermöglicht dieser Crossover auch die Zusammenführung von Modellen aus verschiedenen Bereichen, um multimodale Aufgaben auszuführen.

Ein Beispiel für ein multimodales Modell ist CLIP. CLIP ist ein gemeinsames visuelles Sprachmodell. Es kombiniert die Transformer-Architektur mit einer visuellen Komponente und ermöglicht so das Training großer Text- und Bilddatenmengen.

Durch die Kombination von visuellem und sprachlichem Wissen im Vortraining kann CLIP auch als Bildencoder bei der multimodalen Cue-Generierung verwendet werden. Kurz gesagt, das Aufkommen transformatorbasierter Modelle hat die Erzeugung künstlicher Intelligenz revolutioniert und die Möglichkeit groß angelegter Schulungen eröffnet.

In den letzten Jahren haben Forscher auch damit begonnen, neue Technologien auf Basis dieser Modelle einzuführen.

Um beispielsweise im NLP dem Modell zu helfen, die Aufgabenanforderungen besser zu verstehen, bevorzugen die Leute manchmal Hinweise mit wenigen Schüssen. Es bezieht sich auf die Aufnahme einiger aus dem Datensatz ausgewählter Beispiele in die Eingabeaufforderung.

In visuellen Sprachen kombinieren Forscher musterspezifische Modelle mit selbstüberwachten kontrastiven Lernzielen, um leistungsfähigere Darstellungen bereitzustellen.

Da AIGC in Zukunft immer wichtiger wird, werden immer mehr Technologien eingeführt, die diesem Bereich große Vitalität verleihen werden.

AIGC-Grundlagen

In diesem Abschnitt werden die häufig verwendeten Grundmodelle von AIGC vorgestellt.

Basismodell

Transformer

Transformer ist die Rückgratarchitektur vieler hochmoderner Modelle wie GPT-3, DALL-E-2, Codex und Gopher.

Es wurde zunächst vorgeschlagen, die Einschränkungen traditioneller Modelle wie RNNs bei der Verarbeitung von Sequenzen variabler Länge und dem Kontextbewusstsein zu lösen.

Die Architektur von Transformer basiert hauptsächlich auf einem Selbstaufmerksamkeitsmechanismus, der es dem Modell ermöglicht, auf verschiedene Teile der Eingabesequenz zu achten.

Transformer besteht aus einem Encoder und einem Decoder. Der Encoder empfängt eine Eingabesequenz und generiert eine versteckte Darstellung, während der Decoder eine versteckte Darstellung empfängt und eine Ausgabesequenz generiert.

Jede Schicht des Encoders und Decoders besteht aus einer Mehrkopf-Aufmerksamkeit und einem Feed-Forward-Neuronalen Netzwerk. Multi-Head-Aufmerksamkeit ist die Kernkomponente von Transformer, die lernt, basierend auf der Relevanz von Tags unterschiedliche Gewichtungen zuzuweisen.

Dieser Informationsrouting-Ansatz ermöglicht es dem Modell, langfristige Abhängigkeiten besser zu bewältigen und verbessert daher die Leistung bei einer Vielzahl von NLP-Aufgaben.

Ein weiterer Vorteil von Transformer besteht darin, dass seine Architektur hochgradig parallel ist und es den Daten ermöglicht, induktive Vorspannung zu überwinden. Durch diese Funktion eignet sich Transformer sehr gut für groß angelegte Vorschulungen, sodass sich Transformer-basierte Modelle an verschiedene nachgelagerte Aufgaben anpassen können.

Vorab trainiertes Sprachmodell

Seit der Einführung der Transformer-Architektur ist sie aufgrund ihrer Parallelität und Lernfähigkeit zu einer gängigen Wahl für die Verarbeitung natürlicher Sprache geworden.

Im Allgemeinen können diese auf Transformer basierenden vorab trainierten Sprachmodelle entsprechend ihrer Trainingsaufgabe normalerweise in zwei Kategorien unterteilt werden: autoregressive Sprachmodelle und Maskensprachmodelle.

Bei einem Satz, der aus mehreren Token besteht, besteht das Ziel der maskierten Sprachmodellierung wie BERT und RoBERTa darin, die Wahrscheinlichkeit vorherzusagen, dass das maskierte Token kontextbezogene Informationen erhält.

Das bemerkenswerteste Beispiel für ein maskiertes Sprachmodell ist BERT, das maskierte Sprachmodellierung und Aufgaben zur Vorhersage des nächsten Satzes umfasst. RoBERTa verwendet die gleiche Architektur wie BERT und verbessert seine Leistung durch die Erhöhung der Menge an Pre-Training-Daten und die Einbeziehung anspruchsvollerer Pre-Training-Ziele.

XL-Net basiert auch auf BERT, das Permutationsoperationen beinhaltet, um die Reihenfolge der Vorhersagen für jede Trainingsiteration zu ändern, sodass das Modell mehr Label-übergreifende Informationen lernen kann.

Und autoregressive Sprachmodelle wie GPT-3 und OPT modellieren die Wahrscheinlichkeit angesichts des vorherigen Tokens und sind daher von links nach rechts gerichtete Sprachmodelle. Im Gegensatz zu maskierten Sprachmodellen eignen sich autoregressive Sprachmodelle besser für generative Aufgaben.

Verstärkendes Lernen aus menschlichem Feedback

Obwohl AIGC auf großen Datenmengen trainiert wurde, gibt AIGC möglicherweise nicht immer Inhalte aus, die mit der Absicht des Benutzers übereinstimmen.

Um die AIGC-Ausgabe besser an die menschlichen Vorlieben anzupassen, wurde Verstärkungslernen aus menschlichem Feedback (RLHF) zur Modellfeinabstimmung in verschiedenen Anwendungen wie Sparrow, InstructGPT und ChatGPT eingesetzt.

Normalerweise umfasst der gesamte Prozess von RLHF die folgenden drei Schritte: Vortraining, Belohnungslernen und Feinabstimmung des Verstärkungslernens.

Computing

Hardware

In den letzten Jahren hat die Hardwaretechnologie erhebliche Fortschritte gemacht und das Training großer Modelle erleichtert.

In der Vergangenheit konnte das Training eines großen neuronalen Netzwerks mithilfe einer CPU Tage oder sogar Wochen dauern. Mit der Steigerung der Rechenleistung wurde dieser Prozess jedoch um mehrere Größenordnungen beschleunigt.

Zum Beispiel ist die NVIDIA A100-GPU von NVIDIA im groß angelegten BERT-Inferenzprozess 7-mal schneller als V100 und 11-mal schneller als T4.

Darüber hinaus ist Googles Tensor Processing Unit (TPU) speziell für Deep Learning konzipiert und bietet im Vergleich zur A100-GPU eine höhere Rechenleistung.

Beschleunigte Fortschritte bei der Rechenleistung haben die Effizienz des Modelltrainings für künstliche Intelligenz erheblich verbessert und neue Möglichkeiten für die Entwicklung großer und komplexer Modelle eröffnet.

Verteiltes Training

Eine weitere große Verbesserung ist das verteilte Training.

Beim traditionellen maschinellen Lernen wird das Training normalerweise auf einer Maschine mit einem einzelnen Prozessor durchgeführt. Dieser Ansatz eignet sich gut für kleine Datensätze und Modelle, wird jedoch beim Umgang mit großen Datensätzen und komplexen Modellen unpraktisch.

Beim verteilten Training werden die Trainingsaufgaben auf mehrere Prozessoren oder Maschinen verteilt, was die Trainingsgeschwindigkeit des Modells erheblich verbessert.

Einige Unternehmen haben auch Frameworks veröffentlicht, die den verteilten Trainingsprozess von Deep-Learning-Stacks vereinfachen. Diese Frameworks stellen Tools und APIs bereit, die es Entwicklern ermöglichen, Trainingsaufgaben einfach auf mehrere Prozessoren oder Maschinen zu verteilen, ohne die zugrunde liegende Infrastruktur verwalten zu müssen.

Cloud Computing

Cloud Computing spielt auch eine wichtige Rolle beim Training großer Modelle. Früher wurden Models oft vor Ort ausgebildet. Da Cloud-Computing-Dienste wie AWS und Azure nun Zugriff auf leistungsstarke Rechenressourcen bieten, können Deep-Learning-Forscher und -Praktiker bei Bedarf große GPU- oder TPU-Cluster erstellen, die für das Training großer Modelle erforderlich sind.

Insgesamt ermöglichen diese Fortschritte die Entwicklung komplexerer und genauerer Modelle und eröffnen neue Möglichkeiten in verschiedenen Bereichen der Forschung und Anwendung künstlicher Intelligenz.

Vorstellung des Autors

Philip S. Yu ist ein Wissenschaftler auf dem Gebiet der Informatik, ein ACM/IEEE Fellow und ein angesehener Professor am Department of Computer Science der University of Illinois at Chicago (UIC).

Er hat weltbekannte Erfolge in der Theorie und Technologie des Big Data Mining und Managements erzielt. Als Reaktion auf die Herausforderungen von Big Data in Bezug auf Umfang, Geschwindigkeit und Vielfalt hat er effektive und innovative Lösungen für Data-Mining- und Managementmethoden und -technologien vorgeschlagen, insbesondere für die Integration verschiedener Daten, das Mining von Datenströmen, häufigen Mustern und Unterräumen . Er leistete bahnbrechende Beiträge zur Grafik.

Er leistete auch bahnbrechende Beiträge auf dem Gebiet der parallelen und verteilten Datenbankverarbeitungstechnologie und wandte diese auf das IBM S/390 Parallel Sysplex-System an, wodurch der traditionelle IBM-Mainframe erfolgreich in eine parallele Mikroprozessorarchitektur umgewandelt wurde.

Das obige ist der detaillierte Inhalt von30-seitiges Papier! Neue Arbeit von Yu Shiluns Team: AIGC umfassende Umfrage, Entwicklungsgeschichte von GAN bis ChatGPT. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek: