Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.

Das erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.

Das erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.

Mit der Veröffentlichung von DALL-E 2 durch OpenAI sind autoregressive und Diffusionsmodelle über Nacht zum neuen Standard für groß angelegte generative Modelle geworden. Davor waren Generative Adversarial Networks (GAN) immer die gängige Wahl und abgeleitete Technologien wie StyleGAN . .

Hinter der Popularität von AIGC stand aus technischer Sicht eine große Veränderung in der Architektur des Bilderzeugungsmodells.

Mit der Veröffentlichung von DALL-E 2 durch OpenAI sind autoregressive und Diffusionsmodelle über Nacht zum neuen Standard für groß angelegte generative Modelle geworden. Davor waren Generative Adversarial Networks (GAN) immer die gängige Wahl und abgeleitete StyleGAN und andere Technologien.

Der architektonische Wandel vom GAN- zum Diffusionsmodell wirft auch eine Frage auf: Kann die Leistung durch eine Vergrößerung des GAN-Modells beispielsweise in einem großen Datensatz wie LAION weiter verbessert werden?

Als Reaktion auf das Instabilitätsproblem, das durch die Erhöhung der Kapazität der StyleGAN-Architektur verursacht wurde, haben Forscher der Pohang University of Science and Technology (Südkorea), der Carnegie Mellon University und dem Adobe Research Institute kürzlich eine neue generative kontradiktorische Netzwerkarchitektur GigaGAN vorgeschlagen durchbricht die Skalierungsgrenze des Modells und zeigt, dass GAN weiterhin als Text-zu-Bild-Synthesemodell geeignet sein kann.

Papierlink: https://arxiv.org/abs/2303.05511

Projektlink: https://mingukkang.github.io/GigaGAN/

GigaGAN hat drei große Vorteile.

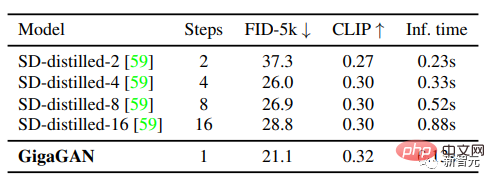

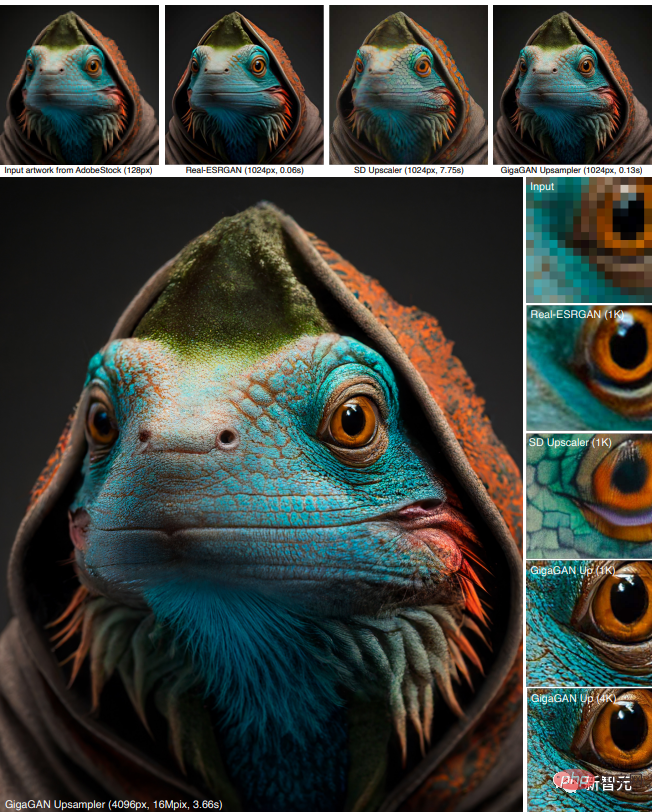

1. Im Vergleich zu Stable Diffusion-v1.5 mit der gleichen Parameterstufe ist die Generierungsgeschwindigkeit bei 512 Sekunden von 2,9 Sekunden auf 0,13 Sekunden verkürzt.

2. Kann hochauflösende Bilder synthetisieren, beispielsweise ein 16-Megapixel-Bild in 3,66 Sekunden.

3 Unterstützt verschiedene Anwendungen zur Bearbeitung latenter Räume, wie z. B. latente Interpolation, Stilmischung und Vektorarithmetikoperationen.

Eine Reihe kürzlich veröffentlichter Modelle wie DALL-E 2, Imagen, Parti und Stable Diffusion läuten eine neue Ära der Bilderzeugung ein und erreichen ein beispielloses Maß an Bildqualität und Modellflexibilität.

Die derzeit vorherrschenden Paradigmen „Diffusionsmodell“ und „autoregressives Modell“ basieren beide auf dem zweischneidigen Schwert des iterativen Denkens, da die iterative Methode ein stabiles Training mit einfachen Zielen durchführen kann, während des Inferenzprozesses jedoch Fehler erzeugt Rechenaufwand.

Im Gegensatz dazu benötigen Generative Adversarial Networks (GAN) nur einen Vorwärtsdurchlauf, um Bilder zu generieren, sodass sie von Natur aus effizienter sind.

Obwohl GAN-Modelle die „vorherige Ära“ der generativen Modellierung dominierten, erfordert die Erweiterung von GAN aufgrund der Instabilität im Trainingsprozess eine sorgfältige Anpassung der Netzwerkstruktur und Trainingsüberlegungen. Daher werden GANs zwar für Einzel- oder Einzelmodelle verwendet Die Modellierung mehrerer Objektklassen, aber die Skalierung auf komplexe Datensätze (ganz zu schweigen von der Generierung von Open-World-Objekten) bleibt eine Herausforderung.

Daher konzentrieren sich derzeit sehr große Modelle, Daten und Rechenressourcen hauptsächlich auf Diffusions- und autoregressive Modelle.

In dieser Arbeit beschäftigen sich die Forscher hauptsächlich mit den folgenden Fragen:

Kann GAN weiterhin skalieren und möglicherweise von diesen Ressourcen profitieren? Oder stößt GAN bereits an seine Grenzen? Was behindert den weiteren Ausbau von GANs? Können diese Hindernisse überwunden werden?

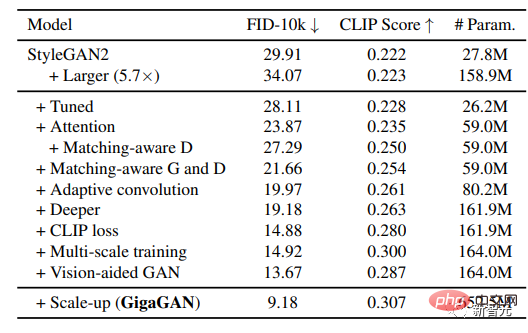

Die Forscher führten zunächst Experimente mit StyleGAN2 durch und stellten fest, dass eine einfache Erweiterung des Backbone-Netzwerks zu instabilem Training führen würde. Nachdem sie mehrere Schlüsselprobleme identifiziert hatten, schlugen sie vor, das Training zu stabilisieren und gleichzeitig die Modellkapazität zu erhöhen.

Erweitern Sie zunächst effektiv die Kapazität des Generators, indem Sie eine Reihe von Filtern beibehalten und eine lineare Kombination spezifischer Proben entnehmen.

Mehrere Techniken, die üblicherweise im Kontext von Diffusionsmodellen verwendet werden, wurden angepasst und bestätigt, dass sie ähnliche Leistungsverbesserungen für GANs bewirken können, wie z. B. die Kombination von Selbstaufmerksamkeitsmechanismus (nur Bild) und Kreuzaufmerksamkeitsmechanismus (Bild-Text) mit Faltung Schichten verbessern die Leistung.

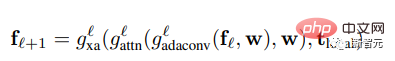

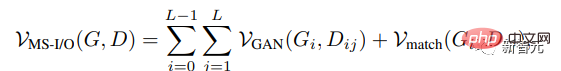

Darüber hinaus führten die Forscher das Multiskalentraining wieder ein und fanden ein neues Schema, das die Bild-Text-Ausrichtung verbessern und niederfrequente Details in der Ausgabe erzeugen kann.

Multiskalentraining ermöglicht es GAN-basierten Generatoren, Parameter in Blöcken mit niedriger Auflösung effizienter zu nutzen, was zu einer besseren Bild-Text-Ausrichtung und Bildqualität führt.

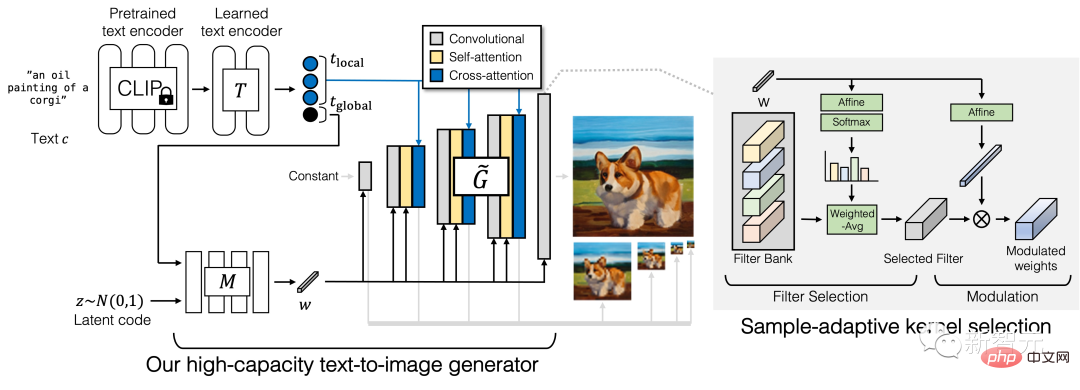

Generator

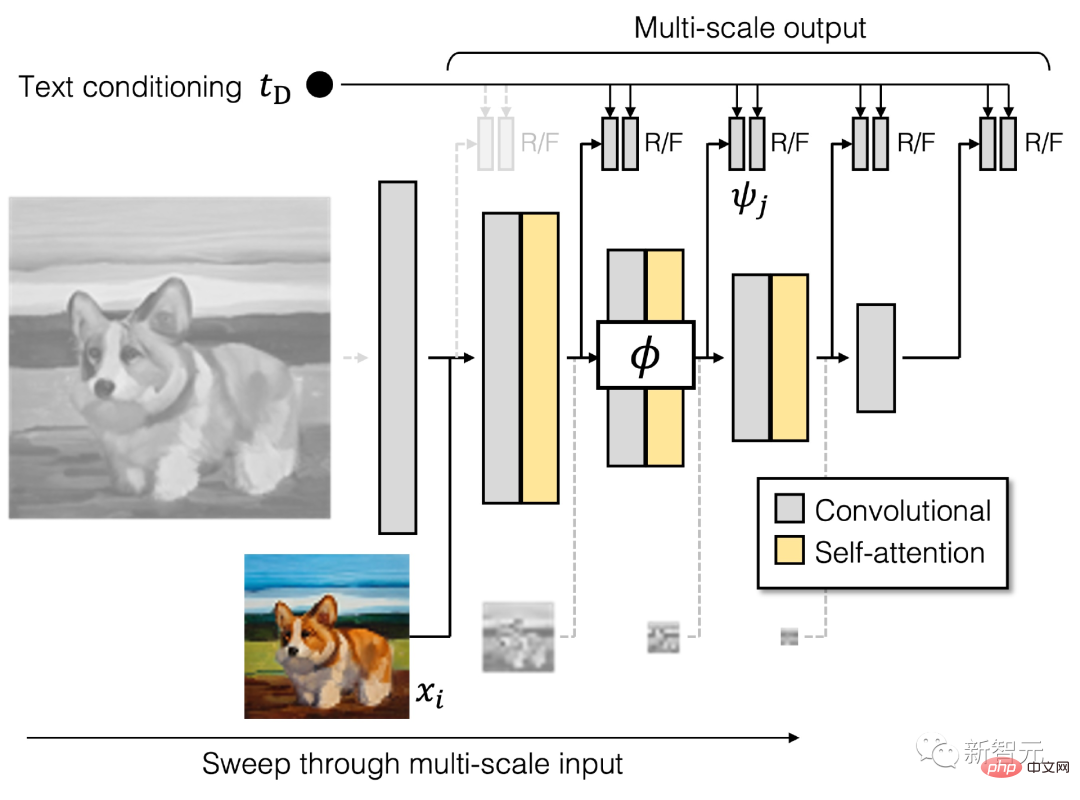

Der Generator von GigaGAN besteht aus einem Textkodierungszweig, einem Stilzuordnungsnetzwerk und einem Multiskalensynthesenetzwerk, ergänzt durch stabile Aufmerksamkeit und adaptive Kernelauswahl.

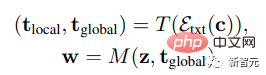

Im Textkodierungszweig werden zunächst ein vorab trainiertes CLIP-Modell und eine erlernte Aufmerksamkeitsschicht T verwendet, um Texteinbettungen zu extrahieren, und dann wird der Einbettungsprozess an das Stilzuordnungsnetzwerk M übergeben, um einen ähnlichen Stilvektor w zu generieren zu StyleGAN

Das Synthesenetzwerk verwendet Stilkodierung als Modulation und Texteinbettung als Aufmerksamkeit, um eine Bildpyramide zu generieren. Auf dieser Grundlage wird ein Beispielalgorithmus für die adaptive Kernelauswahl eingeführt, um eine Faltung basierend auf Eingabetextbedingungen zu implementieren. Adaptive Kernelauswahl.

Diskriminator

Ähnlich wie der Generator besteht der Diskriminator von GigaGAN aus zwei Zweigen, die zur Verarbeitung von Bild- bzw. Textbedingungen verwendet werden.

Der Textzweig verarbeitet den Textzweig ähnlich wie der Generator; der Bildzweig erhält eine Bildpyramide als Eingabe und trifft unabhängige Vorhersagen für jeden Bildmaßstab.

In die Formel werden mehrere zusätzliche Verlustfunktionen eingeführt, um eine schnelle Konvergenz zu fördern.

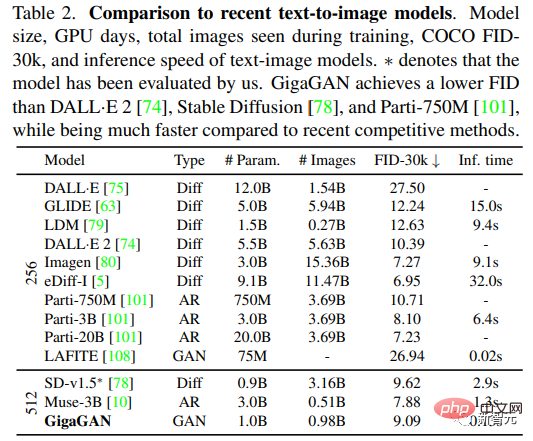

Die Durchführung einer systematischen, kontrollierten Bewertung umfangreicher Text-Bild-Syntheseaufgaben ist schwierig, da die meisten vorhandenen Modelle nicht öffentlich verfügbar sind und selbst wenn der Trainingscode verfügbar ist, das Training eines neuen Modells von Grund auf erforderlich ist Auch die Kosten des Modells wären unerschwinglich.

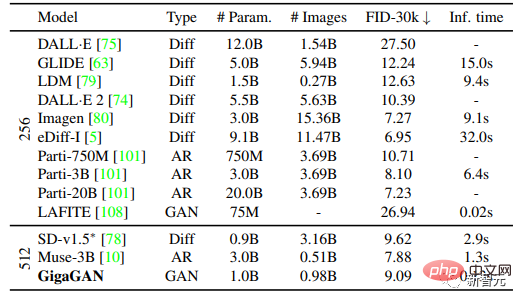

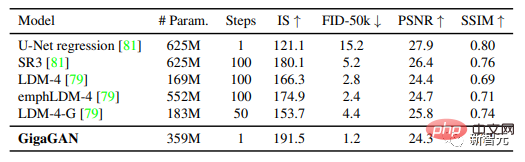

Die Forscher entschieden sich für den Vergleich in ihren Experimenten mit Imagen, Latent Diffusion Models (LDM), Stable Diffusion und Parti, räumten jedoch ein, dass es erhebliche Unterschiede bei Trainingsdatensätzen, Anzahl der Iterationen, Batchgrößen und Modellgrößen gibt.

Für quantitative Bewertungsindikatoren wird die Frechet Inception Distance (FID) hauptsächlich zur Messung der Authentizität der Ausgabeverteilung verwendet, und der CLIP-Score wird zur Bewertung der Bild-Text-Ausrichtung verwendet.

Fünf verschiedene Experimente wurden in der Arbeit durchgeführt:

1 Um die Wirksamkeit der vorgeschlagenen Methode durch schrittweise Einbeziehung jeder technischen Komponente zu demonstrieren;

2 Zeigen Sie, dass GigaGAN eine vergleichbare FID wie stabile Diffusion (SD-v1.5) aufweist und dabei hunderte Male schneller Ergebnisse liefert als Diffusions- oder autoregressive Modelle. 3. Vergleich von GigaGAN mit destillationsbasiertem Vergleich mit der Diffusion Das Modell zeigt, dass GigaGAN schneller Bilder mit höherer Qualität synthetisieren kann als das destillationsbasierte Diffusionsmodell.

4

5 Die Ergebnisse zeigen, dass große GANs immer noch die kontinuierlichen und zerlegten latenten Raumoperationen von GANs nutzen, was neue Bildbearbeitungsmodi ermöglicht.

Nach der Anpassung der Parameter haben Forscher ein stabiles und skalierbares Training eines Milliarden-Parameter-GAN (GigaGAN) auf großen Datensätzen wie LAION2B-en erreicht.

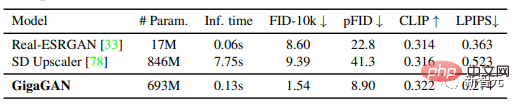

Und die Methode verfolgt einen mehrstufigen Ansatz, bei dem zunächst mit 64×64 generiert und dann auf 512×512 hochgesampelt wird. Diese beiden Netzwerke sind modular und leistungsstark genug, um Plug-and-Play-Nutzung zu ermöglichen .

Die Ergebnisse zeigen, dass das textkonditionierte GAN-Upsampling-Netzwerk als effizienter, hochwertiger Upsampler für grundlegende Diffusionsmodelle (wie DALL-E 2) dienen kann, obwohl während des Trainings nie Bilder des Diffusionsmodells gesehen werden.

Zusammengenommen machen diese Ergebnisse GigaGAN früheren GAN-Modellen weit überlegen, 36-mal größer als StyleGAN2 und 6-mal größer als StyleGAN-XL und XMC-GAN.

Obwohl das Parametervolumen von 1 Milliarde GiGAN immer noch geringer ist als das der größten kürzlich veröffentlichten synthetischen Modelle wie Imagen (3B), DALL-E 2 (5,5B) und Parti (20B), ist dies noch nicht der Fall Es wurde eine Sättigung der verfügbaren Masse in Bezug auf die Modellgröße beobachtet.

GigaGAN erreichte im COCO2014-Datensatz einen Zero-Shot-FID von 9,09, was niedriger ist als der FID von DALL-E 2, Parti-750M und Stable Diffusion

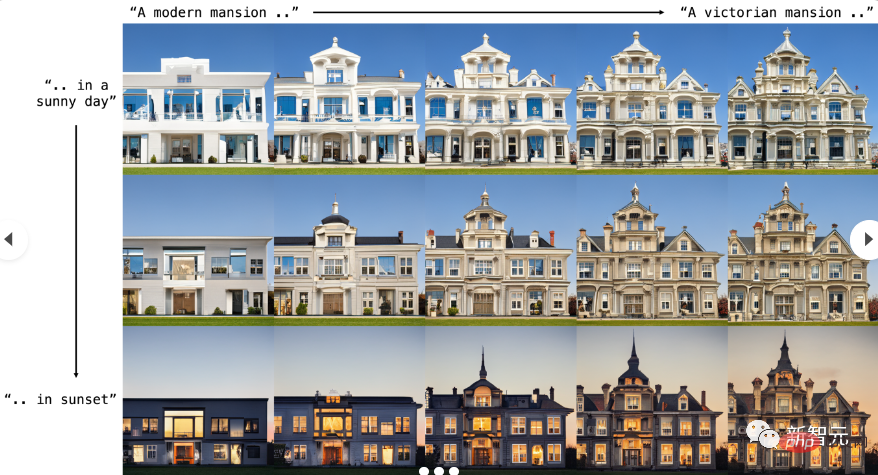

Prompte Interpolation

GigaGAN kann reibungslos zwischen Hinweisen interpolieren. Die vier Ecken im Bild unten werden durch denselben latenten Code generiert, jedoch mit unterschiedlichen Texthinweisen.

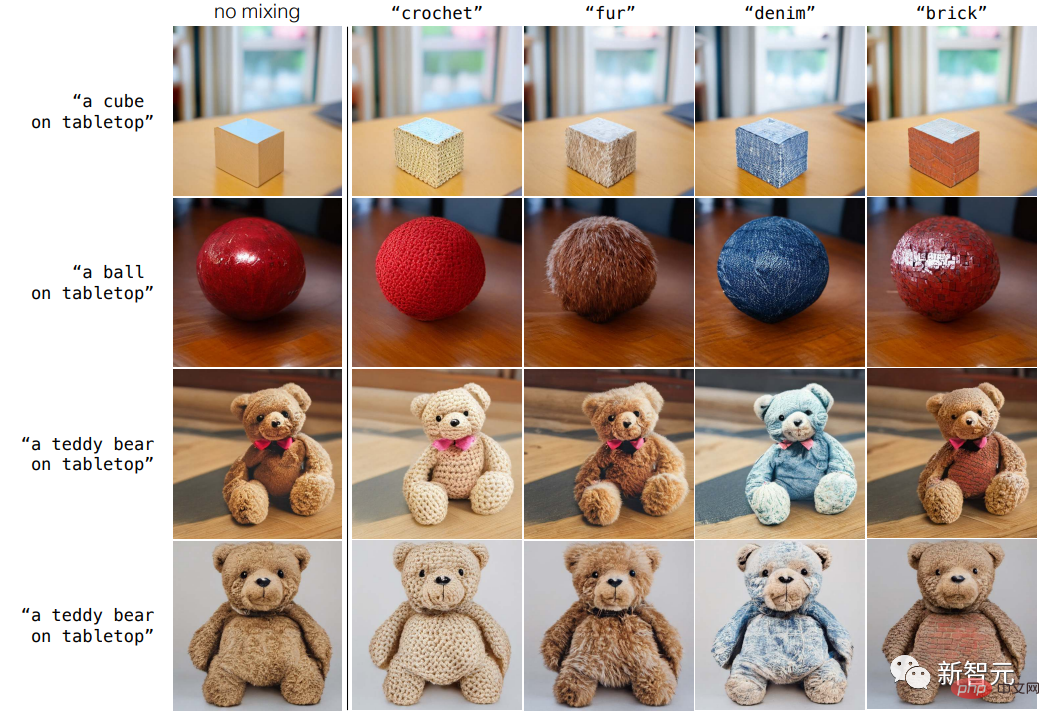

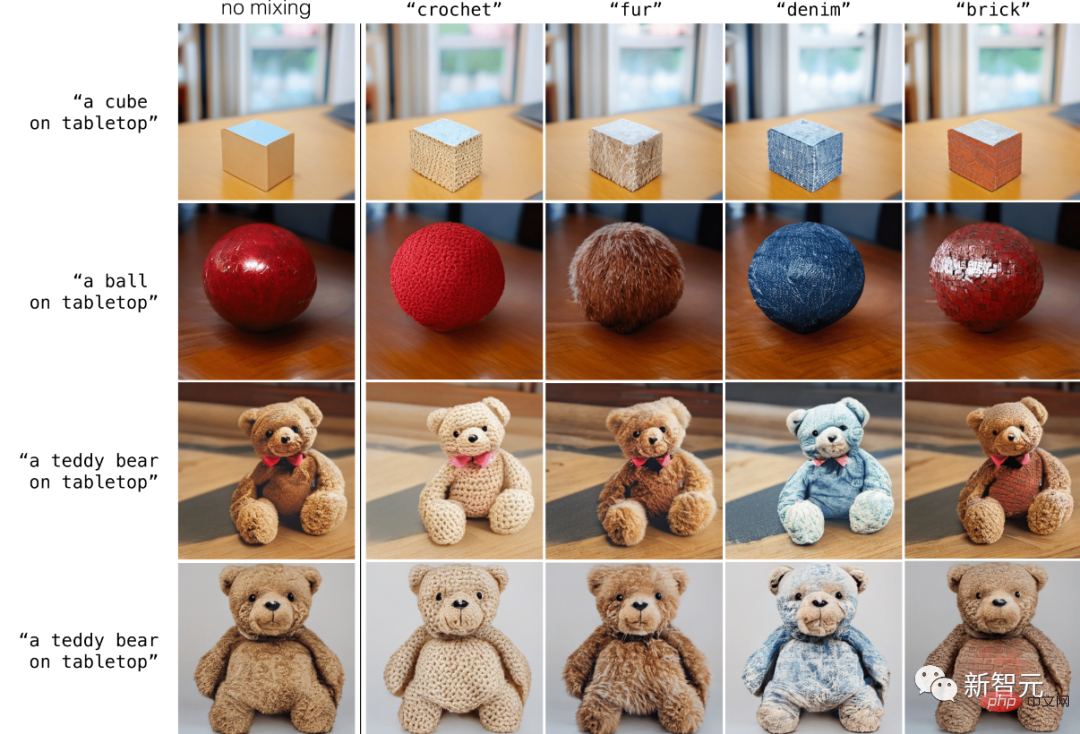

Entwirrtes Prompt-Mixing

GigaGAN bewahrt einen getrennten latenten Raum und ermöglicht so die Kopplung des groben Stils einer Probe mit dem feinen Stil einer anderen Probe, und GigaGAN kann Stile direkt über Textaufforderungen steuern .

Austausch von groben zu feinen Stilen

Die GAN-basierte Modellarchitektur behält einen separaten latenten Raum bei, sodass der grobe Stil einer Probe mit einer anderen verglichen werden kann. Eine Probe feiner Stile gemischt zusammen.

Referenz:

https://mingukkan.github.io/GigaGAN/

Das obige ist der detaillierte Inhalt vonDas erste ultragroße GAN-Modell! Die Generierungsgeschwindigkeit ist mehr als 20-mal schneller als bei Diffusion und das Bild wird in 0,13 Sekunden erstellt. Es werden bis zu 16 Millionen Pixel unterstützt.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1392

1392

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Was passiert, wenn das Netzwerk keine Verbindung zum WLAN herstellen kann?

Apr 03, 2024 pm 12:11 PM

Was passiert, wenn das Netzwerk keine Verbindung zum WLAN herstellen kann?

Apr 03, 2024 pm 12:11 PM

1. Überprüfen Sie das WLAN-Passwort: Stellen Sie sicher, dass das von Ihnen eingegebene WLAN-Passwort korrekt ist und achten Sie auf die Groß-/Kleinschreibung. 2. Überprüfen Sie, ob das WLAN ordnungsgemäß funktioniert: Überprüfen Sie, ob der WLAN-Router normal funktioniert. Sie können andere Geräte an denselben Router anschließen, um festzustellen, ob das Problem beim Gerät liegt. 3. Starten Sie das Gerät und den Router neu: Manchmal liegt eine Fehlfunktion oder ein Netzwerkproblem mit dem Gerät oder Router vor, und ein Neustart des Geräts und des Routers kann das Problem lösen. 4. Überprüfen Sie die Geräteeinstellungen: Stellen Sie sicher, dass die WLAN-Funktion des Geräts eingeschaltet und die WLAN-Funktion nicht deaktiviert ist.

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil