Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Als GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %

Als GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %

Als GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %

GPT-4s Denkweise wird immer menschlicher.

Wenn Menschen Fehler machen, werden sie über ihre Handlungen nachdenken, um zu vermeiden, dass sie erneut Fehler machen. Wenn große Sprachmodelle wie GPT-4 auch die Fähigkeit haben, zu reflektieren, wird die Leistung um wie viel verbessert.

Es ist bekannt, dass große Sprachmodelle (LLM) bei verschiedenen Aufgaben eine beispiellose Leistung gezeigt haben. Diese SOTA-Methoden erfordern jedoch normalerweise eine Feinabstimmung des Modells, eine Richtlinienoptimierung und andere Operationen im definierten Zustandsraum. Aufgrund des Mangels an qualitativ hochwertigen Trainingsdaten und einem klar definierten Zustandsraum ist es immer noch schwierig, das Optimierungsmodell zu implementieren. Darüber hinaus verfügen Modelle noch nicht über bestimmte Eigenschaften, die dem menschlichen Entscheidungsprozess innewohnen, insbesondere die Fähigkeit, aus Fehlern zu lernen.

Aber jetzt haben Forscher der Northeastern University, des MIT und anderer Institutionen in einem aktuellen Artikel Reflexion vorgeschlagen, das dem Agenten die Fähigkeit gibt, sich dynamisch zu erinnern und selbst zu reflektieren.

Um die Wirksamkeit der Methode zu überprüfen, wurde in dieser Studie die Fähigkeit des Agenten bewertet, Entscheidungsaufgaben in der AlfWorld-Umgebung zu erledigen, und seine Fähigkeit, wissensintensive, suchbasierte Frage- und Antwortaufgaben in der HotPotQA-Umgebung zu erledigen. Die Erfolgsquote bei diesen beiden Aufgaben beträgt 97 % bzw. 51 %.

Papieradresse: https://arxiv.org/pdf/2303.11366.pdf

Projektadresse: https://github.com/GammaTauAI/reflexion-human-eval

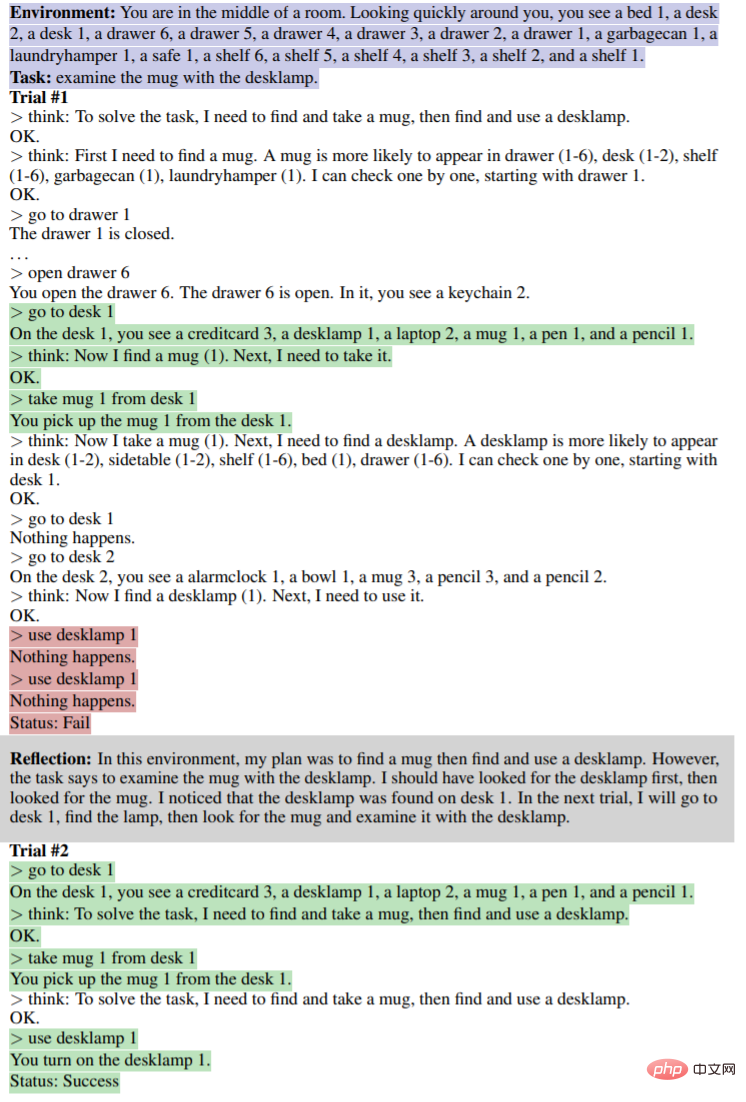

Wie im Bild unten gezeigt, In der Umgebung von AlfWorld sind verschiedene Objekte im Raum angeordnet, und der Agent muss einen Begründungsplan vorlegen, um ein bestimmtes Objekt zu erhalten. Der obere Teil des Bildes unten schlägt aufgrund des ineffizienten Plans des Agenten fehl. Nach der Überlegung erkennt der Agent den Fehler, korrigiert die Argumentationsbahn und gibt eine prägnante Bahnmethode an (unterer Teil der Abbildung).

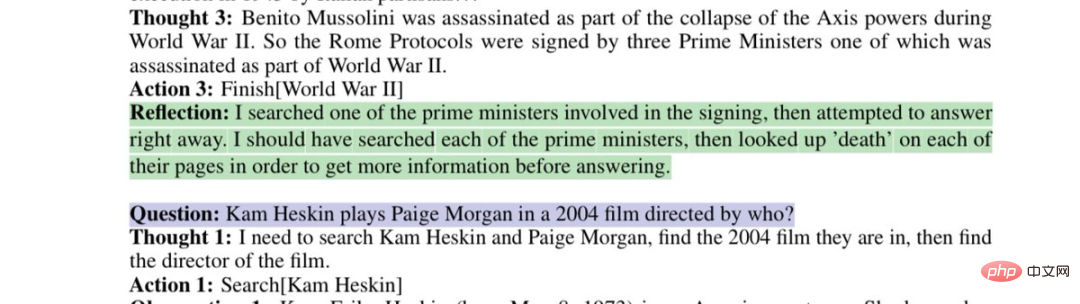

Modellreflexion zu fehlerhaften Suchstrategien:

Dieser Artikel zeigt, dass Sie diesen Fehler beheben können, indem Sie GPT-4 bitten, über „Warum haben Sie sich geirrt?“ zu reflektieren und eine neue Eingabeaufforderung für sich selbst zu generieren werden so lange berücksichtigt, bis das Ergebnis stimmt, wodurch sich die Leistung von GPT-4 um erstaunliche 30 % verbessert.

Internetnutzer müssen seufzen: Die Entwicklungsgeschwindigkeit der künstlichen Intelligenz hat unsere Anpassungsfähigkeit übertroffen.

Einführung in die Methode

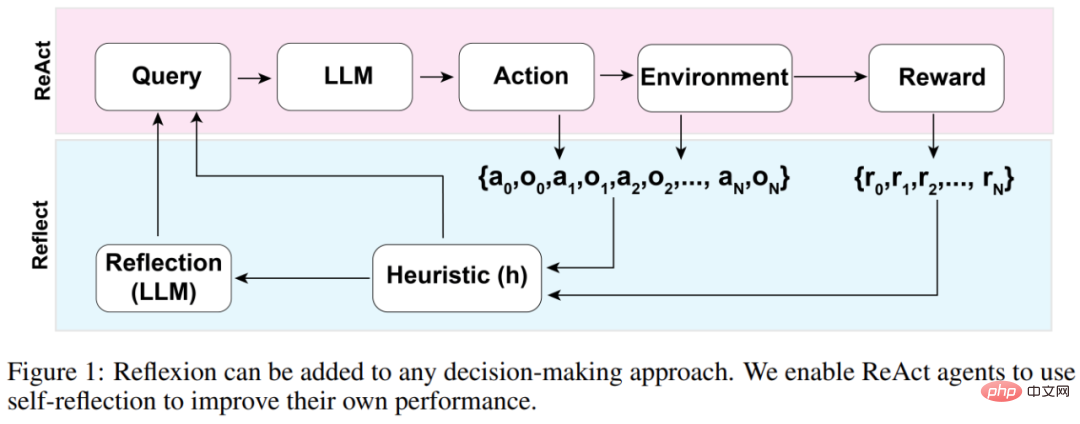

Die Gesamtarchitektur des Reflexion-Agenten ist in Abbildung 1 unten dargestellt, wo Reflexion ReAct verwendet (Yao et al., 2023). Im ersten Versuch erhält der Agent eine Aufgabe aus der Umgebung, die die anfängliche Abfrage darstellt. Anschließend führt der Agent eine vom LLM generierte Folge von Aktionen aus und erhält Beobachtungen und Belohnungen aus der Umgebung. Für Umgebungen, die beschreibende oder kontinuierliche Belohnungen bieten, beschränkt die Studie die Ausgabe auf einfache binäre Erfolgszustände, um die Anwendbarkeit sicherzustellen.

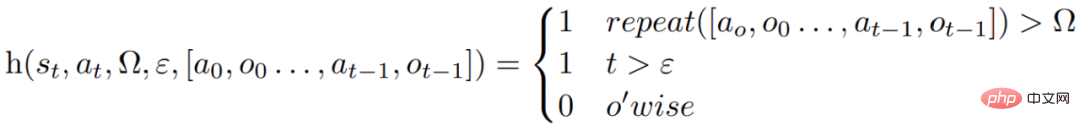

Nach jeder Aktion a_t berechnet der Agent eine heuristische Funktion h, wie in der folgenden Abbildung dargestellt.

Diese heuristische Funktion dient dazu, vom Agenten erzeugte Informationsillusionen (d. h. falsche oder falsche Informationen) zu erkennen ineffizient und „sagen“ dem Agenten, wann er reflektieren muss (Reflexion), wobei t der Zeitschritt ist, s_t der aktuelle Zustand ist, Ω die Anzahl der wiederholten Aktionszyklen darstellt, ε die maximale Gesamtzahl der ausgeführten Aktionen darstellt, [ a_o, o_0 , a_(t−1), o_(t−1)] stellt den Flugbahnverlauf dar. „repeat“ ist eine einfache Funktion, die bestimmt, wie oft eine Schleife wiederholter Aktionen zum gleichen Ergebnis führt.

Wenn die Funktion h dem Agenten mitteilt, dass sie reflektieren muss, fragt der Agent den LLM ab, um seine aktuelle Aufgabe, den Verlauf der Flugbahn und die letzte Belohnung widerzuspiegeln, und dann setzt der Agent die Umgebung zurück und versucht es bei nachfolgenden Versuchen erneut. Wenn die Funktion h dem Agenten nicht mitteilt, dass eine Reflexion erforderlich ist, fügt der Agent a_t und o_t zu seinem Trajektorienverlauf hinzu und fragt den LLM nach der nächsten Aktion ab.

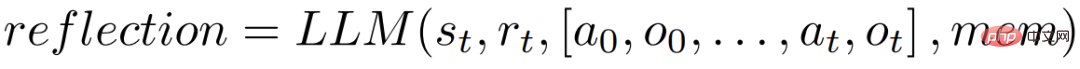

Wenn die Heuristik h zum Zeitpunkt t eine Reflexion vorschlägt, wird der Agent basierend auf seinem aktuellen Zustand s_t, der letzten Belohnung r_t, früheren Aktionen und Beobachtungen [a_0, o_0, ., a_t, o_t] reflektieren Der Agent wird im MEM gespeichert, wodurch ein Reflexionsprozess eingeleitet wird.

Der Zweck der Reflexion besteht darin, dem Agenten zu helfen, „Illusionen“ und Ineffizienzen durch Versuch und Irrtum zu korrigieren. Das für die Reflexion verwendete Modell ist ein LLM, das spezifische Fehlerverläufe und ideale Reflexionsbeispiele als Anregung verwendet.

Der Agent führt den oben genannten Reflexionsprozess iterativ durch. In den Experimenten wurde in der Studie die Anzahl der im Speicher des Agenten gespeicherten Reflexionen auf maximal das Dreifache festgelegt, um Abfragen zu vermeiden, die die Grenzen des LLM überschreiten. Der Lauf wird in den folgenden Situationen abgebrochen:

- Überschreitet die maximale Anzahl von Versuchen;

- Kann die Leistung zwischen zwei aufeinanderfolgenden Versuchen nicht verbessert werden;

- Schließt die Aufgabe ab.

Experimente und Ergebnisse

AlfWorld bietet sechs verschiedene Aufgaben und mehr als 3000 Umgebungen, die erfordern, dass der Agent die Zielaufgabe versteht, einen sequentiellen Plan für Unteraufgaben formuliert und Vorgänge in einer bestimmten Umgebung durchführt.

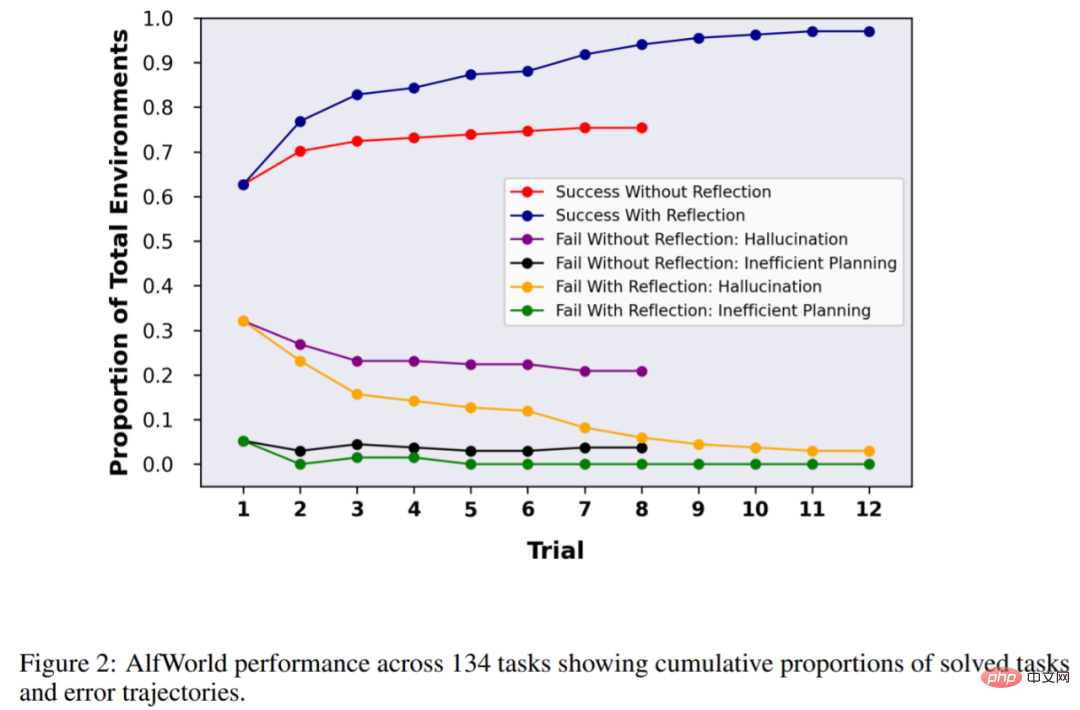

In der Studie wurde der Agent in 134 AlfWorld-Umgebungen getestet. Zu den Aufgaben gehörten das Auffinden versteckter Objekte (z. B. das Finden eines Obstmessers in einer Schublade), das Bewegen von Objekten (z. B. das Bewegen eines Messers auf ein Schneidebrett) und die Verwendung anderer Objekte zur Manipulation andere Gegenstände. Ein Gegenstand (z. B. Tomaten im Kühlschrank).

Ohne Reflexion beträgt die Genauigkeit des Agenten 63 %, und dann wird Reflexion zum Vergleich hinzugefügt. Die Ergebnisse zeigten, dass der Agent in 12 Versuchen 97 % der Umgebung bewältigen konnte und nur 4 von 134 Aufgaben nicht lösen konnte.

Das nächste Experiment wurde in HotPotQA durchgeführt, einem auf Wikipedia basierenden Datensatz, der 113.000 Frage- und Antwortpaare enthält. Er wird hauptsächlich verwendet, um die Fähigkeit des Agenten zu testen, Inhalte und Gründe zu analysieren.

Bei den 100 Frage-Antwort-Paartests von HotpotQA verglich die Studie Basisagenten und auf Reflexion basierende Agenten, bis es ihnen in aufeinanderfolgenden Versuchen nicht gelang, die Genauigkeit zu verbessern. Die Ergebnisse zeigen, dass sich die Leistung des Basisagenten nicht verbessert hat. Im ersten Test betrug die Genauigkeit des Basisagenten 34 % und die Genauigkeit des Reflexionsagenten betrug 32 % Der Wirkstoff hat sich deutlich verbessert. Die Verbesserung liegt bei fast 30 %, was viel besser ist als beim Basiswirkstoff.

In ähnlicher Weise übertraf GPT-4 mit Reflexion auch das reguläre GPT-4 deutlich, als es die Fähigkeit des Modells zum Schreiben von Code testete:

Das obige ist der detaillierte Inhalt vonAls GPT-4 über seinen Fehler nachdachte: Die Leistung stieg um fast 30 % und die Programmierfähigkeit um 21 %. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laraveleloquent-Modellab Abruf: Das Erhalten von Datenbankdaten Eloquentorm bietet eine prägnante und leicht verständliche Möglichkeit, die Datenbank zu bedienen. In diesem Artikel werden verschiedene eloquente Modellsuchtechniken im Detail eingeführt, um Daten aus der Datenbank effizient zu erhalten. 1. Holen Sie sich alle Aufzeichnungen. Verwenden Sie die Methode All (), um alle Datensätze in der Datenbanktabelle zu erhalten: UseApp \ Models \ post; $ posts = post :: all (); Dies wird eine Sammlung zurückgeben. Sie können mit der Foreach-Schleife oder anderen Sammelmethoden auf Daten zugreifen: foreach ($ postas $ post) {echo $ post->