Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Ersatz für ChatGPT, der auf einem Laptop ausgeführt werden kann, ist hier, zusammen mit einem vollständigen technischen Bericht

Ein Ersatz für ChatGPT, der auf einem Laptop ausgeführt werden kann, ist hier, zusammen mit einem vollständigen technischen Bericht

Ein Ersatz für ChatGPT, der auf einem Laptop ausgeführt werden kann, ist hier, zusammen mit einem vollständigen technischen Bericht

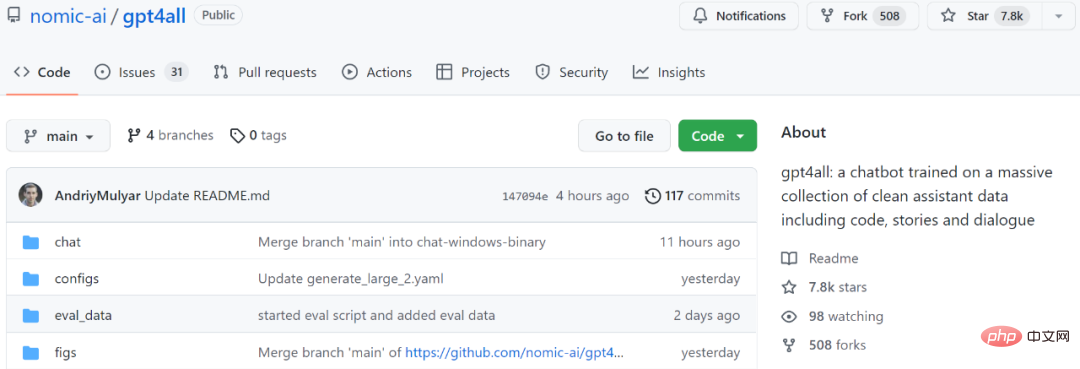

GPT4All ist ein Chatbot, der auf der Grundlage einer großen Menge sauberer Assistentendaten (einschließlich Code, Geschichten und Konversationen) trainiert wird. Die Daten umfassen ca. 800.000 von GPT-3.5-Turbo generierte Daten. Er basiert auf LLaMa und kann auf M1 ausgeführt werden Mac, Windows und andere Umgebungen. Vielleicht ist, wie der Name schon sagt, die Zeit gekommen, in der jeder persönliche GPT nutzen kann.

Seit OpenAI ChatGPT veröffentlicht hat, sind Chatbots in den letzten Monaten immer beliebter geworden.

Obwohl ChatGPT leistungsstark ist, ist es für OpenAI fast unmöglich, es als Open Source zu veröffentlichen. Viele Leute arbeiten an Open Source, wie zum Beispiel LLaMA, das vor einiger Zeit von Meta als Open Source bereitgestellt wurde. Es ist ein allgemeiner Begriff für eine Reihe von Modellen mit Parametermengen im Bereich von 7 Milliarden bis 65 Milliarden. Darunter kann das 13-Milliarden-Parameter-LLaMA-Modell das 175-Milliarden-Parameter-GPT-3 „bei den meisten Benchmarks“ übertreffen.

Von der offenen Quelle von LLaMA haben viele Forscher profitiert. Beispielsweise hat Stanford LLaMA um Instruct-Tuning erweitert und ein neues 7-Milliarden-Parameter-Modell namens Alpaca (basierend auf LLaMA 7B) trainiert. Die Ergebnisse zeigen, dass die Leistung von Alpaca, einem leichten Modell mit nur 7B-Parametern, mit sehr großen Sprachmodellen wie GPT-3.5 vergleichbar ist.

Als weiteres Beispiel ist das Modell, das wir als nächstes vorstellen werden, GPT4All, ebenfalls ein neues 7B-Sprachmodell, das auf LLaMA basiert. Zwei Tage nach dem Start des Projekts hat die Anzahl der Stars 7,8.000 überschritten.

Projektadresse: https://github.com/nomic-ai/gpt4all

Einfach ausgedrückt wird GPT4All auf 800.000 Daten von GPT-3.5-Turbo trainiert, einschließlich Textfragen, Story-Beschreibungen und mehr Dialog und Code umwandeln.

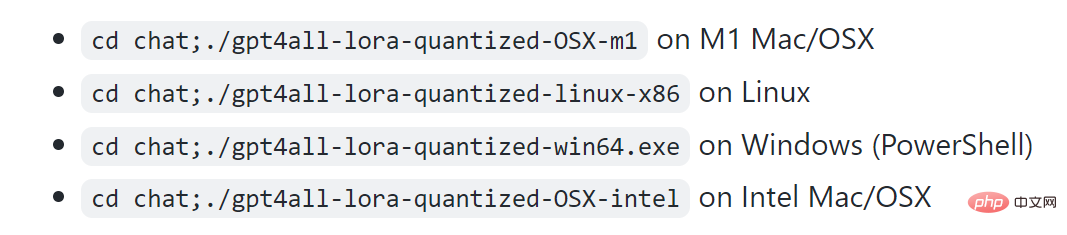

Dem Projekt zufolge kann M1 auf Mac, Windows und anderen Umgebungen ausgeführt werden.

Schauen wir uns zunächst die Wirkung an. Wie in der Abbildung unten gezeigt, können Benutzer ohne Hindernisse mit GPT4All kommunizieren, z. B. indem sie das Modell fragen: „Kann ich ein großes Sprachmodell auf einem Laptop ausführen?“ Die Antwort von GPT4All lautet: „Ja, Sie können einen Laptop zum Trainieren und Verwenden verwenden.“ Testen Sie neuronale Netze oder Modelle für maschinelles Lernen für andere natürliche Sprachen (wie Englisch oder Chinesisch). Wichtig ist, dass Sie genügend verfügbaren Speicher (RAM) benötigen, um der Größe dieser Modelle gerecht zu werden …“ Wenn Sie nicht genau wissen, wie viel Speicher Sie benötigen, können Sie auch weiterhin bei GPT4All nachfragen, dann erhalten Sie eine Antwort. Den Ergebnissen nach zu urteilen ist die Fähigkeit von GPT4All, mehrere Dialogrunden durchzuführen, immer noch sehr stark.

Manche Leute nennen diese Forschung „einen Game Changer. Mit dem Segen von GPT4All können Sie GPT jetzt lokal auf dem MacBook ausführen.“

Ähnlich Zu GPT-4 stellt GPT4All auch einen „technischen Bericht“ zur Verfügung.

Ähnlich Zu GPT-4 stellt GPT4All auch einen „technischen Bericht“ zur Verfügung.

Adresse des technischen Berichts: https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Adresse des technischen Berichts: https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Dieser vorläufige technische Bericht beschreibt kurz die Konstruktionsdetails von GPT4All. Die Forscher legten die gesammelten Daten, Datenverarbeitungsverfahren, Trainingscode und endgültigen Modellgewichte offen, um offene Forschung und Reproduzierbarkeit zu fördern. Sie veröffentlichten auch eine quantisierte 4-Bit-Version des Modells, was bedeutet, dass fast jeder das Modell auf einer CPU ausführen kann.

Als nächstes wollen wir sehen, was in diesem Bericht geschrieben steht.

GPT4All Technical Report

1. Datenerfassung und -sortierungVom 20. März 2023 bis zum 26. März 2023 verwendeten Forscher die GPT-3.5-Turbo OpenAI API, um etwa 1 Million Paare von Eingabeaufforderungen zu sammeln.

Zuerst sammelten die Forscher verschiedene Frage-/Eingabeproben, indem sie drei öffentlich verfügbare Datensätze nutzten:

- LAION OIGs vereinheitlichte Chip2-Teilmenge

- Ein zufälliger Teilstichprobensatz von Stackoverflow-Fragen zur Kodierung von Fragen

- Bigscience/P3-Teilstichprobensatz zur Befehlsoptimierung

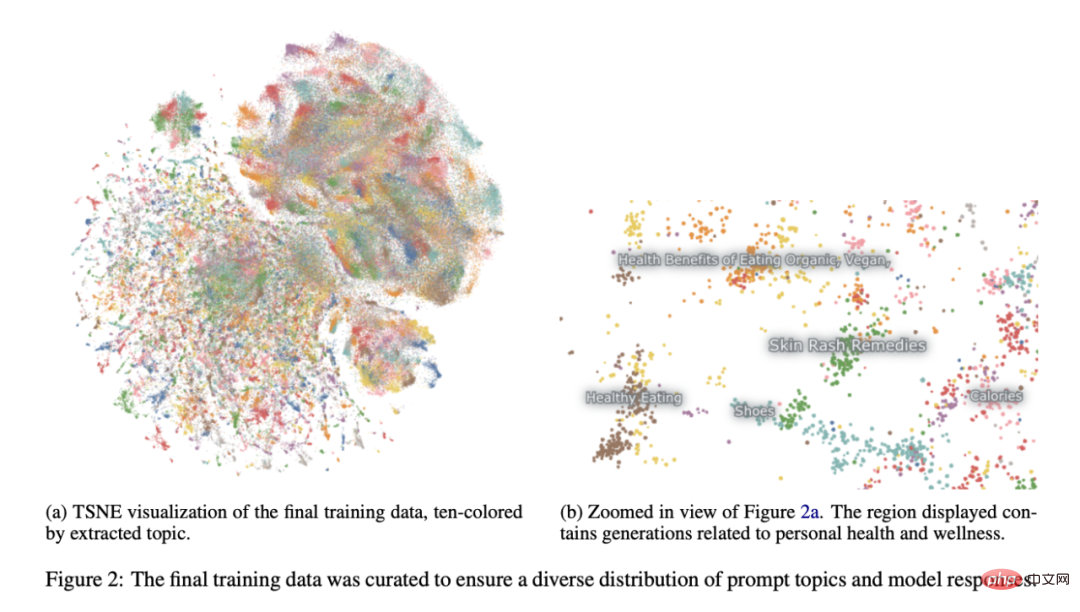

Siehe das Alpaca-Projekt der Stanford University (Taori et al., 2023), Forscher haben viel dafür bezahlt Aufmerksamkeit für die Datenaufbereitung und -kuratierung. Nachdem sie den ersten Datensatz der durch Eingabeaufforderungen generierten Paare gesammelt hatten, luden sie die Daten in Atlas, um sie zu organisieren und zu bereinigen. Dabei wurden alle Proben entfernt, in denen GPT-3.5-Turbo nicht auf Eingabeaufforderungen reagierte und eine fehlerhafte Ausgabe erzeugte. Dadurch reduziert sich die Gesamtzahl der Stichproben auf 806199 hochwertige, durch Eingabeaufforderungen generierte Paare. Als nächstes haben wir die gesamte Bigscience/P3-Teilmenge aus dem endgültigen Trainingsdatensatz entfernt, da ihre Ausgabevielfalt sehr gering war. P3 enthält viele homogene Eingabeaufforderungen, die kurze und homogene Antworten von GPT-3.5-Turbo generieren.

Diese Eliminierungsmethode führte zu einer endgültigen Teilmenge von 437.605 durch Eingabeaufforderung generierten Paaren, wie in Abbildung 2 dargestellt.

Modelltraining

Die Forscher haben mehrere Modelle in einer Instanz von LLaMA 7B verfeinert (Touvron et al., 2023). Das mit ihrer ersten öffentlichen Veröffentlichung verbundene Modell wurde mit LoRA (Hu et al., 2021) in 4 Epochen an 437.605 nachbearbeiteten Beispielen trainiert. Detaillierte Modellhyperparameter und Trainingscode finden Sie in der entsprechenden Ressourcenbibliothek und den Modelltrainingsprotokollen.

Reproduzierbarkeit

Die Forscher haben alle Daten (einschließlich ungenutzter P3-Generationen), Trainingscode und Modellgewichte zur Reproduktion für die Community freigegeben. Interessierte Forscher finden die neuesten Daten, Trainingsdetails und Prüfpunkte im Git-Repository.

Kosten

Die Forscher brauchten etwa vier Tage, um diese Modelle zu erstellen, und die GPU-Kosten betrugen 800 US-Dollar (gemietet von Lambda Labs und Paperspace, einschließlich mehrerer fehlgeschlagener Schulungen) und zusätzlich 500 US-Dollar an OpenAI-API-Gebühren.

Das endgültig veröffentlichte Modell gpt4all-lora kann in etwa 8 Stunden auf dem DGX A100 8x 80 GB von Lambda Labs trainiert werden, was einem Gesamtpreis von 100 US-Dollar entspricht.

Dieses Modell kann auf einem normalen Laptop ausgeführt werden: „Es fallen keine Kosten außer der Stromrechnung an.“

Bewertung

Der Forscher verwendete das SelfInstruct-Papier (Wang et al., 2022). Eine vorläufige Bewertung des Modells wurde anhand menschlicher Bewertungsdaten durchgeführt. Der Bericht vergleicht auch die Grundwahrheitsproblematik dieses Modells mit dem bekanntesten öffentlichen Alpaka-Lora-Modell (beigetragen vom Huggingface-Benutzer Chainyo). Sie fanden heraus, dass alle Modelle bei einer kleinen Anzahl von Aufgaben sehr große Ratlosigkeiten aufwiesen und bis zu 100 Ratlosigkeiten meldeten. Modelle, die anhand dieses gesammelten Datensatzes verfeinert wurden, zeigten im Vergleich zu Alpaca eine geringere Verwirrung bei der Self-Instruct-Bewertung. Die Forscher sagen, dass diese Bewertung nicht erschöpfend ist und noch Raum für weitere Bewertungen besteht. Sie laden die Leser dazu ein, das Modell auf einer lokalen CPU auszuführen (Dokumentation auf Github verfügbar) und sich ein qualitatives Verständnis seiner Fähigkeiten zu verschaffen.

Abschließend ist es wichtig anzumerken, dass die Autoren Daten und Trainingsdetails in der Hoffnung veröffentlicht haben, dass sie die offene LLM-Forschung beschleunigen, insbesondere in den Bereichen Ausrichtung und Interpretierbarkeit. GPT4Alle Modellgewichte und -daten dienen ausschließlich Forschungszwecken und sind gegen jegliche kommerzielle Nutzung lizenziert. GPT4All basiert auf LLaMA, das über eine nichtkommerzielle Lizenz verfügt. Assistentendaten wurden von GPT-3.5-Turbo von OpenAI gesammelt, dessen Nutzungsbedingungen die Entwicklung von Modellen verbieten, die kommerziell mit OpenAI konkurrieren.

Das obige ist der detaillierte Inhalt vonEin Ersatz für ChatGPT, der auf einem Laptop ausgeführt werden kann, ist hier, zusammen mit einem vollständigen technischen Bericht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

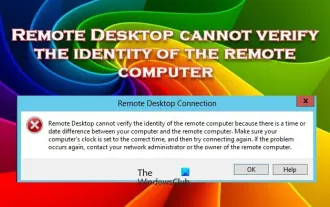

Remotedesktop kann die Identität des Remotecomputers nicht authentifizieren

Feb 29, 2024 pm 12:30 PM

Remotedesktop kann die Identität des Remotecomputers nicht authentifizieren

Feb 29, 2024 pm 12:30 PM

Mit dem Windows-Remotedesktopdienst können Benutzer aus der Ferne auf Computer zugreifen, was für Personen, die aus der Ferne arbeiten müssen, sehr praktisch ist. Es können jedoch Probleme auftreten, wenn Benutzer keine Verbindung zum Remotecomputer herstellen können oder Remotedesktop die Identität des Computers nicht authentifizieren kann. Dies kann durch Netzwerkverbindungsprobleme oder einen Fehler bei der Zertifikatsüberprüfung verursacht werden. In diesem Fall muss der Benutzer möglicherweise die Netzwerkverbindung überprüfen, sicherstellen, dass der Remote-Computer online ist, und versuchen, die Verbindung wiederherzustellen. Außerdem ist es wichtig, sicherzustellen, dass die Authentifizierungsoptionen des Remotecomputers richtig konfiguriert sind, um das Problem zu lösen. Solche Probleme mit den Windows-Remotedesktopdiensten können normalerweise durch sorgfältiges Überprüfen und Anpassen der Einstellungen behoben werden. Aufgrund eines Zeit- oder Datumsunterschieds kann Remote Desktop die Identität des Remotecomputers nicht überprüfen. Bitte stellen Sie Ihre Berechnungen sicher

Die CSRankings National Computer Science Rankings 2024 sind veröffentlicht! CMU dominiert die Liste, MIT fällt aus den Top 5

Mar 25, 2024 pm 06:01 PM

Die CSRankings National Computer Science Rankings 2024 sind veröffentlicht! CMU dominiert die Liste, MIT fällt aus den Top 5

Mar 25, 2024 pm 06:01 PM

Die 2024CSRankings National Computer Science Major Rankings wurden gerade veröffentlicht! In diesem Jahr gehört die Carnegie Mellon University (CMU) im Ranking der besten CS-Universitäten in den Vereinigten Staaten zu den Besten des Landes und im Bereich CS, während die University of Illinois at Urbana-Champaign (UIUC) einen der besten Plätze belegt sechs Jahre in Folge den zweiten Platz belegt. Georgia Tech belegte den dritten Platz. Dann teilten sich die Stanford University, die University of California in San Diego, die University of Michigan und die University of Washington den vierten Platz weltweit. Es ist erwähnenswert, dass das Ranking des MIT zurückgegangen ist und aus den Top 5 herausgefallen ist. CSRankings ist ein globales Hochschulrankingprojekt im Bereich Informatik, das von Professor Emery Berger von der School of Computer and Information Sciences der University of Massachusetts Amherst initiiert wurde. Die Rangfolge erfolgt objektiv

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Aktuelle Deep-Edge-Erkennungsnetzwerke verwenden normalerweise eine Encoder-Decoder-Architektur, die Up- und Down-Sampling-Module enthält, um mehrstufige Merkmale besser zu extrahieren. Diese Struktur schränkt jedoch die Ausgabe genauer und detaillierter Kantenerkennungsergebnisse des Netzwerks ein. Als Antwort auf dieses Problem bietet ein Papier zu AAAI2024 eine neue Lösung. Titel der Abschlussarbeit: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Autoren: Ye Yunfan (Nationale Universität für Verteidigungstechnologie), Xu Kai (Nationale Universität für Verteidigungstechnologie), Huang Yuxing (Nationale Universität für Verteidigungstechnologie), Yi Renjiao (Nationale Universität für Verteidigungstechnologie), Cai Zhiping (National University of Defense Technology) Link zum Papier: https://ar

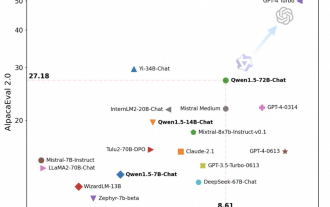

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Pünktlich zum Frühlingsfest ist Version 1.5 des Tongyi Qianwen Large Model (Qwen) online. Heute Morgen erregten die Neuigkeiten über die neue Version die Aufmerksamkeit der KI-Community. Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen. Das Tongyi Qianwen-Team von Alibaba gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde. Darüber hinaus bietet die heutige Version von Qwen 1.5 auch die folgenden Highlights: Unterstützt eine Kontextlänge von 32 KB und öffnet den Prüfpunkt des Base+Chat-Modells.

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Modelle können ebenfalls in Scheiben geschnitten werden, und Microsoft SliceGPT erhöht die Recheneffizienz von LLAMA-2 erheblich

Jan 31, 2024 am 11:39 AM

Große Sprachmodelle (LLMs) verfügen typischerweise über Milliarden von Parametern und werden auf Billionen von Token trainiert. Die Schulung und Bereitstellung solcher Modelle ist jedoch sehr teuer. Um den Rechenaufwand zu reduzieren, werden häufig verschiedene Modellkomprimierungstechniken eingesetzt. Diese Modellkomprimierungstechniken können im Allgemeinen in vier Kategorien unterteilt werden: Destillation, Tensorzerlegung (einschließlich Faktorisierung mit niedrigem Rang), Bereinigung und Quantisierung. Pruning-Methoden gibt es schon seit einiger Zeit, aber viele erfordern nach dem Pruning eine Feinabstimmung der Wiederherstellung (Recovery Fine-Tuning, RFT), um die Leistung aufrechtzuerhalten, was den gesamten Prozess kostspielig und schwierig zu skalieren macht. Forscher der ETH Zürich und von Microsoft haben eine Lösung für dieses Problem namens SliceGPT vorgeschlagen. Die Kernidee dieser Methode besteht darin, die Einbettung des Netzwerks durch das Löschen von Zeilen und Spalten in der Gewichtsmatrix zu reduzieren.

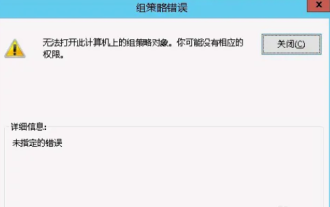

Das Gruppenrichtlinienobjekt kann auf diesem Computer nicht geöffnet werden

Feb 07, 2024 pm 02:00 PM

Das Gruppenrichtlinienobjekt kann auf diesem Computer nicht geöffnet werden

Feb 07, 2024 pm 02:00 PM

Gelegentlich kann es bei der Verwendung eines Computers zu Fehlfunktionen des Betriebssystems kommen. Das Problem, auf das ich heute gestoßen bin, bestand darin, dass das System beim Zugriff auf gpedit.msc mitteilte, dass das Gruppenrichtlinienobjekt nicht geöffnet werden könne, weil möglicherweise die richtigen Berechtigungen fehlten. Das Gruppenrichtlinienobjekt auf diesem Computer konnte nicht geöffnet werden: 1. Beim Zugriff auf gpedit.msc meldet das System, dass das Gruppenrichtlinienobjekt auf diesem Computer aufgrund fehlender Berechtigungen nicht geöffnet werden kann. Details: Das System kann den angegebenen Pfad nicht finden. 2. Nachdem der Benutzer auf die Schaltfläche „Schließen“ geklickt hat, wird das folgende Fehlerfenster angezeigt. 3. Überprüfen Sie sofort die Protokolleinträge und kombinieren Sie die aufgezeichneten Informationen, um festzustellen, dass das Problem in der Datei C:\Windows\System32\GroupPolicy\Machine\registry.pol liegt

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend