Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Menschheit hat die Obergrenze der Silizium-Computing-Architektur erreicht! Es wird erwartet, dass KI bis 2030 50 % der weltweiten Stromversorgung verbrauchen wird

Die Menschheit hat die Obergrenze der Silizium-Computing-Architektur erreicht! Es wird erwartet, dass KI bis 2030 50 % der weltweiten Stromversorgung verbrauchen wird

Die Menschheit hat die Obergrenze der Silizium-Computing-Architektur erreicht! Es wird erwartet, dass KI bis 2030 50 % der weltweiten Stromversorgung verbrauchen wird

Wir haben begonnen, das Gefühl zu verspüren, die Obergrenze des Silizium-Computing-Erlebnisses zu erreichen. In den nächsten 10 Jahren wird es eine gravierende Rechenleistungslücke geben, und weder bestehende Technologieunternehmen noch Regierungen konnten dieses Problem lösen.

Heutzutage sind wir so daran gewöhnt, dass Computer immer billiger werden, dass wir nie daran zweifeln, dass wir es uns eines Tages vielleicht nicht mehr leisten können.

Jetzt stellt Rodolfo Rosini, CEO eines Startups, eine Frage, die uns alle schockiert: Was wäre, wenn wir an die fundamentalen physikalischen Grenzen klassischer Computermodelle stoßen, genau wie unsere Wirtschaft auf billige Computer angewiesen ist?

Die Stagnation im Großformat-Computing

Jetzt haben die Vereinigten Staaten aufgrund mangelnder technologischer Innovation ein Plateau erreicht.

Wrights Gesetz gilt in vielen Branchen – jedes Mal, wenn der Herstellungsprozess um etwa 20 % verbessert wird, verdoppelt sich die Produktivität.

In der Technologie manifestiert es sich als Moores Gesetz.

In den 1960er Jahren bemerkte Intel-Mitbegründer Gordon Moore, dass sich die Anzahl der Transistoren in integrierten Schaltkreisen Jahr für Jahr zu verdoppeln schien, und schlug das Mooresche Gesetz vor.

Seitdem ist dieses Gesetz zur Grundlage des Vertrags zwischen Marketing und Technik geworden und nutzt überschüssige Rechenleistung und schrumpfende Größe, um die Konstruktion von Produkten im Rechenstapel voranzutreiben.

Damals wurde erwartet, dass sich die Rechenleistung mit schnelleren und günstigeren Prozessoren im Laufe der Zeit exponentiell verbessern würde.

Allerdings haben sich die verschiedenen Kräfte, aus denen Moores Gesetz besteht, geändert.

Seit Jahrzehnten ist Dennards Skalierungsgesetz die treibende Kraft hinter dem Mooreschen Gesetz. Transistorgröße und Stromverbrauch werden gleichzeitig halbiert, wodurch sich der Rechenaufwand pro Energieeinheit verdoppelt (letzteres wird auch als Koomey-Gesetz bezeichnet).

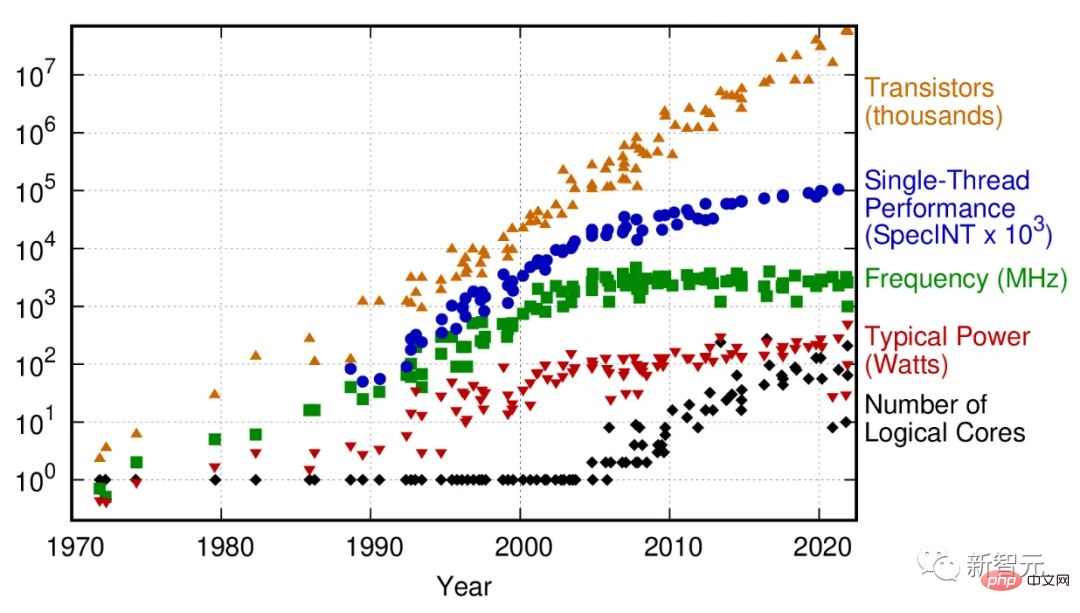

50 Jahre Mikroprozessor-Trenddaten

Im Jahr 2005 begann diese Skalierung zusammenzubrechen, als Stromlecks zu einer Erwärmung des Chips führten und damit die Leistung von Chips mit einem einzigen Prozessorkern stagnierte.

Um den Wachstumskurs im Computerbereich aufrechtzuerhalten, hat sich die Chipindustrie Multi-Core-Architekturen zugewandt: mehrere Mikroprozessoren, die „zusammengeklebt“ sind. Dies mag zwar das Mooresche Gesetz hinsichtlich der Transistordichte erweitern, erhöht jedoch die Komplexität des gesamten Rechenstapels.

Für bestimmte Arten von Computeraufgaben, wie zum Beispiel maschinelles Lernen oder Computergrafik, bringt dies Leistungsverbesserungen. Für viele allgemeine Rechenaufgaben, die nicht gut parallelisiert sind, sind Multi-Core-Architekturen jedoch machtlos.

Kurz gesagt: Die Rechenleistung für viele Aufgaben steigt nicht mehr exponentiell.

Selbst was die Leistung von Multi-Core-Supercomputern angeht, gab es, gemessen an den TOP500 (Rangliste der schnellsten Supercomputer der Welt), um das Jahr 2010 herum einen deutlichen Wendepunkt.

Welche Auswirkungen hat diese Verlangsamung? Die wachsende Rolle, die Computer in verschiedenen Branchen spielen, zeigt, dass die Auswirkungen unmittelbar sind und nur noch wichtiger werden, je weiter das Mooresche Gesetz ins Wanken gerät.

Nehmen Sie zwei extreme Beispiele: Verbesserte Rechenleistung und geringere Kosten haben zu einer Steigerung der Produktivität der Ölexploration in der Energiebranche um 49 % und zu einer Steigerung der Proteinfaltungsvorhersagen um 94 % in der Biotechnologiebranche geführt.

Das bedeutet, dass die Auswirkungen der Rechengeschwindigkeit nicht auf die Technologiebranche beschränkt sind. Der Großteil des Wirtschaftswachstums in den letzten 50 Jahren war auf Effekte zweiter Ordnung zurückzuführen, die durch das Mooresche Gesetz angetrieben wurden, und ohne es könnte die Weltwirtschaft aufhören zu wachsen.

Ein weiterer wichtiger Grund für den Bedarf an mehr Rechenleistung ist der Aufstieg der künstlichen Intelligenz. Heutzutage kann das Training eines großen Sprachmodells (LLM) Millionen von Dollar kosten und Wochen dauern.

Die vom maschinellen Lernen versprochene Zukunft kann ohne eine kontinuierliche Steigerung der Zahlenverarbeitung und Datenskalierung nicht realisiert werden.

Mit zunehmender Verbreitung von Modellen des maschinellen Lernens in der Verbrauchertechnologie, die einen enormen und möglicherweise übertriebenen Bedarf an Computern in anderen Branchen mit sich bringen, wird die kostengünstige Verarbeitung zum Eckpfeiler der Produktivität.

Der Tod des Mooreschen Gesetzes könnte zu einer großen Stagnation in der Informatik führen. Verglichen mit den multimodalen neuronalen Netzen, die möglicherweise zum Erreichen von AGI erforderlich sind, sind die heutigen LLMs immer noch relativ klein und leicht zu trainieren. Zukünftige GPTs und ihre Konkurrenten werden zur Verbesserung und sogar Optimierung besonders leistungsstarke Hochleistungsrechner benötigen.

Vielleicht werden viele Menschen zweifeln. Schließlich wurde das Ende des Mooreschen Gesetzes schon oft vorhergesagt. Warum sollte es jetzt sein?

Historisch gesehen sind viele dieser Vorhersagen auf technische Herausforderungen zurückzuführen. Der menschliche Einfallsreichtum hat diese Hindernisse schon immer wieder überwunden.

Der Unterschied besteht jetzt darin, dass wir nicht mehr mit technischen und nachrichtendienstlichen Herausforderungen konfrontiert sind, sondern mit den durch die Physik auferlegten Einschränkungen.

MIT Technology Review veröffentlichte am 24. Februar einen Artikel, in dem es heißt, dass wir nicht auf das Ende des Mooreschen Gesetzes vorbereitet sind

Überhitzung führt zu Unfähigkeit, Daten zu verarbeiten

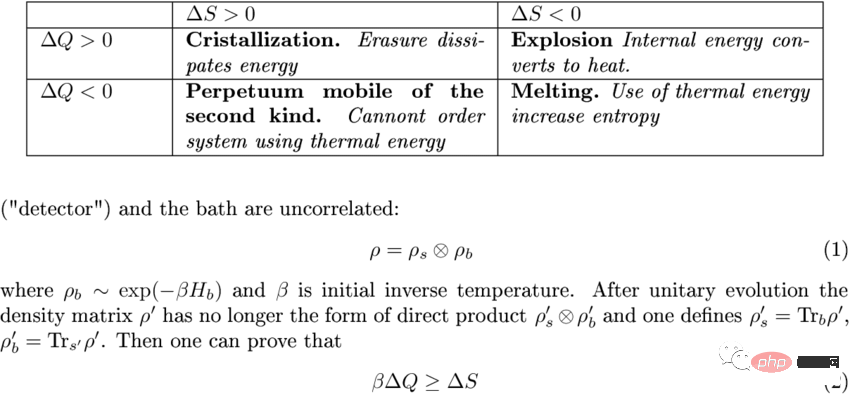

Computer arbeiten, indem sie Informationen verarbeiten.

Während sie Informationen verarbeiten, werden einige davon verworfen, da der Mikroprozessor Rechenzweige zusammenführt oder die Registrierung überschreibt. Es ist nicht kostenlos.

Die Gesetze der Thermodynamik setzen der Effizienz bestimmter Prozesse strenge Grenzen und gelten für Berechnungen genauso wie für Dampfmaschinen. Diese Kosten werden als Landauer-Limit bezeichnet.

Es handelt sich um eine winzige Wärmemenge, die bei jedem Rechenvorgang abgegeben wird: etwa 10^-21 Joule pro Bit.

Da diese Hitze so gering ist, galt die Landauer-Grenze lange Zeit als vernachlässigbar.

Allerdings sind die technischen Fähigkeiten inzwischen so weit fortgeschritten, dass diese Energieskala erreicht werden kann, da der reale Grenzwert aufgrund anderer Gemeinkosten wie Stromlecks schätzungsweise 10-100 Mal größer ist als die Landauer-Grenze. Chips verfügen über Hunderte Milliarden Transistoren, die milliardenfach pro Sekunde arbeiten.

Fügen Sie diese Zahlen zusammen, und vielleicht muss das Mooresche Gesetz noch um eine Größenordnung wachsen, bevor es die thermische Barriere erreicht.

An diesem Punkt werden bestehende Transistorarchitekturen nicht mehr in der Lage sein, die Energieeffizienz weiter zu verbessern, und die erzeugte Wärme verhindert, dass Transistoren dichter gepackt werden.

Wenn wir das nicht herausfinden, können wir nicht klar erkennen, wie sich die Werte der Branche verändern werden.

Mikroprozessoren werden eingeschränkt und die Industrie wird um geringere Vergütungen für marginale Energieeffizienz konkurrieren.

Die Chipgröße wird erweitert. Schauen Sie sich die GPU-Karte der 4000er-Serie von Nvidia an: Trotz der Verwendung eines Prozesses mit höherer Dichte ist sie etwa so groß wie ein kleiner Hund und bietet satte 650 W Leistung.

Dies veranlasste NVIDIA-CEO Jensen Huang Ende 2022 zu der Erklärung, dass „Moores Gesetz tot ist“ – eine Aussage, die zwar größtenteils wahr ist, aber von anderen Halbleiterunternehmen dementiert wurde.

IEEE veröffentlicht jedes Jahr eine Halbleiter-Roadmap. Nach neuester Einschätzung wird die 2D-Skalierung im Jahr 2028 abgeschlossen sein und die 3D-Skalierung soll im Jahr 2031 vollständig eingeführt sein.

3D-Skalierung (bei der Chips übereinander gestapelt werden) ist bereits üblich, allerdings im Computerspeicher, nicht in Mikroprozessoren.

Das liegt daran, dass die Wärmeableitung des Speichers viel geringer ist; die Wärmeableitung ist jedoch in der 3D-Architektur komplex, sodass eine aktive Speicherkühlung wichtig ist.

Speicher mit 256 Schichten kommt und soll bis 2030 die 1.000-Schichten-Marke erreichen.

Zurück zu Mikroprozessoren: Multi-Gate-Gerätearchitekturen, die zu kommerziellen Standards werden (wie FinFETs und Gates-allround), werden in den kommenden Jahren weiterhin dem Mooreschen Gesetz folgen.

Aber aufgrund inhärenter thermischer Probleme war eine echte vertikale Skalierung nach den 1930er Jahren unmöglich.

Tatsächlich überwachen aktuelle Chipsätze sorgfältig, welche Teile des Prozessors zu jedem Zeitpunkt aktiv sind, um eine Überhitzung selbst auf einer einzelnen Ebene zu vermeiden.

Krise 2030?

Vor einem Jahrhundert fragte der amerikanische Dichter Robert Frost einmal: Wird die Welt in Frost oder Feuer enden?

Wenn die Antwort Feuer ist, läutet das fast das Ende der Informatik ein.

Oder akzeptieren Sie einfach die Tatsache, dass der Stromverbrauch steigen und die Herstellung von Mikroprozessoren zunehmen wird.

Zu diesem Zweck hat der Mensch einen großen Teil der Energie der Erde verbraucht.

Vielleicht besteht eine andere Möglichkeit darin, einfach den erhöhten Stromverbrauch zu akzeptieren und die Mikroprozessorfertigung auszuweiten. Dafür nutzen wir bereits einen Großteil des Energievorrats der Erde.

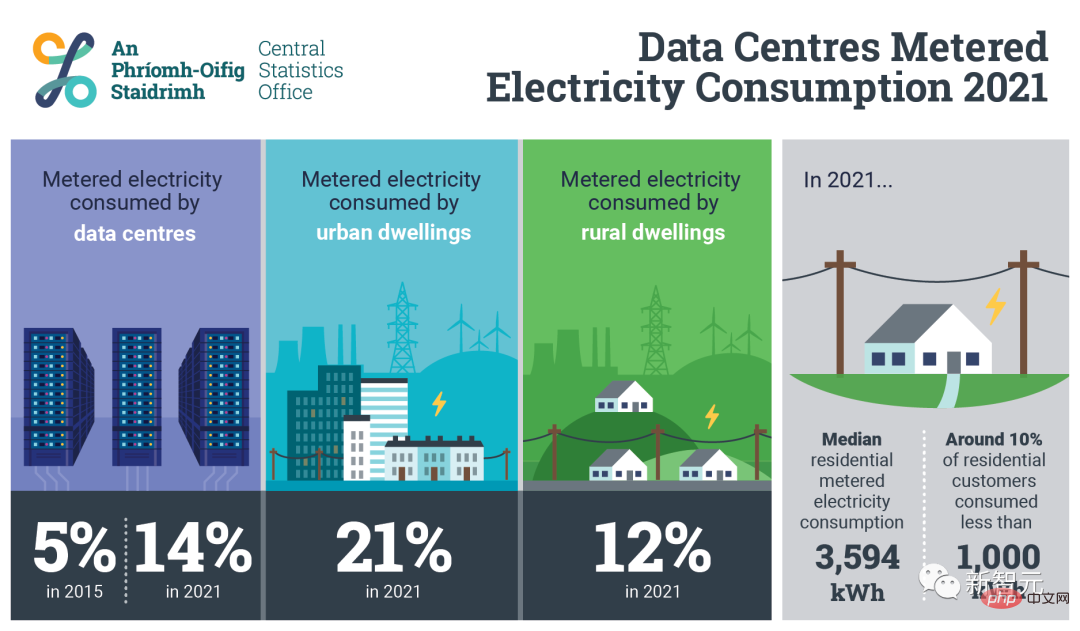

In Irland verbrauchen nur 70 Rechenzentren 14 % der Energie des Landes. Bis in die 2030er Jahre wird erwartet, dass 30–50 % des weltweit produzierten Stroms für Computer und Kühlung verwendet werden.

(Interessanterweise hat der Autor diese Vorhersage nach der Veröffentlichung des Blogbeitrags am 19. März gelöscht. Seine Erklärung ist, dass dies aus Gründen der Klarheit und Genauigkeit auf der Worst-Case-Schlussfolgerung im Nature-Papier basiert Argument, das jetzt entfernt wurde)

Die aktuelle Skalierungsrate der Energieproduktion wird zu einem leichten Anstieg der Kosten für die Skalierung nach dem Mooreschen Gesetz führen.

Eine Reihe einmaliger Optimierungsmaßnahmen auf Design- (Energieeffizienz) und Implementierungsebene (Ersetzen alter, noch verwendeter Designs durch neueste Technologie) wird es Entwicklungsländern wie Indien ermöglichen, mit der Gesamtproduktivität der Welt gleichzuziehen.

Nach dem Ende des Mooreschen Gesetzes wird der Menschheit die Energie ausgehen, bevor die Herstellung von Mikroprozessorchips ihre Grenzen erreicht, und das Tempo des Rückgangs der Rechenkosten wird stagnieren.

Obwohl Quantencomputer als effektive Möglichkeit angepriesen werden, das Mooresche Gesetz zu übertreffen, gibt es zu viele Unbekannte darüber und es wird noch Jahrzehnte von der kommerziellen Nutzung entfernt sein. Zumindest in den nächsten 20 bis 30 Jahren wird es keinen Nutzen haben.

Natürlich wird es in den nächsten 10 Jahren eine gravierende Rechenleistungslücke geben, die kein bestehendes Technologieunternehmen, kein Investor oder keine Regierungsbehörde lösen kann.

Der Konflikt zwischen dem Mooreschen Gesetz und dem Landauer-Limit besteht seit Jahrzehnten und kann als eines der bedeutendsten und kritischsten Ereignisse der 2030er Jahre bezeichnet werden.

Aber jetzt scheint es, dass nicht viele Leute davon wissen.

Das obige ist der detaillierte Inhalt vonDie Menschheit hat die Obergrenze der Silizium-Computing-Architektur erreicht! Es wird erwartet, dass KI bis 2030 50 % der weltweiten Stromversorgung verbrauchen wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

Die allgemeine Matrixmultiplikation (GEMM) ist ein wesentlicher Bestandteil vieler Anwendungen und Algorithmen und außerdem einer der wichtigen Indikatoren zur Bewertung der Leistung der Computerhardware. Eingehende Forschung und Optimierung der Implementierung von GEMM können uns helfen, Hochleistungsrechnen und die Beziehung zwischen Software- und Hardwaresystemen besser zu verstehen. In der Informatik kann eine effektive Optimierung von GEMM die Rechengeschwindigkeit erhöhen und Ressourcen einsparen, was für die Verbesserung der Gesamtleistung eines Computersystems von entscheidender Bedeutung ist. Ein tiefgreifendes Verständnis des Funktionsprinzips und der Optimierungsmethode von GEMM wird uns helfen, das Potenzial moderner Computerhardware besser zu nutzen und effizientere Lösungen für verschiedene komplexe Computeraufgaben bereitzustellen. Durch Optimierung der Leistung von GEMM

So berechnen Sie Addition, Subtraktion, Multiplikation und Division in einem Word-Dokument

Mar 19, 2024 pm 08:13 PM

So berechnen Sie Addition, Subtraktion, Multiplikation und Division in einem Word-Dokument

Mar 19, 2024 pm 08:13 PM

WORD ist ein leistungsstarkes Textverarbeitungsprogramm, mit dem wir verschiedene Texte in Excel bearbeiten können. Wir beherrschen die Berechnungsmethoden der Addition, Subtraktion und Multiplikatoren. Wie subtrahiere ich den Multiplikator? Kann ich ihn nur mit einem Taschenrechner berechnen? Die Antwort ist natürlich nein, WORD kann das auch. Heute werde ich Ihnen beibringen, wie Sie mit Formeln grundlegende Operationen wie Addition, Subtraktion, Multiplikation und Division in Tabellen in Word-Dokumenten berechnen. Lassen Sie mich heute im Detail zeigen, wie man Addition, Subtraktion, Multiplikation und Division in einem WORD-Dokument berechnet. Schritt 1: Öffnen Sie ein WORD, klicken Sie in der Symbolleiste unter [Einfügen] auf [Tabelle] und fügen Sie eine Tabelle in das Dropdown-Menü ein.

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

So zählen Sie die Anzahl der Elemente in einer Liste mit der Funktion count() von Python

Nov 18, 2023 pm 02:53 PM

So zählen Sie die Anzahl der Elemente in einer Liste mit der Funktion count() von Python

Nov 18, 2023 pm 02:53 PM

Um die Anzahl der Elemente in einer Liste mit der Funktion count() von Python zu zählen, sind bestimmte Codebeispiele erforderlich. Als leistungsstarke und leicht zu erlernende Programmiersprache bietet Python viele integrierte Funktionen zur Verarbeitung unterschiedlicher Datenstrukturen. Eine davon ist die Funktion count(), mit der sich die Anzahl der Elemente in einer Liste zählen lässt. In diesem Artikel erklären wir die Verwendung der count()-Funktion im Detail und stellen spezifische Codebeispiele bereit. Die Funktion count() ist eine in Python integrierte Funktion, mit der ein bestimmter Wert berechnet wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

So verwenden Sie die Math.Pow-Funktion in C#, um die Potenz einer bestimmten Zahl zu berechnen

Nov 18, 2023 am 11:32 AM

So verwenden Sie die Math.Pow-Funktion in C#, um die Potenz einer bestimmten Zahl zu berechnen

Nov 18, 2023 am 11:32 AM

In C# gibt es eine Math-Klassenbibliothek, die viele mathematische Funktionen enthält. Dazu gehört die Funktion Math.Pow, die Potenzen berechnet und uns dabei helfen kann, die Potenz einer bestimmten Zahl zu berechnen. Die Verwendung der Math.Pow-Funktion ist sehr einfach, Sie müssen lediglich die Basis und den Exponenten angeben. Die Syntax lautet wie folgt: Math.Pow(base,exponent); wobei base die Basis und exponent den Exponenten darstellt. Diese Funktion gibt ein Ergebnis vom Typ Double zurück, nämlich das Ergebnis der Leistungsberechnung. Lasst uns

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

„Minecraft' verwandelt sich in eine KI-Stadt und NPC-Bewohner spielen Rollenspiele wie echte Menschen

Jan 02, 2024 pm 06:25 PM

Bitte beachten Sie, dass dieser kantige Mann die Stirn runzelt und über die Identität der „ungebetenen Gäste“ vor ihm nachdenkt. Es stellte sich heraus, dass sie sich in einer gefährlichen Situation befand, und als ihr dies klar wurde, begann sie schnell mit der mentalen Suche nach einer Strategie zur Lösung des Problems. Letztendlich entschloss sie sich, vom Unfallort zu fliehen, dann so schnell wie möglich Hilfe zu suchen und sofort Maßnahmen zu ergreifen. Gleichzeitig dachte die Person auf der Gegenseite das Gleiche wie sie... In „Minecraft“ gab es eine solche Szene, in der alle Charaktere von künstlicher Intelligenz gesteuert wurden. Jeder von ihnen hat eine einzigartige Identität. Das zuvor erwähnte Mädchen ist beispielsweise eine 17-jährige, aber kluge und mutige Kurierin. Sie haben die Fähigkeit, sich zu erinnern und zu denken und in dieser kleinen Stadt in Minecraft wie Menschen zu leben. Was sie antreibt, ist ein brandneues,