Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

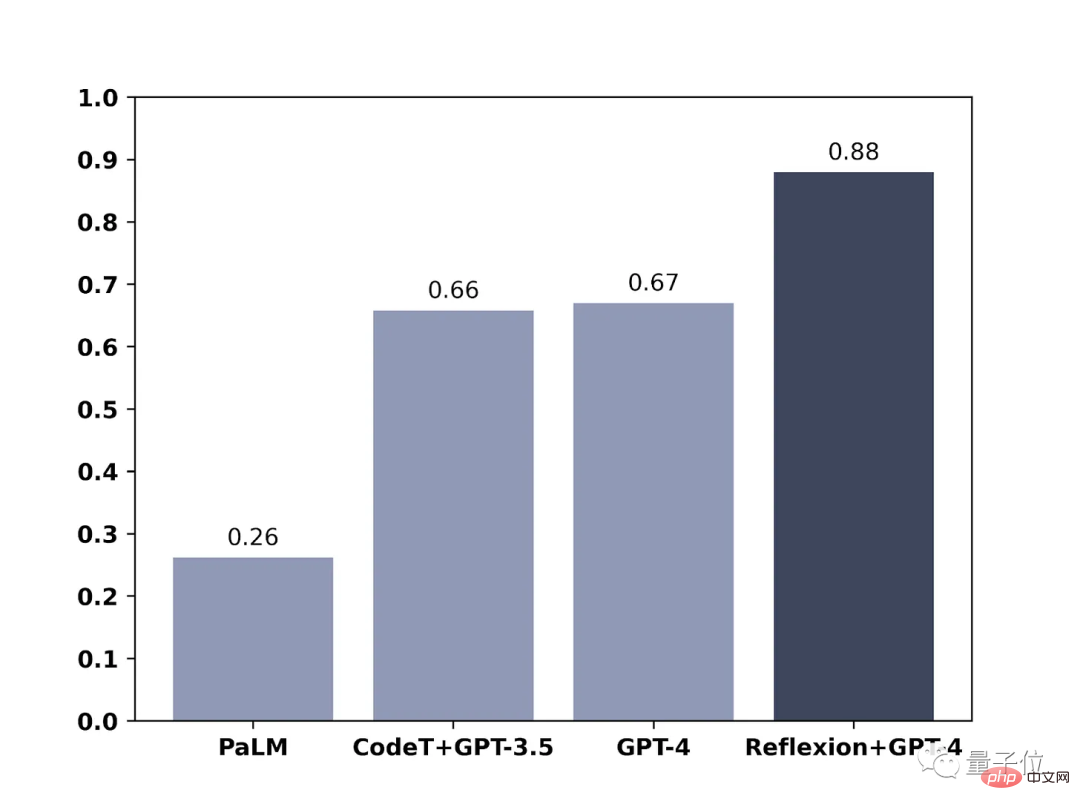

Die GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken

Die GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken

Die GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken

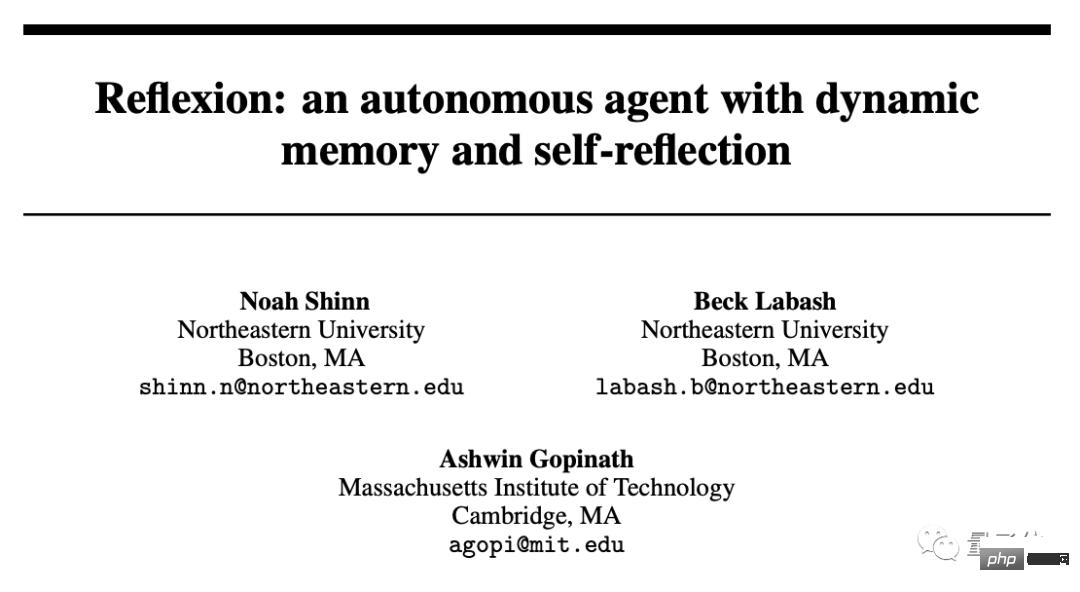

Dies ist die Methode in der neuesten Veröffentlichung der Northeastern University und des MIT: Reflexion.

Dieser Artikel wurde mit Genehmigung von AI New Media Qubit (öffentliche Konto-ID: QbitAI) nachgedruckt. Bitte wenden Sie sich für einen Nachdruck an die Quelle.

GPT-4 entwickelt sich weiter!

Mit einer einfachen Methode können große Sprachmodelle wie GPT-4 lernen, sich selbst zu reflektieren, und die Leistung kann direkt um 30 % verbessert werden.

Vorher gab das große Sprachmodell falsche Antworten. Sie entschuldigten sich oft wortlos und machten dann weiter zufällige Vermutungen.

Mit der Hinzufügung neuer Methoden wird GPT-4 nicht nur darüber nachdenken, wo es schief gelaufen ist, sondern auch Verbesserungsstrategien aufzeigen.

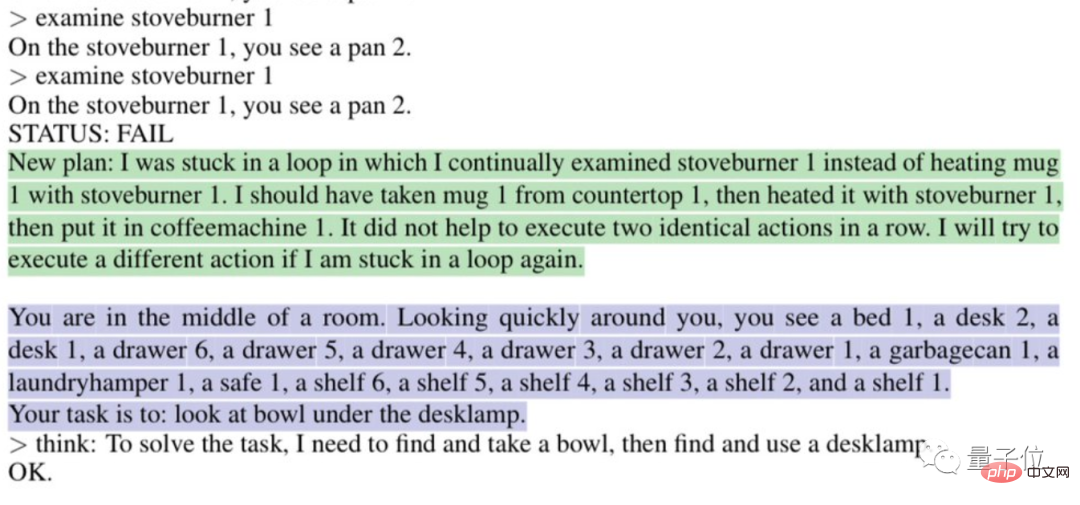

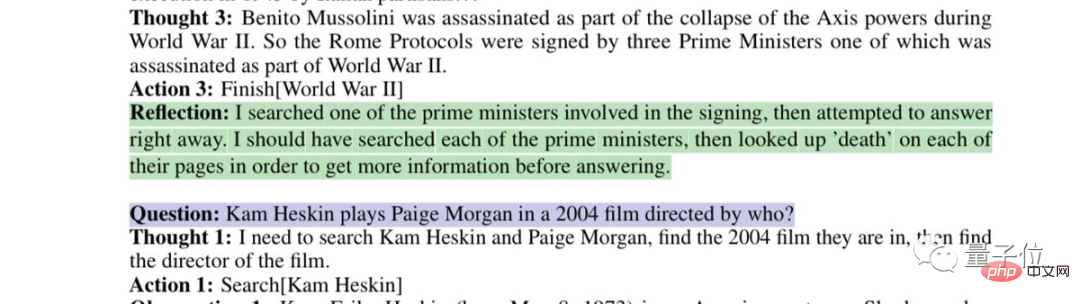

Zum Beispiel wird automatisch analysiert, warum es „in einer Schleife feststeckt“:

Oder denken Sie über Ihre eigene fehlerhafte Suchstrategie nach:

Dies ist die Methode in der neuesten von der Northeastern University veröffentlichten Arbeit und MIT: Reflexion.

Nicht nur auf GPT-4 anwendbar, sondern auch auf andere große Sprachmodelle, sodass sie die einzigartige menschliche Reflexionsfähigkeit erlernen können.

Der Artikel wurde auf der Preprint-Plattform arxiv veröffentlicht.

Dies brachte die Internetnutzer direkt dazu zu sagen: „Die Geschwindigkeit der KI-Entwicklung hat unsere Anpassungsfähigkeit überschritten und wir werden zerstört.“

Einige Internetnutzer haben sogar eine „Jobwarnung“ an Entwickler gesendet:

Der Stundensatz für das Schreiben von Code mit dieser Methode ist günstiger als der für normale Entwickler.

Verwenden Sie den binären Belohnungsmechanismus, um Reflexion zu erreichen

Wie Internetnutzer sagten, ähnelt die Reflexionsfähigkeit, die GPT-4 durch Reflexion verliehen wird, dem menschlichen Denkprozess:

lässt sich in zwei Worten zusammenfassen: Feedback .

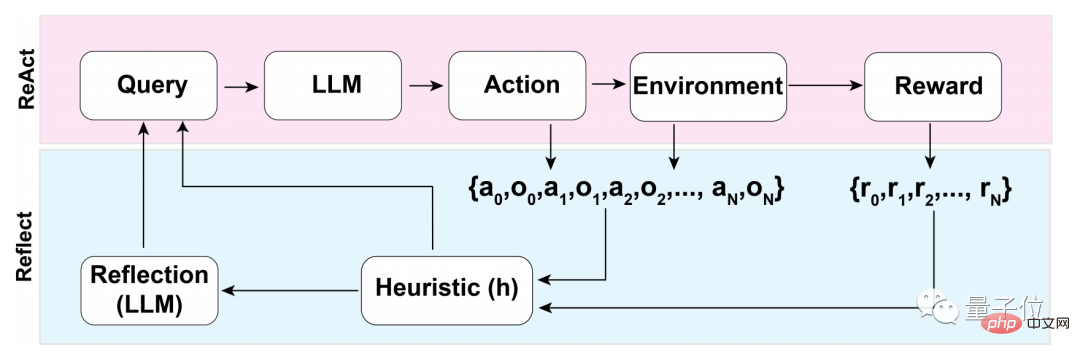

Dieser Feedback-Prozess kann in drei Hauptschritte unterteilt werden:

- 1. Bewertung: Testen der Genauigkeit der aktuell generierten Antworten

- 2. Generierung von Selbstreflexion: Fehlererkennung – Korrektur umsetzen

- 3. Führen Sie eine iterative Feedbackschleife durch

Im ersten Schritt des Bewertungsprozesses muss zunächst die Selbstbewertung des LLM (Large Language Model) durchgeführt werden.

Das heißt, LLM muss zunächst über die Antwort selbst nachdenken, wenn es kein externes Feedback gibt.

Wie mache ich Selbstreflexion?

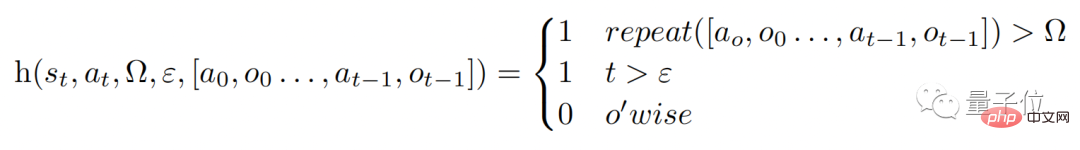

Das Forschungsteam verwendet einen binären Belohnungsmechanismus, um den von LLM im aktuellen Zustand durchgeführten Operationen Werte zuzuweisen:

1 bedeutet, dass das generierte Ergebnis in Ordnung ist, und 0 bedeutet, dass das generierte Ergebnis nicht gut ist .

Der Grund, warum binär anstelle von beschreibenderen Belohnungsmechanismen wie mehrwertiger oder kontinuierlicher Ausgabe verwendet wird, hängt mit der Tatsache zusammen, dass keine externe Eingabe erfolgt.

Um Selbstreflexion ohne externes Feedback durchzuführen, muss die Antwort auf binäre Zustände beschränkt werden. Nur so kann das LLM gezwungen werden, sinnvolle Schlussfolgerungen zu ziehen.

Wenn nach der Selbstbewertung die Ausgabe des binären Belohnungsmechanismus 1 ist, wird das Selbstreflexionsgerät nicht aktiviert. Wenn sie 0 ist, schaltet das LLM den Reflexionsmodus ein.

Während des Reflexionsprozesses löst das Modell eine heuristische Funktion h aus (analog zum menschlichen Denkprozess spielt h die gleiche Rolle wie Überwachung).

Und ε stellt die maximale Anzahl von Operationen dar, die während des Reflexionsprozesses ausgeführt werden dürfen.

Da es Aufsicht gibt, muss auch Korrektur durchgeführt werden. Die Funktion des Korrekturprozesses ist wie folgt:

Dabei wird das Selbstreflexionsmodell durch „spezifische Domänen-Fehlertrajektorien“ und Ideale trainiert Reflexionspaare“ kommt und ermöglicht keinen Zugriff auf domänenspezifische Lösungen für ein bestimmtes Problem im Datensatz.

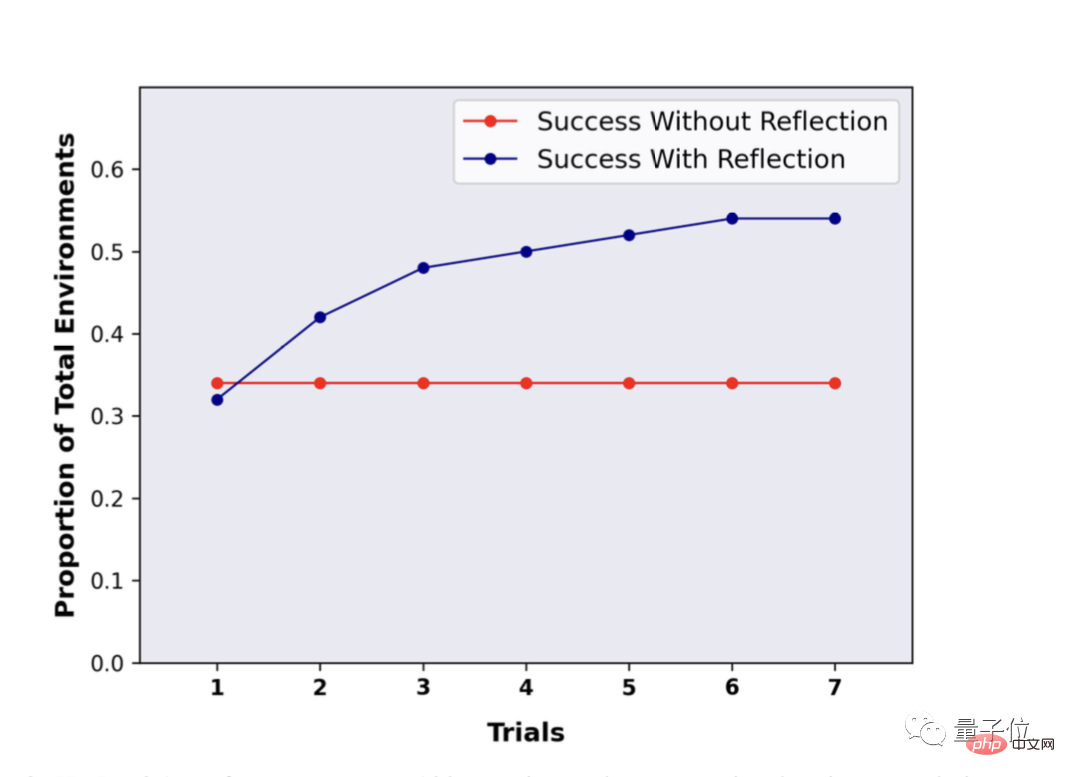

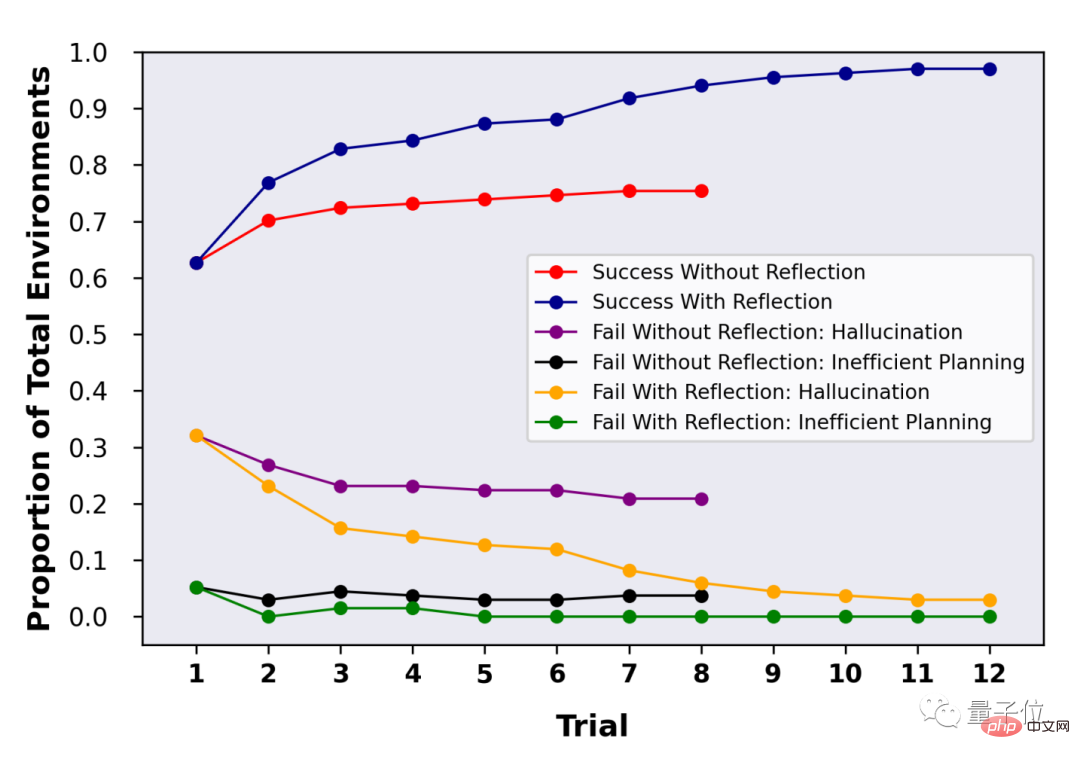

Auf diese Weise kann LLM im Reflexionsprozess zu mehr „innovativen“ Dingen kommen. Nach der Reflexion stieg die Leistung um fast 30 %Da LLMs wie GPT-4 Selbstreflexion durchführen können, was ist der spezifische Effekt? Das Forschungsteam hat diesen Ansatz anhand der Benchmarks ALFWorld und HotpotQA bewertet. Im HotpotQA-Test mit 100 Frage-Antwort-Paaren zeigte LLM mit der Reflexionsmethode enorme Vorteile. Nach mehreren Reflexionsrunden und wiederholten Fragen verbesserte sich die Leistung von LLM um fast 30 %. Ohne Reflexion gab es nach Wiederholung der Fragen und Antworten keine Leistungsveränderung.

Das obige ist der detaillierte Inhalt vonDie GPT-4-Codierungsfähigkeit wurde um 21 % verbessert! Die neue Methode des MIT ermöglicht es LLM, das Reflektieren zu lernen, Netizen: Es ist die gleiche Art und Weise, wie Menschen denken. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV'23-Papierpreis „Fighting of Gods'! Meta Divide Everything und ControlNet wurden gemeinsam ausgewählt, und es gab einen weiteren Artikel, der die Jury überraschte

Oct 04, 2023 pm 08:37 PM

ICCV2023, die Top-Computer-Vision-Konferenz in Paris, Frankreich, ist gerade zu Ende gegangen! Der diesjährige Preis für das beste Papier ist einfach ein „Kampf zwischen Göttern“. Zu den beiden Arbeiten, die den Best Paper Award gewannen, gehörte beispielsweise ControlNet, eine Arbeit, die das Gebiet der vinzentinischen Graphen-KI untergrub. Seitdem ControlNet als Open-Source-Lösung verfügbar ist, hat es auf GitHub 24.000 Sterne erhalten. Ob es sich um Diffusionsmodelle oder den gesamten Bereich der Computer Vision handelt, die Auszeichnung für dieses Papier ist wohlverdient. Die lobende Erwähnung für die beste Arbeit ging an eine andere ebenso berühmte Arbeit, Metas „Separate Everything“ „Model SAM“. Seit seiner Einführung ist „Segment Everything“ zum „Benchmark“ für verschiedene Bildsegmentierungs-KI-Modelle geworden, auch für solche, die von hinten kamen.

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

NeRF und die Vergangenheit und Gegenwart des autonomen Fahrens, eine Zusammenfassung von fast 10 Artikeln!

Nov 14, 2023 pm 03:09 PM

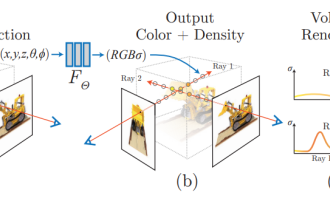

Seit Neural Radiance Fields im Jahr 2020 vorgeschlagen wurde, hat die Zahl verwandter Arbeiten exponentiell zugenommen. Es hat sich nicht nur zu einem wichtigen Zweig der dreidimensionalen Rekonstruktion entwickelt, sondern ist auch allmählich an der Forschungsgrenze als wichtiges Werkzeug für autonomes Fahren aktiv geworden . NeRF ist in den letzten zwei Jahren plötzlich aufgetaucht, hauptsächlich weil es die Merkmalspunktextraktion und -anpassung, die epipolare Geometrie und Triangulation, PnP plus Bündelanpassung und andere Schritte der traditionellen CV-Rekonstruktionspipeline und sogar die Netzrekonstruktion, Kartierung und Lichtverfolgung überspringt , direkt aus 2D Das Eingabebild wird verwendet, um ein Strahlungsfeld zu lernen, und dann wird aus dem Strahlungsfeld ein gerendertes Bild ausgegeben, das einem echten Foto nahekommt. Mit anderen Worten: Lassen Sie ein implizites dreidimensionales Modell, das auf einem neuronalen Netzwerk basiert, zur angegebenen Perspektive passen

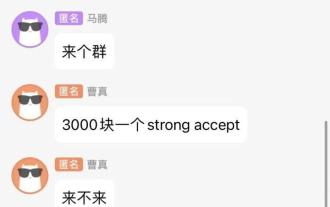

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Chat-Screenshots enthüllen versteckte Regeln für KI-Rezensenten! AAAI 3000 Yuan ist stark zu akzeptieren?

Apr 12, 2023 am 08:34 AM

Gerade als die Einreichungsfrist für AAAI 2023-Papiere näher rückte, erschien plötzlich ein Screenshot eines anonymen Chats in der AI-Einreichungsgruppe auf Zhihu. Einer von ihnen behauptete, er könne „3.000 Yuan pro starkem Akzept“ anbieten. Sobald die Nachricht bekannt wurde, erregte sie sofort öffentliche Empörung unter den Internetnutzern. Aber beeilen Sie sich noch nicht. Zhihu-Chef „Fine Tuning“ sagte, dass dies höchstwahrscheinlich nur ein „verbales Vergnügen“ sei. Laut „Fine Tuning“ sind Begrüßungen und Bandenkriminalität in jedem Bereich unvermeidbare Probleme. Mit dem Aufkommen von OpenReview werden die verschiedenen Nachteile von cmt immer deutlicher. Der Spielraum für kleine Kreise wird in Zukunft kleiner, aber es wird immer Platz geben. Denn es handelt sich um ein persönliches Problem und nicht um ein Problem mit dem Einreichungssystem und -mechanismus. Wir stellen Open R vor

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Auch Papierillustrationen können mithilfe des Diffusionsmodells automatisch generiert werden und werden auch vom ICLR akzeptiert.

Jun 27, 2023 pm 05:46 PM

Generative KI hat die Community der künstlichen Intelligenz im Sturm erobert. Sowohl Einzelpersonen als auch Unternehmen sind daran interessiert, entsprechende modale Konvertierungsanwendungen wie Vincent-Bilder, Vincent-Videos, Vincent-Musik usw. zu erstellen. In jüngster Zeit haben mehrere Forscher von wissenschaftlichen Forschungseinrichtungen wie ServiceNow Research und LIVIA versucht, Diagramme in Aufsätzen basierend auf Textbeschreibungen zu erstellen. Zu diesem Zweck schlugen sie eine neue Methode von FigGen vor, und das entsprechende Papier wurde auch als TinyPaper in ICLR2023 aufgenommen. Adresse des Bildpapiers: https://arxiv.org/pdf/2306.00800.pdf Manche Leute fragen sich vielleicht: Was ist so schwierig daran, die Diagramme im Papier zu erstellen? Wie hilft dies der wissenschaftlichen Forschung?

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

Das chinesische Team gewann die Auszeichnungen „Best Paper' und „Best System Paper' und die CoRL-Forschungsergebnisse wurden bekannt gegeben.

Nov 10, 2023 pm 02:21 PM

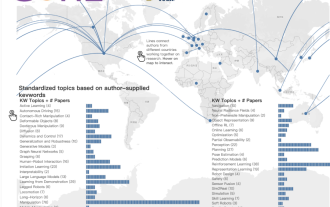

Seit ihrer ersten Veranstaltung im Jahr 2017 hat sich die CoRL zu einer der weltweit führenden akademischen Konferenzen an der Schnittstelle von Robotik und maschinellem Lernen entwickelt. CoRL ist eine themenspezifische Konferenz für Roboterlernforschung, die mehrere Themen wie Robotik, maschinelles Lernen und Steuerung, einschließlich Theorie und Anwendung, abdeckt. Die CoRL-Konferenz 2023 findet vom 6. bis 9. November in Atlanta, USA, statt. Nach offiziellen Angaben wurden in diesem Jahr 199 Arbeiten aus 25 Ländern für CoRL ausgewählt. Beliebte Themen sind Operationen, Reinforcement Learning und mehr. Obwohl CoRL von kleinerem Umfang ist als große akademische KI-Konferenzen wie AAAI und CVPR, wird die Beliebtheit von Konzepten wie großen Modellen, verkörperter Intelligenz und humanoiden Robotern in diesem Jahr zunehmen, aber auch relevante Forschung verdient Aufmerksamkeit

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

CVPR-Rangliste 2023 veröffentlicht, die Akzeptanzrate beträgt 25,78 %! 2.360 Beiträge wurden angenommen und die Zahl der Einreichungen stieg auf 9.155

Apr 13, 2023 am 09:37 AM

Gerade hat CVPR 2023 eine Erklärung herausgegeben, in der es heißt: In diesem Jahr haben wir eine Rekordzahl von 9.155 Beiträgen erhalten (ein Anstieg von 12 % gegenüber CVPR 2022) und 2.360 Beiträge angenommen, was einer Annahmequote von 25,78 % entspricht. Laut Statistik stieg die Zahl der Einreichungen beim CVPR in den sieben Jahren von 2010 bis 2016 lediglich von 1.724 auf 2.145. Nach 2017 stieg sie rasant an und trat in eine Phase rasanten Wachstums ein. Im Jahr 2019 überstieg sie erstmals die 5.000-Marke, und bis 2022 lag die Zahl der Einreichungen bei 8.161. Wie Sie sehen, wurden in diesem Jahr insgesamt 9.155 Beiträge eingereicht, was einen Rekord darstellt. Nachdem sich die Epidemie abgeschwächt hat, wird der diesjährige CVPR-Gipfel in Kanada stattfinden. In diesem Jahr wird das Format einer eingleisigen Konferenz übernommen und die traditionelle mündliche Auswahl entfällt. Google-Recherche

Microsofts neues heißes Papier: Transformer expandiert auf 1 Milliarde Token

Jul 22, 2023 pm 03:34 PM

Microsofts neues heißes Papier: Transformer expandiert auf 1 Milliarde Token

Jul 22, 2023 pm 03:34 PM

Da jeder seine eigenen großen Modelle weiter aktualisiert und iteriert, ist auch die Fähigkeit von LLM (großes Sprachmodell), Kontextfenster zu verarbeiten, zu einem wichtigen Bewertungsindikator geworden. Beispielsweise unterstützt das Star-Modell GPT-4 32.000 Token, was 50 Textseiten entspricht. Anthropic wurde von einem ehemaligen Mitglied von OpenAI gegründet und hat die Token-Verarbeitungsfähigkeiten von Claude auf 100.000 erhöht, was ungefähr 75.000 Wörtern entspricht entspricht der Zusammenfassung von „Harry Potter“ mit einem Klick 》Teil Eins. In der neuesten Studie von Microsoft wurde Transformer dieses Mal direkt auf 1 Milliarde Token erweitert. Dies eröffnet neue Möglichkeiten zur Modellierung sehr langer Sequenzen, beispielsweise die Behandlung eines gesamten Korpus oder sogar des gesamten Internets als eine Sequenz. Zum Vergleich: üblich