Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Kann GPT-4 überhaupt nicht programmiert werden? Jemand hat es zeigen lassen

Kann GPT-4 überhaupt nicht programmiert werden? Jemand hat es zeigen lassen

Kann GPT-4 überhaupt nicht programmiert werden? Jemand hat es zeigen lassen

Nachdem OpenAI GPT-4 veröffentlicht hat, wird die Diskussion über „KI ersetzt menschliche Arbeit“ immer intensiver. Die leistungsstarken Fähigkeiten des Modells und seine potenziellen sozialen Auswirkungen haben bei vielen Menschen Bedenken geweckt. Musk, Bengio und andere haben sogar gemeinsam einen offenen Brief geschrieben, in dem sie alle KI-Institutionen dazu auffordern, die Ausbildung stärkerer KI-Modelle als GPT-4 für einen Zeitraum von mindestens 6 Monaten auszusetzen .

Aber andererseits nehmen auch immer mehr Zweifel an der Leistungsfähigkeit von GPT-4 zu. Vor ein paar Tagen wies Turing-Preisträger Yann LeCun in einer Debatte direkt darauf hin, dass der von der GPT-Familie gewählte autoregressive Weg natürliche Mängel aufweist und es keine Zukunft gibt, weiter voranzukommen.

Gleichzeitig sagten einige Forscher und Praktiker auch, dass GPT-4 möglicherweise nicht so leistungsfähig ist, wie OpenAI gezeigt hat, insbesondere in der Programmierung: Möglicherweise erinnert es sich nur an die vorherigen Fragen, die OpenAI zum Testen des Modells verwendet. Fragen zu Programmierfähigkeiten können auftreten Es ist bereits in seinem Trainingssatz vorhanden, was gegen die Grundregeln des maschinellen Lernens verstößt. Darüber hinaus wiesen einige Leute darauf hin, dass es nicht streng sei, zu beurteilen, ob KI einige Berufe ersetzen werde, nachdem GPT-4 in verschiedenen Prüfungen zu den Besten gehörte. Schließlich bestehe immer noch eine Lücke zwischen diesen Prüfungen und der tatsächlichen menschlichen Arbeit.

Ein aktueller Blog hat die obige Idee ausführlich erläutert.

Problem 1: Kontamination von Trainingsdaten

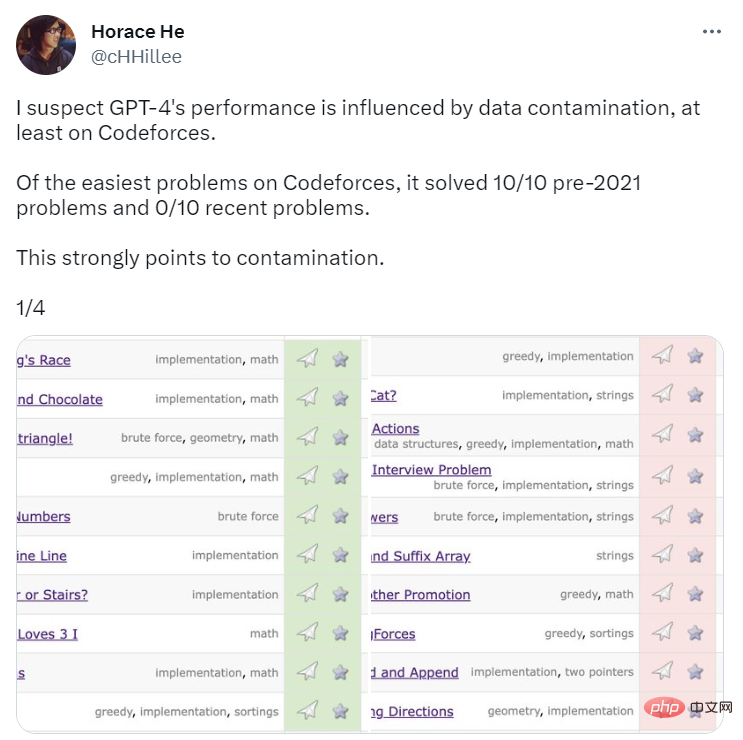

Um die Programmierfähigkeiten von GPT-4 zu vergleichen, hat OpenAI es anhand von Fragen der Programmierwettbewerbs-Website Codeforces bewertet. Überraschenderweise löste GPT-4 10/10 der Probleme vor 2021 und 0/10 der jüngsten einfachen Klassenprobleme. Wissen Sie, die Frist für die Trainingsdaten für GPT-4 ist September 2021. Dies ist ein starker Hinweis darauf, dass das Modell in der Lage ist, sich Lösungen aus seinem Trainingssatz zu merken – oder sich zumindest teilweise an sie zu erinnern, was ausreicht, um das auszufüllen, woran es sich nicht erinnert.

Quelle: https://twitter.com/cHHillee/status/1635790330854526981

Um diese Hypothese weiter zu beweisen, haben die Blogger Arvind Narayanan und Sayash Kapoor GPT-4 zu verschiedenen Zeitpunkten im Jahr 2021 auf Codeforces-Probleme getestet und festgestellt Es kann die einfache Kategorie von Problemen vor dem 5. September lösen, aber die Probleme nach dem 12. September nicht lösen.

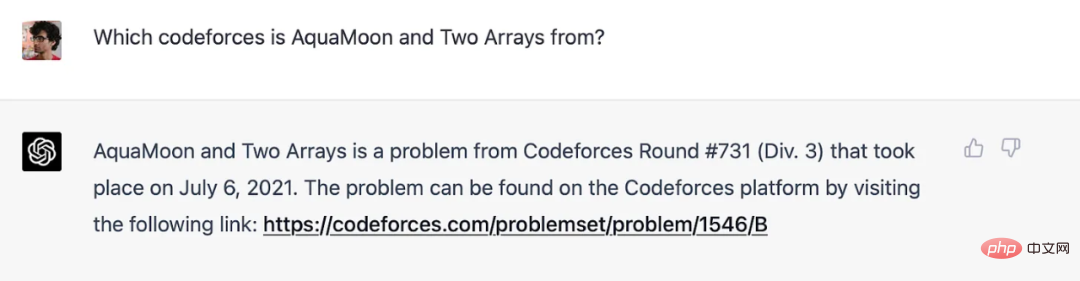

Die Autoren sagen, dass sie tatsächlich deutlich zeigen können, dass GPT-4 die Fragen im Trainingssatz auswendig gelernt hat: Wenn der Titel der Codeforces-Frage zur Eingabeaufforderung hinzugefügt wird, enthält die Antwort von GPT-4 einen Link dazu exakte Übereinstimmung mit dem Link, bei dem die Frage aufgetreten ist (und die runde Zahl ist fast korrekt: es ist einmalig). Beachten Sie, dass GPT-4 zu diesem Zeitpunkt nicht mit dem Internet verbunden war, sodass der Speicher die einzige Erklärung ist.

GPT-4 merkt sich Codeforces-Fragen vor Schulungsfristen.

Die Codeforces-Ergebnisse im Artikel sind davon nicht betroffen, da OpenAI neuere Probleme verwendet (und GPT-4 tatsächlich eine schlechte Leistung erbringt). Für andere Benchmarks als die Programmierung ist den Autoren keine saubere Möglichkeit bekannt, Probleme nach Zeiträumen zu trennen, daher glauben sie, dass OpenAI eine Kontamination wahrscheinlich nicht vermeiden kann. Allerdings konnten sie auch keine Experimente durchführen, um zu testen, wie sich die Leistung an verschiedenen Tagen veränderte.

Allerdings können sie immer noch nach verräterischen Anzeichen Ausschau halten. Ein weiteres Zeichen der Erinnerung: GPT reagiert sehr sensibel auf die Formulierung von Fragen. Melanie Mitchell gab ein Beispiel für eine MBA-Testfrage. Sie änderte einige Details dieses Beispiels. Diese Änderung konnte niemanden täuschen, aber sie hat ChatGPT (mit GPT-3.5) erfolgreich getäuscht. Ein detaillierteres Experiment in dieser Richtung wäre wertvoll.

Aufgrund der mangelnden Transparenz von OpenAI kann der Autor die Kontaminationsfrage nicht sicher beantworten. Sicher ist jedoch, dass der Ansatz von OpenAI zur Erkennung von Kontaminationen oberflächlich und schlampig ist:

Wir verwenden Substring-Matching, um Kreuzkontaminationen zwischen unserem Bewertungsdatensatz und den Daten vor dem Training zu messen. Sowohl Evaluierungs- als auch Trainingsdaten werden verarbeitet, indem alle Leerzeichen und Symbole entfernt werden und nur Zeichen (einschließlich Zahlen) übrig bleiben. Für jede Bewertungsinstanz wählen wir zufällig drei Teilzeichenfolgen mit 50 Zeichen aus (bei weniger als 50 Zeichen wird die gesamte Instanz verwendet). Eine Übereinstimmung wird erkannt, wenn einer der drei abgetasteten Bewertungsteilstrings ein Teilstring des verarbeiteten Trainingsbeispiels ist. Dadurch wird eine Liste fehlerhafter Beispiele erstellt. Wir verwerfen diese und führen sie erneut aus, um unverfälschte Ergebnisse zu erhalten.

Das ist ein fragiler Ansatz. Wenn im Trainingssatz ein Testproblem auftritt, Name und Nummer jedoch geändert werden, bleibt es unentdeckt. Weniger spröde Methoden sind leicht verfügbar, wie etwa der Einbettungsabstand.

Wenn OpenAI distanzbasierte Methoden verwenden würde, wie ähnlich ist dann zu ähnlich? Auf diese Frage gibt es keine objektive Antwort. Daher ist selbst etwas so scheinbar Einfaches wie die Durchführung eines standardisierten Multiple-Choice-Tests mit subjektiven Entscheidungen behaftet.

Aber wir können etwas klarstellen, indem wir fragen, was OpenAI mit diesen Prüfungen messen will. Wenn das Ziel darin besteht, die Leistung eines Sprachmodells bei realen Aufgaben vorherzusagen, gibt es ein Problem. In gewisser Weise ähneln sich zwei Fragen zu Anwaltsprüfungen oder medizinischen Prüfungen mehr als zwei ähnliche Aufgaben, mit denen sich Berufstätige in der Praxis konfrontiert sehen, weil sie aus einem so begrenzten Raum stammen. Daher besteht die Gefahr, dass die Aufnahme von Prüfungsfragen in den Schulungskorpus zu überzogenen Schätzungen des Nutzens des Modells in der realen Welt führt.

Die Erklärung dieser Frage aus der Perspektive der praktischen Nützlichkeit beleuchtet ein weiteres tieferes Problem (Frage 2).

Frage 2: Professionelle Prüfungen sind kein effektiver Weg, um die Fähigkeiten von Menschen und Robotern zu vergleichen.

Das Gedächtnis ist ein Spektrum. Selbst wenn ein Sprachmodell keine exakte Frage im Trainingssatz gesehen hat, wird es aufgrund der Größe des Trainingskorpus zwangsläufig sehr ähnliche Beispiele sehen. Dies bedeutet, dass dem Problem durch eine oberflächlichere Argumentation entgangen werden kann. Daher liefern uns die Benchmark-Ergebnisse keinen Beweis dafür, dass Sprachmodelle die Art von tiefen Denkfähigkeiten erwerben, die menschliche Testteilnehmer benötigen, um diese Fähigkeiten dann in der realen Welt anzuwenden.

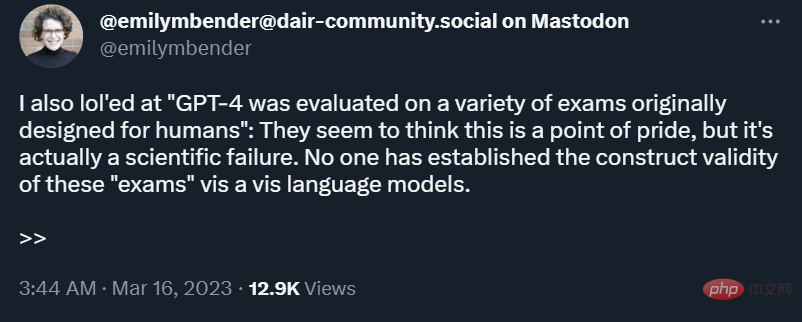

Bei manchen realen Aufgaben kann oberflächliches Denken ausreichend sein, aber nicht immer. Die Welt verändert sich ständig. Wenn also ein Roboter gebeten würde, die rechtlichen Konsequenzen einer neuen Technologie oder einer neuen Gerichtsentscheidung zu analysieren, hätte er kaum einen Anhaltspunkt. Zusammenfassend lässt sich sagen, dass, wie Emily Bender betont, Tests, die für Menschen entwickelt wurden, bei der Anwendung auf Roboter keine Konstruktvalidität aufweisen.

Darüber hinaus wird bei Berufsprüfungen, insbesondere bei der Anwaltsprüfung, das Fachwissen überbetont und praxisnahe Fähigkeiten unterbewertet, die bei standardisierter computergestützter Verwaltung schwerer zu messen sind. Mit anderen Worten: Diese Prüfungen betonen nicht nur die falschen Dinge, sondern überbetonen auch die Dinge, in denen Sprachmodelle gut sind.

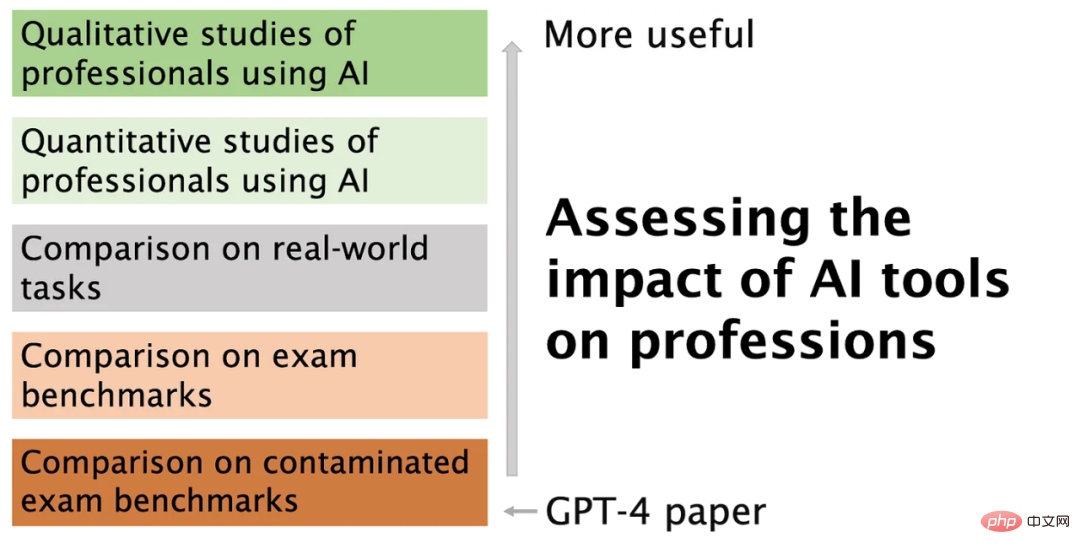

Im Bereich KI werden Benchmarks häufig zum Vergleich verschiedener Modelle verwendet. Diese Benchmarks wurden dafür kritisiert, dass sie mehrdimensionale Bewertungen in einer einzigen Zahl komprimieren. Wenn sie zum Vergleich von Menschen und Robotern herangezogen werden, sind die Ergebnisse falsche Informationen. Leider hat sich OpenAI bei der Bewertung von GPT-4 dafür entschieden, diese Art von Tests intensiv zu nutzen und hat nicht ausreichend versucht, das Kontaminationsproblem anzugehen.

Es gibt bessere Möglichkeiten, die Auswirkungen von KI-Modellen auf Karrieren zu bewerten

Menschen haben während der Arbeit Zugang zum Internet, nicht jedoch bei standardisierten Tests. Wenn also Sprachmodelle genauso gut funktionieren wie Profis mit Zugang zum Internet, ist dies ein besserer Test für ihre tatsächliche Leistung.

Aber das ist immer noch die falsche Frage. Anstatt eigenständige Benchmarks zu verwenden, sollten wir vielleicht messen, wie gut ein Sprachmodell alle realen Aufgaben erfüllen kann, die Profis ausführen müssen. Im akademischen Bereich stoßen wir beispielsweise häufig auf Aufsätze aus Bereichen, mit denen wir nicht vertraut sind und die voller Fachbegriffe sind. Es wäre hilfreich, wenn ChatGPT solche Aufsätze genau und verständlicher zusammenfassen könnte. Einige haben diese Tools sogar zur Peer-Review getestet. Aber selbst in diesem Szenario ist es für Sie schwierig sicherzustellen, dass die zum Testen verwendeten Fragen nicht im Trainingssatz enthalten sind.

Die Vorstellung, dass ChatGPT Profis ersetzen kann, ist noch weit hergeholt. Bei der Volkszählung von 1950 war nur einer von 270 Arbeitsplätzen durch Automatisierung verloren gegangen, nämlich der des Aufzugsführers. Im Moment müssen wir Fachkräfte bewerten, die KI-Tools nutzen, um ihre Arbeit zu erledigen. Zwei frühe Studien sind vielversprechend: eine zum Copiloten für die Programmierung von GitHub und die andere zur Schreibunterstützung von ChatGPT.

In diesem Stadium brauchen wir qualitative Forschung mehr als quantitative Forschung, weil die Tools so neu sind, dass wir nicht einmal wissen, welche quantitativen Fragen wir stellen sollen. Scott Guthrie von Microsoft meldet beispielsweise eine bemerkenswerte Zahl: 40 % des von GitHub Copilot-Benutzern überprüften Codes ist KI-generiert und unverändert. Aber jeder Programmierer wird Ihnen sagen, dass ein großer Teil Ihres Codes aus Vorlagen und anderer alltäglicher Logik besteht, die oft kopiert und eingefügt werden kann, insbesondere in Unternehmensanwendungen. Wenn Copilot dies automatisieren würde, wären die Produktivitätssteigerungen minimal.

Um es klarzustellen: Wir sagen nicht, dass Copilot nutzlos ist, sondern nur, dass bestehende Metriken ohne ein qualitatives Verständnis davon, wie Profis KI nutzen, bedeutungslos sind. Darüber hinaus besteht der Hauptvorteil der KI-gestützten Codierung möglicherweise nicht einmal in einer gesteigerten Produktivität.

Fazit

Das Bild unten fasst den Artikel zusammen und erklärt, warum und wie wir uns von den Metriken entfernen wollen, die OpenAI berichtet.

GPT-4 ist wirklich aufregend, es kann die Probleme von Fachleuten auf viele Arten lösen, beispielsweise durch Automatisierung, indem es einfache, risikoarme, aber mühsame Aufgaben für uns erledigt. Im Moment ist es wahrscheinlich besser, sich darauf zu konzentrieren, diese Vorteile zu erkennen und die vielen Risiken von Sprachmodellen zu mindern.

Das obige ist der detaillierte Inhalt vonKann GPT-4 überhaupt nicht programmiert werden? Jemand hat es zeigen lassen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen