Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

PromptPG: Wenn verstärkendes Lernen auf groß angelegte Sprachmodelle trifft

PromptPG: Wenn verstärkendes Lernen auf groß angelegte Sprachmodelle trifft

PromptPG: Wenn verstärkendes Lernen auf groß angelegte Sprachmodelle trifft

Mathematisches Denken ist eine Kernfähigkeit der menschlichen Intelligenz, aber abstraktes Denken und logisches Denken stellen immer noch eine große Herausforderung für Maschinen dar. Große vorab trainierte Sprachmodelle wie GPT-3 und GPT-4 haben erhebliche Fortschritte beim textbasierten mathematischen Denken (z. B. mathematische Wortprobleme) erzielt. Derzeit ist jedoch unklar, ob diese Modelle komplexere Probleme mit heterogenen Informationen wie Tabellendaten bewältigen können. Um diese Lücke zu schließen, haben Forscher der UCLA und des Allen Institute for Artificial Intelligence (AI2) Tabular Math Word Problems (TabMWP) ins Leben gerufen, einen Datensatz mit 38.431 Open-Domain-Problemen, die sowohl Text als auch mathematisches Denken an tabellarischen Daten erfordern, um das Richtige zu erhalten Antwort. Jede Frage in TabMWP ist mit einem Kontext verknüpft, der ein Bild, einen Text oder eine Tabelle in einem strukturierten Format enthält.

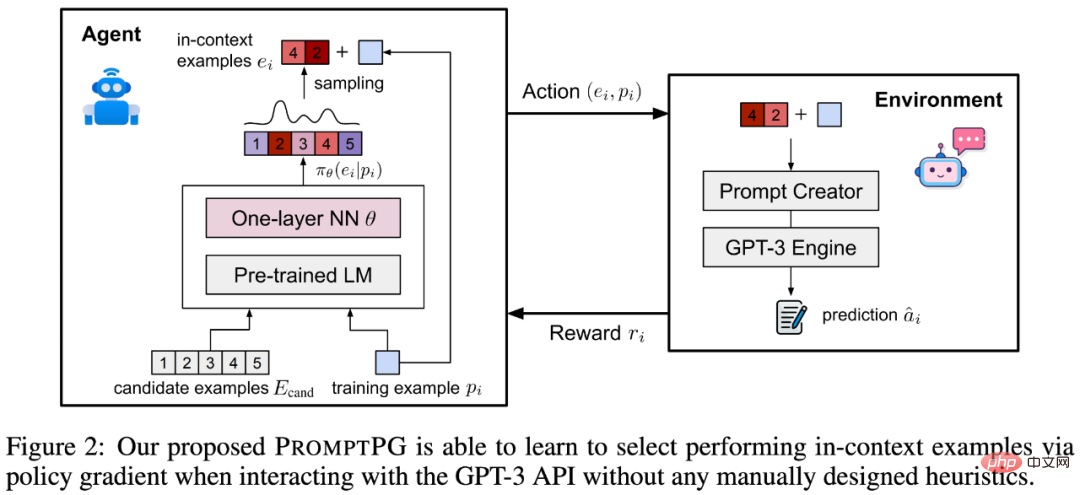

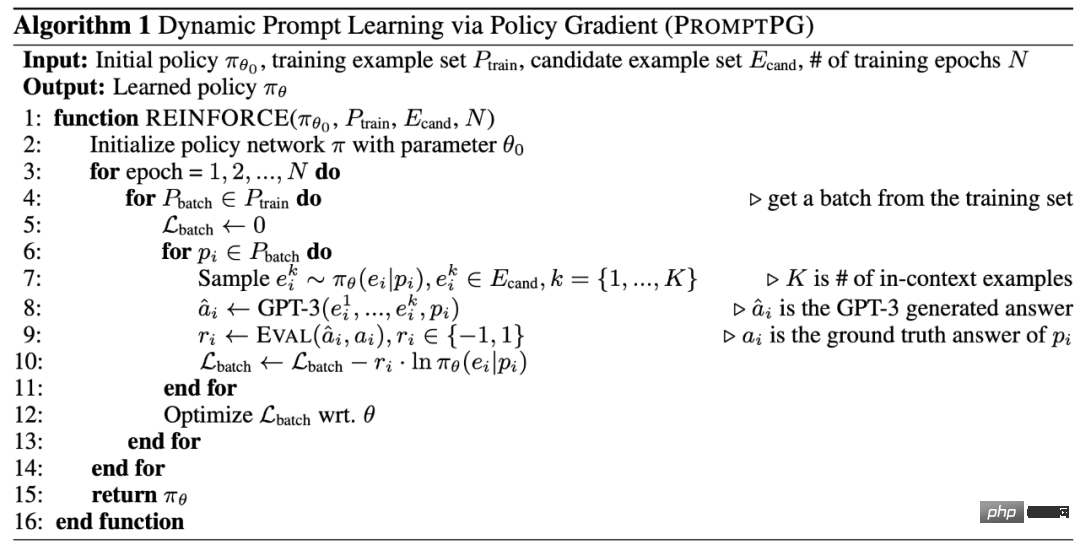

Forscher bewerteten verschiedene vorab trainierte Modelle, darunter Few-shot GPT-3 auf TabMWP. Wie bestehende Untersuchungen ergeben haben, verlässt sich Few-shot GPT-3 stark auf die Auswahl kontextbezogener Beispiele, was dazu führt, dass seine Leistung ziemlich instabil ist, wenn Beispiele zufällig ausgewählt werden. Diese Instabilität ist noch schwerwiegender, wenn es um komplexe Inferenzprobleme wie TabMWP geht. Um dieses Problem zu lösen, schlug der Autor die PromptPG-Methode vor, die die Auswahl von Beispielen in das kontextbezogene Bandit-Problem beim Verstärkungslernen umwandelt und Policy Gradient verwendet, um ein Richtliniennetzwerk zu trainieren, um zu lernen, aus einer kleinen Menge das Optimum auszuwählen Trainingsdaten. -Kontextbeispiel. Experimentelle Ergebnisse zeigen, dass ihre vorgeschlagene PromptPG-Methode die optimale Basislinie (Few-shot CoT GPT-3) bei der Beantwortung von Fragen um 5,31 % übertrifft und ihre Methode das Problem im Vergleich zu zufällig ausgewählten In-Context-Beispielen deutlich reduziert Stabilität dieser Art von Methode. ??

- Datenvisualisierung: https://promptpg.github.io/explore

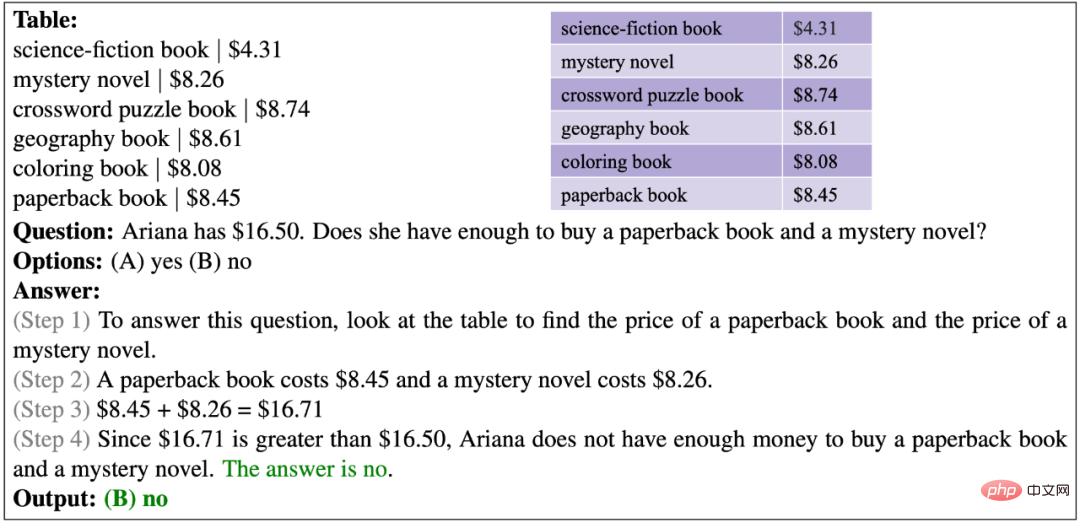

- 1. TabMWP-DatensatzDas Folgende ist aus Zwei Beispiele aus dem TabMWP-Datensatz. Bei der einen handelt es sich um eine Freitextfrage mit numerischen Antworten, bei der anderen um eine Multiple-Choice-Frage mit Textantworten. Wie Sie sehen, bietet jede Frage eine Lösung, die eine schrittweise Begründung beinhaltet. Um Probleme in TabMWP zu lösen, muss das System sowohl zur Tabellensuche als auch zum mehrstufigen mathematischen Denken fähig sein. Nehmen Sie das Beispiel im Bild unten: Um zu antworten: „Wie viel wird sie ausgeben (wenn Tracy drei Brotsorten kauft)“, müssen wir zuerst die entsprechenden Preise der drei Brotsorten in der Tabelle finden und dann die Kosten berechnen des Kaufpreises für jede Brotsorte und addieren Sie diese, um den Endpreis zu erhalten.

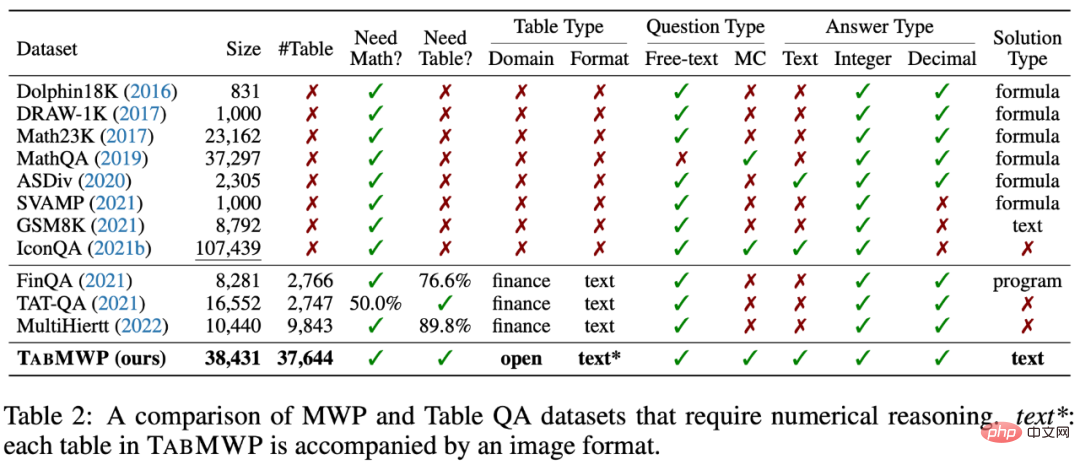

- Wie in den Statistiken in der Tabelle unten gezeigt, enthält der TabMWP-Datensatz 38.431 tabellarische Mathematikaufgaben. 74,7 % der Fragen waren Freitextfragen und 25,3 % waren Multiple-Choice-Fragen. TabMWP verfügt über insgesamt 28.876 einzigartige Fragen, 6.153 einzigartige Antworten und 35.442 einzigartige Lösungen, was auf die große Vielfalt der Fragenverteilung hinweist. Die durchschnittliche Länge der Fragen betrug 22,1 Wörter und die durchschnittliche Länge der Antworten 49,5 Wörter, was auf den lexikalischen Reichtum von TabMWP hinweist. Ein besonderes Merkmal von TabMWP ist, dass jedes Problem von einem Tabellenkontext begleitet wird, ohne den das Problem nicht gelöst werden kann. TabMWP verfügt über insgesamt 37.644 verschiedene Tabellen mit einer durchschnittlichen Tabellengröße von 5,9 Zeilen, 2,2 Spalten, 12,9 Zellen und maximal 54 Zellen. Diese Statistiken zeigen, dass auch die Tabellen in TabMWP reich an Vielfalt sind.

- Der TabMWP-Datensatz verfügt über zwei verschiedene Fragetypen und fünf verschiedene Antworttypen:

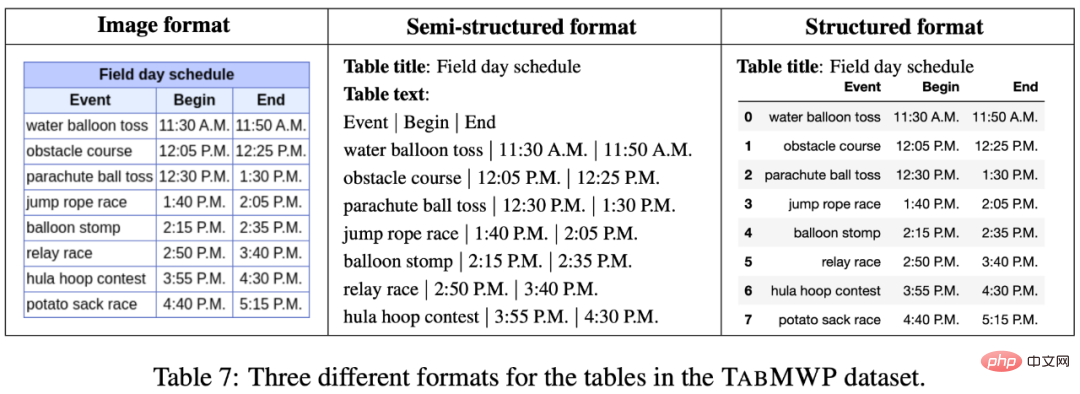

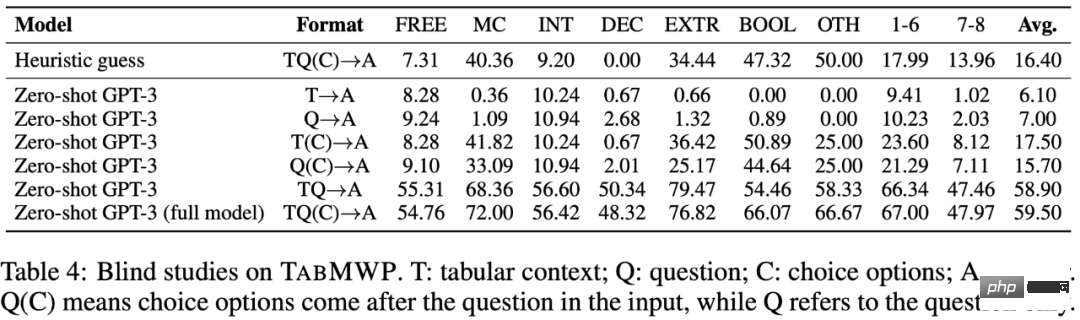

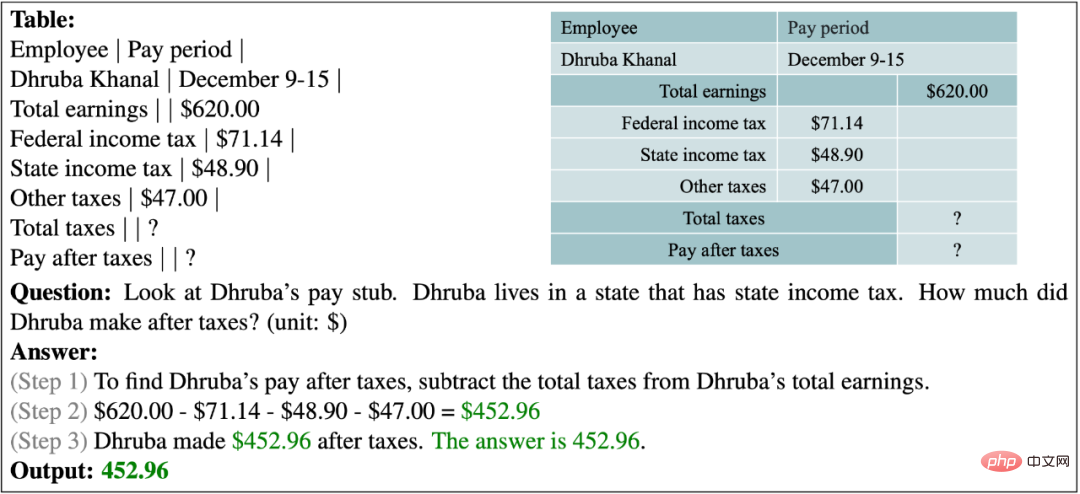

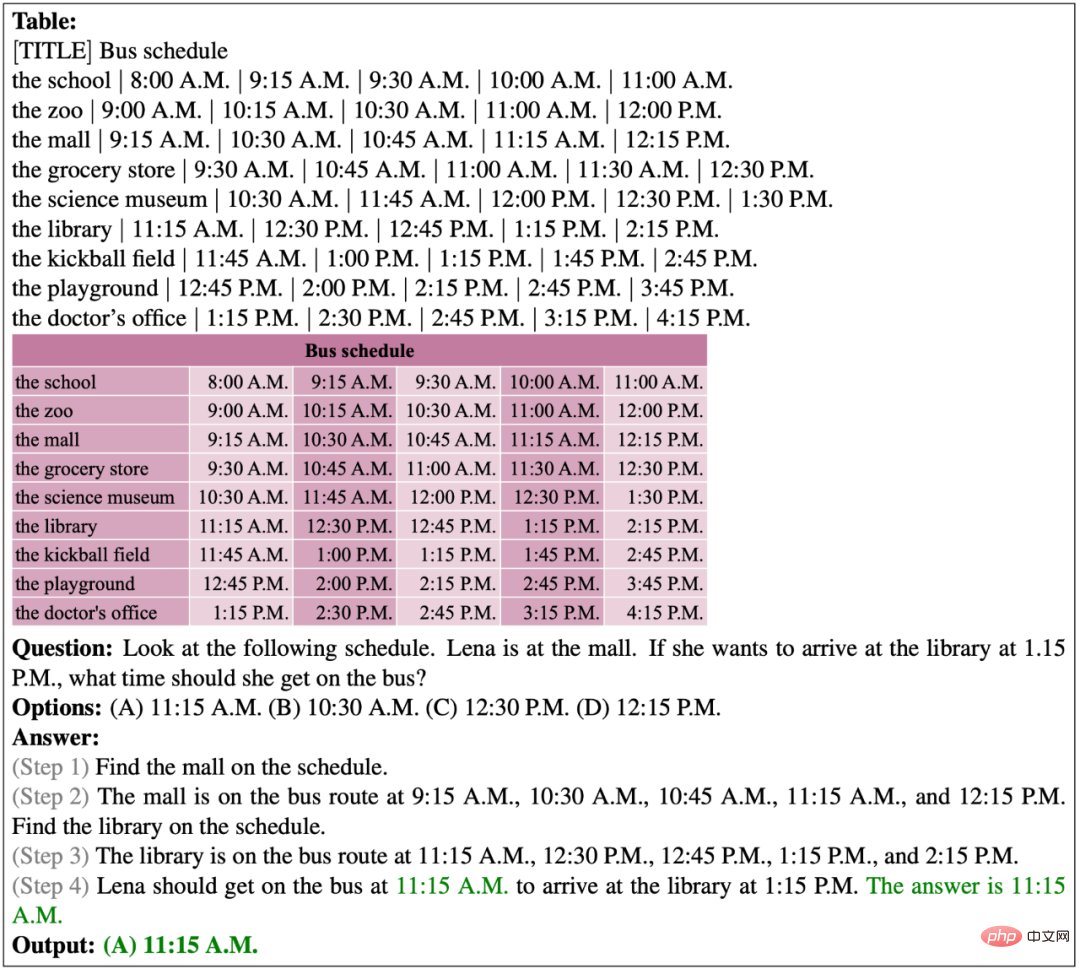

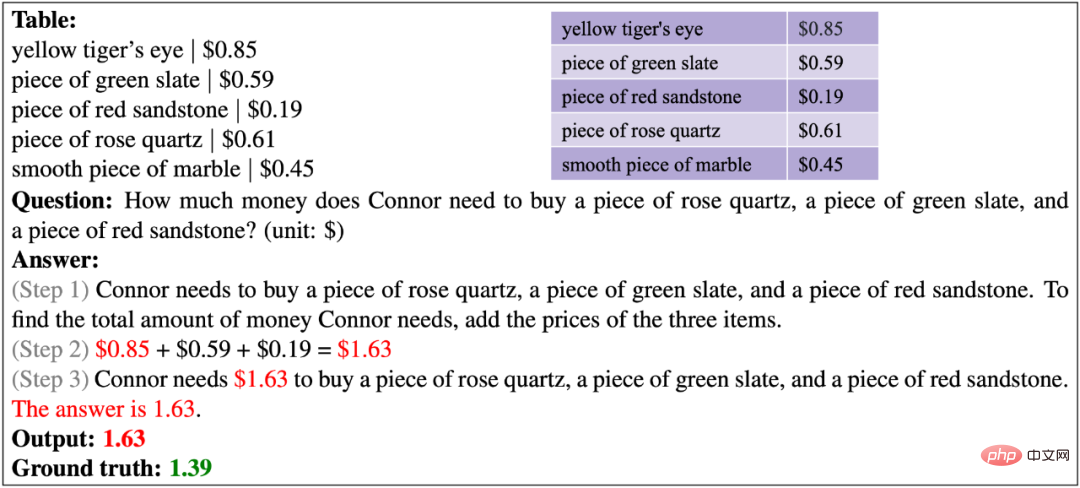

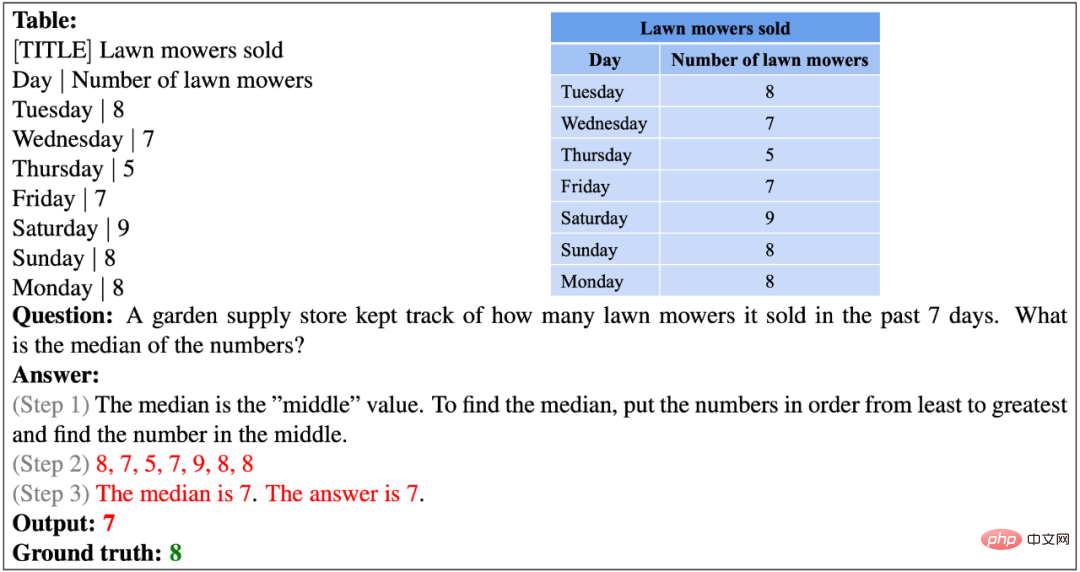

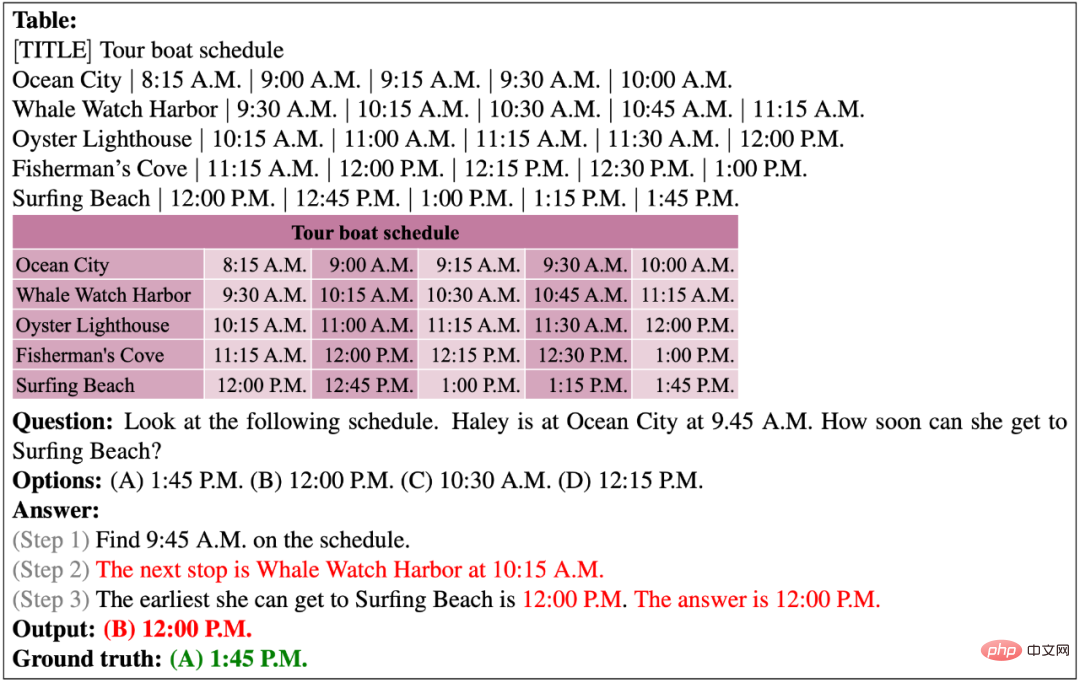

Jede Frage in TabMWP hat einen tabellarischen Kontext, der in drei Formaten dargestellt wird: Bild, halbstrukturierter Text und strukturiert. Dies eröffnet die Möglichkeit, verschiedene Arten von Inferenzmodellen zu entwickeln. Im Vergleich zu vorhandenen Datensätzen erfordert TabMWP sowohl Tabellenverständnis als auch mathematische Denkfähigkeiten, um Fragen zu beantworten. Darüber hinaus verfügt TabMWP über einen detaillierten mehrstufigen Argumentationsprozess für jede Frage, der offensichtliche Vorteile in Bezug auf Datensatzgröße, Tabellentyp, Fragetyp und Antworttyp bietet. Nach bestem Wissen dieses Artikels ist TabMWP der erste mathematische Argumentationsdatensatz im tabellarischen Open-Domain-Szenario. 2. PromptPG-Methode . Sie wählen zufällig einige kontextbezogene Beispiele aus dem Trainingssatz sowie Testbeispiele aus, um Eingabeaufforderungen zu erstellen, die GPT-3 dazu veranlassen, Antworten vorherzusagen. Jüngste Forschungsergebnisse zeigen jedoch, dass diese Art des Lernens mit wenigen Schüssen, die auf einer zufälligen Auswahl basiert, bei verschiedenen kontextuellen Beispielauswahlen sehr instabil sein kann. Bei komplexen Inferenzproblemen wie TabMWP, die Tabellen verschiedener Typen und Formate umfassen, ist die zufällige Auswahl möglicherweise noch weniger effektiv. . Wie in Abbildung 2 dargestellt, lernt das Richtliniennetzwerk, das beste Kontextbeispiel aus dem Kandidatenpool (Kandidatenbeispiele) zu finden, und sein Optimierungsziel besteht darin, die Vorhersage eines bestimmten Trainingsbeispiels (Trainingsbeispiels) bei der Interaktion mit dem GPT zu maximieren -3 Umweltpreis. Das Richtliniennetzwerk zur Auswahl von Beispielen ist ein BERT-Sprachmodell basierend auf festen Parametern und ein einschichtiges neuronales Netzwerk mit lernbaren Parametern. Nach Abschluss des Optimierungslernens kann PromptPG dynamisch verschiedene optimale Beispiele aus Kandidatenbeispielen für verschiedene Testfragen auswählen und so die Inferenzleistung von GPT-3 maximieren. Das Folgende ist der Lernalgorithmus von PromptPG. 3. Experimente und Analysen Es ist ersichtlich, dass TAPEX aufgrund des Vortrainings auf Tabellendaten mit ähnlichen Parametermengen eine bessere Leistung als UnifiedQA erbringt. Sowohl bei TAPEX als auch bei UnifiedQA kann die Erhöhung der Anzahl der Parameter im Modell die Genauigkeit der Vorhersagen verbessern. Darüber hinaus kann die Feinabstimmung des Modells auf TabMWP auch die Genauigkeit der Vorhersagen erheblich verbessern. Groß angelegtes Sprachmodell GPT-3 kann ohne Feinabstimmung eine ähnliche Genauigkeit wie die fein abgestimmten UnifiedQA- und TAPEX-Modelle erreichen (Zero-Shot GPT-3). Wenn das Few-Shot-GPT-3-Modell zufällig zwei kontextbezogene Beispiele als GPT-3-Hinweise auswählt, kann es im Vergleich zu Zero-Shot-GPT-3 eine weitere Verbesserung um 0,17 % erzielen. Indem Few-shot GPT-3 mehrere Zwischenschritte generieren ließ, bevor die endgültige Antwort generiert wurde (Few-shot-CoT GPT-3), konnten die Forscher ein optimales Basismodell mit einer Genauigkeit von 62,92 % erhalten. Im Gegensatz zur zufälligen Auswahl von Kontextbeispielen trainiert das in diesem Artikel vorgeschlagene PromptPG ein Richtliniennetzwerk über Policy Gradient, um geeignetere Kontextbeispiele auszuwählen, und erzielte die höchsten Vorhersageergebnisse (68,23 %) bei TabMWP und seine durchschnittliche Vorhersage Genauigkeit Die Rate übertrifft das beste Basismodell (Few-shot-CoT GPT-3) um 5,31 %. Insbesondere zeigt PromptPG seine Überlegenheit in der Vorhersagegenauigkeit für fast alle Fragetypen, Antworttypen und Frageschwierigkeiten. Trotzdem hat PromptPG gegenüber der menschlichen Leistung von 90,22 % noch viel Raum für Verbesserungen. Ablationsexperiment Tabelle 4 zeigt, dass alle Eingabeelemente von TabMWP (Fragetext, Tabelleninformationen, Optionsinformationen) entscheidend sind, um die Frage richtig zu beantworten. Nur mit allen Problemelementen als Eingabeinformationen erreichte Zero-shot GPT-3 seine relativ höchste durchschnittliche Vorhersagegenauigkeit (59,50 %). Unterschiedliche Beispielauswahl Als Vergleichsexperiment verglichen die Forscher auch andere Methoden mit unterschiedlicher Beispielauswahl. Wie in Tabelle 5 gezeigt, kann die Auswahl desselben Fragetyps oder Antworttyps wie bei der Testfrage dem Modell dabei helfen, relevantere Beispiele zu finden und die Genauigkeit der Antwort zu verbessern. Die Auswahl der komplexesten Beispiele führt nicht zu einer konsequenten Verbesserung der Antwortgenauigkeit. Eine feste Auswahl der beiden besten Beispiele unter den Kandidatenbeispielen kann die Genauigkeit leicht verbessern und die Varianz verringern. Durch Auswahl des Beispiels, das dem Testproblem semantisch am nächsten kommt, wird die Genauigkeit erreicht, die der PromptPG-Methode am nächsten kommt. Insgesamt hat PromptPG seine Vorteile bei der Verbesserung der Vorhersagegenauigkeit und der Reduzierung der Vorhersagevarianz voll unter Beweis gestellt. Die folgende Abbildung zeigt ein Beispiel für die PromptPG-Auswahl und das endgültige Vorhersageergebnis. Es ist ersichtlich, dass die PromptPG-Methode Beispiele mit ähnlichen mathematischen Fähigkeiten wie die Testfragen auswählen kann, wodurch die Inferenzleistung von Few-shot GPT-3 verbessert wird. Beispiel für eine erfolgreiche Vorhersage Das Folgende zeigt die richtige Antwort von PromptPG auf eine Freitextfrage. Bei dieser Frage müssen acht Zahlen in einer Tabelle addiert und dividiert werden, um den Durchschnitt zu ermitteln. Im folgenden Beispiel wird das Modell gebeten, einen Steuerbericht zu verstehen und das Gehalt nach Steuerabzügen zu berechnen. Das Folgende zeigt die korrekten Vorhersagen von PromptPG für Multiple-Choice-Fragen. Die angegebene Tabelle hat insgesamt 9 Zeilen und 6 Spalten. Das Modell findet die Zielzelle erfolgreich in der Tabelle und führt eine mehrstufige Inferenz durch, um die richtige Antwort vorherzusagen. Im folgenden Beispiel muss das Modell das Budget und die Gesamtkosten vergleichen, um zu überprüfen, ob Ariana über genügend Geld verfügt. Beispiel für einen Vorhersagefehler Das Folgende zeigt die falsche Vorhersage von PromptPG für ein Freitextproblem. Das Modell hat den falschen Preis für Rosenquarz ermittelt und dadurch die Gesamtkosten der drei Artikel falsch berechnet. Im folgenden Beispiel liefert die Frage eine abstrakte Stamm- und Blatttabelle. Das Modell war nicht in der Lage, diese domänenspezifische Tabelle zu verstehen und verfügte nicht über fortgeschrittene logische Argumentationsfähigkeiten, um falsche Antworten zu erhalten. Das folgende Beispiel zeigt, dass das bestehende Modell offenbar nicht in der Lage ist, Zahlen zu sortieren. Im folgenden Beispiel erscheint die Zeit, die genau mit der in der Frage genannten aktuellen Zeit übereinstimmt, nicht in der Tabelle, sodass das Modell die Abfahrtszeit der nächsten Haltestelle nicht genau lokalisieren kann. Im folgenden Beispiel ist es für das Modell schwierig, arithmetische Operationen für eine lange Zahlenreihe genau auszuführen. Der Autor schlug TabMWP vor, den ersten groß angelegten Datensatz zur Lösung mathematischer Probleme im tabellarischen Kontext. TabMWP enthält 38.431 offene Fragen, darunter zwei Fragetypen und fünf Antworttypen, wobei jede Frage mit einem mehrstufigen Lösungsprozess gekennzeichnet ist. Die Autoren verwendeten modernste QA- und TableQA-Methoden, führten umfassende Experimente zu TabMWP in vorab trainierten und fein abgestimmten Umgebungen durch und bewerteten sie mithilfe des großen vorab trainierten Sprachmodells GPT-3. Die Autoren schlagen außerdem eine neue Reinforcement-Learning-Methode vor, PromptPG, die Policy Gradient Learning nutzt, um optimale Instanzen aus den Trainingsdaten für die Eingabeaufforderung des GPT-3-Modells auszuwählen. Experimentelle Ergebnisse zeigen, dass PromptPG bestehende Basislinien deutlich übertrifft und die Leistungsinstabilität bei Vorhersagen im Vergleich zur Zufallsauswahl verringert.

Um dieses Problem zu lösen, schlägt der Autor eine verbesserte Methode vor:

Um dieses Problem zu lösen, schlägt der Autor eine verbesserte Methode vor: Promptes Lernen durch Policy Gradient, bei dem gelernt wird, kontextbezogene Beispiele aus einer kleinen Menge an Trainingsdaten auszuwählen, genannt PromptPG

PromptPG

4. Fazit und Ausblick

Das obige ist der detaillierte Inhalt vonPromptPG: Wenn verstärkendes Lernen auf groß angelegte Sprachmodelle trifft. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

In Debian -Systemen werden Readdir -Systemaufrufe zum Lesen des Verzeichnisinhalts verwendet. Wenn seine Leistung nicht gut ist, probieren Sie die folgende Optimierungsstrategie aus: Vereinfachen Sie die Anzahl der Verzeichnisdateien: Teilen Sie große Verzeichnisse so weit wie möglich in mehrere kleine Verzeichnisse auf und reduzieren Sie die Anzahl der gemäß Readdir -Anrufe verarbeiteten Elemente. Aktivieren Sie den Verzeichnis -Inhalt Caching: Erstellen Sie einen Cache -Mechanismus, aktualisieren Sie den Cache regelmäßig oder bei Änderungen des Verzeichnisinhalts und reduzieren Sie häufige Aufrufe an Readdir. Speicher -Caches (wie Memcached oder Redis) oder lokale Caches (wie Dateien oder Datenbanken) können berücksichtigt werden. Nehmen Sie eine effiziente Datenstruktur an: Wenn Sie das Verzeichnis -Traversal selbst implementieren, wählen Sie effizientere Datenstrukturen (z.

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

In diesem Artikel wird beschrieben, wie Sie die Protokollierungsstufe des Apacheweb -Servers im Debian -System anpassen. Durch Ändern der Konfigurationsdatei können Sie die ausführliche Ebene der von Apache aufgezeichneten Protokollinformationen steuern. Methode 1: Ändern Sie die Hauptkonfigurationsdatei, um die Konfigurationsdatei zu finden: Die Konfigurationsdatei von Apache2.x befindet sich normalerweise im Verzeichnis/etc/apache2/. Der Dateiname kann je nach Installationsmethode Apache2.conf oder httpd.conf sein. Konfigurationsdatei bearbeiten: Öffnen Sie die Konfigurationsdatei mit Stammberechtigungen mit einem Texteditor (z. B. Nano): Sudonano/etc/apache2/apache2.conf

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

In Debian -Systemen wird die Readdir -Funktion zum Lesen des Verzeichnisinhalts verwendet, aber die Reihenfolge, in der sie zurückgibt, ist nicht vordefiniert. Um Dateien in einem Verzeichnis zu sortieren, müssen Sie zuerst alle Dateien lesen und dann mit der QSORT -Funktion sortieren. Der folgende Code zeigt, wie Verzeichnisdateien mithilfe von Readdir und QSORT in Debian System sortiert werden:#include#include#include#include // benutzerdefinierte Vergleichsfunktion, verwendet für QSortIntCompare (constvoid*a, constvoid*b) {rettrcmp (*(*(*(

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

In Debian Systems ist OpenSSL eine wichtige Bibliothek für Verschlüsselung, Entschlüsselung und Zertifikatverwaltung. Um einen Mann-in-the-Middle-Angriff (MITM) zu verhindern, können folgende Maßnahmen ergriffen werden: Verwenden Sie HTTPS: Stellen Sie sicher, dass alle Netzwerkanforderungen das HTTPS-Protokoll anstelle von HTTP verwenden. HTTPS verwendet TLS (Transport Layer Security Protocol), um Kommunikationsdaten zu verschlüsseln, um sicherzustellen, dass die Daten während der Übertragung nicht gestohlen oder manipuliert werden. Überprüfen Sie das Serverzertifikat: Überprüfen Sie das Serverzertifikat im Client manuell, um sicherzustellen, dass es vertrauenswürdig ist. Der Server kann manuell durch die Delegate -Methode der URLSession überprüft werden

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Die Readdir -Funktion im Debian -System ist ein Systemaufruf, der zum Lesen des Verzeichnisgehalts verwendet wird und häufig in der C -Programmierung verwendet wird. In diesem Artikel wird erläutert, wie Readdir in andere Tools integriert wird, um seine Funktionalität zu verbessern. Methode 1: Kombinieren Sie C -Sprachprogramm und Pipeline zuerst ein C -Programm, um die Funktion der Readdir aufzurufen und das Ergebnis auszugeben:#include#include#includeIntmain (intargc, char*argv []) {Dir*Dir; structDirent*Eintrag; if (argc! = 2) {{

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wenn Sie Hadoop-Protokolle auf Debian verwalten, können Sie die folgenden Schritte und Best Practices befolgen: Protokollaggregation Aktivieren Sie die Protokollaggregation: Set Garn.log-Aggregation-Enable in true in der Datei marn-site.xml, um die Protokollaggregation zu aktivieren. Konfigurieren von Protokoll-Retentionsrichtlinien: Setzen Sie Garn.log-Aggregation.Retain-Sekunden, um die Retentionszeit des Protokolls zu definieren, z. B. 172800 Sekunden (2 Tage). Log Speicherpfad angeben: über Garn.n