Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Aufforderung zum Ausschneiden von Bildern mit einem Klick! Meta veröffentlicht das erste grundlegende Bildsegmentierungsmodell in der Geschichte und schafft damit ein neues Paradigma für den Lebenslauf

Aufforderung zum Ausschneiden von Bildern mit einem Klick! Meta veröffentlicht das erste grundlegende Bildsegmentierungsmodell in der Geschichte und schafft damit ein neues Paradigma für den Lebenslauf

Aufforderung zum Ausschneiden von Bildern mit einem Klick! Meta veröffentlicht das erste grundlegende Bildsegmentierungsmodell in der Geschichte und schafft damit ein neues Paradigma für den Lebenslauf

Gerade hat Meta AI das Segment Anything Model (SAM) veröffentlicht – das erste Basismodell für die Bildsegmentierung.

SAM kann mit einem Klick die Segmentierung jedes beliebigen Objekts aus Fotos oder Videos erreichen und ohne Stichproben zu anderen Aufgaben migrieren.

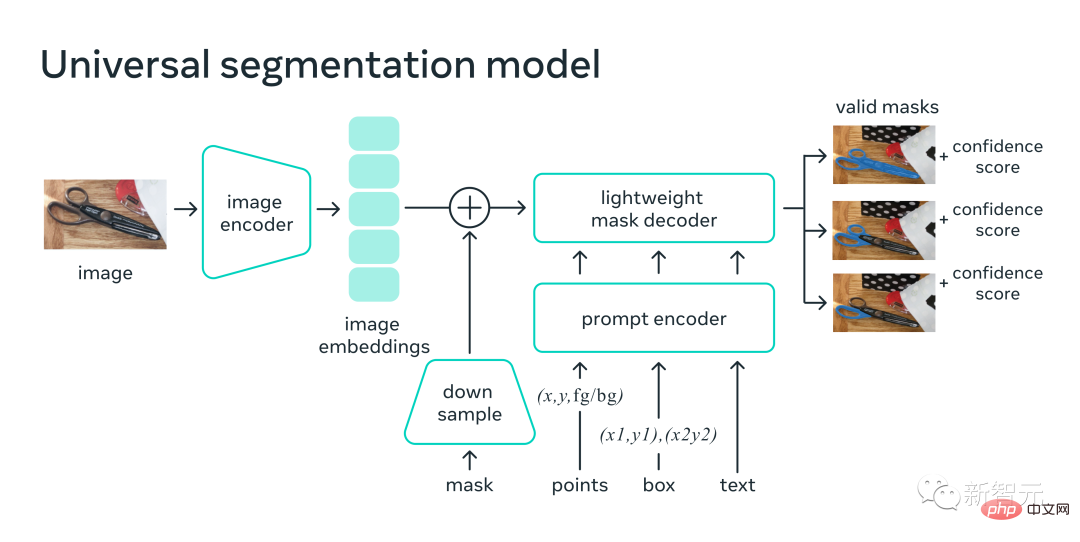

Insgesamt folgt SAM den Ideen des Grundmodells:

1. Eine sehr einfache, aber skalierbare Architektur, die multimodale Eingabeaufforderungen verarbeiten kann: Text, Schlüsselpunkte, Begrenzungsrahmen.

2. Intuitiver Annotationsprozess, eng verbunden mit dem Modelldesign.

3. Ein Datenschwungrad, das es ermöglicht, das Modell auf eine große Anzahl unbeschrifteter Bilder zu übertragen.

Und es ist keine Übertreibung zu sagen, dass SAM das allgemeine Konzept von „Objekten“ gelernt hat, selbst für unbekannte Objekte, unbekannte Szenen (wie unter Wasser und unter einem Mikroskop) und mehrdeutige Fälle.

Darüber hinaus kann SAM auch auf neue Aufgaben und neue Bereiche verallgemeinert werden, und Praktiker müssen das Modell nicht mehr selbst verfeinern.

Papieradresse: https://ai.facebook.com/research/publications/segment-anything/

Das Mächtigste ist, dass Meta ein völlig anderes Lebenslauf-Paradigma implementiert, Sie können es in einem einheitlichen Geben Sie im Framework-Prompt-Encoder einen Punkt, einen Begrenzungsrahmen und einen Satz an, um das Objekt mit einem Klick direkt zu segmentieren.

In diesem Zusammenhang sagte Jin Tian, Experte für KI-Algorithmen von Tencent: „Das Prompt-Paradigma im NLP-Bereich hat begonnen, sich auf den Lebenslaufbereich auszudehnen. Und dieses Mal könnte es das traditionelle Vorhersagedenken des Lebenslaufs völlig verändern. Diesmal.“ Sie können es wirklich tun. Verwenden Sie ein Modell, um jedes Objekt dynamisch zu segmentieren!

Der Lebenslauf existiert also wirklich nicht mehr?

SAM: „Schneiden“ Sie alle Objekte in jedem Bild mit einem Klick aus.

Segment Anything ist das erste Basismodell für die Bildsegmentierung.Segmentierung bezieht sich auf die Identifizierung, welche Bildpixel zu einem Objekt gehören und war schon immer eine Kernaufgabe der Computer Vision.

Wenn Sie jedoch ein genaues Segmentierungsmodell für eine bestimmte Aufgabe erstellen möchten, ist in der Regel hochspezialisierte Arbeit von Experten erforderlich. Dieser Prozess erfordert eine KI-Trainingsinfrastruktur und eine große Menge sorgfältig gekennzeichneter domäneninterner Daten, also den Schwellenwert ist extrem hoch.

Um dieses Problem zu lösen, schlug Meta ein Grundmodell für die Bildsegmentierung vor – SAM. Dieses auf verschiedenen Daten trainierte Hint-Modell ist nicht nur an eine Vielzahl von Aufgaben anpassbar, sondern funktioniert auch ähnlich wie Hinweise in NLP-Modellen.

Das SAM-Modell versteht das Konzept „Was ist ein Objekt“ und kann eine Maske für jedes Objekt in jedem Bild oder Video generieren, sogar für Objekte, die es während des Trainings nicht gesehen hat.

SAM ist so vielseitig, dass es eine Vielzahl von Anwendungsfällen abdeckt und ohne zusätzliche Schulung sofort in neuen Bildgebungsbereichen eingesetzt werden kann, egal ob es sich um Unterwasserfotos oder Zellmikroskopie handelt. Mit anderen Worten: SAM verfügt bereits über die Fähigkeit zur Zero-Sample-Migration.

Meta sagte aufgeregt im Blog: Es ist zu erwarten, dass SAM in Zukunft in jeder Anwendung verwendet wird, die Objekte in Bildern finden und segmentieren muss.

SAM kann Teil eines größeren KI-Systems werden, um ein allgemeineres multimodales Verständnis der Welt zu entwickeln, beispielsweise das Verständnis des visuellen und textlichen Inhalts von Webseiten.

Im Bereich AR/VR kann SAM Objekte basierend auf der Sichtlinie des Benutzers auswählen und die Objekte dann auf 3D „aufrüsten“.

Für Inhaltsersteller kann SAM Bildbereiche für Collagen oder Videobearbeitung extrahieren.

SAM kann auch Tiere oder Objekte in Videos lokalisieren und verfolgen und so die naturwissenschaftliche und astronomische Forschung unterstützen.

Universelle Segmentierungsmethode

In der Vergangenheit gab es zwei Möglichkeiten, das Segmentierungsproblem zu lösen.

Eine davon ist die interaktive Segmentierung, die Objekte jeder Kategorie segmentieren kann, aber eine Feinabstimmung der Maske durch Iteration erfordert.

Die zweite ist die automatische Segmentierung, mit der bestimmte im Voraus definierte Objekte segmentiert werden können. Der Trainingsprozess erfordert jedoch eine große Menge manueller Anmerkungen zu Objekten (um beispielsweise eine Katze zu segmentieren, sind Tausende von Beispielen erforderlich).

Kurz gesagt, keine dieser beiden Methoden kann eine universelle, vollautomatische Segmentierungsmethode bereitstellen.

Und SAM kann als Verallgemeinerung dieser beiden Methoden angesehen werden und kann problemlos eine interaktive Segmentierung und eine automatische Segmentierung durchführen.

Auf der Eingabeaufforderungsschnittstelle des Modells können zahlreiche Segmentierungsaufgaben ausgeführt werden, indem einfach die richtigen Eingabeaufforderungen (Klicks, Kästchen, Text usw.) für das Modell entworfen werden.

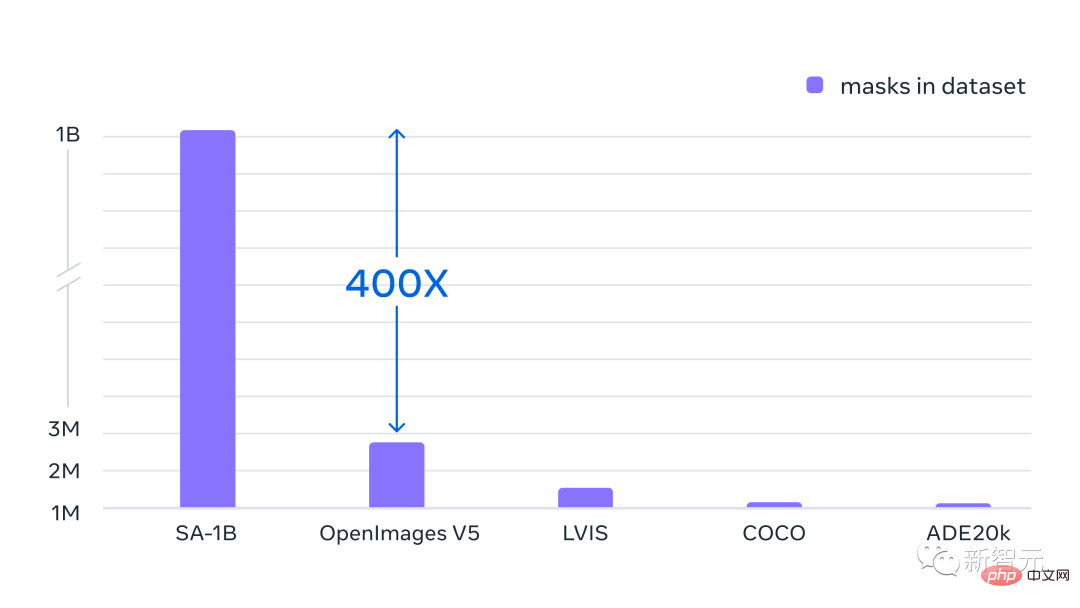

Darüber hinaus wird SAM anhand eines vielfältigen, hochwertigen Datensatzes mit über 1 Milliarde Masken trainiert, sodass das Modell auf neue Objekte und Bilder verallgemeinern kann, die über das hinausgehen, was es während des Trainings beobachtet hat. Dadurch müssen Praktiker nicht mehr ihre eigenen Segmentierungsdaten sammeln, um Modelle für Anwendungsfälle zu verfeinern.

Diese Art von Flexibilität, die auf neue Aufgaben und neue Bereiche übertragen werden kann, ist das erste Mal im Bereich der Bildsegmentierung.

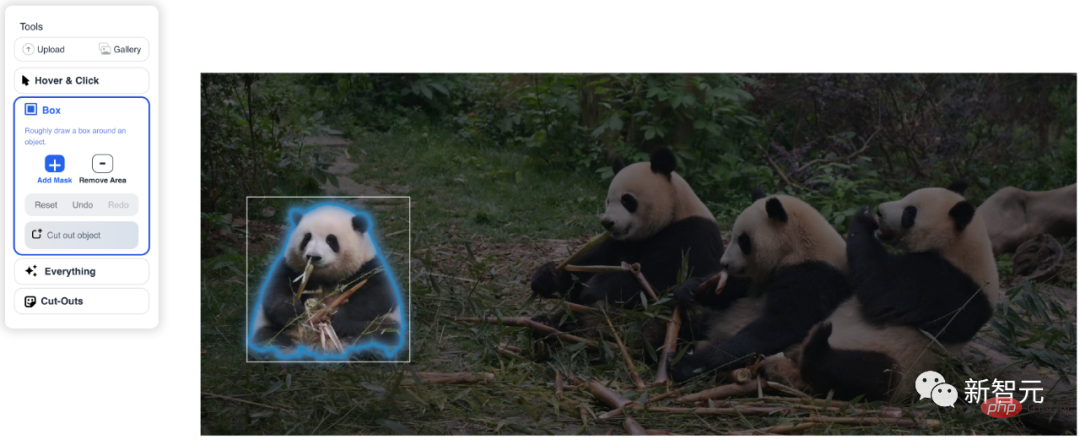

(1) Mit SAM können Benutzer Objekte mit einem einzigen Klick segmentieren oder interaktiv auf viele Punkte klicken und außerdem Bounding-Box-Hinweise für das Modell verwenden.

(2) Angesichts der Mehrdeutigkeit segmentierter Objekte kann SAM mehrere gültige Masken ausgeben, was eine wesentliche Fähigkeit zur Lösung von Segmentierungsproblemen in der realen Welt darstellt.

(3) SAM kann alle Objekte im Bild automatisch erkennen und blockieren. (4) Nach der Vorberechnung der Bildeinbettungen kann SAM in Echtzeit Segmentierungsmasken für jede Eingabeaufforderung generieren, sodass Benutzer in Echtzeit mit dem Modell interagieren können.

Wie es funktioniert

Der von den Forschern trainierte SAM kann für jede Eingabeaufforderung gültige Segmentierungsmasken zurückgeben. Hinweise können Vordergrund-/Hintergrundpunkte, grobe Kästchen oder Masken, Freiformtext oder allgemein alle Informationen sein, die darauf hinweisen, dass eine Segmentierung im Bild erforderlich ist.

Die Anforderung einer gültigen Maske bedeutet lediglich, dass die Ausgabe auch in Fällen erfolgen sollte, in denen der Hinweis mehrdeutig ist und sich auf mehrere Objekte beziehen kann (z. B. kann ein Punkt auf einem Hemd ein Hemd oder eine Person darstellen, die ein Hemd trägt). Eines dieser Objekte ist eine vernünftige Maske.

Forscher beobachteten, dass Aufgaben vor dem Training und interaktive Datenerfassung dem Modelldesign spezifische Einschränkungen auferlegen.

Insbesondere muss das Modell in Echtzeit auf der CPU in einem Webbrowser ausgeführt werden, damit das Standardpersonal effizient und in Echtzeit mit SAM für Anmerkungen interagieren kann.

Obwohl Laufzeitbeschränkungen einen Kompromiss zwischen Qualität und Laufzeit bedeuten, stellten die Forscher fest, dass in der Praxis mit einfachen Designs gute Ergebnisse erzielt werden können. Der Bildencoder von

SAM erzeugt einmalige Einbettungen für Bilder, während der leichtgewichtige Decoder alle Hinweise im Handumdrehen in Vektoreinbettungen umwandelt. Diese beiden Informationsquellen werden dann in einem leichtgewichtigen Decoder kombiniert, der Segmentierungsmasken vorhersagt.

Nach der Berechnung der Bildeinbettung kann SAM in nur 50 Millisekunden ein Bildstück generieren und eine beliebige Eingabeaufforderung im Webbrowser ausgeben.

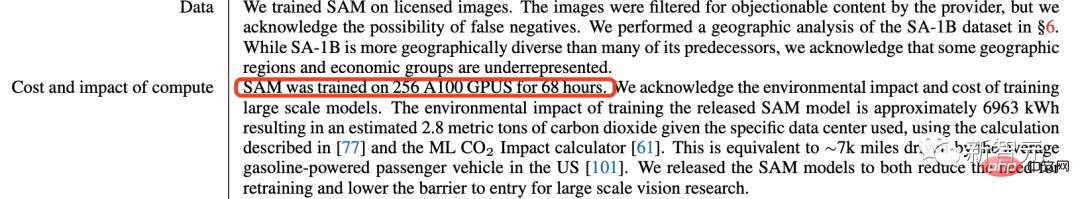

Das neueste SAM-Modell wurde 68 Stunden lang (fast 5 Tage) auf 256 A100-Bildern trainiert.

Projektdemonstration

Mehrere Eingabeaufforderungen

Mit Eingabeaufforderungen zur Angabe des im Bild zu segmentierenden Inhalts können verschiedene Segmentierungsaufgaben ohne zusätzliche Schulung gelöst werden.

Verwenden Sie interaktive Punkte und Kästchen als Eingabeaufforderungen

Eingabeaufforderungsdesign

SAM kann Eingabeaufforderungen von anderen Systemen akzeptieren.

Wählen Sie beispielsweise das entsprechende Objekt basierend auf den visuellen Fokusinformationen des Benutzers aus dem AR/VR-Headset aus. Metas Entwicklung einer KI, die die reale Welt verstehen kann, wird den Weg für seine zukünftige Metaversum-Reise ebnen.

Alternativ können Sie die Text-zu-Objekt-Segmentierung mithilfe von Begrenzungsrahmenhinweisen aus dem Objektdetektor implementieren.

Skalierbare Ausgabe

Ausgabemasken können als Eingabe für andere KI-Systeme verwendet werden.

Zum Beispiel kann die Maske eines Objekts in einem Video verfolgt, durch Bildbearbeitungsanwendungen in 3D umgewandelt oder für kreative Aufgaben wie Collagen verwendet werden.

Zum Beispiel kann die Maske eines Objekts in einem Video verfolgt, durch Bildbearbeitungsanwendungen in 3D umgewandelt oder für kreative Aufgaben wie Collagen verwendet werden.

Zero-Shot-Generalisierung

SAM lernt eine allgemeine Vorstellung davon, was ein Objekt ist – dieses Verständnis ermöglicht es, Zero-Shot-Verallgemeinerungen auf unbekannte Objekte und Bilder vorzunehmen, ohne zusätzliche Schulung ist erforderlich.

Verschiedene Bewertungen

Verschiedene Bewertungen

In der Box-Funktion einfach das Kästchen auswählen und die Erkennung wird sofort abgeschlossen.

Nachdem Sie auf Alles geklickt haben, werden alle vom System erkannten Objekte sofort extrahiert.

Nachdem Sie sich für Cut-Outs entschieden haben, erhalten Sie in Sekundenschnelle einen dreieckigen Knödel.

SA-1B-Datensatz: 11 Millionen Bilder, 1,1 Milliarden Masken

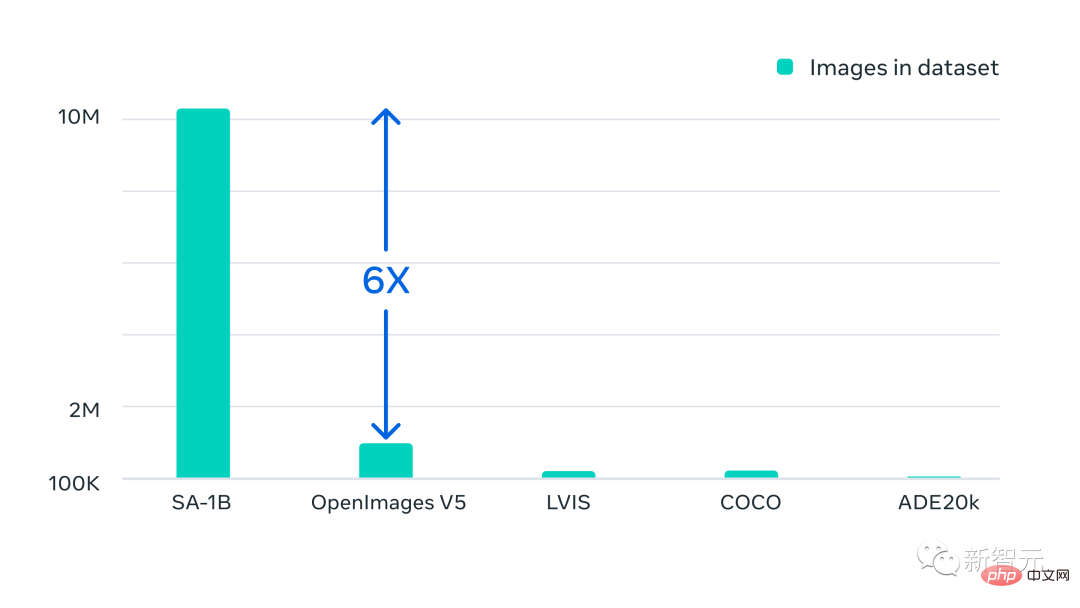

Zusätzlich zu den neuen Modellen veröffentlichte Meta auch SA-1B, den bislang größten Segmentierungsdatensatz.

Dieser Datensatz besteht aus 11 Millionen vielfältigen, hochauflösenden, die Privatsphäre schützenden Bildern und 1,1 Milliarden hochwertigen Segmentierungsmasken.

Die Gesamteigenschaften des Datensatzes sind wie folgt:

· Gesamtzahl der Bilder: 11 Millionen

· Gesamtzahl der Masken: 1,1 Milliarden

· Durchschnittliche Maske pro Bild: 100

· Durchschnittliche Bildauflösung: 1500 × 2250 Pixel

HINWEIS: Bild- oder Maskenanmerkungen haben keine Klassenbezeichnungen

Meta betont, dass diese Daten über unsere Daten-Engine erfasst werden und alle Masken vollständig von SAM generiert werden Automatisch generiert.

Mit dem SAM-Modell ist das Sammeln neuer Segmentierungsmasken schneller als je zuvor und das interaktive Kommentieren einer Maske dauert nur etwa 14 Sekunden.

Der Annotationsprozess pro Maske ist nur zweimal langsamer als das Annotieren von Begrenzungsrahmen. Mit der schnellsten Annotationsschnittstelle dauert das Annotieren von Begrenzungsrahmen etwa 7 Sekunden.

SAM-Modell COCOs vollständig manuelle, auf Polygonen basierende Maskenannotation ist 6,5-mal schneller als frühere umfangreiche Segmentierungsdatenerfassungsbemühungen und 2-mal schneller als die bisher größte Datenannotationsbemühung (ebenfalls modellgestützt).

Der Einsatz interaktiver Anmerkungsmasken reicht jedoch nicht aus, um mehr als 1 Milliarde maskierte Datensätze zu erstellen. Aus diesem Grund hat Meta eine Daten-Engine zum Erstellen von SA-1B-Datensätzen entwickelt.

Diese Daten-Engine verfügt über drei „Gänge“:

1. Modellhilfsanmerkung

2 Die Mischung aus vollautomatischer Annotation und Hilfsannotation trägt dazu bei, die Vielfalt der gesammelten Masken zu erhöhen

3 . Vollautomatische Maskenerstellung, die die Skalierbarkeit von Datensätzen ermöglicht

Unser endgültiger Datensatz umfasst über 1,1 Milliarden Segmentierungsmasken, die auf etwa 11 Millionen autorisierten und die Privatsphäre schützenden Bildern gesammelt wurden.

SA-1B verfügt über 400x mehr Masken als jeder vorhandene Segmentierungsdatensatz. Und menschliche Auswertungsstudien bestätigen, dass die Masken von hoher Qualität und Vielfalt sind und in einigen Fällen sogar qualitativ mit früheren Masken aus kleineren, vollständig manuell annotierten Datensätzen vergleichbar sind.

Bilder des SA-1B wurden von Fotoanbietern aus mehreren Ländern erhalten, die sich über verschiedene geografische Gebiete und Einkommensniveaus erstrecken.

Während einige geografische Regionen immer noch unterrepräsentiert sind, verfügt SA-1B über mehr Bilder und eine bessere Gesamtdarstellung in allen Regionen als frühere Segmentierungsdatensätze.

Abschließend hofft Meta, dass diese Daten die Grundlage für neue Datensätze bilden können, die zusätzliche Anmerkungen enthalten, beispielsweise Textbeschreibungen, die jeder Maske zugeordnet sind. „RBG-Meister leitet das Team“ Ross Girshick „ Computer Vision und maschinelles Lernen.

Im Jahr 2012 erhielt Ross Girshick seinen Doktortitel in Informatik an der University of Chicago unter der Leitung von Pedro Felzenszwalb.Bevor er zu FAIR kam, war Ross Forscher bei Microsoft Research und Postdoc an der University of California, Berkeley, wo seine Mentoren Jitendra Malik und Trevor Darrell waren.

Er erhielt 2017 den PAMI Young Researcher Award, 2017 und 2021 den PAMI Mark Everingham Award als Anerkennung für seine Beiträge zu Open-Source-Software.

Netizen: Lebenslauf existiert wirklich nicht mehr

Meta hat dieses grundlegende Segmentierungsmodell im Lebenslaufbereich erstellt, was viele Internetnutzer zum Schreien brachte: „Jetzt existiert der Lebenslauf wirklich nicht mehr.“

Meta-Wissenschaftler Justin Johnson sagte: „Für mich stellen die Daten-Engine von Segment Anything und ChatGPTs RLHF eine neue Ära der groß angelegten künstlichen Intelligenz dar, anstatt alles aus verrauschten Netzwerkdaten zu lernen, können wir menschliche Annotationen geschickt in Kombination mit Big Data anwenden.“ Neue Funktionen freigeben. Beaufsichtigtes Lernen ist zurück!

Freund „Matrix Mingzi“ sagte, dass dieser Artikel ein weiterer Beweis dafür sei, dass Multimodalität die Zukunft des Lebenslaufs sei und reiner Lebenslauf kein Morgen habe.

Das obige ist der detaillierte Inhalt vonAufforderung zum Ausschneiden von Bildern mit einem Klick! Meta veröffentlicht das erste grundlegende Bildsegmentierungsmodell in der Geschichte und schafft damit ein neues Paradigma für den Lebenslauf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist ein Vorschlag zur Änderung des Aave -Protokoll -Tokens und zur Einführung von Token -Repos, die ein Quorum für Aavedao implementiert hat. Marc Zeller, Gründer der AAVE -Projektkette (ACI), kündigte dies auf X an und stellte fest, dass sie eine neue Ära für die Vereinbarung markiert. Marc Zeller, Gründer der Aave Chain Initiative (ACI), kündigte auf X an, dass der Aavenomics -Vorschlag das Modifizieren des Aave -Protokoll -Tokens und die Einführung von Token -Repos umfasst, hat ein Quorum für Aavedao erreicht. Laut Zeller ist dies eine neue Ära für die Vereinbarung. AVEDAO -Mitglieder stimmten überwiegend für die Unterstützung des Vorschlags, der am Mittwoch 100 pro Woche betrug

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.

Was sind die Hybrid -Blockchain -Handelsplattformen?

Apr 21, 2025 pm 11:36 PM

Was sind die Hybrid -Blockchain -Handelsplattformen?

Apr 21, 2025 pm 11:36 PM

Vorschläge für die Auswahl eines Kryptowährungsaustauschs: 1. Für die Liquiditätsanforderungen ist Priorität Binance, Gate.io oder OKX aufgrund seiner Bestelltiefe und der starken Volatilitätsbeständigkeit. 2. Compliance and Security, Coinbase, Kraken und Gemini haben strenge regulatorische Bestätigung. 3. Innovative Funktionen, Kucoins sanftes Stakel und Derivatdesign von Bitbit eignen sich für fortschrittliche Benutzer.

Die zehn Top-Empfehlungen zur Plattform für Echtzeitdaten auf den Währungskreismärkten werden veröffentlicht

Apr 22, 2025 am 08:12 AM

Die zehn Top-Empfehlungen zur Plattform für Echtzeitdaten auf den Währungskreismärkten werden veröffentlicht

Apr 22, 2025 am 08:12 AM

Zu den für Anfängern geeigneten Kryptowährungsdatenplattformen gehören CoinMarketCap und nicht-kleine Trompete. 1. CoinmarketCap bietet globale Rangliste für den Preis, den Marktwert und der Handelsvolumen für Anfänger für Anfänger und Grundanalyse. 2. Das nichtklammernde Angebot bietet eine chinesisch-freundliche Schnittstelle, die chinesischen Benutzern geeignet ist, um potenzielle Projekte mit geringem Risiko schnell zu untersuchen.

Rexas Finance (RXS) kann Solana (SOL), Cardano (ADA), XRP und Dogecoin (Doge) im Jahr 2025 übertreffen

Apr 21, 2025 pm 02:30 PM

Rexas Finance (RXS) kann Solana (SOL), Cardano (ADA), XRP und Dogecoin (Doge) im Jahr 2025 übertreffen

Apr 21, 2025 pm 02:30 PM

Auf dem volatilen Kryptowährungsmarkt suchen Anleger nach Alternativen, die über die beliebten Währungen hinausgehen. Obwohl bekannte Kryptowährungen wie Solana (SOL), Cardano (ADA), XRP und Doge (DOGE) auch Herausforderungen wie Marktgefühle, regulatorische Unsicherheit und Skalierbarkeit gegenübersehen. Ein neues aufstrebendes Projekt, Rexasfinance (RXS), entsteht jedoch. Es stützt sich nicht auf Prominenteffekte oder Hype, sondern konzentriert sich auf die Kombination der realen Vermögenswerte (RWA) mit Blockchain-Technologie, um den Anlegern eine innovative Möglichkeit zum Investieren zu bieten. Diese Strategie hofft, eines der erfolgreichsten Projekte von 2025 zu sein. Rexasfi