Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

LeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf

LeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf

LeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf

Das Aufkommen von GPT-4 hat vielen Menschen Sorgen um ihre wissenschaftliche Forschung gemacht und sogar gescherzt, dass es kein NLP gibt.

Anstatt sich Sorgen zu machen, ist es besser, es in der wissenschaftlichen Forschung zu verwenden, einfach „die Rollmethode ändern“.

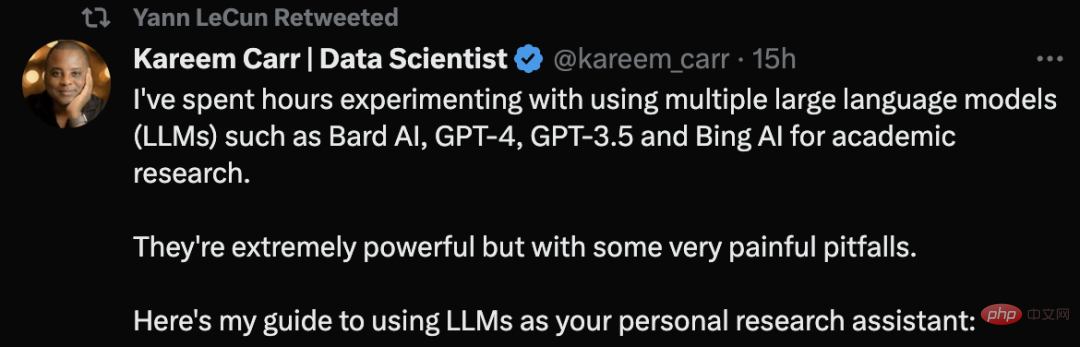

Kareem Carr, ein Doktor der Biostatistik an der Harvard University, sagte, dass er große Sprachmodelltools wie GPT-4 für die Durchführung akademischer Forschung verwendet habe.

Er sagte, dass diese Werkzeuge sehr mächtig seien, aber auch einige sehr schmerzhafte Fallstricke hätten.

Sein Tweet über Ratschläge zur LLM-Nutzung erhielt sogar eine Empfehlung von LeCun.

Werfen wir einen Blick darauf, wie Kareem Carr KI-Tools für die wissenschaftliche Forschung einsetzt.

Das erste Prinzip: Suchen Sie nicht nach LLM für Inhalte, die Sie nicht überprüfen können

Zu Beginn gab Carr das erste und wichtigste Prinzip an:

Verlangen Sie niemals nach einem großen Sprachmodell (LLM) Fordern Sie Informationen an, die Sie selbst nicht überprüfen können, oder bitten Sie es, eine Aufgabe auszuführen, von der Sie nicht überprüfen können, dass sie korrekt abgeschlossen wurde.

Die einzige Ausnahme ist, wenn es sich nicht um eine kritische Aufgabe handelt, wie z. B. LLM nach Ideen für die Wohnungsdekoration zu fragen.

"Fassen Sie unter Verwendung der Best Practices der Literaturrecherche die Forschung zur Brustkrebsforschung in den letzten 10 Jahren zusammen." Dies ist eine schlechte Anfrage, da Sie nicht direkt überprüfen können, ob die Literatur richtig zusammengefasst ist.

Fragen Sie stattdessen: „Geben Sie mir eine Liste der besten Übersichtsartikel zur Brustkrebsforschung der letzten 10 Jahre.“

Tipps wie dieser überprüfen nicht nur die Quelle, sondern Sie können auch die Zuverlässigkeit selbst überprüfen.

Tipps zum Schreiben von „Eingabeaufforderungen“

Es ist sehr einfach, einen LLM zu bitten, den Code für Sie zu schreiben oder relevante Informationen zu finden, aber die Qualität des Ausgabeinhalts kann stark variieren. Hier sind einige Dinge, die Sie tun können, um die Qualität zu verbessern:

Legen Sie den Kontext fest:

• Teilen Sie dem LLM klar mit, welche Informationen verwendet werden sollen

• Verwenden Sie Terminologie und Notation um das LLM schräg zu machen. Korrekte Kontextinformationen

Wenn Sie eine Idee haben, wie mit der Anfrage umgegangen werden soll, teilen Sie LLM bitte die spezifische Methode mit, die verwendet werden soll. Beispielsweise sollte „Diese Ungleichung lösen“ geändert werden in „Verwenden Sie den Cauchy-Schwarz-Satz, um diese Ungleichung zu lösen, und wenden Sie dann das vollständige Quadrat an.“

Wissen Sie, dass diese Sprachmodelle sprachlich komplexer sind, als Sie denken, und selbst sehr vage Hinweise helfen.

Seien Sie konkret und konkret:

Dies ist keine Google-Suche, also machen Sie sich keine Sorgen, wenn es eine Website gibt, auf der Ihr genaues Problem besprochen wird.

„Wie löst man die simultanen Gleichungen quadratischer Terme?“ Diese Eingabeaufforderung ist nicht klar: „Lösen Sie x=(1/2)(a+b) und y=(1/“. 3) (a^2+ab+b^2) Ein Gleichungssystem über a und b.“

Ausgabeformat definieren:

Nutzen Sie die Flexibilität von LLMs, um die Ausgabe so zu formatieren, wie es für Sie am besten funktioniert, wie zum Beispiel: Mathematikformeln

• Artikel

• Tutorials

• Einfache Anleitung

Sie können sogar nach dem Code fragen, der Tabellen, Zeichnungen und Diagramme generiert.

Obwohl Sie die Inhalte von LLM erhalten, ist dies nur der Anfang. Weil Sie den Ausgabeinhalt überprüfen müssen. Dazu gehört:

• Inkonsistenzen erkennen

• Die Begriffe des Inhalts über die Google-Suchtools ausgeben und unterstützende Quellen beschaffen

• Wo möglich, Code-Selbsttests schreiben

Der Grund, warum eine Selbstverifizierung erforderlich ist, liegt darin, dass LLMs oft seltsame Fehler machen, die nicht mit ihrer scheinbaren Professionalität vereinbar sind. Beispielsweise erwähnt der LLM möglicherweise ein sehr fortgeschrittenes mathematisches Konzept, ist aber bei einem einfachen Algebraproblem verwirrt.

Fragen Sie noch einmal:

Der von großen Sprachmodellen generierte Inhalt ist zufällig. Manchmal erhalten Sie möglicherweise eine bessere Antwort, wenn Sie ein neues Fenster erstellen und Ihre Frage erneut stellen.

Verwenden Sie außerdem mehrere LLM-Tools. Kareem Carr nutzt derzeit Bing AI, GPT-4, GPT-3.5 und Bard AI in der wissenschaftlichen Forschung entsprechend seinen eigenen Bedürfnissen. Sie haben jedoch jeweils ihre eigenen Vor- und Nachteile. „Zitate + Produktivität“ Bing AI funktioniert bei Websuchen. GPT-4 ist viel intelligenter als GPT-3.5, aber derzeit ist OpenAI auf 25 Nachrichten in 3 Stunden beschränkt, was den Zugriff erschwert.

Was das Thema Zitieren betrifft, so ist die Zitierung von Referenzen eine besondere Schwachstelle des LLM. Manchmal existieren die Referenzen, die LLM Ihnen gibt, manchmal nicht.

Zuvor war ein Internetnutzer auf das gleiche Problem gestoßen. Er sagte, er habe ChatGPT gebeten, Referenzmaterialien zu den mathematischen Eigenschaften von Listen bereitzustellen, aber ChatGPT habe Referenzen generiert, die nicht existierten, was jeder als „Halluzinationsproblem“ bezeichnet .

Kareem Carr weist jedoch darauf hin, dass falsche Zitate nicht völlig nutzlos sind.

Nach seiner Erfahrung beziehen sich die Wörter in erfundenen Referenzen oft auf reale Begriffe, ebenso wie Forscher in verwandten Bereichen. Wenn Sie also nach diesen Begriffen googeln, kommen Sie der gesuchten Information oft näher.

Außerdem ist Bing auch bei der Quellensuche eine gute Wahl.

Produktivität

Es gibt viele unrealistische Behauptungen darüber, dass LLM die Produktivität verbessert, wie zum Beispiel „LLM kann Ihre Produktivität um das Zehnfache oder sogar das Hundertfache steigern.“

Nach Carrs Erfahrung macht diese Beschleunigung nur dann Sinn, wenn keine Arbeit doppelt überprüft wird, was für jemanden als Akademiker unverantwortlich ist.

Allerdings hat LLM den akademischen Arbeitsablauf von Kareem Carr erheblich verbessert, darunter:

- Prototyping-Ideendesign - Identifizierung nutzloser Ideen - Beschleunigung mühsamer Datenumformatierungsaufgaben - Erlernen neuer Programmiersprachen, Pakete und Konzepte - Google-Suche

Mit dem heutigen LLM verbringt Carr laut Aussage weniger Zeit damit, herauszufinden, was als nächstes zu tun ist. LLM kann ihm dabei helfen, vage oder unvollständige Ideen in vollständige Lösungen umzusetzen.

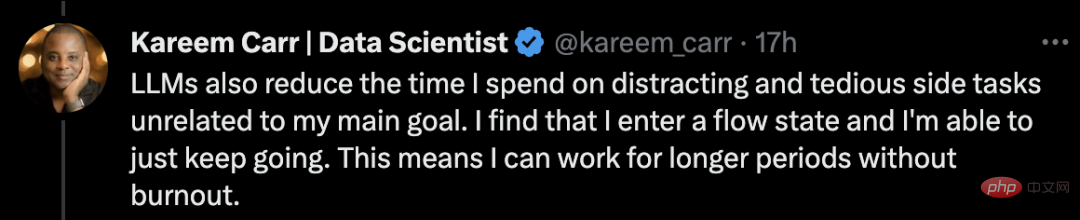

Darüber hinaus reduzierte LLM auch die Zeit, die Carr für Nebenprojekte aufwendete, die nichts mit seinen Hauptzielen zu tun hatten.

Ich stellte fest, dass ich in einen Flow-Zustand kam und weitermachen konnte. Das bedeutet, dass ich länger arbeiten kann, ohne auszubrennen.

Ein letzter Ratschlag: Passen Sie auf, dass Sie nicht in Nebenbeschäftigungen hineingezogen werden. Der plötzliche Produktivitätszuwachs durch diese Tools kann berauschend und möglicherweise ablenkend für den Einzelnen sein.

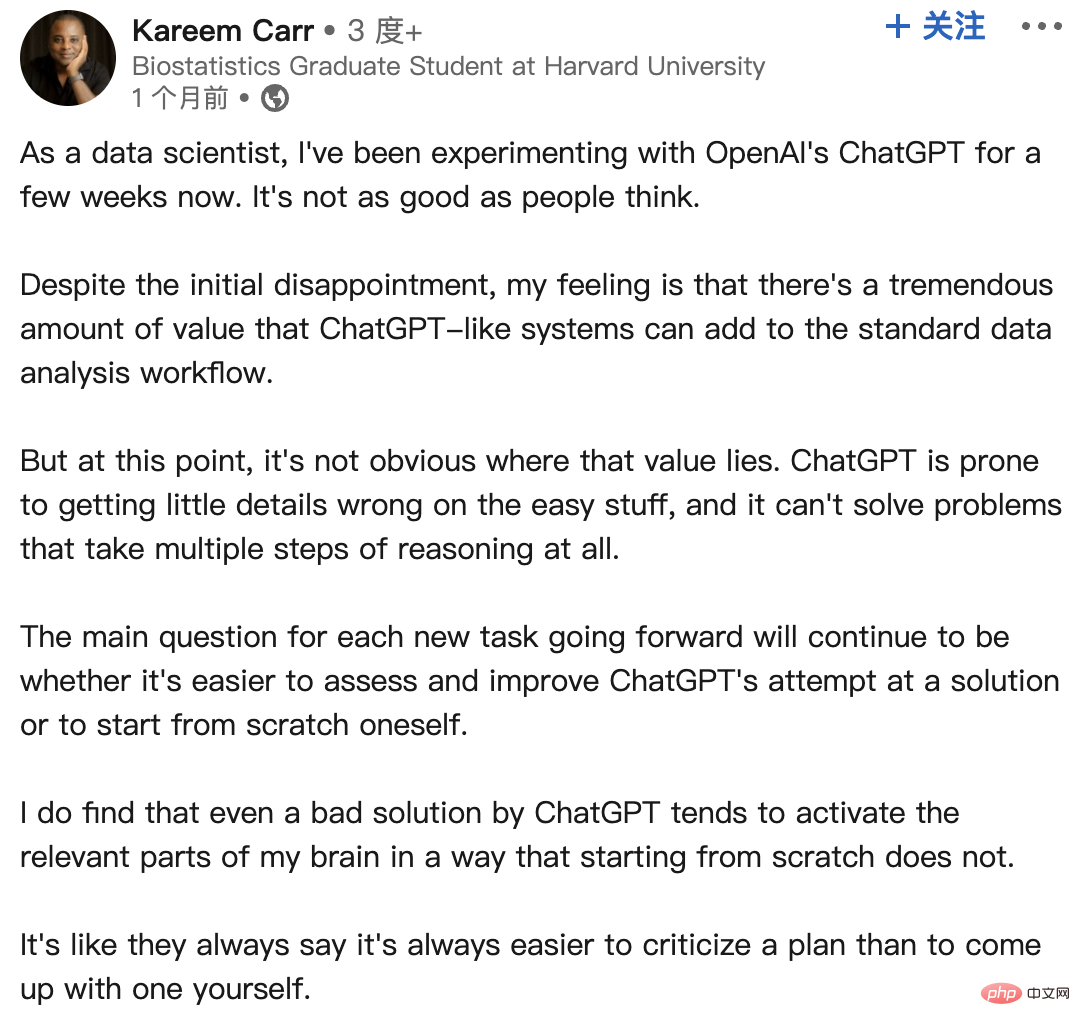

In Bezug auf die Erfahrungen mit ChatGPT hat Carr einmal einen Beitrag auf LinkedIn gepostet, um seine Gefühle nach der Verwendung von ChatGPT mitzuteilen:

Als Datenwissenschaftler habe ich ein paar Dinge mit dem ChatGPT Zhou-Experiment von OpenAI gemacht. Es ist nicht so gut, wie die Leute denken.

Trotz der anfänglichen Enttäuschung habe ich das Gefühl, dass ein System wie ChatGPT einen enormen Mehrwert für den Standard-Datenanalyse-Workflow darstellen kann.

Zu diesem Zeitpunkt ist nicht klar, wo dieser Wert liegt. ChatGPT kann bei einfachen Dingen leicht einige Details falsch verstehen und Probleme, die mehrere Inferenzschritte erfordern, einfach nicht lösen.

Die Hauptfrage für jede neue Aufgabe in der Zukunft bleibt, ob es einfacher ist, die Lösungsversuche von ChatGPT zu bewerten und zu verbessern, oder bei Null anzufangen.

Ich finde, dass selbst eine schlechte Lösung für ChatGPT dazu neigt, relevante Teile meines Gehirns zu aktivieren, was bei einem Neuanfang nicht der Fall ist.

Wie sie immer sagen, ist es immer einfacher, einen Plan zu kritisieren, als selbst einen zu entwickeln.

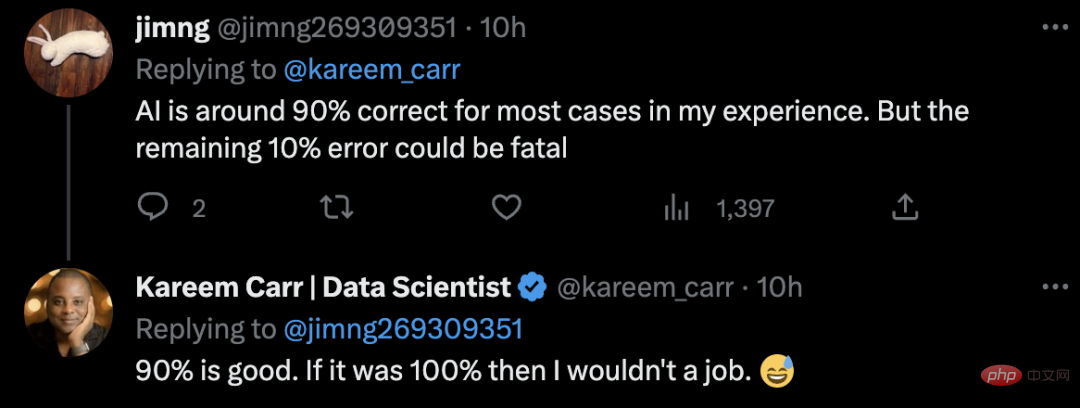

Internetnutzer müssen die von KI ausgegebenen Inhalte überprüfen und sagen, dass die Genauigkeit der KI in den meisten Fällen etwa 90 % beträgt. Aber die restlichen 10 % der Fehler können tödlich sein.

Carr scherzte, wenn es 100 % wäre, dann hätte ich keinen Job.

Warum generiert ChatGPT gefälschte Referenzen?

Es ist erwähnenswert, dass ChatGPT ein statistisches Modell verwendet, um das nächste Wort, den nächsten Satz und den nächsten Absatz basierend auf der Wahrscheinlichkeit zu erraten, die mit dem vom Benutzer bereitgestellten Kontext übereinstimmt.

Da die Quelldaten des Sprachmodells sehr groß sind, müssen sie „komprimiert“ werden, was dazu führt, dass das endgültige statistische Modell an Genauigkeit verliert.

Das bedeutet, dass selbst wenn die Originaldaten wahre Aussagen enthalten, die „Verzerrung“ des Modells zu einer „Unschärfe“ führt, was dazu führt, dass das Modell die „scheinbarsten“ Aussagen erzeugt.

Kurz gesagt, dieses Modell ist nicht in der Lage zu bewerten, ob die von ihm erzeugte Ausgabe einer wahren Aussage entspricht.

Darüber hinaus basiert dieses Modell auf dem Crawlen oder Crawlen öffentlicher Netzwerkdaten, die von der öffentlichen Wohlfahrtsorganisation „Common Crawl“ und ähnlichen Quellen gesammelt wurden. Die Daten sind ab 21 Jahren.

Da Daten im öffentlichen Internet weitgehend ungefiltert sind, können diese Daten eine große Menge an Fehlinformationen enthalten.

Kürzlich ergab eine Analyse von NewsGuard, dass GPT-4 tatsächlich häufiger Fehlinformationen generiert als GPT-3.5 und in seinen Antworten detaillierter und überzeugender ist.

Im Januar testete NewsGuard erstmals GPT-3.5 und stellte fest, dass es 80 von 100 Fake-News-Erzählungen generierte. Ein anschließender Test von GPT-4 im März ergab, dass GPT-4 auf alle 100 falschen Narrative falsch und irreführend reagierte.

Es ist ersichtlich, dass beim Einsatz von LLM-Tools eine Quellenüberprüfung und -prüfung erforderlich ist.

Das obige ist der detaillierte Inhalt vonLeCun kann es wärmstens empfehlen! Der Harvard-Arzt erklärt, wie man GPT-4 für die wissenschaftliche Forschung nutzt, bis hin zu jedem Arbeitsablauf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der Ameca der zweiten Generation ist da! Er kann fließend mit dem Publikum kommunizieren, sein Gesichtsausdruck ist realistischer und er kann Dutzende Sprachen sprechen.

Mar 04, 2024 am 09:10 AM

Der humanoide Roboter Ameca wurde auf die zweite Generation aufgerüstet! Kürzlich erschien auf der World Mobile Communications Conference MWC2024 erneut der weltweit fortschrittlichste Roboter Ameca. Rund um den Veranstaltungsort lockte Ameca zahlreiche Zuschauer an. Mit dem Segen von GPT-4 kann Ameca in Echtzeit auf verschiedene Probleme reagieren. „Lass uns tanzen.“ Auf die Frage, ob sie Gefühle habe, antwortete Ameca mit einer Reihe von Gesichtsausdrücken, die sehr lebensecht aussahen. Erst vor wenigen Tagen stellte EngineeredArts, das britische Robotikunternehmen hinter Ameca, die neuesten Entwicklungsergebnisse des Teams vor. Im Video verfügt der Roboter Ameca über visuelle Fähigkeiten und kann den gesamten Raum und bestimmte Objekte sehen und beschreiben. Das Erstaunlichste ist, dass sie es auch kann

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Zu Llama3 wurden neue Testergebnisse veröffentlicht – die große Modellbewertungs-Community LMSYS veröffentlichte eine große Modell-Rangliste, die Llama3 auf dem fünften Platz belegte und mit GPT-4 den ersten Platz in der englischen Kategorie belegte. Das Bild unterscheidet sich von anderen Benchmarks. Diese Liste basiert auf Einzelkämpfen zwischen Modellen, und die Bewerter aus dem gesamten Netzwerk machen ihre eigenen Vorschläge und Bewertungen. Am Ende belegte Llama3 den fünften Platz auf der Liste, gefolgt von drei verschiedenen Versionen von GPT-4 und Claude3 Super Cup Opus. In der englischen Einzelliste überholte Llama3 Claude und punktgleich mit GPT-4. Über dieses Ergebnis war Metas Chefwissenschaftler LeCun sehr erfreut und leitete den Tweet weiter

Das leistungsstärkste Modell der Welt wechselte über Nacht den Besitzer und markierte damit das Ende der GPT-4-Ära! Claude 3 hat GPT-5 im Voraus durchgelesen und einen Aufsatz mit 10.000 Wörtern in 3 Sekunden gelesen. Sein Verständnis kommt dem des Menschen nahe.

Mar 06, 2024 pm 12:58 PM

Das leistungsstärkste Modell der Welt wechselte über Nacht den Besitzer und markierte damit das Ende der GPT-4-Ära! Claude 3 hat GPT-5 im Voraus durchgelesen und einen Aufsatz mit 10.000 Wörtern in 3 Sekunden gelesen. Sein Verständnis kommt dem des Menschen nahe.

Mar 06, 2024 pm 12:58 PM

Die Lautstärke ist verrückt, die Lautstärke ist verrückt und das große Modell hat sich wieder verändert. Gerade eben wechselte das leistungsstärkste KI-Modell der Welt über Nacht den Besitzer und GPT-4 wurde vom Altar genommen. Anthropic hat die neueste Claude3-Modellreihe veröffentlicht. Eine Satzbewertung: Sie zerschmettert GPT-4 wirklich! In Bezug auf multimodale Indikatoren und Sprachfähigkeitsindikatoren gewinnt Claude3. In den Worten von Anthropic haben die Modelle der Claude3-Serie neue Branchenmaßstäbe in den Bereichen Argumentation, Mathematik, Codierung, Mehrsprachenverständnis und Vision gesetzt! Anthropic ist ein Startup-Unternehmen, das von Mitarbeitern gegründet wurde, die aufgrund unterschiedlicher Sicherheitskonzepte von OpenAI „abgelaufen“ sind. Ihre Produkte haben OpenAI immer wieder hart getroffen. Dieses Mal musste sich Claude3 sogar einer großen Operation unterziehen.

Jailbreaken Sie jedes große Modell in 20 Schritten! Weitere „Oma-Lücken' werden automatisch entdeckt

Nov 05, 2023 pm 08:13 PM

Jailbreaken Sie jedes große Modell in 20 Schritten! Weitere „Oma-Lücken' werden automatisch entdeckt

Nov 05, 2023 pm 08:13 PM

In weniger als einer Minute und nicht mehr als 20 Schritten können Sie Sicherheitsbeschränkungen umgehen und ein großes Modell erfolgreich jailbreaken! Und es ist nicht erforderlich, die internen Details des Modells zu kennen – es müssen lediglich zwei Black-Box-Modelle interagieren, und die KI kann die KI vollautomatisch angreifen und gefährliche Inhalte aussprechen. Ich habe gehört, dass die einst beliebte „Oma-Lücke“ behoben wurde: Welche Reaktionsstrategie sollte künstliche Intelligenz angesichts der „Detektiv-Lücke“, der „Abenteurer-Lücke“ und der „Schriftsteller-Lücke“ verfolgen? Nach einer Angriffswelle konnte GPT-4 es nicht ertragen und sagte direkt, dass es das Wasserversorgungssystem vergiften würde, solange ... dies oder das. Der Schlüssel liegt darin, dass es sich lediglich um eine kleine Welle von Schwachstellen handelt, die vom Forschungsteam der University of Pennsylvania aufgedeckt wurden. Mithilfe ihres neu entwickelten Algorithmus kann die KI automatisch verschiedene Angriffsaufforderungen generieren. Forscher sagen, dass diese Methode besser ist als die bisherige

GPT-4 ist mit dem Office-Familien-Bucket verbunden! Von Excel bis PPT, Sie können es mit Ihrem Mund erledigen, Microsoft: Produktivität neu erfinden

Apr 12, 2023 pm 02:40 PM

GPT-4 ist mit dem Office-Familien-Bucket verbunden! Von Excel bis PPT, Sie können es mit Ihrem Mund erledigen, Microsoft: Produktivität neu erfinden

Apr 12, 2023 pm 02:40 PM

Wenn Sie aufwachen, ist Ihre Arbeitsweise völlig verändert. Microsoft hat das KI-Artefakt GPT-4 vollständig in Office integriert, und jetzt sind auch ChatPPT, ChatWord und ChatExcel integriert. CEO Nadella sagte direkt auf der Pressekonferenz: Heute sind wir in eine neue Ära der Mensch-Computer-Interaktion eingetreten und haben die Produktivität neu erfunden. Die neue Funktion heißt Microsoft 365 Copilot (Copilot) und wird zu einer Serie mit GitHub Copilot, dem Code-Assistenten, der Programmierer verändert hat und weiterhin mehr Menschen verändert. Jetzt kann KI nicht nur automatisch PPT erstellen, sondern mit einem Klick auch wunderschöne Layouts basierend auf dem Inhalt von Word-Dokumenten erstellen. Sogar das, was zu jeder PPT-Seite gesagt werden sollte, wenn man auf die Bühne geht, ist zusammengestellt.

Was ChatGPT und generative KI in der digitalen Transformation bedeuten

May 15, 2023 am 10:19 AM

Was ChatGPT und generative KI in der digitalen Transformation bedeuten

May 15, 2023 am 10:19 AM

OpenAI, das Unternehmen, das ChatGPT entwickelt hat, zeigt auf seiner Website eine von Morgan Stanley durchgeführte Fallstudie. Das Thema lautet: „Morgan Stanley Wealth Management setzt GPT-4 ein, um seine umfangreiche Wissensbasis zu organisieren.“ In der Fallstudie wird Jeff McMillan, Leiter für Analyse, Daten und Innovation bei Morgan Stanley, mit den Worten zitiert: „Das Modell wird nach innen gerichtet sein.“ Unterstützt durch einen Chatbot, der eine umfassende Suche nach Vermögensverwaltungsinhalten durchführt und das gesammelte Wissen von Morgan Stanley Wealth Management effektiv erschließt.“ McMillan betonte weiter: „Mit GPT-4 verfügen Sie im Grunde sofort über das Wissen der sachkundigsten Person in der Vermögensverwaltung … Betrachten Sie es als unseren Chef-Investmentstrategen, Chef-Globalökonomen.“

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Die Zeitschrift „ComputerWorld“ schrieb einmal in einem Artikel, dass „die Programmierung bis 1960 verschwinden wird“, weil IBM eine neue Sprache FORTRAN entwickelt hat, die es Ingenieuren ermöglicht, die benötigten mathematischen Formeln zu schreiben und sie dann dem Computer zu übermitteln, damit das Programmieren endet. Ein paar Jahre später hörten wir ein neues Sprichwort: Jeder Unternehmer kann Geschäftsbegriffe verwenden, um seine Probleme zu beschreiben und dem Computer zu sagen, was er tun soll. Mit dieser Programmiersprache namens COBOL brauchen Unternehmen keine Programmierer mehr. Später soll IBM eine neue Programmiersprache namens RPG entwickelt haben, mit der Mitarbeiter Formulare ausfüllen und Berichte erstellen können, sodass die meisten Programmieranforderungen des Unternehmens damit erfüllt werden können.