Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google hat den LLM-Kampf verloren! Immer mehr Spitzenforscher wechseln den Job bei OpenAI

Google hat den LLM-Kampf verloren! Immer mehr Spitzenforscher wechseln den Job bei OpenAI

Google hat den LLM-Kampf verloren! Immer mehr Spitzenforscher wechseln den Job bei OpenAI

Vor ein paar Tagen geriet Google fast in eine PR-Krise. Jacob Devlin, ein ehemaliger Mitarbeiter von Bert, der OpenAI verlassen hatte, gab bekannt, dass Bard tatsächlich mithilfe von ChatGPT-Daten trainiert wurde.

Anschließend dementierte Google dies schnell.

Und diese Kontroverse hat auch zu einer großen Diskussion geführt: Warum wechseln immer mehr Top-Forscher von Google ihren Job zu OpenAI? Kann es diesen LLM-Kampf noch gewinnen?

Antwort eines Freundes

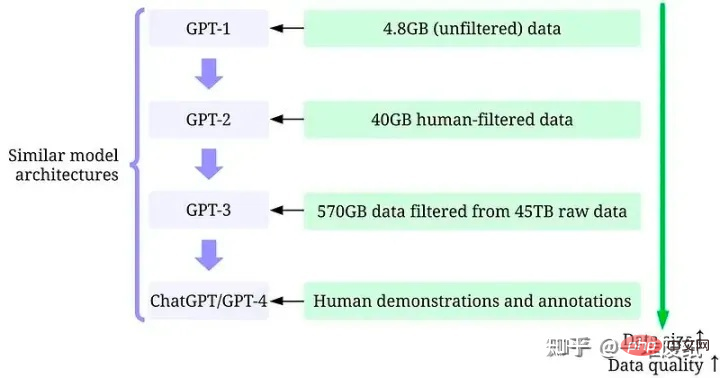

Ein Arzt von der Rice University und ein enger Freund sagten, dass die Lücke zwischen Google und OpenAI tatsächlich eine Datenlücke sei.

„OpenAI ist stark von LLM besessen, was von Unternehmen wie Google völlig unerreicht ist. Natürlich ist die Kluft zwischen Menschen nur ein Aspekt, die Datenlücke und die Einstellung zu Daten sind der Schlüssel zum Erfolg. Menschen mögen das Wenn Sie Geld ausgeben, um es zurückzugewinnen, kann die Technologie dies möglicherweise ausgleichen, aber die Datenlücke wird Google nicht in kurzer Zeit schließen /abs/2303.10158

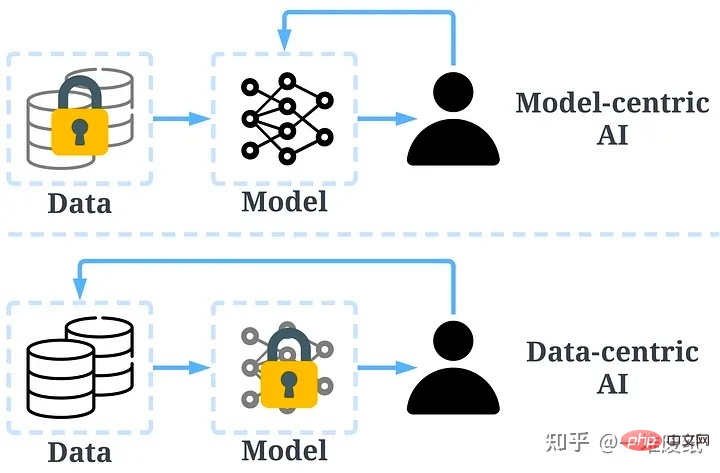

Ein entscheidender Faktor für den Erfolg von ChatGPT sind natürlich qualitativ hochwertige kommentierte Daten.

„Ein Haufen Altpapier“ stellt vor, dass OpenAI großen Wert auf die Qualität der Daten und Labels legt. Es ist äußerst streng bei der Auswahl der Kommentatoren (es gibt Prüfungen) und wird am Ende sogar Fragebögen ausstellen. Es ist diese Besessenheit, die zum Erfolg des GPT-Modells geführt hat, mit dem Google überhaupt nicht mithalten kann.

„Ein Haufen Altpapier“ stellt vor, dass OpenAI großen Wert auf die Qualität der Daten und Labels legt. Es ist äußerst streng bei der Auswahl der Kommentatoren (es gibt Prüfungen) und wird am Ende sogar Fragebögen ausstellen. Es ist diese Besessenheit, die zum Erfolg des GPT-Modells geführt hat, mit dem Google überhaupt nicht mithalten kann.

Und da Hunderte Millionen Nutzer weiterhin neue Daten für OpenAI bereitstellen, wird die Kluft zwischen Google und OpenAI nur noch größer.

Das Konzept der datenzentrierten KI hat den Grundstein für den Erfolg von OpenAI gelegt.

„Zhang Junlin“, ein ausgezeichneter Beantworter zu Themen der Verarbeitung natürlicher Sprache und Deep Learning, sagte, dass OpenAI alle zurückgelassen habe. Einschließlich Google liegt das Verständnis des LLM-Entwicklungskonzepts offensichtlich einen Schritt hinter OpenAI zurück. Die Realität ist, dass OpenAI zu gute Leistungen erbracht hat und alle zurückgelassen hat, nicht nur im Inland. Ich denke, dass OpenAI im Ausland in Bezug auf Konzepte und verwandte Technologien für LLM etwa ein halbes bis ein Jahr vor Google und DeepMind liegt, und dass es China etwa zwei Jahre voraus ist. Zhihu-Befragter „Zhou Daodao“ sagte, dass der Vergleich des jüngsten Umsturzes von Google mit OpenAI diesen Spitzenforschern einen großen Schock versetzt haben muss.

Zhihu-Befragter „Zhou Daodao“ sagte, dass der Vergleich des jüngsten Umsturzes von Google mit OpenAI diesen Spitzenforschern einen großen Schock versetzt haben muss.

Darüber hinaus wird gesagt, dass OpenAI den Forschern mehr Ressourcen und umfassendere Anforderungen bieten wird als Google. Schließlich ist OpenAI eher eine Forschungseinrichtung, während Google eher eine Abteilung ist, die KI als Produkt behandelt.

Die Antwort des Befragten „Chen Dabao“ ist sehr herzzerreißend.

Die Unternehmensgeschichte wird in Zukunft zwei klassische und ironische Fälle aufzeichnen:

1. Kodak hat die Digitalkamera erfunden

2. Google hat den Transformator erfunden

Fotoquelle: „Chen Dabao“ Anonym Im Kommentarbereich tauchten auch Personen mit Interessen auf.

Eine weitere anonyme Person hat ins Schwarze getroffen.

Ein Freund wies auf das „Innovatoren-Dilemma“ von Google als Großunternehmen hin.

Zhihu „Xingnan Zhou (Bill)“ kam zu dem Schluss, dass große Unternehmen wie Google aufgrund ihrer Politik alle ein Trottel sind.

Und Insider hat einen langen Artikel für uns zusammengefasst, in dem er eine Bestandsaufnahme der Top-Talente macht, die im Laufe der Jahre aus dem Team für künstliche Intelligenz von Google verloren gegangen sind.

Wo sind all die Talente geblieben?

Google hat einige sehr wichtige Forschungsergebnisse auf dem Gebiet der künstlichen Intelligenz beigetragen. Das Unternehmen hat seine Innovationen jedoch nur langsam in Produkte umgesetzt.

Infolgedessen wechseln führende KI-Forscher zu Startups, die einen größeren Wert und eine größere Wirkung erzielen können, wie OpenAI, Character.AI, DeepMind, Cohere, Inceptive.

Google befindet sich bereits in einer defensiven Position und wird seine führende Position im Bereich der künstlichen Intelligenz jederzeit verlieren. Der Abgang von Spitzenforschern hat das Problem verschärft.

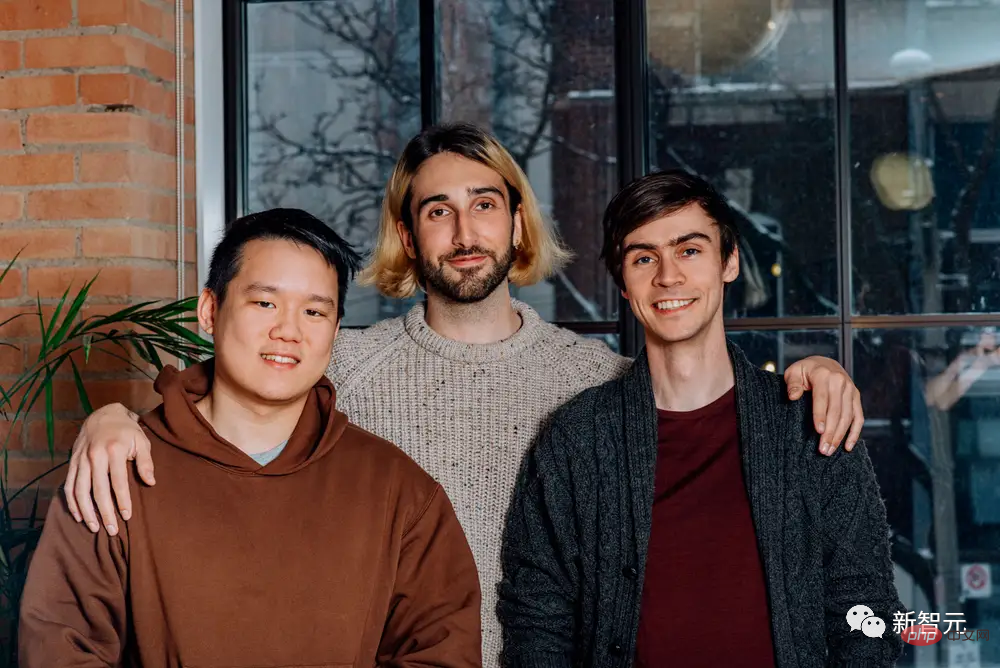

Das Mitbegründerteam von Cohere, Ivan Zhang, Aidan Gomez und Nick Frosst

Auch wenn sich Google möglicherweise im Defensivmodus befindet, muss dies nicht der Fall sein. Das Unternehmen hat einen Großteil der zugrunde liegenden Technologie selbst entwickelt und basiert auf Produkten wie ChatGPT. Es stellt seine Forschungsergebnisse auch als Open Source zur Verfügung, was den kometenhaften Aufstieg von OpenAI etwas ironisiert.

Google zögert seit langem, Chatbots ähnlich wie ChatGPT zu veröffentlichen, da befürchtet wird, dass die Technologie dem Ruf seines Unternehmens schaden würde.

Daniel De Freitas und Noam Shazeer, die beiden Forscher hinter Googles groß angelegtem Sprachmodell LaMDA, haben das Unternehmen verlassen, frustriert über die Verzögerung des Unternehmens bei der Veröffentlichung eines Chatbots ähnlich wie ChatGPT.

Andere ehemalige Google-Forscher glauben ebenfalls, dass Startups in einer so aufregenden Ära der künstlichen Intelligenz den Forschern die Verantwortung für ihre Ergebnisse übertragen und selbst mehr Wert und Einfluss ausüben werden.

Hier sind einige der bekanntesten Artikel im Bereich der künstlichen Intelligenz von Forschern, die Google für andere Unternehmen verlassen haben.

Ilya Sutskever

„Sequence-to-Sequence Learning with Neural Networks“ wurde 2014 veröffentlicht. In diesem Sequence-to-Sequence-Artikel werden Sprachmodelle trainiert, um Wortsequenzen in einer Domäne in Sequenzen in einer anderen Domäne umzuwandeln. Wandeln Sie beispielsweise einen englischen Satz in einen französischen Satz um.

Ilya Sutskever leitete die Forschung zu diesem Artikel. Er verließ Google im Jahr 2015 nach fast drei Jahren als Forschungswissenschaftler. Sutskever ist Mitbegründer von OpenAI und arbeitet dort weiterhin als leitender Wissenschaftler.

Aufmerksamkeit ist alles, was Sie brauchen

Der Blockbuster-Artikel dieses Transformers wurde inzwischen mehr als 70.000 Mal zitiert. Transformer gilt als Durchbruch in der Verarbeitung natürlicher Sprache. Es hilft der KI, die Bedeutung zu verstehen, indem es kontextuelle Nuancen ermittelt, indem es jedes Wort in einem Satz gleichzeitig betrachtet und die Bedeutung jedes Wortes abwägt.

Das „T“ in ChatGPT steht für Transformer, was die Bedeutung dieses Dokuments zeigt.

Allerdings haben die acht Autoren dieses Artikels, außer Llion Jones, alle Google verlassen.

Ashish Vaswani verließ Google Brain (Googles Deep-Learning-KI-Forschungsteam) nach fünf Jahren, um Adept zu gründen, ein Unternehmen, das kürzlich 350 Millionen US-Dollar gesammelt hat, um generative KI-Tools zu entwickeln, die Menschen helfen, Produktivitätssoftware effektiver zu nutzen. Kürzlich verließ er Adept und wechselte zu einem heimlichen Startup.

Noam Shazeer ist jetzt CEO von Character.AI.

Niki Parmar verließ Google Brain nach fünf Jahren, um als Mitbegründerin und CTO von Adept zu fungieren, aber wie Vaswani wechselte auch sie kürzlich zu einem geheimen Startup.

Jakob Uszkoreit arbeitet seit 13 Jahren bei Google und beschäftigt sich mit neuronalen Netzen und Deep Learning. Heute ist er Mitbegründer von Inceptive, einem Startup, das Deep Learning nutzt, um neue Behandlungen zu entwickeln.

Aidan Gomez ist Mitbegründer und CEO von Cohere, einem Unternehmen, das rund 160 Millionen US-Dollar gesammelt hat, um Entwicklern dabei zu helfen, generative künstliche Intelligenz in ihre Apps und Websites zu integrieren. Er verbrachte anderthalb Jahre als Forscher bei Google Brain. Und sein Mitbegründer von Cohere, Nick Frosst, war vier Jahre lang als Forscher bei Google Brain tätig.

Lukasz Kaiser verließ Google Brain, nachdem er mehr als 7 Jahre bei Google Brain gearbeitet hatte, und kam 2021 zu OpenAI. Kaiser wurde kürzlich im GPT-4-Whitepaper von OpenAI als Hauptverantwortlicher für seine Long-Context-Fähigkeiten genannt, die es Chatbots ermöglichen, längere Gespräche zu führen, ohne den Kontext der Diskussion zu vergessen.

Illia Polosukhin arbeitet seit drei Jahren bei Google Brain an Deep Learning und natürlichem Sprachverständnis. Er verließ das Unternehmen 2017 und gründete Pagoda, eine Web3-Startup-Plattform.

Aufbau eines menschenähnlichen Open-Domain-Chatbots

Dieses Papier stellt Googles Original-Chatbot Meena vor und untersucht, wie Chatbots lernen können, über Themen zu sprechen, indem sie Daten aus öffentlichen Social-Media-Konversationen untersuchen. Außerdem wird ein von Google erstellter Test beschrieben, mit dem die Sprachleistung von Chatbots bewertet werden soll.

Dieses Papier ist ein weiterer wichtiger Meilenstein in der Modellierung großer Sprachen. Die Autoren glauben, dass sie ein großes Sprachmodell erstellen können, das ohne hart codiertes Training menschenähnliche Antworten liefern kann.

Einer der Autoren, Daniel De Freitas, war Mitbegründer und Präsident von Character.AI, nachdem er fünf Jahre lang als Forscher bei Google Brain gearbeitet hatte.

De Freitas‘ Kollege bei Character.AI, Romal Thoppilan, hat ebenfalls zu diesem Artikel beigetragen.

Links ist Romal Thoppilan; rechts ist Daniel De Freitas

LaMDA: Sprachmodell für Konversationsanwendungen

LaMDA ist die Abkürzung für Sprachmodell für Konversationsanwendungen und ist die Basis des Chatbots Bard . Es wurde erstmals im Jahr 2020 als Meena vorgeführt, aber Google hat Meena nie der Öffentlichkeit zugänglich gemacht. Ehemalige Mitarbeiter der Google-Forschungsabteilung für künstliche Intelligenz erklärten, dass dies ein PR-Albtraum wäre, da Google befürchtete, dass die Bots schädliche Kommentare abgeben würden.

Mehrere wichtige Forscher hinter LaMDA haben Google Brain verlassen.

Character.AI, ein letztes Jahr von Daniel De Freitas und Noam Shazeer gegründetes Unternehmen, hat kürzlich rund 200 Millionen US-Dollar gesammelt, um Chatbots zu entwickeln, die in einer Vielzahl von Rollen sprechen, von Musk über Therapeuten bis hin zu Lebensberatern.

Romal Thoppilan ist der Gründungsforscher von Character.AI, nachdem er sieben Jahre lang bei Google Brain gearbeitet hat.

Alicia Jin wird Ende 2022 als Forschungsingenieurin bei Character.AI einsteigen. Sie arbeitete drei Jahre lang bei Google Brain.

BERT

BERT (Bidirektionale Encoder-Repräsentationen von Transformers) basiert auf dem Transformer-Modell der Verarbeitung natürlicher Sprache. Nach dem Vortraining kann es zwei Aufgaben gut erledigen: maskierte Sprachmodellierung und Vorhersage des nächsten Satzes. Mit anderen Worten: BERT versucht, versteckte oder „maskierte“ Wörter vorherzusagen, was den Algorithmus dazu zwingt, hart zu arbeiten, um mehr über den umgebenden Text zu erfahren und versteckte Wörter besser vorherzusagen.

Wenn Sie „Können Sie Medikamente für die Apotheke einer anderen Person kaufen?“ eingeben, wird klar, dass „andere Personen“ ein wichtiger Teil der Abfrage sind.

Google hat bereits 2019 damit begonnen, BERT in seine Suchmaschine zu integrieren. Dies ist eine der größten Verbesserungen der Suchgenauigkeit seit der Integration eines weiteren maschinellen Lernalgorithmus, RankBrain, im Jahr 2015.

Jacob Devlin ist der Hauptautor dieses Artikels und kam kurz vor dem Start von ChatGPT zu OpenAI.

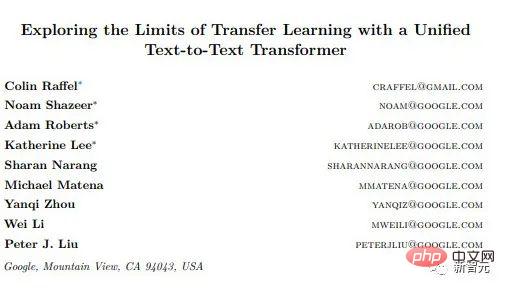

T5

Der offizielle Name des T5-Papiers lautet „Exploring the Limits of Transfer Learning with a Unified Text-to-Text Transformer“. Es basiert auf BERT und eignet sich sehr gut für Aufgaben wie Übersetzung und Zusammenfassung.

Colin Raffel, der den Artikel leitete, war etwa fünf Jahre lang als wissenschaftlicher Mitarbeiter bei Google Brain tätig, bevor er das Unternehmen 2021 verließ. Derzeit ist er Assistenzprofessor am UNC-Chapel Hill und verbringt einen Tag pro Woche als Forscher bei Hugging Face. Hugging Face gab kürzlich bekannt, dass es im Mai 2022 100 Millionen US-Dollar eingesammelt hat, womit das Unternehmen einen Wert von 2 Milliarden US-Dollar hat. Benutzer können große Sprachmodelle und Datensätze auf Hugging Face teilen.

Sharan Narang, eine weitere Mitwirkende des T5-Papiers, verließ Google Brain im Jahr 2022, nachdem sie dort vier Jahre lang gearbeitet hatte. Heute ist er Forscher für künstliche Intelligenz bei Meta Corporation.

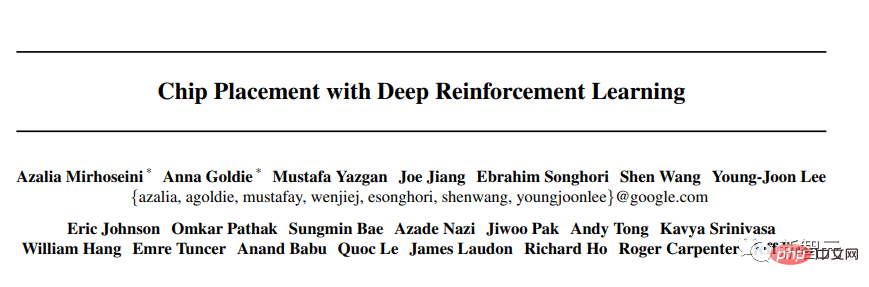

Eine Musterplatzierungsmethode für schnelles Chip-Design

Eine von den Google-Wissenschaftlern Azalia Mirhoseini und Anna Goldie geleitete Arbeit ergab, dass künstliche Intelligenz den Designprozess von Chips schneller abschließen kann als menschliche Experten.

Ein weiteres vom Duo geleitetes Papier, „Chip Layout with Deep Reinforcement Learning“, bietet eine Möglichkeit, künstliche Intelligenz im Chipdesign zu nutzen, um die Leistung zu maximieren und gleichzeitig den Flächen- und Stromverbrauch zu minimieren.

Diese Erkenntnisse haben Google dabei geholfen, TPU-Chips speziell für maschinelle Lernaufgaben zu entwickeln.

Mirhoseini und Goldie verließen beide Google im Jahr 2022, um sich Anthropic anzuschließen, ebenfalls einem OpenAI-Konkurrenten, der ein eigenes groß angelegtes Sprachmodell und einen Chatbot namens Claude entwickelt.

DeepMind

Mustafa Suleyman ist Mitbegründer von DeepMind und fungiert als Chief Product Officer des Unternehmens. Dabei handelt es sich um ein Labor für künstliche Intelligenz, das 2014 von Google übernommen wurde. Das Labor entwickelte AlphaGo, das maschinelle Lernprogramm, das Weltmeister im Go-Spiel besiegte.

Alphabet, die Muttergesellschaft von Google, gab kürzlich in ihrem Finanzbericht für das vierte Quartal bekannt, dass die Finanzergebnisse von DeepMind unabhängig von „anderen Investitionen“ sein werden, was die Bedeutung künstlicher Intelligenz für die zukünftige Strategie von Google unterstreicht. Typischerweise ist „sonstige Investitionen“ ein allgemeiner Begriff für die im Entstehen begriffenen Projekte des Unternehmens, die noch nicht die Rentabilität erreicht haben.

Suleyman setzt sich leidenschaftlich dafür ein, die Sicherheit neuer Produkte für künstliche Intelligenz zu gewährleisten. Während seiner Arbeit bei DeepMind gründete er eine Forschungsabteilung namens DeepMind Ethics and Society, um die realen Auswirkungen künstlicher Intelligenz zu untersuchen. Im Jahr 2019 wurde er von DeepMind beurlaubt, nachdem ihm Mobbing von Mitarbeitern vorgeworfen wurde. Während die Ermittlungen liefen, wechselte er als Vizepräsident zu Google zurück.

Suleyman wurde in vielen Forschungsarbeiten zum Thema maschinelles Lernen zitiert. Im Februar 2022 gründete er zusammen mit dem LinkedIn-Erfinder Reid Hoffman das Startup für künstliche Intelligenz Inflection.

Viele der wichtigsten Mitwirkenden an Googles bahnbrechendsten Veröffentlichungen zur künstlichen Intelligenz haben das Unternehmen verlassen und sich Konkurrenten wie OpenAI angeschlossen oder eigene Unternehmen gegründet.

Als ChatGPT von OpenAI Ende 2022 herauskam, kündigte Google-CEO Sundar Pichai intern einen „roten Alarm“ an und forderte das Unternehmen auf, zu reagieren.

Damals sagte Pichai, dass Google ohne Frage weiterhin Spitzenforscher im Bereich der künstlichen Intelligenz einstellen werde.

Aber kann Google nach dem Verlust so vieler fähiger Leute immer noch wieder Großes erreichen?

Referenzen:

https://www.businessinsider.com/google-ai-teams-brain-drain-researchers-leave-2023-3

https://www.zhihu.com/question/592975340/ Antwort /2963265672

https://zhuanlan.zhihu.com/p/597586623

https://www.zhihu.com/question/592975340/answer/2964598555

Das obige ist der detaillierte Inhalt vonGoogle hat den LLM-Kampf verloren! Immer mehr Spitzenforscher wechseln den Job bei OpenAI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Deepseek ist ein leistungsstarkes Informations -Abruf -Tool. .

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek ist eine proprietäre Suchmaschine, die nur schneller und genauer in einer bestimmten Datenbank oder einem bestimmten System sucht. Bei der Verwendung wird den Benutzern empfohlen, das Dokument zu lesen, verschiedene Suchstrategien auszuprobieren, Hilfe und Feedback zur Benutzererfahrung zu suchen, um die Vorteile optimal zu nutzen.

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

In diesem Artikel wird der Registrierungsprozess der Webversion Sesam Open Exchange (GATE.IO) und die Gate Trading App im Detail vorgestellt. Unabhängig davon, ob es sich um eine Webregistrierung oder eine App -Registrierung handelt, müssen Sie die offizielle Website oder den offiziellen App Store besuchen, um die Genuine App herunterzuladen, und dann den Benutzernamen, das Kennwort, die E -Mail, die Mobiltelefonnummer und die anderen Informationen eingeben und eine E -Mail- oder Mobiltelefonüberprüfung abschließen.

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden? Bitbit ist eine Kryptowährungsbörse, die den Benutzern Handelsdienste anbietet. Die mobilen Apps der Exchange können aus den folgenden Gründen nicht direkt über AppStore oder Googleplay heruntergeladen werden: 1. App Store -Richtlinie beschränkt Apple und Google daran, strenge Anforderungen an die im App Store zulässigen Anwendungsarten zu haben. Kryptowährungsanträge erfüllen diese Anforderungen häufig nicht, da sie Finanzdienstleistungen einbeziehen und spezifische Vorschriften und Sicherheitsstandards erfordern. 2. Die Einhaltung von Gesetzen und Vorschriften In vielen Ländern werden Aktivitäten im Zusammenhang mit Kryptowährungstransaktionen reguliert oder eingeschränkt. Um diese Vorschriften einzuhalten, kann die Bitbit -Anwendung nur über offizielle Websites oder andere autorisierte Kanäle verwendet werden

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Es ist wichtig, einen formalen Kanal auszuwählen, um die App herunterzuladen und die Sicherheit Ihres Kontos zu gewährleisten.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Dieser Artikel empfiehlt die Top Ten Ten Cryptocurrency -Handelsplattformen, die es wert sind, auf Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI und Xbit -dezentrale Börsen geachtet zu werden. Diese Plattformen haben ihre eigenen Vorteile in Bezug auf Transaktionswährungsmenge, Transaktionstyp, Sicherheit, Konformität und Besonderheiten. Die Auswahl einer geeigneten Plattform erfordert eine umfassende Überlegung, die auf eigener Handelserfahrung, Risikotoleranz und Investitionspräferenzen basiert. Ich hoffe, dieser Artikel hilft Ihnen dabei, den besten Anzug für sich selbst zu finden

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Befolgen Sie diese einfachen Schritte, um auf die neueste Version des Binance -Website -Login -Portals zuzugreifen. Gehen Sie zur offiziellen Website und klicken Sie in der oberen rechten Ecke auf die Schaltfläche "Anmeldung". Wählen Sie Ihre vorhandene Anmeldemethode. Geben Sie Ihre registrierte Handynummer oder E -Mail und Kennwort ein und vervollständigen Sie die Authentifizierung (z. B. Mobilfifizierungscode oder Google Authenticator). Nach einer erfolgreichen Überprüfung können Sie auf das neueste Version des offiziellen Website -Login -Portals von Binance zugreifen.

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Eine detaillierte Einführung in den Anmeldungsbetrieb der Sesame Open Exchange -Webversion, einschließlich Anmeldeschritte und Kennwortwiederherstellungsprozess.