Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Was für ein Lärm! Versteht ChatGPT die Sprache? PNAS: Lassen Sie uns zunächst untersuchen, was „Verstehen' ist

Was für ein Lärm! Versteht ChatGPT die Sprache? PNAS: Lassen Sie uns zunächst untersuchen, was „Verstehen' ist

Was für ein Lärm! Versteht ChatGPT die Sprache? PNAS: Lassen Sie uns zunächst untersuchen, was „Verstehen' ist

Ob eine Maschine über diese Frage nachdenken kann, ist wie die Frage, ob ein U-Boot schwimmen kann. ——Dijkstra

Lange vor der Veröffentlichung von ChatGPT hatte die Branche bereits die Veränderungen gerochen, die große Models mit sich brachten.

Am 14. Oktober letzten Jahres veröffentlichten die Professoren Melanie Mitchell und David C. Krakauer vom Santa Fe Institute eine Rezension auf arXiv, in der sie umfassend alle Fragen zum Thema „Ob groß angelegte vorab trainierte Sprachmodelle „Sprache verstehen können“ untersuchten. In diesem Artikel werden die „Pro“- und „Contra“-Argumente sowie die Schlüsselthemen in der breiteren Wissenschaft der Intelligenz beschrieben, die sich aus diesen Argumenten ergeben.

Link zum Papier: https://arxiv.org/pdf/2210.13966.pdf

Publikationszeitschrift: „Proceedings of the National Academy of Sciences“ (PNAS)

Version zu lang zum Lesen:

Das Hauptargument für „Verstehen“ ist, dass große Sprachmodelle viele Aufgaben erfüllen können, die scheinbar Verständnis erfordern.

Das Hauptargument gegen „Verstehen“ ist, dass das Verständnis großer Sprachmodelle aus menschlicher Sicht sehr fragil ist, z Ihr Wissen, multimodale Sprachmodelle können dieses Problem lindern.

Das kritischste Problem ist, dass noch niemand eine verlässliche Definition von „Was ist Verstehen“ hat und nicht weiß, wie man die Verständnisfähigkeit von Sprachmodellen testet. Tests für Menschen sind möglicherweise nicht unbedingt zum Testen geeignet große Sprachen. Modellverständnisfähigkeit.

Zusammenfassend lässt sich sagen, dass große Sprachmodelle Sprache verstehen können, aber vielleicht auf eine andere Art und Weise als Menschen.

Forscher glauben, dass eine neue Wissenschaft der Intelligenz entwickelt werden kann, um verschiedene Arten des Verstehens eingehend zu untersuchen, die Vorteile und Grenzen verschiedener Verstehensmodi herauszufinden und gleichzeitig die kognitiven Unterschiede zu integrieren, die sich aus verschiedenen Formen des Verstehens ergeben.

Die erste Autorin des Artikels, Melanie Mitchell, ist Professorin am Santa Fe Institute. Sie schloss ihr Studium 1990 mit einem Doktortitel ab, und ihr Mentor war Hofstadter. Gödel, Escher, Bach: Gesammelte Werke“) Ihre Forschungsschwerpunkte sind analoges Denken, komplexe Systeme, genetische Algorithmen und zelluläre Automaten.

Was genau ist „verstehen“?

„Was ist Verstehen?“ hat Philosophen, Kognitionswissenschaftler und Pädagogen oft als Referenz für „Verstehensfähigkeit“ verwendet.

Bis vor Kurzem entbrannte mit dem Aufkommen großer künstlicher Intelligenzsysteme, insbesondere großer Sprachmodelle (LLM), in der künstlichen Intelligenz-Community eine heftige Debatte darüber, ob Maschinen nun dazu in der Lage seien die Sprache der Natur verstehen, die physischen und sozialen Situationen verstehen, die die Sprache beschreibt.

Dies ist keine rein akademische Debatte. Der Grad und die Art und Weise, wie Maschinen die Welt verstehen, hat einen erheblichen Einfluss darauf, inwieweit Menschen KI bei der Ausführung von Aufgaben wie dem Autofahren, der Diagnose von Krankheiten und der Pflege älterer Menschen vertrauen können Kinder in menschenbezogenen Aufgaben erziehen. Ergreifen Sie starke und transparente Maßnahmen.

Die aktuelle Debatte zeigt, dass es einige Unterschiede in der Art und Weise gibt, wie die akademische Gemeinschaft über das Verstehen in intelligenten Systemen denkt, insbesondere in mentalen Modellen, die auf „statistischer Korrelation“ und „offensichtlichen Kausalmechanismen“ beruhen.

Allerdings besteht in der KI-Forschungsgemeinschaft immer noch ein allgemeiner Konsens über das Maschinenverständnis, das heißt, dass KI-Systeme zwar bei vielen spezifischen Aufgaben scheinbar intelligentes Verhalten zeigen, aber nicht verstehen, womit sie es zu tun haben Art und Weise, wie Menschen Daten verarbeiten.

Zum Beispiel versteht Gesichtserkennungssoftware nicht, dass das Gesicht Teil des Körpers ist, noch versteht sie die Rolle von Gesichtsausdrücken in der sozialen Interaktion, noch versteht sie, wie Menschen das Konzept des Gesichts in nahezu unendlicher Weise nutzen Anzahl der Möglichkeiten.

Ähnlich verstehen Sprach-zu-Text- und maschinelle Übersetzungsprogramme die Sprache, die sie verarbeiten, nicht, und selbstfahrende Systeme verstehen nicht den subtilen Blickkontakt oder die Körpersprache, die Fahrer und Fußgänger verwenden, um Unfälle zu vermeiden.

Tatsächlich ist die oft zitierte Sprödigkeit dieser künstlichen Intelligenzsysteme, d. h. unvorhersehbare Fehler und das Fehlen einer robusten Verallgemeinerung, ein Schlüsselindikator für die Bewertung des KI-Verständnisses.

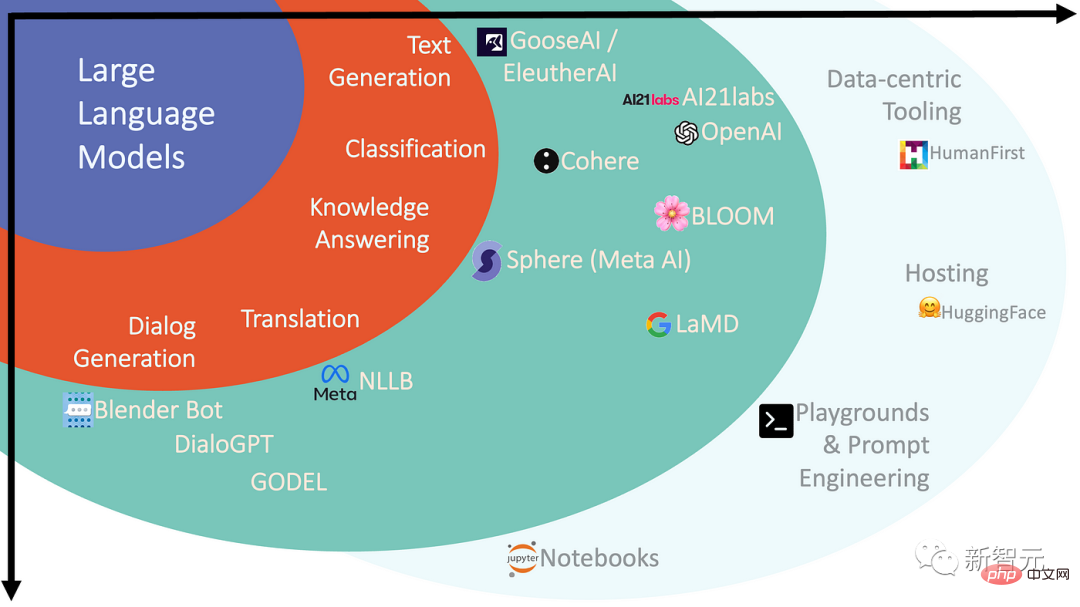

In den letzten Jahren sind das Publikum und der Einfluss großer Sprachmodelle (LLMs) im Bereich der künstlichen Intelligenz stark gestiegen, und dies hat auch die Ansichten einiger Menschen über die Aussichten des maschinellen Sprachverständnisses verändert.

Groß angelegte Pre-Training-Modelle, auch Grundlagenmodelle genannt, sind tiefe neuronale Netze mit Milliarden bis Billionen Parametern (Gewichten), die auf massive Korpora natürlicher Sprache (einschließlich Online-Texten, Online-Büchern usw.) angewendet werden. Erhalten nach „ Vorschulung“.

Die Aufgabe des Modells während des Trainings besteht darin, die fehlenden Teile des Eingabesatzes vorherzusagen. Daher wird diese Methode auch als „selbstüberwachtes Lernen“ bezeichnet. Das resultierende Netzwerk ist ein komplexes statistisches Modell, das die Wörter im Eingabesatz erhalten kann Trainingsdaten und wie sich Phrasen zueinander verhalten.

Dieses Modell kann zur Generierung natürlicher Sprache verwendet und für bestimmte Aufgaben in natürlicher Sprache verfeinert oder weiter trainiert werden, um der „Benutzerabsicht“ besser zu entsprechen. Aber für Laien und Wissenschaftler: Was genau ist ein Sprachmodell? Wie diese Aufgaben bewältigt werden, bleibt ein Rätsel.

Das Innenleben neuronaler Netze ist weitgehend undurchsichtig, und selbst die Forscher, die diese Netze aufbauen, haben nur begrenzte Intuition für Systeme dieser Größenordnung.

Der Neurowissenschaftler Terrence Sejnowski beschreibt die Emergenzfähigkeit von LLMs so:

Nach dem Durchbrechen einer bestimmten Schwelle ist es, als ob Außerirdische plötzlich auftauchen und auf schreckliche, menschliche Weise eingesetzt werden können der Kommunikation mit uns. Im Moment ist nur eines klar: Große Sprachmodelle sind nicht menschlich, einige Aspekte ihres Verhaltens scheinen intelligent zu sein, aber wenn nicht menschliche Intelligenz, was ist dann die Natur ihrer Intelligenz?

Für Verständnis vs. Gegen Verständnis

Trotz der beeindruckenden Leistung großer Sprachmodelle sind hochmoderne LLMs immer noch anfällig für Sprödigkeit und nichtmenschliche Fehler.

Allerdings ist zu beobachten, dass sich die Netzwerkleistung mit der Erweiterung der Parameteranzahl und der Trainingskorpusgröße deutlich verbessert hat, was auch einige Forscher auf diesem Gebiet zu der Behauptung veranlasst hat, dass solange ein ausreichend großes Netzwerk vorhanden ist Netzwerk- und Trainingsdatensatz, Sprachmodell (multimodale Version) Vielleicht eine multimodale Version – wird zu Intelligenz und Verständnis auf menschlicher Ebene führen.

Ein neuer Slogan für künstliche Intelligenz ist aufgetaucht: Scale is all you need!

Diese Aussage spiegelt auch die Debatte über groß angelegte Sprachmodelle in der Forschungsgemeinschaft für künstliche Intelligenz wider:

Eine Denkrichtung glaubt, dass Sprachmodelle Sprache wirklich verstehen und allgemein argumentieren können (obwohl dies der Fall ist). (noch nicht das Niveau des Menschen erreicht).

Zum Beispiel ist das LaMDA-System von Google vorab auf Text trainiert und dann auf Konversationsaufgaben abgestimmt, sodass es in der Lage ist, Gespräche mit Benutzern in einem sehr breiten Spektrum von Domänen zu führen.

Die andere Schule glaubt, dass große vorab trainierte Modelle wie GPT-3 oder LaMDA, egal wie fließend ihre Sprachausgabe ist, kein Verständnis besitzen können, weil diese Modelle keine praktische Erfahrung und keine mentalen Modelle haben der Welt.

Sprachmodelle werden nur darauf trainiert, Wörter in einer großen Anzahl von Textsammlungen vorherzusagen, sodass sie die Form der Sprache lernen können, weit davon entfernt, die Bedeutung hinter der Sprache zu lernen.

Ein ausschließlich auf Sprache trainiertes System wird niemals an die menschliche Intelligenz herankommen, selbst wenn es von nun an bis zum Tod des Universums trainiert wird. Es ist klar, dass diese Systeme nur für ein oberflächliches Verständnis geeignet sind und niemals annähernd an das ganzheitliche Denken des Menschen herankommen werden.

Ein anderer Wissenschaftler glaubt, dass das Verständnis von Intelligenz, Agenten und im weiteren Sinne falsch ist, wenn man über diese Systeme spricht, und dass Sprachmodelle tatsächlich komprimierte Speicher menschlichen Wissens sind, die eher einer Bibliothek oder Enzyklopädie als einem Agenten ähneln.

Zum Beispiel wissen Menschen, was „Juckreiz“ bedeutet, wenn es uns zum Lachen bringt, weil wir ein Sprachmodell haben, das das Wort „Juckreiz“ verwenden kann, aber dieses Gefühl hat er offensichtlich nicht erlebt um ein Wort in ein Gefühl umzuwandeln und nicht in ein anderes Wort.

Diejenigen auf der Seite „LLMs verstehen nicht“ argumentieren, dass die Sprachkompetenz großer Sprachmodelle zwar überraschend ist, unsere Überraschung jedoch unsere mangelnde Intuition darüber widerspiegelt, welche statistischen Korrelationen auf der Skala dieser Modelle entstehen können.

Eine Umfrage aus dem Jahr 2022 unter aktiven Forschern in der Community zur Verarbeitung natürlicher Sprache zeigt deutliche Spaltungen in dieser Debatte.

Als 480 Befragte gefragt wurden, ob sie der Aussage zustimmen, dass LLMs Sprache grundsätzlich verstehen können, dass „generative Sprachmodelle, die nur auf Text trainiert werden, in gewisser Weise natürliche Sprache verstehen können“, lauteten die Umfrageergebnisse waren gleichmäßig geteilter Meinung, wobei die Hälfte (51 %) zustimmte und die andere Hälfte (49 %) nicht zustimmte.

Maschinelles Verständnis unterscheidet sich vom menschlichen Verständnis

Obwohl beide Seiten der „LLM-Verständnisfähigkeit“-Debatte über ausreichende Intuition verfügen, um ihre jeweiligen Ansichten zu stützen, reichen die derzeit verfügbaren kognitionswissenschaftlichen Methoden zur Erlangung eines tieferen Verständnisses nicht aus, um die Frage zu beantworten Fragen wie diese zu LLM.

Tatsächlich haben einige Forscher psychologische Tests (ursprünglich zur Beurteilung menschlicher Verständnis- und Denkmechanismen konzipiert) auf LLMs angewendet und herausgefunden, dass LLMs in einigen Fällen bei Tests zur Theorie des Geistes menschenähnliche Reaktionen zeigen und menschlich- wie Fähigkeiten und Vorurteile bei der Beurteilung von Argumenten.

Während diese Tests als zuverlässige Mittel zur Beurteilung menschlicher Generalisierungsfähigkeiten gelten, ist dies bei Systemen der künstlichen Intelligenz möglicherweise nicht der Fall.

Große Sprachmodelle verfügen über eine besondere Fähigkeit, Korrelationen zwischen ihren Trainingsdaten und Token in der Eingabe zu lernen und können diese Korrelation zur Lösung von Problemen verwenden. Stattdessen verwenden Menschen eine Komprimierung, die ihr reales Erfahrungskonzept widerspiegelt.

Bei der Anwendung von für Menschen konzipierten Tests auf LLMs kann die Interpretation der Ergebnisse auf Annahmen über die menschliche Kognition beruhen, die für diese Modelle möglicherweise einfach nicht zutreffen.

Um Fortschritte zu erzielen, müssen Wissenschaftler neue Benchmarks und Erkennungsmethoden entwickeln, um die Mechanismen verschiedener Arten von Intelligenz und Verständnis zu verstehen, einschließlich der neuen Formen „bizarrer, gedankenähnlicher Wesenheiten“, die wir derzeit geschaffen haben Es gab auch einige verwandte Arbeiten.

Da Modelle größer werden und leistungsfähigere Systeme entwickelt werden, betont die Debatte über das Verstehen in LLMs die Notwendigkeit, „unsere Wissenschaft der Intelligenz zu erweitern“, damit „Verstehen“ sinnvoll ist, sowohl für Menschen als auch für Maschinen.

Der Neurowissenschaftler Terrence Sejnowski weist darauf hin, dass die unterschiedlichen Meinungen der Experten zur Intelligenz von LLMs zeigen, dass unsere alten, auf natürlicher Intelligenz basierenden Vorstellungen nicht ausreichen.

Wenn LLMs und verwandte Modelle durch die Nutzung statistischer Korrelationen in einem beispiellosen Ausmaß erfolgreich sein können, können sie vielleicht als eine „neue Form des Verstehens“ betrachtet werden, die außergewöhnliche, übermenschliche Vorhersagefähigkeiten ermöglicht, wie die Systeme AlphaZero und AlphaFold von DeepMind , die eine „exotische“ Form der Intuition in die Bereiche Schachspiel bzw. Proteinstrukturvorhersage bringen.

Man kann also sagen, dass der Bereich der künstlichen Intelligenz in den letzten Jahren Maschinen mit neuen Verständnismethoden geschaffen hat, höchstwahrscheinlich ein völlig neues Konzept, und diese neuen Konzepte sind wichtig, da wir bei der Verfolgung des Ziels Fortschritte machen Die schwer fassbare Natur der Intelligenz wird weiterhin bereichert.

Probleme, die eine große Menge an codiertem Wissen erfordern und hohe Leistungsanforderungen stellen, werden weiterhin die Entwicklung groß angelegter statistischer Modelle fördern, während Probleme mit begrenztem Wissen und starken Kausalmechanismen für das Verständnis der menschlichen Intelligenz von Vorteil sein werden.

Die Herausforderung für die Zukunft besteht darin, neue wissenschaftliche Methoden zu entwickeln, um das detaillierte Verständnis verschiedener Formen der Intelligenz offenzulegen, ihre Stärken und Grenzen zu erkennen und zu lernen, wie man diese wirklich unterschiedlichen kognitiven Modi integriert.

Referenz:

https://www.pnas.org/doi/10.1073/pnas.2215907120

Das obige ist der detaillierte Inhalt vonWas für ein Lärm! Versteht ChatGPT die Sprache? PNAS: Lassen Sie uns zunächst untersuchen, was „Verstehen' ist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

3 Möglichkeiten, die Sprache auf dem iPhone zu ändern

Feb 02, 2024 pm 04:12 PM

3 Möglichkeiten, die Sprache auf dem iPhone zu ändern

Feb 02, 2024 pm 04:12 PM

Es ist kein Geheimnis, dass das iPhone eines der benutzerfreundlichsten elektronischen Geräte ist, und einer der Gründe dafür ist, dass es ganz einfach nach Ihren Wünschen personalisiert werden kann. In der Personalisierung können Sie die Sprache auf eine andere Sprache ändern als die, die Sie beim Einrichten Ihres iPhones ausgewählt haben. Wenn Sie mit mehreren Sprachen vertraut sind oder die Spracheinstellung Ihres iPhones falsch ist, können Sie sie wie unten erläutert ändern. So ändern Sie die Sprache des iPhone [3 Methoden] iOS ermöglicht Benutzern, die bevorzugte Sprache auf dem iPhone frei zu wechseln, um sie an unterschiedliche Bedürfnisse anzupassen. Sie können die Sprache der Interaktion mit Siri ändern, um die Kommunikation mit dem Sprachassistenten zu erleichtern. Gleichzeitig können Sie bei Verwendung der lokalen Tastatur problemlos zwischen mehreren Sprachen wechseln, um die Eingabeeffizienz zu verbessern.

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

Wie stelle ich die Sprache des Win10-Computers auf Chinesisch ein?

Jan 05, 2024 pm 06:51 PM

Wie stelle ich die Sprache des Win10-Computers auf Chinesisch ein?

Jan 05, 2024 pm 06:51 PM

Manchmal installieren wir einfach das Computersystem und stellen fest, dass das System auf Englisch ist. In diesem Fall müssen wir die Computersprache im Win10-System auf Chinesisch ändern . So ändern Sie die Computersprache in Win10 auf Chinesisch 1. Schalten Sie den Computer ein und klicken Sie auf die Startschaltfläche in der unteren linken Ecke. 2. Klicken Sie links auf die Einstellungsoption. 3. Wählen Sie auf der sich öffnenden Seite „Zeit und Sprache“. 4. Klicken Sie nach dem Öffnen links auf „Sprache“. 5. Hier können Sie die gewünschte Computersprache einstellen.

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

So entwickeln Sie einen intelligenten Chatbot mit ChatGPT und Java

Oct 28, 2023 am 08:54 AM

In diesem Artikel stellen wir vor, wie man intelligente Chatbots mit ChatGPT und Java entwickelt, und stellen einige spezifische Codebeispiele bereit. ChatGPT ist die neueste Version des von OpenAI entwickelten Generative Pre-Training Transformer, einer auf neuronalen Netzwerken basierenden Technologie für künstliche Intelligenz, die natürliche Sprache verstehen und menschenähnlichen Text generieren kann. Mit ChatGPT können wir ganz einfach adaptive Chats erstellen

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

Kann Chatgpt in China verwendet werden?

Mar 05, 2024 pm 03:05 PM

chatgpt kann in China verwendet werden, kann jedoch nicht registriert werden. Wenn Benutzer sich registrieren möchten, können sie zur Registrierung eine ausländische Mobiltelefonnummer verwenden. Beachten Sie, dass während des Registrierungsprozesses auf die Netzwerkumgebung umgestellt werden muss eine fremde IP.

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So erstellen Sie einen intelligenten Kundendienstroboter mit ChatGPT PHP

Oct 28, 2023 am 09:34 AM

So bauen Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter. Einführung: Mit der Entwicklung der Technologie der künstlichen Intelligenz werden Roboter zunehmend im Bereich Kundendienst eingesetzt. Der Einsatz von ChatGPTPHP zum Aufbau eines intelligenten Kundendienstroboters kann Unternehmen dabei helfen, effizientere und personalisiertere Kundendienste anzubieten. In diesem Artikel wird erläutert, wie Sie mit ChatGPTPHP einen intelligenten Kundendienstroboter erstellen, und es werden spezifische Codebeispiele bereitgestellt. 1. Installieren Sie ChatGPTPHP und nutzen Sie ChatGPTPHP, um einen intelligenten Kundendienstroboter aufzubauen.

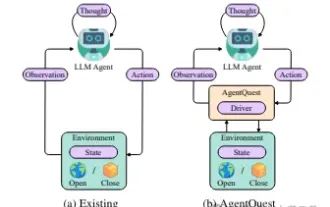

Erkundung der Grenzen von Agenten: AgentQuest, ein modulares Benchmark-Framework zur umfassenden Messung und Verbesserung der Leistung großer Sprachmodellagenten

Apr 11, 2024 pm 08:52 PM

Erkundung der Grenzen von Agenten: AgentQuest, ein modulares Benchmark-Framework zur umfassenden Messung und Verbesserung der Leistung großer Sprachmodellagenten

Apr 11, 2024 pm 08:52 PM

Basierend auf der kontinuierlichen Optimierung großer Modelle haben LLM-Agenten – diese leistungsstarken algorithmischen Einheiten – das Potenzial gezeigt, komplexe mehrstufige Argumentationsaufgaben zu lösen. Von der Verarbeitung natürlicher Sprache bis hin zum Deep Learning rücken LLM-Agenten nach und nach in den Fokus von Forschung und Industrie. Sie können nicht nur menschliche Sprache verstehen und generieren, sondern auch Strategien formulieren, Aufgaben in verschiedenen Umgebungen ausführen und sogar API-Aufrufe und Codierung zum Erstellen verwenden Lösungen. In diesem Zusammenhang ist die Einführung des AgentQuest-Frameworks ein Meilenstein. Es bietet nicht nur eine modulare Benchmarking-Plattform für die Bewertung und Weiterentwicklung von LLM-Agenten, sondern bietet Forschern auch leistungsstarke Tools, um die Leistung dieser Agenten gleichzeitig zu verfolgen und zu verbessern granularerer Ebene