Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

HuggingGPT ist beliebt: Ein ChatGPT steuert alle KI-Modelle und hilft Menschen automatisch bei der Erledigung von KI-Aufgaben. Netizens: Lassen Sie Ihren Mund essen.

HuggingGPT ist beliebt: Ein ChatGPT steuert alle KI-Modelle und hilft Menschen automatisch bei der Erledigung von KI-Aufgaben. Netizens: Lassen Sie Ihren Mund essen.

HuggingGPT ist beliebt: Ein ChatGPT steuert alle KI-Modelle und hilft Menschen automatisch bei der Erledigung von KI-Aufgaben. Netizens: Lassen Sie Ihren Mund essen.

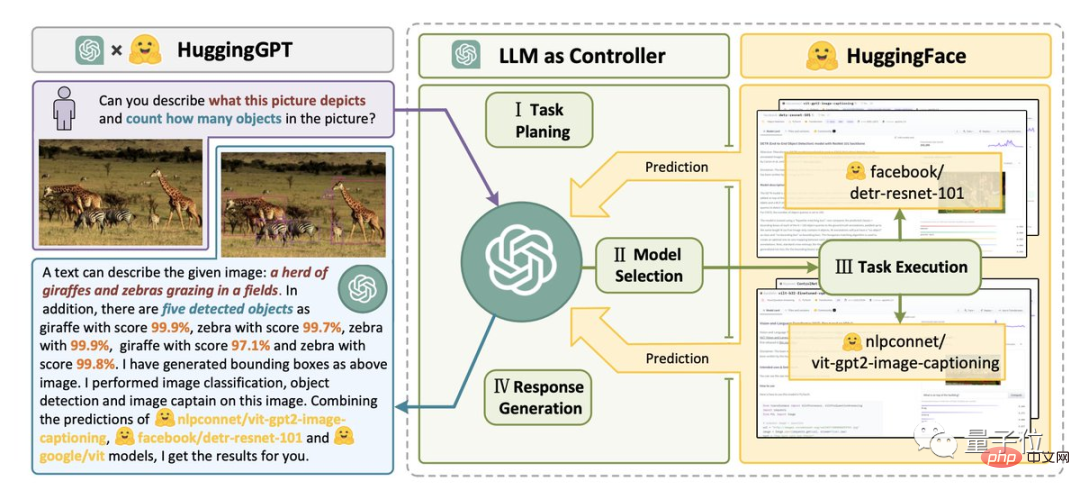

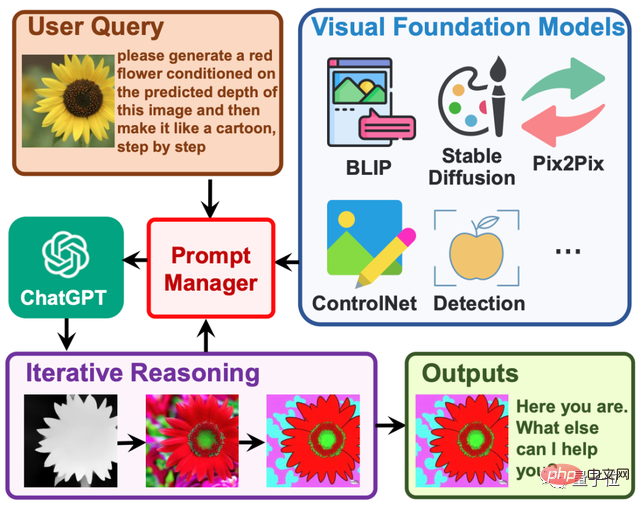

Die stärkste Kombination: HuggingFace+ChatGPT——

HuggingGPT, sie ist da!

Geben Sie einfach eine KI-Aufgabe, z. B. „Welche Tiere sind auf dem Bild unten und wie viele von jeder Art gibt es?“

Es kann Ihnen dabei helfen, automatisch zu analysieren, welche KI-Modelle benötigt werden, und dann das entsprechende Modell direkt auf HuggingFace aufzurufen, um Sie bei der Ausführung und Vervollständigung zu unterstützen.

Im gesamten Prozess müssen Sie lediglich Ihre Anforderungen in natürlicher Sprache ausgeben.

Dieses Ergebnis der Zusammenarbeit zwischen der Zhejiang-Universität und Microsoft Research Asia wurde sofort nach seiner Veröffentlichung schnell populär.

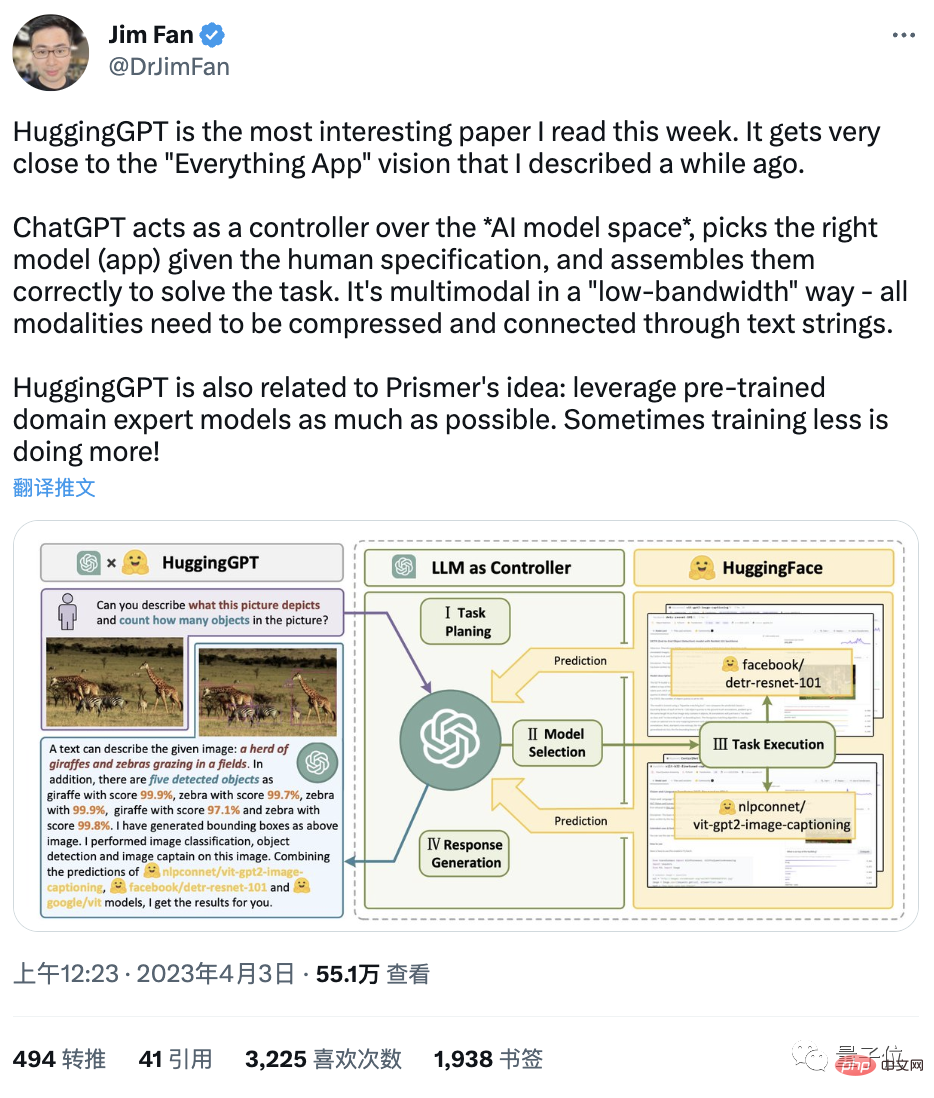

Der NVIDIA-KI-Forscher Jim Fan sagte direkt:

Das ist der interessanteste Artikel, den ich diese Woche gelesen habe. Seine Idee kommt der „Everything App“ sehr nahe (alles ist eine App und Informationen werden direkt von der KI gelesen).

Und ein Internetnutzer „schlägt sich direkt auf den Oberschenkel“:

Ist das nicht der „Pakettransfer-Mann“ von ChatGPT?

KI entwickelt sich rasant weiter und hinterlässt uns etwas zu essen...

Also, was genau ist los?

HuggingGPT: Ihr KI-Modell „Hugging Man“

Wenn diese Kombination tatsächlich nur ein „Hugging Man“ ist, dann ist das Muster zu klein.

Seine wahre Bedeutung ist AGI.

Wie der Autor sagte, ist ein wichtiger Schritt in Richtung AGI die Fähigkeit, komplexe KI-Aufgaben mit unterschiedlichen Domänen und Modi zu lösen.

Davon sind unsere aktuellen Ergebnisse noch weit entfernt – viele Modelle können nur eine bestimmte Aufgabe gut erfüllen.

Die Leistung des LLM für große Sprachmodelle in Bezug auf Sprachverständnis, -generierung, -interaktion und -schlussfolgerung brachte den Autor jedoch zum Nachdenken:

Sie können als Zwischencontroller zur Verwaltung aller vorhandenen KI-Modelle verwendet werden, indem sie „alle mobilisieren und kombinieren“. of AI“ zur Lösung komplexer KI-Aufgaben.

In diesem System ist die Sprache die universelle Schnittstelle.

So wurde HuggingGPT geboren.

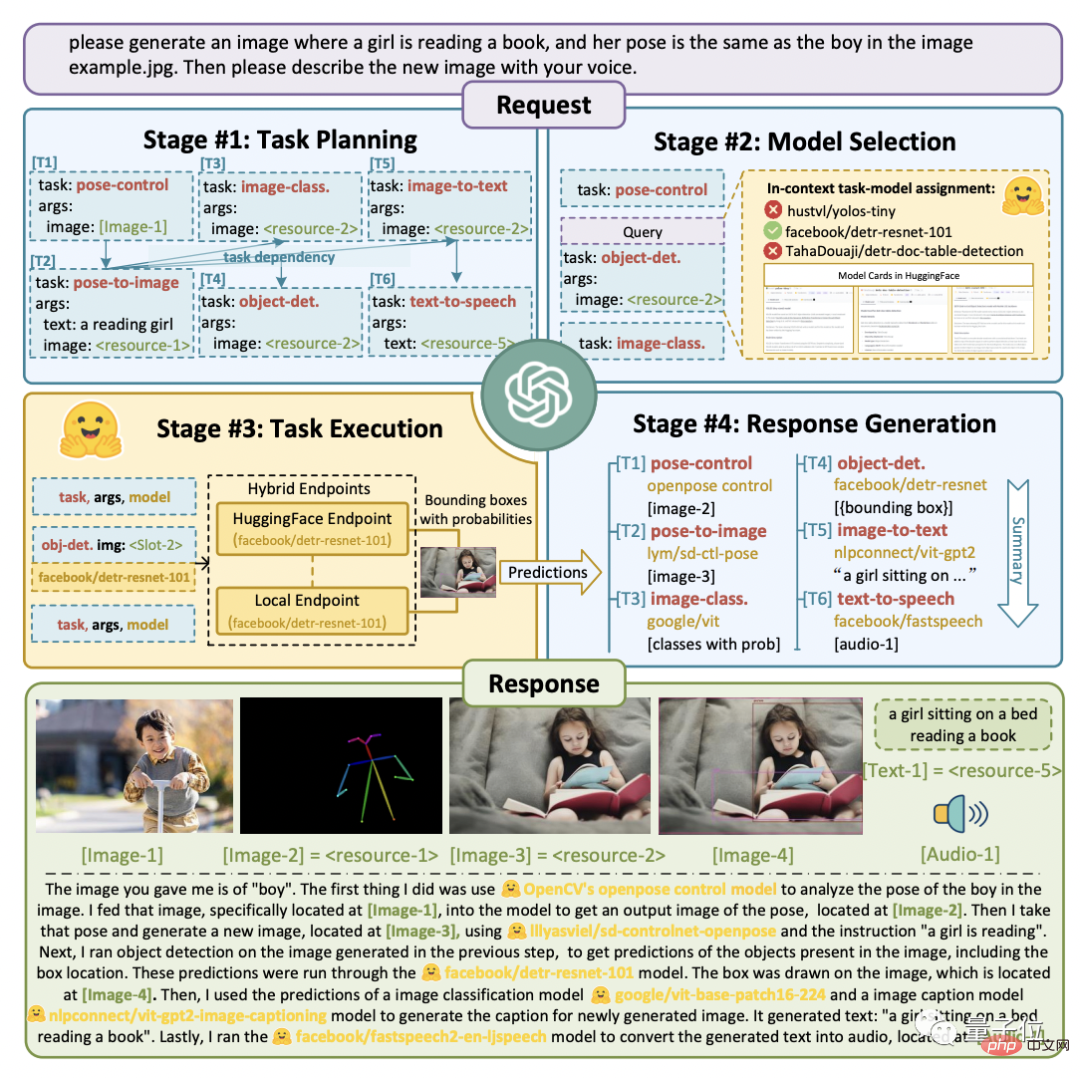

Der Engineering-Prozess ist in vier Schritte unterteilt:

Erstens die Aufgabenplanung. ChatGPT analysiert die Anforderungen des Benutzers in einer Aufgabenliste und bestimmt die Ausführungsreihenfolge und Ressourcenabhängigkeiten zwischen Aufgaben.

Zweitens die Modellauswahl. ChatGPT weist Aufgaben geeignete Modelle zu, basierend auf den Beschreibungen jedes auf HuggingFace gehosteten Expertenmodells.

Dann wird die Aufgabe ausgeführt. Das ausgewählte Expertenmodell auf dem Hybridendpunkt (einschließlich lokaler Inferenz und HuggingFace-Inferenz) führt die zugewiesenen Aufgaben gemäß der Aufgabensequenz und den Abhängigkeiten aus und gibt die Ausführungsinformationen und Ergebnisse an ChatGPT weiter.

Zum Schluss die Ergebnisse ausgeben. ChatGPT fasst die Ausführungsprozessprotokolle und Inferenzergebnisse jedes Modells zusammen und gibt die endgültige Ausgabe aus.

Wie im Bild unten gezeigt.

Angenommen, wir stellen eine solche Anfrage:

Bitte erstellen Sie ein Bild eines Mädchens, das ein Buch liest. Ihre Haltung ist die gleiche wie die des Jungen in example.jpg. Beschreiben Sie dann mit Ihrer Stimme das neue Bild.

Sie können sehen, wie HuggingGPT es in 6 Unteraufgaben zerlegt und das jeweils auszuführende Modell auswählt, um das Endergebnis zu erhalten.

Was ist die konkrete Wirkung?

Der Autor führte tatsächliche Messungen mit gpt-3.5-turbo und text-davinci-003 durch, zwei Varianten, auf die über die OpenAI-API öffentlich zugegriffen werden kann.

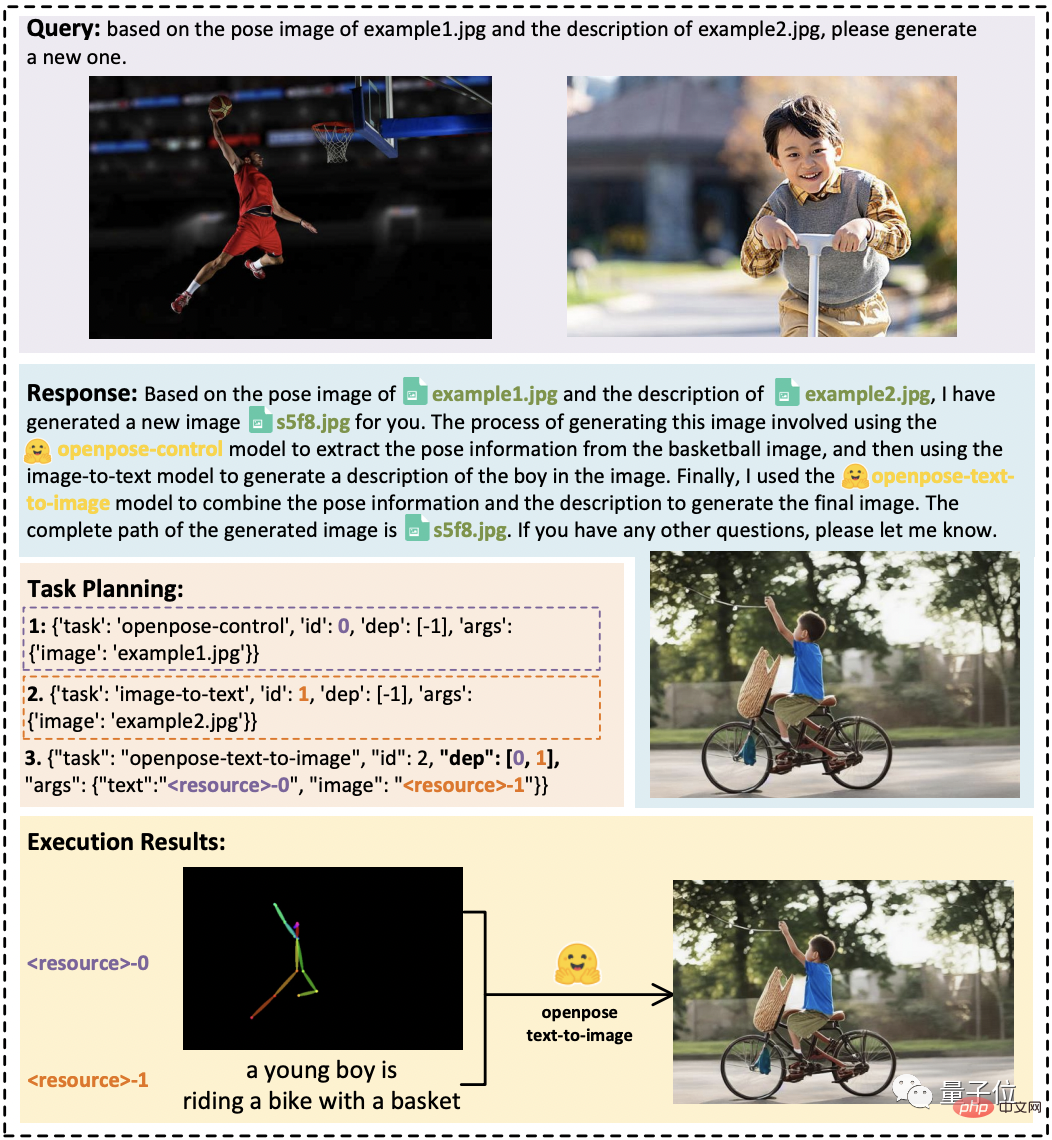

Wie in der folgenden Abbildung dargestellt:

Wenn zwischen Aufgaben Ressourcenabhängigkeiten bestehen, kann HuggingGPT die spezifischen Aufgaben entsprechend der abstrakten Anforderung des Benutzers korrekt analysieren und die Bildkonvertierung abschließen.

In Audio- und Videoaufgaben wurde auch die Fähigkeit demonstriert, die Zusammenarbeit zwischen Modellen zu organisieren, indem die beiden Modelle parallel bzw. seriell ausgeführt wurden, ein Video von „Astronauts Walking in Space“ und Dubbing funktioniert.

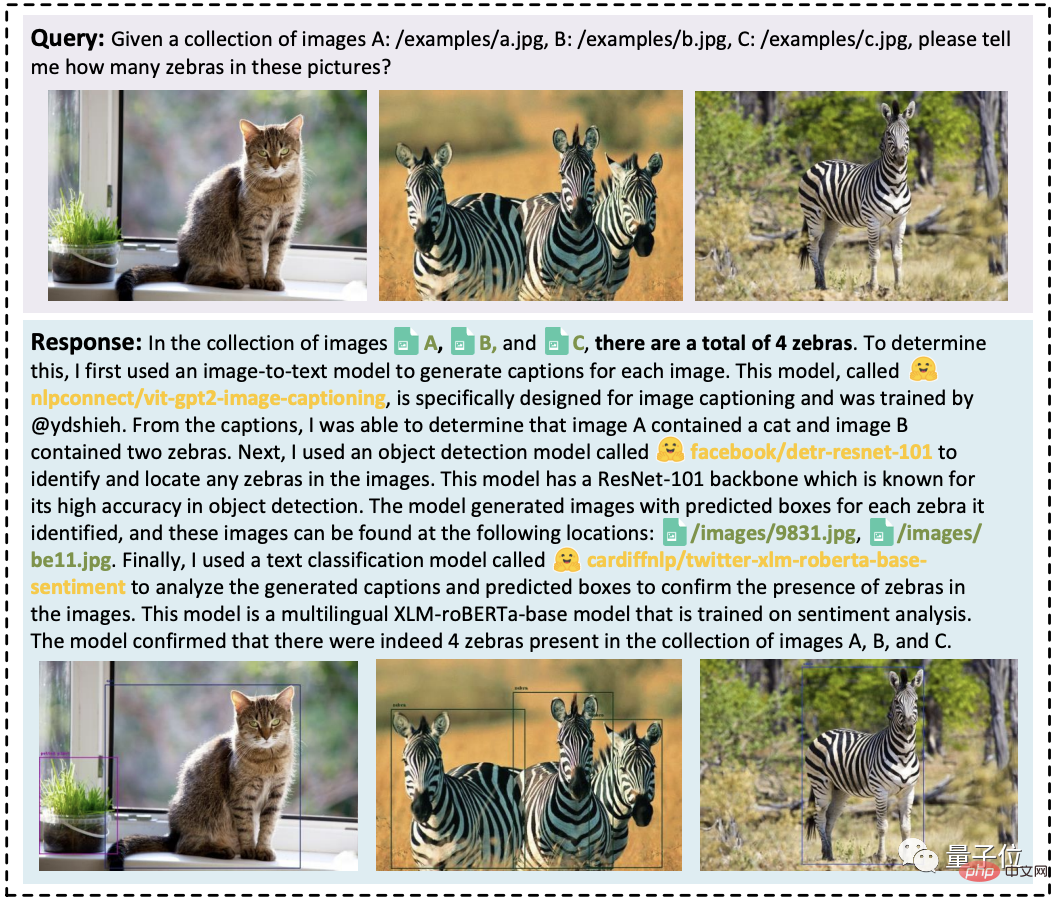

Darüber hinaus können Eingaberessourcen mehrerer Benutzer integriert werden, um einfache Überlegungen anzustellen, beispielsweise um zu zählen, wie viele Zebras sich auf den folgenden drei Bildern befinden.

Zusammenfassung in einem Satz: HuggingGPT kann bei verschiedenen Formen komplexer Aufgaben gute Leistungen zeigen.

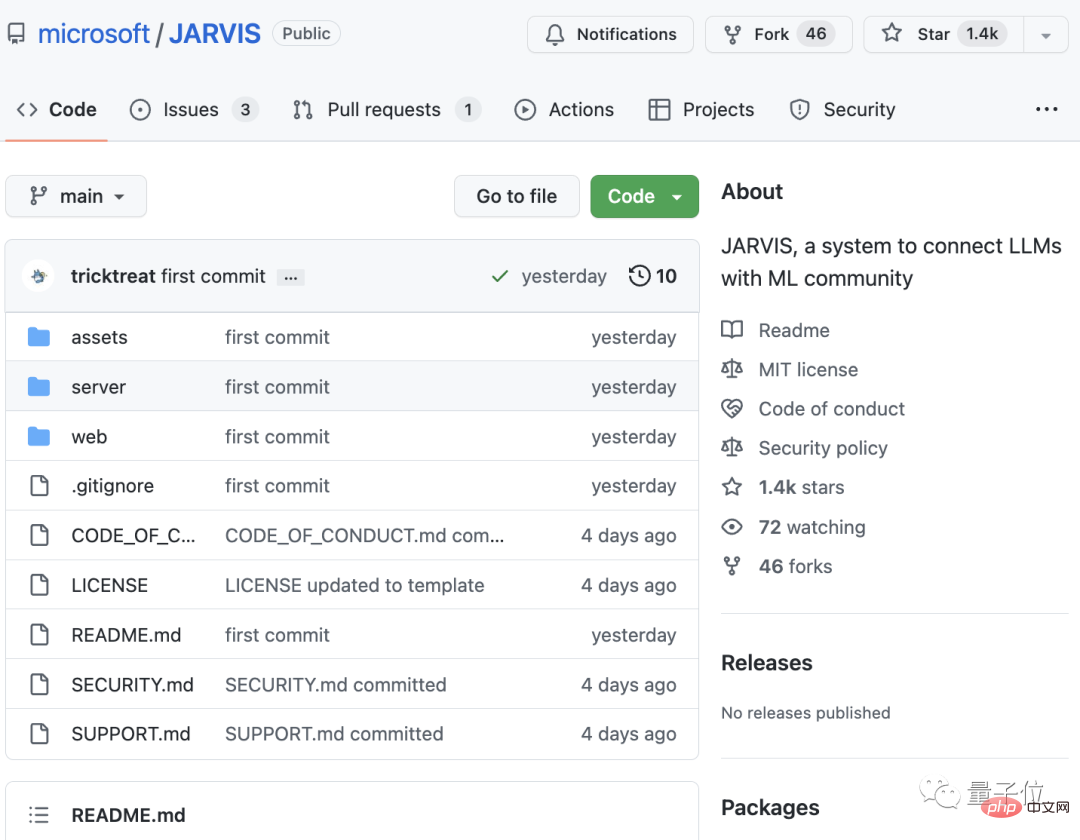

Das Projekt ist Open Source und heißt „Jarvis“.

Derzeit ist der Artikel von HuggingGPT veröffentlicht und das Projekt befindet sich im Aufbau. Nur ein Teil des Codes ist Open Source und hat 1,4.000 Sterne erhalten.

Uns ist aufgefallen, dass der Projektname nicht HuggingGPT heißt, sondern der KI-Butler JARVIS in Iron Man.

Einige Leute haben festgestellt, dass die Idee davon dem gerade im März veröffentlichten Visual ChatGPT sehr ähnlich ist: Letzteres HuggingGPT, hauptsächlich wurde der Umfang der aufrufbaren Modelle um mehr erweitert, einschließlich Menge und Typ.

Ja, tatsächlich haben sie alle einen gemeinsamen Autor: das Microsoft Asia Research Institute.

Konkret ist der erste Autor von Visual ChatGPT der leitende MSRA-Forscher Wu Chenfei, und der korrespondierende Autor ist der leitende MSRA-Forscher Duan Nan. Zu

HuggingGPT gehören zwei Co-Autoren:

Shen Yongliang, der von der Zhejiang-Universität kommt und diese Arbeit während seines Praktikums bei MSRA abgeschlossen hat;

Song Kaitao, ein Forscher bei MSRA.

Der korrespondierende Autor ist Zhuang Yueting, Professor der Fakultät für Informatik der Zhejiang-Universität.

Abschließend sind die Internetnutzer sehr aufgeregt über die Geburt dieses leistungsstarken neuen Tools. Einige Leute sagten:

ChatGPT ist zum Oberbefehlshaber aller von Menschen geschaffenen KI geworden.

Manche Leute glauben auch, dass

AGI möglicherweise kein LLM ist, sondern mehrere miteinander verbundene Modelle, die durch einen „Zwischenhändler“-LLM verbunden sind.

Haben wir also die Ära der „Semi-AGI“ begonnen?

Papieradresse:https://www.php.cn/link/1ecdec353419f6d7e30857d00d0312d1

Projekt.Link:https://www.php.cn/link/859555c74e9afd 45ab 771c615c1e49a6

Referenzlink:https://www.php.cn/link/62d2b7ba91f34c0ac08aa11c359a8d2c

Das obige ist der detaillierte Inhalt vonHuggingGPT ist beliebt: Ein ChatGPT steuert alle KI-Modelle und hilft Menschen automatisch bei der Erledigung von KI-Aufgaben. Netizens: Lassen Sie Ihren Mund essen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

So setzen Sie die Debian Apache -Protokollebene fest

Apr 13, 2025 am 08:33 AM

In diesem Artikel wird beschrieben, wie Sie die Protokollierungsstufe des Apacheweb -Servers im Debian -System anpassen. Durch Ändern der Konfigurationsdatei können Sie die ausführliche Ebene der von Apache aufgezeichneten Protokollinformationen steuern. Methode 1: Ändern Sie die Hauptkonfigurationsdatei, um die Konfigurationsdatei zu finden: Die Konfigurationsdatei von Apache2.x befindet sich normalerweise im Verzeichnis/etc/apache2/. Der Dateiname kann je nach Installationsmethode Apache2.conf oder httpd.conf sein. Konfigurationsdatei bearbeiten: Öffnen Sie die Konfigurationsdatei mit Stammberechtigungen mit einem Texteditor (z. B. Nano): Sudonano/etc/apache2/apache2.conf

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

So optimieren Sie die Leistung von Debian Readdir

Apr 13, 2025 am 08:48 AM

In Debian -Systemen werden Readdir -Systemaufrufe zum Lesen des Verzeichnisinhalts verwendet. Wenn seine Leistung nicht gut ist, probieren Sie die folgende Optimierungsstrategie aus: Vereinfachen Sie die Anzahl der Verzeichnisdateien: Teilen Sie große Verzeichnisse so weit wie möglich in mehrere kleine Verzeichnisse auf und reduzieren Sie die Anzahl der gemäß Readdir -Anrufe verarbeiteten Elemente. Aktivieren Sie den Verzeichnis -Inhalt Caching: Erstellen Sie einen Cache -Mechanismus, aktualisieren Sie den Cache regelmäßig oder bei Änderungen des Verzeichnisinhalts und reduzieren Sie häufige Aufrufe an Readdir. Speicher -Caches (wie Memcached oder Redis) oder lokale Caches (wie Dateien oder Datenbanken) können berücksichtigt werden. Nehmen Sie eine effiziente Datenstruktur an: Wenn Sie das Verzeichnis -Traversal selbst implementieren, wählen Sie effizientere Datenstrukturen (z.

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

So implementieren Sie die Dateisortierung nach Debian Readdir

Apr 13, 2025 am 09:06 AM

In Debian -Systemen wird die Readdir -Funktion zum Lesen des Verzeichnisinhalts verwendet, aber die Reihenfolge, in der sie zurückgibt, ist nicht vordefiniert. Um Dateien in einem Verzeichnis zu sortieren, müssen Sie zuerst alle Dateien lesen und dann mit der QSORT -Funktion sortieren. Der folgende Code zeigt, wie Verzeichnisdateien mithilfe von Readdir und QSORT in Debian System sortiert werden:#include#include#include#include // benutzerdefinierte Vergleichsfunktion, verwendet für QSortIntCompare (constvoid*a, constvoid*b) {rettrcmp (*(*(*(

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Debian Mail Server Firewall -Konfigurationstipps

Apr 13, 2025 am 11:42 AM

Das Konfigurieren der Firewall eines Debian -Mailservers ist ein wichtiger Schritt zur Gewährleistung der Serversicherheit. Im Folgenden sind mehrere häufig verwendete Firewall -Konfigurationsmethoden, einschließlich der Verwendung von Iptables und Firewalld. Verwenden Sie Iptables, um Firewall so zu konfigurieren, dass Iptables (falls bereits installiert) installiert werden:

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Debian Mail Server SSL -Zertifikat -Installationsmethode

Apr 13, 2025 am 11:39 AM

Die Schritte zur Installation eines SSL -Zertifikats auf dem Debian Mail -Server sind wie folgt: 1. Installieren Sie zuerst das OpenSSL -Toolkit und stellen Sie sicher, dass das OpenSSL -Toolkit bereits in Ihrem System installiert ist. Wenn nicht installiert, können Sie den folgenden Befehl installieren: sudoapt-getupdatesudoapt-getinstallopenssl2. Generieren Sie den privaten Schlüssel und die Zertifikatanforderung als nächst

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Wie Debian Readdir sich in andere Tools integriert

Apr 13, 2025 am 09:42 AM

Die Readdir -Funktion im Debian -System ist ein Systemaufruf, der zum Lesen des Verzeichnisgehalts verwendet wird und häufig in der C -Programmierung verwendet wird. In diesem Artikel wird erläutert, wie Readdir in andere Tools integriert wird, um seine Funktionalität zu verbessern. Methode 1: Kombinieren Sie C -Sprachprogramm und Pipeline zuerst ein C -Programm, um die Funktion der Readdir aufzurufen und das Ergebnis auszugeben:#include#include#includeIntmain (intargc, char*argv []) {Dir*Dir; structDirent*Eintrag; if (argc! = 2) {{

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

Wie Debian OpenSSL verhindert, dass Mann-in-the-Middle-Angriffe

Apr 13, 2025 am 10:30 AM

In Debian Systems ist OpenSSL eine wichtige Bibliothek für Verschlüsselung, Entschlüsselung und Zertifikatverwaltung. Um einen Mann-in-the-Middle-Angriff (MITM) zu verhindern, können folgende Maßnahmen ergriffen werden: Verwenden Sie HTTPS: Stellen Sie sicher, dass alle Netzwerkanforderungen das HTTPS-Protokoll anstelle von HTTP verwenden. HTTPS verwendet TLS (Transport Layer Security Protocol), um Kommunikationsdaten zu verschlüsseln, um sicherzustellen, dass die Daten während der Übertragung nicht gestohlen oder manipuliert werden. Überprüfen Sie das Serverzertifikat: Überprüfen Sie das Serverzertifikat im Client manuell, um sicherzustellen, dass es vertrauenswürdig ist. Der Server kann manuell durch die Delegate -Methode der URLSession überprüft werden

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wie man Debian Hadoop Log Management macht

Apr 13, 2025 am 10:45 AM

Wenn Sie Hadoop-Protokolle auf Debian verwalten, können Sie die folgenden Schritte und Best Practices befolgen: Protokollaggregation Aktivieren Sie die Protokollaggregation: Set Garn.log-Aggregation-Enable in true in der Datei marn-site.xml, um die Protokollaggregation zu aktivieren. Konfigurieren von Protokoll-Retentionsrichtlinien: Setzen Sie Garn.log-Aggregation.Retain-Sekunden, um die Retentionszeit des Protokolls zu definieren, z. B. 172800 Sekunden (2 Tage). Log Speicherpfad angeben: über Garn.n