Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Hat das Sprachmodell gelernt, selbstständig Suchmaschinen zu nutzen? Meta AI schlägt die selbstüberwachte Lernmethode Toolformer mit API-Aufruf vor

Hat das Sprachmodell gelernt, selbstständig Suchmaschinen zu nutzen? Meta AI schlägt die selbstüberwachte Lernmethode Toolformer mit API-Aufruf vor

Hat das Sprachmodell gelernt, selbstständig Suchmaschinen zu nutzen? Meta AI schlägt die selbstüberwachte Lernmethode Toolformer mit API-Aufruf vor

Bei Aufgaben zur Verarbeitung natürlicher Sprache haben große Sprachmodelle beeindruckende Ergebnisse beim Null-Schuss- und Wenig-Schuss-Lernen erzielt. Allerdings weisen alle Modelle inhärente Einschränkungen auf, die oft nur teilweise durch weitere Erweiterungen behoben werden können. Zu den Einschränkungen des Modells gehören insbesondere die Unfähigkeit, auf die neuesten Informationen zuzugreifen, die „Informationshalluzination“ von Fakten, die Schwierigkeit, ressourcenarme Sprachen zu verstehen, der Mangel an mathematischen Fähigkeiten für präzise Berechnungen usw.

Eine einfache Möglichkeit, diese Probleme zu lösen, besteht darin, das Modell mit externen Tools auszustatten, beispielsweise einer Suchmaschine, einem Taschenrechner oder einem Kalender. Bestehende Methoden beruhen jedoch häufig auf umfangreichen manuellen Anmerkungen oder beschränken den Einsatz von Werkzeugen auf bestimmte Aufgabeneinstellungen, wodurch die Verwendung von Sprachmodellen in Kombination mit externen Werkzeugen schwer zu verallgemeinern ist.

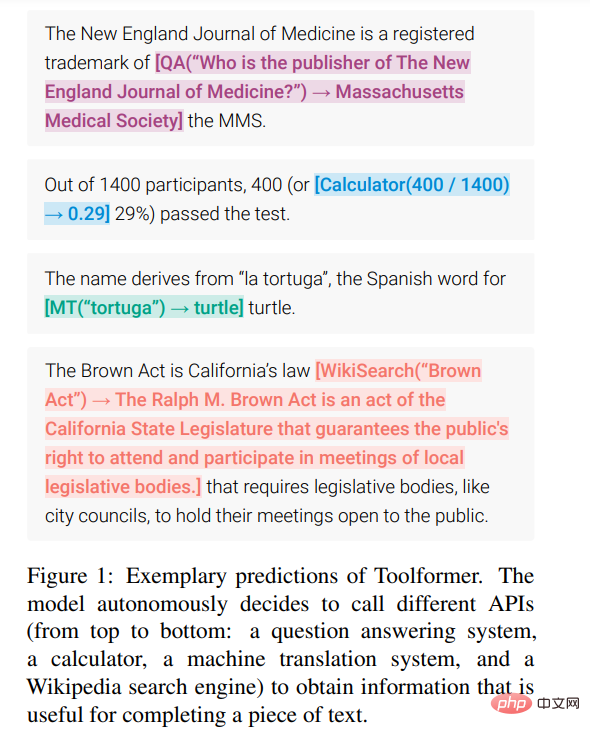

Um diesen Engpass zu überwinden, hat Meta AI kürzlich eine neue Methode namens Toolformer vorgeschlagen, mit der das Sprachmodell lernen kann, verschiedene externe Tools zu „verwenden“.

Papieradresse: https://arxiv.org/pdf/2302.04761v1.pdf

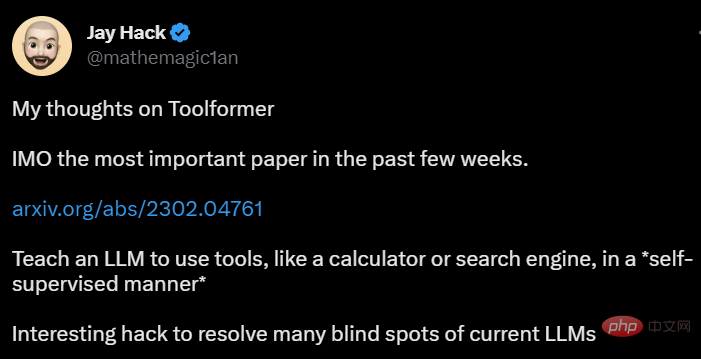

Toolformer erregte bald große Aufmerksamkeit, und einige Leute dachten, dass dieses Papier das Problem löste. Es gibt Derzeit gebe es viele Probleme mit großen Sprachmodellen, und er lobte: „Dies ist das wichtigste Papier der letzten Wochen.“

Jemand hat darauf hingewiesen, dass Toolformer selbstüberwachtes Lernen verwendet, damit große Sprachmodelle mit nur wenigen Beispielen lernen können, einige APIs und Tools zu verwenden, was sehr flexibel und effizient ist:

Manche Leute glauben sogar, dass Toolformer uns der künstlichen allgemeinen Intelligenz (AGI) einen Schritt näher bringen wird.

Toolformer erhält eine so hohe Bewertung, weil es die folgenden praktischen Anforderungen erfüllt:

- Große Sprachmodelle sollten die Verwendung von Werkzeugen selbstüberwacht erlernen und kein umfangreiches Handbuch erforderlich sein Anmerkung. Dies ist von entscheidender Bedeutung, da die Kosten für menschliche Anmerkungen hoch sind. Noch wichtiger ist jedoch, dass sich das, was Menschen für nützlich halten, von dem unterscheiden kann, was das Modell für nützlich hält.

- Sprachmodelle erfordern einen umfassenderen Einsatz von Werkzeugen, die nicht an eine bestimmte Aufgabe gebunden sind.

Dadurch wird der oben erwähnte Engpass deutlich aufgehoben. Werfen wir einen genaueren Blick auf die Methoden und experimentellen Ergebnisse von Toolformer.

Methode

Toolformer basiert auf der Idee, Datensätze von Grund auf zu generieren (Schick und Schütze, 2021b; Honovich et al., 2022; Wang et al., 2022) basierend auf großen Sprachmodellen mit in- Kontextlernen (ICL): Ausgehend von nur wenigen Beispielen von Menschen, die die API verwenden, können Sie LM einen riesigen Sprachmodellierungsdatensatz mit potenziellen API-Aufrufen annotieren lassen und dann eine selbstüberwachte Verlustfunktion verwenden, um zu bestimmen, welche API-Aufrufe tatsächlich zur Vorhersage des Modells beitragen zukünftige Token; und schließlich Feinabstimmung basierend auf API-Aufrufen, die für LM selbst nützlich sind.

Da Toolformer unabhängig vom verwendeten Datensatz ist, kann es für genau denselben Datensatz verwendet werden, auf dem das Modell vorab trainiert wurde, wodurch sichergestellt wird, dass das Modell keine Allgemeingültigkeit und Sprachmodellierungsfunktionen verliert.

Konkret besteht das Ziel dieser Forschung darin, dem Sprachmodell M die Möglichkeit zu geben, verschiedene Tools über API-Aufrufe zu verwenden. Dies erfordert, dass die Eingabe und Ausgabe jeder API als Textsequenzen charakterisiert werden kann. Dadurch können API-Aufrufe nahtlos in jeden beliebigen Text eingefügt werden, wobei spezielle Token verwendet werden, um den Anfang und das Ende jedes solchen Aufrufs zu markieren.

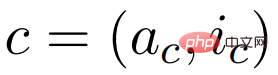

Die Studie stellt jeden API-Aufruf als Tupel dar

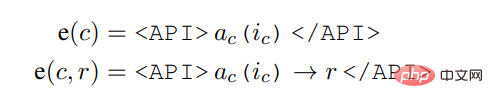

, wobei a_c der Name der API und i_c die entsprechende Eingabe ist. Bei einem API-Aufruf c mit entsprechendem Ergebnis r stellt diese Studie die linearisierte Folge von API-Aufrufen ohne und einschließlich ihres Ergebnisses wie folgt dar:

wobei,

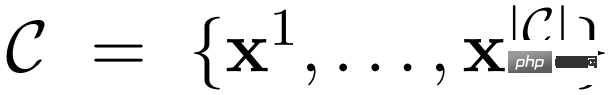

Anhand eines Datensatzes

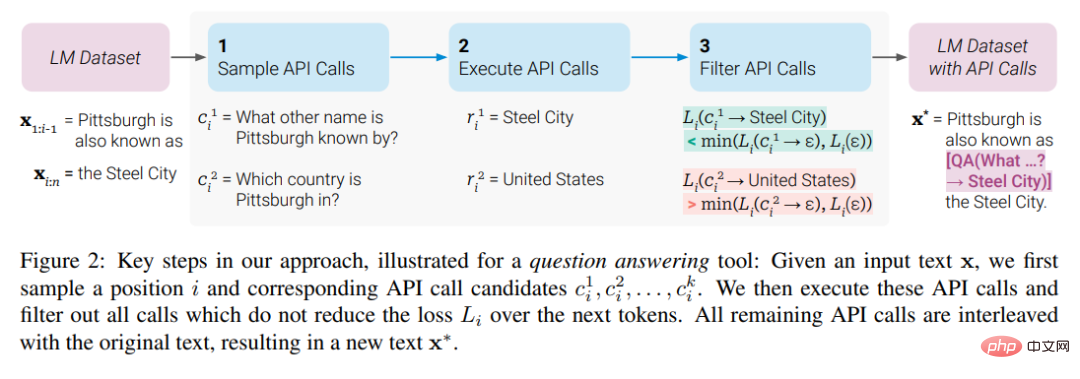

wandelte die Studie diesen Datensatz zunächst in einen Datensatz C* um, indem API-Aufrufe hinzugefügt wurden. Dies erfolgt in drei Schritten, wie in Abbildung 2 unten dargestellt: Zunächst nutzt die Studie die kontextbezogenen Lernfähigkeiten von M, um eine große Anzahl potenzieller API-Aufrufe abzutasten, führt dann diese API-Aufrufe aus und überprüft dann, ob die erhaltenen Antworten Vorhersagen unterstützen Zukünftiger Token, der als Filterkriterium verwendet werden soll. Nach der Filterung führt die Studie API-Aufrufe an verschiedene Tools zusammen, generiert letztendlich den Datensatz C* und optimiert M selbst an diesem Datensatz.

Experimente und Ergebnisse

In dieser Studie wurden Experimente zu verschiedenen nachgelagerten Aufgaben durchgeführt. Die Ergebnisse zeigen Folgendes: Toolformer (gelernt, verschiedene APIs zu verwenden) basiert auf dem vorab trainierten 6.7B-Parameter GPT-J-Modell und -Tools) übertrifft das größere GPT-3-Modell und mehrere andere Basislinien bei einer Vielzahl von Aufgaben deutlich.

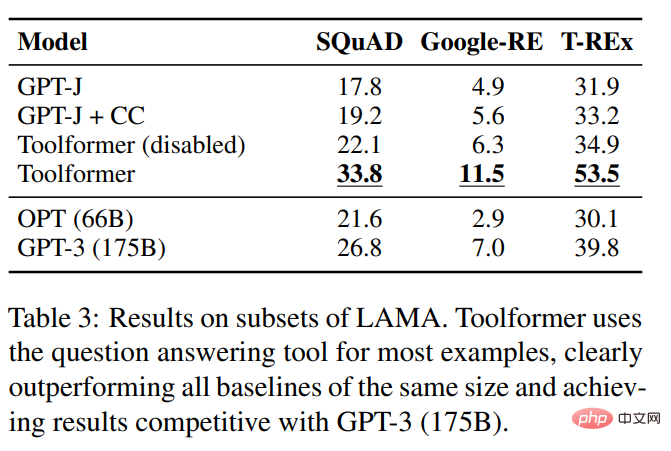

Diese Studie evaluierte mehrere Modelle für SQuAD-, GoogleRE- und T-REx-Teilmengen des LAMA-Benchmarks. Die experimentellen Ergebnisse sind in Tabelle 3 unten aufgeführt:

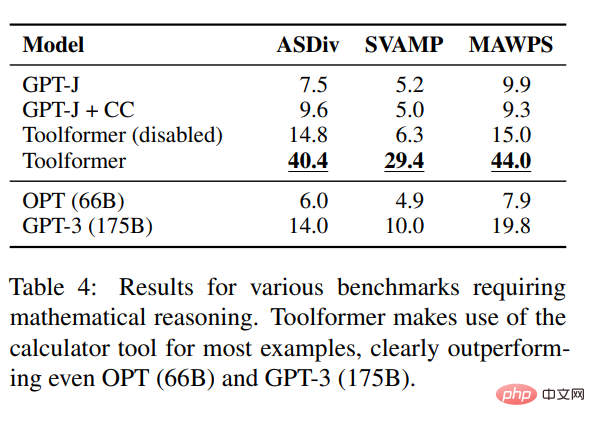

Um die Mathematik der Toolformer-Inferenz zu testen Fähigkeiten: In dieser Studie werden Experimente mit den Benchmarks ASDiv, SVAMP und MAWPS durchgeführt. Experimente zeigen, dass Toolformer in den meisten Fällen Taschenrechner-Tools verwendet, was deutlich besser ist als OPT (66B) und GPT-3 (175B).

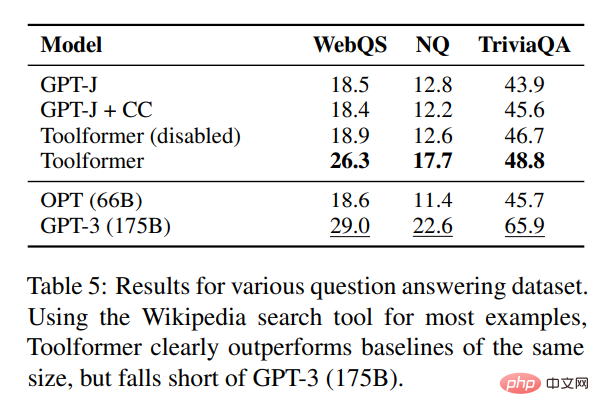

In Bezug auf die Beantwortung von Fragen führte die Studie Experimente mit drei Datensätzen zur Beantwortung von Fragen durch: Web-Fragen, natürliche Fragen und TriviaQA. Toolformer übertrifft Basismodelle derselben Größe deutlich, ist jedoch GPT-3 (175B) unterlegen.

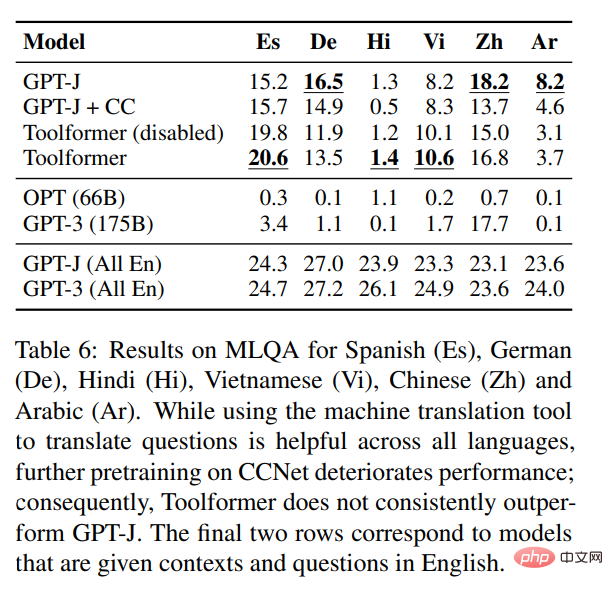

In Bezug auf sprachübergreifende Aufgaben wurden in dieser Studie alle Basismodelle auf Toolformer und MLQA verglichen. Die Ergebnisse sind in Tabelle 6 unten aufgeführt:

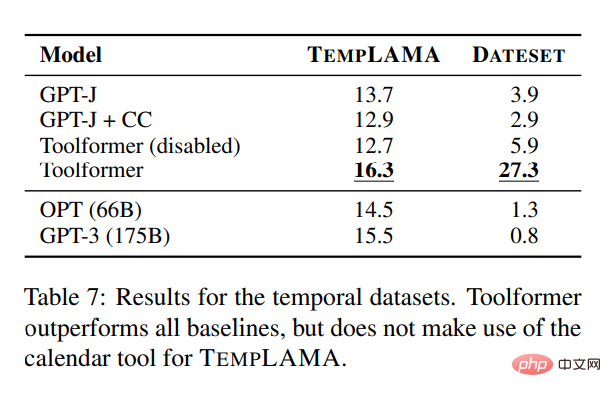

Um Studieren Sie die Kalender-API. Um ihre Nützlichkeit zu demonstrieren, experimentiert diese Studie mit mehreren Modellen auf TEMPLAMA und einem neuen Datensatz namens DATESET. Toolformer übertrifft alle Baselines, verwendet jedoch nicht das TEMPLAMA-Kalendertool.

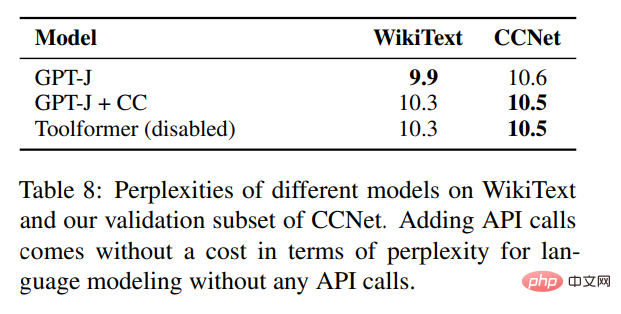

Neben der Validierung von Leistungsverbesserungen bei verschiedenen nachgelagerten Aufgaben hofft die Studie auch sicherzustellen, dass die Sprachmodellierungsleistung von Toolformer nicht durch die Feinabstimmung von API-Aufrufen beeinträchtigt wird. Zu diesem Zweck führt diese Studie Experimente mit zwei Sprachmodellierungsdatensätzen zur Auswertung durch. Die Verwirrung des Modells ist in Tabelle 8 unten dargestellt.

Für die Sprachmodellierung ohne API-Aufrufe kostet das Hinzufügen von API-Aufrufen nichts.

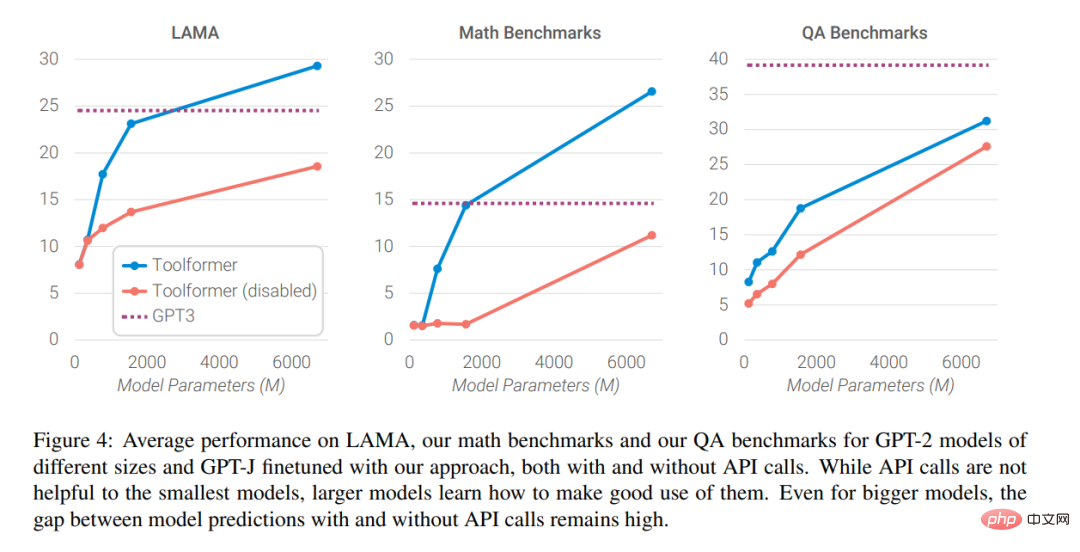

Abschließend analysierten die Forscher die Auswirkungen der Möglichkeit, Hilfe von externen Tools auf die Modellleistung zu holen, wenn der Maßstab des Sprachmodells zunimmt. Die Analyseergebnisse sind in Abbildung 4 unten dargestellt

Interessierte Leser können das Originalpapier lesen, um weitere Forschungsdetails zu erfahren.

Interessierte Leser können das Originalpapier lesen, um weitere Forschungsdetails zu erfahren.

Das obige ist der detaillierte Inhalt vonHat das Sprachmodell gelernt, selbstständig Suchmaschinen zu nutzen? Meta AI schlägt die selbstüberwachte Lernmethode Toolformer mit API-Aufruf vor. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

Gitee Pages statische Website -Bereitstellung fehlgeschlagen: Wie können Sie einzelne Dateien 404 Fehler beheben und beheben?

Apr 04, 2025 pm 11:54 PM

GitePages statische Website -Bereitstellung fehlgeschlagen: 404 Fehlerbehebung und Auflösung bei der Verwendung von Gitee ...

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Bedarf die Produktion von H5 -Seiten eine kontinuierliche Wartung?

Apr 05, 2025 pm 11:27 PM

Die H5 -Seite muss aufgrund von Faktoren wie Code -Schwachstellen, Browserkompatibilität, Leistungsoptimierung, Sicherheitsaktualisierungen und Verbesserungen der Benutzererfahrung kontinuierlich aufrechterhalten werden. Zu den effektiven Wartungsmethoden gehören das Erstellen eines vollständigen Testsystems, die Verwendung von Versionstools für Versionskontrolle, die regelmäßige Überwachung der Seitenleistung, das Sammeln von Benutzern und die Formulierung von Wartungsplänen.

Wie kann man Lückeneffekt auf das Karten- und Gutscheinlayout mit Gradientenhintergrund erzielen?

Apr 05, 2025 am 07:48 AM

Wie kann man Lückeneffekt auf das Karten- und Gutscheinlayout mit Gradientenhintergrund erzielen?

Apr 05, 2025 am 07:48 AM

Erkennen Sie den Lückeneffekt des Karten -Gutschein -Layouts. Beim Entwerfen von Karten -Gutschein -Layout begegnen Sie häufig die Notwendigkeit, Lücken zu Karten -Gutscheinen hinzuzufügen, insbesondere wenn der Hintergrund Gradient ist ...

Warum werden die lila abgeschnittenen Bereiche im Flex -Layout fälschlicherweise als 'Überlaufraum' betrachtet?

Apr 05, 2025 pm 05:51 PM

Warum werden die lila abgeschnittenen Bereiche im Flex -Layout fälschlicherweise als 'Überlaufraum' betrachtet?

Apr 05, 2025 pm 05:51 PM

Fragen zu lila Schrägstrichen in Flex -Layouts Bei der Verwendung von Flex -Layouts können Sie auf einige verwirrende Phänomene stoßen, wie beispielsweise in den Entwicklerwerkzeugen (D ...

Warum wirkt sich negative Margen in einigen Fällen nicht wirksam? Wie löst ich dieses Problem?

Apr 05, 2025 pm 10:18 PM

Warum wirkt sich negative Margen in einigen Fällen nicht wirksam? Wie löst ich dieses Problem?

Apr 05, 2025 pm 10:18 PM

Warum werden negative Margen in einigen Fällen nicht wirksam? Während der Programmierung negative Margen in CSS (negativ ...

Wie erhalten Sie Echtzeit-Anwendungs- und Zuschauerdaten auf der Arbeit von 58.com?

Apr 05, 2025 am 08:06 AM

Wie erhalten Sie Echtzeit-Anwendungs- und Zuschauerdaten auf der Arbeit von 58.com?

Apr 05, 2025 am 08:06 AM

Wie erhalte ich dynamische Daten von 58.com Arbeitsseite beim Kriechen? Wenn Sie eine Arbeitsseite von 58.com mit Crawler -Tools kriechen, können Sie auf diese begegnen ...

JavaScript -Code -Zeilenumbruch: Wie kann man langen String und Objektattributzugriff ordnungsgemäß behandeln?

Apr 05, 2025 am 08:03 AM

JavaScript -Code -Zeilenumbruch: Wie kann man langen String und Objektattributzugriff ordnungsgemäß behandeln?

Apr 05, 2025 am 08:03 AM

Detaillierte Erläuterung von JavaScript-Code-Zeilen-Brechen-Fähigkeiten beim Schreiben von JavaScript-Code. Wir stoßen häufig auf eine zu lange Codezeile, die nicht nur die Lesbarkeit des Codes beeinflusst ...

Warum werden negative Margen in einigen Fällen nicht wirksam?

Apr 05, 2025 pm 04:09 PM

Warum werden negative Margen in einigen Fällen nicht wirksam?

Apr 05, 2025 pm 04:09 PM

Warum werden negative Margen in einigen Fällen nicht wirksam? Wenn Sie CSS zum Layout -Webseiten verwenden, begegnen Sie häufig negative Margen (negativ ...