Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

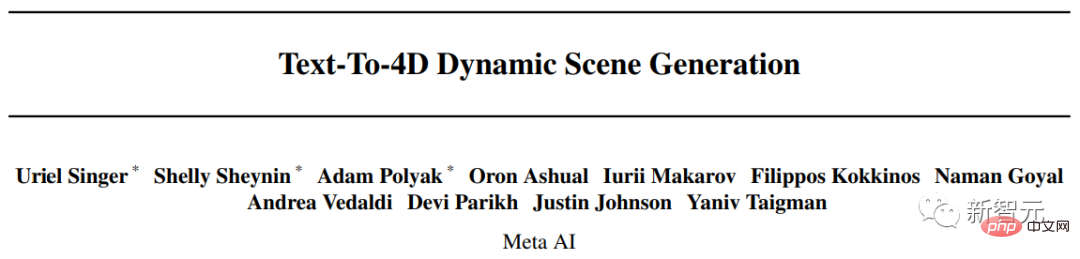

AIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?

AIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?

AIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?

KI-Generierungsmodelle haben in der vergangenen Zeit enorme Fortschritte gemacht, was den Bildbereich betrifft. Benutzer können Bilder durch Eingabe natürlicher Spracheingaben (wie DALL-E 2, Stable Diffusion) oder in der Zeitdimension erzeugen . Erweitern Sie, um kontinuierliche Videos zu generieren (z. B. Phenaki), oder erweitern Sie die räumliche Dimension, um direkt 3D-Modelle zu generieren (z. B. Dreamfusion).

Aber bisher befinden sich diese Aufgaben noch in einem isolierten Forschungsstadium, und es gibt keine technische Überschneidung untereinander.

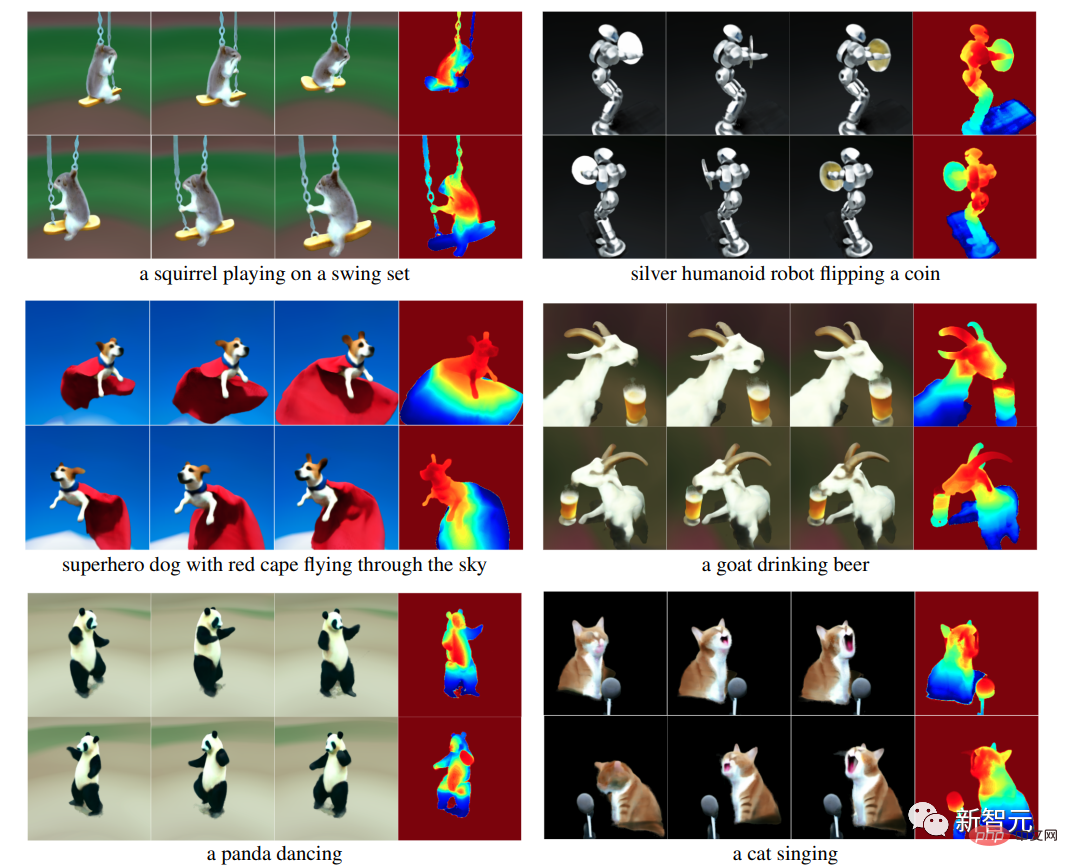

Kürzlich kombinierten Meta-KI-Forscher die Vorteile von Video- und generativen 3D-Modellen und schlugen ein brandneues Text-zu-vierdimensionales (3D + Zeit)-Generierungssystem MAV3D (MakeA-Video3D) vor, das eine Beschreibung in natürlicher Sprache übernimmt input und gibt eine dynamische dreidimensionale Szenendarstellung aus, die aus jeder Perspektive gerendert werden kann.

Papierlink: https://arxiv.org/abs/2301.11280

Projektlink: https://make-a-video3d.github.io/

MAV3D ist außerdem das erste Modell, das dreidimensionale dynamische Szenen basierend auf vorgegebenen Textbeschreibungen generieren kann.

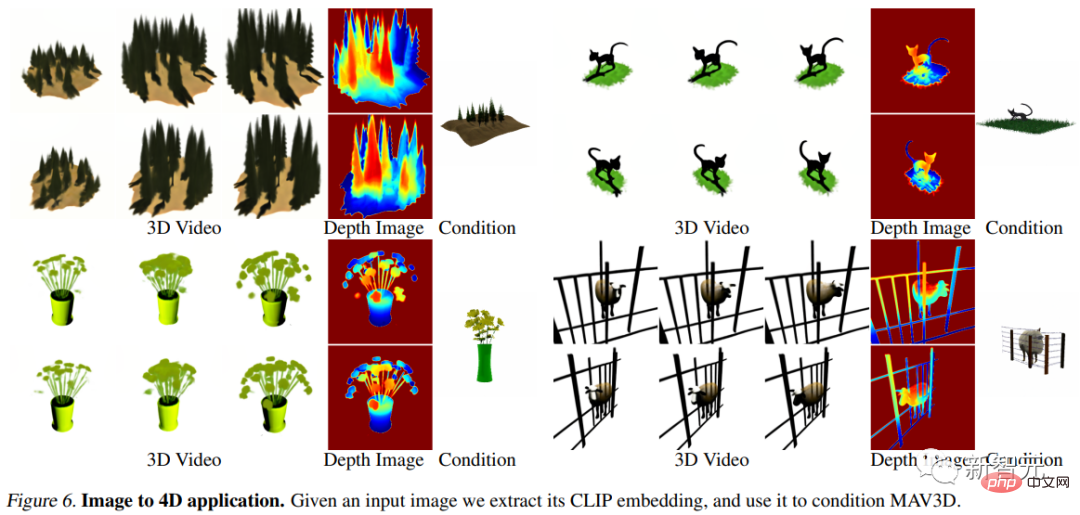

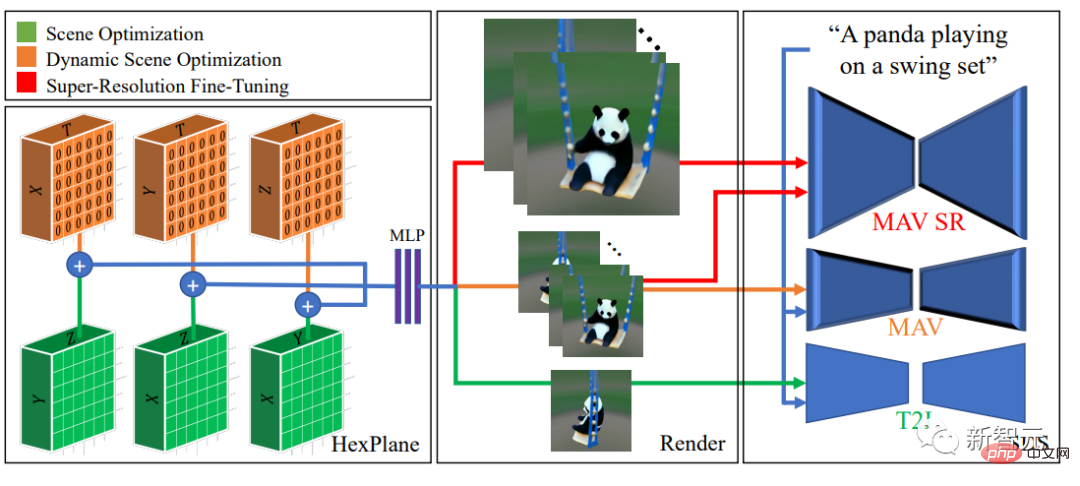

Die in diesem Artikel vorgeschlagene Methode verwendet ein dynamisches 4D-Neuronales Strahlungsfeld (NeRF), um die Szenendarstellung, Dichte und Bewegungskonsistenz zu optimieren, indem ein auf Text-zu-Video (T2V) basierendes Diffusionsmodell und die dadurch erzeugte Dynamik abgefragt werden Der bereitgestellte Text Die Videoausgabe kann aus jeder Kameraposition und aus jedem Winkel betrachtet und in jede 3D-Umgebung zusammengesetzt werden.Mit dieser Methode können 3D-Assets für Videospiele, visuelle Effekte oder Augmented und Virtual Reality generiert werden.

eine vorgefertigte 4D-Modellsammlung.

Corgi spielt Ball

MAV3DsTraining erfordert keine 3D- oder 4D-Daten, das T2V-Modell muss nur auf Text-Bild-Paare und unbeschriftete Videos trainiert werden.

Im experimentellen Teil führten die Forscher umfangreiche quantitative und qualitative Experimente durch, um die Wirksamkeit der Methode nachzuweisen, wodurch die zuvor festgelegte interne Basislinie deutlich verbessert wurde.Text zur dynamischen 4D-Szene

Aufgrund des Mangels an Trainingsdaten haben Forscher mehrere Ideen zur Lösung dieser Aufgabe entwickelt.Ein Ansatz könnte darin bestehen, einen vorab trainierten 2D-Videogenerator zu finden und eine 4D-Rekonstruktion aus dem generierten Video zu extrahieren. Allerdings ist die Rekonstruktion der Form verformbarer Objekte aus Videos immer noch ein sehr anspruchsvolles Problem, nämlich

Non-Rigid Structure from Motion (NRSfM).

Wenn Sie mehrere gleichzeitige Blickwinkel auf ein Objekt erhalten, wird die Aufgabe einfacher. Obwohl Multikamera-Setups in realen Daten selten sind, glauben die Forscher, dass vorhandene Videogeneratoren implizit Modelle der Szene aus beliebigen Blickwinkeln generieren.

Der MAV3D-Algorithmus erreicht dies durch die Optimierung des dynamischen Neural Radiation Field (NeRF) und die Dekodierung von Eingabetext in Video, wobei zufällige Blickwinkel um das Objekt herum abgetastet werden. Der direkte Einsatz des Videogenerators zur Optimierung des dynamischen NeRF hat zu keinen zufriedenstellenden Ergebnissen geführt. Es gibt noch einige Probleme, die während des Implementierungsprozesses überwunden werden müssen: 1 Ein effektiver, durchgängig erlernbarer Algorithmus Es wird eine dynamische 3D-Szenendarstellung benötigt im Raum sein und die Auflösung der Ausgabe in der Zeitdimension erweitern, da die 4D-Ausgabe viel Speicher und Rechenleistung erfordert MAV3D-Modell Um diese Darstellung ohne entsprechende (Text-, 4D-)Daten zu überwachen, schlagen die Forscher eine mehrstufige Trainingspipeline für dynamisches Szenenrendering vor und demonstrieren die Wirksamkeit jeder Komponente für die Erzielung qualitativ hochwertiger Ergebnisse.

Eine wichtige Beobachtung ist, dass die direkte Optimierung dynamischer Szenen mithilfe von Score Distillation Sampling (SDS) unter Verwendung von Text-to-Video (T2V)-Modellen zu visuellen Artefakten und suboptimaler Konvergenz führen kann. Daher entschieden sich die Forscher, zunächst das Text-to-Image (T2I)-Modell zu verwenden, um die statische 3D-Szene mit Textaufforderungen abzugleichen, und dann das 3D-Szenenmodell dynamisch zu verbessern. Darüber hinaus wird ein neuer temporaler SDS-Verlust- und Bewegungsregularisierungsterm in das Modell eingeführt, der sich experimentell als entscheidend für realistische und anspruchsvolle Bewegungen erwiesen hat.

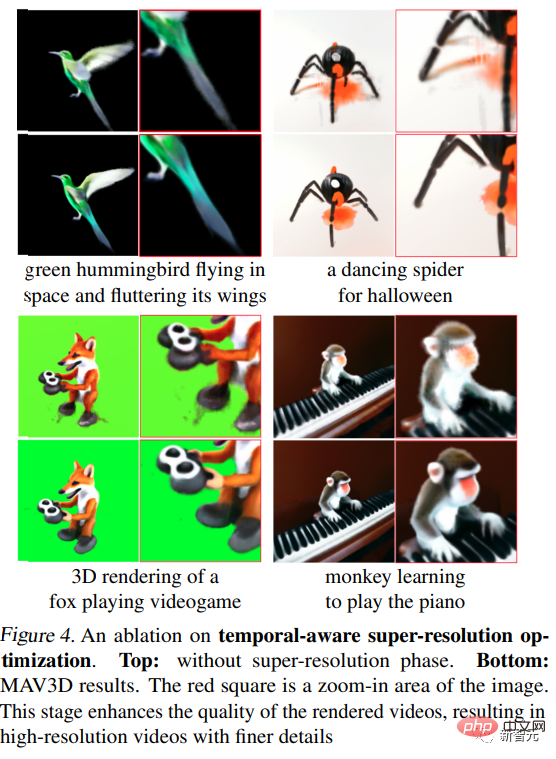

und mit einer zusätzlichen zeitbewussten Superauflösungs-Feinabstimmungsstufe auf eine Ausgabe mit höherer Auflösung skaliert. Schließlich wird das SDS des Super-Resolution-Moduls des T2V-Modells verwendet, um hochauflösende Gradienteninformationen für das überwachte Lernen des 3D-Szenenmodells zu erhalten, wodurch seine visuelle Wiedergabetreue erhöht und die Verarbeitung von Bildern mit höherer Auflösung währenddessen ermöglicht wird der Inferenzprozess. Die Ausgabe wird abgetastet. Experimenteller Teil Bewertungsmetriken Darüber hinaus werden vier qualitative Metriken verwendet, die abgeleitet werden können, indem menschliche Kommentatoren nach ihren Präferenzen unter den beiden generierten Videos gefragt werden: (i) Videoqualität; (iii) Menge der Übung; und (iv) Authentizität der Übung .

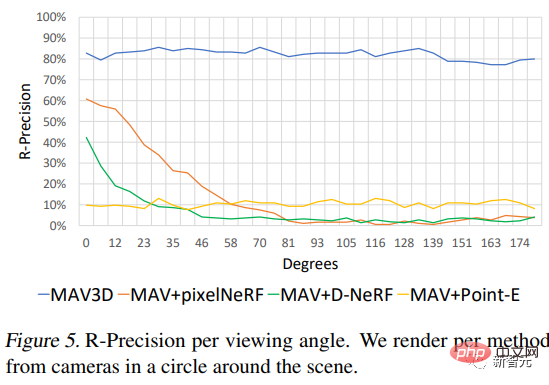

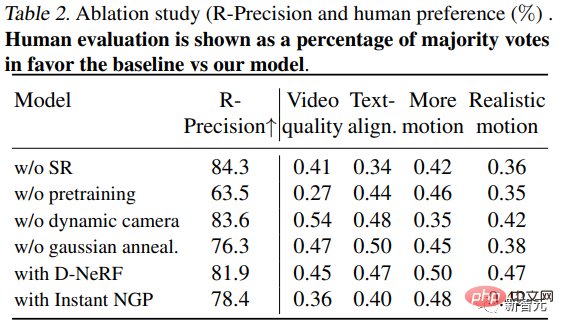

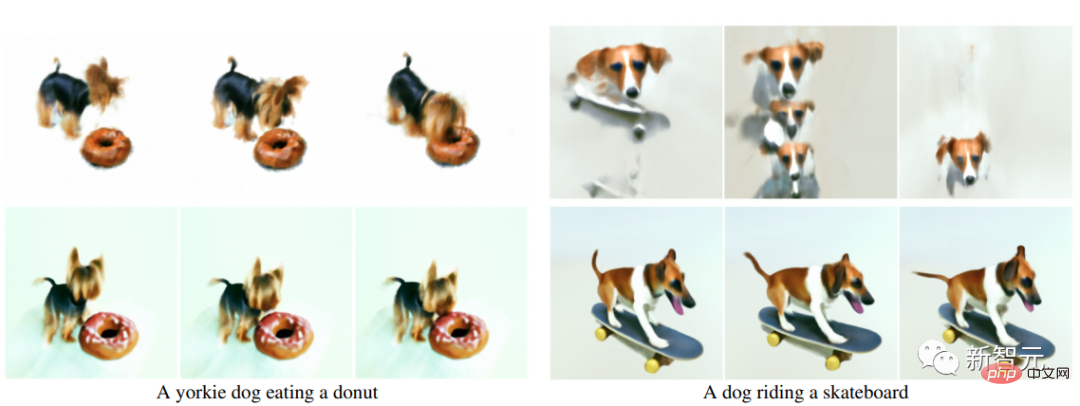

Text-zu-4D-Vergleich Da es zuvor keine Methode zur Konvertierung von Text in 4D gab, erstellten die Forscher zum Vergleich drei Basislinien auf der Grundlage der T2V-Generierungsmethode Um Sequenzen in dreidimensionale Szenendarstellungen umzuwandeln, kommen drei unterschiedliche Methoden zum Einsatz. Die erste Sequenz wird durch den One-Shot-Renderer für neuronale Szenen (Point-E) erhalten; die zweite wird durch die unabhängige Anwendung von pixelNeRF auf jedes Bild generiert; die dritte wird durch die Anwendung von D-NeRF in Kombination mit der COLMAP-Extracted-Kamera generiert Position. Es ist ersichtlich, dass die Methode das Basismodell hinsichtlich der objektiven R-Genauigkeitsmetrik übertrifft und von menschlichen Kommentatoren bei allen Metriken höher bewertet wird. Darüber hinaus untersuchten die Forscher auch die Leistung der Methode unter verschiedenen Kamerawinkeln. Ablationsexperiment 1. Modell ohne Feinabstimmung der Szenen-Superauflösung (SR) trainiert, mit der gleichen Anzahl von Schritten wie MAV3D (Stufe 3). Menschliche Annotatoren bevorzugen Modelle mit SR in Bezug auf Qualität, Textausrichtung und Bewegung geschult. Darüber hinaus verbessert die Super-Resolution-Feinabstimmung die Qualität gerenderter Videos, wodurch hochauflösende Videos mit feineren Details und weniger Rauschen erstellt werden. 2. Kein Vortraining: Wenn die Schritte zur direkten Optimierung dynamischer Szenen (ohne statisches Szenen-Vortraining) mit MAV3D identisch sind, ist das Ergebnis eine viel geringere Szenenqualität oder eine schlechte Konvergenz: bei In 73 % und 65 % der Fälle werden mit statischer Aufladung vorab trainierte Modelle hinsichtlich der Videoqualität und realistischen Bewegung bevorzugt.

Das obige ist der detaillierte Inhalt vonAIGC entwickelt sich zu schnell! Meta veröffentlicht den ersten textbasierten 4D-Videosynthesizer: Werden auch 3D-Spielemodellierer entlassen?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

So wählen Sie eine Gitlab -Datenbank in CentOS aus

Apr 14, 2025 pm 05:39 PM

So wählen Sie eine Gitlab -Datenbank in CentOS aus

Apr 14, 2025 pm 05:39 PM

Bei der Installation und Konfiguration von GitLab in einem CentOS -System ist die Auswahl der Datenbank von entscheidender Bedeutung. GitLab ist mit mehreren Datenbanken kompatibel, aber PostgreSQL und MySQL (oder MariADB) werden am häufigsten verwendet. Dieser Artikel analysiert Datenbankauswahlfaktoren und enthält detaillierte Installations- und Konfigurationsschritte. Datenbankauswahlhandbuch Bei der Auswahl einer Datenbank müssen Sie die folgenden Faktoren berücksichtigen: PostgreSQL: Die Standarddatenbank von GitLab ist leistungsstark, hat eine hohe Skalierbarkeit, unterstützt komplexe Abfragen und Transaktionsverarbeitung und ist für große Anwendungsszenarien geeignet. MySQL/Mariadb: Eine beliebte relationale Datenbank, die in Webanwendungen häufig verwendet wird, mit einer stabilen und zuverlässigen Leistung. MongoDB: NoSQL -Datenbank, spezialisiert auf

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an