Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Sind Sie immer noch besorgt, dass Sie ChatGPT nicht spielen können? Auch mit diesen Dutzend Open-Source-Alternativen können Sie einen intelligenten Dialog erleben

Sind Sie immer noch besorgt, dass Sie ChatGPT nicht spielen können? Auch mit diesen Dutzend Open-Source-Alternativen können Sie einen intelligenten Dialog erleben

Sind Sie immer noch besorgt, dass Sie ChatGPT nicht spielen können? Auch mit diesen Dutzend Open-Source-Alternativen können Sie einen intelligenten Dialog erleben

Seit der ersten Veröffentlichung von ChatGPT sind fast vier Monate vergangen. In dieser Zeit ließ die erstaunliche Leistung von ChatGPT die Leute fragen, ob AIGC im Voraus realisiert werden würde.

Ein bekanntes Geheimnis ist jedoch, dass ChatGPT wahrscheinlich kein Open Source ist. In Verbindung mit der enormen Investition in Rechenleistung und riesigen Trainingsdaten hat es der Forschungsgemeinschaft viele Hürden gesetzt, seinen Implementierungsprozess zu kopieren.

Angesichts des Ansturms von ChatGPT sind Open-Source-Alternativen eine gute Wahl. Sie bieten zwar ähnliche Funktionen, können Ihnen aber auch ermöglichen, den Funktionsmechanismus von ChatGPT durch Alternativen zu verstehen.

Mit der Weiterentwicklung der Technologie sind mittlerweile viele andere neue KI-Modelle entstanden, die ChatGPT ähneln. In diesem Artikel werden wir eine Bestandsaufnahme der Open-Source-Ersatzprojekte von ChatGPT machen. Der Inhalt wird in zwei Teile unterteilt: Der eine ist eine Zusammenfassung von ChatGPT-ähnlichen Open-Source-Projekten und der andere eine Ergänzung zur Projektzusammenfassung.

Projektzusammenfassung

Der Projektautor nichtdax hat 9 Open-Source-ChatGPT-Ersatzprojekte zusammengestellt. Sie werden im Folgenden einzeln vorgestellt.

Projektadresse: https://github.com/nichtdax/awesome-totally-open-chatgpt

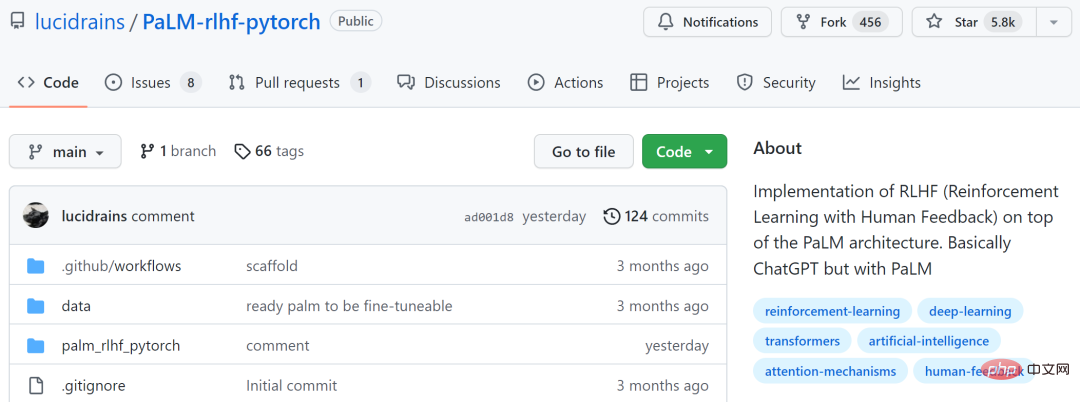

PaLM-rlhf-pytorch.

th Ein Projekt ist „PaLM-rlhf-pytorch“, und der Projektautor ist Phil Wang. Bei diesem Projekt handelt es sich um eine Implementierung von RLHF (Reinforcement Learning with Human Feedback) auf der PaLM-Architektur, bei der es sich im Wesentlichen um ChatGPT unter Verwendung von PaLM handelt.

Dieses Projekt hat 5,8.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/lucidrains/PaLM-rlhf-pytorch

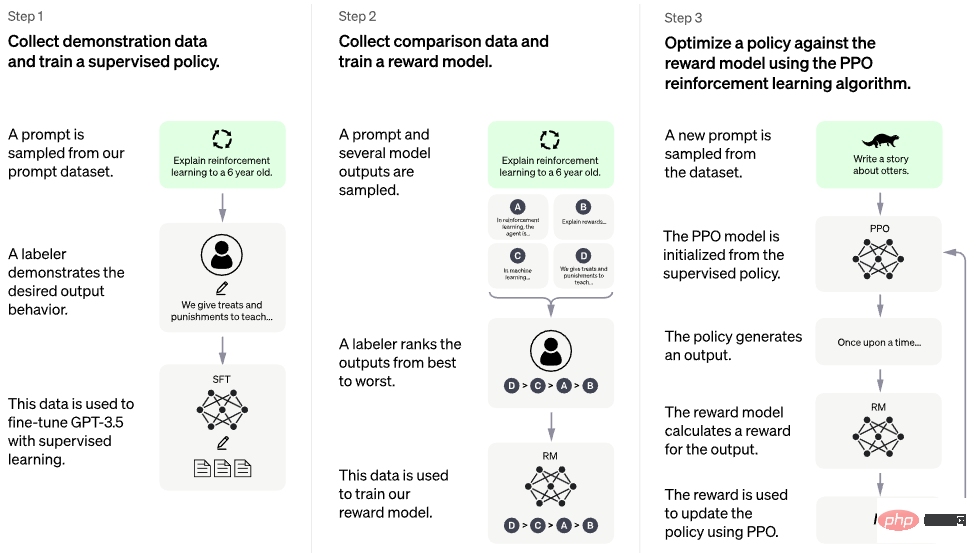

Das Bild unten zeigt den Trainingsprozess.

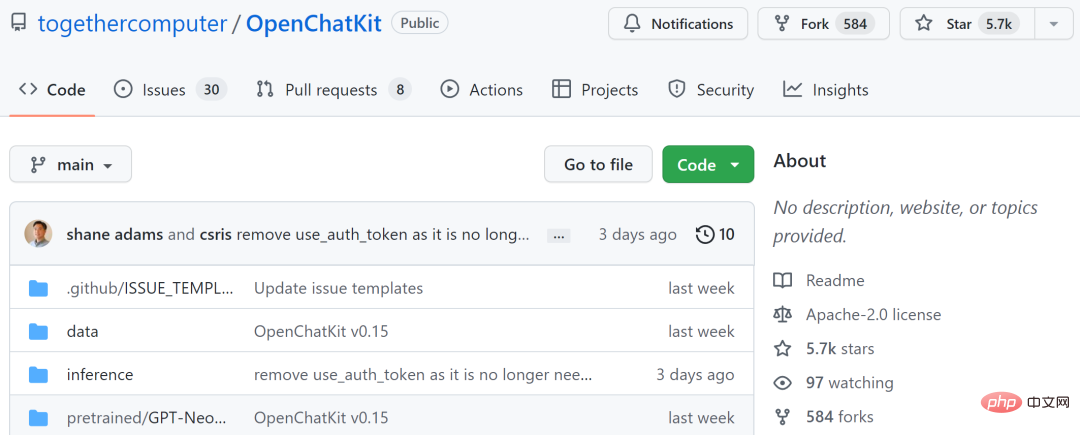

OpenChatKit

Das zweite Projekt ist „OpenChatKit“, das eine leistungsstarke Open-Source-Grundlage für die Erstellung spezialisierter und allgemeiner Chatbots für verschiedene Anwendungen bietet. Das Kit umfasst ein anweisungsoptimiertes Sprachmodell mit 20 Milliarden Parametern, ein Optimierungsmodell mit 6 Milliarden Parametern und ein skalierbares Abrufsystem, das die neuesten Antworten aus einem benutzerdefinierten Repository abdeckt.

OpenChatKit wird auf dem OIG-43M-Trainingsdatensatz trainiert, der eine Vereinigung von Together, LAION und Ontocord.ai ist. Der Projektautor gab an, dass dies nicht nur die Veröffentlichung eines Modells, sondern auch der Beginn eines Open-Source-Projekts sei. Sie veröffentlichen eine Reihe von Tools und Prozessen und verbessern diese kontinuierlich durch Community-Beiträge.

Dieses Projekt hat 5,7.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/togethercomputer/OpenChatKit

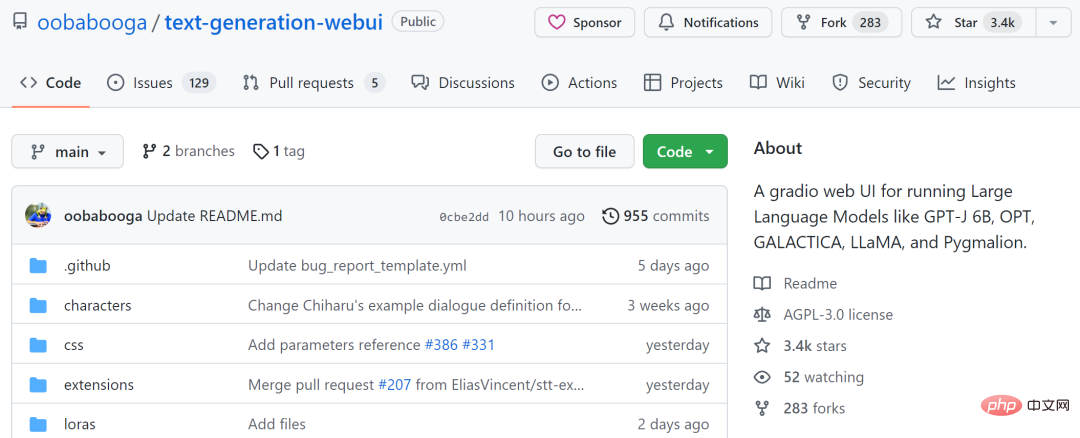

text-generation-webui

Das dritte Projekt ist „text-generation-webui“, das es ist eine Web-Benutzeroberfläche mit Farbverlauf zum Ausführen großer Sprachmodelle wie GPT-J 6B, OPT, GALACTICA, LLaMA und Pygmalion. Dieses Projekt soll das AUTOMATIC1111/stable-diffusion-webui der Textgenerierung sein.

Zu den Funktionen gehören die Verwendung von Dropdown-Menüs zum Wechseln zwischen verschiedenen Modellen, die Bereitstellung eines Notebook-Modus ähnlich dem OpenAI-Spielplatz, ein Chat-Modus für Gespräche und Rollenspiele, die Generierung einer schönen HTML-Ausgabe für GPT-4chan und mehr.

Das Projekt hat 3,4.000 auf GitHub erhalten.

Projektadresse: https://github.com/oobabooga/text-generation-webui

KoboldAI-Client

Das vierte Projekt ist „KoboldAI-Client“, das It ist ein browserbasiertes Frontend, das KI-gestütztes Schreiben durch mehrere lokale und Remote-KI-Modelle implementiert.

KoboldAI-Client bietet einen Standardsatz an Tools, darunter Speicher, Autorennotizen, Weltinformationen, Speichern und Laden, anpassbare AI-Einstellungen, Formatierungsoptionen und die Möglichkeit, vorhandene Text-Adventure-Spiele AI Dungeon zu importieren. Sie können den Abenteuermodus aktivieren oder Spiele wie AI Dungeon Unleashed spielen.

Dieses Projekt hat 1,4.000 auf GitHub erhalten.

Projektadresse: https://github.com/KoboldAI/KoboldAI-Client

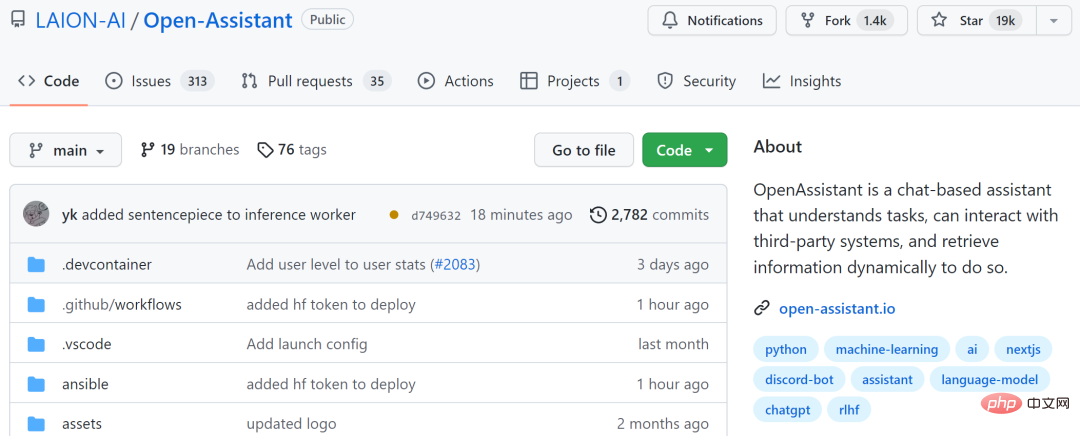

Open-Assistant

Das fünfte Projekt ist „Open-Assistant“, dessen Ziel es ist, Make große chatbasierte Sprachmodelle, die für jedermann zugänglich sind. Die Autoren des Projekts hoffen, eine Revolution in der Sprachinnovation auszulösen, ebenso wie eine stabile Verbreitung der Welt dabei hilft, Kunst und Bilder auf neue Weise zu schaffen.

Der Projektautor plant, qualitativ hochwertige, manuell generierte Beispiele für die Ausführung von Anweisungen (Anweisungen + Antworten) zu sammeln, mit einem Ziel von mehr als 50.000. Für jede erfasste Meldung werden mehrere Abschlussergebnisse abgetastet. Als nächstes treten Sie in die RLHF-Trainingsphase ein, die auf dem Anweisungs- und Belohnungsmodell basiert.

Dieses Projekt hat 19.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/LAION-AI/Open-Assistant

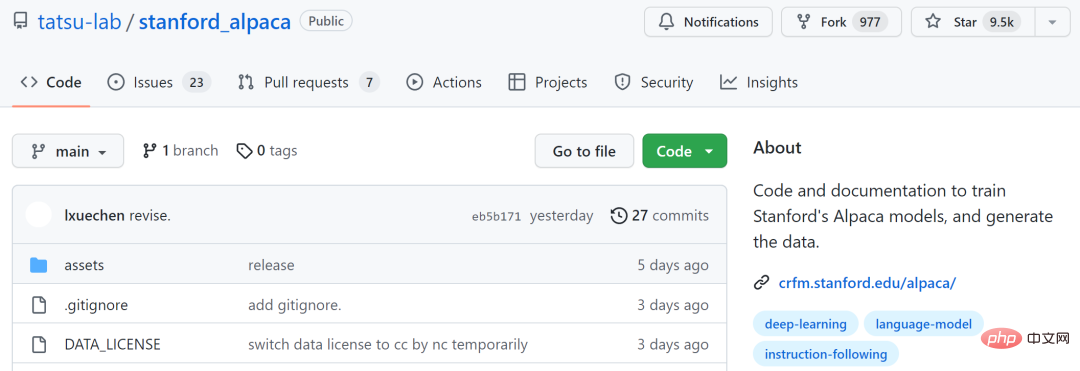

stanford_alpaca

Das sechste Projekt ist „stanford_alpaca“, dessen Ziel es ist, zu bauen und zu teilen ein LLaMA-Modell, dem Anweisungen folgen. Dieses Repo enthält 52.000 Daten zur Feinabstimmung des Modells, Code zur Generierung der Daten und Code zur Feinabstimmung des Modells.

Dieses Projekt hat 9,5.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/tatsu-lab/stanford_alpaca

ChatRWKV

Das siebte Projekt ist „ChatRWKV“, das ChatGPT ähnelt, es aber ist Das Modell powered by RWKV (100 % RNN) wird unterstützt und ist Open Source. Nach Angaben der Projektautoren ist RWKV derzeit das einzige RNN-Modell, das hinsichtlich Qualität und Skalierbarkeit mit Transformatoren mithalten kann, gleichzeitig schneller ist und VRAM spart.

Dieses Projekt hat 3,5.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/BlinkDL/ChatRWKV

ChatGLM-6B

Das achte Projekt ist das Open-Source-Modell „ChatGLM-6B“ für zweisprachige Konversationen zwischen Chinesisch und Englisch, das auf der Architektur des General Language Model (GLM) basiert 6,2 Milliarden Parameter. In Kombination mit der Modellquantisierungstechnologie können Benutzer es lokal auf Grafikkarten der Verbraucherklasse bereitstellen (auf der INT4-Quantisierungsebene sind mindestens 6 GB Videospeicher erforderlich).

ChatGLM-6B verwendet eine ähnliche Technologie wie ChatGPT und ist für chinesische Fragen und Antworten sowie Dialoge optimiert. Nach zweisprachigem Training in Chinesisch und Englisch mit etwa 1T-Identifikatoren, ergänzt durch überwachte Feinabstimmung, Feedback-Selbstbedienung, Lernen zur Verstärkung menschlicher Rückmeldungen und anderen Technologien, konnte der 6,2 Milliarden Parameter umfassende ChatGLM-6B Antworten generieren, die ziemlich konsistent sind menschliche Vorlieben.

Aufgrund des geringen Umfangs von ChatGLM-6B ist jedoch derzeit bekannt, dass es einige Einschränkungen aufweist, wie z. B. sachliche/mathematische Logikfehler, mögliche Erzeugung schädlicher/voreingenommener Inhalte, schwache kontextbezogene Fähigkeiten und Selbst- Verwirrung und die Erzeugung englischer Anweisungen, die den chinesischen Anweisungen völlig widersprechen.

Dieses Projekt hat 6.000 Sterne auf GitHub erhalten.

Projektadresse: https://github.com/THUDM/ChatGLM-6B

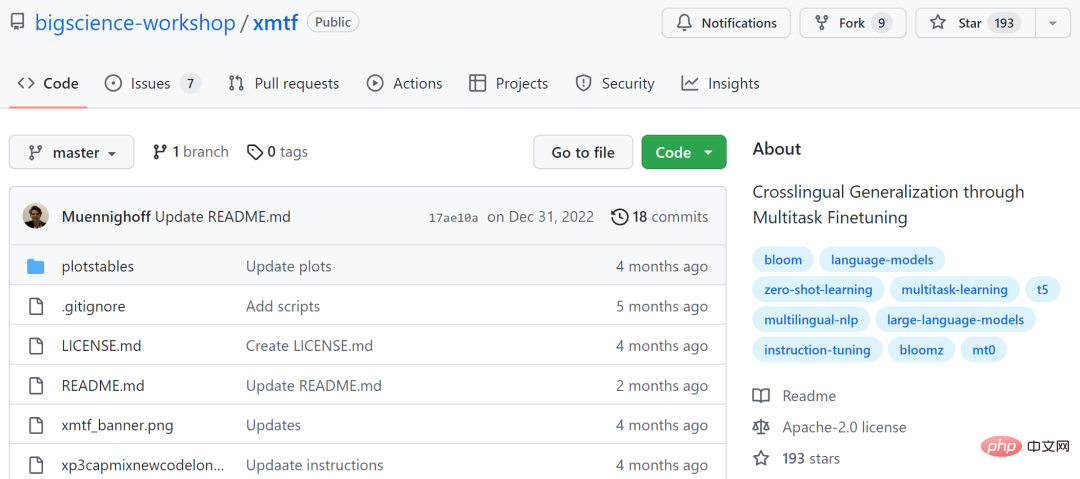

xmtf

Das neunte Projekt ist „xmtf“, das das Erstellungspapier „Crosslingual Generalization“ enthält „Alle Komponenten von BLOOMZ, mT0 und xP3 eingeführt in „durch Multitask Finetuning“.

Unter anderem ist BLOOMZ ein mehrsprachiges Modell mit 176 Milliarden Parametern; mT0 (bezieht sich hier speziell auf Googles T5X); xP3 ist ein überwachter Datensatz in 46 Sprachen mit Eingabeaufforderungen in Englisch und maschineller Übersetzung.

Projektadresse: https://github.com/bigscience-workshop/xmtf

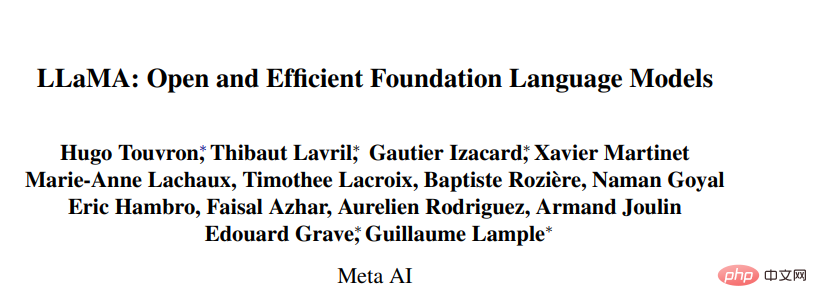

Zusätzlich zu den oben genannten Modellen umfasst das ChatGPT-Ersatzprojekt auch große Modelle, die auf Meta basieren Open Source Einige Studien zur LLaMA-Reihe (Large Language Model Meta AI). Die Anzahl der Parameter in dieser Modellreihe reicht von 7 Milliarden bis 65 Milliarden. Das LLaMA-Modell mit 13 Milliarden Parametern kann GPT-3 (175 Milliarden Parameter) „bei den meisten Benchmarks“ übertreffen und auf einer einzigen V100-GPU laufen, während das größte LLaMA-Modell mit 65 Milliarden Parametern mit Google Chinchilla-70B und PaLM vergleichbar ist; 540B.

- Papierlink: https://research.facebook.com/publications/llama-open-and-efficient-foundation-Language-Models/

- GitHub-Link: https://github. com/facebookresearch/llama

Basierend auf dieser Forschung haben Entwickler auch mehrere Open-Source-Projekte vorgeschlagen.

llama.cpp kann LLaMA ohne GPU ausführen

Das Projekt llama.cpp hat LLaMA auf dem MacBook implementiert, und Entwickler haben LLaMA 7B erfolgreich auf Raspberry Pi mit 4 GB RAM ausgeführt. Zusammenfassend lässt sich sagen, dass Entwickler LLaMA-Modelle auch dann ausführen können, wenn sie keine GPU haben.

Projektadresse: https://github.com/ggerganov/llama.cpp

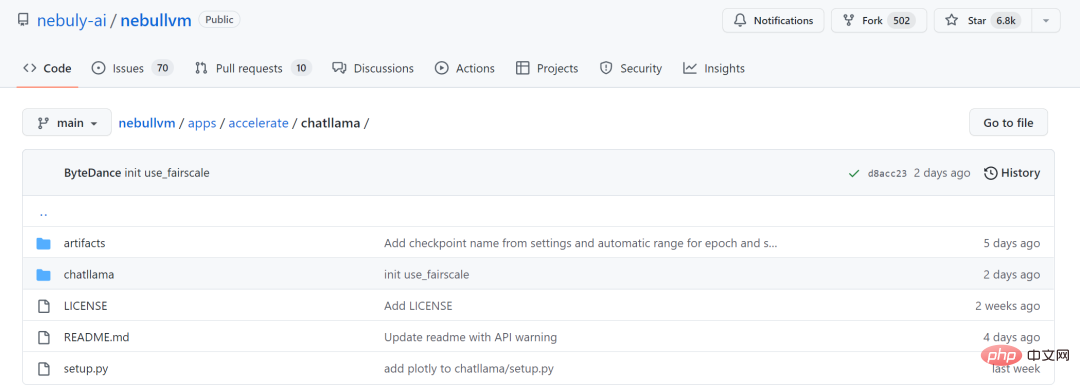

ChatLLaMA

Da die LLaMA-Großmodellreihe nicht die RLHF-Methode verwendet, hat das Startup Nebuly AI die Trainingsmethode der RLHF-Version von LLaMA (ChatLLaMA) als Open Source bereitgestellt. Der Trainingsprozess ähnelt ChatGPT und das Projekt ermöglicht den Aufbau von Diensten im ChatGPT-Stil auf der Grundlage vorab trainierter LLaMA-Modelle. Im Vergleich zu ChatGPT verfügt LLaMA über eine kleinere Architektur, aber der Trainingsprozess und die Einzel-GPU-Inferenz sind schneller und kostengünstiger. Die Bibliothek unterstützt auch alle LLaMA-Modellarchitekturen (7B, 13B, 33B, 65B), sodass Benutzer Leistungspräferenzen ableiten können Feinabstimmung des Modells.

Projektadresse: https://github.com/nebuly-ai/nebullvm/tree/main/apps/accelerate/chatllama

Ich freue mich auf die Teilnahme weiterer Open-Source-Projekte die Zukunft.

Das obige ist der detaillierte Inhalt vonSind Sie immer noch besorgt, dass Sie ChatGPT nicht spielen können? Auch mit diesen Dutzend Open-Source-Alternativen können Sie einen intelligenten Dialog erleben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Zehn empfohlene Open-Source-Tools für kostenlose Textanmerkungen

Mar 26, 2024 pm 08:20 PM

Bei der Textanmerkung handelt es sich um die Arbeit mit entsprechenden Beschriftungen oder Tags für bestimmte Inhalte im Text. Sein Hauptzweck besteht darin, zusätzliche Informationen zum Text für eine tiefere Analyse und Verarbeitung bereitzustellen, insbesondere im Bereich der künstlichen Intelligenz. Textanmerkungen sind für überwachte maschinelle Lernaufgaben in Anwendungen der künstlichen Intelligenz von entscheidender Bedeutung. Es wird zum Trainieren von KI-Modellen verwendet, um Textinformationen in natürlicher Sprache genauer zu verstehen und die Leistung von Aufgaben wie Textklassifizierung, Stimmungsanalyse und Sprachübersetzung zu verbessern. Durch Textanmerkungen können wir KI-Modellen beibringen, Entitäten im Text zu erkennen, den Kontext zu verstehen und genaue Vorhersagen zu treffen, wenn neue ähnliche Daten auftauchen. In diesem Artikel werden hauptsächlich einige bessere Open-Source-Textanmerkungstools empfohlen. 1.LabelStudiohttps://github.com/Hu

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

15 empfohlene kostenlose Open-Source-Bildanmerkungstools

Mar 28, 2024 pm 01:21 PM

Bei der Bildanmerkung handelt es sich um das Verknüpfen von Beschriftungen oder beschreibenden Informationen mit Bildern, um dem Bildinhalt eine tiefere Bedeutung und Erklärung zu verleihen. Dieser Prozess ist entscheidend für maschinelles Lernen, das dabei hilft, Sehmodelle zu trainieren, um einzelne Elemente in Bildern genauer zu identifizieren. Durch das Hinzufügen von Anmerkungen zu Bildern kann der Computer die Semantik und den Kontext hinter den Bildern verstehen und so den Bildinhalt besser verstehen und analysieren. Die Bildanmerkung hat ein breites Anwendungsspektrum und deckt viele Bereiche ab, z. B. Computer Vision, Verarbeitung natürlicher Sprache und Diagramm-Vision-Modelle. Sie verfügt über ein breites Anwendungsspektrum, z. B. zur Unterstützung von Fahrzeugen bei der Identifizierung von Hindernissen auf der Straße und bei der Erkennung und Diagnose von Krankheiten durch medizinische Bilderkennung. In diesem Artikel werden hauptsächlich einige bessere Open-Source- und kostenlose Bildanmerkungstools empfohlen. 1.Makesens

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Gerade erschienen! Ein Open-Source-Modell zum Generieren von Bildern im Anime-Stil mit einem Klick

Apr 08, 2024 pm 06:01 PM

Lassen Sie mich Ihnen das neueste AIGC-Open-Source-Projekt vorstellen – AnimagineXL3.1. Dieses Projekt ist die neueste Version des Text-zu-Bild-Modells mit Anime-Thema und zielt darauf ab, Benutzern ein optimiertes und leistungsfähigeres Erlebnis bei der Generierung von Anime-Bildern zu bieten. Bei AnimagineXL3.1 konzentrierte sich das Entwicklungsteam auf die Optimierung mehrerer Schlüsselaspekte, um sicherzustellen, dass das Modell neue Höhen in Bezug auf Leistung und Funktionalität erreicht. Zunächst erweiterten sie die Trainingsdaten, um nicht nur Spielcharakterdaten aus früheren Versionen, sondern auch Daten aus vielen anderen bekannten Anime-Serien in das Trainingsset aufzunehmen. Dieser Schritt erweitert die Wissensbasis des Modells und ermöglicht ihm ein umfassenderes Verständnis verschiedener Anime-Stile und Charaktere. AnimagineXL3.1 führt eine neue Reihe spezieller Tags und Ästhetiken ein

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins