Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

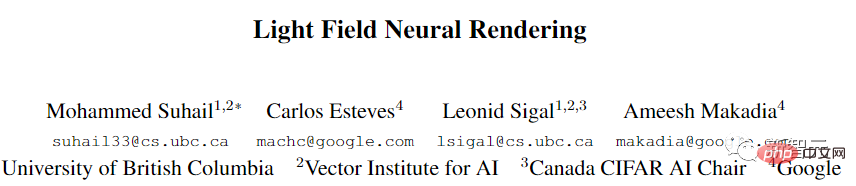

Trainieren Sie einfach einmal, um neue 3D-Szenen zu generieren! Die Entwicklungsgeschichte von Googles „Light Field Neural Rendering'

Trainieren Sie einfach einmal, um neue 3D-Szenen zu generieren! Die Entwicklungsgeschichte von Googles „Light Field Neural Rendering'

Trainieren Sie einfach einmal, um neue 3D-Szenen zu generieren! Die Entwicklungsgeschichte von Googles „Light Field Neural Rendering'

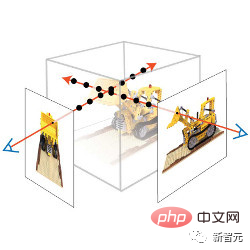

Die Ansichtssynthese ist ein zentrales Problem an der Schnittstelle von Computer Vision und Computergrafik. Sie bezieht sich auf die Erstellung einer neuen Ansicht einer Szene aus mehreren Bildern der Szene.

Um eine neue Ansicht einer Szene genau zu synthetisieren, muss ein Modell mehrere Arten von Informationen aus einem kleinen Satz von Referenzbildern erfassen, z. B. detaillierte 3D-Struktur, Materialien und Beleuchtung usw.

Seit Forscher im Jahr 2020 das Neural Radiation Field (NeRF)-Modell vorgeschlagen haben, hat dieses Thema auch immer mehr Aufmerksamkeit erhalten, was die Leistung der Synthese neuer Ansichten erheblich gefördert hat.

Einer der ganz Großen ist Google, das auch viele Artikel im Bereich NeRF veröffentlicht hat. In diesem Artikel stellen wir Ihnen zwei von Google auf der CVPR 2022 und der ECCV 2022 veröffentlichte Artikel zum Thema vor Light Field Neural Die Entwicklung von Rendering-Modellen .

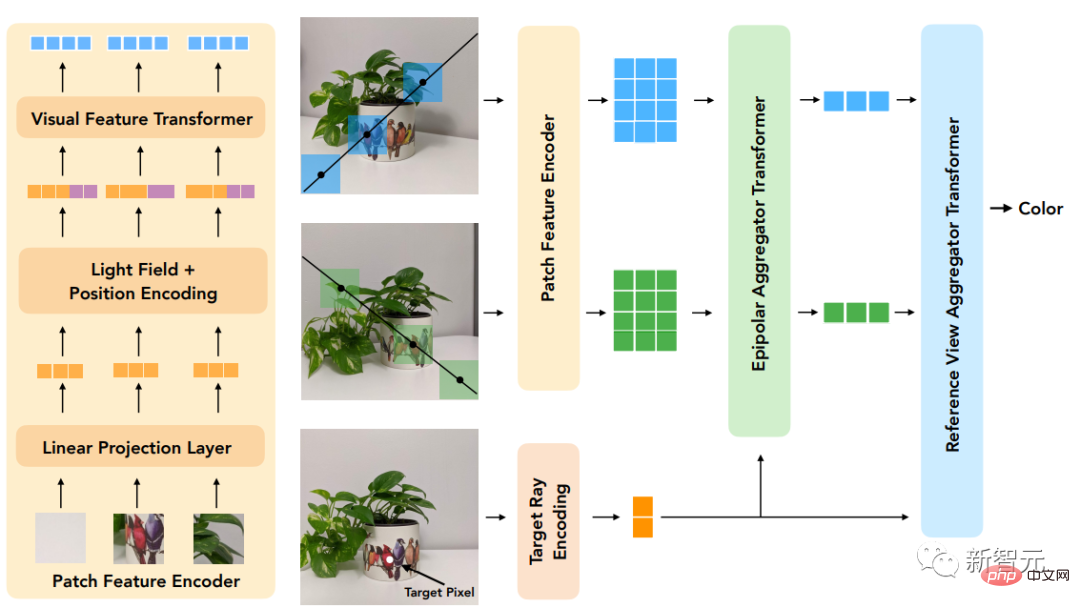

Der erste Artikel schlägt ein Transformer-basiertes zweistufiges Modell vor, um zu lernen, Referenzpixelfarben zu kombinieren, indem zunächst Merkmale entlang der Epipolarlinie (Epipolarlinie) und dann Merkmale entlang der Referenzansicht erhalten werden, um die Farbe der Zielstrahlen zu erzeugen , verbessert die Genauigkeit der Ansichtswiedergabe erheblich .

Link zum Dokument: https://arxiv.org/pdf/2112.09687.pdf und Transluzenz, erfordert jedoch eine dichte Ansicht der Szene. Auf geometrischer Rekonstruktion basierende Methoden erfordern nur spärliche Ansichten, können jedoch nicht-Lambertsche Effekte, d. h. nichtideale Streuung, nicht genau modellieren.

Das in der Arbeit vorgeschlagene neue Modell kombiniert die Vorteile dieser beiden Richtungen und mildert ihre Einschränkungen

Durch die Arbeit mit einer vierdimensionalen Darstellung des Lichtfeldes kann das Modell lernen, die Sicht genau darzustellen. damit verbundene Effekte. Die Szenengeometrie wird implizit aus einer spärlichen Menge an Ansichten gelernt, indem während des Trainings und der Inferenz geometrische Einschränkungen erzwungen werden.

Das Modell übertrifft modernste Modelle bei mehreren Vorwärts- und 360°-Datensätzen und verfügt über einen größeren Spielraum bei Szenen mit starken sichtlinienabhängigen Änderungen.

Ein weiterer Artikel befasst sich mit dem

Ein weiterer Artikel befasst sich mit dem

der Synthese unsichtbarer Szenen durch die Verwendung von Transformer-Sequenzenmit kanonisierter Positionskodierung. Nachdem das Modell an einer Reihe von Szenen trainiert wurde, kann es zum Synthetisieren von Ansichten neuer Szenen verwendet werden.

Link zum Papier: https://arxiv.org/pdf/2207.10662.pdf Mit dieser Methode kann die Farbe des Zielstrahls in der neuen Szene direkt vorhergesagt werden, indem einfach der Patchsatz aus der Szene abgetastet wird.

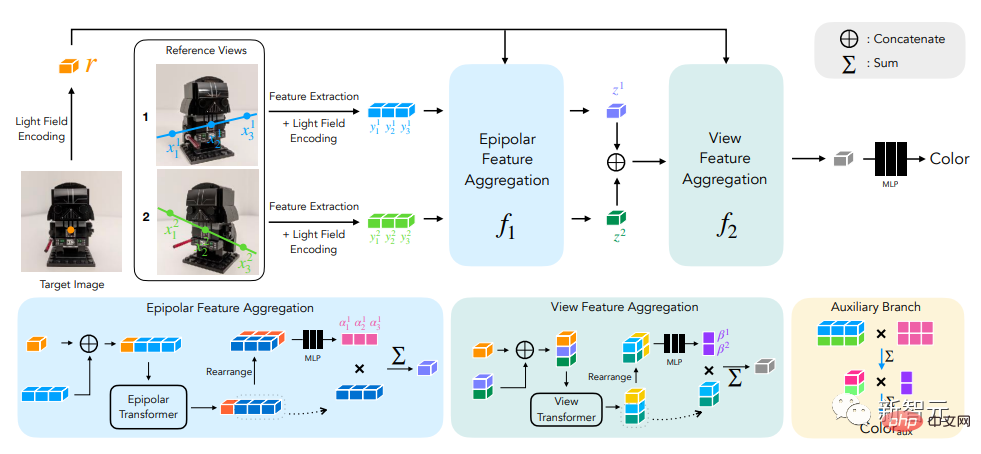

Für die Positionskodierung parametrisieren die Forscher die Strahlen auf ähnliche Weise wie bei der Lichtfelddarstellungsmethode. Der Unterschied besteht darin, dass die Koordinaten relativ zum Zielstrahl normiert werden, was die Methode auch unabhängig vom Referenzrahmen macht und verbessert Allgemeinheit. Sex . Abschließende experimentelle Ergebnisse zeigen, dass diese Methode andere Methoden bei der Synthese neuer Ansichten unsichtbarer Szenen übertrifft, selbst wenn sie trainiert wird. Light Field Neural Rendering Um ein neues Bild zu generieren, müssen wir von den Kameraparametern des Eingabebildes ausgehen, zunächst die Koordinaten des Zielstrahls ermitteln (jeweils einem Pixel entsprechen) und für jede Koordinate eine Modellabfrage durchführen. Die Lösung der Forscher bestand nicht darin, jedes Referenzbild vollständig zu verarbeiten, sondern nur auf die Bereiche zu schauen, die die Zielpixel beeinflussen könnten. Diese Regionen können durch epipolare Geometrie bestimmt werden, indem jedes Zielpixel einer Linie in jedem Referenzrahmen zugeordnet wird. Aus Sicherheitsgründen müssen Sie einen kleinen Bereich um einige Punkte auf der Epipolarlinie auswählen, um einen Satz von Patches zu bilden, der tatsächlich vom Modell verarbeitet wird, und dann den Transformer auf diesen Satz von Patches anwenden Ermitteln Sie die Farbe des Zielpixels.

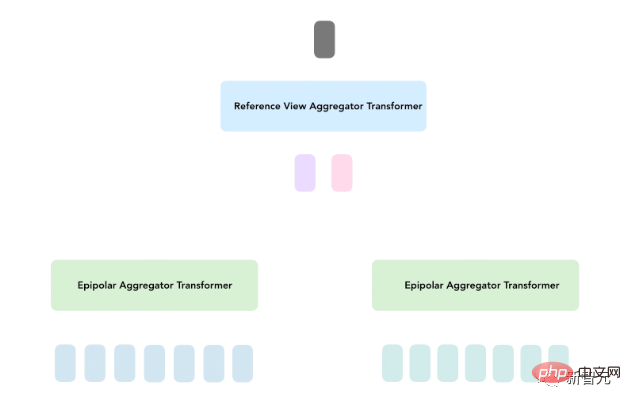

Beim Light Field Neural Rendering (LFNR) verwenden Forscher zwei Transformer-Sequenzen, um eine Sammlung von Patches auf Zielpixelfarben abzubilden. Der erste Transformer aggregiert Informationen entlang jeder Epipolarlinie und der zweite Transformer aggregiert Informationen entlang jedes Referenzbildes. Diese Methode kann den ersten Transformer so interpretieren, dass er potenzielle Entsprechungen von Zielpixeln in jedem Referenzrahmen findet, während der zweite Transformer Überlegungen zu Verdeckungs- und Sichtlinien-abhängigen Effekten anstellt, was ebenfalls bildbasiert ist Rendern.

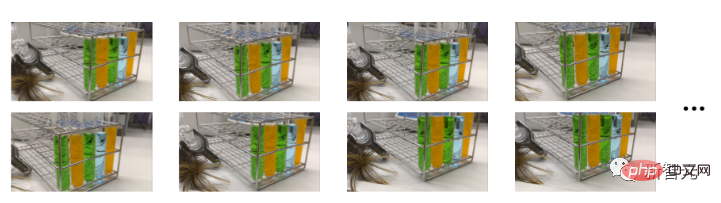

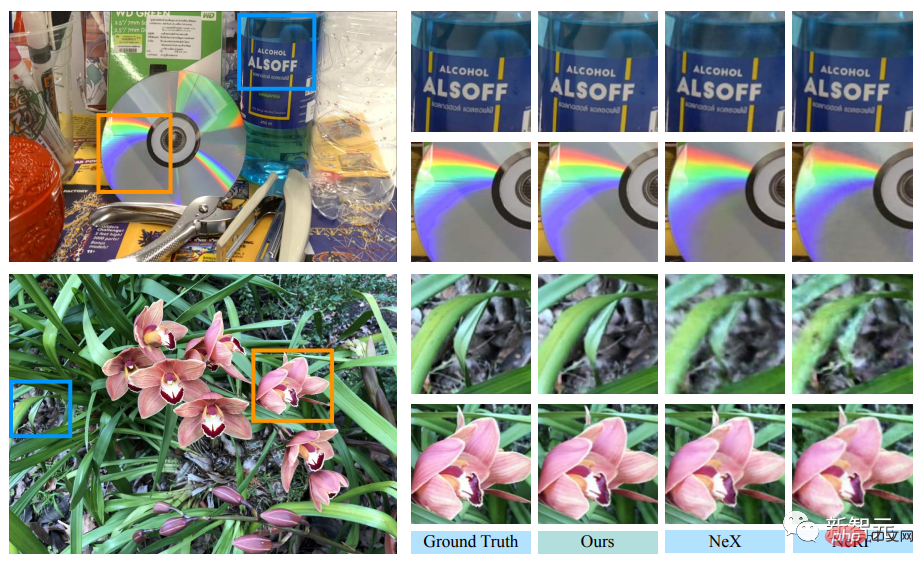

LFNR kann einige der schwierigeren sichtlinienabhängigen Effekte im NeX/Shiny-Datensatz reproduzieren, wie zum Beispiel Regenbögen und Reflexionen auf CDs, Reflexionen, Brechungen und Transluzenz auf Flaschen.

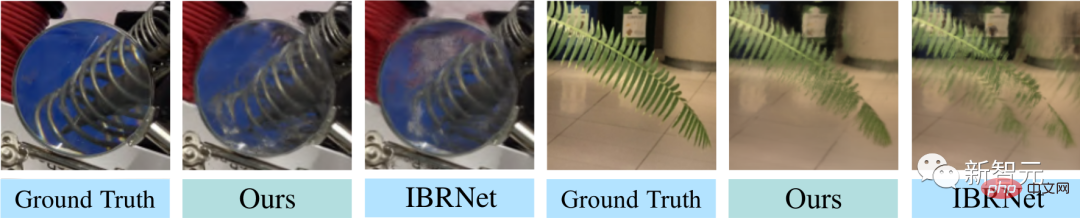

Einmal trainieren und auf neue Szenen verallgemeinern Der erste Transformer faltet die Informationen entlang jeder Epipolarlinie unabhängig für jedes Referenzbild. Dies bedeutet auch, dass das Modell nur auf der Grundlage der ausgegebenen Strahlkoordinaten und Patches jedes Referenzbildes entscheiden kann funktioniert gut in Trainingsszenen (wie die meisten neuronalen Rendering-Methoden), lässt sich jedoch nicht auf verschiedene Szenen verallgemeinern. Generalisierbare Modelle sind wichtig, weil sie ohne Umschulung direkt auf neue Szenarien angewendet werden können. Forscher schlugen ein allgemeines Patch-basiertes Neural-Rendering-Modell (GPNR) vor, um dieses Manko von LFNR zu beheben. Durch Hinzufügen eines Transformers zum Modell, sodass dieser vor den beiden anderen Transformern läuft und Informationen zwischen Punkten gleicher Tiefe in allen Referenzbildern austauscht. GPNR besteht aus einer Sequenz von drei Transformern, die eine Reihe von Patches, die entlang epipolarer Linien extrahiert wurden, in Pixelfarben abbilden. Bildfelder werden durch lineare Projektionsebenen auf anfängliche Merkmale abgebildet, und diese Merkmale werden dann vom Modell kontinuierlich verfeinert und aggregiert, um schließlich Merkmale und Farben zu bilden. Nachdem der erste Transformer beispielsweise die Patch-Sequenz aus „Park Bench“ extrahiert hat, kann das neue Modell Hinweise wie „Blumen“ verwenden, die in beiden Ansichten in entsprechenden Tiefen erscheinen, um das Vorhandensein einer möglichen Übereinstimmung anzuzeigen. Eine weitere Schlüsselidee dieser Arbeit besteht darin, die Positionskodierung entsprechend dem Zielstrahl zu normalisieren, denn wenn Sie in verschiedenen Szenarien verallgemeinern möchten, müssen Sie die Größen in einem relativen und nicht in einem absoluten Referenzsystem darstellen Um die Generalisierungsleistung des Modells zu bewerten, trainierten die Forscher GPNR anhand einer Reihe von Szenarien und testeten es anhand neuer Szenarien. GPNR verbessert sich bei mehreren Benchmarks (nach IBRNet- und MVSNeRF-Protokollen) im Durchschnitt um 0,5–1,0 dB, insbesondere beim IBRNet-Benchmark übertrifft GPNR das Basismodell, obwohl nur 11 % der Trainingsszenarien verwendet werden. GPNR generierte Ansichtsdetails zu gepflegten Szenen in NeX/Shiny und LLFF ohne Feinabstimmung. GPNR reproduziert Details auf den Lamellen und der Brechung durch die Linse genauer als IBRNet.  Die Innovation des Modells besteht darin, dass es ein bildbasiertes Rendering durchführt, bei dem die Farbe und Eigenschaften des Referenzbilds kombiniert werden, um eine neue Ansicht zu rendern. Es basiert ausschließlich auf Transformer und arbeitet mit dem Bild-Patch-Set . Und sie nutzen 4D-Lichtfelddarstellungen zur Positionskodierung und helfen so, ansichtsbezogene Effekte zu simulieren.

Die Innovation des Modells besteht darin, dass es ein bildbasiertes Rendering durchführt, bei dem die Farbe und Eigenschaften des Referenzbilds kombiniert werden, um eine neue Ansicht zu rendern. Es basiert ausschließlich auf Transformer und arbeitet mit dem Bild-Patch-Set . Und sie nutzen 4D-Lichtfelddarstellungen zur Positionskodierung und helfen so, ansichtsbezogene Effekte zu simulieren. Die Eingabe in das Modell besteht aus einem Satz von Referenzbildern, den entsprechenden Kameraparametern (Brennweite, Position und räumliche Ausrichtung) und den Koordinaten des Zielstrahls, dessen Farbe der Benutzer wünscht bestimmen.

Transformer ist in diesem Fall besonders nützlich, da der Selbstaufmerksamkeitsmechanismus natürlich die Patch-Sammlung als Eingabe verwenden kann und die Aufmerksamkeitsgewichtung selbst verwendet werden kann, um die Ausgabepixel in Kombination mit Farben und Funktionen der Referenzansicht vorherzusagen . Farbe.

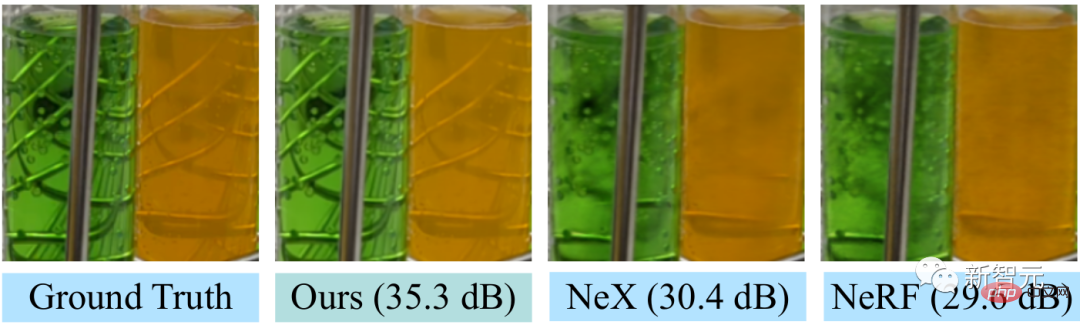

Transformer ist in diesem Fall besonders nützlich, da der Selbstaufmerksamkeitsmechanismus natürlich die Patch-Sammlung als Eingabe verwenden kann und die Aufmerksamkeitsgewichtung selbst verwendet werden kann, um die Ausgabepixel in Kombination mit Farben und Funktionen der Referenzansicht vorherzusagen . Farbe.  LFNR verbessert das Spitzen-Signal-Rausch-Verhältnis (PSNR) um bis zu 5 dB im Vergleich zum Sota-Modell bei den beliebtesten View-Synthese-Benchmarks (NeRFs Blender und Real Forward-Facing Scenes und NeXs Shiny). was ziemlich ist. Dadurch wird der Fehler auf Pixelebene um das 1,8-fache reduziert.

LFNR verbessert das Spitzen-Signal-Rausch-Verhältnis (PSNR) um bis zu 5 dB im Vergleich zum Sota-Modell bei den beliebtesten View-Synthese-Benchmarks (NeRFs Blender und Real Forward-Facing Scenes und NeXs Shiny). was ziemlich ist. Dadurch wird der Fehler auf Pixelebene um das 1,8-fache reduziert.  Im Vergleich zu früheren Methoden wie NeX und NeRF sind sie nicht in der Lage, Sichtlinieneffekte wie die Transluzenz und den Brechungsindex von Reagenzgläsern in der Laborszene im NeX/Shiny-Datensatz zu reproduzieren .

Im Vergleich zu früheren Methoden wie NeX und NeRF sind sie nicht in der Lage, Sichtlinieneffekte wie die Transluzenz und den Brechungsindex von Reagenzgläsern in der Laborszene im NeX/Shiny-Datensatz zu reproduzieren .

Aber LFNR hat auch Einschränkungen.

Das obige ist der detaillierte Inhalt vonTrainieren Sie einfach einmal, um neue 3D-Szenen zu generieren! Die Entwicklungsgeschichte von Googles „Light Field Neural Rendering'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Verzichten Sie auf die Encoder-Decoder-Architektur und verwenden Sie das Diffusionsmodell zur Kantenerkennung, das effektiver ist. Die National University of Defense Technology hat DiffusionEdge vorgeschlagen

Feb 07, 2024 pm 10:12 PM

Aktuelle Deep-Edge-Erkennungsnetzwerke verwenden normalerweise eine Encoder-Decoder-Architektur, die Up- und Down-Sampling-Module enthält, um mehrstufige Merkmale besser zu extrahieren. Diese Struktur schränkt jedoch die Ausgabe genauer und detaillierter Kantenerkennungsergebnisse des Netzwerks ein. Als Antwort auf dieses Problem bietet ein Papier zu AAAI2024 eine neue Lösung. Titel der Abschlussarbeit: DiffusionEdge:DiffusionProbabilisticModelforCrispEdgeDetection Autoren: Ye Yunfan (Nationale Universität für Verteidigungstechnologie), Xu Kai (Nationale Universität für Verteidigungstechnologie), Huang Yuxing (Nationale Universität für Verteidigungstechnologie), Yi Renjiao (Nationale Universität für Verteidigungstechnologie), Cai Zhiping (National University of Defense Technology) Link zum Papier: https://ar

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

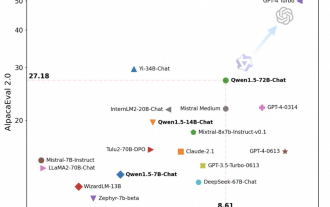

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Tongyi Qianwen ist wieder Open Source, Qwen1.5 bietet sechs Volumenmodelle und seine Leistung übertrifft GPT3.5

Feb 07, 2024 pm 10:15 PM

Pünktlich zum Frühlingsfest ist Version 1.5 des Tongyi Qianwen Large Model (Qwen) online. Heute Morgen erregten die Neuigkeiten über die neue Version die Aufmerksamkeit der KI-Community. Die neue Version des großen Modells umfasst sechs Modellgrößen: 0,5B, 1,8B, 4B, 7B, 14B und 72B. Unter ihnen übertrifft die Leistung der stärksten Version GPT3.5 und Mistral-Medium. Diese Version umfasst das Basismodell und das Chat-Modell und bietet Unterstützung für mehrere Sprachen. Das Tongyi Qianwen-Team von Alibaba gab an, dass die entsprechende Technologie auch auf der offiziellen Website von Tongyi Qianwen und der Tongyi Qianwen App eingeführt wurde. Darüber hinaus bietet die heutige Version von Qwen 1.5 auch die folgenden Highlights: Unterstützt eine Kontextlänge von 32 KB und öffnet den Prüfpunkt des Base+Chat-Modells.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

CLIP-BEVFormer: Überwacht explizit die BEVFormer-Struktur, um die Leistung der Long-Tail-Erkennung zu verbessern

Mar 26, 2024 pm 12:41 PM

Oben geschrieben und das persönliche Verständnis des Autors: Derzeit spielt das Wahrnehmungsmodul im gesamten autonomen Fahrsystem eine entscheidende Rolle Das Steuermodul im autonomen Fahrsystem trifft zeitnahe und korrekte Urteile und Verhaltensentscheidungen. Derzeit sind Autos mit autonomen Fahrfunktionen in der Regel mit einer Vielzahl von Dateninformationssensoren ausgestattet, darunter Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellenradarsensoren, um Informationen in verschiedenen Modalitäten zu sammeln und so genaue Wahrnehmungsaufgaben zu erfüllen. Der auf reinem Sehen basierende BEV-Wahrnehmungsalgorithmus wird von der Industrie aufgrund seiner geringen Hardwarekosten und einfachen Bereitstellung bevorzugt, und seine Ausgabeergebnisse können problemlos auf verschiedene nachgelagerte Aufgaben angewendet werden.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Das Neueste von der Universität Oxford! Mickey: 2D-Bildabgleich in 3D SOTA! (CVPR\'24)

Apr 23, 2024 pm 01:20 PM

Projektlink vorne geschrieben: https://nianticlabs.github.io/mickey/ Anhand zweier Bilder kann die Kameraposition zwischen ihnen geschätzt werden, indem die Korrespondenz zwischen den Bildern hergestellt wird. Normalerweise handelt es sich bei diesen Entsprechungen um 2D-zu-2D-Entsprechungen, und unsere geschätzten Posen sind maßstabsunabhängig. Einige Anwendungen, wie z. B. Instant Augmented Reality jederzeit und überall, erfordern eine Posenschätzung von Skalenmetriken und sind daher auf externe Tiefenschätzer angewiesen, um die Skalierung wiederherzustellen. In diesem Artikel wird MicKey vorgeschlagen, ein Keypoint-Matching-Prozess, mit dem metrische Korrespondenzen im 3D-Kameraraum vorhergesagt werden können. Durch das Erlernen des 3D-Koordinatenabgleichs zwischen Bildern können wir auf metrische Relativwerte schließen