Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Implementieren Sie Edge-Training mit weniger als 256 KB Speicher, und die Kosten betragen weniger als ein Tausendstel von PyTorch

Implementieren Sie Edge-Training mit weniger als 256 KB Speicher, und die Kosten betragen weniger als ein Tausendstel von PyTorch

Implementieren Sie Edge-Training mit weniger als 256 KB Speicher, und die Kosten betragen weniger als ein Tausendstel von PyTorch

Wenn es um das Training neuronaler Netze geht, ist der erste Eindruck eines jeden GPU + Server + Cloud-Plattform. Aufgrund des enormen Speicheraufwands wird herkömmliches Training oft in der Cloud durchgeführt und die Edge-Plattform ist nur für die Inferenz verantwortlich. Ein solches Design erschwert jedoch die Anpassung des KI-Modells an neue Daten: Schließlich ist die reale Welt ein dynamisches, sich veränderndes und sich entwickelndes Szenario. Wie kann ein Training alle Szenarien abdecken?

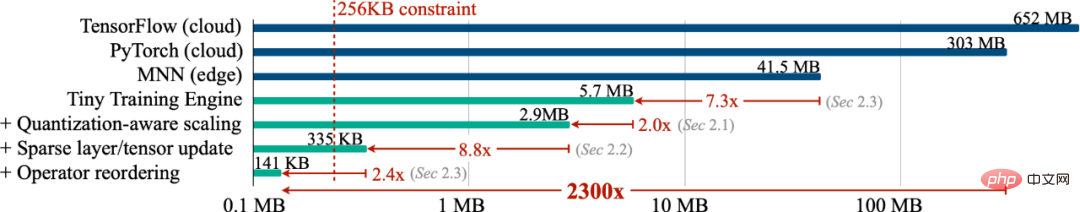

Können wir ein Training am Edge (On-Device-Training) durchführen, damit sich das Modell kontinuierlich an neue Daten anpassen kann, damit das Gerät kontinuierlich selbstständig lernen kann? In dieser Arbeit haben wir ein On-Device-Training mit weniger als 256 KB Speicher implementiert, und der Overhead betrug weniger als 1/1000 von PyTorch Gleichzeitig haben wir ein Cloud-Training für die visuelle Wake-Word-Aufgabe (VWW) durchgeführt ). Genauigkeit. Diese Technologie ermöglicht es Modellen, sich an neue Sensordaten anzupassen. Benutzer können maßgeschneiderte Dienste nutzen, ohne Daten in die Cloud hochladen zu müssen, wodurch die Privatsphäre geschützt wird.

- Website: https://tinytraining.mit.edu/

- Papier: https://arxiv.org/abs/2206.15472

- De mo: https : //www.bilibili.com/video/BV1qv4y1d7MV

- Code: https://github.com/mit-han-lab/tiny-training

Hintergrund

Training am Gerät (On-Device Training) ermöglicht vorab trainierten Modellen die Anpassung an neue Umgebungen nach der Bereitstellung. Durch lokales Training und Anpassung auf Mobilgeräten kann das Modell seine Ergebnisse kontinuierlich verbessern und das Modell für den Benutzer anpassen. Durch die Feinabstimmung von Sprachmodellen können sie beispielsweise aus dem Eingabeverlauf lernen. Durch die Anpassung von Vision-Modellen können intelligente Kameras kontinuierlich neue Objekte erkennen. Indem wir das Training näher an das Terminal und nicht an die Cloud verlegen, können wir die Modellqualität effektiv verbessern und gleichzeitig die Privatsphäre der Benutzer schützen, insbesondere bei der Verarbeitung privater Informationen wie medizinischer Daten und des Eingabeverlaufs.

Das Training auf kleinen IoT-Geräten unterscheidet sich jedoch wesentlich vom Cloud-Training und ist sehr anspruchsvoll. Erstens ist die SRAM-Größe von AIoT-Geräten (MCU) normalerweise begrenzt (256 KB). Auf dieser Ebene des Gedächtnisses ist es sehr schwierig, Schlussfolgerungen zu ziehen, geschweige denn zu trainieren. Darüber hinaus weisen die vorhandenen kostengünstigen und effizienten Transfer-Lernalgorithmen, wie z. B. nur das Training des Last-Layer-Klassifikators (letzter FC) und nur das Lernen des Bias-Terms, oft eine unbefriedigende Genauigkeit auf und können in der Praxis nicht verwendet werden, geschweige denn in modernen Anwendungen Deep-Learning-Frameworks sind nicht in der Lage, die theoretischen Zahlen dieser Algorithmen in gemessene Einsparungen umzuwandeln. Schließlich sind moderne Deep-Training-Frameworks (PyTorch, TensorFlow) normalerweise für Cloud-Server konzipiert, und das Training kleiner Modelle (MobileNetV2-w0.35) erfordert viel Speicher, selbst wenn die Batch-Größe auf 1 eingestellt ist. Daher müssen wir Algorithmen und Systeme gemeinsam entwerfen, um ein Training auf intelligenten Endgeräten zu erreichen.

Methoden und Ergebnisse

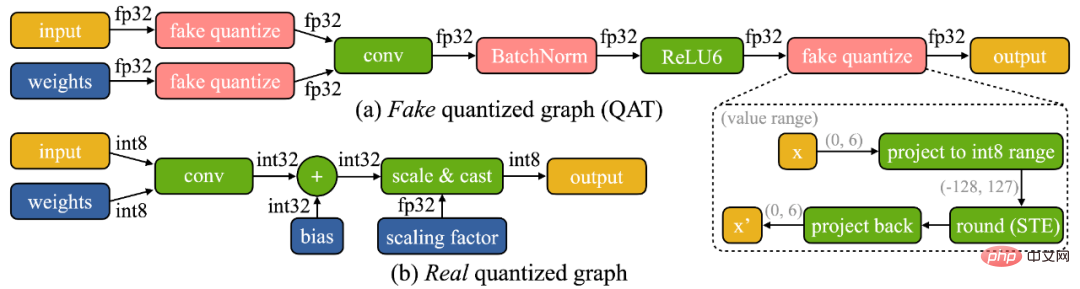

Wir haben festgestellt, dass das Training auf dem Gerät zwei einzigartige Herausforderungen mit sich bringt: (1) Das Modell wird auf dem Edge-Gerät quantisiert. Ein wirklich quantisierter Graph (siehe unten) ist aufgrund der geringen Genauigkeit der Tensoren und des Fehlens von Stapelnormalisierungsschichten schwierig zu optimieren. (2) Die begrenzten Hardwareressourcen (Speicher und Berechnung) kleiner Hardware ermöglichen keine vollständige Backpropagation, was die Speichernutzung beeinträchtigt kann leicht die Grenze des SRAM des Mikrocontrollers überschreiten (um mehr als eine Größenordnung), aber wenn nur die letzte Schicht aktualisiert wird, wird die endgültige Genauigkeit zwangsläufig unbefriedigend sein.

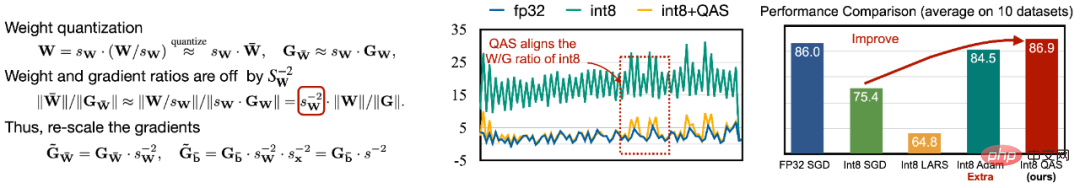

Um die Schwierigkeit der Optimierung zu bewältigen, schlagen wir Quantization-Aware Scaling (QAS) vor, um den Gradienten von Tensoren mit unterschiedlichen Bitgenauigkeiten automatisch zu skalieren (wie in der linken Abbildung unten dargestellt). QAS kann Steigungen und Parameterskalen automatisch anpassen und das Training stabilisieren, ohne dass zusätzliche Hyperparameter erforderlich sind. Bei 8 Datensätzen kann QAS mit Gleitkomma-Training eine konsistente Leistung erzielen (rechtes Bild unten).

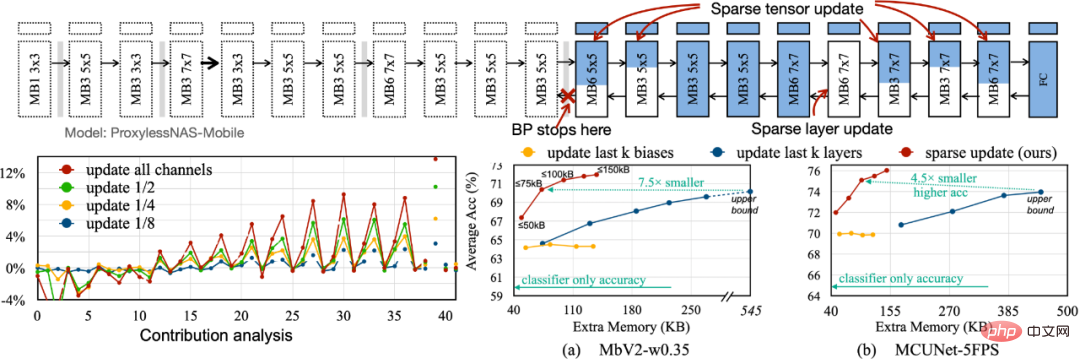

Um den für die Backpropagation erforderlichen Speicherbedarf zu reduzieren, schlagen wir Sparse Update vor, um die Gradientenberechnung weniger wichtiger Ebenen und Unterblätter zu überspringen. Wir entwickeln eine automatische Methode basierend auf der Beitragsanalyse, um das optimale Aktualisierungsschema zu finden. Verglichen mit der vorherigen, nur voreingenommenen Aktualisierung der letzten k-Schichten hat das von uns durchsuchte Sparse-Aktualisierungsschema 4,5- bis 7,5-fache Speichereinsparungen, und die durchschnittliche Genauigkeit bei 8 Downstream-Datensätzen ist sogar noch höher.

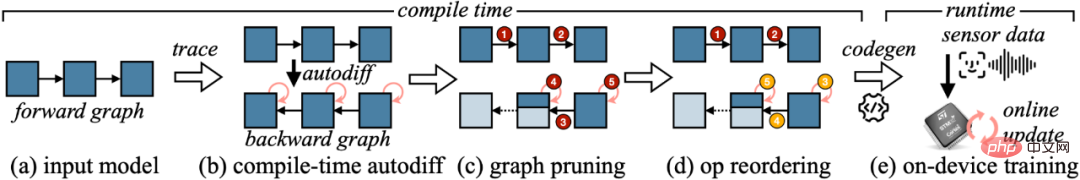

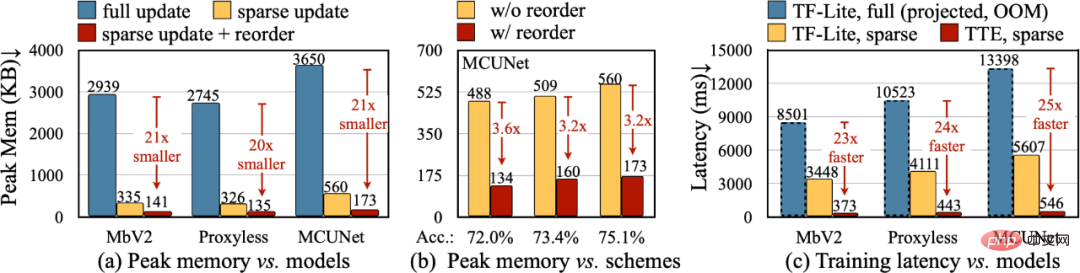

Um die theoretische Reduktion im Algorithmus in reale numerische Werte umzuwandeln, haben wir die Tiny Training Engine (TTE) entwickelt: Sie verlagert die Arbeit der automatischen Differenzierung auf die Kompilierungszeit und verwendet Codegen, um den Laufzeitaufwand zu reduzieren. Es unterstützt auch das Beschneiden und Neuanordnen von Diagrammen für echte Einsparungen und Beschleunigungen. Sparse Update reduziert den Spitzenspeicher effektiv um das 7- bis 9-fache im Vergleich zum Full Update und kann durch Neuordnung weiter auf das 20- bis 21-fache der gesamten Speichereinsparung verbessert werden. Im Vergleich zu TF-Lite erhöhen der optimierte Kernel und das Sparse-Update in TTE die Gesamttrainingsgeschwindigkeit um das 23- bis 25-fache.

Fazit

In diesem Artikel haben wir die erste Lösung vorgestellt, um das Training auf einem Mikrocontroller (mit nur 256 KB Speicher und 1 MB Flash-Speicher) umzusetzen. Unser Algorithmus-System-Co-Design (System-Algorithm Co-Design) reduziert den für das Training erforderlichen Speicher (1000 Mal im Vergleich zu PyTorch) und die Trainingszeit (20 Mal im Vergleich zu TF-Lite) erheblich und erzielt eine höhere Genauigkeit bei nachgelagerten Aufgaben. Tiny Training kann viele interessante Anwendungen ermöglichen. Beispielsweise können Mobiltelefone Sprachmodelle basierend auf den E-Mails/Eingabehistorien der Benutzer anpassen, intelligente Kameras können kontinuierlich neue Gesichter/Objekte erkennen und einige KI-Szenarien, die nicht mit dem Internet verbunden werden können, können ebenfalls fortgesetzt werden zu lernen (z. B. Landwirtschaft, Schifffahrt, industrielle Montagelinien). Durch unsere Arbeit können kleine Endgeräte nicht nur Inferenz, sondern auch Training durchführen. Bei diesem Vorgang werden niemals personenbezogene Daten in die Cloud hochgeladen, sodass kein Datenschutzrisiko besteht. Gleichzeitig kann das KI-Modell kontinuierlich selbstständig lernen, sich an eine sich dynamisch verändernde Welt anzupassen!

Das obige ist der detaillierte Inhalt vonImplementieren Sie Edge-Training mit weniger als 256 KB Speicher, und die Kosten betragen weniger als ein Tausendstel von PyTorch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1655

1655

14

14

1413

1413

52

52

1306

1306

25

25

1252

1252

29

29

1226

1226

24

24

Optimierung des großen Speichers. Was soll ich tun, wenn der Computer auf 16g/32g Speichergeschwindigkeit aktualisiert wird und es keine Änderung gibt?

Jun 18, 2024 pm 06:51 PM

Optimierung des großen Speichers. Was soll ich tun, wenn der Computer auf 16g/32g Speichergeschwindigkeit aktualisiert wird und es keine Änderung gibt?

Jun 18, 2024 pm 06:51 PM

Bei mechanischen Festplatten oder SATA-Solid-State-Laufwerken werden Sie die erhöhte Software-Laufgeschwindigkeit spüren. Wenn es sich um eine NVME-Festplatte handelt, spüren Sie sie möglicherweise nicht. 1. Importieren Sie die Registrierung in den Desktop und erstellen Sie ein neues Textdokument, kopieren Sie den folgenden Inhalt, fügen Sie ihn ein, speichern Sie ihn als 1.reg, klicken Sie dann mit der rechten Maustaste, um den Computer zusammenzuführen und neu zu starten. WindowsRegistryEditorVersion5.00[HKEY_LOCAL_MACHINE\SYSTEM\CurrentControlSet\Control\SessionManager\MemoryManagement]"DisablePagingExecutive"=d

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

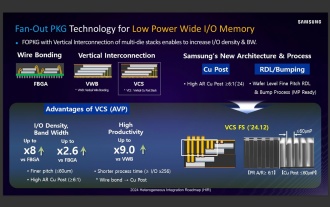

Quellen zufolge werden Samsung Electronics und SK Hynix nach 2026 gestapelten mobilen Speicher kommerzialisieren

Sep 03, 2024 pm 02:15 PM

Quellen zufolge werden Samsung Electronics und SK Hynix nach 2026 gestapelten mobilen Speicher kommerzialisieren

Sep 03, 2024 pm 02:15 PM

Laut Nachrichten dieser Website vom 3. September berichteten die koreanischen Medien etnews gestern (Ortszeit), dass die „HBM-ähnlichen“ mobilen Speicherprodukte mit Stapelstruktur von Samsung Electronics und SK Hynix nach 2026 kommerzialisiert werden. Quellen zufolge betrachten die beiden koreanischen Speichergiganten gestapelten mobilen Speicher als wichtige zukünftige Einnahmequelle und planen, den „HBM-ähnlichen Speicher“ auf Smartphones, Tablets und Laptops auszudehnen, um End-Side-KI mit Strom zu versorgen. Früheren Berichten auf dieser Website zufolge heißt das Produkt von Samsung Electronics LPWide I/O-Speicher und SK Hynix nennt diese Technologie VFO. Die beiden Unternehmen haben ungefähr den gleichen technischen Weg gewählt, nämlich die Kombination von Fan-Out-Verpackungen und vertikalen Kanälen. Der LPWide I/O-Speicher von Samsung Electronics hat eine Bitbreite von 512

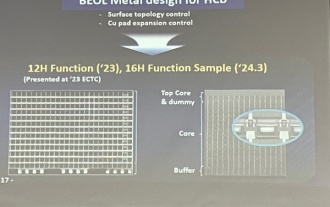

Samsung gab den Abschluss der Verifizierung der 16-Layer-Hybrid-Bonding-Stacking-Prozesstechnologie bekannt, die voraussichtlich in großem Umfang im HBM4-Speicher zum Einsatz kommen wird

Apr 07, 2024 pm 09:19 PM

Samsung gab den Abschluss der Verifizierung der 16-Layer-Hybrid-Bonding-Stacking-Prozesstechnologie bekannt, die voraussichtlich in großem Umfang im HBM4-Speicher zum Einsatz kommen wird

Apr 07, 2024 pm 09:19 PM

Dem Bericht zufolge sagte Dae Woo Kim, Geschäftsführer von Samsung Electronics, dass Samsung Electronics auf der Jahrestagung 2024 der Korean Microelectronics and Packaging Society die Verifizierung der 16-schichtigen Hybrid-Bonding-HBM-Speichertechnologie abschließen werde. Es wird berichtet, dass diese Technologie die technische Verifizierung bestanden hat. In dem Bericht heißt es außerdem, dass diese technische Überprüfung den Grundstein für die Entwicklung des Speichermarktes in den nächsten Jahren legen werde. DaeWooKim sagte, dass Samsung Electronics erfolgreich einen 16-schichtigen gestapelten HBM3-Speicher auf Basis der Hybrid-Bonding-Technologie hergestellt hat. Das Speichermuster funktioniert in Zukunft normal für die Massenproduktion von HBM4-Speicher. ▲Bildquelle TheElec, wie unten: Im Vergleich zum bestehenden Bonding-Prozess müssen beim Hybrid-Bonding keine Unebenheiten zwischen den DRAM-Speicherschichten hinzugefügt werden, sondern es werden die oberen und unteren Schichten direkt mit Kupfer verbunden.

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Lexar bringt Ares Wings of War DDR5 7600 16 GB x2-Speicherkit auf den Markt: Hynix A-Die-Partikel, 1.299 Yuan

May 07, 2024 am 08:13 AM

Lexar bringt Ares Wings of War DDR5 7600 16 GB x2-Speicherkit auf den Markt: Hynix A-Die-Partikel, 1.299 Yuan

May 07, 2024 am 08:13 AM

Laut Nachrichten dieser Website vom 6. Mai hat Lexar den Übertaktungsspeicher der Ares Wings of War-Serie DDR57600CL36 auf den Markt gebracht. Das 16GBx2-Set wird am 7. Mai um 0:00 Uhr gegen eine Anzahlung von 50 Yuan im Vorverkauf erhältlich sein 1.299 Yuan. Der Lexar Wings of War-Speicher verwendet Hynix A-Die-Speicherchips, unterstützt Intel In Bezug auf die Wärmeableitung ist dieses Speicherset mit einer 1,8 mm dicken Wärmeableitungsweste aus Vollaluminium ausgestattet und mit dem exklusiven wärmeleitenden Silikonfettpad von PMIC ausgestattet. Der Speicher verwendet 8 hochhelle LED-Perlen und unterstützt 13 RGB-Beleuchtungsmodi.