Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Aktuelles Interview mit DeepMind-Chefwissenschaftler Oriol Vinyals: Die Zukunft der allgemeinen KI ist starkes interaktives Meta-Lernen

Aktuelles Interview mit DeepMind-Chefwissenschaftler Oriol Vinyals: Die Zukunft der allgemeinen KI ist starkes interaktives Meta-Lernen

Aktuelles Interview mit DeepMind-Chefwissenschaftler Oriol Vinyals: Die Zukunft der allgemeinen KI ist starkes interaktives Meta-Lernen

Seit AlphaGo 2016 die Menschen bei Go besiegte, arbeiten DeepMind-Wissenschaftler an der Erforschung leistungsstarker allgemeiner Algorithmen für künstliche Intelligenz, und Oriol Vinyals ist einer von ihnen.

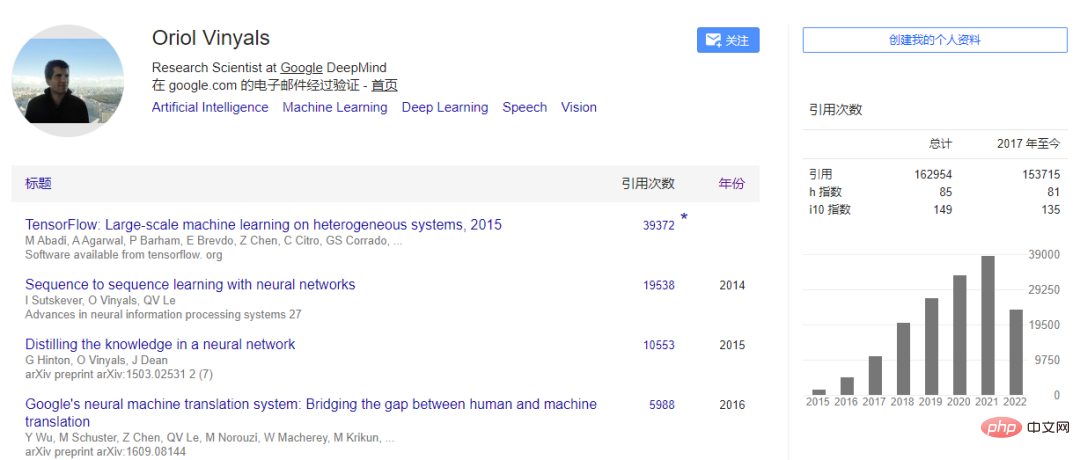

Vinyals kam 2016 zu DeepMind und ist derzeit leitender Wissenschaftler und leitet die Deep-Learning-Gruppe. Zuvor arbeitete er bei Google Brain. Seine Doktorarbeit absolvierte er an der University of California, Berkeley, wo er 2016 den MIT TR35 Innovator Award erhielt. Seine Forschungsergebnisse zu seq2seq, Wissensdestillation und TensorFlow wurden auf Produkte wie Google Translate, Text-to-Speech und Spracherkennung angewendet. Seine Artikel wurden mehr als 160.000 Mal zitiert.

Kürzlich war Oriol Vinyals Gast im Podcast von Lex Fridman und sprach über einige seiner Ansichten zu Deep Learning, Generalist Agent Gato, Meta-Learning, neuronalen Netzen, KI-Bewusstsein und anderen Richtungen. Vinyals ist davon überzeugt:

- Die Erweiterung des Modellmaßstabs kann die Synergie zwischen den multimodalen Modi des Agenten verbessern. Durch Gewichtswiederverwendung ist dies nicht erforderlich von Grund auf trainiert werden;

- Meta-Learning wird dem interaktiven Lernen zwischen dem Agenten und der Umgebung mehr Aufmerksamkeit schenken; Technischer Erfolg allgemeiner, groß angelegter Modelle oder Agenten. Die Schlüssel sind: Datentechnik, Bereitstellungstechnik und Festlegung von Baselines.

- Bestehende KI-Modelle sind noch weit davon entfernt, Bewusstsein zu erzeugen, als rechnerische Gehirne. Die Art und Weise, wie menschliches Denken funktioniert, kann die Forschung auf Algorithmenebene inspirieren Aber ob es das menschliche Niveau übertreffen kann, ist ungewiss.

- Der folgende AI Technology Review hat den Interviewinhalt bearbeitet und organisiert, ohne die ursprüngliche Bedeutung zu ändern:

- 1. Universeller Algorithmus

Fridman: Kann ein KI-System in unserem Leben gebaut werden und uns in diesem Gespräch ersetzen? Interviewer oder Interviewpartner?

Vinyals:Was ich fragen möchte ist: Wollen wir das erreichen? Ich freue mich zu sehen, dass wir sehr leistungsstarke Modelle verwenden und das Gefühl haben, dass sie uns näher kommen, aber die Frage ist, wäre es immer noch ein interessantes Artefakt ohne die menschliche Seite des Gesprächs? Wahrscheinlich nicht. In StarCraft können wir beispielsweise Agenten erstellen, die Spiele spielen und gegen sich selbst antreten, aber letztendlich geht es den Leuten darum, wie sich die Agenten verhalten, wenn der Konkurrent ein Mensch ist. Es besteht also kein Zweifel daran, dass wir mit KI stärker sein werden. Beispielsweise können Sie einige sehr interessante Probleme aus dem KI-System herausfiltern. Im Sprachbereich nennen wir dies manchmal „Terry Picking“. Wenn ich jetzt ein Tool wie dieses hätte, würden Sie eine interessante Frage stellen und ein bestimmtes System würde einige Wörter auswählen, um die Antwort zu bilden, aber das ist für mich nicht wirklich aufregend.

Fridman: Was wäre, wenn die Erregung von Menschen selbst Teil der objektiven Funktion dieses Systems wäre?

Vinyals: Wenn Sie in Spielen einen Algorithmus entwerfen, können Sie die Belohnungsfunktion als Ziel schreiben. Aber wenn man es messen und optimieren kann, was ist dann das Spannende daran? Das ist wahrscheinlich der Grund, warum wir Videospiele spielen, online interagieren und Katzenvideos ansehen. Tatsächlich ist es sehr interessant, Belohnungen zu modellieren, die über die offensichtlichen Belohnungsfunktionen hinausgehen, die beim verstärkenden Lernen verwendet werden. Außerdem macht KI in bestimmten Aspekten einige wichtige Fortschritte. Beispielsweise können wir anhand ihrer Akzeptanz im Internet beurteilen, ob ein Gespräch oder eine Information vertrauenswürdig ist. Wenn Sie dann eine Funktion automatisch erlernen können, können Sie sie einfacher optimieren und dann ein Gespräch führen, um einige der weniger offensichtlichen Informationen wie Aufregung zu optimieren. Es wäre interessant, ein System aufzubauen, bei dem mindestens ein Aspekt vollständig von der erregenden Belohnungsfunktion gesteuert wird.

Aber offensichtlich enthält das System immer noch viele menschliche Elemente vom Systembauer, und die Bezeichnung für Aufregung kommt von uns, daher ist es schwierig, Aufregung zu berechnen. Soweit ich weiß, hat noch niemand so etwas gemacht.

Fridman: Vielleicht muss das System auch ein starkes Identitätsgefühl haben. Es wird Erinnerungen haben und Geschichten über seine Vergangenheit erzählen können. Es kann aus kontroversen Meinungen lernen, da es im Internet viele Daten darüber gibt, welche Meinungen Menschen vertreten und welche Aufregung mit einer bestimmten Meinung verbunden ist. Das System kann daraus etwas schaffen, das nicht mehr auf Grammatik und Wahrhaftigkeit optimiert ist, sondern auf die menschliche Konsistenz des Satzes.Vinyals: Aus der Perspektive eines Entwicklers neuronaler Netze und künstlicher Intelligenz versucht man normalerweise, viele der interessanten Themen, über die man spricht, in Benchmarks abzubilden und dann auch in Fragen darüber, wie diese Systeme derzeit gebaut werden. Wie In der eigentlichen Architektur des Lernens, des Lernens aus welchen Daten und dem, was gelernt werden soll, werden wir hier über das Gewicht mathematischer Funktionen sprechen.

Was brauchen wir beim aktuellen Stand des Gamings, um diese Lebenserfahrungen wie Angst zu erreichen? Auf der sprachlichen Seite sehen wir derzeit nur sehr geringe Fortschritte, da wir derzeit viele menschliche Online-Interaktionen nutzen und dann Sequenzen extrahieren, bei denen es sich um Zeichenfolgen aus Wörtern, Buchstaben, Bildern, Tönen, Modalitäten usw. handelt Versuchen, über ein neuronales Netzwerk eine Funktion zu lernen, um die Wahrscheinlichkeit zu maximieren, diese Sequenzen zu sehen.

Einige der Methoden, mit denen wir diese Modelle derzeit trainieren, werden hoffentlich die Fähigkeiten entwickeln, von denen Sie sprechen. Einer davon ist der Lebenszyklus des Agenten oder Modells, den das Modell aus Offline-Daten lernt, also nur passiv beobachtet und maximiert. Genau wie in einer Berglandschaft, in der es überall menschliche Interaktionsdaten gibt, erhöhen Sie das Gewicht; wo keine Daten vorhanden sind, verringern Sie das Gewicht. Modelle erleben sich normalerweise nicht selbst, sie sind lediglich passive Beobachter von Daten. Wir lassen sie dann Daten generieren, während wir mit ihnen interagieren. Dies schränkt jedoch die Erfahrung, die sie tatsächlich beim Optimieren oder weiteren Optimieren von Gewichten machen können, erheblich ein. Aber dieses Stadium haben wir noch nicht einmal erreicht.

In AlphaGo und SlphaStar stellen wir das Modell bereit und lassen es mit Menschen konkurrieren oder mit Menschen (z. B. Sprachmodellen) interagieren, um das Modell zu trainieren. Sie werden nicht kontinuierlich trainiert, sie lernen nicht anhand der aus den Daten gelernten Gewichte und sie verbessern sich nicht kontinuierlich.

Aber wenn Sie über neuronale Netze nachdenken, ist es verständlich, dass sie möglicherweise nicht aus Gewichtsänderungen im engeren Sinne des Wortes lernen, sondern damit zusammenhängen, wie Neuronen miteinander verbunden sind und wie wir im Laufe unseres Lebens lernen. Aber wenn Sie mit diesen Systemen sprechen, ist der Kontext des Gesprächs in ihrem Gedächtnis vorhanden. Es ist so, als ob Sie einen Computer starten und dieser viele Informationen auf der Festplatte hat. Sie haben auch Zugriff auf das Internet, das alle Informationen enthält. Es gibt auch die Erinnerung, die wir als Hoffnung des Handelnden betrachten.

Der Speicherplatz ist im Moment sehr begrenzt, wir sprechen jetzt von etwa 2.000 Wörtern, die wir haben, darüber hinaus beginnen wir zu vergessen, was wir sehen, sodass eine gewisse kurzfristige Kontinuität besteht. Wenn der Agent über Kohärenz verfügt, kann er sich den Satz merken, wenn Sie ihn fragen: „Wie heißen Sie?“, vergisst jedoch möglicherweise den Kontext über 2.000 Wörter hinaus.

Technisch gesehen gibt es also eine Grenze für das, was Menschen von Deep Learning erwarten können. Wir hoffen jedoch, dass Benchmarks und Technologie eine kontinuierliche Anhäufung von Gedächtniserfahrungen ermöglichen und Offline-Lernen offensichtlich sehr leistungsfähig ist. Wir haben einen langen Weg zurückgelegt, wir haben erneut die Macht dieser Nachahmungen oder des Internetmaßstabs gesehen, diese grundlegenden Dinge über die Welt zu gewichten, aber es fehlt an Erfahrung.

Wenn wir mit Systemen sprechen, trainieren wir sie tatsächlich nicht einmal, es sei denn, ihr Gedächtnis ist beeinträchtigt. Das ist der dynamische Teil, aber sie lernen nicht auf die gleiche Weise, wie Sie und ich von Geburt an lernen. Was Ihre Frage betrifft, möchte ich hier darauf hinweisen, dass Erinnerung und Erfahrung etwas anderes sind als nur das Beobachten und Lernen über die Welt.

Das zweite Problem, das ich sehe, ist, dass wir alle diese Modelle von Grund auf trainieren. Es scheint, dass etwas fehlt, wenn wir das Modell nicht von Grund auf trainieren und uns von Anfang an inspirieren lassen. Es sollte für uns eine Möglichkeit geben, das Modell alle paar Monate wie eine Spezies zu trainieren, während viele andere Elemente des Universums aus früheren Iterationen aufgebaut werden. Aus der Perspektive eines reinen neuronalen Netzwerks ist es schwierig, die vorherigen Gewichte nicht zu verwerfen. Wir lernen und aktualisieren diese Gewichte aus den Daten. Es fühlt sich also so an, als ob etwas fehlt und wir es vielleicht irgendwann finden, aber wie es aussehen wird, ist noch nicht ganz klar.

Fridman: Das Training von Grund auf scheint eine Verschwendung zu sein. Es muss eine Möglichkeit geben, Gewichte jedes Mal wiederzuverwenden, wenn wir Go and Chess-, StarCraft- und Proteinfaltungsprobleme lösen, während wir riesige neue neuronale Netzwerkdatenbanken skalieren. Wie können wir Gewichte wiederverwenden? Wie lernt man, das Verallgemeinerbare zu extrahieren und den Rest zu verwerfen? Wie kann man Gewichte besser initialisieren?

Vinyals: Das Herzstück des Deep Learning ist die geniale Idee, dass ein einziger Algorithmus alle Aufgaben löst. Da immer mehr Benchmarks auftauchen, hat sich dieses Grundprinzip als unmöglich erwiesen. Das heißt, Sie haben eine leere, rechnerische, gehirnähnliche Initialisierung des neuronalen Netzwerks und füttern es dann beim überwachten Lernen mit weiteren Dingen.

Der Idealfall ist, dass die erwartete Eingabe und die Ausgabe auch so sein sollten, wie sie sind. Die Bildklassifizierung kann beispielsweise darin bestehen, eine von 1000 Kategorien auszuwählen. Dies ist das Bildnetzwerk. Viele Probleme lassen sich auf diese Weise abbilden. Es sollte auch einen allgemeinen Ansatz geben, den Sie für jede bestimmte Aufgabe verwenden können, ohne viele Änderungen vorzunehmen oder nachzudenken. Dies ist meiner Meinung nach der Kern der Deep-Learning-Forschung.

Wir haben es noch nicht herausgefunden, aber es wäre spannend, wenn die Leute weniger Tricks (einen allgemeinen Algorithmus) entdecken könnten, um wichtige Probleme zu lösen. Auf algorithmischer Ebene haben wir bereits etwas Allgemeines, eine Formel zum Trainieren sehr leistungsfähiger neuronaler Netzwerkmodelle auf großen Datenmengen.

Und in vielen Fällen müssen Sie die Besonderheiten einiger praktischer Probleme berücksichtigen. Das Proteinfaltungsproblem ist wichtig und es gibt bereits einige grundlegende Ansätze wie Transformer-Modelle, graphische neuronale Netze, Erkenntnisse aus NLP (wie BERT) und Wissensdestillation. In dieser Formel müssen wir auch etwas Einzigartiges für das Proteinfaltungsproblem finden, das sehr wichtig ist und wir es lösen sollten, und es ist möglich, dass das bei diesem Problem erlernte Wissen auf die nächste Iteration von Deep-Learning-Forschern angewendet wird.

Vielleicht gab es in den letzten 23 Jahren im Bereich des Meta-Lernens einige Fortschritte bei allgemeinen Algorithmen, hauptsächlich bei GPT-3, die im Sprachbereich erstellt wurden. Das Modell wird nur einmal trainiert und beschränkt sich nicht nur auf die Übersetzung von Sprachen oder nur auf die Kenntnis des einem Satz zugrunde liegenden Gefühls, das ihm tatsächlich durch Hinweise beigebracht werden kann, die ihm im Wesentlichen mehr Beispiele zeigen. Wir werden durch die Sprache motiviert, und die Sprache selbst ist für uns eine natürliche Möglichkeit, voneinander zu lernen. Vielleicht stellt es mir zuerst ein paar Fragen, und dann sage ich ihm, dass es diese neue Aufgabe erledigen soll. Sie müssen es nicht von Grund auf neu trainieren. Wir haben einige magische Momente beim Lernen mit wenigen Schüssen erlebt, bei denen die Sprache nur in reinen Sprachmodalitäten angeregt wurde.

In den letzten zwei Jahren haben wir gesehen, wie sich dies auf andere Modalitäten über die Sprache hinaus ausgeweitet hat, indem wir visuelle Elemente, Action und Spiele hinzugefügt haben und große Fortschritte gemacht haben. Dies könnte eine Möglichkeit sein, ein einzelnes Modell zu implementieren. Das Problem besteht darin, dass es schwierig ist, Gewicht oder Kapazität zu diesem Modell hinzuzufügen, aber es ist auf jeden Fall leistungsstark.

Aktuell wurden Fortschritte bei textbasierten Aufgaben oder visuellen Stilklassifizierungsaufgaben erzielt, aber es dürfte noch weitere Durchbrüche geben. Wir haben eine gute Ausgangslage und möchten, dass sich die Ausgangslage in Richtung allgemeiner künstlicher Intelligenz bewegt, und die Community bewegt sich in diese Richtung, was großartig ist. Was mich reizt, ist die Frage, was die nächsten Schritte im Deep Learning sind, um diese Modelle leistungsfähiger zu machen. Wie trainiere ich sie? Wenn sie sich weiterentwickeln müssen, wie können sie dann „gezüchtet“ werden? Sollten sie die Gewichte ändern, wenn Sie ihm Aufgaben beibringen? Es sind noch viele Fragen zu beantworten.

2. Generalist Agent Gato

Fridman: Können Sie den „Miau“- und Katzenausdruck in Ihrem Tweet erklären? Und was ist Gato? Wie funktioniert es? Um was für ein neuronales Netzwerk handelt es sich? Wie trainiere ich?

Vinyals: Zunächst einmal ist der Name Gato, wie auch eine Reihe anderer von DeepMind veröffentlichter Modelle, nach Tieren benannt. Große Sequenzmodelle beginnen nur mit der Sprache, erweitern jedoch auf andere Modalitäten. Gopher, Chinchilla, das sind reine Sprachmodelle, und kürzlich haben wir Flamingo herausgebracht, das sich mit dem Sehen befasst. Gato fügt visuelle und Aktionsmodalitäten wie oben, unten, links und rechts hinzu und kann auf natürliche Weise von Wörtern auf leistungsstarke Sprachsequenzmodelle abgebildet werden.

Vor der Veröffentlichung von Gato haben wir besprochen, welches Tier wir benennen sollten. Ich denke, das Wichtigste, was wir berücksichtigen sollten, ist das einzigartige Attribut von Gato, das auf Spanisch „Katze“ bedeutet.

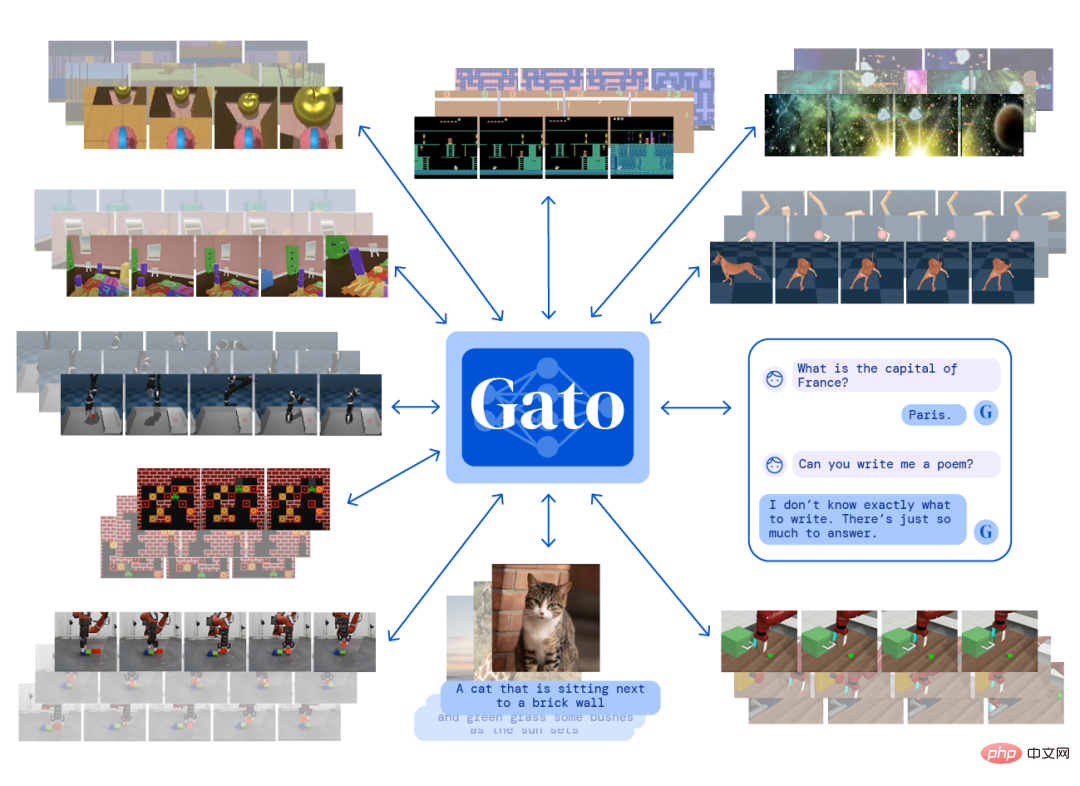

Die Grundlagen von Gato unterscheiden sich nicht von denen vieler anderer Jobs. Es handelt sich um ein Transformer-Modell, ein wiederkehrendes neuronales Netzwerk, das mehrere Modalitäten abdeckt, darunter Sehen, Sprache und Handeln. Das Ziel während des Trainings besteht darin, vorherzusagen, was als nächstes in der Abfolge kommt. Wenn es sich beim Training um eine Aktionssequenz handelt, dann darum, vorherzusagen, was die nächste Aktion ist. Auch Zeichenfolgen und Bildsequenzen ähneln sich. Wir betrachten sie alle als Bytes, und die Aufgabe des Modells besteht darin, vorherzusagen, was das nächste Byte ist. Dann können Sie dieses Byte als Aktion verstehen und diese Aktion im Spiel verwenden. Sie können es auch als Aktionswort verstehen und schreiben das Wort nach unten während des Gesprächs mit dem System.

Gatos Input umfasst Bilder, Texte, Videos, Aktionen und einige Wahrnehmungssensoren von Robotern, denn auch Roboter sind Teil der Trainingsinhalte. Es gibt Text und Aktionen aus, es gibt keine Bilder aus. Wir entwerfen derzeit ein solches Ausgabeformular, daher sage ich, dass Gato ein Anfang ist, da noch viel zu tun ist. Im Wesentlichen ist Gato ein Gehirn, das, wenn man ihm eine Folge von Beobachtungen und Modalitäten gibt, den nächsten Schritt in der Folge ausgibt. Dann beginnen Sie mit dem Übergang zum nächsten und sagen weiterhin den nächsten voraus und so weiter.

Jetzt ist es nicht nur ein Sprachmodell wie Chinchilla und Flamingo, sondern es ist auch ein Agent, der auf eine Vielzahl von Datensätzen trainiert wird, um einfach gut in StarCraft- und Atari-Spielen zu sein. oder gehen.

Fridman: Welche Art von Modell kann in Bezug auf die Aktionsmodalität als „intelligenter Agent“ bezeichnet werden?

Vinyals: Meiner Meinung nach ist ein Agent eigentlich die Fähigkeit, in einer Umgebung Maßnahmen zu ergreifen. Es reagiert, indem es der Umgebung eine Aktion erteilt, die eine neue Beobachtung zurückgibt, und dann die nächste Aktion generiert.

Die Art und Weise, wie wir Gato trainieren, besteht darin, den Beobachtungsdatensatz zu extrahieren, bei dem es sich um einen groß angelegten Imitations-Lernalgorithmus handelt, z. B. um ihn zu trainieren, um vorherzusagen, wie das nächste Wort im Datensatz lauten wird. Wir verfügen über einen Datensatz von Personen, die auf Webseiten SMS schreiben und chatten.

DeepMind interessiert sich für verstärkendes Lernen und Lernagenten, die in verschiedenen Umgebungen arbeiten. Wir haben einen Datensatz entwickelt, der die Erfahrungsverläufe des Agenten aufzeichnet. Andere Agenten, die wir ausbilden, verfolgen ein einziges Ziel, beispielsweise die Steuerung einer dreidimensionalen Spielumgebung und die Navigation durch ein Labyrinth. Wir fügen dem Datensatz die Erfahrungen hinzu, die wir aus der Interaktion eines Agenten mit der Umgebung gewonnen haben.

Beim Training von Gato mischen wir Daten wie Wörter und die Interaktion zwischen dem Agenten und der Umgebung für das Training. Dies ist die „Universalität“ von Gato. Für verschiedene Modalitäten und Aufgaben gibt es nur ein einziges „Gehirn“. Im Vergleich zu den meisten neuronalen Netzen der letzten Jahre ist es mit nur 1 Milliarde Parametern nicht so groß.

Trotz seiner geringen Größe ist der Trainingsdatensatz sehr anspruchsvoll und vielfältig und enthält nicht nur Internetdaten, sondern auch die Interaktionserfahrung des Agenten mit verschiedenen Umgebungen.

Im Prinzip kann Gato jede Umgebung steuern, insbesondere trainierte Videospiele, verschiedene Roboteraufgaben und andere Umgebungen. Aber es wird nicht besser sein als der Lehrer, der es unterrichtet hat. Gato ist immer noch relativ klein, daher ist es ein Anfang, die Synergie zwischen verschiedenen Modalitäten zu verbessern. Und ich glaube, es wird einige neue Möglichkeiten geben, Daten zu studieren oder aufzubereiten. Wir müssen dem Modell beispielsweise klar machen, dass es beim Spielen von Atari-Spielen nicht nur Auf- und Abbewegungen berücksichtigt, der Agent muss in der Lage sein, diese zu sehen Bevor Sie mit dem Spielen beginnen, können Sie einen Text verwenden, um ihm mitzuteilen: „Ich zeige Ihnen eine ganze Sequenz und Sie werden mit dem Spielen dieses Spiels beginnen.“ Daher kann Text eine Möglichkeit sein, die Daten zu verbessern.

Fridman: Wie tokenisiert man Text, Bilder, Spielaktionen und Roboteraufgaben?

Vinyals: Gute Frage. Die Tokenisierung ist ein Ausgangspunkt, um alle Daten in eine Sequenz zu bringen. Es ist, als würden wir alles in diese Puzzleteile zerlegen und dann simulieren, wie das Puzzle aussieht. Wenn man sie aneinanderreiht, ergeben sie eine Sequenz. Gato verwendet die aktuelle Standard-Text-Tokenisierungstechnologie. „ing“ ist beispielsweise eine häufig verwendete Teilzeichenfolge im Englischen und kann daher als Token verwendet werden.

Fridman: Wie viele Token werden für ein Wort benötigt?

Vinyals: Für ein englisches Wort beträgt die aktuelle Tokenisierungsgranularität im Allgemeinen 2 bis 5 Symbole, was größer als Buchstaben und kleiner als Wörter ist.

Fridman: Haben Sie versucht, Emojis zu tokenisieren?

Vinyals: Emojis sind eigentlich nur Buchstabenfolgen.

Fridman: Sind Emojis Bilder oder Text?

Vinyals: kann Emojis tatsächlich Zeichenfolgen zuordnen, sodass Sie dem Modell Emojis zuführen können und es Emojis ausgibt. In Gato verarbeiten wir Bilder so, dass wir sie in Pixel unterschiedlicher Intensität komprimieren, was zu einer sehr langen Pixelfolge führt.

Fridman: Da ist also keine Semantik im Spiel? Sie müssen nichts über das Bild verstehen?

Vinyals: Ja, hier wird nur der Begriff der Komprimierung verwendet. Auf der Tokenisierungsebene finden wir gemeinsame Muster zum Komprimieren von Bildern.

Fridman: Visuelle Informationen wie Farbe erfassen die Bedeutung eines Bildes, nicht nur Statistiken.

Vinyals: Beim maschinellen Lernen ist die Methode der Bildverarbeitung stärker datengesteuert. Wir verwenden einfach die Statistiken des Bildes und quantifizieren sie dann. Gemeinsame Teilzeichenfolgen werden als Token positioniert und Bilder sind ähnlich, es besteht jedoch keine Verbindung zwischen ihnen. Wenn wir uns Token als ganze Zahlen vorstellen, nehmen wir an, dass der Text 10.000 Token hat, von 1 bis 10.000, und sie repräsentieren alle Sprachen und Wörter, die wir sehen werden.

Das Bild ist ein weiterer Satz ganzer Zahlen von 10001 bis 20000, und die beiden sind völlig unabhängig. Was sie verbindet, sind die Daten, und im Datensatz gibt der Titel des Bildes an, worum es in dem Bild geht. Das Modell muss von Text zu Pixel vorhersagen, und die Korrelation zwischen beiden erfolgt, während der Algorithmus lernt. Zusätzlich zu Wörtern und Bildern können wir Aktionen auch ganze Zahlen zuweisen, sie diskretisieren und ähnliche Ideen verwenden, um Aktionen in Token zu komprimieren.

So ordnen wir nun alle räumlichen Typen ganzzahligen Sequenzen zu. Sie belegen jeweils unterschiedliche Räume, und was sie verbindet, ist der Lernalgorithmus.

Fridman: Du hast vorhin erwähnt, dass es schwer zu skalieren ist, was meinst du damit? Manche Notfälle haben Größengrenzen. Warum ist es so schwierig, ein Netzwerk wie Gato zu erweitern?

Vinyals: Eine Vergrößerung ist nicht schwer, wenn Sie das Gato-Netzwerk neu trainieren. Der Punkt ist, dass wir jetzt 1 Milliarde Parameter haben. Können wir die gleichen Gewichte verwenden, um diese auf ein größeres Gehirn zu übertragen? Das ist sehr schwierig. Es gibt also das Konzept der Modularität in der Softwareentwicklung, und es wurden einige Studien durchgeführt, in denen Modularität zum Einsatz kam. Flamingo verarbeitet keine Aktionen, ist aber leistungsstark im Umgang mit Bildern, und die Aufgaben zwischen diesen Projekten sind unterschiedlich und modular.

Wir haben die Modularität im Flamingo-Modell perfekt implementiert, wir haben die Gewichte des reinen Sprachmodells Chinchilla genommen, diese Gewichte dann eingefroren und einige neue neuronale Netze an den richtigen Stellen im Modell verbunden. Sie müssen herausfinden, wie Sie weitere Funktionen hinzufügen können, ohne andere Funktionen zu beeinträchtigen.

Wir erstellen ein kleines Subnetzwerk, das nicht zufällig initialisiert wird, sondern durch Selbstüberwachung lernt. Anschließend verwendeten wir den Datensatz, um die beiden Modalitäten visuell und verbal zu verbinden. Wir haben den größten Teil des Netzwerks eingefroren und dann einige Parameter zusätzlich zum Training von Grund auf hinzugefügt. Dann erschien Flamingo, seine Eingabe bestand aus Text und Bildern und seine Ausgabe war Text. Sie können ihm neue Sehaufgaben beibringen, und es macht Dinge, die über das hinausgehen, was der Datensatz selbst bietet, aber es nutzt einen Großteil der Sprachkenntnisse, die es von Chinchilla erhalten hat.

Die Schlüsselidee dieser Modularität besteht darin, dass wir ein eingefrorenes Gehirn nehmen und ihm eine neue Funktion hinzufügen. Bis zu einem gewissen Grad können Sie sehen, dass wir selbst bei DeepMind diesen Eklektizismus von Flamingo haben, der eine sinnvollere Nutzung der Skalierung ermöglicht, ohne ein System von Grund auf neu trainieren zu müssen.

Obwohl auch Gato denselben Datensatz verwendet, wird er von Grund auf trainiert. Ich denke, die große Frage für die Community ist: Sollten wir von Grund auf trainieren oder sollten wir uns auf Modularität konzentrieren? Modularität ist eine sehr effektive Möglichkeit zur Skalierung.

3. Meta-Lernen wird mehr Interaktionen beinhalten

Fridman: Können wir nach dem Aufkommen von Gato den Begriff „Meta-Lernen“ neu definieren? Was ist Ihrer Meinung nach Meta-Learning? Wird Meta-Learning in 5 oder 10 Jahren wie ein erweitertes Gato aussehen?

Vinyals: Vielleicht wäre ein Blick nach hinten statt nach vorne eine gute Perspektive. Wenn wir im Jahr 2019 über Meta-Learning sprechen, hat sich seine Bedeutung mit der GPT-3-Revolution größtenteils geändert. Der damalige Maßstab war die Fähigkeit, die Objektidentität zu erlernen, daher eignete er sich sehr gut für das Sehen und die Objektklassifizierung. Wir lernen nicht nur die 1000 Kategorien, die uns ImageNet vorgibt, sondern auch die Objektkategorien, die bei der Interaktion mit dem Modell definiert werden können.

Die Entwicklung des Modells ist interessant. Zunächst verfügen wir über eine spezielle Sprache, bei der es sich um einen kleinen Datensatz handelt, und wir geben dem Modell eine neue Klassifizierungsaufgabe. Mit Hinweisen in Form von Datensätzen für maschinelles Lernen erhalten wir ein System, das Objekte so vorhersagen oder klassifizieren kann, wie wir sie definieren. Schließlich wird das Sprachmodell zum Lernenden. GPT-3 zeigt, dass wir uns auf die Objektklassifizierung und die Bedeutung von Meta-Learning im Kontext des Lernens von Objektklassen konzentrieren können.

Jetzt sind wir nicht mehr an den Benchmark gebunden, wir können dem Modell direkt einige logische Aufgaben durch natürliche Sprache mitteilen. Diese Modelle sind nicht perfekt, aber sie erledigen neue Aufgaben und erlangen durch Meta-Learning neue Fähigkeiten. Das Flamingo-Modell erstreckt sich auf visuelle und sprachliche Multimodalität, verfügt jedoch über dieselben Fähigkeiten. Du kannst es lehren. Eine neue Funktion besteht beispielsweise darin, dass Sie ein Foto von einer Zahl machen und ihr das Rechnen beibringen können. Man zeigt ihm ein paar Beispiele und es lernt, sodass es weit über die bisherige Bildklassifizierung hinausgeht.

Dies erweitert die Bedeutung von Meta-Learning in der Vergangenheit. Meta-Learning ist ein sich ständig verändernder Begriff. Angesichts der aktuellen Fortschritte bin ich gespannt, was als nächstes passiert, vielleicht ist das in 5 Jahren eine andere Geschichte. Wir haben ein System mit einer Reihe von Gewichten und können ihm durch interaktive Eingabeaufforderungen beibringen, StarCraft zu spielen. Stellen Sie sich vor, Sie sprechen mit einem System, bringen ihm ein neues Spiel bei und zeigen ihm Beispiele des Spiels. Vielleicht stellt Ihnen das System sogar Fragen wie: „Ich habe dieses Spiel gerade gespielt, habe ich gut gespielt? Können Sie mir in fünf oder zehn Jahren mehr beibringen?“ In speziellen Bereichen werden diese Lernfähigkeiten interaktiver sein und reicher. Ganz anders ist beispielsweise AlphaStar, das wir speziell für StarCraft entwickelt haben. Der Algorithmus ist allgemein, aber die Gewichte sind spezifisch.

Meta-Lernen geht über Aufforderungen hinaus und umfasst mehr Interaktionen. Das System fordert uns möglicherweise auf, ihm Feedback zu geben, nachdem es einen Fehler gemacht oder ein Spiel verloren hat. Tatsächlich existieren die Benchmarks bereits, wir haben lediglich ihre Ziele geändert. In gewisser Weise stelle ich mir allgemeine künstliche Intelligenz wie folgt vor: Wir haben bereits eine Leistung von 101 % bei bestimmten Aufgaben wie Schach und StarCraft, und in der nächsten Iteration können wir bei allen Aufgaben eine Leistung von 20 % erreichen. Der Fortschritt der nächsten Modellgeneration geht definitiv in diese Richtung. Natürlich können wir bei manchen Dingen einen Fehler machen, z. B. weil wir nicht über die nötigen Werkzeuge verfügen oder vielleicht nicht genug Transformer. In den nächsten 5 bis 10 Jahren werden die Gewichte des Modells wahrscheinlich trainiert sein, und es wird mehr darum gehen, zu lehren oder dem Modell Meta-Lernen zu ermöglichen.

Dies ist ein interaktiver Unterricht. Im Bereich des maschinellen Lernens wird diese Methode schon lange nicht mehr zur Bearbeitung von Klassifizierungsaufgaben eingesetzt. Meine Idee ähnelt ein wenig dem Algorithmus für den nächsten Nachbarn. Es ist fast der einfachste Algorithmus und erfordert kein Lernen oder Berechnen von Gradienten. Der nächste Nachbar misst den Abstand zwischen Punkten in einem Datensatz. Um dann einen neuen Punkt zu klassifizieren, müssen Sie nur berechnen, welcher Punkt in dieser großen Datenmenge der nächste ist. Sie können sich den Hinweis also so vorstellen: Sie verarbeiten beim Hochladen nicht nur einfache Punkte, sondern fügen dem vorab trainierten System Wissen hinzu.

Der Tipp ist eine Weiterentwicklung eines sehr klassischen Konzepts des maschinellen Lernens, nämlich das Lernen am nächsten Punkt. In einer unserer Studien aus dem Jahr 2016 wurde die Methode des nächsten Nachbarn verwendet, die auch im Bereich Computer Vision sehr verbreitet ist. Die Berechnung des Abstands zwischen zwei Bildern ist ein sehr aktives Forschungsgebiet Holen Sie sich auch einen guten Klassifikator.

Diese Abstände und Punkte sind nicht auf Bilder beschränkt, sondern können auch Texte oder Texte, Bilder, Aktionssequenzen und andere neue Informationen sein, die dem Modell beigebracht werden. Wir werden wahrscheinlich kein Krafttraining mehr machen. Einige Techniken des Meta-Lernens führen eine Feinabstimmung durch, und wenn sie eine neue Aufgabe bekommen, trainieren sie die Gewichte ein wenig.

4. Die Kraft von Transformer

Fridman: Wir haben allgemeine, großformatige Modelle und Agenten wie Flamingo, Chinchilla und Gopher hergestellt. Was sind ihre technischen Besonderheiten?

Vinyals: Ich denke, der Schlüssel zum Erfolg liegt in der Technik. Das erste ist Data Engineering, denn was wir am Ende sammeln, ist ein Datensatz. Dann folgt das Bereitstellungsprojekt, bei dem wir das Modell in großem Umfang auf einigen Rechenclustern bereitstellen. Dieser Erfolgsfaktor gilt für alles, der Teufel steckt tatsächlich im Detail.

Darüber hinaus gibt es Fortschritte im aktuellen Benchmark. Ein Team verbringt mehrere Monate mit einer Recherche und ist sich nicht sicher, ob es gelingt, aber wenn man kein Risiko eingeht und etwas tut, das unmöglich erscheint, wird es keine Chance geben des Erfolgs. Wir brauchen jedoch eine Möglichkeit, den Fortschritt zu messen, daher ist die Festlegung von Benchmarks von entscheidender Bedeutung.

Wir haben AlphaFold anhand umfangreicher Benchmarks entwickelt und die Daten und Indikatoren für dieses Projekt sind alle sofort verfügbar. Bei einem guten Team sollte es nicht darum gehen, schrittweise Verbesserungen zu finden und eine Arbeit zu veröffentlichen, sondern darum, ein höheres Ziel zu haben und jahrelang daran zu arbeiten.

Im Bereich des maschinellen Lernens mögen wir Architekturen wie neuronale Netze, und bevor Transformer auf den Markt kam, war dies ein sehr schnell wachsender Bereich. „Aufmerksamkeit ist alles, was Sie brauchen“ ist in der Tat ein großartiges Aufsatzthema. Diese Architektur erfüllt unseren Traum, jede beliebige Bytefolge zu modellieren. Ich denke, der Fortschritt dieser Architekturen liegt in gewissem Maße in der Funktionsweise neuronaler Netze. Es ist schwierig, eine Architektur zu finden, die vor fünf Jahren erfunden wurde, immer noch stabil ist und sich kaum verändert hat, sodass Transformer weiterhin in vielen Projekten auftauchen kann . ist überraschend.

Fridman: Wo liegt auf der philosophischen Ebene der Technologie die Magie der Aufmerksamkeit? Wie funktioniert Aufmerksamkeit im menschlichen Geist?

Vinyals: Es gibt einen Unterschied zwischen Transformer und künstlichen neuronalen Netzwerken mit langem Kurzzeitgedächtnis. In den frühen Tagen von Transformer waren LSTMs noch sehr leistungsfähige Sequenzmodelle. Die Stärke von Transformer besteht darin, dass eine induktive Aufmerksamkeitsverzerrung eingebaut ist. Angenommen, wir möchten eine komplexe Aufgabe für eine Reihe von Wörtern lösen, z. B. die Übersetzung eines gesamten Absatzes oder die Vorhersage des nächsten Absatzes basierend auf den vorherigen zehn Absätzen.

Intuitiv erledigt Transformer diese Aufgaben, indem er Menschen nachahmt und nachahmt. Nachdem Sie gerade einen Textabschnitt gelesen haben, werden Sie vielleicht einen weiteren Blick darauf werfen wollen Im Text ist dies ein hypothesengesteuerter Prozess. Wenn ich mich frage, ob mein nächstes Wort „Katze“ oder „Hund“ sein wird, funktioniert der Transformer so, dass er zwei Annahmen hat: Wird es Katze sein? Oder ein Hund? Wenn es sich um eine Katze handelt, finde ich einige Wörter (nicht unbedingt das Wort „Katze“ selbst) und gehe meine Schritte zurück, um zu sehen, ob „Katze“ oder „Hund“ sinnvoller ist.

Dann führt es einige sehr tiefgreifende Berechnungen für Wörter durch, kombiniert Wörter und kann auch Abfragen durchführen. Wenn Sie wirklich über den Text nachdenken, müssen Sie sich den gesamten Text oben noch einmal ansehen, aber was lenkt die Aufmerksamkeit? Was ich gerade geschrieben habe, ist sicherlich wichtig, aber das, was Sie vor zehn Seiten geschrieben haben, kann auch entscheidend sein, daher müssen Sie nicht über die Platzierung nachdenken, sondern über den Inhalt. Transformer können bestimmte Inhalte abfragen und zur besseren Entscheidungsfindung herausziehen. Dies ist eine Möglichkeit, Transformer zu erklären, und ich denke, dass diese induktive Vorspannung sehr mächtig ist. Der Transformer kann im Laufe der Zeit einige detaillierte Änderungen aufweisen, aber die induktive Vorspannung macht den Transformer leistungsfähiger als ein wiederkehrendes Netzwerk, das auf der Aktualitätsvorspannung basiert, was bei einigen Aufgaben effektiv ist, aber sehr große Mängel aufweist.

Transformer selbst hat auch Mängel. Ich denke, eine der größten Herausforderungen sind die Aufforderungen, die wir gerade besprochen haben. Eine Eingabeaufforderung kann bis zu 1000 Wörter lang sein, oder ich muss dem System sogar ein Video und einen Wikipedia-Artikel über ein Spiel zeigen. Ich musste auch mit dem System interagieren, während es das Spiel spielte, und mir Fragen stellen. Ich muss ein guter Lehrer sein, um Modellen beizubringen, Dinge zu erreichen, die über ihre derzeitigen Fähigkeiten hinausgehen. Die Frage ist also: Wie vergleichen wir diese Aufgaben? Wie verändern wir die Struktur der Architektur? Das ist umstritten.

Fridman: Wie wichtig sind einzelne Menschen bei all diesem Forschungsfortschritt? Inwieweit haben sie das Feld verändert? Sie leiten jetzt die Deep-Learning-Forschung bei DeepMind, Sie haben viele Projekte, viele brillante Forscher, wie viel Veränderung können all diese Menschen bewirken?

Vinyals: Ich glaube, dass Menschen eine große Rolle spielen. Manche Leute möchten eine Idee haben, die funktioniert, und dabei bleiben, andere sind vielleicht praktischer und es ist ihnen egal, welche Idee funktioniert, solange sie die Proteinfaltung knacken können. Wir brauchen diese beiden scheinbar gegensätzlichen Ideen. Historisch gesehen haben beide früher oder später etwas hervorgebracht. Die Unterscheidung zwischen den beiden ähnelt möglicherweise auch dem sogenannten Exploration-Exploitation-Tradeoff im Bereich des verstärkenden Lernens. Wenn Sie mit Menschen in einem Team oder bei einem Meeting interagieren, werden Sie schnell feststellen, dass etwas erforschbar oder ausnutzbar ist.

Es ist falsch, irgendeinen Forschungsstil zu leugnen. Ich komme aus der Branche, also verfügen wir über große Rechenleistung, und es wird auch entsprechende spezifische Arten von Forschung geben. Für den wissenschaftlichen Fortschritt müssen wir Fragen beantworten, die wir jetzt beantworten sollten.

Gleichzeitig sehe ich auch große Fortschritte. Der Aufmerksamkeitsmechanismus wurde ursprünglich in Montreal, Kanada, aufgrund mangelnder Rechenleistung entdeckt, als wir mit unseren Freunden bei Google Brain an Sequenz-zu-Sequenz-Modellen arbeiteten. Wir haben 8 GPUs verwendet (was damals tatsächlich viel war), und ich denke, Montreal war hinsichtlich des Rechenumfangs noch relativ begrenzt. Doch dann entdeckten sie das Konzept der inhaltsbasierten Aufmerksamkeit, das schließlich zu Transformer führte.

Fridman: Viele Leute denken, dass Genie in großartigen Ideen steckt, aber ich vermute, dass Genie in der Technik oft im Detail liegt. Manchmal kann ein einzelner Ingenieur oder einige wenige Ingenieure das ändern, was wir tun, insbesondere solche, die eine technische Entscheidung treffen Auf einem Großrechner erstellt, kann eine Kettenreaktion auslösen.

Vinyals: Wenn Sie auf die Geschichte der Entwicklung von Deep Learning und neuronalen Netzen zurückblicken, werden Sie feststellen, dass es zufällige Elemente gibt. Weil GPUs zufällig zum richtigen Zeitpunkt erschienen, allerdings für Videospiele. Auch die Hardwareentwicklung wird also vom Zeitfaktor beeinflusst. Aufgrund dieser Hardware-Revolution wurden auch Rechenzentren gegründet. Zum Beispiel die Rechenzentren von Google. Mit einem solchen Rechenzentrum können wir Modelle trainieren. Auch Software ist ein wichtiger Faktor und immer mehr Menschen betreten diesen Bereich. Wir können auch erwarten, dass ein System über alle Benchmarks verfügt.

5. KI ist noch weit davon entfernt, Bewusstsein zu entwickeln

Fridman: Sie haben gemeinsam mit Jeff Dean, Percy Liang und anderen einen Artikel mit dem Titel „Emergent Abilities of Large Language Models“ verfasst. Wie lässt sich Emergenz in neuronalen Netzen intuitiv erklären? Gibt es einen magischen Wendepunkt? Ist dies von Aufgabe zu Aufgabe unterschiedlich?

Vinyals: Nehmen Sie Benchmarking als Beispiel. Wenn Sie das System trainieren und analysieren, wie stark sich die Datensatzgröße auf die Leistung auswirkt, wie sich die Modellgröße auf die Leistung auswirkt, wie lange es dauert, das System zu trainieren, um die Leistung zu beeinflussen usw., verläuft die Kurve recht glatt. Wenn wir ImageNet als eine sehr glatte und vorhersehbare Trainingskurve betrachten, sieht es in gewisser Weise ziemlich glatt und vorhersehbar aus.

Auf der sprachlichen Seite erfordert der Benchmark mehr Nachdenken, auch wenn es sich bei der Eingabe um einen Satz handelt, der ein mathematisches Problem beschreibt, erfordert er mehr Verarbeitung und mehr Selbstbeobachtung. Die Leistung des Modells kann zufällig werden, bis das Abfragesystem von Transformer oder ein Sprachmodell wie Transformer eine korrekte Frage stellt, und die Leistung beginnt, sich von zufällig zu nicht zufällig zu ändern. Dies ist sehr empirisch und basiert auf keiner Formalisierungstheorie .

Fridman: Kürzlich behauptete ein Google-Ingenieur, dass das Lambda-Sprachmodell bewusst sei. Dieser Fall berührt den menschlichen Aspekt, den technischen Aspekt des maschinellen Lernens und den philosophischen Aspekt der Rolle von KI-Systemen in der menschlichen Welt. Welche Perspektive haben Sie als Ingenieur für maschinelles Lernen und als Mensch?

Vinyals: Ich denke, dass alle aktuellen Modelle noch lange nicht bei Bewusstsein sind. Ich habe das Gefühl, ein bisschen ein gescheiterter Wissenschaftler zu sein, und ich habe immer das Gefühl, maschinelles Lernen als eine Wissenschaft zu sehen, die möglicherweise anderen Wissenschaften helfen könnte. Ich mag Astronomie und Biologie, aber ich bin kein Experte auf diesen Gebieten, also ich beschloss, maschinelles Lernen zu studieren.

Aber als ich mehr über Alphafold erfuhr und etwas über Proteine, Biologie und Biowissenschaften lernte, begann ich zu beobachten, was auf atomarer Ebene geschah. Wir neigen dazu, neuronale Netze als Gehirne zu betrachten, und wenn ich kein Experte bin, kommt mir das komplex und magisch vor, aber biologische Systeme sind weitaus komplexer als rechnerische Gehirne, und bestehende Modelle haben noch nicht das Niveau biologischer Gehirne erreicht.

Ich bin nicht so überrascht über diesen Google-Ingenieur. Vielleicht, weil ich sehe, dass die Zeitkurve glatter wird, haben sich Sprachmodelle seit Shannons Arbeit in den 50er Jahren nicht so schnell weiterentwickelt, und die Ideen, die wir vor 100 Jahren hatten, unterscheiden sich nicht allzu sehr von den Ideen, die wir heute haben. Aber niemand sollte anderen sagen, was sie denken sollen.

Die Komplexität, die der Mensch seit Beginn seiner Erschaffung besitzt, und die Komplexität der Entwicklung des Universums als Ganzes sind für mich um eine Größenordnung faszinierender. Es ist gut, von dem, was man tut, besessen zu sein, aber ich wünschte, ein Biologieexperte würde mir sagen, dass es nicht so magisch ist. Durch die Interaktion in der Gemeinschaft erlangen wir außerdem ein Bildungsniveau, das hilft zu verstehen, was nicht normal, was unsicher usw. ist, ohne das eine Technologie nicht richtig genutzt werden kann.

Fridman: Muss ein System Bewusstsein erlangen, um Intelligenzprobleme zu lösen? Welcher Teil des menschlichen Geistes ist bei der Entwicklung von KI-Systemen hilfreich?

Vinyals: Ich glaube nicht, dass die Intelligenz eines Systems den Punkt erreichen muss, an dem es über ein äußerst nützliches Gehirn verfügt, das Sie herausfordern und führen kann. Stattdessen sollten Sie ihm beibringen, Dinge zu tun. Persönlich bin ich mir nicht sicher, ob Bewusstsein notwendig ist. Vielleicht werden Bewusstsein oder andere biologische oder evolutionäre Perspektiven unsere Algorithmen der nächsten Generation beeinflussen.

Die Details der Berechnungen, die das menschliche Gehirn und neuronale Netze durchführen, sind unterschiedlich. Natürlich gibt es einige Ähnlichkeiten zwischen den beiden, aber wir wissen nicht genug über die Details des Gehirns. Aber wenn man den Umfang ein wenig einschränkt, etwa auf unseren Denkprozess, wie das Gedächtnis funktioniert, sogar wie wir uns zu dem entwickelt haben, was wir jetzt sind, was Erforschung und Entwicklung sind usw., können diese die Forschung auf Algorithmusebene inspirieren.

Fridman: Stimmen Sie Richard Sutton in „The Bitter Lesson“ zu, dass die größte Lektion aus 70 Jahren KI-Forschung darin besteht, dass allgemeine Methoden zur Nutzung der Rechenleistung letztendlich funktionieren?

Vinyals: Ich kann nur zustimmen. Für den Aufbau vertrauenswürdiger, komplexer Systeme ist Skalierung erforderlich. Das reicht möglicherweise nicht aus und wir brauchen einige Durchbrüche. Sutton erwähnte, dass die Suche eine Skalierungsmethode ist und dass die Suche in einem Bereich wie Go nützlich ist, weil es eine klare Belohnungsfunktion gibt. Aber bei einigen anderen Missionen waren wir nicht ganz sicher, was wir tun sollten.

6. KI kann mindestens über eine Intelligenz auf menschlichem Niveau verfügen

Fridman: Glauben Sie, dass wir in Ihrem Leben ein allgemeines künstliches Intelligenzsystem aufbauen können, das die menschliche Intelligenz erreicht oder sogar übertrifft?

Vinyals: Ich bin absolut davon überzeugt, dass es Intelligenz auf menschlichem Niveau haben wird. Das Wort „Transzendenz“ ist schwer zu definieren, insbesondere wenn wir aktuelle Standards aus der Perspektive des Nachahmungslernens betrachten. Wir können KI durchaus dazu bringen, Menschen in der Sprache zu imitieren und zu übertreffen. Um durch Nachahmung auf die menschliche Ebene zu gelangen, sind verstärktes Lernen und andere Dinge erforderlich. In einigen Bereichen zahlt es sich bereits aus.

Wenn es darum geht, menschliche Fähigkeiten zu übertreffen, ist AlphaGo bei weitem mein Lieblingsbeispiel. Und im Allgemeinen bin ich mir nicht sicher, ob wir eine Belohnungsfunktion so definieren können, dass sie die menschliche Intelligenz nachahmt. Was die Transzendenz angeht, bin ich mir noch nicht sicher, aber sie wird definitiv die menschliche Ebene erreichen. Offensichtlich werden wir nicht versuchen, darüber hinauszugehen, und wenn wir das täten, hätten wir übermenschliche Wissenschaftler und Entdeckungen, um die Welt voranzubringen, aber zumindest Systeme auf menschlicher Ebene wären sehr mächtig.

Fridman: Glauben Sie, dass es einen einzigartigen Moment geben wird, in dem Milliarden intelligenter Agenten, die das menschliche Niveau erreichen oder übertreffen, tief in die menschliche Gesellschaft integriert sind? Wirst du Angst haben oder dich auf die Welt freuen?

Vinyals: Vielleicht müssen wir darüber nachdenken, ob wir dieses Ziel tatsächlich erreichen können. Das Zusammenleben zu vieler Menschen mit begrenzten Ressourcen kann zu Problemen führen. Mengenbegrenzungen dürften wohl auch für digitale Entitäten gelten. Dies geschieht aus Gründen der Energieverfügbarkeit, da sie auch Energie verbrauchen.

Tatsächlich sind die meisten Systeme in Bezug auf den Energiebedarf weniger effizient als wir. Aber ich denke, als Gesellschaft müssen wir zusammenarbeiten, um vernünftige Wege zu finden, um zu wachsen und zusammenzuleben. Ich würde mich freuen, wenn es passieren würde, Aspekte der Automatisierung, die Menschen Zugriff auf bestimmte Ressourcen oder Wissen ermöglichen, die sonst offensichtlich keinen Zugriff darauf hätten, und das ist die Anwendung, auf die ich am meisten gespannt bin.

Fridman: Letzte Frage: Wird es in der zukünftigen Welt mehr Menschen oder mehr Roboter geben, wenn die Menschen das Sonnensystem verlassen?

Vinyals: Menschen und KI mögen sich vermischen und nebeneinander existieren, das ist nur Spekulation, aber es gibt bereits Unternehmen, die versuchen, uns auf diese Weise besser zu machen. Ich möchte, dass das Verhältnis höchstens 1:1 beträgt. 1:1 ist vielleicht machbar, aber das Gleichgewicht zu verlieren ist nicht gut.

Original-Videolink: https://youtu.be/aGBLRlLe7X8

Das obige ist der detaillierte Inhalt vonAktuelles Interview mit DeepMind-Chefwissenschaftler Oriol Vinyals: Die Zukunft der allgemeinen KI ist starkes interaktives Meta-Lernen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen