Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Hinzufügen realen Agentenverhaltens zum autonomen Fahrsimulator CARLA

Hinzufügen realen Agentenverhaltens zum autonomen Fahrsimulator CARLA

Hinzufügen realen Agentenverhaltens zum autonomen Fahrsimulator CARLA

arXiv-Artikel „Einfügung realer Agentenverhaltensweisen in den autonomen Fahrsimulator CARLA“, 22. Juni, Spanien.

Die Rolle der Simulation beim autonomen Fahren wird aufgrund des Bedarfs an schnellem Prototyping und umfangreichen Tests immer wichtiger. Physikbasierte Simulation bietet zahlreiche Vorteile und Vorteile zu angemessenen Kosten und eliminiert gleichzeitig das Risiko für Prototyping, Fahrer und Gefährdete Verkehrsteilnehmer (VRU).

Es gibt jedoch zwei wesentliche Einschränkungen. Erstens bezieht sich die bekannte Realitätslücke auf den Unterschied zwischen Realität und Simulation, der verhindert, dass simulierte autonome Fahrerlebnisse eine effektive Leistung in der realen Welt erzielen. Zweitens mangelt es an empirischem Wissen über das Verhalten realer Akteure (Menschen), darunter Ersatzfahrer oder Beifahrer und andere Verkehrsteilnehmer wie Fahrzeuge, Fußgänger oder Radfahrer.

Agentensimulationen sind in der Regel vorprogrammiert, probabilistisch zufällig oder auf der Grundlage realer Daten generiert, stellen jedoch nicht das Verhalten realer Agenten dar, die mit bestimmten Simulationsszenarien interagieren. In diesem Artikel wird ein vorläufiger Rahmen vorgeschlagen, der eine Echtzeitinteraktion zwischen realen Agenten und simulierten Umgebungen, einschließlich autonomer Fahrzeuge, ermöglicht und synthetische Sequenzdaten von simulierten Sensoren über mehrere Ansichten hinweg generiert, um Vorhersagesysteme zu trainieren, die auf Verhaltensmodellen basieren.

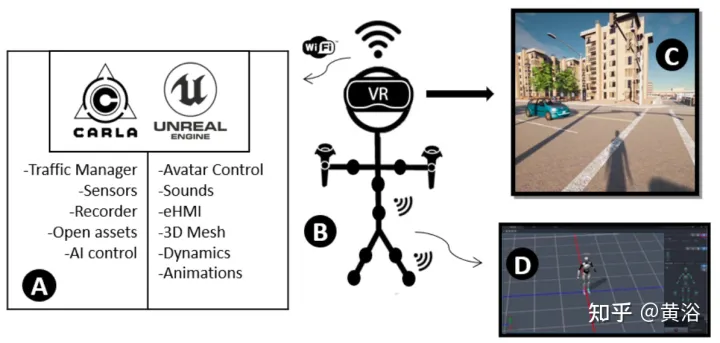

Dieser Ansatz integriert immersive Virtual Reality (VR)- und Human Motion Capture (HMC)-Systeme mit CARLA für autonomes Fahren. Es beschreibt die Hardware- und Softwarearchitektur und diskutiert die sogenannte Verhaltenslücke.

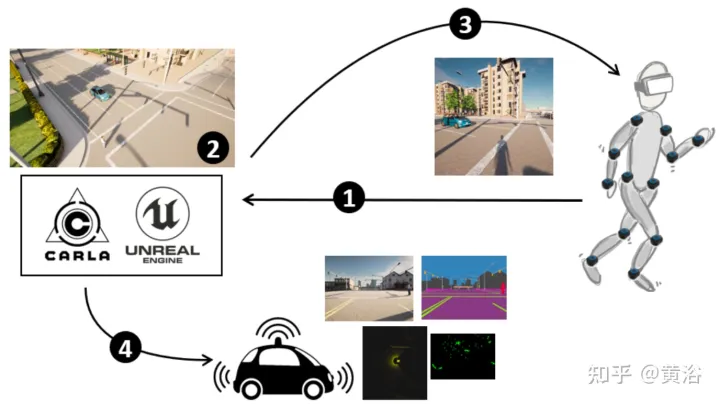

Die Abbildung zeigt einen Überblick über die Methode: (1) CARLA-UE ist mit Kopf- (VR-Headset) und Körperhaltungen (Motion-Capture-System) ausgestattet. (2) Generieren Sie Szenen mit autonomen Fahrzeugen und digitalen Fußgängern. (3) Bereitstellung einer Umgebung für Fußgänger (über VR-Headsets). (4) Automatische Fahrzeugsensoren erfassen die Umgebung, einschließlich Fußgänger.

Im Folgenden werden die Funktionen des immersiven VR-Systems im autonomen Fahrsimulator CARLA vorgestellt.

Erreichen Sie ein vollständiges Eintauchen in Fußgänger, indem Sie Verhaltens- und Interaktionsstudien durchführen und dabei die Funktionen von UE4 und externer Hardware wie VR-Brillen und einer Reihe von Bewegungssensoren nutzen.

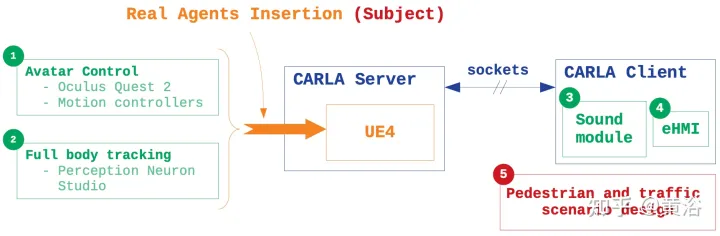

Der CARLA-Open-Source-Simulator ist auf UE4 implementiert und bietet hochwertiges Rendering, realistische Physikumgebungen und ein Ökosystem interoperabler Plug-Ins. CARLA simuliert dynamische Verkehrsszenen und bietet eine Schnittstelle zwischen der von UE4 erstellten virtuellen Welt und dem in der Szene laufenden Straßenagenten. Um dies zu erreichen, ist CARLA als Server-Client-System konzipiert, wobei der Server die Simulation ausführt und die Szene rendert. Die Kommunikation zwischen Client und Server erfolgt über Sockets.

Die Hauptmerkmale des Einfügens realen Agentenverhaltens in die Simulation basieren auf fünf Punkten (wie in der Abbildung dargestellt): 1) Avatar-Steuerung: CARLA-Blueprint-Bibliothek, sammelt die Architektur aller Rollen und Attribute und ändert sie der Fußgänger-Entwurf, in Erstellen Sie eine immersive und bewegliche VR-Schnittstelle zwischen Menschen und der virtuellen Welt; 2) Körperverfolgung: Verwenden Sie eine Reihe von Trägheitssensoren und proprietärer externer Software, um die Bewegung und Bewegungswahrnehmung des Motivs durch reale Szenen zu erfassen und Avatare zu übertragen Bewegung durch .bvh-Dateien In den Simulator integriert; 3) Sounddesign: Da CARLA ein audioloser Simulator ist, werden Positionsgeräusche in die Umgebung eingebracht, um das Eintauchen zu verbessern; 4) eHMI-Integration: Ermöglicht die Kommunikation des autonomen Fahrzeugstatus und Absichtsinformationen, führen Sie interaktive Recherchen durch; 5) Szenensimulation: Entwerfen Sie Verkehrsszenen im CARLA-Client, um das Verhalten von Fahrzeugen und Fußgängern zu steuern.

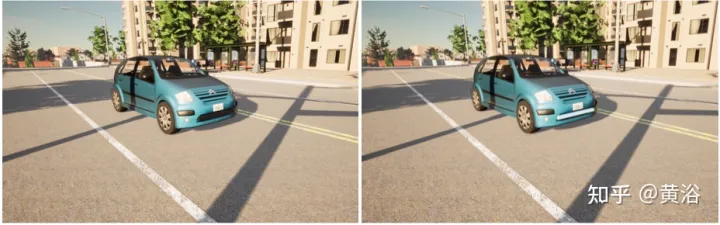

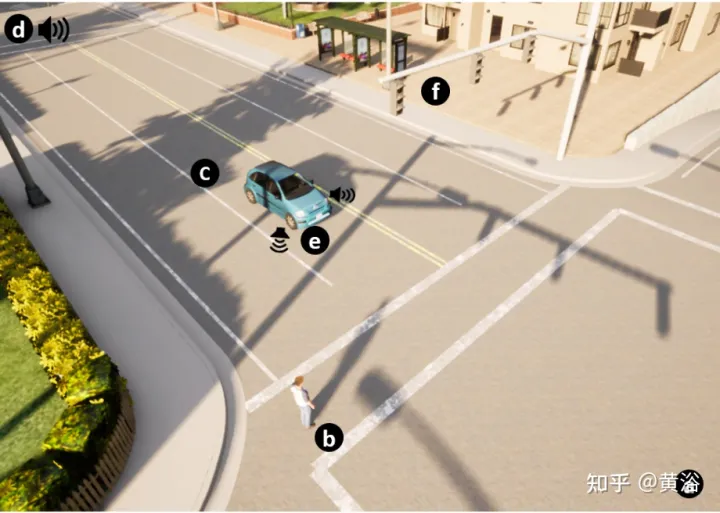

Die Kommunikation zwischen Verkehrsteilnehmern ist ein wichtiger Faktor im Verkehrsumfeld. Im Experiment wurde eine externe Mensch-Maschine-Schnittstelle (eHMI) für das autonome Fahrzeug bereitgestellt, um seinen Status und seine Absichten den tatsächlichen Verkehrsteilnehmern mitzuteilen.

Wie in der Abbildung dargestellt, besteht das vorgeschlagene eHMI-Design aus einem Lichtstreifen entlang der Fahrzeugfront. Das Bild links ist ohne eHMI und das Bild rechts ist mit eHMI. Dies ermöglicht die Untersuchung der Auswirkung der Schnittstelle auf die Entscheidungsfindung, wenn Fußgänger-Trajektorien mit Fahrzeug-Trajektorien in virtuellen Szenen zusammenlaufen.

Die gesamte Systemarchitektur ist in der Abbildung dargestellt:

CARLA bietet verschiedene Möglichkeiten zur Simulation von Verkehr und spezifischen Verkehrsszenarien. Füllen Sie Simulationen mit realistischen städtischen Verkehrsbedingungen mit Verkehrsmanagementmodulen. Die Steuerung jedes Fahrzeugs wird in einem bestimmten Thread ausgeführt. Die Kommunikation mit anderen Schichten wird durch synchrones Messaging verwaltet.

Kontrollieren Sie den Verkehrsfluss, indem Sie Parameter festlegen, die ein bestimmtes Verhalten erzwingen. Beispielsweise kann es Autos erlaubt werden, zu schnell zu fahren, Ampelbedingungen zu ignorieren, Fußgänger zu ignorieren oder einen Spurwechsel zu erzwingen.

Der Hauptkörper ist in den Simulator integriert, einschließlich einer 3D-Modellkarte der Stadt. Jede Karte basiert auf einer OpenDRIVE-Datei, die einen vollständig kommentierten Straßenverlauf beschreibt. Mit dieser Funktion können Sie Ihre eigenen Karten entwerfen, dieselben Verkehrsszenarien in realen und virtuellen Umgebungen reproduzieren, die Integration des realen Verhaltens des Simulators bewerten und Feldstudien durch den Vergleich von Interaktionsergebnissen durchführen.

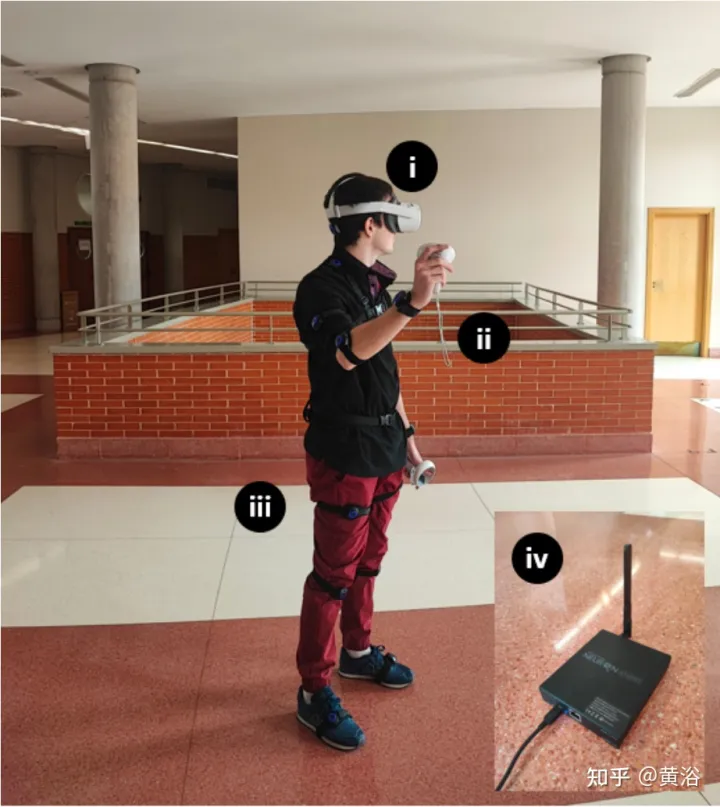

Das Hardware-Setup ist wie im Bild dargestellt: Während des Experiments wurde Oculus Quest 2 als Head-Mounted Device (HMD) verwendet, erstellt von Meta, 6 GB RAM-Prozessor, zwei einstellbaren 1832 x 1920-Objektiven, 90 Hz Bildwiederholfrequenz und 256 GB Speicher. Das Quest 2 verfügt über Wi-Fi 6, Bluetooth 5.1 und USB-Typ-C-Konnektivität, SteamVR-Unterstützung und 3D-Lautsprecher. Für die Ganzkörperverfolgung kombinieren Sie die Lösung mit PNS mit einem Trägheitstracker. Das Kit enthält ein eigenständiges VR-Headset, 2 Motion Controller, 17 Studio-Trägheitskörpersensoren, 14 Gurtsätze, einen Ladekoffer und einen Studio-Transceiver.

Da CARLA Build und Quest 2 nur auf Windows basieren, basiert das VR Immersion System derzeit auf den Betriebssystemen UE4.24 und Windows 10. Mit dem TCP-Sockets-Plugin werden die Position des Editors aller Teilnehmer und andere nützliche Parameter von der Python-API gesendet, wodurch die Stimme jedes Teilnehmers oder das eHMI eines autonomen Fahrzeugs integriert wird. „VR Preview“ startet das Spiel auf HMD. Perception Neuron Studio arbeitet mit Axis Studio, das bis zu drei Probanden gleichzeitig und 23 Körper- und Fingersensoren gleichzeitig unterstützt.

Das Bild zeigt die Simulation interaktiver Verkehrsbedingungen: (a) 3D-Weltdesign. (b) Passender Testamentsvollstrecker-Avatar für Fußgänger. (c) Selbstfahrende Autos. (d) Umgebungsgeräusche und intelligente Geräusche. (e) eHMI. (f) Ampeln und Verkehrszeichen.

Das obige ist der detaillierte Inhalt vonHinzufügen realen Agentenverhaltens zum autonomen Fahrsimulator CARLA. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Beherrschen Sie die Koordinatensystemkonvertierung wirklich? Multisensorik-Themen, die für das autonome Fahren unverzichtbar sind

Oct 12, 2023 am 11:21 AM

Der erste Pilot- und Schlüsselartikel stellt hauptsächlich mehrere häufig verwendete Koordinatensysteme in der autonomen Fahrtechnologie vor und erläutert, wie die Korrelation und Konvertierung zwischen ihnen abgeschlossen und schließlich ein einheitliches Umgebungsmodell erstellt werden kann. Der Schwerpunkt liegt hier auf dem Verständnis der Umrechnung vom Fahrzeug in den starren Kamerakörper (externe Parameter), der Kamera-in-Bild-Konvertierung (interne Parameter) und der Bild-in-Pixel-Einheitenkonvertierung. Die Konvertierung von 3D in 2D führt zu entsprechenden Verzerrungen, Verschiebungen usw. Wichtige Punkte: Das Fahrzeugkoordinatensystem und das Kamerakörperkoordinatensystem müssen neu geschrieben werden: Das Ebenenkoordinatensystem und das Pixelkoordinatensystem. Schwierigkeit: Sowohl die Entzerrung als auch die Verzerrungsaddition müssen auf der Bildebene kompensiert werden. 2. Einführung Insgesamt gibt es vier visuelle Systeme Koordinatensystem: Pixelebenenkoordinatensystem (u, v), Bildkoordinatensystem (x, y), Kamerakoordinatensystem () und Weltkoordinatensystem (). Es gibt eine Beziehung zwischen jedem Koordinatensystem,

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt