In den letzten Jahren erlebte die künstliche Intelligenz eine explosionsartige Entwicklung und in letzter Zeit einen allmählichen Rückgang ihrer Popularität. Es scheint, dass künstliche Intelligenz zu einem Spiel geworden ist, das nur von großen Unternehmen gespielt wird.

Der Grund ist, dass die „Schwelle“ für künstliche Intelligenz immer höher wird.

Vor nicht allzu langer Zeit veröffentlichte Jeff Dean, die repräsentative Figur von Google AI, ein neues Werk, das jedoch für ziemliches Aufsehen in der Branche sorgte. Der Grund liegt nicht darin, dass die Arbeit selbst großartig ist. Diese Studie verbesserte sich im Vergleich zu den neuesten Ergebnissen nur um 0,03 %, kostete aber mehr als 57.000 US-Dollar an TPU-Rechenleistung, was eine große Sache ist.

Viele Leute sagen, dass die aktuelle KI-Forschung zu einer Darstellung von Rechenleistung und Ressourcen geworden ist und normale Wissenschaftler nicht mehr studieren können.

Es gibt immer noch viele Menschen, die solche Zweifel haben: Welche Veränderungen hat die künstliche Intelligenz für uns gebracht? Was kann es außer Go noch tun und wie sieht seine Zukunft aus?

Über diese Fragen hatten wir ein ausführliches Gespräch mit Dr. Feng Ji. Er ist Geschäftsführer des Nanjing AI Research Institute von Sinovation Ventures und Gründer von Bei Yang Quantitative. Er verfügt über langjährige Forschungserfahrung im Bereich KI. Durch dieses Gespräch haben wir ein neues Verständnis für die zukünftige Entwicklung und Implementierung von KI gewonnen.

Google hat in letzter Zeit tatsächlich viel Aufmerksamkeit zu diesem Thema erhalten,

Erstens haben große Unternehmen allmählich begonnen, sich einer „gewalttätigen Ästhetik“ zuzuwenden, das heißt, Verwenden von „Super-Large-Scale-Data“ + „Super-Large-Scale-Rechenleistung“ und Erkundung der Obergrenze tiefer neuronaler Netze gewaltsam. Doch wo liegen die Grenzen und Limits dieses Ansatzes?

Zweitens: Ist diese Methode aus akademischer und wissenschaftlicher Forschungsperspektive der einzige Ausweg für KI? Tatsächlich wird bereits viel geforscht, um andere technische Wege zu untersuchen, beispielsweise wie man von perzeptueller Intelligenz zu kognitiver Intelligenz übergeht, wie man eine relativ kleine Datenmenge nutzt, um Probleme zu lösen, auf die künstliche Intelligenz stößt, usw.

Drittens ist eine so große Rechenleistung für praktische Anwendungen in der Industrie wirklich nötig? In der Branche gibt es eine große Anzahl von Aufgaben, die sich auf Nicht-Sprache, Bild und Text beziehen, was auch die akademische Gemeinschaft dazu zwingt, einige effizientere Algorithmen zu entwickeln.

Vor den 1990er Jahren basierte die repräsentative Technologie der „künstlichen Intelligenz“ noch auf „Symbolik“, also auf logischen Überlegungen basierenden Technologien wie Planung und Suche.

Nach 2010 läutete eine wichtige Veränderung in der künstlichen Intelligenz ein, die darin bestand, neuronale Netzwerktechnologie zu nutzen, um diese Wahrnehmungsaufgaben besser darzustellen. Es gibt jedoch immer noch eine große Anzahl von „heiligen Gral“-Problemen der künstlichen Intelligenz, die nicht gelöst wurden, z. B. wie man logisches Denken anwendet, wie man gesunden Menschenverstand anwendet, wie man das Gedächtnis besser modelliert usw.

Um diese Probleme zu lösen, reicht es aus, tiefe neuronale Netze zu verwenden? Dies könnte die nächste wichtige Richtung sein, über die sich Wissenschaft und Industrie mehr Sorgen machen.

Die sogenannte „wahrnehmungsbezogene künstliche Intelligenz“ ist tatsächlich ein repräsentatives Beispiel für die erfolgreiche Implementierung künstlicher Intelligenz in den letzten Jahren, wie z. B. Bilderkennung, Spracherkennung und einige Aufgaben zur Textgenerierung.

Aber was noch wichtiger ist: Wie kann man von dieser Art von Wahrnehmungsaufgaben zu Aufgaben mit kognitiven Fähigkeiten übergehen, insbesondere wie kann man künstliche Intelligenz nutzen, um logisches Denken und gesunden Menschenverstand zu erreichen, um die allgemeine künstliche Intelligenz wirklich zu verwirklichen?

Als Reaktion auf dieses Problem gibt es meines Wissens drei hauptsächliche technische Wege in der Wissenschaft.

Befolgen Sie zunächst weiterhin den Weg der neuronalen Netze und versuchen Sie, das Problem durch ständige Anhäufung von Daten und Rechenleistung zu lösen.

Zweitens versuchen Sie, die Technologie der Symbolik einzuführen, die eine Kombination aus Konnektionismus + Symbolik ist.

Drittens: Verbessern Sie weiterhin die traditionellen Techniken des logischen Denkens, und dieser Weg ist auch der schwierigste.

Daten sind für die Entwicklung künstlicher Intelligenz immer wichtiger geworden. Die Branche hat ein neues Konzept namens „datenzentriertes“ Entwicklungsmodell vorgeschlagen. Im Gegensatz dazu hieß es früher „modellzentriert“.

Traditionell verbringen Ingenieure mehr Zeit damit, ein Modell zu erstellen und die Leistung des Systems durch Anpassen von Parametern zu verbessern. Heutzutage liegt die Aufmerksamkeit aller jedoch darauf, den Datensatz zu verbessern, den Trainingssatz zu verbessern, den Trainingssatz ausgewogener zu gestalten und das Modell dann auf einem guten Datensatz trainieren zu lassen bessere Ergebnisse.

Da unsere Nachfrage nach Datenschutz allmählich wächst, nehmen auch einige negative Auswirkungen und nichttechnische Anforderungen zu, die Daten mit sich bringen. Wenn beispielsweise mehrere Institutionen eine gemeinsame Modellierung durchführen, können die Daten aus Datenschutzgründen nicht zwischen den Institutionen ausgetauscht werden. Technologien wie föderiertes Lernen sind also darauf ausgelegt, eine gemeinsame Modellierung zu erreichen und gleichzeitig den Datenschutz zu schützen.

Mittlerweile hat jeder nach und nach erkannt, dass der Unterschied zwischen den einzelnen Organisationen in der spezifischen industriellen Entwicklung in ihren Daten liegt. Da es nun sehr praktische Open-Source-Software-Frameworks und sehr effiziente Hardware-Implementierungen gibt, haben sich Ingenieure auf Daten konzentriert – Dies ist ein Paradigmenwechsel, das heißt ein Paradigmenwechsel.

Bei Yang Quantitative, das ich selbst gegründet habe, ist ein Hedgefonds mit KI-Technologie als Kern. Innerhalb des Unternehmens beträgt die Datenmenge, die täglich gespeichert werden muss, etwa 25–30 TB. Wir stoßen also auf das Problem der „Speicherwand“.

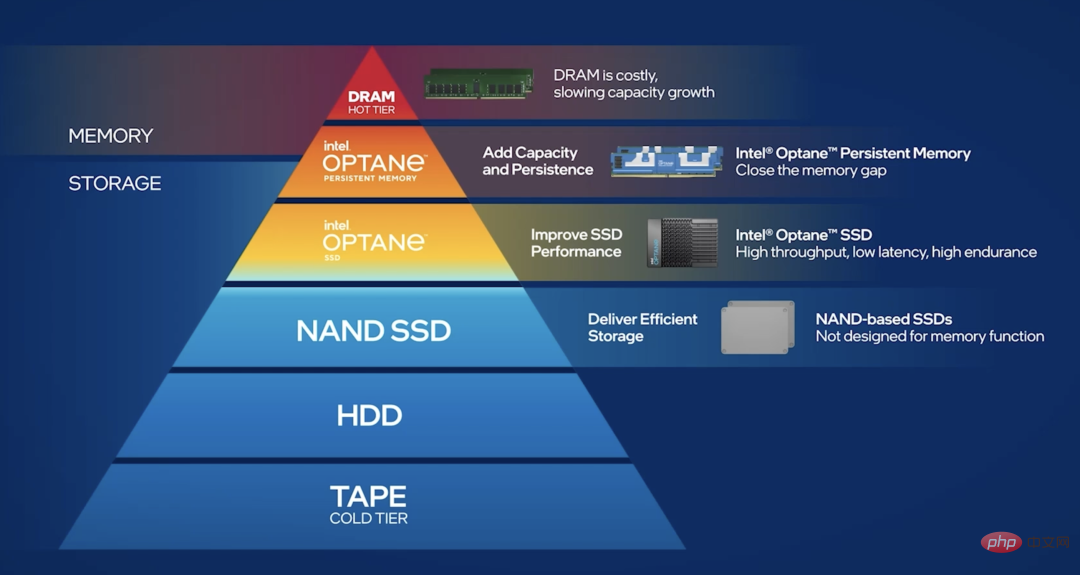

Um dem Druck standzuhalten, der durch massive Datenmengen auf den Speicher entsteht, haben wir die Daten in kalte Daten, warme Daten und heiße Daten unterteilt. „Kalte Daten“ bedeutet, dass die Häufigkeit des Datenzugriffs nicht sehr hoch ist und sie in die Datenbank fallen können. „Hot Data“ bedeutet, dass wir viele Lese- und Schreibaufgaben erledigen müssen, die Daten im Allgemeinen verstreut sind und der Lese- und Schreibaufwand jedes Mal sehr groß ist. Wie kann man also heiße Daten verteilt speichern?

Im Vergleich zu reinen SSD-Lösungen gibt es jetzt bessere Lösungen, wie z. B. Optane Persistent Memory: Es liegt zwischen Speicher und SSD und kann Hot-Daten verteilt speichern, wodurch die „Speicherwand“ minimiert werden kann " Problem.

Mittlerweile gibt es ein sehr beliebtes Konzept namens „Cloud Native“, das den Umbau der Cloud-Computing-Infrastruktur vorantreibt. Und „AI-native“ für künstliche Intelligenz ist tatsächlich passiert. Insbesondere in den letzten 10 Jahren haben sich Computerhardware-Innovationen tatsächlich rund um Anwendungen der künstlichen Intelligenz entwickelt.

Zum Beispiel haben wir aktuell immer mehr Anforderungen an Trusted Computing in der Cloud. Beispielsweise ist der Berechnungsprozess eines KI-Modells das zentrale geistige Eigentum eines Unternehmens. Wenn es in der Cloud oder auf einer öffentlichen Plattform platziert wird, besteht natürlich die Gefahr, dass der Berechnungsprozess gestohlen wird.

Gibt es in diesem Fall eine hardwarebasierte Lösung? Die Antwort lautet: Ja. Wir verwenden beispielsweise die SGX-Datenschutzsandbox auf Intel-Chips, die unsere Berechnungen in der Hardware schützen kann. Dies ist tatsächlich eine sehr wichtige Grundlage für die organisationsübergreifende Zusammenarbeit.

Dies ist ein sehr typisches Beispiel, bei dem es darum geht, Chip- oder Hardwarehersteller dazu zu drängen, entsprechend der Nachfrage entsprechende Lösungen bereitzustellen.

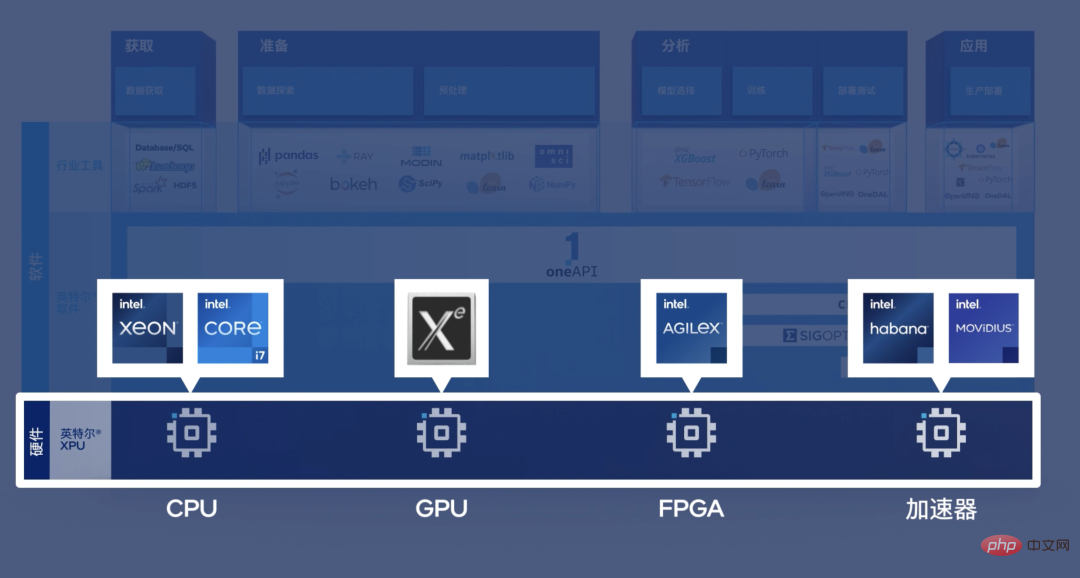

Diese Sichtweise ist tatsächlich eher einseitig. Nehmen Sie als Beispiel die tägliche Arbeit von BeiYang Quantitative. Wenn wir beim quantitativen Handel die Daten von der CPU auf die GPU kopieren und dann zurückkopieren, ist es für viele quantitative Handelsaufgaben zu spät. Mit anderen Worten: Wir benötigen eine sehr leistungsstarke CPU-Version der Modellimplementierung der künstlichen Intelligenz.

Ein anderes Beispiel: Wir haben viele Aufgaben, die eine Datenanalyse und -verarbeitung direkt auf der Netzwerkkarte erfordern, und die Netzwerkkarte verfügt normalerweise über einen FPGA-Chip, und es ist sogar zu spät, die von ihr verarbeiteten Daten an die GPU zu übertragen. Für ein solches Szenario mit geringer Latenz, das die Hilfe künstlicher Intelligenz erfordert, benötigen wir eine heterogene Architektur.

Mit anderen Worten, egal ob FPGA, ASIC, CPU oder GPU, sie haben unterschiedliche Verwendungszwecke in verschiedenen Szenarien.

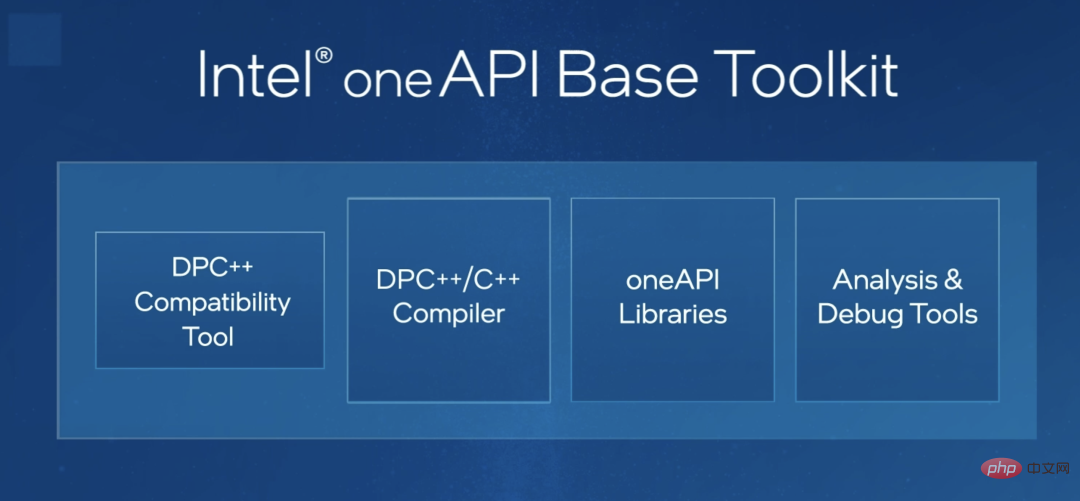

Bezüglich der Programmierung für heterogene Plattformen sehe ich, dass die Branche bereits einige Versuche unternommen hat. Ich halte zum Beispiel Intels oneAPI für ein sehr wichtiges Tool. Mit anderen Worten: OneAPI ermöglicht die automatische Anpassung desselben Codesatzes an CPU, FPGA oder andere Chiptypen. Dies wird die Programmierschwierigkeiten für Ingenieure erheblich reduzieren und es ihnen ermöglichen, sich auf die Algorithmeninnovation zu konzentrieren.

Ich finde das sehr wichtig, um heterogene Anwendungen zu fördern.

Ich denke, dass möglicherweise eine bessere End-to-End-Lösung erforderlich ist. Jetzt haben wir tatsächlich ein Upgrade von „Software 1.0“ auf die Ära „Software 2.0“ durchgeführt. Mit anderen Worten: Von der Konstruktion komplexer Softwareentwicklung, die auf traditionellen Regeln basiert, zur Konstruktionsmethode der datengesteuerten Softwareentwicklung.

Zuvor mussten wir uns auf unseren großen Einfallsreichtum verlassen, um eine Reihe exquisiter Systeme zu schreiben, um das gesamte Programm zum Laufen zu bringen. Dies ähnelt einer mechanischen Uhr. Die besten Programmierer konzentrieren sich auf die Funktionsweise der „Zahnräder“ und darauf, wie man diese „Uhr“ zum Laufen bringt.

Wenn ich nicht weiß, wie ich diesen Satz von Betriebsregeln ermitteln soll, dann gebe ich ihn einfach einer großen Datenmenge oder einem Algorithmus für maschinelles Lernen. Dieser Algorithmus generiert einen neuen Algorithmus, und dieser neue Algorithmus ist Dinge, die wir bekommen wollen. Dieser Ansatz ähnelt ein wenig dem Bau eines Roboters, der Roboter baut.

Im Zeitalter der Software 2.0 wird sich das Entwicklungsparadigma des gesamten Software-Engineerings stark ändern. Der Kern besteht darin, wie man „datenzentriert“ einfacher implementieren kann "Software. Technische Entwicklung.

Ich denke, es gibt wahrscheinlich zwei Aspekte. Erstens müssen wir aus industrieller Sicht immer noch von Grundprinzipien ausgehen, d. h. auf der Grundlage unserer eigenen Bedürfnisse und unter Berücksichtigung vieler nichttechnischer Faktoren. Ich habe zum Beispiel ein Unternehmen gesehen, das ein Gesichtserkennungssystem für die Sicherheit der Gemeinschaft entwickeln wollte, aber für jeden Ein- und Ausgang waren vier sehr teure GPUs erforderlich. Dies ist ein typisches Beispiel dafür, dass man nicht von den Anforderungen und Kosten ausgeht.

Zweitens folgt die akademische Forschung nicht unbedingt dem Trend. Wie wir eingangs sagten, besteht kein Grund, hinsichtlich der Größe der Modelle miteinander zu konkurrieren: Wenn Sie eines mit Hunderten von Milliarden haben, werde ich eines mit Billionen bauen, und wenn Sie eines mit Billionen haben, werde ich bauen eins. Zehn Billionen.

Tatsächlich gibt es eine große Anzahl von Aufgaben, die Parameter im kleinen Maßstab erfordern, oder aufgrund von Kosten und anderen Einschränkungen kann nur eine kleine Anzahl von Proben bereitgestellt werden. Wie kann man unter solchen Bedingungen innovativ sein und Durchbrüche erzielen? Dies ist eine Verantwortung, die die akademische Gemeinschaft initiativ übernehmen sollte.

Lassen Sie uns darüber nachdenken. In den späten 1990er Jahren kostete die Erstellung einer Website 20.000 bis 30.000 Yuan, da es zu dieser Zeit nur sehr wenige Menschen mit Netzwerkprogrammierkenntnissen gab. Aber heute kann wahrscheinlich jeder Gymnasiast mit nur einem Mausklick eine Website erstellen.

Mit anderen Worten: Netzwerkkenntnisse gehören bereits zum Werkzeugkasten eines jeden gewöhnlichen Programmierers.

Tatsächlich ist die Technologie der künstlichen Intelligenz dasselbe. Um 2015 gab es wahrscheinlich nicht mehr als 1.000 Menschen auf der Welt, die ein Deep-Learning-Framework erstellen und auf einer GPU ausführen konnten. Aber jetzt, da es ein exponentielles Wachstum erlebt hat, wissen viele Menschen, wie es geht. Wir haben Grund zu der Annahme, dass jeder Programmierer in etwa fünf Jahren über umfassendere Lösungen für künstliche Intelligenz in seinem Toolkit verfügen wird und die Schwelle für deren Implementierung definitiv kontinuierlich gesenkt wird. Nur so kann die Technologie der künstlichen Intelligenz in jedem Unternehmen breiter eingesetzt werden.

KI-Labore in großen Fabriken werden also unweigerlich verschwinden. Genau wie um das Jahr 2000 verfügen viele Unternehmen über ein Internet Lab, ein Labor, das sich allen Netzwerkangelegenheiten des Unternehmens widmet und technische Ergebnisse für andere Geschäftsabteilungen bereitstellt. Dies liegt daran, dass es nur sehr wenige Menschen gibt, die sich mit dieser Technologie auskennen, also müssen sie dies tun.

Das Gleiche gilt für AI Lab. Wenn die Schwelle für die Implementierung von KI-Technologie schrittweise gesenkt wird und eine große Anzahl von Personen in Unternehmensabteilungen ebenfalls über ähnliche Technologien verfügt, wird diese Art von AI Lab unweigerlich verschwinden. Ich denke, dass es sich um ein vorübergehendes Produkt im Prozess der technologischen Entwicklung handelt, was eine gute Sache ist. Wenn große Hersteller keine KI-Labore haben, wird es wahrscheinlich die Ära sein, in der künstliche Intelligenz wirklich aufblüht.

Zuerst brauchen wir auch den Segen des Mooreschen Gesetzes. Es gibt immer noch eine große Anzahl von Aufgaben, die viel Rechenleistung erfordern. Wir müssen die Hardware weiter iterieren und den Algorithmus aktualisieren. Nur wenn Dinge, die in einem Cluster ausgeführt werden müssen, auf einem Mobiltelefon ausgeführt werden können, kann KI in großer Zahl implementiert werden.

Zweitens muss sich der Schwerpunkt der Innovation im Bereich der künstlichen Intelligenz vom Internetgeschäft auf einige traditionelle Branchen verlagern. Bisher konzentrierten sich alle darauf, wie man künstliche Intelligenz nutzen kann, um bessere visuelle Lösungen, bessere Empfehlungssysteme oder bessere P-Bild-Software zu schaffen. Doch in der Realwirtschaft gibt es tatsächlich eine Vielzahl von Abteilungen und Unternehmen, die Daten generieren. Wenn diese realen Wirtschaftsdaten besser informiert werden können, kann der Wert, den sie bringen, den der aktuellen virtuellen Wirtschaft bei weitem übertreffen.

Das obige ist der detaillierte Inhalt vonZehn Fragen zur künstlichen Intelligenz: Da KI immer komplexer wird, wo liegt die Zukunft?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!