Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Wie führt man eine Bildsuche effizient und genau durch? Schauen Sie sich das vorab trainierte Lightweight-Vision-Modell an

Wie führt man eine Bildsuche effizient und genau durch? Schauen Sie sich das vorab trainierte Lightweight-Vision-Modell an

Wie führt man eine Bildsuche effizient und genau durch? Schauen Sie sich das vorab trainierte Lightweight-Vision-Modell an

Hatten Sie jemals Probleme beim Abrufen von Bildern?

Entweder ist es schwierig, das gewünschte Bild in der riesigen Menge an Bildern genau zu finden, oder es kann zu unbefriedigenden Ergebnissen bei der textbasierten Suche kommen. In Bezug auf dieses Problem führten Forscher von Microsoft Research Asia und der Microsoft Cloud Computing and Artificial Intelligence Division eingehende Untersuchungen zu leichten visuellen Modellen durch und schlugen eine Reihe von Entwurfs- und Komprimierungsmethoden für visuelle Vortrainingsmodelle vor, um die Anforderungen an die visuelle Lightweight-Bereitstellung zu realisieren .

Aktuell wurden diese Methode und dieses Modell erfolgreich auf die Bing-Suchmaschine von Microsoft angewendet, wodurch eine genaue und schnelle Schlussfolgerung und der Abruf von zig Milliarden Bildern erreicht wurde. In diesem Artikel werden die Entwicklung, Schlüsseltechnologien, Anwendungen und Potenziale von leichten visuellen Vortrainingsmodellen sowie zukünftige Chancen und Herausforderungen ausführlich erläutert. Ich hoffe, dass jeder den Bereich des leichten visuellen Vortrainings besser verstehen kann gemeinsam die Entwicklung verwandter Technologien vorantreiben.

In letzter Zeit haben Transformer-basierte visuelle Pre-Training-Modelle bei vielen Computer-Vision-Aufgaben eine überlegene Leistung erzielt und große Aufmerksamkeit erhalten. Visuelle Transformer-Vortrainingsmodelle weisen jedoch normalerweise große Parameter und eine hohe Komplexität auf, was ihre Bereitstellung und Verwendung in praktischen Anwendungen einschränkt, insbesondere in Geräten mit eingeschränkten Ressourcen oder in Szenarien mit hohen Echtzeitanforderungen. Daher ist die Forschung zur „Leichtgewichtung“ großer visueller Pre-Training-Modelle zu einem neuen heißen Thema in Wissenschaft und Industrie geworden.

In diesem Zusammenhang führten Forscher von Microsoft Research Asia und der Microsoft Cloud Computing and Artificial Intelligence Division eine eingehende Untersuchung des strukturellen Designs und der Trainingsinferenz großer visueller Modelle durch und konzentrierten sich dabei auch auf die Leichtbau- und Echtzeitleistung von Große Modelle und die Cloud-Bereitstellung haben auch innovative Anwendungen hervorgebracht. Dieser Artikel beginnt mit der Entwicklung leichter visueller Pre-Training-Modelle, untersucht die Schlüsseltechnologien in der Modell-Leichtbauforschung sowie die Anwendung und das Potenzial leichter visueller Transformer-Modelle in tatsächlichen Produkten und blickt schließlich auf die zukünftigen Entwicklungsmöglichkeiten und -aussichten von leichte visuelle Herausforderung.

Große visuelle Modelle tauchen nacheinander auf, aber leichten Modellen vor dem Training mangelt es an Aufmerksamkeit

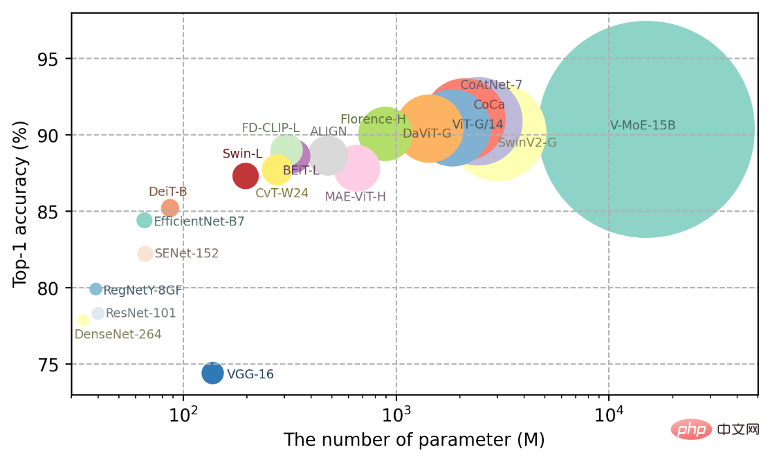

In den letzten Jahren hat der Fortschritt des Deep Learning bei ImageNet-Bildklassifizierungsaufgaben hauptsächlich von der erheblichen Erweiterung der Kapazität profitiert von visuellen Modellen. Wie in Abbildung 1 dargestellt, hat sich die Kapazität visueller Pre-Training-Modelle in nur wenigen Jahren um mehr als das 300-fache erweitert, vom ResNet-101-Modell mit 44,5 Millionen Parametern bis zum V-MoE-Modell mit 15 Milliarden Parametern Große visuelle Vortrainingsmodelle Trainingsmodelle haben große Fortschritte bei Aufgaben wie dem Bildverständnis und der Generierung visueller Inhalte gemacht.

Abbildung 1: Änderungstrenddiagramm der Parameter des visuellen Pre-Training-Modells

Ob es sich um das 3-Milliarden-Parameter-Swin-V2-Modell von Microsoft oder das von Google veröffentlichte 1,8-Milliarden-Parameter-ViT-G/14-Modell handelt, Große visuelle Modelle haben bei vielen Aufgaben eine überlegene Leistung gezeigt, insbesondere ihre leistungsstarken Small-Shot- (Few-Shot-) und sogar Zero-Shot-Generalisierungsfähigkeiten (Zero-Shot), die für das Erreichen allgemeiner Intelligenz von entscheidender Bedeutung sind.

In vielen praktischen Szenarien ist es jedoch aufgrund begrenzter Speicher- und Rechenressourcen schwierig, große Modelle direkt bereitzustellen oder die Echtzeitanforderungen nicht zu erfüllen. Daher ist die Forschung an leichten visuellen Pre-Training-Modellen immer wichtiger geworden und hat einen hohen praktischen Anwendungswert. Obwohl es derzeit einige Arbeiten zur Erforschung leichtgewichtiger Modelle gibt, sind die meisten dieser Methoden für bestimmte Aufgaben und spezifische Strukturen konzipiert. Die Vielseitigkeit des Modells wird während des Entwurfs- und Trainingsprozesses nicht berücksichtigt, und es gibt Einschränkungen bei der Verallgemeinerung.

Forschung zu Schlüsseltechnologien für leichte visuelle Modelle

Um leichte visuelle Pre-Training-Modelle zu realisieren, entdeckten Microsoft-Forscher zwei Schlüsselprobleme: 1) Wie kann eine vielseitigere, leichte Modellstruktur entworfen werden? 2) Wie kann man angesichts der begrenzten Kapazität leichter visueller Pre-Training-Modelle effiziente Pre-Training-Methoden entwerfen, damit kleine Modelle effektive Informationen aus großen Datenmengen lernen können? Angesichts dieser Probleme haben Forscher durch unermüdliche Forschung und Erkundung erste Ergebnisse erzielt.

Denn der Kern der Verbesserung der Vielseitigkeit leichter vorab trainierter Modelle liegt darin, die Lernfähigkeit des Modells unter der Bedingung begrenzter Ressourcen (Parametermenge, Verzögerung usw.) zu stärken, damit es besser lernen kann In großen Datenmengen führten die Forscher daher eine eingehende Untersuchung aus den folgenden drei Perspektiven durch:

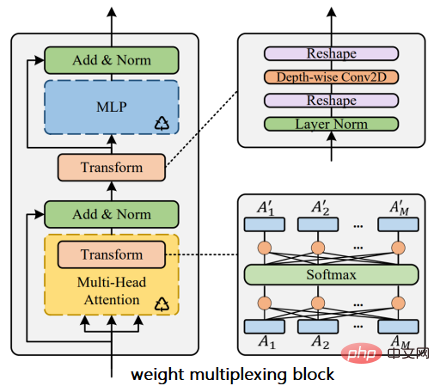

1. Leichtes Moduldesign

Leichte Module mit geringer Latenz sind ein wichtiger Bestandteil von Leichtbaumodellen. In Faltungs-Neuronalen Netzen gehören zu den repräsentativen leichten Modulen der Inverted Residual Block von MobileNet und die Kanal-Zufalls-Crossover-Einheit (Shuffle Unit) von ShuffleNet. Da in der visuellen Transformer-Struktur die Aufmerksamkeitsberechnung zwischen Bildblöcken die Informationen zur relativen Positionskodierung nicht gut berücksichtigt, haben die Forscher eine leichtgewichtige Plug-and-Play-Methode für die relative Positionskodierung von zweidimensionalen Bildern iRPE entwickelt [1]. die Leistung des Modells ohne Änderung von Trainingshyperparametern. Um das Problem der Redundanz der visuellen Transformer-Parameter anzugehen, haben Forscher außerdem das Weight Multiplexing-Modul entwickelt [2]. Wie in Abbildung 2 dargestellt, reduziert diese Methode die Redundanz von Modellparametern durch mehrschichtige Wiederverwendung von Gewichten und führt nicht gemeinsam genutzte lineare Transformationen ein, um die Parametervielfalt zu erhöhen. Abbildung 2: Gewichtsmultiplexmodul in Transformer Leistung [3]. Zu den repräsentativen Werken im Bereich Faltungs-Neuronale Netze gehören NASNet und EfficientNet. Bei der Suche nach visuellen Transformer-Strukturen haben Forscher nacheinander AutoFormer [4] und S3 [5] für mehrere Dimensionen wie Kanalbreite, Netzwerktiefe und Anzahl der Köpfe im visuellen Modell vorgeschlagen und so ein dynamisches skalierbares Training und die Skalierbarkeit des visuellen Modells realisiert . Struktursuche. Bei gleicher Modellgenauigkeit weist das durch die Suche erhaltene neue Modell eine geringere Anzahl von Parametern und Berechnungen auf. Es ist erwähnenswert, dass die Forscher in S3 den E-T-Fehler [5] und das Weight-Sharing-Supernet verwendet haben, um den Suchraum zu steuern und zu verbessern. Während sie eine effizientere Modellstruktur erhielten, analysierten sie auch den Entwicklungsprozess des Suchraums, wie in Abbildung dargestellt 3 dargestellt. Gleichzeitig bietet der Prozess der Modellstruktursuche effektive Designerfahrung und Referenz für den Entwurf von Leichtbaumodellen. Abbildung 3: Entwicklungsprozess des Suchraums für leichte Modelle Es ist schwierig, die reichhaltigen Informationen und das Wissen, die in großen Datenmengen enthalten sind, direkt zu erlernen. Um dieses Problem zu lösen, haben Forscher ein schnelles Destillationsschema vor dem Training vorgeschlagen, um das Wissen großer Modelle auf leichte kleine Modelle zu übertragen [6]. Wie in Abbildung 4 dargestellt, ist die schnelle Destillation vor dem Training im Gegensatz zur herkömmlichen einstufigen Wissensdestillation in zwei Phasen unterteilt: 1) Komprimieren und Speichern der im Trainingsprozess des großen Modells verwendeten Datenerweiterungsinformationen und Vorhersageinformationen; Nachdem die Vorhersageinformationen und Daten des großen Modells erweitert wurden, wird das große Modell als Lehrer verwendet, um das Lernen und Trainieren leichter Schülermodelle durch Destillation vor dem Training zu leiten. Anders als beim Beschneiden und Quantisieren verwendet diese Methode die oben erwähnte Wiederverwendung von Gewichten [2], die auf der Gewichtsteilung basiert. Durch die Einführung einer leichten Gewichtstransformation und -destillation wird das große visuelle Modell vor dem Training erfolgreich komprimiert und ein universelleres, robusteres, leichtes Modell erhalten. Mit dieser Methode kann das ursprüngliche große Modell Dutzende Male komprimiert werden, ohne dass die Leistung darunter leidet.

Abbildung 4: Schnelle Wissensdestillation vor dem Training

Diese Reihe von Forschungsergebnissen hat nicht nur viele Artikel auf führenden akademischen Konferenzen zum Thema Computer Vision veröffentlicht (CVPR, ICCV, ECCV, NeurIPS usw.) [1-6], ebenfalls durch Zusammenarbeit mit Microsoft Bing, hat leichtgewichtige Pre-Training-Modelle erfolgreich auf Bildsuchprodukte angewendet und so die Fähigkeit verbessert, Bild- und Videoinhalte im tatsächlichen Geschäft zu verstehen.

Anwendung eines leichten visuellen Pre-Training-Modells

Leichte visuelle Pre-Training-Modelle haben viele praktische Anwendungen, insbesondere in Szenarien mit hohen Echtzeitanforderungen oder Ressourcenbeschränkungen, wie zum Beispiel: Echtzeit-Rendering und -Verbesserung von Cloud-Videos, End-to-End-Bildtests und Verständnis von Videoinhalten . Leichte visuelle Modelle haben breite Anwendungsaussichten im intelligenten Einzelhandel, in der fortschrittlichen Fertigung und in anderen Bereichen gezeigt und werden in Zukunft eine wichtige Rolle in aufstrebenden Branchen wie Metaverse und autonomem Fahren spielen. Am Beispiel der Bildinhaltssuche im Bing-Produkt von Microsoft wird Ihnen im Folgenden die praktische Anwendung und Bereitstellung leichter visueller Modelle gezeigt.

Gegenwärtig ist die inhaltsbasierte Bildsuche relativ ausgereift, um die Kategorieattribute von Bildern zu verstehen, aber es gibt immer noch große Herausforderungen, den Inhalt komplexer Szenen zu verstehen. Bilder komplexer Szenen weisen in der Regel Merkmale wie große Schärfentiefe, unübersichtliche Hintergründe, viele Charaktere und komplexe Objektbeziehungen auf, die das Verständnis des Inhalts erheblich erschweren und somit höhere Anforderungen an die Robustheit und Generalisierung vorab trainierter Modelle stellen.

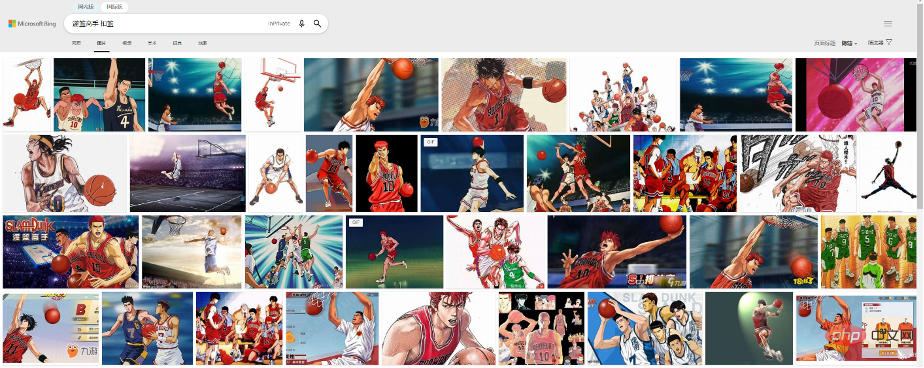

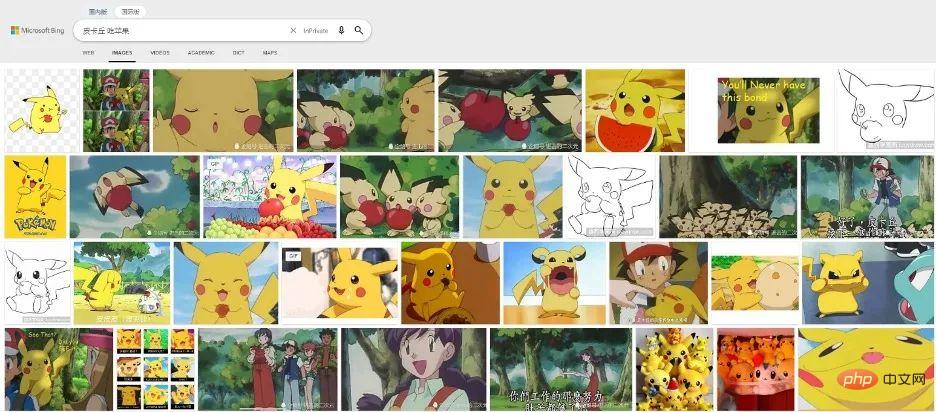

Zum Beispiel kann die Suchqualität von Anime-Bildern lange Zeit nicht effektiv verbessert werden. Zu den größten Herausforderungen gehören: Mallinien und Farben sind übertriebener als echte Szenenbilder, enthalten mehr Aktionen und Szenen, verschiedene Comics großer Unterschied in Stil und Inhalt. Die Abbildungen 5 bis 7 zeigen jeweils drei verschiedene Zeichentrickfiguren und Verhaltensweisen von „Slam Dunk“, „Pikachu“ und „Captain“. Ihre Comic-Stile und Inhalte sind sehr unterschiedlich. Das effektive Verständnis des Inhalts von Comic-Bildern stellt höhere Anforderungen an visuelle Vorschulungsmodelle.

Abbildung 5: In der Microsoft Bing-Suchmaschine umfasst das Verständnis der Aktionen des Slam Dunk Masters: Eintauchen, Dribbeln, Stehlen, Schießen usw.

Abbildung 6: In Microsoft Bing In der Suchmaschine, das Verständnis von Pikachus Verhalten ist wie Äpfel essen, Wassermelone essen, Eis essen usw.

Abbildung 7: In der Microsoft Bing-Suchmaschine eine Nahaufnahme der Schießaktion des Fußballspielers

oben Das oben erwähnte leichte visuelle allgemeine Modell und der schnelle Destillationsalgorithmus vor dem Training wurden erfolgreich in der Bing-Suchmaschine von Microsoft eingesetzt. Mit Hilfe des von Microsoft Research Asia bereitgestellten multimodalen Pre-Training-Modells für visuelle Sprache verbessert die Bing-Bildsuchfunktion von Microsoft das Verständnis von Comic-Inhalten und kann Bildinhalte zurückgeben, die den Benutzeranforderungen besser entsprechen.

Gleichzeitig stellt die riesige Indexbibliothek der Microsoft Bing-Suchmaschine sehr hohe Anforderungen an die Sucheffizienz. Die von Microsoft Research Asia bereitgestellte schnelle Destillationsmethode vor dem Training migriert die Indizierungsfunktionen des vorab trainierten großen Modells effektiv auf ein leichtes Modell, wodurch die Erkennungsgenauigkeit des vorhandenen Modells um 14 % verbessert und die Berechnungseffizienz erheblich optimiert wird , wodurch eine schnelle Argumentation auf zig Milliarden Bildern erreicht wird.

Zukünftige Chancen und Herausforderungen

Modellleichtbau ist der Kern zukünftiger Anwendungen künstlicher Intelligenz. Da sich Bildverarbeitungstechnologie, Algorithmen, Rechenleistung und Daten immer weiter verbessern, hat die Komplexität der Modelle dramatisch zugenommen und der Energieverbrauch von Berechnungen neuronaler Netze ist immer teurer geworden. Die hohe Recheneffizienz und die geringen Bereitstellungs- und Anwendungskosten des leichten visuellen Modells können in Zukunft bei realeren Produkten von großem Vorteil sein. Darüber hinaus können lokalisierte, leichte, vorab trainierte visuelle Modelle Benutzerdaten und Privatsphäre besser schützen und gleichzeitig mehr Dienste unterstützen. Die Daten des Benutzers müssen das Gerät nicht mehr verlassen, sodass Remote-Upgrades von Funktionen wie Modelldiensten möglich sind.

Natürlich sind sich Forscher auch der Herausforderungen bewusst, mit denen leichte, vorab trainierte visuelle Modelle konfrontiert sind: Einerseits im Hinblick auf das Design der Modellstruktur, wie die optimale Lernfähigkeit des Modells unter den Einschränkungen der Modellanzahl erreicht werden kann Parameter und Inferenzverzögerungen waren schon immer Themen, denen Wissenschaft und Industrie große Aufmerksamkeit widmen. Obwohl viele effektive Modellstrukturen angesammelt wurden und in Bereichen wie dem Universal Approximation Theorem (UAT) und der Neural Network Structure Search (NAS) große Fortschritte erzielt wurden, gibt es immer noch Lücken zwischen den vorhandenen leichten, vorab trainierten visuellen Modellen und visuellen Großmodellen zwischen Modellen, die weiter optimiert und verbessert werden müssen. Andererseits haben Wissenschaft und Industrie in Bezug auf Trainingsmethoden verschiedene Trainingsmethoden wie Selbstüberwachung, Bildklassifizierung und Multimodalität für große visuelle Modelle vorgeschlagen, die die allgemeinen Fähigkeiten des Modells erheblich verbessert haben. Wie eine effektivere Trainingsmethode für leichte Modelle mit begrenzter Kapazität entwickelt werden kann, erfordert weitere Forschung und Erkundung. Die Forscher von Microsoft Research Asia werden weiterhin den wissenschaftlichen Forschungsfortschritt von leichten, vorab trainierten visuellen Modellen vorantreiben und weitere Technologiekollegen willkommen heißen, um verwandte Technologien in diesem Bereich zu kommunizieren und zu erforschen.

Das obige ist der detaillierte Inhalt vonWie führt man eine Bildsuche effizient und genau durch? Schauen Sie sich das vorab trainierte Lightweight-Vision-Modell an. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Die Kuaishou-Version von Sora „Ke Ling' steht zum Testen offen: Sie generiert über 120 Sekunden Videos, versteht die Physik besser und kann komplexe Bewegungen genau modellieren

Jun 11, 2024 am 09:51 AM

Was? Wird Zootopia durch heimische KI in die Realität umgesetzt? Zusammen mit dem Video wird ein neues groß angelegtes inländisches Videogenerationsmodell namens „Keling“ vorgestellt. Sora geht einen ähnlichen technischen Weg und kombiniert eine Reihe selbst entwickelter technologischer Innovationen, um Videos zu produzieren, die nicht nur große und vernünftige Bewegungen aufweisen, sondern auch die Eigenschaften der physischen Welt simulieren und über starke konzeptionelle Kombinationsfähigkeiten und Vorstellungskraft verfügen. Den Daten zufolge unterstützt Keling die Erstellung ultralanger Videos von bis zu 2 Minuten mit 30 Bildern pro Sekunde, mit Auflösungen von bis zu 1080p und unterstützt mehrere Seitenverhältnisse. Ein weiterer wichtiger Punkt ist, dass es sich bei Keling nicht um eine vom Labor veröffentlichte Demo oder Video-Ergebnisdemonstration handelt, sondern um eine Anwendung auf Produktebene, die von Kuaishou, einem führenden Anbieter im Bereich Kurzvideos, gestartet wurde. Darüber hinaus liegt das Hauptaugenmerk darauf, pragmatisch zu sein, keine Blankoschecks auszustellen und sofort nach der Veröffentlichung online zu gehen. Das große Modell von Ke Ling wurde bereits in Kuaiying veröffentlicht.

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil