Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Selbst wenn ein großer Bereich des Bildes fehlt, kann es realistisch wiederhergestellt werden. Das neue Modell CM-GAN berücksichtigt die globalen Struktur- und Texturdetails.

Selbst wenn ein großer Bereich des Bildes fehlt, kann es realistisch wiederhergestellt werden. Das neue Modell CM-GAN berücksichtigt die globalen Struktur- und Texturdetails.

Selbst wenn ein großer Bereich des Bildes fehlt, kann es realistisch wiederhergestellt werden. Das neue Modell CM-GAN berücksichtigt die globalen Struktur- und Texturdetails.

Bildwiederherstellung bezieht sich auf die Vervollständigung fehlender Bildbereiche, was eine der Grundaufgaben des Computer Vision ist. Diese Richtung hat viele praktische Anwendungen, wie z. B. Objektentfernung, Bild-Retargeting, Bildsynthese usw.

Frühe Inpainting-Methoden basierten auf Bildblocksynthese oder Farbdiffusion, um fehlende Teile des Bildes auszufüllen. Um komplexere Bildstrukturen zu erreichen, wenden sich Forscher datengesteuerten Ansätzen zu, bei denen sie tiefe generative Netzwerke nutzen, um visuelle Inhalte und Erscheinungsbild vorherzusagen. Es hat sich gezeigt, dass generative Inpainting-Modelle durch Training an großen Bildmengen und unterstützt durch Rekonstruktion und kontroverse Verluste bei verschiedenen Arten von Eingabedaten, einschließlich natürlicher Bilder und menschlicher Gesichter, optisch ansprechendere Ergebnisse liefern.

Bestehende Arbeiten können jedoch nur bei der Vervollständigung einfacher Bildstrukturen gute Ergebnisse zeigen, und die Generierung von Bildinhalten mit komplexer Gesamtstruktur und hochauflösenden Details ist immer noch eine große Herausforderung, insbesondere wenn das Bild Löcher aufweist, wenn es groß ist.

Im Wesentlichen steht das Bild-Inpainting vor zwei Hauptproblemen: Zum einen geht es darum, den globalen Kontext genau auf unvollständige Regionen zu übertragen, und zum anderen darum, echte lokale Details zu synthetisieren, die mit globalen Hinweisen übereinstimmen. Um das Problem der globalen Kontextausbreitung zu lösen, nutzen bestehende Netzwerke Encoder-Decoder-Strukturen, atrous Faltungen, kontextuelle Aufmerksamkeit oder Fourier-Faltungen, um weitreichende Merkmalsabhängigkeiten zu integrieren und das effektive Empfangsfeld zu erweitern. Darüber hinaus basieren der zweistufige Ansatz und das iterative Füllen von Lücken auf der Vorhersage grober Ergebnisse, um die globale Struktur zu verbessern. Diesen Modellen fehlt jedoch ein Mechanismus, um die Semantik unmaskierter Regionen auf hoher Ebene zu erfassen und sie effektiv in Löcher zu übertragen, um eine globale Gesamtstruktur zu synthetisieren.

Auf dieser Grundlage haben Forscher der University of Rochester und Adobe Research ein neues generatives Netzwerk vorgeschlagen: CM-GAN (cascaded modulation GAN), das die Gesamtstruktur und lokale Details besser synthetisieren kann. CM-GAN umfasst einen Encoder mit Fourier-Faltungsblöcken, um mehrskalige Merkmalsdarstellungen aus Eingabebildern mit Löchern zu extrahieren. Es gibt auch einen Zwei-Stream-Decoder in CM-GAN, der auf jeder Skalenebene einen neuartigen kaskadierten globalen räumlichen Modulationsblock festlegt.

In jedem Decoderblock wenden wir zunächst eine globale Modulation an, um eine grobe und semantisch bewusste Struktursynthese durchzuführen, und führen dann eine räumliche Modulation durch, um die Feature-Map auf räumlich adaptive Weise weiter anzupassen. Darüber hinaus wurde in dieser Studie ein Trainingsschema für die Objektwahrnehmung entwickelt, um Artefakte innerhalb des Hohlraums zu verhindern und den Anforderungen von Objektentfernungsaufgaben in realen Szenen gerecht zu werden. Die Studie führte umfangreiche Experimente durch, um zu zeigen, dass CM-GAN bestehende Methoden sowohl bei quantitativen als auch qualitativen Bewertungen deutlich übertrifft.

- Papieradresse: https://arxiv.org/pdf/2203.11947.pdf

- Projektadresse: https://github.com/htzheng/CM-GAN-Inpainting

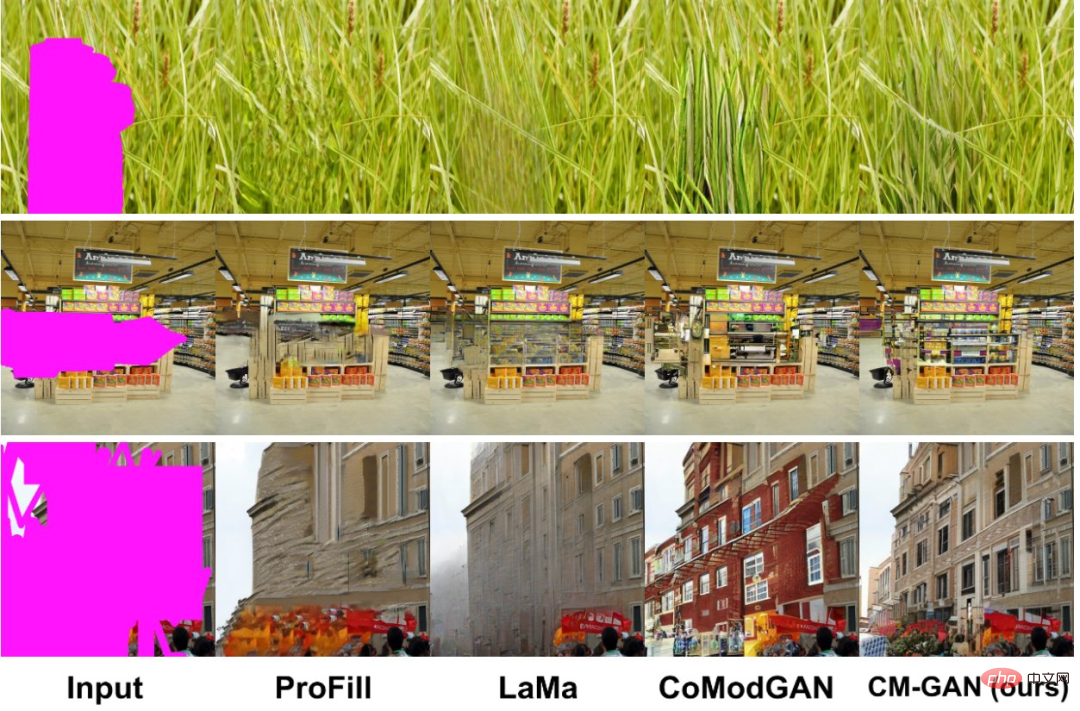

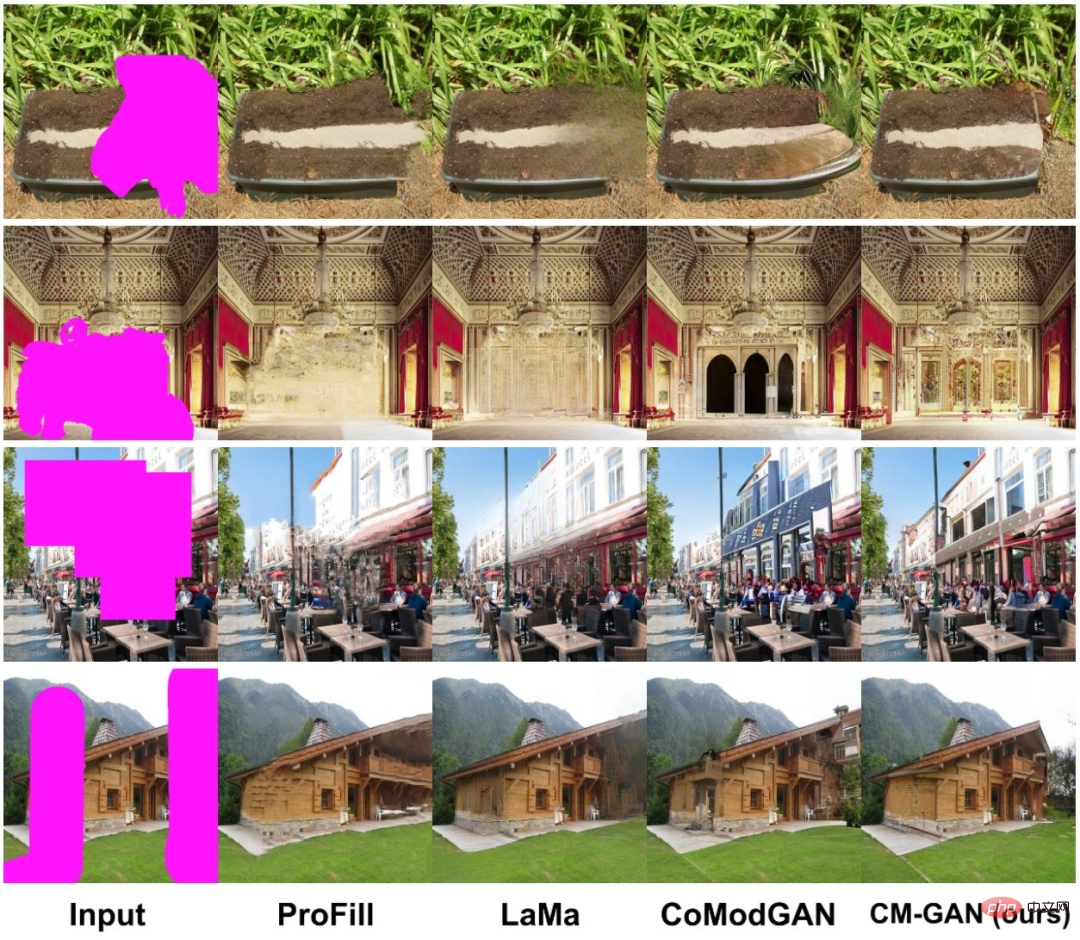

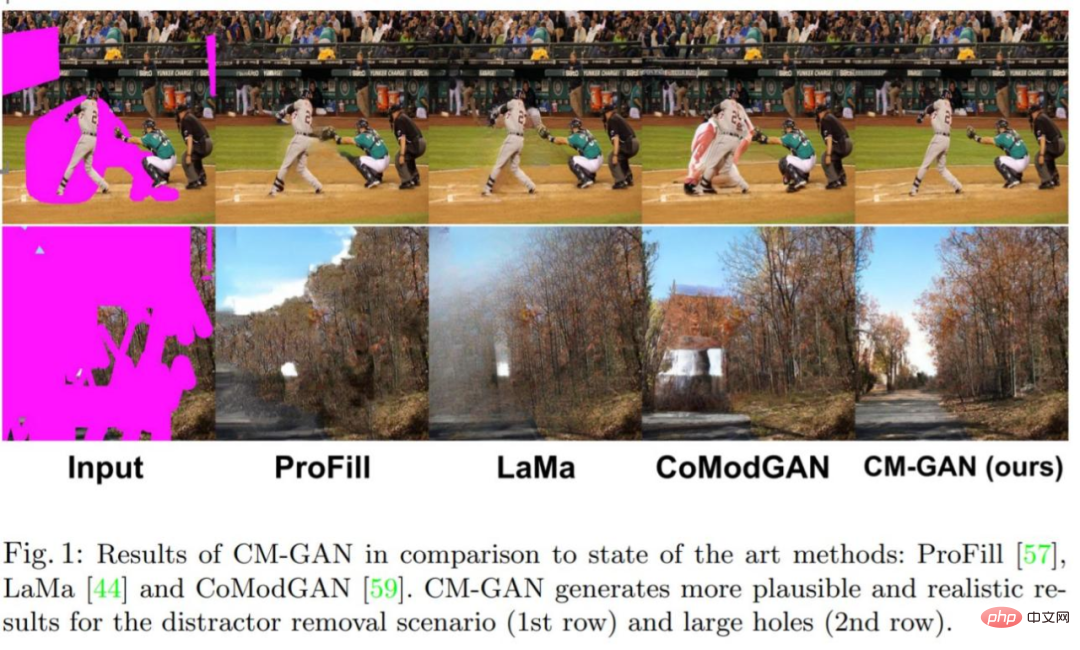

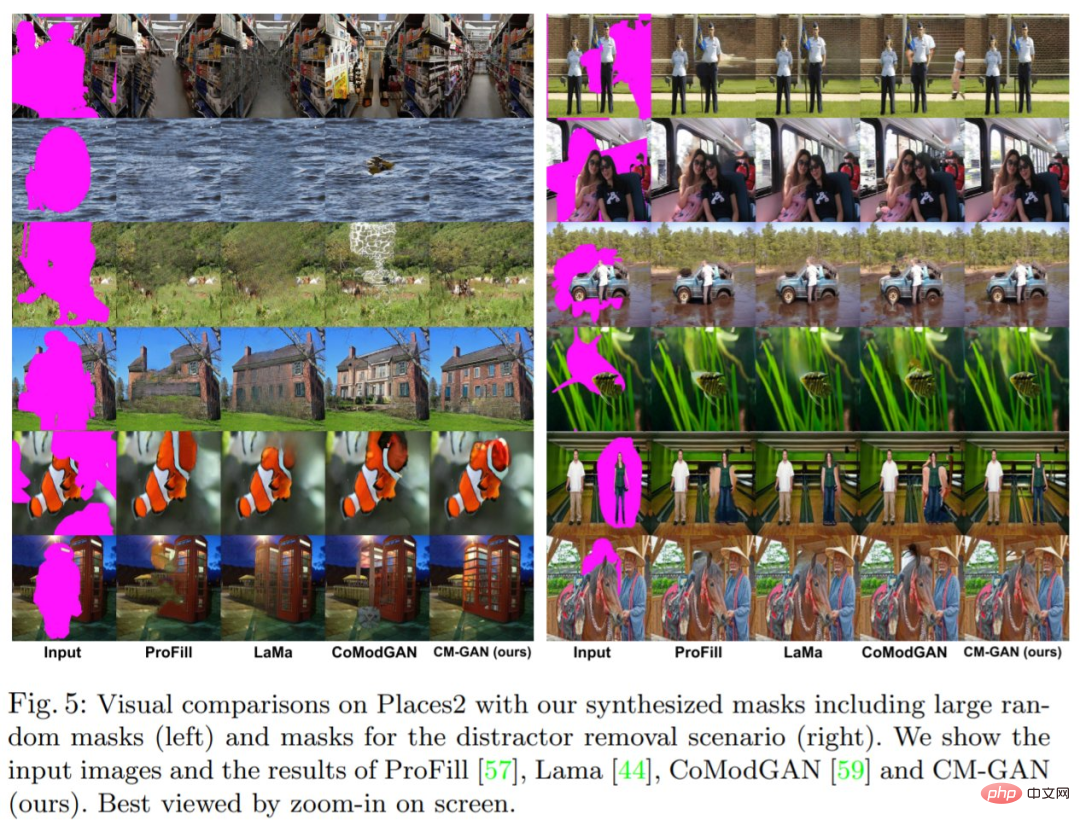

Sehen wir uns zunächst den Bildreparatureffekt an. Im Vergleich zu anderen Methoden kann CM-GAN bessere Texturen rekonstruieren:

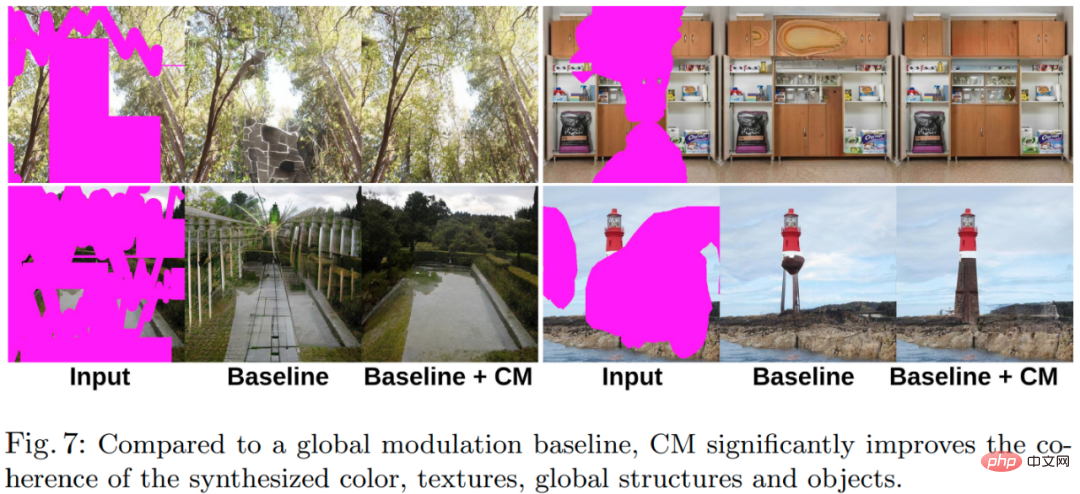

CM-GAN kann bessere globale Strukturen synthetisieren:

CM-GAN hat bessere Objektgrenzen:

Werfen wir einen Blick auf die Methode und die experimentellen Ergebnisse dieser Studie.

Methode

Kaskadenmodulation GAN

Um den globalen Kontext der Bildvervollständigung besser zu modellieren, schlägt diese Studie einen neuen Mechanismus zur Kaskadierung globaler Codemodulation mit räumlicher Codemodulation vor. Dieser Mechanismus hilft, mit teilweise ungültigen Features umzugehen und gleichzeitig den globalen Kontext besser in den räumlichen Bereich einzufügen. Die neue Architektur CM-GAN kann die Gesamtstruktur und lokale Details gut synthetisieren, wie in Abbildung 1 unten dargestellt.

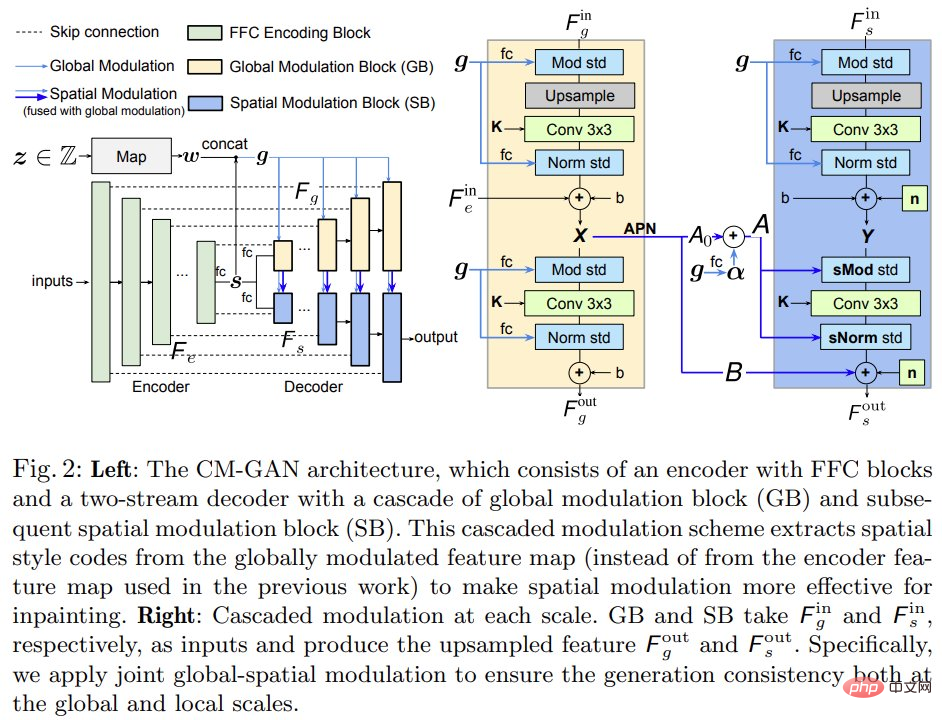

Wie in Abbildung 2 (links) unten dargestellt, basiert CM-GAN auf einem Encoderzweig und zwei parallelen kaskadierten Decoderzweigen, um eine visuelle Ausgabe zu erzeugen. Der Encoder verwendet einen Teil des Bildes und der Maske als Eingabe und generiert Feature-Maps mit mehreren Maßstäben  .

.

Im Gegensatz zu den meisten Encoder-Decoder-Methoden extrahiert diese Studie zur Vervollständigung der Gesamtstruktur die globalen Stilcodes aus den Merkmalen der höchsten Ebene  der vollständig verbundenen Schicht und führt dann eine

der vollständig verbundenen Schicht und führt dann eine  Normalisierung durch. Darüber hinaus generiert ein MLP-basiertes Mapping-Netzwerk Stilcodes w aus Rauschen, um die Zufälligkeit der Bilderzeugung zu simulieren. Codes w werden mit s kombiniert, um einen globalen Code g = [s; w] zu erzeugen, der in nachfolgenden Decodierungsschritten verwendet wird.

Normalisierung durch. Darüber hinaus generiert ein MLP-basiertes Mapping-Netzwerk Stilcodes w aus Rauschen, um die Zufälligkeit der Bilderzeugung zu simulieren. Codes w werden mit s kombiniert, um einen globalen Code g = [s; w] zu erzeugen, der in nachfolgenden Decodierungsschritten verwendet wird.

Globale räumliche Kaskadenmodulation. Um den globalen Kontext in der Dekodierungsphase besser zu verbinden, schlägt diese Studie eine globale räumliche kaskadierte Modulation (CM) vor. Wie in Abbildung 2 (rechts) dargestellt, basiert die Decodierungsstufe auf zwei Zweigen: dem globalen Modulationsblock (GB) und dem räumlichen Modulationsblock (SB) und führt ein paralleles Hochsampeln globaler Merkmale F_g und lokaler Merkmale F_s durch.

Im Gegensatz zu bestehenden Methoden führt CM-GAN eine neue Methode ein, globalen Kontext in Lochregionen einzufügen. Auf konzeptioneller Ebene besteht es aus kaskadierten globalen und räumlichen Modulationen zwischen Merkmalen auf jeder Skala und integriert natürlich drei Kompensationsmechanismen für die globale Kontextmodellierung: 1) Merkmals-Upsampling; 3) räumliche Modulation.

Objektwahrnehmungstraining

Der Algorithmus, der Masken für das Training generiert, ist entscheidend. Im Wesentlichen sollte die abgetastete Maske der im tatsächlichen Anwendungsfall gezeichneten Maske ähneln und die Maske sollte vermeiden, das gesamte Objekt oder große Teile neuer Objekte abzudecken. Zu stark vereinfachte Maskierungsschemata können zu Artefakten führen.

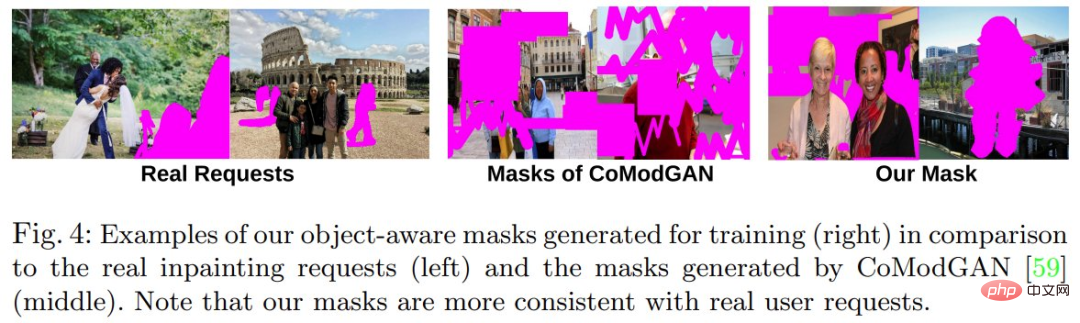

Um reale Anwendungsfälle zum Entfernen von Objekten besser zu unterstützen und gleichzeitig zu verhindern, dass das Modell neue Objekte innerhalb von Löchern synthetisiert, schlägt diese Studie ein Objektbewusstseins-Trainingsschema vor, das während des Trainings realistischere Masken generiert, wie unten in 4 gezeigt.

Konkret leitet die Studie zunächst die Trainingsbilder an das Panorama-Segmentierungsnetzwerk PanopticFCN weiter, um hochpräzise Segmentierungsanmerkungen auf Instanzebene zu generieren, und tastet dann eine Mischung aus freien Löchern und Objektlöchern als Ausgangsmaske ab. und schließlich die Überlappungsrate zwischen dem Loch und jeder Instanz im Bild berechnen. Wenn das Überlappungsverhältnis größer als der Schwellenwert ist, schließt die Methode die Vordergrundinstanz aus dem Loch aus. Andernfalls bleibt das Loch unverändert und das simulierte Objekt wird mit dem auf 0,5 gesetzten Schwellenwert fertiggestellt. Die Studie erweitert und übersetzt Objektmasken nach dem Zufallsprinzip, um eine Überanpassung zu vermeiden. Darüber hinaus vergrößert diese Studie Löcher an Instanzsegmentierungsgrenzen, um zu verhindern, dass Hintergrundpixel in der Nähe von Löchern in den eingefärbten Bereich gelangen.

Trainingsziel mit Masked-R_1-Regularisierung

Das Modell wird mit einer Kombination aus gegnerischem Verlust und segmentierungsbasiertem Wahrnehmungsverlust trainiert. Experimente zeigen, dass diese Methode auch bei reiner Nutzung kontradiktorischer Verluste gute Ergebnisse erzielen kann, das Hinzufügen von Wahrnehmungsverlusten jedoch die Leistung weiter verbessern kann.

Darüber hinaus schlägt diese Studie eine maskierte R_1-Regularisierung speziell für das kontradiktorische Training stabiler Inpainting-Aufgaben vor, bei der eine Maske m verwendet wird, um die Berechnung von Gradienteneinbußen außerhalb der Maske zu vermeiden.

Experimente

Diese Studie führte Bild-Inpainting-Experimente am Places2-Datensatz mit einer Auflösung von 512 × 512 durch und präsentierte quantitative und qualitative Bewertungsergebnisse des Modells.

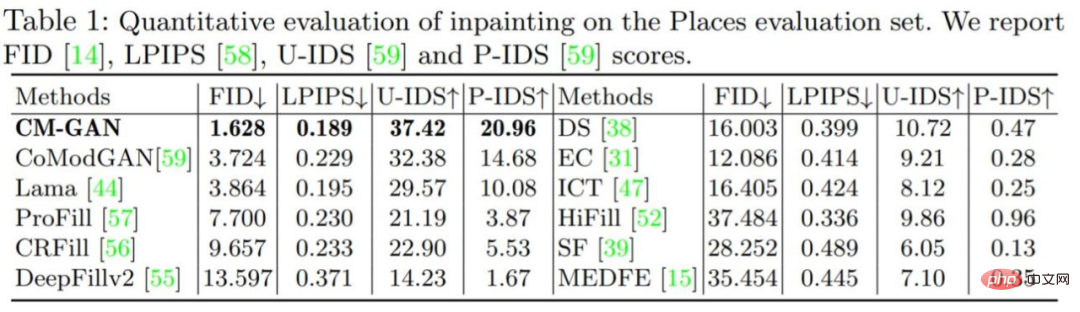

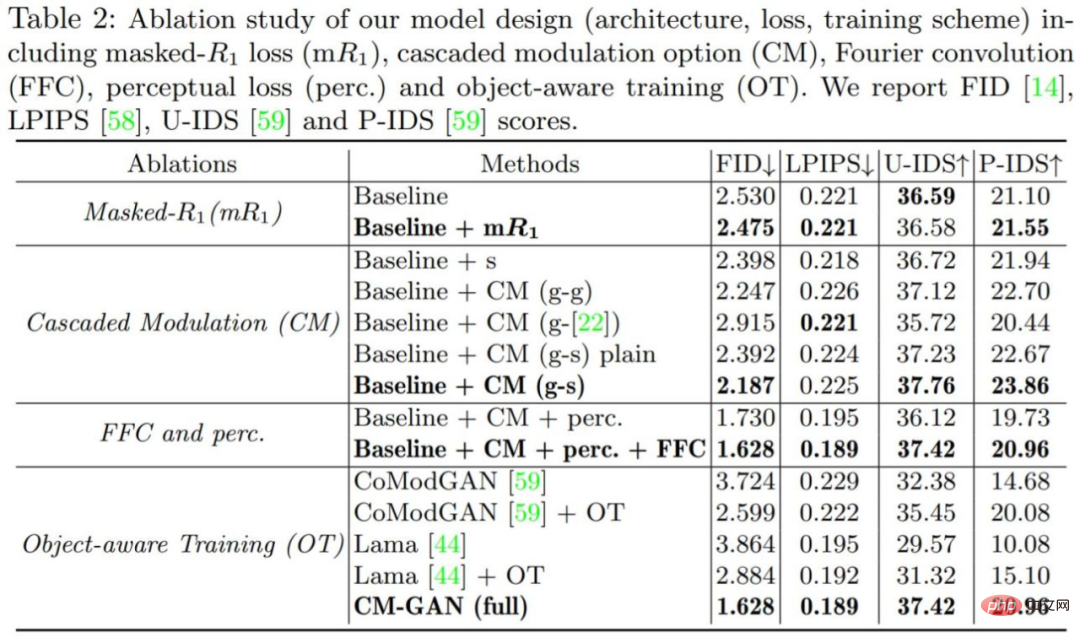

Quantitative Auswertung: Tabelle 1 unten zeigt den Vergleich zwischen CM-GAN und anderen Maskierungsmethoden. Die Ergebnisse zeigen, dass CM-GAN andere Methoden in Bezug auf FID, LPIPS, U-IDS und P-IDS deutlich übertrifft. Mit Hilfe von Perceptual Loss, LaMa, erreicht CM-GAN dank der zusätzlichen semantischen Führung durch das vorab trainierte Wahrnehmungsmodell deutlich bessere LPIPS-Scores als CoModGAN und andere Methoden. Im Vergleich zu LaMa/CoModGAN reduziert CM-GAN den FID von 3,864/3,724 auf 1,628.

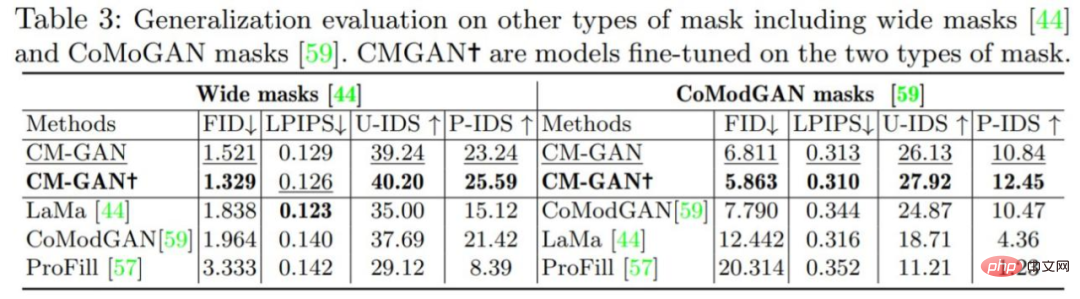

Wie in Tabelle 3 unten gezeigt, erzielte CM-GAN mit oder ohne Feinabstimmung sowohl auf LaMa- als auch auf CoModGAN-Masken deutlich bessere Leistungssteigerungen als LaMa und CoModGAN, was darauf hinweist, dass das Modell über die Fähigkeit zur Generalisierung verfügt. Es ist erwähnenswert, dass die Leistung von CM-GAN, das auf der CoModGAN-Maske und der objektbewussten Maske trainiert wurde, immer noch besser ist als die der CoModGAN-Maske, was bestätigt, dass CM-GAN über eine bessere Generierungsfähigkeit verfügt.

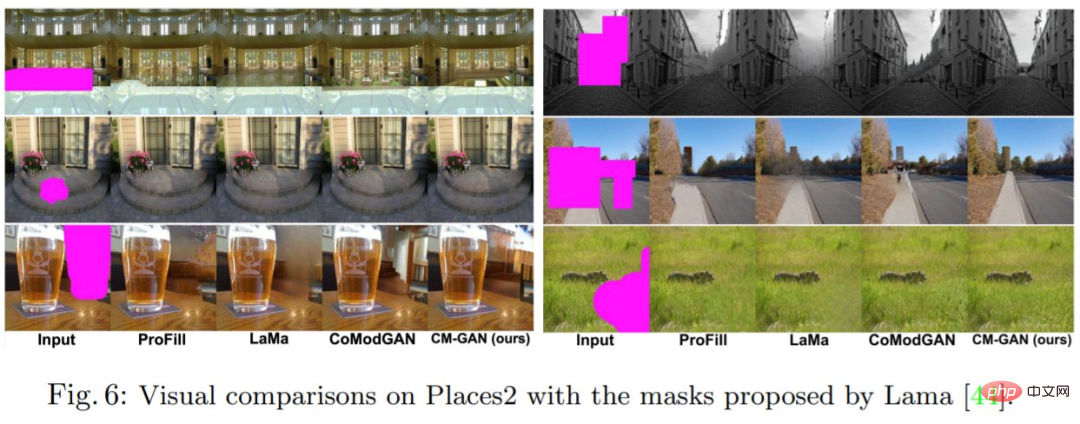

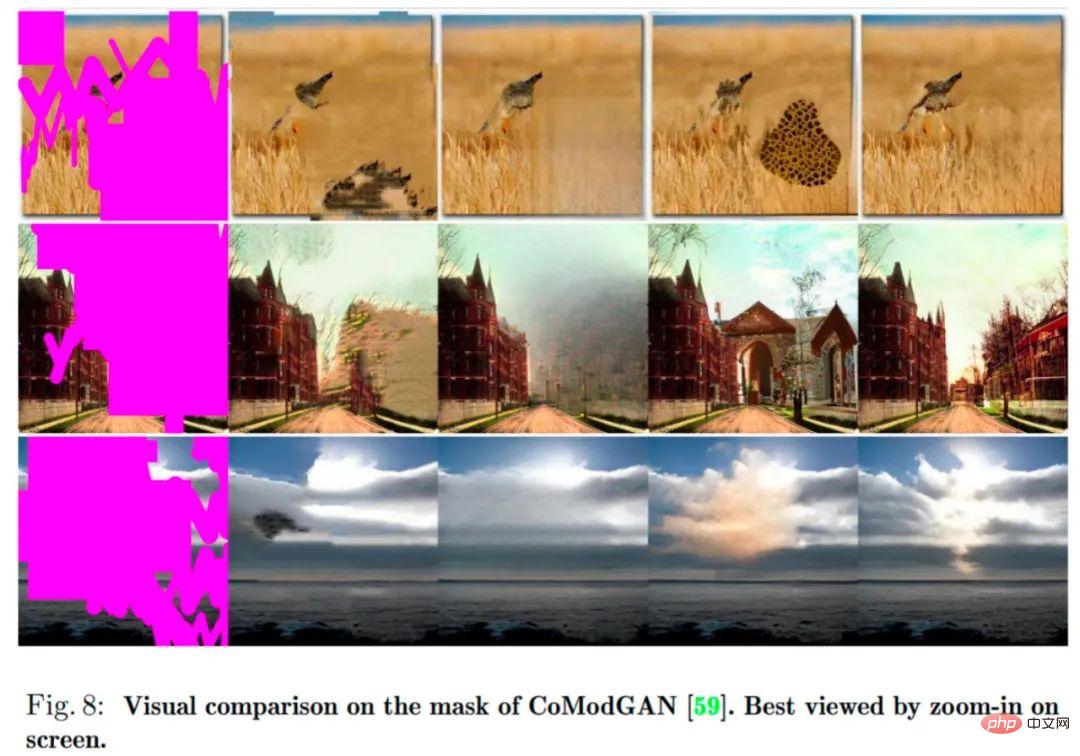

Qualitative Bewertung: Abbildung 5, Abbildung 6, Abbildung 8 zeigen die visuellen Vergleichsergebnisse der CM-GAN- und SOTA-Methoden in Bezug auf synthetische Masken. ProFill ist in der Lage, inkohärente globale Strukturen zu erzeugen, CoModGAN erzeugt Strukturartefakte und Farbflecken und LaMa ist anfällig für große Bildunschärfe bei natürlichen Szenen. Im Gegensatz dazu erzeugt die CM-GAN-Methode eine kohärentere semantische Struktur und eine klarere Textur und kann auf verschiedene Szenarien angewendet werden.

Um die Bedeutung jeder Komponente im Modell zu überprüfen, führte die Studie eine Reihe von Ablationsexperimenten durch und alle Modelle wurden mit dem Places2-Datensatz trainiert und bewertet . Die Ergebnisse des Ablationsexperiments sind in Tabelle 2 und Abbildung 7 unten dargestellt.

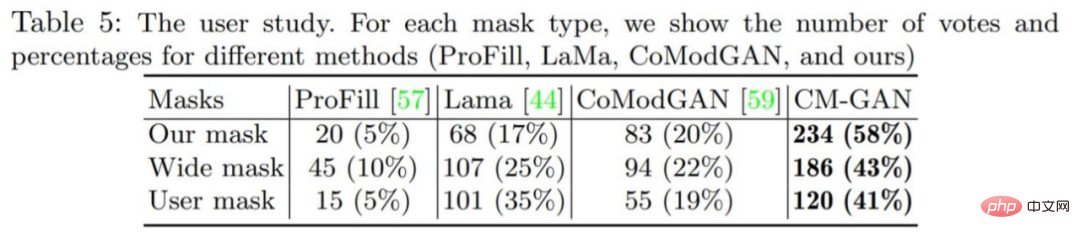

Die Studie führte auch eine Benutzerstudie durch, um die Qualität der visuellen Generierung der CM-GAN-Methode besser zu bewerten. Die Ergebnisse sind in Tabelle 5 unten aufgeführt. Darüber hinaus bietet der Anhang weitere visuelle Vergleiche und experimentelle Analysen als Referenz für den Leser.

Das obige ist der detaillierte Inhalt vonSelbst wenn ein großer Bereich des Bildes fehlt, kann es realistisch wiederhergestellt werden. Das neue Modell CM-GAN berücksichtigt die globalen Struktur- und Texturdetails.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1375

1375

52

52

Diese Apple-ID wird im iTunes Store noch nicht verwendet: Fix

Jun 10, 2024 pm 05:42 PM

Diese Apple-ID wird im iTunes Store noch nicht verwendet: Fix

Jun 10, 2024 pm 05:42 PM

Wenn Sie sich mit der AppleID beim iTunesStore anmelden, wird möglicherweise die Fehlermeldung „Diese AppleID wurde nicht im iTunesStore verwendet“ auf dem Bildschirm angezeigt. Es gibt keine Fehlermeldungen, über die Sie sich Sorgen machen müssen. Sie können sie beheben, indem Sie diese Lösungssätze befolgen. Fix 1 – Lieferadresse ändern Der Hauptgrund, warum diese Aufforderung im iTunes Store erscheint, ist, dass Sie nicht die richtige Adresse in Ihrem AppleID-Profil haben. Schritt 1 – Öffnen Sie zunächst die iPhone-Einstellungen auf Ihrem iPhone. Schritt 2 – AppleID sollte über allen anderen Einstellungen stehen. Also, öffnen Sie es. Schritt 3 – Öffnen Sie dort die Option „Zahlung & Versand“. Schritt 4 – Bestätigen Sie Ihren Zugang mit Face ID. Schritt

So beheben Sie rote Augen auf dem iPhone

Feb 23, 2024 pm 04:31 PM

So beheben Sie rote Augen auf dem iPhone

Feb 23, 2024 pm 04:31 PM

Sie haben also auf Ihrer letzten Party einige tolle Fotos gemacht, aber leider waren die meisten Fotos, die Sie gemacht haben, rote Augen. Das Foto selbst ist großartig, aber die roten Augen darin ruinieren das Bild irgendwie. Ganz zu schweigen davon, dass einige dieser Partyfotos möglicherweise von den Handys Ihrer Freunde stammen. Heute schauen wir uns an, wie man rote Augen aus Fotos entfernt. Was verursacht die roten Augen auf dem Foto? Beim Fotografieren mit Blitz kommt es häufig zu roten Augen. Dies liegt daran, dass das Licht des Blitzes direkt in den Augenhintergrund scheint, wodurch die Blutgefäße unter dem Auge das Licht reflektieren, wodurch auf dem Foto der Effekt roter Augen entsteht. Glücklicherweise sind einige Kameras dank der kontinuierlichen Weiterentwicklung der Technologie mittlerweile mit Funktionen zur Rote-Augen-Korrektur ausgestattet, die dieses Problem effektiv lösen können. Mit dieser Funktion nimmt die Kamera Bilder auf

Wie kann das Problem gelöst werden, dass Win11 die Anmeldeinformationen nicht überprüft?

Jan 30, 2024 pm 02:03 PM

Wie kann das Problem gelöst werden, dass Win11 die Anmeldeinformationen nicht überprüft?

Jan 30, 2024 pm 02:03 PM

Wenn sich ein Win11-Benutzer mit Anmeldeinformationen anmeldet, erhält er eine Fehlermeldung, dass Ihre Anmeldeinformationen nicht überprüft werden können. Was ist los? Nachdem der Herausgeber dieses Problem untersucht hatte, stellte ich fest, dass es mehrere verschiedene Situationen geben kann, die dieses Problem direkt oder indirekt verursachen. Schauen wir uns das gemeinsam mit dem Herausgeber an.

Eine einfache Anleitung zur Behebung von Windows 11-Bluescreen-Problemen

Dec 27, 2023 pm 02:26 PM

Eine einfache Anleitung zur Behebung von Windows 11-Bluescreen-Problemen

Dec 27, 2023 pm 02:26 PM

Viele Freunde stoßen bei der Verwendung von Computer-Betriebssystemen immer auf Bluescreens. Selbst das neueste Win11-System kann dem Schicksal von Bluescreens nicht entkommen. Deshalb habe ich Ihnen heute ein Tutorial zum Reparieren von Win11-Bluescreens gebracht. Unabhängig davon, ob Sie auf einen Bluescreen gestoßen sind oder nicht, können Sie ihn zunächst herausfinden, falls Sie ihn benötigen. So beheben Sie den Win11-Bluescreen-Methode 1. Wenn wir auf einen Bluescreen stoßen, starten Sie zunächst das System neu und prüfen Sie, ob es normal starten kann. 2. Wenn es normal gestartet werden kann, klicken Sie mit der rechten Maustaste auf „Computer“ auf dem Desktop und wählen Sie „Verwalten“ 3. Erweitern Sie dann „Systemprogramme“ auf der linken Seite des Popup-Fensters und wählen Sie „Ereignisanzeige“ 4. Im Mit der Ereignisanzeige können Sie sehen, welches konkrete Problem den Bluescreen verursacht hat. 5. Verfolgen Sie dann einfach die Bluescreen-Situation und die Ereignisse

Umfassender Leitfaden zu PHP 500-Fehlern: Ursachen, Diagnose und Korrekturen

Mar 22, 2024 pm 12:45 PM

Umfassender Leitfaden zu PHP 500-Fehlern: Ursachen, Diagnose und Korrekturen

Mar 22, 2024 pm 12:45 PM

Ein umfassender Leitfaden zu PHP500-Fehlern: Ursachen, Diagnose und Korrekturen Während der PHP-Entwicklung stoßen wir häufig auf Fehler mit dem HTTP-Statuscode 500. Dieser Fehler wird normalerweise „500InternalServerError“ genannt, was bedeutet, dass bei der Verarbeitung der Anfrage auf der Serverseite einige unbekannte Fehler aufgetreten sind. In diesem Artikel untersuchen wir die häufigsten Ursachen von PHP500-Fehlern, wie man sie diagnostiziert und behebt und stellen spezifische Codebeispiele als Referenz bereit. Häufige Ursachen für 1.500 Fehler 1.

Die Lautstärke kann in WIN10 nicht angepasst werden

Mar 27, 2024 pm 05:16 PM

Die Lautstärke kann in WIN10 nicht angepasst werden

Mar 27, 2024 pm 05:16 PM

1. Drücken Sie win+r, um das Ausführungsfenster zu öffnen, geben Sie [regedit] ein und drücken Sie die Eingabetaste, um den Registrierungseditor zu öffnen. 2. Klicken Sie im geöffneten Registrierungseditor, um [HKEY_LOCAL_MACHINESOFTWAREMicrosoftWindowsCurrentVersionRun] zu erweitern. Klicken Sie mit der rechten Maustaste auf die leere Stelle auf der rechten Seite, wählen Sie [Neu – Zeichenfolgenwert] und benennen Sie sie in [systray.exe] um. 3. Doppelklicken Sie, um systray.exe zu öffnen, ändern Sie die numerischen Daten in [C:WindowsSystem32systray.exe] und klicken Sie auf [OK], um die Einstellungen zu speichern.

So lösen Sie das durch csrss.exe verursachte Bluescreen-Problem

Dec 28, 2023 pm 06:24 PM

So lösen Sie das durch csrss.exe verursachte Bluescreen-Problem

Dec 28, 2023 pm 06:24 PM

Wenn Ihr Computer nach dem Start häufig einen blauen Bildschirm anzeigt, liegt möglicherweise ein schwerwiegender Fehler (Stoppcode 0xF4) vor, der vom Windows-System in der Datei csrss.exe verursacht wurde. Sehen wir uns nun an, wie wir das Problem beheben können! So beheben Sie den Bluescreen von csrss.exe: Drücken Sie zunächst gleichzeitig die Tasten „Strg+Alt+Entf“. Daraufhin wird die Benutzeroberfläche des Microsoft Windows-Task-Managers angezeigt. Klicken Sie auf die Registerkarte „Task-Manager“. Auf dem Bildschirm werden alle laufenden Programme und die von ihnen belegten Ressourcen sowie weitere Informationen aufgelistet. Klicken Sie erneut, um die Registerkarte „Prozesse“ aufzurufen, klicken Sie erneut auf „Bildname“ und suchen Sie dann die Datei „csrss.exe“ in der Liste. Klicken Sie auf die Schaltfläche „Prozess beenden“.

So beheben Sie das Problem, dass aufgrund eines abnormalen Netzwerkkartentreibers kein Zugriff auf das Internet möglich ist

Jan 06, 2024 pm 06:33 PM

So beheben Sie das Problem, dass aufgrund eines abnormalen Netzwerkkartentreibers kein Zugriff auf das Internet möglich ist

Jan 06, 2024 pm 06:33 PM

Einige Freunde stellen fest, dass ihr Computer keine Verbindung zum Internet herstellen kann, weil der Netzwerkkartentreiber abnormal ist, und möchten wissen, wie er repariert werden kann. Tatsächlich verfügt das aktuelle System über eine eigene Treiberreparaturfunktion, sodass wir diese nur manuell aktualisieren müssen Wenn es nicht funktioniert, kann die Treibersoftware verwendet werden. So beheben Sie das Problem, dass der Netzwerkkartentreiber abnormal ist und keine Verbindung zum Internet herstellen kann: PS: Wenn dieses Problem plötzlich auftritt, können Sie zunächst versuchen, den Computer neu zu starten. Wenn es nach dem Neustart immer noch nicht funktioniert, fahren Sie mit den folgenden Vorgängen fort . Methode 1: 1. Klicken Sie zunächst mit der rechten Maustaste auf die Taskleiste und wählen Sie „Startmenü“. 2. Öffnen Sie „Geräte-Manager“ im Rechtsklick-Menü. 3. Klicken Sie auf „Netzwerkadapter“, wählen Sie dann „Treiber aktualisieren“ und klicken Sie auf „Automatisch nach Treiber suchen“. 5. Einige Benutzer sind ebenfalls von dem Problem betroffen.