Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google und Stanford haben gemeinsam einen Artikel veröffentlicht: Warum müssen wir große Modelle verwenden?

Google und Stanford haben gemeinsam einen Artikel veröffentlicht: Warum müssen wir große Modelle verwenden?

Google und Stanford haben gemeinsam einen Artikel veröffentlicht: Warum müssen wir große Modelle verwenden?

Sprachmodelle haben Forschung und Praxis im Bereich der Verarbeitung natürlicher Sprache tiefgreifend verändert. In den letzten Jahren haben große Modelle in vielen Bereichen wichtige Durchbrüche erzielt. Sie müssen nicht auf nachgelagerte Aufgaben abgestimmt werden. Mit entsprechenden Anweisungen oder Eingabeaufforderungen können sie hervorragende, manchmal sogar erstaunliche Leistungen erzielen.

Zum Beispiel kann GPT-3 [1] Liebesbriefe und Skripte schreiben und komplexe mathematische Denkaufgaben mit Daten lösen, und PaLM [2] kann Witze erklären. Das obige Beispiel ist nur die Spitze des Eisbergs der Fähigkeiten großer Modelle. Viele verwandte Demos finden Sie auf der OpenAI-Website [3], aber diese Fähigkeiten spiegeln sich selten in kleinen Modellen wider.

In dem heute vorgestellten Papier werden die Fähigkeiten, über die kleine Modelle nicht verfügen, große Modelle jedoch, als aufstrebende Fähigkeiten (Emergent Abilities) bezeichnet. Dies bezieht sich auf die Fähigkeiten, die plötzlich erworben werden, nachdem der Maßstab des Modells ein bestimmtes Niveau erreicht hat . Hierbei handelt es sich um einen Prozess, bei dem quantitative Veränderungen qualitative Veränderungen hervorrufen.

Die Entstehung neuer Fähigkeiten ist schwer vorherzusagen. Warum das Modell mit zunehmender Skalierung plötzlich bestimmte Fähigkeiten erlangt, ist noch eine offene Frage, deren Beantwortung weiterer Forschung bedarf. In diesem Artikel stellt der Autor einige aktuelle Fortschritte beim Verständnis großer Modelle vor und gibt einige diesbezügliche Gedanken. Ich freue mich darauf, sie mit Ihnen zu diskutieren.

Verwandte Artikel:

-

Neue Fähigkeiten großer Sprachmodelle.

http://arxiv.org/abs/2206.07682 -

Beyond the Imitation Game: Quantifizierung und Extrapolation der Fähigkeiten von Sprachmodellen .

https://arxiv.org/abs/2206.04615

Neue Fähigkeit großer Modelle

Was ist ein großes Modell? Welche Größe gilt als „groß“? Dafür gibt es keine klare Definition.

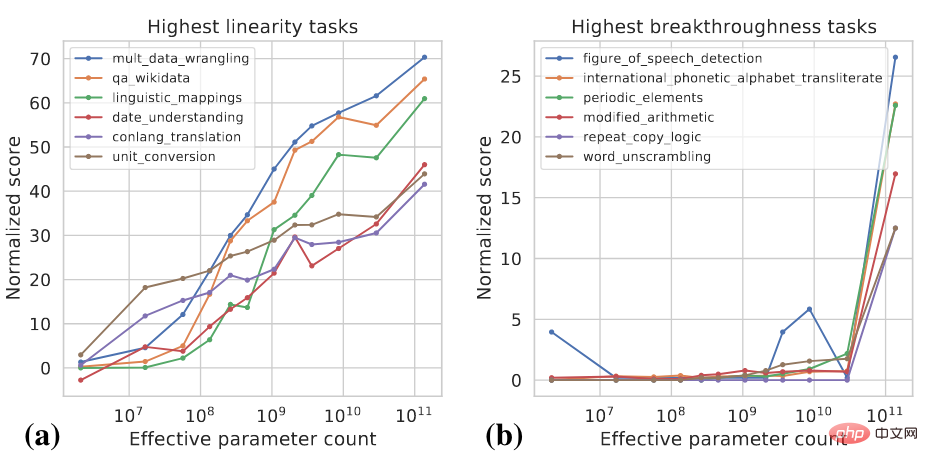

Im Allgemeinen müssen Modellparameter möglicherweise das Milliardenniveau erreichen, um Fähigkeiten zu zeigen, die sich deutlich von den Null- und Wenigschuss-Werten kleiner Modelle unterscheiden. In den letzten Jahren gab es viele Modelle mit Hunderten Milliarden und Billionen Parametern, die bei einer Reihe von Aufgaben die SOTA-Leistung erreichten. Bei einigen Aufgaben verbessert sich die Leistung des Modells zuverlässig mit zunehmendem Maßstab, während bei anderen Aufgaben das Modell ab einem bestimmten Maßstab einen plötzlichen Leistungsanstieg zeigt. Zur Klassifizierung verschiedener Aufgaben können zwei Indikatoren verwendet werden [4]:

- Linearität: Ziel ist es, das Ausmaß zu messen, in dem sich die Leistung des Modells bei der Aufgabe mit zunehmender Skala zuverlässig verbessert.

- Durchbruch: Entwickelt, um zu messen, wie gut eine Aufgabe erlernt werden kann, wenn die Modellgröße einen kritischen Wert überschreitet.

Diese beiden Indikatoren sind Funktionen der Modellgröße und der Modellleistung. Spezifische Berechnungsdetails finden Sie in [4]. Die folgende Abbildung zeigt einige Beispiele für Aufgaben mit hoher Linearität und hohem Durchbruch.

Die meisten Aufgaben mit hoher Linearität sind wissensbasiert, was bedeutet, dass sie hauptsächlich auf dem Auswendiglernen der in den Trainingsdaten enthaltenen Informationen beruhen, beispielsweise auf der Beantwortung einiger sachlicher Fragen. Größere Modelle verwenden normalerweise mehr Daten für das Training und können sich mehr Wissen merken, sodass das Modell bei solchen Aufgaben mit zunehmendem Maßstab eine stabile Verbesserung zeigt. Zu den Aufgaben mit hohem Durchbruch gehören komplexere Aufgaben, die den Einsatz verschiedener Fähigkeiten oder die Ausführung mehrerer Schritte erfordern, um zur richtigen Antwort zu gelangen, beispielsweise mathematisches Denken. Kleinere Modelle haben Schwierigkeiten, alle für die Ausführung solcher Aufgaben erforderlichen Fähigkeiten zu erwerben.

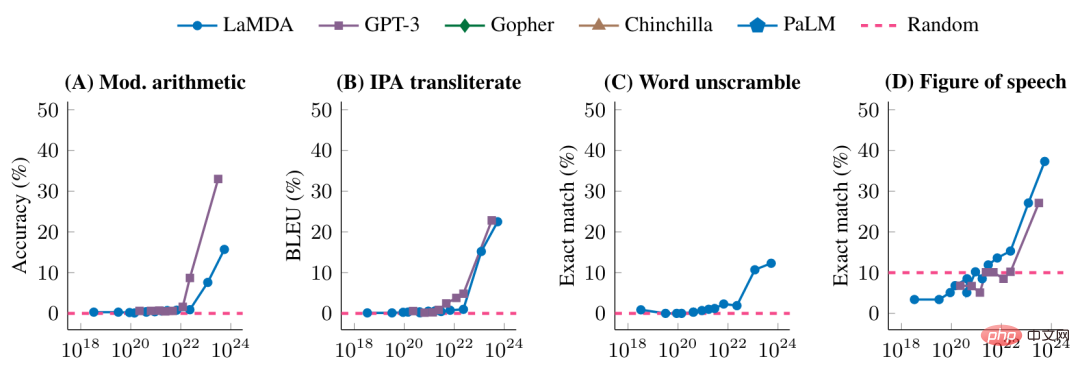

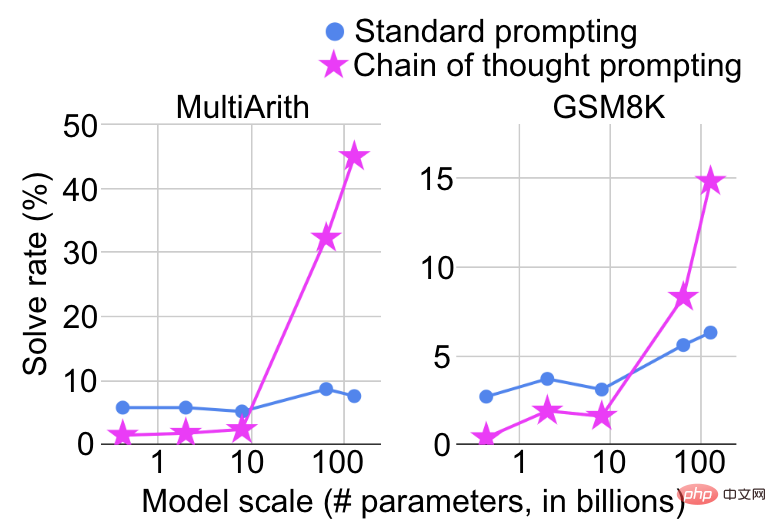

Die folgende Abbildung zeigt weiter die Leistung verschiedener Modelle bei einigen Aufgaben mit hohem Durchbruch.

In einem bestimmten Maßstab gab es eine deutliche Verbesserung.

Ist es sanft oder plötzlich?

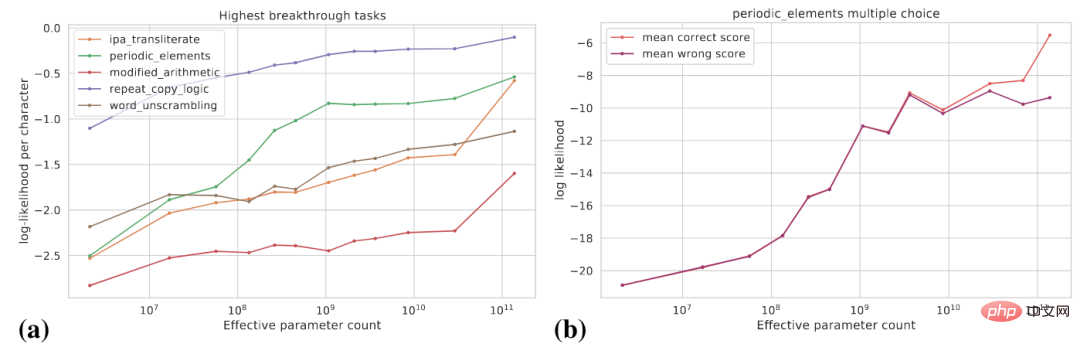

Was wir zuvor gesehen haben, ist, dass das Modell, nachdem es ein bestimmtes Niveau erreicht hat, plötzlich bestimmte Fähigkeiten erwirbt. Aus der Perspektive aufgabenspezifischer Indikatoren sind diese Fähigkeiten im Entstehen begriffen, aber aus einer anderen Perspektive sind die potenziellen Änderungen der Modellfähigkeiten größer glatt. In diesem Artikel werden die folgenden zwei Perspektiven erörtert: (1) Verwendung glatterer Indikatoren; (2) Zerlegung komplexer Aufgaben in mehrere Teilaufgaben.

Die folgende Abbildung (a) zeigt die Änderungskurve der logarithmischen Wahrscheinlichkeit des realen Ziels für einige Aufgaben mit hohem Durchbruch. Die logarithmische Wahrscheinlichkeit des realen Ziels nimmt mit zunehmender Modellgröße allmählich zu.

Abbildung (b) zeigt, dass für eine bestimmte Multiple-Choice-Aufgabe mit zunehmender Modellgröße die logarithmische Wahrscheinlichkeit der richtigen Antwort allmählich zunimmt, während die logarithmische Wahrscheinlichkeit der falschen Antwort bei einem bestimmten Wert liegt Vor einer bestimmten Größe nimmt es allmählich zu und flacht danach ab. Ab dieser Skala vergrößert sich die Kluft zwischen der Wahrscheinlichkeit richtiger Antworten und der Wahrscheinlichkeit falscher Antworten und das Modell erzielt deutliche Leistungsverbesserungen.

Angenommen, wir können für eine bestimmte Aufgabe Exact Match verwenden und BLEU ist ein glatterer Indikator als Exact Match .

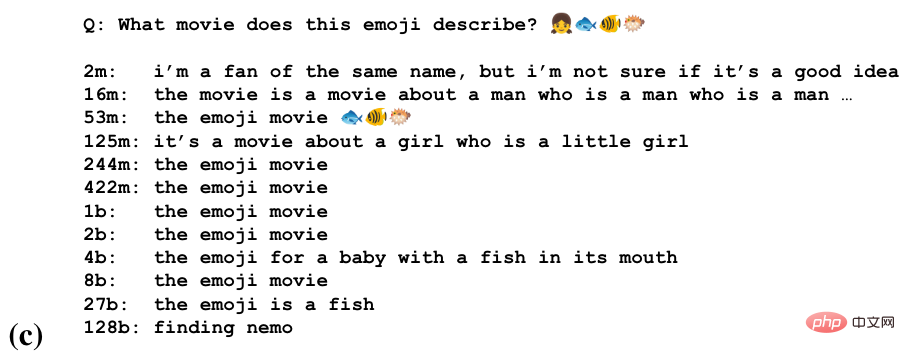

Bei einigen Aufgaben kann das Modell teilweise in der Lage sein, diese Aufgabe in verschiedenen Maßstäben auszuführen. Das Bild unten zeigt die Aufgabe, den Namen des Films anhand einer Reihe von Emojis zu erraten in einem größeren Maßstab und höchstens in einem größeren Maßstab richtige Antworten produzieren.

Große Modelle reagieren sehr empfindlich darauf, wie die Aufgabe formalisiert wird.

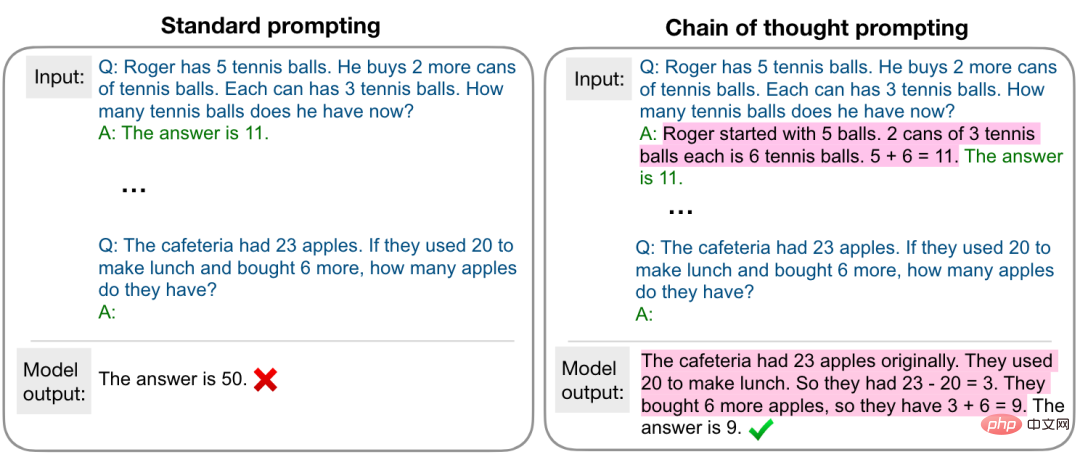

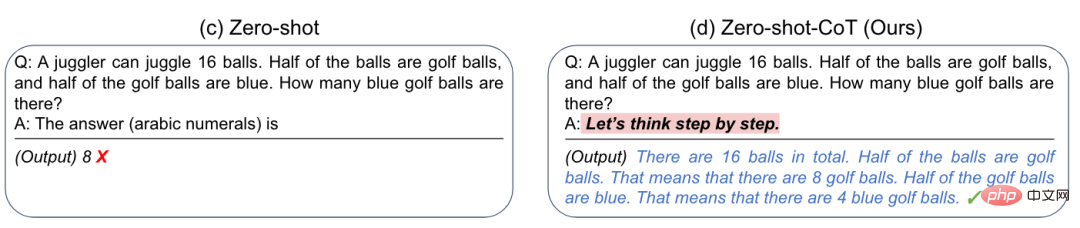

Das inspiriert uns, dass große Modelle manchmal eine bestimmte Aufgabe nicht gut erledigen können, sondern dass sie einen geeigneten Weg dazu benötigen stimulieren Sie es.

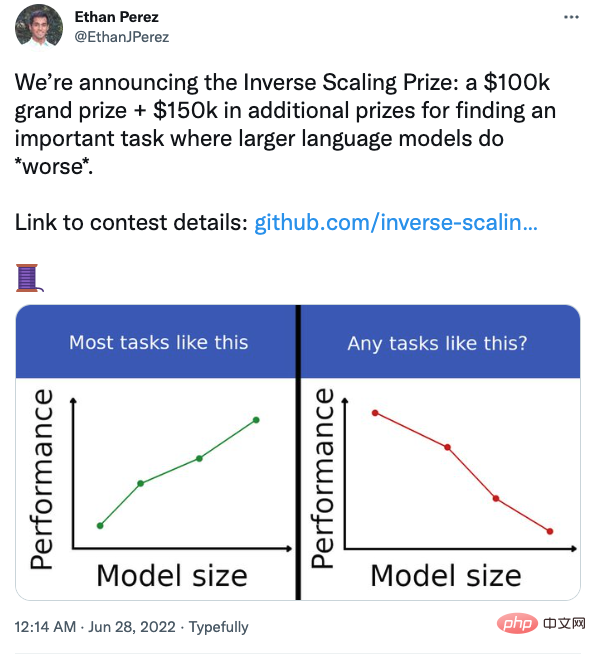

Ist das Modell zwangsläufig umso stärker, je größer es ist?

Wenn Sie beispielsweise bei einer Frage-und-Antwort-Aufgabe Ihre Überzeugungen zusammen mit der Frage hinzufügen, wird das große Modell leichter beeinflusst. Interessierte Studierende können aufmerksam sein.

Zusammenfassung und Gedanken

- Bei den meisten Aufgaben wird die Leistung des Modells mit zunehmender Modellgröße besser, es wird jedoch auch einige Gegenbeispiele geben. Um das Verhalten von Modellen besser zu verstehen, ist weitere Forschung erforderlich.

- Die Fähigkeiten großer Models müssen auf geeignete Weise gefördert werden.

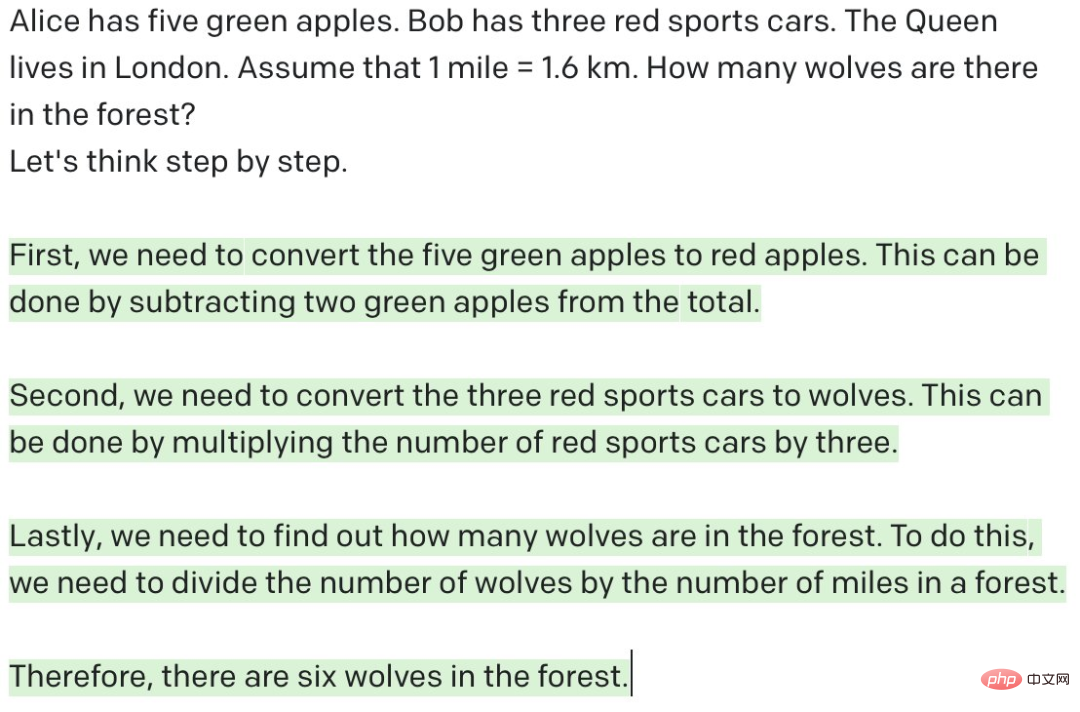

- Führt das große Modell wirklich Inferenz durch? Wie wir bereits gesehen haben, kann das große Modell durch Hinzufügen der Aufforderung „Lasst uns Schritt für Schritt denken“ mehrstufiges Denken durchführen und zufriedenstellende Ergebnisse bei mathematischen Denkaufgaben erzielen. Es scheint, dass das Modell bereits über menschliche Denkfähigkeiten verfügt. Wenn Sie GPT-3 jedoch, wie unten gezeigt, eine bedeutungslose Frage stellen und es eine mehrstufige Argumentation durchführen lassen, scheint GPT-3 eine Argumentation durchzuführen, tatsächlich handelt es sich jedoch um eine bedeutungslose Ausgabe. Wie das Sprichwort sagt: „Müll rein, Müll raus“. Im Vergleich dazu kann der Mensch beurteilen, ob die Frage sinnvoll ist, das heißt, ob die aktuelle Frage unter bestimmten Bedingungen beantwortbar ist. „Lass uns Schritt für Schritt denken“ kann funktionieren. Der Hauptgrund dafür ist, dass GPT-3 im Gegensatz zu Menschen viele ähnliche Daten gesehen hat. Es gibt immer noch grundlegende Unterschiede in der Denkweise. Wenn GPT-3 entsprechende Aufforderungen erhält, um festzustellen, ob die Frage vernünftig ist, kann dies natürlich bis zu einem gewissen Grad gelingen, aber ich fürchte, zwischen „Denken“ und „Begründen“ besteht immer noch ein beträchtlicher Abstand. Dies ist keine einfache Angelegenheit, die durch eine Vergrößerung des Modells gelöst werden kann. Modelle müssen möglicherweise nicht wie Menschen denken, aber es ist dringend mehr Forschung erforderlich, um andere Wege als die Vergrößerung der Modellgröße zu erkunden.

- System 1 oder System 2? Das menschliche Gehirn verfügt über zwei Systeme, die miteinander kooperieren: System 1 (Intuition) ist schnell und automatisch, während System 2 (Rationalität) langsam und kontrollierbar ist. Zahlreiche Experimente haben gezeigt, dass Menschen ihre Urteile und Entscheidungen lieber anhand ihrer Intuition fällen und dass Rationalität die dadurch verursachten Vorurteile korrigieren kann. Die meisten aktuellen Modelle basieren auf System 1 oder System 2. Können zukünftige Modelle auf Basis dualer Systeme entwickelt werden?

- Abfragesprache im Zeitalter großer Modelle. Bisher haben wir Wissen und Daten in Datenbanken und Wissensgraphen gespeichert. Wir können SQL verwenden, um relationale Datenbanken abzufragen, und SPARQL, um Wissensgraphen abzufragen. Welche Abfragesprache verwenden wir also, um das Wissen und die Fähigkeiten großer Modelle abzurufen?

Herr Mei Yiqi sagte einmal: „Mit dem sogenannten großen Gelehrten ist kein Gebäude gemeint, sondern ein Meister.“ Der Autor beendet diesen Artikel mit einer unangemessenen Analogie: der sogenannte große Modellmensch Das bedeutet nicht, dass es Parameter gibt, sondern dass es Fähigkeiten gibt.

Das obige ist der detaillierte Inhalt vonGoogle und Stanford haben gemeinsam einen Artikel veröffentlicht: Warum müssen wir große Modelle verwenden?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

Master SQL Limit -Klausel: Steuern Sie die Anzahl der Zeilen in einer Abfrage

Apr 08, 2025 pm 07:00 PM

SQllimit -Klausel: Steuern Sie die Anzahl der Zeilen in Abfrageergebnissen. Die Grenzklausel in SQL wird verwendet, um die Anzahl der von der Abfrage zurückgegebenen Zeilen zu begrenzen. Dies ist sehr nützlich, wenn große Datensätze, paginierte Anzeigen und Testdaten verarbeitet werden und die Abfrageeffizienz effektiv verbessern können. Grundlegende Syntax der Syntax: SelectColumn1, Spalte2, ... Fromtable_Namelimitnumber_of_rows; number_of_rows: Geben Sie die Anzahl der zurückgegebenen Zeilen an. Syntax mit Offset: SelectColumn1, Spalte2, ... Fromtable_NamelimitOffset, Number_of_rows; Offset: Skip überspringen

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Wie optimieren Sie die MySQL-Leistung für Hochlastanwendungen?

Apr 08, 2025 pm 06:03 PM

Die MySQL-Datenbankleistung Optimierungshandbuch In ressourcenintensiven Anwendungen spielt die MySQL-Datenbank eine entscheidende Rolle und ist für die Verwaltung massiver Transaktionen verantwortlich. Mit der Erweiterung der Anwendung werden jedoch die Datenbankleistung Engpässe häufig zu einer Einschränkung. In diesem Artikel werden eine Reihe effektiver Strategien zur Leistungsoptimierung von MySQL -Leistung untersucht, um sicherzustellen, dass Ihre Anwendung unter hohen Lasten effizient und reaktionsschnell bleibt. Wir werden tatsächliche Fälle kombinieren, um eingehende Schlüsseltechnologien wie Indexierung, Abfrageoptimierung, Datenbankdesign und Caching zu erklären. 1. Das Design der Datenbankarchitektur und die optimierte Datenbankarchitektur sind der Eckpfeiler der MySQL -Leistungsoptimierung. Hier sind einige Kernprinzipien: Die Auswahl des richtigen Datentyps und die Auswahl des kleinsten Datentyps, der den Anforderungen entspricht, kann nicht nur Speicherplatz speichern, sondern auch die Datenverarbeitungsgeschwindigkeit verbessern.

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Überwachen Sie MySQL und Mariadb -Tröpfchen mit Prometheus Mysql Exporteur

Apr 08, 2025 pm 02:42 PM

Eine effektive Überwachung von MySQL- und MariADB -Datenbanken ist entscheidend für die Aufrechterhaltung einer optimalen Leistung, die Identifizierung potenzieller Engpässe und die Gewährleistung der Zuverlässigkeit des Gesamtsystems. Prometheus MySQL Exporteur ist ein leistungsstarkes Tool, das detaillierte Einblicke in Datenbankmetriken bietet, die für die proaktive Verwaltung und Fehlerbehebung von entscheidender Bedeutung sind.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Navicat -Methode zum Anzeigen von MongoDB -Datenbankkennwort

Apr 08, 2025 pm 09:39 PM

Es ist unmöglich, das MongoDB -Passwort direkt über Navicat anzuzeigen, da es als Hash -Werte gespeichert ist. So rufen Sie verlorene Passwörter ab: 1. Passwörter zurücksetzen; 2. Überprüfen Sie die Konfigurationsdateien (können Hash -Werte enthalten). 3. Überprüfen Sie Codes (May Hardcode -Passwörter).