Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Sie können das vorab trainierte Modell für die chinesische Sprache nicht finden? Die chinesische Version Wav2vec 2.0 und HuBERT kommen

Sie können das vorab trainierte Modell für die chinesische Sprache nicht finden? Die chinesische Version Wav2vec 2.0 und HuBERT kommen

Sie können das vorab trainierte Modell für die chinesische Sprache nicht finden? Die chinesische Version Wav2vec 2.0 und HuBERT kommen

Wav2vec 2.0 [1], HuBERT [2] und WavLM [3] sowie andere Sprachvortrainingsmodelle wurden durch selbstüberwachtes Lernen an Zehntausenden Stunden unbeschrifteter Sprachdaten (wie Libri-light) erheblich verbessert. Die Leistung von Sprach-Downstream-Aufgaben wie der automatischen Spracherkennung (ASR), Text-to-Speech (TTS) und Sprachkonversation (VC) wurde verbessert. Allerdings gibt es für diese Modelle keine öffentlichen chinesischen Versionen, was ihre Anwendung in chinesischen Sprachforschungsszenarien erschwert.

WenetSpeech [4] ist ein Multi-Domain-Sprachdatensatz von mehr als 10.000 Stunden, der gemeinsam von der Audio, Speech and Language Processing Research Group der NPU (ASLP@NPU), Mobvoi und Hillshell veröffentlicht wurde. Um die Lücke in den chinesischen Sprachvortrainingsmodellen zu schließen, haben wir die chinesischen Versionen von Wav2vec 2.0 und HuBERT-Modellen als Open Source bereitgestellt, die auf 10.000 Stunden WenetSpeech-Datentraining basieren.

Um die Leistung des vorab trainierten Modells zu überprüfen, haben wir es anhand der ASR-Aufgabe überprüft. Experimentelle Ergebnisse zeigen, dass bei der ASR-Aufgabe mit 100 Stunden überwachter Daten die vom Pre-Training-Modell erlernte Sprachdarstellung im Vergleich zu den herkömmlichen akustischen FBank-Funktionen eine deutliche Leistungsverbesserung aufweist. Sie kann sogar mit nur 100 Stunden überwachter Daten erhalten werden und 1000 Stunden Aufsicht.

Modelllink: https://github.com/TencentGameMate/chinese_speech_pretrain

Modelleinführung

Wav2vec 2.0-Modell

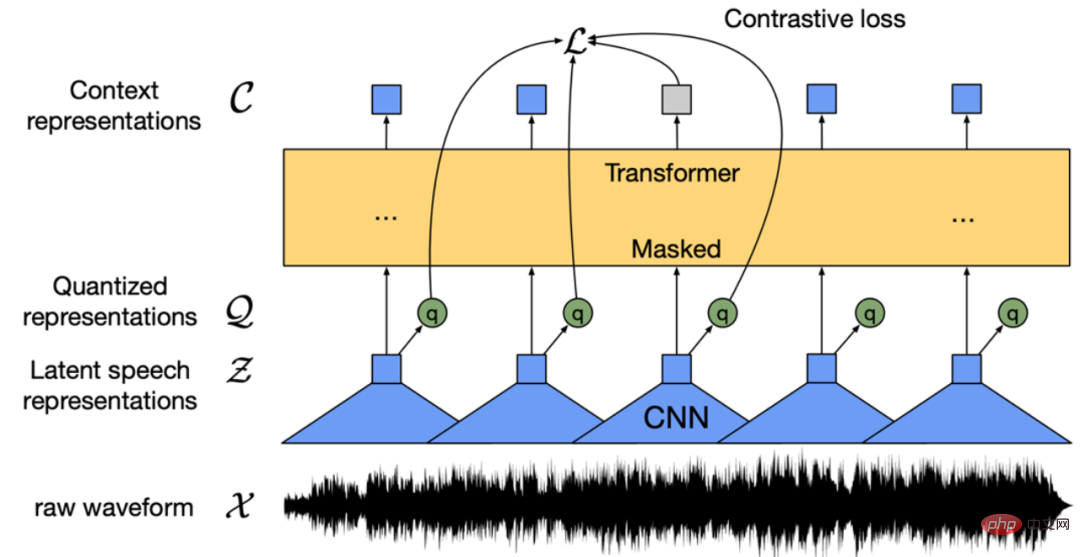

Abbildung 1: Wav2ve c 2.0-Modellstruktur (Baevski et al . , 2020)

Wav2vec 2.0 [1] ist ein unbeaufsichtigtes Sprachvortrainingsmodell, das 2020 von Meta veröffentlicht wurde. Seine Kernidee besteht darin, durch Vektorquantisierung (VQ) ein selbst erstelltes überwachtes Trainingsziel zu erstellen, die Eingabe in großen Mengen zu maskieren und dann die kontrastive Lernverlustfunktion für das Training zu verwenden. Die Modellstruktur ist in Abbildung 1 oben dargestellt. Der auf dem Convolutational Neural Network (CNN) basierende Feature-Extraktor codiert das Original-Audio in eine Folge von Frame-Features und wandelt jedes Frame-Feature über das VQ-Modul in ein diskretes Feature Q um als selbstüberwachtes Ziel verwendet. Gleichzeitig wird die Rahmenmerkmalssequenz einer Maskierungsoperation unterzogen und tritt dann in das Transformer-Modell [5] ein, um die Kontextdarstellung C zu erhalten. Schließlich wird der Abstand zwischen der Kontextdarstellung der Maskenposition und dem entsprechenden diskreten Merkmal q durch Vergleich der Lernverlustfunktion, also des positiven Probenpaars, verkürzt. Im Originalpapier verwendet das Wav2vec 2.0 BASE-Modell eine 12-schichtige Transformer-Struktur und wird mit 1.000 Stunden LibriSpeech-Daten trainiert. Das LARGE-Modell verwendet eine 24-schichtige Transformer-Struktur und wird mit 60.000 Stunden Libri-Light-Daten trainiert. In Bezug auf die Trainingszeit verwendet das BASE-Modell 64 V100-Grafikkarten für das Training für 1,6 Tage und das LARGE-Modell verwendet 128 V100-Grafikkarten für das Training für 5 Tage. In der nachgelagerten ASR-Auswertung erreichte das System selbst bei Verwendung von nur 10 Minuten überwachter Daten immer noch ein Word Error Rate (WER)-Ergebnis von 4,8. „HuBERT-Modell“ ähnelt Wav2ve c 2.0, der Unterschied liegt in der Trainingsmethode. Wav2vec 2.0 diskretisiert Sprachmerkmale als selbstüberwachtes Ziel während des Trainings, während HuBERT das Trainingsziel durch Durchführen von K-Means-Clustering für MFCC-Merkmale oder HuBERT-Merkmale erhält. Das HuBERT-Modell verwendet eine iterative Trainingsmethode. Die erste Iteration des BASE-Modells führt ein Clustering für die MFCC-Features durch. Die zweiten Iteration führt ein Clustering für die in der ersten Iteration erhaltenen Features der mittleren Ebene durch Die zweite Iteration des BASE-Modells extrahiert Features für die Clusterbildung. Den experimentellen Ergebnissen des Originalpapiers nach zu urteilen, ist das HuBERT-Modell besser als Wav2vec 2.0, insbesondere wenn die nachgelagerten Aufgaben nur sehr wenige überwachte Trainingsdaten haben, z. B. 1 Stunde oder 10 Minuten.

Chinesisches Vortrainingsmodell

Experimentelle KonfigurationWir verwenden 10.000 Stunden chinesische Daten aus dem WenetSpeech [4] train_l-Set als unbeaufsichtigte Vortrainingsdaten. Die Daten stammen hauptsächlich aus YouTube und Podcasts und umfassen verschiedene Arten von Aufnahmeszenen, Hintergrundgeräuschen, Sprechstilen usw. Zu den Bereichen gehören hauptsächlich Hörbücher, Erzählungen, Dokumentationen, Fernsehserien, Interviews, Nachrichten, Lesungen, Reden, Varietés und andere. usw. 10 Hauptszene. Wir haben Wav2vec 2.0- und HuBERT-Modelle basierend auf dem Fairseq-Toolkit [6] trainiert und dabei der Modellkonfiguration von [1, 2] gefolgt. Jedes vorab trainierte Modellmodell enthält zwei Größen: BASE und LARGE. Für das BASE-Modell verwenden wir 8 A100-Grafikkarten, die Gradientenakkumulation beträgt 8 und simulieren 64 Grafikkarten für das Training. Für das LARGE-Modell verwenden wir 16 A100-Grafikkarten, die Gradientenakkumulation beträgt 8 und simulieren 128 Grafikkarten für das Training.

Überprüfung der Downstream-SpracherkennungsaufgabeUm die Wirkung des vorab trainierten Modells auf die Downstream-ASR-Aufgabe zu überprüfen, folgen wir der experimentellen Konfiguration des Conformer-Modells [10] im ESPnet-Toolkit [7,8,9]. Das heißt, das vorab trainierte Modell wird als verwendet. Der Merkmalsextraktor führt eine gewichtete Summierung der Darstellungen der verborgenen Ebene des eingegebenen Sprachextraktions-Vortrainingsmodells durch, und die resultierende Sprachdarstellung ersetzt die herkömmlichen FBank-Merkmale als Eingabe des Konformes ASR-Modell.

- Aishell-Datensatz

Wir verwendeten den Aishell 178-Stunden-Trainingssatz als überwachte Daten für das Training und verglichen die Wörter mit FBank-Funktionen, Wav2vec 2.0 BASE/LARGE-Modellfunktionen bzw. HuBERT BASE/LARGE-Modellfunktionen. Ergebnisse der Zeichenfehlerrate (CER). Gleichzeitig verglichen wir zusätzlich die Auswirkung auf den Aishell-Testsatz, wenn wir den WenetSpeech train_l-Satz mit 10.000 Stunden chinesischen Daten für das Training verwendeten. Die Trainingsdaten nutzen variable Geschwindigkeit (0,9-, 1,0-, 1,1-fach) und die SpecAugment-Datenerweiterungstechnologie, die Dekodierungsmethode ist die Strahlsuche und für die Neubewertung wird ein Transformer-basiertes Sprachmodell verwendet.

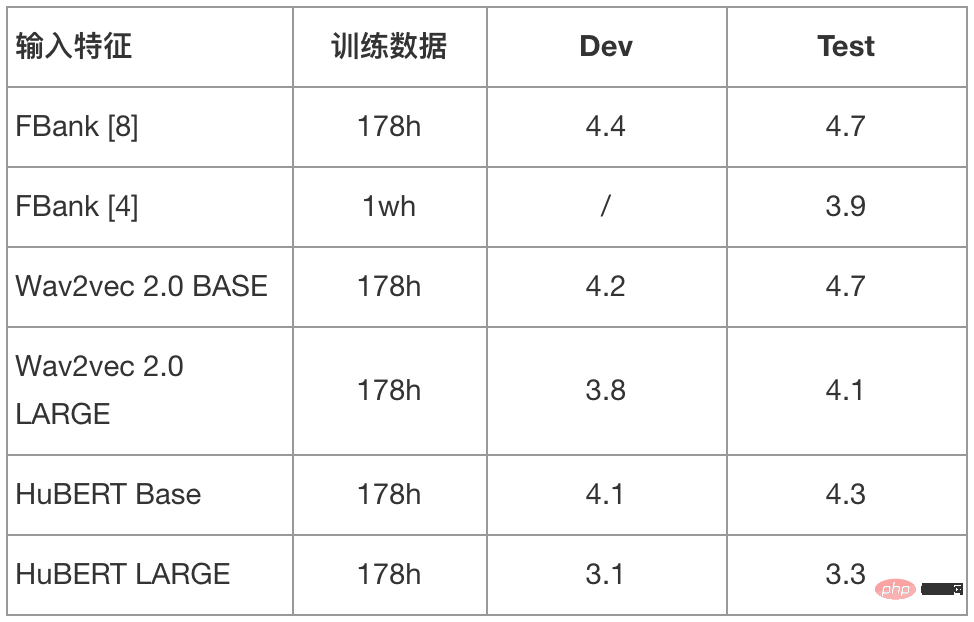

Tabelle 1: Ergebnisse der Wortfehlerrate (CER%) verschiedener Modelle im Aishell-Testsatz

Wie aus den Ergebnissen in Tabelle 1 ersichtlich ist, durch Kombination von Zehntausenden Stunden unüberwachter Daten Das trainierte Pre-Training-Modell und die nachgelagerten ASR-Aufgabeneffekte wurden erheblich verbessert. Insbesondere bei Verwendung des HuBERT LARGE-Modells wurde eine relative Verbesserung der CER um etwa 30 % im Testsatz erzielt und damit die besten Ergebnisse in der Branche bei 178 Stunden überwachter Trainingsdaten erzielt.

- WenetSpeech-Datensatz

Wir haben den WenetSpeech train_s-Satz 100 Stunden chinesischer Daten als überwachte Daten für das Training verwendet und die Verwendung von FBank-Funktionen, Wav2vec 2.0 BASE/LARGE-Modellfunktionen und HuBERT BASE/LARGE verglichen Ergebnisse der Zeichenfehlerrate (CER). Gleichzeitig verglichen wir zusätzlich die Modellergebnisse mit dem WenetSpeech train_m-Set für 1.000 Stunden und dem train_l-Set für 10.000 Stunden chinesischer Daten-FBank-Funktionen. Die Trainingsdaten verwenden keine Datenerweiterungstechnologie mit variabler Geschwindigkeit oder SpecAugment, die Dekodierungsmethode ist die Strahlsuche und es wird keine Neubewertung des Sprachmodells verwendet.

Tabelle 2: Ergebnisse der Wortfehlerrate (CER%) verschiedener Modelle im WenetSpeech-Testsatz

Wie aus den Ergebnissen in Tabelle 2 ersichtlich ist, durch Kombination von Zehntausenden Stunden unüberwachter Daten Mit dem trainierten vorab trainierten Modell werden die Downstream-ASR-Ergebnisse erheblich verbessert. Insbesondere bei Verwendung von HuBERT LARGE als Sprachdarstellungsextraktor schneidet das mit 100 Stunden überwachten Daten trainierte ASR-Modell besser ab als das mit 1000 Stunden FBank-Funktionen trainierte Modell und kommt sogar dem mit 10.000 Stunden Daten trainierten Modell nahe.

Für weitere experimentelle Ergebnisse zu Voice-Downstream-Aufgaben folgen Sie bitte dem GitHub-Link (https://github.com/TencentGameMate/chinese_speech_pretrain). Jeder ist herzlich willkommen, das von uns bereitgestellte chinesische Sprachvortrainingsmodell für Forschungsarbeiten zu nutzen und die Anwendung des Sprachvortrainingsmodells in chinesischen und verwandten Szenarien zu untersuchen.

Das obige ist der detaillierte Inhalt vonSie können das vorab trainierte Modell für die chinesische Sprache nicht finden? Die chinesische Version Wav2vec 2.0 und HuBERT kommen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1657

1657

14

14

1415

1415

52

52

1309

1309

25

25

1257

1257

29

29

1229

1229

24

24

Wie viel ist Bitcoin wert?

Apr 28, 2025 pm 07:42 PM

Wie viel ist Bitcoin wert?

Apr 28, 2025 pm 07:42 PM

Der Preis von Bitcoin liegt zwischen 20.000 und 30.000 US -Dollar. 1. Bitcoin's Preis hat seit 2009 dramatisch geschwankt und im Jahr 2017 fast 20.000 US -Dollar und im Jahr 2021 in Höhe von fast 60.000 USD erreicht. 2. Die Preise werden von Faktoren wie Marktnachfrage, Angebot und makroökonomischem Umfeld beeinflusst. 3. Erhalten Sie Echtzeitpreise über Börsen, mobile Apps und Websites. V. 5. Es hat eine gewisse Beziehung zu den traditionellen Finanzmärkten und ist von den globalen Aktienmärkten, der Stärke des US-Dollars usw. betroffen. 6. Der langfristige Trend ist optimistisch, aber Risiken müssen mit Vorsicht bewertet werden.

Welche der zehn besten Währungshandelsplattformen der Welt gehören 2025 zu den zehn Top -Währungshandelsplattformen

Apr 28, 2025 pm 08:12 PM

Welche der zehn besten Währungshandelsplattformen der Welt gehören 2025 zu den zehn Top -Währungshandelsplattformen

Apr 28, 2025 pm 08:12 PM

Zu den zehn Top -Kryptowährungsbörsen der Welt im Jahr 2025 gehören Binance, OKX, Gate.io, Coinbase, Kraken, Huobi, Bitfinex, Kucoin, Bittrex und Poloniex, die alle für ihr hohes Handelsvolumen und ihre Sicherheit bekannt sind.

Welche der zehn besten Währungsplattformen der Welt sind die neueste Version der zehn besten Währungshandelsplattformen

Apr 28, 2025 pm 08:09 PM

Welche der zehn besten Währungsplattformen der Welt sind die neueste Version der zehn besten Währungshandelsplattformen

Apr 28, 2025 pm 08:09 PM

Zu den zehn Top -Kryptowährungs -Handelsplattformen der Welt gehören Binance, OKX, Gate.io, Coinbase, Kraken, Huobi Global, Bitfinex, Bittrex, Kucoin und Poloniex, die alle eine Vielzahl von Handelsmethoden und leistungsstarken Sicherheitsmaßnahmen bieten.

Was sind die zehn Top -Apps für virtuelle Währungshandel? Die neuesten Ranglisten für digitale Währung Exchange

Apr 28, 2025 pm 08:03 PM

Was sind die zehn Top -Apps für virtuelle Währungshandel? Die neuesten Ranglisten für digitale Währung Exchange

Apr 28, 2025 pm 08:03 PM

Die zehn Top -Börsen für digitale Währungen wie Binance, OKX, Gate.io haben ihre Systeme, effiziente diversifizierte Transaktionen und strenge Sicherheitsmaßnahmen verbessert.

Decryption Gate.io Strategy Upgrade: Wie definieren Sie das Krypto -Asset -Management in Memebox 2.0?

Apr 28, 2025 pm 03:33 PM

Decryption Gate.io Strategy Upgrade: Wie definieren Sie das Krypto -Asset -Management in Memebox 2.0?

Apr 28, 2025 pm 03:33 PM

Memebox 2.0 definiert das Krypto -Asset -Management durch innovative Architektur- und Leistungsbrachdurchbrüche. 1) Es löst drei Hauptschmerzpunkte: Vermögenssetsilos, Einkommensverfall und Paradox der Sicherheit und Bequemlichkeit. 2) Durch intelligente Asset-Hubs werden dynamische Risikomanagement- und Renditeverstärkungsmotoren die Übertragungsgeschwindigkeit, die durchschnittliche Ertragsrate und die Reaktionsgeschwindigkeit für Sicherheitsvorfälle verbessert. 3) Nutzern die Integration von Asset Visualisierung, Richtlinienautomatisierung und Governance -Integration zur Verfügung stellen und die Rekonstruktion des Benutzerwerts realisieren. 4) Durch ökologische Zusammenarbeit und Compliance -Innovation wurde die Gesamtwirksamkeit der Plattform verbessert. 5) In Zukunft werden intelligente Vertragsversicherungspools, die Prognosemarktintegration und die KI-gesteuerte Vermögenszuweisung gestartet, um weiterhin die Entwicklung der Branche zu leiten.

Empfohlene zuverlässige Handelsplattformen für digitale Währung. Top 10 Digitalwährungsbörsen in der Welt. 2025

Apr 28, 2025 pm 04:30 PM

Empfohlene zuverlässige Handelsplattformen für digitale Währung. Top 10 Digitalwährungsbörsen in der Welt. 2025

Apr 28, 2025 pm 04:30 PM

Empfohlene zuverlässige Handelsplattformen für digitale Währung: 1. OKX, 2. Binance, 3. Coinbase, 4. Kraken, 5. Huobi, 6. Kucoin, 7. Bitfinex, 8. Gemini, 9. Bitstamp, 10. Poloniex, diese Plattformen sind für ihre Sicherheit, Benutzererfahrung und verschiedene Funziktionen, geeignet für Benutzer, geeignet für Benutzer, geeignet für Benutzer, geeignet für Benutzer, geeignet für Ufers, für Benutzer, geeignet für Ufersniveaus, in unterschiedlichen Digitalverkehrsniveaus, in unterschiedlichen Niveaus, bei Digitalwährung, für Nutzer, für Benutzer, in unterschiedliche Ebenen von Digitalwährung, für Benutzer, die für Nutzer, für Benutzer, in unterschiedlichen Digitalverkehrsniveaus, auf Digitalwährung, auf Digitalwährung, auf Digitalwährung, bei Digitalwährung, auf Digitalwährung bekannt

Was sind die Top -Währungshandelsplattformen? Die Top 10 neuesten virtuellen Währungsbörsen

Apr 28, 2025 pm 08:06 PM

Was sind die Top -Währungshandelsplattformen? Die Top 10 neuesten virtuellen Währungsbörsen

Apr 28, 2025 pm 08:06 PM

Derzeit unter den zehn besten Börsen der virtuellen Währung eingestuft: 1. Binance, 2. OKX, 3. Gate.io, 4. Coin Library, 5. Siren, 6. Huobi Global Station, 7. Bybit, 8. Kucoin, 9. Bitcoin, 10. Bit Stamp.

Wie misst ich die Thread -Leistung in C?

Apr 28, 2025 pm 10:21 PM

Wie misst ich die Thread -Leistung in C?

Apr 28, 2025 pm 10:21 PM

Durch die Messung der Thread -Leistung in C kann Timing -Tools, Leistungsanalyse -Tools und benutzerdefinierte Timer in der Standardbibliothek verwendet werden. 1. Verwenden Sie die Bibliothek, um die Ausführungszeit zu messen. 2. Verwenden Sie GPROF für die Leistungsanalyse. Zu den Schritten gehört das Hinzufügen der -PG -Option während der Kompilierung, das Ausführen des Programms, um eine Gmon.out -Datei zu generieren, und das Generieren eines Leistungsberichts. 3. Verwenden Sie das Callgrind -Modul von Valgrind, um eine detailliertere Analyse durchzuführen. Zu den Schritten gehört das Ausführen des Programms zum Generieren der Callgrind.out -Datei und das Anzeigen der Ergebnisse mit KCACHEGRIND. 4. Benutzerdefinierte Timer können die Ausführungszeit eines bestimmten Codesegments flexibel messen. Diese Methoden helfen dabei, die Thread -Leistung vollständig zu verstehen und den Code zu optimieren.