Was ist das Machine-Learning-Modell von Transformer?

Übersetzer |. Li Rui

Rezensent |. Es wird hauptsächlich für fortgeschrittene Anwendungen in der Verarbeitung natürlicher Sprache verwendet. Google nutzt es, um seine Suchmaschinenergebnisse zu verbessern. OpenAI hat Transformer verwendet, um die berühmten GPT-2- und GPT-3-Modelle zu erstellen.

Seit ihrem Debüt im Jahr 2017 hat sich die Transformer-Architektur weiterentwickelt und in viele verschiedene Varianten erweitert, die von Sprachaufgaben bis hin zu anderen Domänen reichen. Sie wurden für die Zeitreihenvorhersage verwendet. Sie sind die Schlüsselinnovation hinter AlphaFold, dem Proteinstruktur-Vorhersagemodell von DeepMind. Das Quellcode-Generierungsmodell Codex von OpenAI basiert ebenfalls auf Transformer. Transformatoren sind seit Kurzem auch im Bereich der Computer Vision angekommen, wo sie bei vielen komplexen Aufgaben nach und nach Convolutional Neural Networks (CNN) ersetzen.

Seit ihrem Debüt im Jahr 2017 hat sich die Transformer-Architektur weiterentwickelt und in viele verschiedene Varianten erweitert, die von Sprachaufgaben bis hin zu anderen Domänen reichen. Sie wurden für die Zeitreihenvorhersage verwendet. Sie sind die Schlüsselinnovation hinter AlphaFold, dem Proteinstruktur-Vorhersagemodell von DeepMind. Das Quellcode-Generierungsmodell Codex von OpenAI basiert ebenfalls auf Transformer. Transformatoren sind seit Kurzem auch im Bereich der Computer Vision angekommen, wo sie bei vielen komplexen Aufgaben nach und nach Convolutional Neural Networks (CNN) ersetzen.

Forscher suchen immer noch nach Möglichkeiten, Transformer zu verbessern und für neue Anwendungen zu nutzen. Hier ist eine kurze Erklärung, was Transformers spannend macht und wie sie funktionieren.

1. Verwenden Sie neuronale Netze, um Sequenzdaten zu verarbeiten.

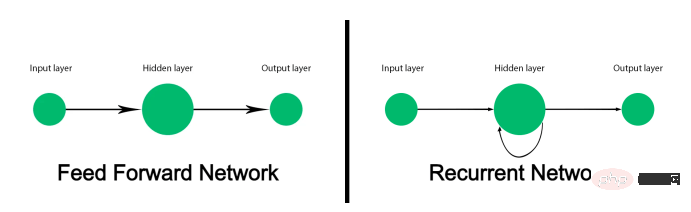

Herkömmliche Feedforward-Neuronale Netze sind nicht dafür ausgelegt, Sequenzdaten zu verfolgen und jede Eingabe einer Ausgabe zuzuordnen. Es funktioniert gut für Aufgaben wie die Bildklassifizierung, schlägt jedoch bei Sequenzdaten wie Text fehl. Modelle für maschinelles Lernen, die Text verarbeiten, müssen nicht nur jedes Wort verarbeiten, sondern auch berücksichtigen, wie Wörter in der richtigen Reihenfolge angeordnet und zueinander in Beziehung stehen. Und die Bedeutung eines Wortes kann sich abhängig von den anderen Wörtern ändern, die davor und danach im Satz vorkommen.

Vor dem Aufkommen von Transformer waren Recurrent Neural Networks (RNN) die bevorzugte Lösung für die Verarbeitung natürlicher Sprache. Wenn eine Folge von Wörtern vorgegeben wird, verarbeitet ein wiederkehrendes neuronales Netzwerk (RNN) das erste Wort und gibt die Ergebnisse an die Schicht zurück, die das nächste Wort verarbeitet. Dies ermöglicht es, einen ganzen Satz zu verfolgen, anstatt jedes Wort einzeln zu verarbeiten.

Die Mängel rekurrenter neuronaler Netze (RNN) schränken ihren Nutzen ein. Erstens sind sie sehr langsam zu verarbeiten. Da sie Daten sequentiell verarbeiten müssen, können sie die Vorteile paralleler Rechenhardware und Grafikprozessoren (GPUs) nicht für Training und Inferenz nutzen. Zweitens können sie lange Textsequenzen nicht verarbeiten. Je tiefer das rekurrente neuronale Netzwerk (RNN) in den Textausschnitt eindringt, desto geringer wird die Wirkung der ersten paar Wörter des Satzes. Dieses als „verschwindender Farbverlauf“ bekannte Problem tritt auf, wenn zwei verknüpfte Wörter im Text weit voneinander entfernt sind. Drittens erfassen sie nur die Beziehung zwischen einem Wort und den ihm vorangehenden Wörtern. Tatsächlich hängt die Bedeutung von Wörtern von den Wörtern ab, die vor und nach ihnen stehen.

Das Long Short-Term Memory (LSTM)-Netzwerk ist der Nachfolger des Recurrent Neural Network (RNN), das das Problem des verschwindenden Gradienten bis zu einem gewissen Grad lösen und größere Textsequenzen verarbeiten kann. Aber Long Short-Term Memory (LSTM) ist noch langsamer zu trainieren als Recurrent Neural Networks (RNN) und kann dennoch nicht alle Vorteile des parallelen Rechnens nutzen. Sie setzen immer noch auf die serielle Verarbeitung von Textsequenzen.

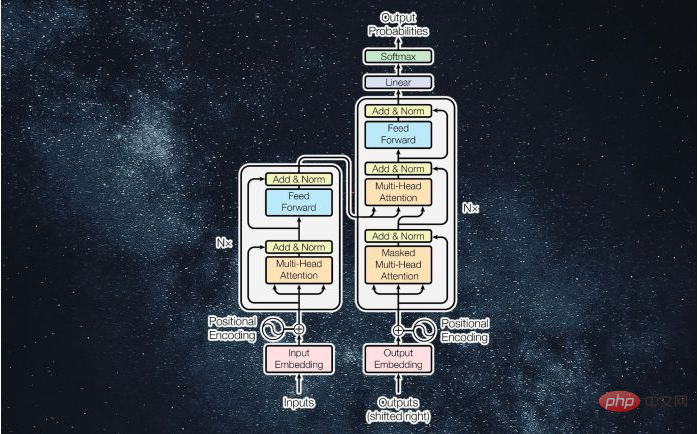

In einem Artikel aus dem Jahr 2017 mit dem Titel „Aufmerksamkeit ist alles, was benötigt wird“ wurde Transformer vorgestellt und festgestellt, dass Transformer

zwei wichtige Beiträge geleistet hat: Erstens ermöglichten sie die parallele Verarbeitung ganzer Sequenzen und ermöglichten so die Konvertierung sequentieller Geschwindigkeit und Kapazität Deep-Learning-Modelle lassen sich mit beispielloser Geschwindigkeit skalieren. Zweitens führen sie „Aufmerksamkeitsmechanismen“ ein, die Beziehungen zwischen Wörtern in sehr langen Textsequenzen sowohl vorwärts als auch rückwärts verfolgen können.

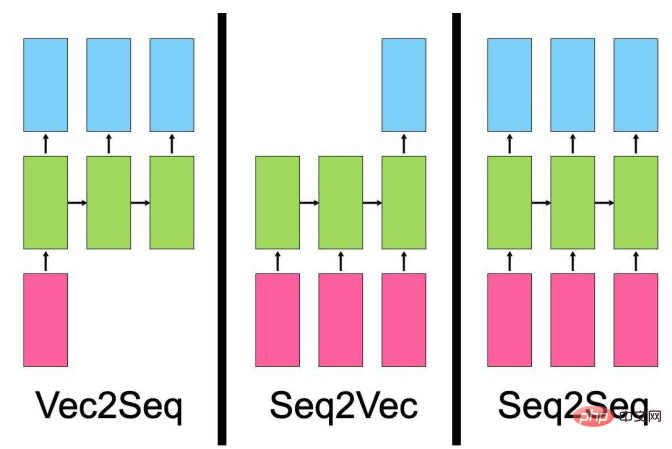

Bevor wir diskutieren, wie das Transformer-Modell funktioniert, ist es notwendig, die Arten von Problemen zu diskutieren, die sequenzielle neuronale Netze lösen.

- Vector-to-Sequence-Modelle nehmen eine einzelne Eingabe (z. B. ein Bild) und generieren eine Datensequenz (z. B. eine Beschreibung).

- „Sequence-to-Vector“-Modelle nehmen Sequenzdaten als Eingabe, etwa Produktbewertungen oder Social-Media-Beiträge, und geben einen einzelnen Wert aus, etwa einen Sentiment-Score.

- Ein „Sequenz-zu-Sequenz“-Modell nimmt als Eingabe eine Sequenz, beispielsweise einen englischen Satz, und gibt eine andere Sequenz aus, beispielsweise die französische Übersetzung dieses Satzes.

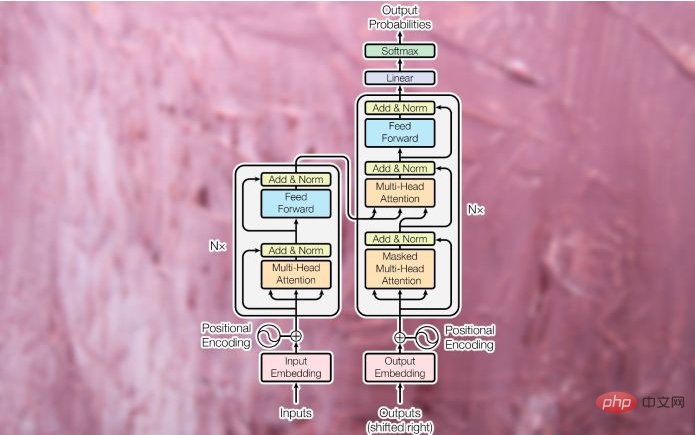

Trotz ihrer Unterschiede haben alle diese Modelltypen eines gemeinsam: Sie lernen Ausdrücke. Die Aufgabe eines neuronalen Netzwerks besteht darin, einen Datentyp in einen anderen Datentyp umzuwandeln. Während des Trainings passt die verborgene Schicht des neuronalen Netzwerks (die Schicht zwischen Eingabe und Ausgabe) ihre Parameter so an, dass sie die Eigenschaften des Eingabedatentyps am besten darstellen, und ordnet sie der Ausgabe zu. Der ursprüngliche Transformer wurde als Sequenz-zu-Sequenz-Modell (seq2seq) für die maschinelle Übersetzung konzipiert (Sequenz-zu-Sequenz-Modelle sind natürlich nicht auf Übersetzungsaufgaben beschränkt). Es besteht aus einem Encodermodul, das die Eingabezeichenfolge aus der Quellsprache in einen Vektor komprimiert, der Wörter und ihre Beziehungen zueinander darstellt. Das Decodermodul wandelt den codierten Vektor in eine Textzeichenfolge in der Zielsprache um.

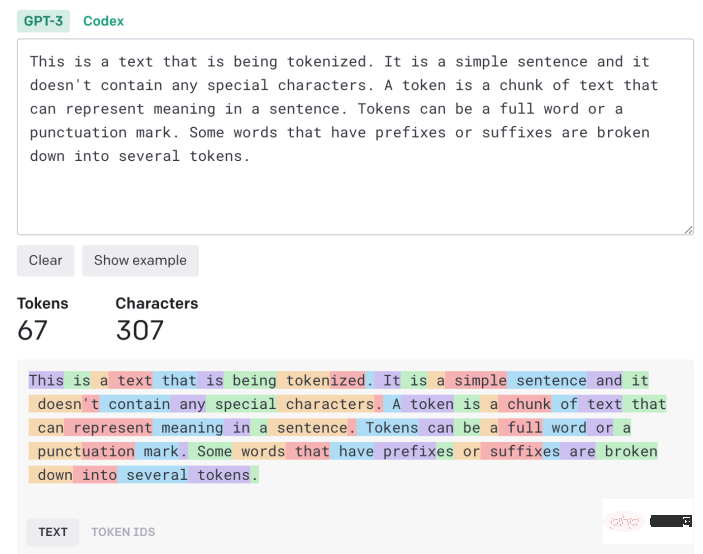

2. Markieren und Einbetten

Eingabetext muss verarbeitet und in ein einheitliches Format konvertiert werden, bevor er in Transformer eingegeben werden kann. Zunächst wird der Text durch einen „Tokenizer“ geleitet, der ihn in einzelne Zeichenblöcke zerlegt, die einzeln verarbeitet werden können. Der Tokenisierungsalgorithmus kann von der Anwendung abhängen. In den meisten Fällen zählt jedes Wort und jedes Satzzeichen ungefähr als ein Token. Einige Suffixe und Präfixe gelten als separate Token (z. B. „ize“, „ly“ und „pre“). Der Tokenizer generiert eine Liste von Zahlen, die die Token-IDs des Eingabetexts darstellen.

Die Token werden dann in „Worteinbettungen“ umgewandelt. Worteinbettung ist ein Vektor, der versucht, den Wert eines Wortes in einem mehrdimensionalen Raum zu erfassen. Beispielsweise können die Wörter „Katze“ und „Hund“ in einigen Dimensionen ähnliche Werte haben, da sie beide in Sätzen über Tiere und Haustiere verwendet werden. In anderen Dimensionen, die Katzen von Hunden unterscheiden, ist „Katze“ jedoch eher „Löwe“ als „Wolf“. Ebenso liegen „Paris“ und „London“ wahrscheinlich näher beieinander, da es sich bei beiden um Städte handelt. Aufgrund der unterschiedlichen Dimensionen eines Landes ist „London“ jedoch näher an „England“ und „Paris“ eher an „Frankreich“. Und Worteinbettungen haben typischerweise Hunderte von Dimensionen.

Worteinbettungen werden über Einbettungsmodelle erstellt, die separat vom Transformer trainiert werden. Es gibt mehrere vorab trainierte Einbettungsmodelle für Sprachaufgaben.

3. Aufmerksamkeitsschicht

Sobald der Satz in eine Liste von Worteinbettungen umgewandelt wurde, wird er in das Encodermodul des Transformers eingespeist. Im Gegensatz zu den Modellen „Recurrent Neural Network“ (RNN) und „Long Short-Term Memory“ (LSTM) empfängt Transformer nicht jeweils eine Eingabe. Es kann Einbettungswerte für ganze Sätze empfangen und parallel verarbeiten. Dies macht Transformers recheneffizienter als ihre Vorgänger und ermöglicht es ihnen außerdem, Textszenarien sowohl in Vorwärts- als auch in Rückwärtssequenzen zu untersuchen.

Um die Reihenfolge der Wörter im Satz beizubehalten, wendet der Transformer eine „Positionskodierung“ an, was im Grunde bedeutet, dass er den Wert jedes Einbettungsvektors ändert, um seine Position im Text darzustellen.

Als nächstes wird die Eingabe an den ersten Encoderblock weitergeleitet, der sie über eine „Aufmerksamkeitsschicht“ verarbeitet. Die Aufmerksamkeitsschicht versucht, die Beziehungen zwischen Wörtern in einem Satz zu erfassen. Betrachten Sie zum Beispiel den Satz „Die große schwarze Katze überquerte die Straße, nachdem ihr eine Flasche auf die Seite gefallen war.“ Hier muss das Modell „it“ mit „cat“ und „its“ mit „bottle“ verknüpfen. Daher sollten weitere Assoziationen entstehen, etwa „groß“ und „Katze“ oder „gekreuzt“ und „Katze“. Andernfalls erhält die Aufmerksamkeitsschicht eine Liste von Worteinbettungen, die einzelne Wortwerte darstellen, und generiert eine Liste von Vektoren, die einzelne Wörter und ihre Beziehungen darstellen. Die Aufmerksamkeitsschicht enthält mehrere „Aufmerksamkeitsköpfe“, von denen jeder unterschiedliche Arten von Beziehungen zwischen Wörtern erfassen kann.

Die Ausgabe der Aufmerksamkeitsschicht wird einem Feedforward-Neuronalen Netzwerk zugeführt, das sie in eine Vektordarstellung umwandelt und an die nächste Aufmerksamkeitsschicht sendet. Transformer

enthalten mehrere Aufmerksamkeitsblöcke und Feedforward-Ebenen, um nach und nach komplexere Zusammenhänge zu erfassen.

Das Decodermodul hat die Aufgabe, die Aufmerksamkeitsvektoren des Encoders in Ausgabedaten (z. B. eine übersetzte Version des Eingabetextes) umzuwandeln. Während der Trainingsphase hat der Decoder Zugriff auf die vom Encoder erzeugten Aufmerksamkeitsvektoren und die erwarteten Ergebnisse (z. B. übersetzte Zeichenfolgen).

Der Decoder verwendet die gleichen Tokenisierungs-, Worteinbettungs- und Aufmerksamkeitsmechanismen, um die erwarteten Ergebnisse zu verarbeiten und Aufmerksamkeitsvektoren zu erstellen. Anschließend werden dieser Aufmerksamkeitsvektor und die Aufmerksamkeitsschicht im Encodermodul übergeben, um eine Beziehung zwischen den Eingabe- und Ausgabewerten herzustellen. In einer Übersetzungsanwendung ist dies der Teil, in dem Wörter in der Ausgangs- und der Zielsprache einander zugeordnet werden. Wie das Encodermodul werden die Aufmerksamkeitsvektoren des Decoders durch Feedforward-Schichten geleitet. Das Ergebnis wird dann auf einen sehr großen Pool an Vektoren abgebildet, d. h. auf die Größe der Zieldaten (im Falle einer Übersetzung kann dies Zehntausende Wörter umfassen). 4. Training Transformer Das Encodermodul empfängt und verarbeitet den vollständigen Eingabestring. Der Decoder empfängt jedoch eine maskierte Version der Ausgabezeichenfolge (ein Wort nach dem anderen) und versucht, eine Zuordnung zwischen dem codierten Aufmerksamkeitsvektor und dem erwarteten Ergebnis herzustellen. Der Encoder versucht, das nächste Wort vorherzusagen und nimmt basierend auf der Differenz zwischen seiner Ausgabe und dem erwarteten Ergebnis Korrekturen vor. Diese Rückmeldung ermöglicht es dem Konverter, die Parameter des Encoders und Decoders zu ändern und nach und nach die richtige Zuordnung zwischen den Eingabe- und Ausgabesprachen zu erstellen.

Je mehr Trainingsdaten und Parameter ein Transformer hat, desto besser ist er in der Lage, Kohärenz und Konsistenz über längere Textsequenzen hinweg aufrechtzuerhalten.

5. Änderungen in Transformer

Im oben untersuchten Beispiel der maschinellen Übersetzung lernt das Encodermodul von Transformer die Beziehung zwischen englischen Wörtern und Sätzen, während der Decoder die Zuordnung zwischen Englisch und Französisch lernt.

Aber nicht alle Transformer-Anwendungen erfordern Encoder- und Decodermodule. Beispielsweise verwendet die GPT-Familie großer Sprachmodelle einen Stapel von Decodermodulen, um Text zu generieren. BERT ist eine weitere Variante des von Google-Forschern entwickelten Transformer-Modells, die jedoch nur das Encoder-Modul verwendet.

Der Vorteil einiger dieser Architekturen besteht darin, dass sie durch selbstüberwachtes Lernen oder unüberwachte Methoden trainiert werden können. BERT beispielsweise führt den Großteil seines Trainings durch, indem es einen großen Korpus unbeschrifteten Textes nimmt, Teile davon ausblendet und versucht, die fehlenden Teile vorherzusagen. Anschließend passt es seine Parameter an, je nachdem, wie nah oder weit seine Vorhersagen von den tatsächlichen Daten entfernt sind. Durch die kontinuierliche Wiederholung dieses Vorgangs erfasst BERT die Beziehung zwischen verschiedenen Wörtern in verschiedenen Szenen. Nach dieser Vortrainingsphase kann BERT für nachgelagerte Aufgaben wie die Beantwortung von Fragen, die Zusammenfassung von Texten oder die Stimmungsanalyse durch Training anhand einer kleinen Anzahl beschrifteter Beispiele verfeinert werden. Der Einsatz von unbeaufsichtigtem und selbstüberwachtem Vortraining kann den Aufwand für die Kommentierung von Trainingsdaten reduzieren.

Es gibt noch viel mehr über Transformers und die neuen Apps, die sie freischalten, was den Rahmen dieses Artikels sprengen würde. Forscher suchen immer noch nach Möglichkeiten, mehr Hilfe von Transformer zu erhalten.

Transformer löste auch Diskussionen über Sprachverständnis und allgemeine künstliche Intelligenz aus. Klar ist, dass der Transformer, wie andere neuronale Netze auch, ein statistisches Modell ist, das in der Lage ist, Regelmäßigkeiten in Daten auf clevere und raffinierte Weise zu erfassen. Obwohl sie Sprache nicht so „verstehen“ wie Menschen, ist ihre Entwicklung dennoch spannend und hat noch viel mehr zu bieten.

Originallink: https://bdtechtalks.com/2022/05/02/what-is-the-transformer/

Das obige ist der detaillierte Inhalt vonWas ist das Machine-Learning-Modell von Transformer?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In den Bereichen maschinelles Lernen und Datenwissenschaft stand die Interpretierbarkeit von Modellen schon immer im Fokus von Forschern und Praktikern. Mit der weit verbreiteten Anwendung komplexer Modelle wie Deep Learning und Ensemble-Methoden ist das Verständnis des Entscheidungsprozesses des Modells besonders wichtig geworden. Explainable AI|XAI trägt dazu bei, Vertrauen in maschinelle Lernmodelle aufzubauen, indem es die Transparenz des Modells erhöht. Eine Verbesserung der Modelltransparenz kann durch Methoden wie den weit verbreiteten Einsatz mehrerer komplexer Modelle sowie der Entscheidungsprozesse zur Erläuterung der Modelle erreicht werden. Zu diesen Methoden gehören die Analyse der Merkmalsbedeutung, die Schätzung des Modellvorhersageintervalls, lokale Interpretierbarkeitsalgorithmen usw. Die Merkmalswichtigkeitsanalyse kann den Entscheidungsprozess des Modells erklären, indem sie den Grad des Einflusses des Modells auf die Eingabemerkmale bewertet. Schätzung des Modellvorhersageintervalls

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Übersetzer |. Rezensiert von Li Rui |. Chonglou Modelle für künstliche Intelligenz (KI) und maschinelles Lernen (ML) werden heutzutage immer komplexer, und die von diesen Modellen erzeugten Ergebnisse sind eine Blackbox, die den Stakeholdern nicht erklärt werden kann. Explainable AI (XAI) zielt darauf ab, dieses Problem zu lösen, indem es Stakeholdern ermöglicht, die Funktionsweise dieser Modelle zu verstehen, sicherzustellen, dass sie verstehen, wie diese Modelle tatsächlich Entscheidungen treffen, und Transparenz in KI-Systemen, Vertrauen und Verantwortlichkeit zur Lösung dieses Problems gewährleistet. In diesem Artikel werden verschiedene Techniken der erklärbaren künstlichen Intelligenz (XAI) untersucht, um ihre zugrunde liegenden Prinzipien zu veranschaulichen. Mehrere Gründe, warum erklärbare KI von entscheidender Bedeutung ist. Vertrauen und Transparenz: Damit KI-Systeme allgemein akzeptiert und vertrauenswürdig sind, müssen Benutzer verstehen, wie Entscheidungen getroffen werden

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

Yolov10: Ausführliche Erklärung, Bereitstellung und Anwendung an einem Ort!

Jun 07, 2024 pm 12:05 PM

1. Einleitung In den letzten Jahren haben sich YOLOs aufgrund ihres effektiven Gleichgewichts zwischen Rechenkosten und Erkennungsleistung zum vorherrschenden Paradigma im Bereich der Echtzeit-Objekterkennung entwickelt. Forscher haben das Architekturdesign, die Optimierungsziele, Datenerweiterungsstrategien usw. von YOLO untersucht und erhebliche Fortschritte erzielt. Gleichzeitig behindert die Verwendung von Non-Maximum Suppression (NMS) bei der Nachbearbeitung die End-to-End-Bereitstellung von YOLO und wirkt sich negativ auf die Inferenzlatenz aus. In YOLOs fehlt dem Design verschiedener Komponenten eine umfassende und gründliche Prüfung, was zu erheblicher Rechenredundanz führt und die Fähigkeiten des Modells einschränkt. Es bietet eine suboptimale Effizienz und ein relativ großes Potenzial zur Leistungsverbesserung. Ziel dieser Arbeit ist es, die Leistungseffizienzgrenze von YOLO sowohl in der Nachbearbeitung als auch in der Modellarchitektur weiter zu verbessern. zu diesem Zweck

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Übertrifft DPO umfassend: Das Team von Chen Danqi schlug eine einfache Präferenzoptimierung (SimPO) vor und verfeinerte außerdem das stärkste 8B-Open-Source-Modell

Jun 01, 2024 pm 04:41 PM

Um große Sprachmodelle (LLMs) an menschlichen Werten und Absichten auszurichten, ist es wichtig, menschliches Feedback zu lernen, um sicherzustellen, dass sie nützlich, ehrlich und harmlos sind. Im Hinblick auf die Ausrichtung von LLM ist Reinforcement Learning basierend auf menschlichem Feedback (RLHF) eine wirksame Methode. Obwohl die Ergebnisse der RLHF-Methode ausgezeichnet sind, gibt es einige Herausforderungen bei der Optimierung. Dazu gehört das Training eines Belohnungsmodells und die anschließende Optimierung eines Richtlinienmodells, um diese Belohnung zu maximieren. Kürzlich haben einige Forscher einfachere Offline-Algorithmen untersucht, darunter die direkte Präferenzoptimierung (Direct Preference Optimization, DPO). DPO lernt das Richtlinienmodell direkt auf der Grundlage von Präferenzdaten, indem es die Belohnungsfunktion in RLHF parametrisiert, wodurch die Notwendigkeit eines expliziten Belohnungsmodells entfällt. Diese Methode ist einfach und stabil

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

Keine OpenAI-Daten erforderlich, schließen Sie sich der Liste der großen Codemodelle an! UIUC veröffentlicht StarCoder-15B-Instruct

Jun 13, 2024 pm 01:59 PM

An der Spitze der Softwaretechnologie kündigte die Gruppe von UIUC Zhang Lingming zusammen mit Forschern der BigCode-Organisation kürzlich das StarCoder2-15B-Instruct-Großcodemodell an. Diese innovative Errungenschaft erzielte einen bedeutenden Durchbruch bei Codegenerierungsaufgaben, übertraf erfolgreich CodeLlama-70B-Instruct und erreichte die Spitze der Codegenerierungsleistungsliste. Die Einzigartigkeit von StarCoder2-15B-Instruct liegt in seiner reinen Selbstausrichtungsstrategie. Der gesamte Trainingsprozess ist offen, transparent und völlig autonom und kontrollierbar. Das Modell generiert über StarCoder2-15B Tausende von Anweisungen als Reaktion auf die Feinabstimmung des StarCoder-15B-Basismodells, ohne auf teure manuelle Annotationen angewiesen zu sein.

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Tsinghua-Universität übernahm und YOLOv10 kam heraus: Die Leistung wurde erheblich verbessert und es stand auf der GitHub-Hotlist

Jun 06, 2024 pm 12:20 PM

Die Benchmark-Zielerkennungssysteme der YOLO-Serie haben erneut ein großes Upgrade erhalten. Seit der Veröffentlichung von YOLOv9 im Februar dieses Jahres wurde der Staffelstab der YOLO-Reihe (YouOnlyLookOnce) in die Hände von Forschern der Tsinghua-Universität übergeben. Letztes Wochenende erregte die Nachricht vom Start von YOLOv10 die Aufmerksamkeit der KI-Community. Es gilt als bahnbrechendes Framework im Bereich Computer Vision und ist für seine End-to-End-Objekterkennungsfunktionen in Echtzeit bekannt. Es führt das Erbe der YOLO-Serie fort und bietet eine leistungsstarke Lösung, die Effizienz und Genauigkeit vereint. Papieradresse: https://arxiv.org/pdf/2405.14458 Projektadresse: https://github.com/THU-MIG/yo