Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Datensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen

Datensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen

Datensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen

arXiv-Artikel „Ithaca365: Dataset and Driving Perception under Repeated and Challenging Weather Conditions“, hochgeladen am 1. August 22, Arbeit von den Universitäten Cornell und Ohio State.

In den letzten Jahren haben sich die Wahrnehmungsfähigkeiten autonomer Fahrzeuge durch den Einsatz großräumiger Datensätze verbessert, die häufig an bestimmten Orten und bei guten Wetterbedingungen gesammelt werden. Um jedoch hohe Sicherheitsanforderungen zu erfüllen, müssen diese Sensorsysteme unter verschiedenen Wetterbedingungen, einschließlich Schnee- und Regenbedingungen, robust funktionieren.

Dieser Artikel schlägt einen Datensatz vor, um mithilfe eines neuen Datenerfassungsprozesses ein robustes autonomes Fahren zu erreichen, d. h. in verschiedenen Szenarien (Stadt, Autobahn, ländliches Gebiet, Campus), Wetter (Schnee, Regen, Sonne), Zeit (Tag). (Nacht) ) und Verkehrsbedingungen (Fußgänger, Radfahrer und Autos) wurden die Daten entlang einer 15 km langen Strecke wiederholt aufgezeichnet.

Dieser Datensatz umfasst Bilder und Punktwolken von Kameras und Lidar-Sensoren sowie hochpräzises GPS/INS, um eine Korrespondenz über Routen hinweg herzustellen. Der Datensatz umfasst Straßen- und Objektanmerkungen, lokale Verdeckungen und 3D-Begrenzungsrahmen, die mit amodalen Masken erfasst wurden.

Wiederholte Pfade eröffnen neue Forschungsrichtungen für die Zielerkennung, kontinuierliches Lernen und die Erkennung von Anomalien.

Ithaca365-Link: Ein neuer Datensatz, der robustes autonomes Fahren über einen neuartigen Datenerfassungsprozess ermöglicht.

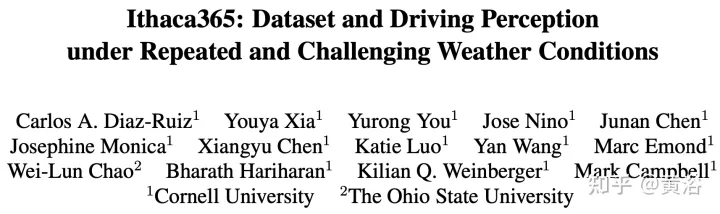

Bild ist die Sensorkonfiguration für die Datenerfassung:

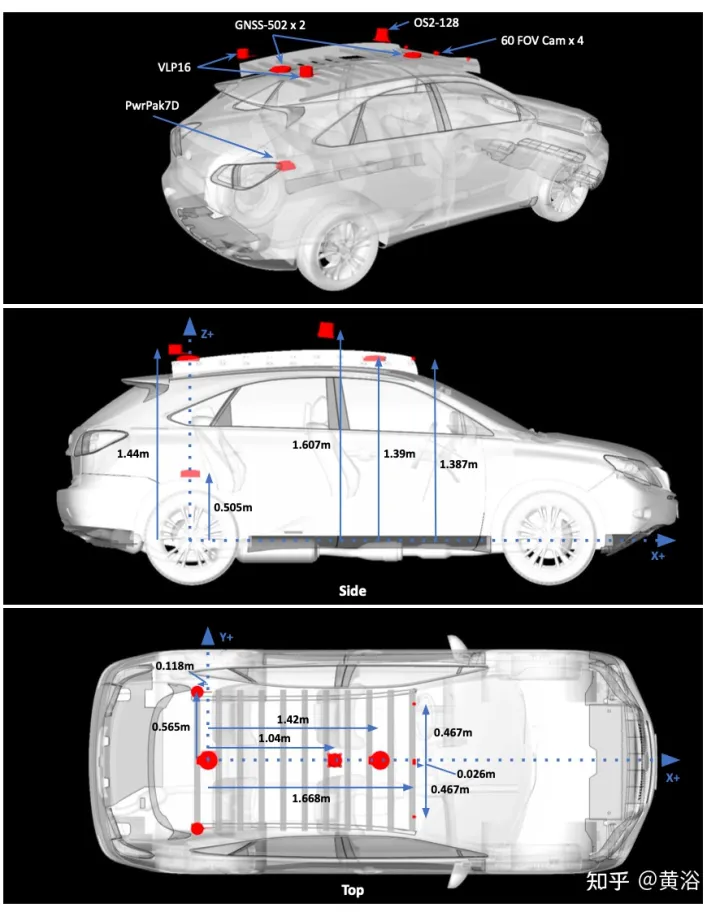

Bild a zeigt die Roadmap mit Aufnahmen an mehreren Standorten. Die Fahrten sollten zu unterschiedlichen Tageszeiten, auch nachts, Daten sammeln. Zeichnen Sie starke Schneeverhältnisse vor und nach der Straßenräumung auf.

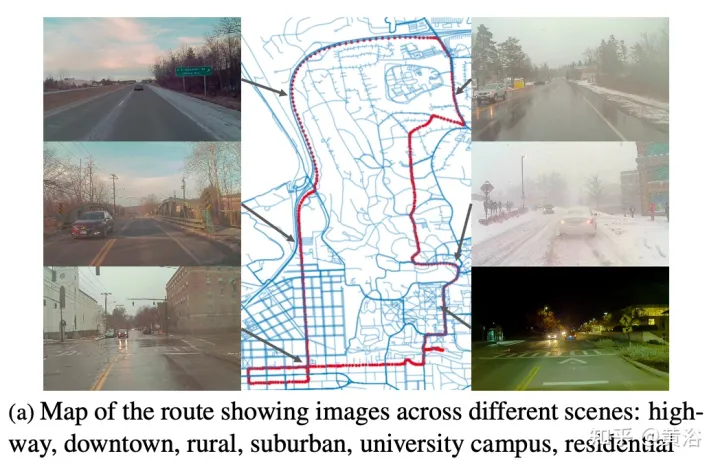

Ein wesentliches Merkmal des Datensatzes ist, dass dieselben Orte unter unterschiedlichen Bedingungen beobachtet werden können; ein Beispiel ist in Abbildung b dargestellt.

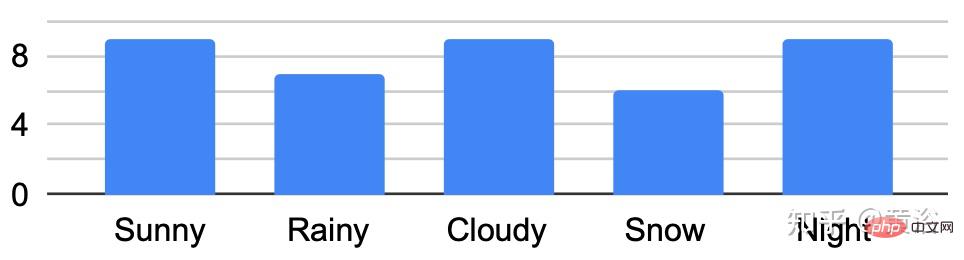

Die Abbildung zeigt die Durchquerungsanalyse unter verschiedenen Bedingungen:

Entwickeln Sie ein benutzerdefiniertes Beschriftungstool zum Erhalten nichtmodaler Masken von Straßen und Zielen. Verwenden Sie für Straßenmarkierungen unter unterschiedlichen Umgebungsbedingungen, z. B. schneebedeckten Straßen, wiederholte Durchquerungen derselben Route. Konkret wandelt die aus GPS-Lage- und LIDAR-Daten erstellte Punktwolken-Straßenkarte die Straßenbezeichnung „gutes Wetter“ in „schlechtes Wetter“ um.

Routen/Daten sind in 76 Intervalle unterteilt. Projizieren Sie die Punktwolke in BEV und beschriften Sie die Straße mit dem Polygon-Annotator. Sobald die Straße in BEV markiert ist (wodurch eine 2D-Straßengrenze generiert wird), wird das Polygon unter Verwendung eines Schwellenwerts von 1,5 m durchschnittlicher Höhe in kleinere 150 m² große Polygone zerlegt und eine ebene Anpassung an den Punkten innerhalb des Polygons durchgeführt Grenze zur Bestimmung der Straßenhöhe.

Passen Sie mithilfe von RANSAC und einem Regressor eine Ebene an diese Punkte an. Berechnen Sie dann die Höhe jedes Punkts entlang der Grenze anhand der geschätzten Grundebene. Projizieren Sie die Straßenpunkte in das Bild und erstellen Sie eine Tiefenmaske, um die nichtmodale Beschriftung der Straße zu erhalten. Durch den Abgleich von Standorten mit markierten Karten mit GPS und die Optimierung von Routen mit ICP kann die Bodenebene auf bestimmte Standorte auf neuen Sammelrouten projiziert werden.

Eine abschließende Überprüfung der ICP-Lösung durch Überprüfung, ob die durchschnittliche projizierte Ground-Truth-Maske der Straßenmarkierung mit allen anderen Ground-Truth-Masken am selben Standort übereinstimmt. Andernfalls werden die Abfragestandortdaten nicht abgerufen.

Amodale Ziele werden mit Scale AI für sechs Vordergrundzielkategorien gekennzeichnet: Autos, Busse, Lastwagen (einschließlich Fracht, Feuerwehrautos, Pickups, Krankenwagen), Fußgänger, Radfahrer und Motorradfahrer.

Dieses Etikettierungsparadigma besteht aus drei Hauptkomponenten: Zuerst werden sichtbare Instanzen eines Objekts identifiziert, dann werden verdeckte Instanzsegmentierungsmasken abgeleitet und schließlich wird die Okklusionsreihenfolge jedes Objekts markiert. Die Markierung erfolgt in der Kameraansicht ganz links nach vorne. Folgt den gleichen Standards wie KINS („Amodale Instanzsegmentierung mit Kins-Datensatz“. CVPR, 2019).

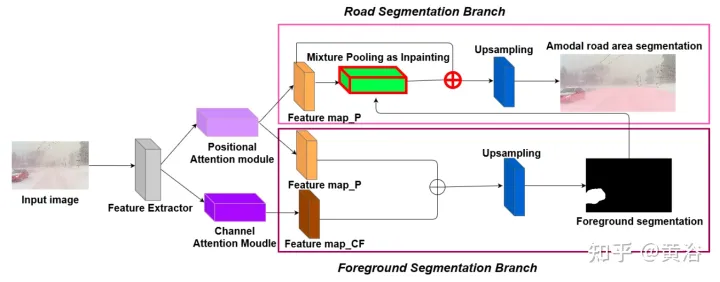

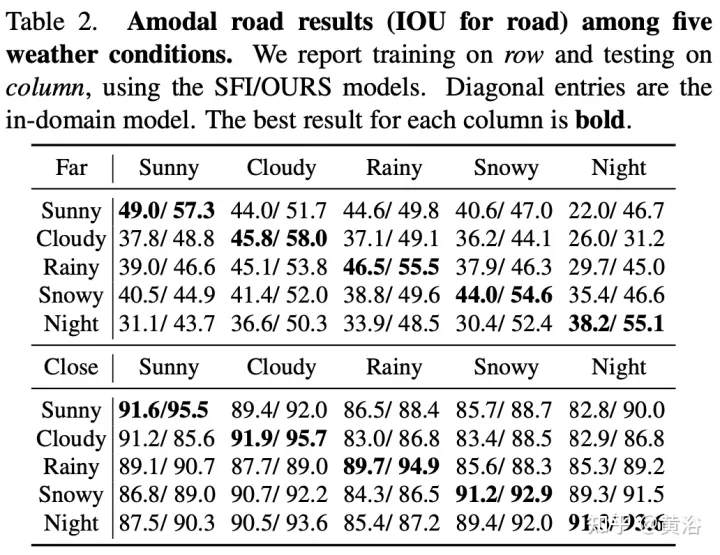

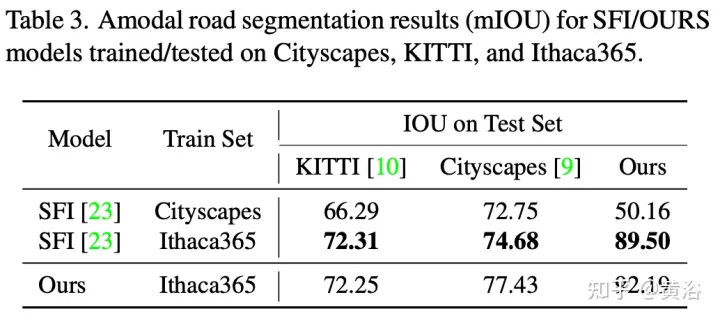

Um die Umweltvielfalt und die amodale Qualität des Datensatzes zu demonstrieren, wurden zwei Basisnetzwerke trainiert und getestet, um amodale Straßen auf Pixelebene zu identifizieren, die auch dann funktionieren, wenn die Straßen mit Schnee oder Autos bedeckt sind. Das erste Basisnetzwerk ist Semantic Foreground Inpainting (SFI). Die zweite Baseline, wie in der Abbildung dargestellt, nutzt die folgenden drei Innovationen, um den SFI zu verbessern.

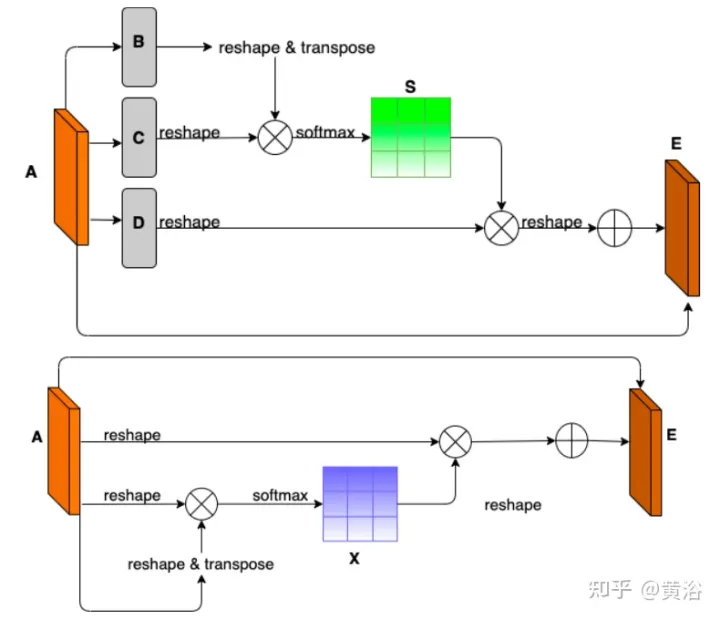

- Position und Kanal Hinweis: Da die amodale Segmentierung hauptsächlich auf das Unsichtbare schließen lässt, ist der Kontext ein sehr wichtiger Anhaltspunkt. DAN („Dual Attention Network for Scene Segmentation“, CVPR’2019) stellt zwei Innovationen vor, um zwei unterschiedliche Hintergründe zu erfassen. Das Position Attention Module (PAM) verwendet Pixelfunktionen, um sich auf andere Pixel des Bildes zu konzentrieren und tatsächlich den Kontext von anderen Teilen des Bildes zu erfassen. Das Channel Attention Module (CAM) verwendet einen ähnlichen Aufmerksamkeitsmechanismus, um Kanalinformationen effizient zu aggregieren. Hier werden diese beiden Module auf den Backbone-Feature-Extraktor angewendet. Kombination von CAM und PAM zur besseren Lokalisierung feiner Maskengrenzen. Die endgültige Vordergrundinstanzmaske wird durch eine Upsampling-Ebene erhalten.

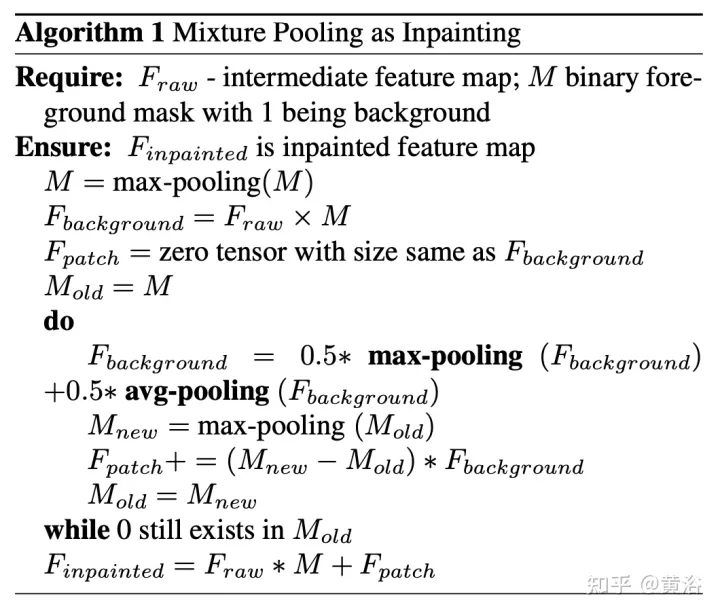

- Hybrides Pooling als Inpainting: Maximales Pooling wird als Inpainting-Vorgang verwendet, um überlappende Vordergrund-Features durch nahegelegene Hintergrund-Features zu ersetzen und so nichtmodale Straßen-Features wiederherzustellen. Da Hintergrundfunktionen jedoch normalerweise gleichmäßig verteilt sind, reagiert der Max-Pooling-Vorgang sehr empfindlich auf zusätzliches Rauschen. Im Gegensatz dazu verringern durchschnittliche Pooling-Vorgänge den Lärm auf natürliche Weise. Zu diesem Zweck werden durchschnittliches Pooling und maximales Pooling zum Patchen kombiniert, was als Mixture Pooling bezeichnet wird.

- Summenoperation: Vor der letzten Upsampling-Schicht werden die Features aus dem Hybrid-Pooling-Modul nicht direkt übergeben, sondern die restlichen Links aus der Ausgabe des PAM-Moduls werden einbezogen. Durch die gemeinsame Optimierung zweier Feature-Maps im Straßensegmentierungszweig kann das PAM-Modul auch Hintergrundfeatures von verdeckten Bereichen lernen. Dies kann zu einer genaueren Wiederherstellung von Hintergrundfunktionen führen.

Das Bild zeigt das Architekturdiagramm von PAM und CAM:

Der Algorithmus-Pseudocode für das Patchen durch Hybrid-Pooling lautet wie folgt:

Der Trainings- und Testcode für die nichtmodale Straßensegmentierung lautet wie folgt folgt: https://github.com/coolgrasshopper/amodal_road_segmentation

Die experimentellen Ergebnisse sind wie folgt:

Das obige ist der detaillierte Inhalt vonDatensätze und Fahrwahrnehmung bei sich wiederholenden und herausfordernden Wetterbedingungen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Smart App Control unter Windows 11: So aktivieren oder deaktivieren Sie es

Jun 06, 2023 pm 11:10 PM

Intelligent App Control ist ein sehr nützliches Tool in Windows 11, das dabei hilft, Ihren PC vor nicht autorisierten Apps zu schützen, die Ihre Daten beschädigen können, wie z. B. Ransomware oder Spyware. In diesem Artikel wird erklärt, was Smart App Control ist, wie es funktioniert und wie man es in Windows 11 ein- oder ausschaltet. Was ist Smart App Control in Windows 11? Smart App Control (SAC) ist eine neue Sicherheitsfunktion, die mit dem Windows 1122H2-Update eingeführt wurde. Es arbeitet mit Microsoft Defender oder Antivirensoftware von Drittanbietern zusammen, um potenziell unnötige Apps zu blockieren, die Ihr Gerät verlangsamen, unerwartete Werbung anzeigen oder andere unerwartete Aktionen ausführen können. Intelligente Anwendung

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Mit solch einer mächtigen KI-Imitationsfähigkeit ist es wirklich unmöglich, dies zu verhindern. Hat die Entwicklung der KI mittlerweile dieses Niveau erreicht? Ihr vorderer Fuß lässt Ihre Gesichtszüge fliegen, und auf Ihrem hinteren Fuß wird genau der gleiche Ausdruck reproduziert. Starren, Augenbrauen hochziehen, schmollen, egal wie übertrieben der Ausdruck ist, alles wird perfekt nachgeahmt. Erhöhen Sie den Schwierigkeitsgrad, heben Sie die Augenbrauen höher, öffnen Sie die Augen weiter, und sogar die Mundform ist schief und der Ausdruck des Avatars kann perfekt reproduziert werden. Wenn Sie die Parameter auf der linken Seite anpassen, ändert der virtuelle Avatar auf der rechten Seite auch seine Bewegungen entsprechend, um eine Nahaufnahme von Mund und Augen zu erhalten. Man kann nicht sagen, dass die Nachahmung genau gleich ist, aber der Ausdruck ist genau derselbe gleich (ganz rechts). Die Forschung stammt von Institutionen wie der Technischen Universität München, die GaussianAvatars vorschlägt

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

MotionLM: Sprachmodellierungstechnologie für die Bewegungsvorhersage mit mehreren Agenten

Oct 13, 2023 pm 12:09 PM

Dieser Artikel wird mit Genehmigung des öffentlichen Kontos von Autonomous Driving Heart nachgedruckt. Bitte wenden Sie sich für den Nachdruck an die Quelle. Originaltitel: MotionLM: Multi-Agent Motion Forecasting as Language Modeling Papierlink: https://arxiv.org/pdf/2309.16534.pdf Autorenzugehörigkeit: Waymo Konferenz: ICCV2023 Papieridee: Für die Sicherheitsplanung autonomer Fahrzeuge das zukünftige Verhalten zuverlässig vorhersagen der Straßenverkehrsbeamten ist von entscheidender Bedeutung. Diese Studie stellt kontinuierliche Trajektorien als Sequenzen diskreter Bewegungstokens dar und behandelt die Bewegungsvorhersage mit mehreren Agenten als eine Sprachmodellierungsaufgabe. Das von uns vorgeschlagene Modell MotionLM hat die folgenden Vorteile: Erstens

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Wussten Sie, dass es bei Programmierern in ein paar Jahren einen Niedergang geben wird?

Nov 08, 2023 am 11:17 AM

Die Zeitschrift „ComputerWorld“ schrieb einmal in einem Artikel, dass „die Programmierung bis 1960 verschwinden wird“, weil IBM eine neue Sprache FORTRAN entwickelt hat, die es Ingenieuren ermöglicht, die benötigten mathematischen Formeln zu schreiben und sie dann dem Computer zu übermitteln, damit das Programmieren endet. Ein paar Jahre später hörten wir ein neues Sprichwort: Jeder Unternehmer kann Geschäftsbegriffe verwenden, um seine Probleme zu beschreiben und dem Computer zu sagen, was er tun soll. Mit dieser Programmiersprache namens COBOL brauchen Unternehmen keine Programmierer mehr. Später soll IBM eine neue Programmiersprache namens RPG entwickelt haben, mit der Mitarbeiter Formulare ausfüllen und Berichte erstellen können, sodass die meisten Programmieranforderungen des Unternehmens damit erfüllt werden können.

Implementierung von OpenAI CLIP für benutzerdefinierte Datensätze

Sep 14, 2023 am 11:57 AM

Implementierung von OpenAI CLIP für benutzerdefinierte Datensätze

Sep 14, 2023 am 11:57 AM

Im Januar 2021 kündigte OpenAI zwei neue Modelle an: DALL-E und CLIP. Bei beiden Modellen handelt es sich um multimodale Modelle, die Text und Bilder auf irgendeine Weise verbinden. Der vollständige Name von CLIP lautet Contrastive Language-Image Pre-training (ContrastiveLanguage-ImagePre-training), eine Vortrainingsmethode, die auf kontrastierenden Text-Bild-Paaren basiert. Warum CLIP einführen? Denn die derzeit beliebte StableDiffusion ist kein einzelnes Modell, sondern besteht aus mehreren Modellen. Eine der Schlüsselkomponenten ist der Text-Encoder, der zur Codierung der Texteingabe des Benutzers verwendet wird. Dieser Text-Encoder ist der Text-Encoder CL im CLIP-Modell.

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der intelligente universelle humanoide Roboter GR-1 Fourier steht kurz vor dem Vorverkaufsstart!

Sep 27, 2023 pm 08:41 PM

Der humanoide Roboter, der 1,65 Meter groß ist, 55 Kilogramm wiegt und über 44 Freiheitsgrade in seinem Körper verfügt, kann schnell gehen, Hindernissen schnell ausweichen, Steigungen stetig hinauf und hinunter klettern und Stößen und Störungen standhalten. Jetzt können Sie ihn mit nach Hause nehmen ! Der universelle humanoide Roboter GR-1 von Fourier Intelligence hat mit dem Vorverkauf begonnen. Der universelle humanoide Roboter Fourier GR-1 ist jetzt zum Vorverkauf geöffnet. GR-1 verfügt über eine hochgradig bionische Rumpfkonfiguration und anthropomorphe Bewegungssteuerung. Er verfügt über 44 Freiheitsgrade im gesamten Körper. Er verfügt über die Fähigkeit zu gehen, Hindernissen auszuweichen, über Hindernisse zu klettern, Abhänge zu überwinden, Störungen zu widerstehen und sich anzupassen Es handelt sich um ein allgemeines künstliches Intelligenzsystem. Offizielle Vorverkaufsseite der Website: www.fftai.cn/order#FourierGR-1# Fourier Intelligence muss neu geschrieben werden.

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

Was sind die effektiven Methoden und gängigen Basismethoden für die Vorhersage der Fußgängerbahn? Teilen der besten Konferenzbeiträge!

Oct 17, 2023 am 11:13 AM

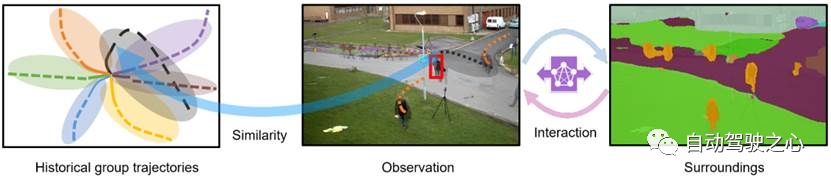

Die Flugbahnvorhersage stand in den letzten zwei Jahren im Rampenlicht, aber das meiste davon konzentriert sich auf die Richtung der Fahrzeugflugbahnvorhersage. Heute wird Autonomous Driving Heart den Algorithmus für die Flugbahnvorhersage von Fußgängern auf NeurIPS – SHENet teilen. Menschliche Bewegungsmuster unterliegen in der Regel bis zu einem gewissen Grad begrenzten Regeln. Basierend auf dieser Annahme sagt SHENet die zukünftige Flugbahn einer Person voraus, indem es implizite Szenenregeln lernt. Der Artikel wurde von Autonomous Driving Heart als Original zertifiziert! Nach persönlichem Verständnis des Autors ist die Vorhersage der zukünftigen Flugbahn einer Person aufgrund der Zufälligkeit und Subjektivität menschlicher Bewegungen derzeit immer noch ein herausforderndes Problem. Allerdings variieren menschliche Bewegungsmuster in eingeschränkten Szenen häufig aufgrund von Szenenbeschränkungen (z. B. Grundrissen, Straßen und Hindernissen) und der Interaktivität von Mensch zu Mensch oder Mensch zu Objekt.