Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Große Modelle geben eine genaue Rückmeldung an kleine Modelle, und die Wissensdestillation trägt dazu bei, die Leistung des KI-Algorithmus zu verbessern.

Große Modelle geben eine genaue Rückmeldung an kleine Modelle, und die Wissensdestillation trägt dazu bei, die Leistung des KI-Algorithmus zu verbessern.

Große Modelle geben eine genaue Rückmeldung an kleine Modelle, und die Wissensdestillation trägt dazu bei, die Leistung des KI-Algorithmus zu verbessern.

01 Hintergrund der Geburt der Wissensdestillation

Seitdem haben tiefe neuronale Netze (DNN) sowohl in der Industrie als auch in der Wissenschaft große Erfolge erzielt, insbesondere bei Computer-Vision-Aufgaben. Der Erfolg von Deep Learning ist größtenteils auf seine skalierbare Architektur zur Kodierung von Daten mit Milliarden von Parametern zurückzuführen. Sein Trainingsziel besteht darin, die Beziehung zwischen Eingaben und Ausgaben anhand eines vorhandenen Trainingsdatensatzes zu modellieren die Menge und Qualität der gekennzeichneten Trainingsdaten.

Im Vergleich zu herkömmlichen Algorithmen im Bereich Computer Vision verfügen die meisten DNN-basierten Modelle aufgrund der „Überparametrisierung“ über starke Verallgemeinerungsfähigkeiten. Diese Verallgemeinerungsfähigkeit spiegelt sich in allen Dateneingaben zu einem bestimmten Problem wider. Das Modell kann bessere Vorhersageergebnisse liefern, unabhängig davon, ob es sich um Trainingsdaten, Testdaten oder unbekannte Daten handelt, die zum Problem gehören. Um den Vorhersageeffekt von Geschäftsalgorithmen zu verbessern, haben Algorithmeningenieure im aktuellen Kontext des Deep Learning häufig zwei Lösungen:

Verwenden Sie komplexere Netzwerke, die parametrisiert sind. Diese Art von Netzwerk verfügt über sehr starke Lernfähigkeiten, erfordert jedoch Eine große Menge erfordert mehr Rechenressourcen für das Training und die Inferenzgeschwindigkeit ist langsamer.

Ensemble-Modell integriert viele Modelle mit schwächeren Effekten, normalerweise einschließlich der Integration von Parametern und der Integration von Ergebnissen.

Diese beiden Lösungen können die Leistung bestehender Algorithmen erheblich verbessern, aber beide vergrößern den Maßstab des Modells, erzeugen einen größeren Rechenaufwand und erfordern große Rechen- und Speicherressourcen.

Bei der Arbeit besteht das ultimative Ziel verschiedener Algorithmusmodelle darin,

eine bestimmte Anwendung zu bedienen. Genau wie beim Kauf und Verkauf müssen wir unsere Einnahmen und Ausgaben kontrollieren. Bei industriellen Anwendungen müssen Modelle nicht nur über gute Vorhersagen verfügen, sondern auch der Einsatz von Rechenressourcen muss streng kontrolliert werden. Man kann nicht nur Ergebnisse berücksichtigen, ohne die Effizienz zu berücksichtigen. Im Bereich Computer Vision, wo die Menge der Eingabedatenkodierung hoch ist, sind die Rechenressourcen noch begrenzter und die Ressourcenbelegung des Steuerungsalgorithmus ist noch wichtiger. Im Allgemeinen liefern größere Modelle bessere Vorhersageergebnisse, aber die Probleme einer langen Trainingszeit und einer langsamen Inferenzgeschwindigkeit erschweren die Bereitstellung des Modells in Echtzeit. Insbesondere bei Geräten mit begrenzten Rechenressourcen, wie z. B. Videoüberwachung, selbstfahrenden Autos und Cloud-Umgebungen mit hohem Durchsatz, reicht die Reaktionsgeschwindigkeit offensichtlich nicht aus. Obwohl kleinere Modelle eine schnellere Inferenzgeschwindigkeit aufweisen, sind der Inferenzeffekt und die Generalisierungsleistung aufgrund unzureichender Parameter möglicherweise nicht so gut. Die Abwägung großer und kleiner Modelle war schon immer ein heißes Thema. Die meisten aktuellen Lösungen bestehen darin, ein DNN-Modell geeigneter Größe basierend auf der Leistung des Endgeräts in der Bereitstellungsumgebung auszuwählen.

Wenn wir ein kleineres Modell haben möchten, das den gleichen oder einen ähnlichen Effekt wie das große Modell erzielen und gleichzeitig eine schnelle Inferenzgeschwindigkeit beibehalten kann, wie können wir das tun?Beim maschinellen Lernen gehen wir oft davon aus, dass es eine potenzielle Zuordnungsfunktionsbeziehung zwischen Eingabe und Ausgabe gibt. Das Erlernen eines neuen Modells von Grund auf ist eine annähernd unbekannte Zuordnungsfunktion zwischen den Eingabedaten und der entsprechenden Bezeichnung. Unter der Voraussetzung, dass die Eingabedaten unverändert bleiben, ist es aus empirischer Sicht schwierig, ein kleines Modell von Grund auf zu trainieren, um die Wirkung eines großen Modells zu erreichen. Um die Leistung kleiner Modellalgorithmen zu verbessern, besteht im Allgemeinen der effektivste Weg darin, mehr Eingabedaten zu kennzeichnen, dh mehr Überwachungsinformationen bereitzustellen, wodurch die erlernte Zuordnungsfunktion robuster und leistungsfähiger werden kann. Um zwei Beispiele zu nennen: Im Bereich Computer Vision kann die Instanzsegmentierungsaufgabe die Wirkung der Zielbegrenzungsrahmenerkennung verbessern, indem sie zusätzliche Maskeninformationen bereitstellt. Die Übertragungslernaufgabe kann neue Aufgaben erheblich verbessern, indem sie ein vorab trainiertes Modell auf einem größeren Modell bereitstellt Datensatz. Vorhersageeffekt. Daher kann die Bereitstellung weiterer Überwachungsinformationen der Schlüssel zur Verringerung der Kluft zwischen Modellen im kleinen Maßstab und Modellen im großen Maßstab sein.

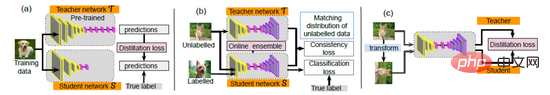

Nach dem, was zuvor gesagt wurde, bedeutet der Erhalt von mehr Aufsichtsinformationen die Kennzeichnung von mehr Trainingsdaten, was oft mit enormen Kosten verbunden ist. Gibt es also eine kostengünstige und effiziente Methode, um Aufsichtsinformationen zu erhalten? Der Artikel aus dem Jahr 2006 [1] wies darauf hin, dass das neue Modell so gestaltet werden kann, dass es sich dem ursprünglichen Modell annähert (das Modell ist eine Funktion). Da die Funktion des Originalmodells bekannt ist, werden beim Training des neuen Modells natürlich mehr Überwachungsinformationen hinzugefügt, was offensichtlich praktikabler ist. Wenn man weiter darüber nachdenkt, können die vom Originalmodell bereitgestellten Überwachungsinformationen unterschiedliche Wissensdimensionen enthalten. Diese einzigartigen Informationen werden möglicherweise nicht vom neuen Modell selbst erfasst. Dies ist in gewissem Maße auch ein Problem für das neue Modell. „Domänenübergreifendes“ Lernen.Im Jahr 2015 folgte Hinton der Idee der Annäherung in der Arbeit „Destillieren des Wissens in einem neuronalen Netzwerk“ [2] und übernahm die Führung beim Vorschlag des Konzepts „Wissensdestillation (KD)“: Sie können zuerst trainieren ein großes und starkes Modell und überträgt dann das darin enthaltene Wissen auf das kleinere Modell, wodurch der Zweck erreicht wird, „die schnellere Inferenzgeschwindigkeit des kleinen Modells beizubehalten und gleichzeitig einen Effekt zu erzielen, der dem des großen Modells entspricht oder diesem nahe kommt“. Das zuerst trainierte große Modell kann als Lehrermodell bezeichnet werden, und das später trainierte kleine Modell wird als Schülermodell bezeichnet. Der gesamte Trainingsprozess kann anschaulich mit dem „Lehrer-Schüler-Lernen“ verglichen werden. In den folgenden Jahren kam es zu einer umfangreichen Wissensdestillation und einer Lehrer-Schüler-Lernarbeit, die der Branche weitere neue Lösungen lieferte. Derzeit wird KD in zwei verschiedenen Bereichen häufig eingesetzt: Modellkomprimierung und Wissenstransfer [3].

02 Wissensdestillation

Einführung

Wissensdestillation ist eine Modellkomprimierungsmethode, die auf der Idee des „Lehrer-Schüler-Netzwerks“ basiert und aufgrund ihrer Einfachheit und Wirksamkeit in der Branche weit verbreitet ist . Sein Zweck besteht darin, das im trainierten großen Modell – Distill (Distill) – enthaltene Wissen in ein anderes kleines Modell zu extrahieren. Wie kann man also das Wissen oder die Generalisierungsfähigkeit des großen Modells auf das kleine Modell übertragen? Das KD-Papier stellt den Wahrscheinlichkeitsvektor der Stichprobenausgabe des großen Modells dem kleinen Modell als weiches Ziel zur Verfügung, sodass die Ausgabe des kleinen Modells versucht, sich auf dieses weiche Ziel zu verlassen (ursprünglich beruhte es auf One-Hot-Codierung). Nähern Sie sich dem Lernen großer Modellverhalten an.

Im traditionellen Hard-Label-Trainingsprozess werden alle negativen Labels einheitlich behandelt, aber diese Methode trennt die Beziehung zwischen Kategorien. Wenn Sie beispielsweise handgeschriebene Ziffern erkennen möchten, sehen einige Bilder mit der gleichen Beschriftung wie „3“ möglicherweise eher wie „8“ aus, und andere sehen möglicherweise eher wie „2“ aus. Harte Beschriftungen können diese Informationen jedoch nicht unterscheiden. trainiertes großes Modell kann ausgeben. Die Ausgabe der Softmax-Schicht des großen Modells enthält neben positiven Beispielen auch viele Informationen. Beispielsweise ist die Wahrscheinlichkeit, die einigen negativen Etiketten entspricht, viel größer als bei anderen negativen Etiketten. Das Verhalten des ungefähren Lernens ermöglicht es, dass jede Stichprobe mehr Informationen in das Studentennetzwerk einbringt als herkömmliche Trainingsmethoden.

Daher hat der Autor die Verlustfunktion beim Training des Studentennetzwerks geändert, sodass das kleine Modell nicht nur an die Grundwahrheitsbezeichnung der Trainingsdaten, sondern auch an die Wahrscheinlichkeitsverteilung der Ausgabe des großen Modells angepasst werden kann. Diese Methode wird Wissensdestillationstraining (KD-Training) genannt. Die im Wissensdestillationsprozess verwendeten Trainingsbeispiele können dieselben sein wie die, die zum Training des großen Modells verwendet wurden, oder es kann ein unabhängiger Transfersatz gefunden werden.

Detaillierte Erläuterung der Methode

Detaillierte Erläuterung der Methode

Konkret verwendet die Wissensdestillation das Lehrer-Schüler-Modell, bei dem der Lehrer die Ausgabe von „Wissen“ und der Schüler der Empfänger von „Wissen“ ist. Der Prozess der Wissensdestillation gliedert sich in 2 Stufen:

- Lehrermodell-Training:

- Das als Net-T bezeichnete „Lehrermodell“ zeichnet sich durch ein relativ komplexes Modell aus, das auch aus mehreren separat trainierten Modellen integriert werden kann Modelle werden. Es gibt keine Einschränkungen hinsichtlich der Modellarchitektur, der Parametermenge oder der Integration für das „Teacher-Modell“, da das Modell nicht bereitgestellt werden muss. Die einzige Voraussetzung ist, dass es für die Eingabe X Y ausgeben kann, wobei Y abgebildet wird Softmax und die Ausgabe Die Werte entsprechen den Wahrscheinlichkeitswerten der entsprechenden Kategorien. Studentenmodelltraining:

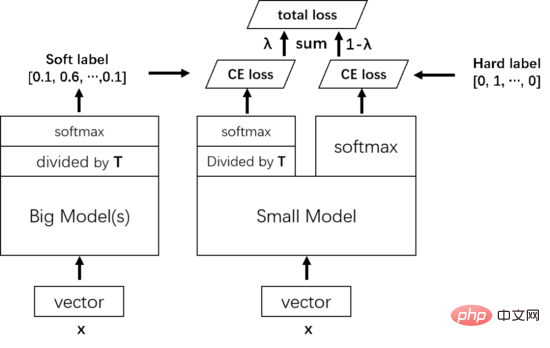

- Trainieren Sie das „Studentenmodell“, genannt Net-S, bei dem es sich um ein einzelnes Modell mit einer kleinen Anzahl von Parametern und einer relativ einfachen Modellstruktur handelt. In ähnlicher Weise kann für die Eingabe X Y ausgegeben werden, und Y kann nach der Softmax-Zuordnung auch den Wahrscheinlichkeitswert ausgeben, der der entsprechenden Kategorie entspricht. Da die Ergebnisse des Netzwerks mit Softmax leicht ins Extreme gehen können, ist das Vertrauen einer bestimmten Klasse extrem hoch und das Vertrauen anderer Klassen ist zu diesem Zeitpunkt sehr gering Das Modell, auf das geachtet wird, gehört möglicherweise immer noch nur zu einer bestimmten Klasse. Da außerdem verschiedene Kategorien negativer Informationen ebenfalls eine relative Bedeutung haben, ist es nicht gut, wenn alle negativen Bewertungen ähnlich sind, und kann den Zweck der Wissensdestillation nicht erreichen. Um dieses Problem zu lösen, wird das Konzept der Temperatur (Temperatur) eingeführt und eine hohe Temperatur verwendet, um die Informationen herauszudestillieren, die in kleinen Wahrscheinlichkeitswerten enthalten sind. Insbesondere werden Logits durch die Temperatur T dividiert, bevor sie die Softmax-Funktion durchlaufen.

Während des Trainings wird das vom Lehrermodell erlernte Wissen zunächst auf das kleine Modell destilliert. Insbesondere wird für Probe X zunächst die vorletzte Schicht des großen Modells durch eine Temperatur T dividiert und dann ein weiches Ziel durch Softmax vorhergesagt. Das kleine Modell teilt ebenfalls die vorletzte Schicht durch die gleiche Temperatur T, sagt dann ein Ergebnis über Softmax voraus und verwendet dann die Kreuzentropie dieses Ergebnisses und des weichen Ziels als Teil des Gesamttrainingsverlusts. Dann wird die Kreuzentropie der normalen Ausgabe des kleinen Modells und der wahren Wertbezeichnung (hartes Ziel) als weiterer Teil des Gesamtverlusts des Trainings verwendet. Der Gesamtverlust gewichtet die beiden Verluste zusammen als endgültigen Verlust für das Training des kleinen Modells.

Wenn das kleine Modell trainiert ist und vorhergesagt werden muss, ist die Temperatur T nicht mehr erforderlich und kann direkt gemäß dem herkömmlichen Softmax ausgegeben werden.

03 FitNet

Einführung

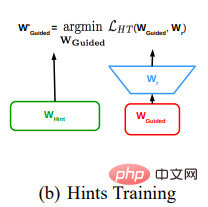

Das FitNet-Papier führt während der Destillation Hinweise für Fortgeschrittene ein, um das Training von Schülermodellen zu leiten. Verwenden Sie ein breites und flaches Lehrermodell, um ein schmales und tiefes Schülermodell zu trainieren. Bei der Durchführung von Hinweisen wird vorgeschlagen, eine Ebene zu verwenden, um die Ausgabeformen der Hinweisebene und der geführten Ebene abzugleichen. Dies wird in der Arbeit zukünftiger Generationen häufig als Anpassungsebene bezeichnet.

Im Allgemeinen entspricht dies der Verwendung nicht nur der Logit-Ausgabe des Lehrermodells, sondern auch der Feature-Map der mittleren Ebene des Lehrermodells als Aufsichtsinformationen bei der Wissensdestillation. Man kann sich vorstellen, dass es für kleine Modelle zu schwierig ist, große Modelle am Ausgabeende direkt zu imitieren (je tiefer das Modell, desto schwieriger ist es zu trainieren und es ist ziemlich ermüdend, die letzte Schicht von Überwachungssignalen zu übertragen). Es ist besser, in der Mitte einige Überwachungssignale hinzuzufügen, damit das Modell während des Trainings Schicht für Schicht lernen kann, anstatt die schwierigste Zuordnungsfunktion direkt zu lernen. Außerdem beschleunigt die Hinweisführung die Konvergenz Das Finden besserer lokaler Minima bei einem nichtkonvexen Problem ermöglicht eine tiefere und schnellere Ausbildung des Studentennetzwerks. Unser Ziel scheint es zu sein, den Schülern die Möglichkeit zu geben, Fragen zur College-Aufnahmeprüfung zu beantworten. Deshalb bringen wir ihnen zunächst die Fragen für die Mittelstufe bei (lassen Sie das kleine Modell zunächst die erste Hälfte des Modells verwenden, um zu lernen, die zugrunde liegenden Merkmale des Bildes zu extrahieren). und kehren Sie dann zum ursprünglichen Zweck zurück, um Fragen zur Hochschulaufnahmeprüfung zu lernen (verwenden Sie KD, um alle Parameter des kleinen Modells anzupassen).

Dieser Artikel ist der Vorfahre der vorgeschlagenen Destillations-Zwischenmerkmalskarte. Der vorgeschlagene Algorithmus ist sehr einfach, aber die Idee ist bahnbrechend.

Detaillierte Erläuterung der Methode

Die spezifische Methode von FitNets ist:

- Bestimmen Sie das Lehrernetzwerk und trainieren Sie es ausgereift, um den Hinweis der mittleren Merkmalsschicht des Lehrernetzwerks zu extrahieren.

- Richten Sie das Schülernetzwerk ein Dieses Netzwerk ist im Allgemeinen enger und tiefer als das Lehrernetzwerk. Das Schülernetzwerk wird so trainiert, dass die Zwischenmerkmalsschichten des Schülernetzwerks mit den Hinweisen des Lehrermodells übereinstimmen. Da die mittlere Merkmalsschicht des Schülernetzwerks und die Hinweisgröße des Lehrers unterschiedlich sind, muss nach der mittleren Merkmalsschicht des Schülernetzwerks ein Regressor hinzugefügt werden, um die Merkmalsdimensionalität zu verbessern und sie an die Größe der Hinweisschicht anzupassen. Die vom Regressor transformierte Verlustfunktion, die mit der Hinweisschicht des Lehrernetzwerks und der Zwischenmerkmalsschicht des Schülernetzwerks übereinstimmt, ist die mittlere quadratische Fehlerverlustfunktion.

Im tatsächlichen Training wird es häufig in Verbindung mit dem KD-Training im vorherigen Abschnitt verwendet, wobei eine zweistufige Trainingsmethode verwendet wird: Verwenden Sie zunächst das Hinweistraining, um die Parameter der ersten Hälfte des kleinen Modells vorab zu trainieren, und verwenden Sie sie dann KD-Training zum Trainieren aller Parameter. Da im Destillationsprozess mehr Überwachungsinformationen verwendet werden, ist die auf der Zwischenmerkmalskarte basierende Destillationsmethode leistungsfähiger als die auf den Ergebnisprotokollen basierende Destillationsmethode, die Trainingszeit ist jedoch länger.

04 Zusammenfassung

Wissensdestillation ist sehr effektiv, um Wissen von Ensembles oder von stark regulierten großen Modellen auf kleinere Modelle zu übertragen. Die Destillation funktioniert auch dann sehr gut, wenn Daten für eine oder mehrere Klassen im Migrationsdatensatz fehlen, der zum Trainieren des Destillationsmodells verwendet wird. Nachdem die Klassiker KD und FitNet vorgeschlagen wurden, entstanden verschiedene Destillationsmethoden. Wir hoffen, in Zukunft auch weitere Untersuchungen in den Bereichen Modellkomprimierung und Wissenstransfer durchführen zu können.

Über den Autor

Ma Jialiang ist leitender Computer-Vision-Algorithmus-Ingenieur bei NetEase Yidun. Er ist hauptsächlich für die Forschung, Entwicklung, Optimierung und Innovation von Computer-Vision-Algorithmen im Bereich der Inhaltssicherheit verantwortlich.

Das obige ist der detaillierte Inhalt vonGroße Modelle geben eine genaue Rückmeldung an kleine Modelle, und die Wissensdestillation trägt dazu bei, die Leistung des KI-Algorithmus zu verbessern.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

So stellen Sie die Zeitüberschreitung von Vue Axios fest

Apr 07, 2025 pm 10:03 PM

Um die Zeitüberschreitung für Vue Axios festzulegen, können wir eine Axios -Instanz erstellen und die Zeitleitungsoption angeben: in globalen Einstellungen: vue.Prototyp. $ Axios = axios.create ({Timeout: 5000}); In einer einzigen Anfrage: this. $ axios.get ('/api/user', {timeout: 10000}).

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

So optimieren Sie die Datenbankleistung nach der MySQL -Installation

Apr 08, 2025 am 11:36 AM

Die MySQL -Leistungsoptimierung muss von drei Aspekten beginnen: Installationskonfiguration, Indexierung und Abfrageoptimierung, Überwachung und Abstimmung. 1. Nach der Installation müssen Sie die my.cnf -Datei entsprechend der Serverkonfiguration anpassen, z. 2. Erstellen Sie einen geeigneten Index, um übermäßige Indizes zu vermeiden und Abfrageanweisungen zu optimieren, z. B. den Befehl Erklärung zur Analyse des Ausführungsplans; 3. Verwenden Sie das eigene Überwachungstool von MySQL (ShowProcessList, Showstatus), um die Datenbankgesundheit zu überwachen und die Datenbank regelmäßig zu sichern und zu organisieren. Nur durch kontinuierliche Optimierung dieser Schritte kann die Leistung der MySQL -Datenbank verbessert werden.

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der Hauptschlüssel von MySQL kann null sein

Apr 08, 2025 pm 03:03 PM

Der MySQL -Primärschlüssel kann nicht leer sein, da der Primärschlüssel ein Schlüsselattribut ist, das jede Zeile in der Datenbank eindeutig identifiziert. Wenn der Primärschlüssel leer sein kann, kann der Datensatz nicht eindeutig identifiziert werden, was zu Datenverwirrung führt. Wenn Sie selbstsinkrementelle Ganzzahlsspalten oder UUIDs als Primärschlüssel verwenden, sollten Sie Faktoren wie Effizienz und Raumbelegung berücksichtigen und eine geeignete Lösung auswählen.