Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

PyTorch wird an die Linux Foundation übertragen, was erhebliche Auswirkungen auf die KI-Forschung haben wird

PyTorch wird an die Linux Foundation übertragen, was erhebliche Auswirkungen auf die KI-Forschung haben wird

PyTorch wird an die Linux Foundation übertragen, was erhebliche Auswirkungen auf die KI-Forschung haben wird

Kürzlich gab PyTorch-Gründer Soumith Chintala auf der offiziellen Website von PyTorch bekannt, dass PyTorch als Top-Level-Projekt offiziell an die Linux Foundation (LF) mit dem Namen PyTorch Foundation übertragen wird.

PyTorch wurde im Januar 2017 geboren und von Facebook Artificial Intelligence Research (FAIR) ins Leben gerufen. Es handelt sich um eine Python-Open-Source-Bibliothek für maschinelles Lernen, die auf Torch basiert und für Anwendungen wie die Verarbeitung natürlicher Sprache verwendet werden kann. Als eines der beliebtesten Frameworks für maschinelles Lernen hat PyTorch derzeit mehr als 2.400 Mitwirkende und fast 154.000 Projekte basieren auf PyTorch.

Die Kernaufgabe der Linux Foundation ist die gemeinsame Entwicklung von Open-Source-Software. Die Mitglieder des Verwaltungsausschusses der Stiftung kommen alle von Unternehmen wie AMD, Amazon Web Services (AWS), Google Cloud, Meta, Microsoft Azure und NVIDIA Das Modell entspricht dem aktuellen Stand und der Entwicklungsrichtung von PyTorch. Die Gründung der PyTorch Foundation wird in den kommenden Jahren sicherstellen, dass Geschäftsentscheidungen transparent und offen von einem vielfältigen Mitgliederkreis getroffen werden.

In diesem Zusammenhang sagte Soumith Chintala: „Da PyTorch sich weiter zu einem Multi-Stakeholder-Projekt entwickelt, ist es an der Zeit, auf eine breitere Open-Source-Basis umzusteigen.“ wie Kubernetes und NodeJS“

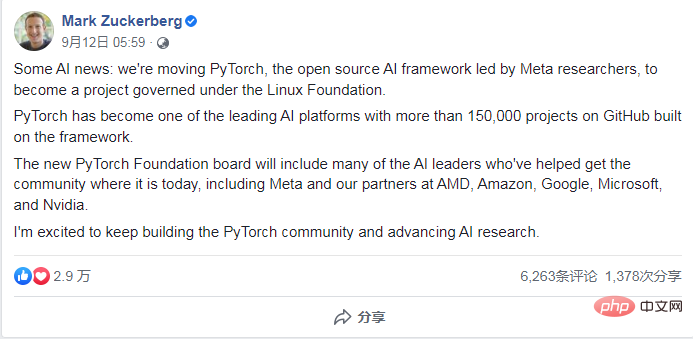

Zuckerberg schrieb auch in einem Facebook-Beitrag: „Der neue Vorstand der PyTorch Foundation wird viele Mitglieder umfassen, die der Community helfen werden, zu den heutigen KI-Führungskräften heranzuwachsen, darunter Meta und unsere Partner bei AMD, Amazon, Google, „

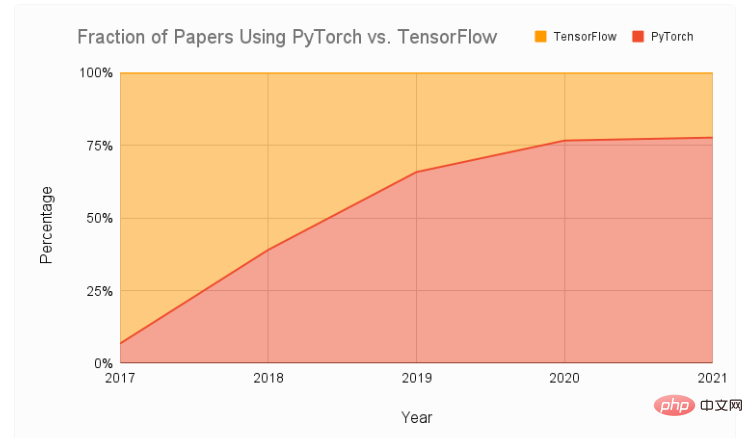

PyTorch Der nächste Schritt für die Stiftung Im Januar 2017 startete das Facebook Artificial Intelligence Research Institute PyTorch auf Basis von Microsoft und NVIDIA Fackel. Es handelt sich um ein Python-basiertes Paket für nachhaltiges Computing, das zwei erweiterte Funktionen bietet: Tensor-Computing mit leistungsstarker GPU-Beschleunigung (wie NumPy) und tiefe neuronale Netze einschließlich eines automatischen Ableitungssystems. Als eines der beliebtesten Frameworks für maschinelles Lernen hat PyTorch seit seiner ersten Open-Source-Veröffentlichung auf GitHub schnell den Spitzenplatz auf der Beliebtheitsliste von GitHub eingenommen. Im Vergleich zu einem anderen beliebten TensorFlow-Framework ist die Nutzung von PyTorch in nur wenigen Jahren von nur 7 % auf fast 80 % gestiegen.

Seit der Gründung von PyTorch haben mehr als 2.400 Mitwirkende Projekte auf Basis von PyTorch erstellt, wobei fast 154.000 Projekte erstellt wurden.

Soumith Chintala sagte, dass die Geschäftsführung von PyTorch seit langem unstrukturiert sei. Die Mitglieder des Meta-Teams hätten viel Zeit und Energie aufgewendet, um PyTorch zu einer organisatorisch gesünderen Einheit zu machen, und es seien viele Strukturen eingeführt worden. In der nächsten Phase besteht das Entwicklungsziel von PyTorch darin, die Interessen mehrerer Interessengruppen zu unterstützen. Aus diesem Grund wurde die Linux Foundation ausgewählt: „Sie verfügt über umfassende organisatorische Erfahrung bei der Ausrichtung großer Open-Source-Projekte mit mehreren Interessengruppen und verfügt über eine starke Organisationsstruktur.“ Die richtige Balance finden, um spezifische Lösungen für diese Projekte zu finden. „

Derzeit hat die Linux Foundation Tausende von Mitgliedern auf der ganzen Welt und mehr als 850 Open-Source-Projekte, deren Projekte direkt zu grundlegenden KI/ML-Projekten beitragen oder dazu beitragen Anwendungsfälle und Integration mit seinen Plattformen wie LF Networking, AGL, Delta Lake, RISC-V usw. Als Teil der Linux Foundation profitieren PyTorch und seine Community von der Unterstützung der zahlreichen Programme und Community-Aktivitäten der Linux Foundation, darunter Schulungs- und Zertifizierungsprogramme, Community-Forschung und mehr.

PyTorch hat außerdem Zugriff auf das LFX-Kollaborationsportal der Linux Foundation, das Orientierung bietet und der PyTorch-Community hilft, zukünftige Führungskräfte zu identifizieren, potenzielle Mitarbeiter zu finden und gemeinsame Community-Dynamik zu beobachten. Die Linux Foundation erklärte: „PyTorch hat seinen aktuellen Stand durch gute Wartung und Open-Source-Community-Management erreicht. Wir werden keine der Vorteile von PyTorch ändern

Referenzlink:

https://pytorch.org/blog/“ PyTorchfoundation/

https://www.assemblyai.com/blog/pytorch-vs-tensorflow-in-2022/

https://linuxfoundation.org/en/blog/welcoming-pytorch-to-the-linux- Stiftung/

Das obige ist der detaillierte Inhalt vonPyTorch wird an die Linux Foundation übertragen, was erhebliche Auswirkungen auf die KI-Forschung haben wird. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1389

1389

52

52

iFlytek: Die Fähigkeiten des Ascend 910B von Huawei sind grundsätzlich mit denen des A100 von Nvidia vergleichbar, und sie arbeiten zusammen, um eine neue Basis für die allgemeine künstliche Intelligenz meines Landes zu schaffen

Oct 22, 2023 pm 06:13 PM

iFlytek: Die Fähigkeiten des Ascend 910B von Huawei sind grundsätzlich mit denen des A100 von Nvidia vergleichbar, und sie arbeiten zusammen, um eine neue Basis für die allgemeine künstliche Intelligenz meines Landes zu schaffen

Oct 22, 2023 pm 06:13 PM

Diese Website berichtete am 22. Oktober, dass iFlytek im dritten Quartal dieses Jahres einen Nettogewinn von 25,79 Millionen Yuan erzielte, was einem Rückgang von 81,86 % gegenüber dem Vorjahr entspricht; der Nettogewinn in den ersten drei Quartalen betrug 99,36 Millionen Yuan Rückgang um 76,36 % gegenüber dem Vorjahr. Jiang Tao, Vizepräsident von iFlytek, gab bei der Leistungsbesprechung im dritten Quartal bekannt, dass iFlytek Anfang 2023 ein spezielles Forschungsprojekt mit Huawei Shengteng gestartet und gemeinsam mit Huawei eine leistungsstarke Betreiberbibliothek entwickelt hat, um gemeinsam eine neue Basis für Chinas allgemeine künstliche Intelligenz zu schaffen Intelligenz, die den Einsatz inländischer Großmodelle ermöglicht. Die Architektur basiert auf unabhängig innovativer Soft- und Hardware. Er wies darauf hin, dass die aktuellen Fähigkeiten des Huawei Ascend 910B grundsätzlich mit dem A100 von Nvidia vergleichbar seien. Auf dem bevorstehenden iFlytek 1024 Global Developer Festival werden iFlytek und Huawei weitere gemeinsame Ankündigungen zur Rechenleistungsbasis für künstliche Intelligenz machen. Er erwähnte auch,

Die perfekte Kombination aus PyCharm und PyTorch: detaillierte Installations- und Konfigurationsschritte

Feb 21, 2024 pm 12:00 PM

Die perfekte Kombination aus PyCharm und PyTorch: detaillierte Installations- und Konfigurationsschritte

Feb 21, 2024 pm 12:00 PM

PyCharm ist eine leistungsstarke integrierte Entwicklungsumgebung (IDE) und PyTorch ist ein beliebtes Open-Source-Framework im Bereich Deep Learning. Im Bereich maschinelles Lernen und Deep Learning kann die Verwendung von PyCharm und PyTorch für die Entwicklung die Entwicklungseffizienz und Codequalität erheblich verbessern. In diesem Artikel wird detailliert beschrieben, wie PyTorch in PyCharm installiert und konfiguriert wird, und es werden spezifische Codebeispiele angehängt, um den Lesern zu helfen, die leistungsstarken Funktionen dieser beiden besser zu nutzen. Schritt 1: Installieren Sie PyCharm und Python

Einführung in fünf Stichprobenmethoden bei Aufgaben zur Generierung natürlicher Sprache und bei der Implementierung von Pytorch-Code

Feb 20, 2024 am 08:50 AM

Einführung in fünf Stichprobenmethoden bei Aufgaben zur Generierung natürlicher Sprache und bei der Implementierung von Pytorch-Code

Feb 20, 2024 am 08:50 AM

Bei Aufgaben zur Generierung natürlicher Sprache ist die Stichprobenmethode eine Technik, um eine Textausgabe aus einem generativen Modell zu erhalten. In diesem Artikel werden fünf gängige Methoden erläutert und mit PyTorch implementiert. 1. GreedyDecoding Bei der Greedy-Decodierung sagt das generative Modell die Wörter der Ausgabesequenz basierend auf der Eingabesequenz Zeit Schritt für Zeit voraus. In jedem Zeitschritt berechnet das Modell die bedingte Wahrscheinlichkeitsverteilung jedes Wortes und wählt dann das Wort mit der höchsten bedingten Wahrscheinlichkeit als Ausgabe des aktuellen Zeitschritts aus. Dieses Wort wird zur Eingabe für den nächsten Zeitschritt und der Generierungsprozess wird fortgesetzt, bis eine Abschlussbedingung erfüllt ist, beispielsweise eine Sequenz mit einer bestimmten Länge oder eine spezielle Endmarkierung. Das Merkmal von GreedyDecoding besteht darin, dass die aktuelle bedingte Wahrscheinlichkeit jedes Mal die beste ist

Implementierung eines Rauschentfernungs-Diffusionsmodells mit PyTorch

Jan 14, 2024 pm 10:33 PM

Implementierung eines Rauschentfernungs-Diffusionsmodells mit PyTorch

Jan 14, 2024 pm 10:33 PM

Bevor wir das Funktionsprinzip des Denoising Diffusion Probabilistic Model (DDPM) im Detail verstehen, wollen wir zunächst einige Aspekte der Entwicklung generativer künstlicher Intelligenz verstehen, die auch zu den Grundlagenforschungen von DDPM gehört. VAEVAE verwendet einen Encoder, einen probabilistischen latenten Raum und einen Decoder. Während des Trainings sagt der Encoder den Mittelwert und die Varianz jedes Bildes voraus und tastet diese Werte aus einer Gaußschen Verteilung ab. Das Ergebnis der Abtastung wird an den Decoder weitergeleitet, der das Eingabebild in eine dem Ausgabebild ähnliche Form umwandelt. Zur Berechnung des Verlusts wird die KL-Divergenz verwendet. Ein wesentlicher Vorteil von VAE ist die Fähigkeit, vielfältige Bilder zu erzeugen. In der Abtastphase kann man direkt aus der Gaußschen Verteilung Stichproben ziehen und über den Decoder neue Bilder erzeugen. GAN hat in nur einem Jahr große Fortschritte bei Variational Autoencodern (VAEs) gemacht.

Tutorial zur Installation von PyCharm mit PyTorch

Feb 24, 2024 am 10:09 AM

Tutorial zur Installation von PyCharm mit PyTorch

Feb 24, 2024 am 10:09 AM

Als leistungsstarkes Deep-Learning-Framework wird PyTorch häufig in verschiedenen maschinellen Lernprojekten eingesetzt. Als leistungsstarke integrierte Python-Entwicklungsumgebung kann PyCharm auch bei der Umsetzung von Deep-Learning-Aufgaben eine gute Unterstützung bieten. In diesem Artikel wird die Installation von PyTorch in PyCharm ausführlich vorgestellt und spezifische Codebeispiele bereitgestellt, um den Lesern den schnellen Einstieg in die Verwendung von PyTorch für Deep-Learning-Aufgaben zu erleichtern. Schritt 1: Installieren Sie PyCharm. Zuerst müssen wir sicherstellen, dass wir es haben

Deep Learning mit PHP und PyTorch

Jun 19, 2023 pm 02:43 PM

Deep Learning mit PHP und PyTorch

Jun 19, 2023 pm 02:43 PM

Deep Learning ist ein wichtiger Zweig im Bereich der künstlichen Intelligenz und hat in den letzten Jahren immer mehr Aufmerksamkeit erhalten. Um Deep-Learning-Forschung und -Anwendungen durchführen zu können, ist es oft notwendig, einige Deep-Learning-Frameworks zu verwenden, um dies zu erreichen. In diesem Artikel stellen wir vor, wie man PHP und PyTorch für Deep Learning verwendet. 1. Was ist PyTorch? PyTorch ist ein von Facebook entwickeltes Open-Source-Framework für maschinelles Lernen. Es kann uns helfen, schnell Deep-Learning-Modelle zu erstellen und zu trainieren. PyTorc

so schnell! Erkennen Sie Videosprache in nur wenigen Minuten mit weniger als 10 Codezeilen in Text

Feb 27, 2024 pm 01:55 PM

so schnell! Erkennen Sie Videosprache in nur wenigen Minuten mit weniger als 10 Codezeilen in Text

Feb 27, 2024 pm 01:55 PM

Hallo zusammen, ich bin Kite. Die Notwendigkeit, Audio- und Videodateien in Textinhalte umzuwandeln, war vor zwei Jahren schwierig, aber jetzt kann dies problemlos in nur wenigen Minuten gelöst werden. Es heißt, dass einige Unternehmen, um Trainingsdaten zu erhalten, Videos auf Kurzvideoplattformen wie Douyin und Kuaishou vollständig gecrawlt haben, dann den Ton aus den Videos extrahiert und sie in Textform umgewandelt haben, um sie als Trainingskorpus für Big-Data-Modelle zu verwenden . Wenn Sie eine Video- oder Audiodatei in Text konvertieren müssen, können Sie diese heute verfügbare Open-Source-Lösung ausprobieren. Sie können beispielsweise nach bestimmten Zeitpunkten suchen, zu denen Dialoge in Film- und Fernsehsendungen erscheinen. Kommen wir ohne weitere Umschweife zum Punkt. Whisper ist OpenAIs Open-Source-Whisper. Es ist natürlich in Python geschrieben und erfordert nur ein paar einfache Installationspakete.

Detaillierte Erläuterung der GQA, des in großen Modellen häufig verwendeten Aufmerksamkeitsmechanismus und der Pytorch-Codeimplementierung

Apr 03, 2024 pm 05:40 PM

Detaillierte Erläuterung der GQA, des in großen Modellen häufig verwendeten Aufmerksamkeitsmechanismus und der Pytorch-Codeimplementierung

Apr 03, 2024 pm 05:40 PM

Grouped Query Attention (GroupedQueryAttention) ist eine Methode zur Aufmerksamkeit für mehrere Abfragen in großen Sprachmodellen. Ihr Ziel besteht darin, die Qualität von MHA zu erreichen und gleichzeitig die Geschwindigkeit von MQA beizubehalten. GroupedQueryAttention gruppiert Abfragen und Abfragen innerhalb jeder Gruppe haben die gleiche Aufmerksamkeitsgewichtung, was dazu beiträgt, die Rechenkomplexität zu reduzieren und die Inferenzgeschwindigkeit zu erhöhen. In diesem Artikel erklären wir die Idee der GQA und wie man sie in Code übersetzt. GQA befindet sich im Artikel GQA:TrainingGeneralizedMulti-QueryTransformerModelsfromMulti-HeadCheckpoint