Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Basierend auf der modalübergreifenden Elementübertragung erfordert die Referenzvideoobjekt-Segmentierungsmethode der Meitu & Dalian University of Technology nur eine einzige Stufe

Basierend auf der modalübergreifenden Elementübertragung erfordert die Referenzvideoobjekt-Segmentierungsmethode der Meitu & Dalian University of Technology nur eine einzige Stufe

Basierend auf der modalübergreifenden Elementübertragung erfordert die Referenzvideoobjekt-Segmentierungsmethode der Meitu & Dalian University of Technology nur eine einzige Stufe

Einführung

Referring VOS (RVOS) ist eine neu entstehende Aufgabe, die darauf abzielt, die Objekte, auf die sich der Text bezieht, aus einer Videosequenz basierend auf dem Referenztext zu segmentieren. Im Vergleich zur halbüberwachten Videoobjektsegmentierung stützt sich RVOS nur auf abstrakte Sprachbeschreibungen statt auf Referenzmasken auf Pixelebene, was eine bequemere Option für die Mensch-Computer-Interaktion darstellt und daher große Aufmerksamkeit gefunden hat.

Link zum Papier: https://www.aaai.org/AAAI22Papers/AAAI-1100.LiD.pdf

Der Hauptzweck dieser Forschung besteht darin, die Probleme bestehender RVOS zu lösen Aufgaben Zwei große Herausforderungen:

- Wie man Textinformationen und Bildinformationen modalitätsübergreifend zusammenführt, um die Skalenkonsistenz zwischen den beiden Modalitäten aufrechtzuerhalten und die vom Text bereitgestellten nützlichen Funktionsreferenzen vollständig in die Bildfunktionen zu integrieren

- Wie man die zweistufige Strategie bestehender Methoden aufgibt (d. h. zunächst Bild für Bild ein grobes Ergebnis auf Bildebene erhalten, dann das Ergebnis als Referenz verwenden und die endgültige Vorhersage durch Strukturverfeinerung mit erweiterten Zeitinformationen erhalten). ) , wodurch die gesamte RVOS-Aufgabe in einem einstufigen Framework vereint wird.

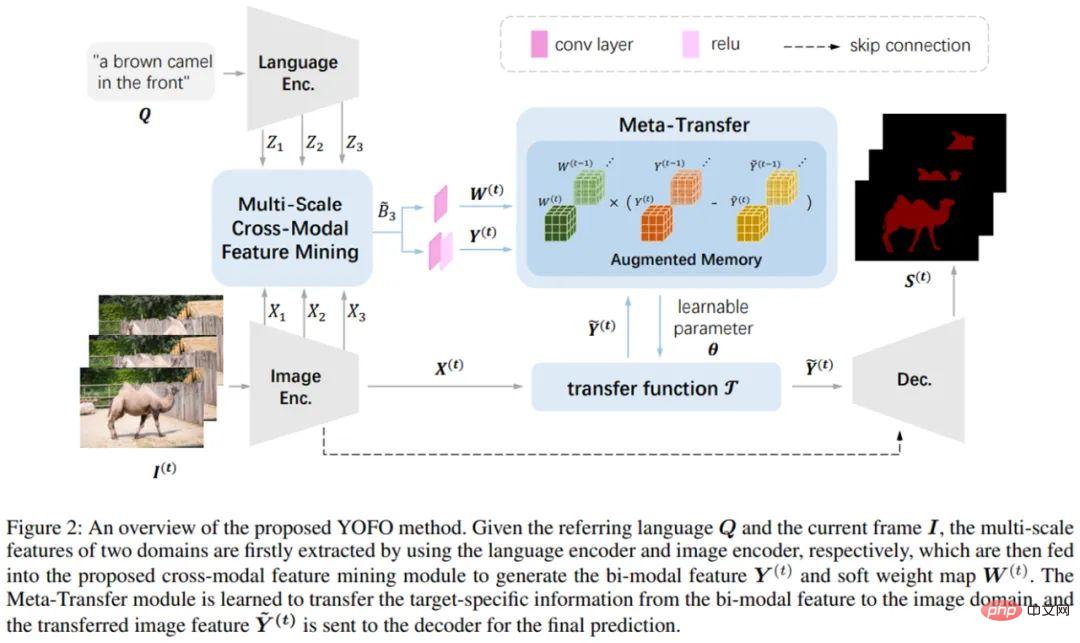

In diesem Zusammenhang schlägt diese Forschung ein End-to-End-RVOS-Framework für die modalübergreifende Elementmigration vor – YOFO Seine wichtigsten Beiträge und Innovationen sind:

- nur Es erfordert Einstufige Argumentation zum direkten Erhalten der Segmentierungsergebnisse von Videozielen mithilfe von Referenztextinformationen. Die anhand von zwei gängigen Datensätzen – Ref-DAVIS2017 und Ref-Youtube-VOS – erzielten Ergebnisse übertreffen alle aktuellen zweistufigen Methoden Meta-Transfer-Modul zur Verbesserung der zeitlichen Informationen, wodurch ein zielgerichteteres Feature-Lernen erreicht wird;

- Schlägt ein Multi-Scale Cross-Modal Feature Mining-Modul vor, das nützliche Features vollständig integrieren kann in Sprache und Bildern.

- Implementierungsstrategie

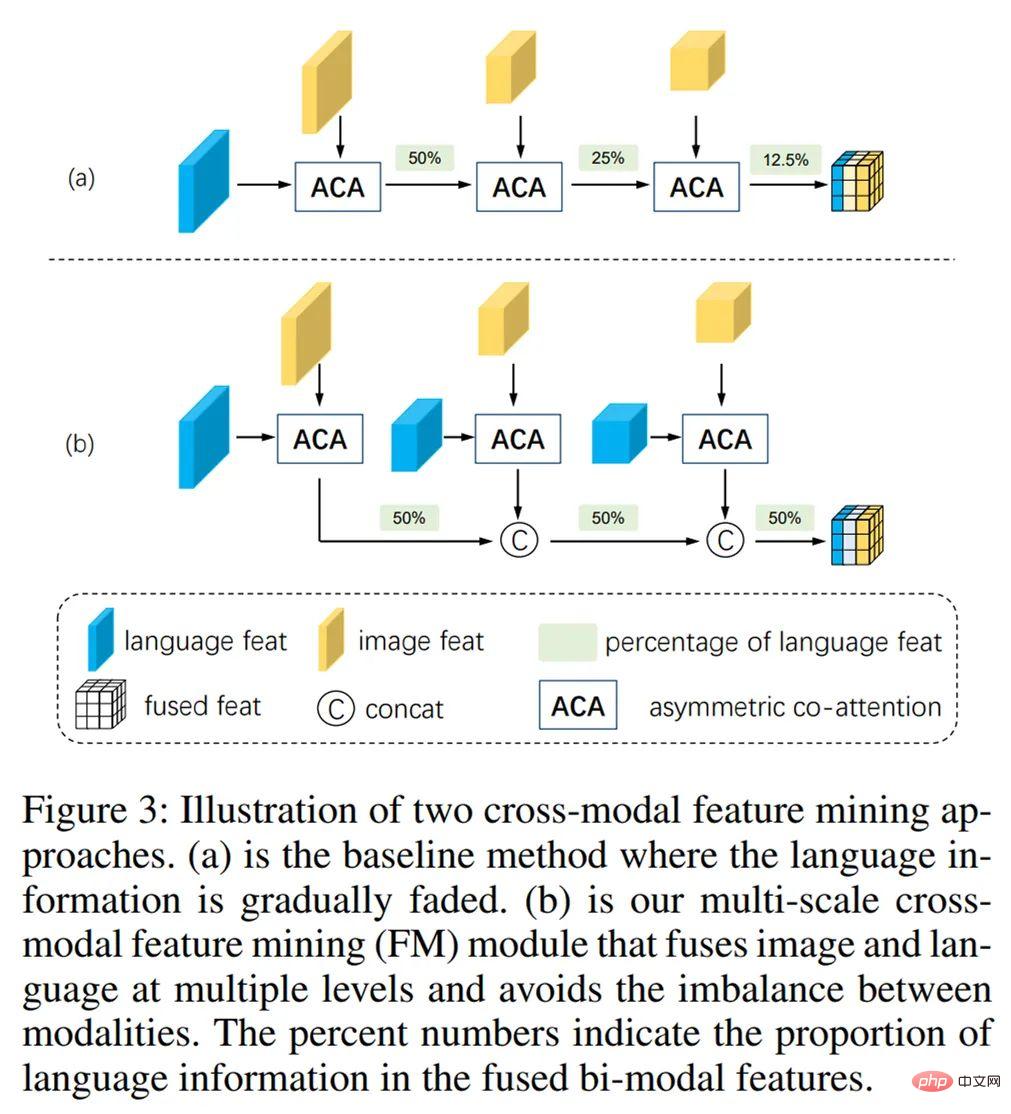

Mehrskalenübergreifendes Feature-Mining-Modul

: Dieses Modul kann die Beziehung zwischen den durch Bildmerkmale übermittelten Skaleninformationen und den Sprachmerkmalen aufrechterhalten, indem zwei modale Merkmale unterschiedlicher Maßstäbe schrittweise zusammengeführt werden. Konsistenz und, was noch wichtiger ist, stellt sicher, dass Sprachinformationen während des Fusionsprozesses nicht durch mehrskalige Bildinformationen verwässert und überlagert werden.

Meta-Migrationsmodul

: Es wird eine Learning-to-Learn-Strategie übernommen, und der Prozess kann einfach als die folgende Mapping-Funktion beschrieben werden. Unter diesen ist die Migrationsfunktion eine Faltung, dann ist  ihr Faltungskernparameter:

ihr Faltungskernparameter:

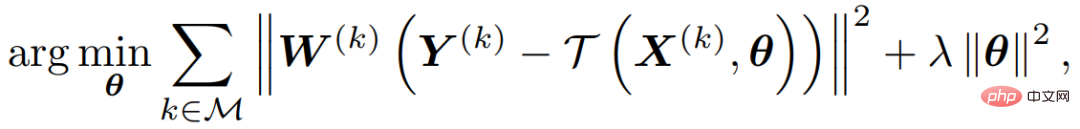

Der Optimierungsprozess kann als folgende Zielfunktion ausgedrückt werden:

Unter diesen stellt M die Speicherbank dar, die historische Informationen speichern kann, und W stellt das Gewicht verschiedener Positionen dar, die angegeben werden können Der Aufmerksamkeitsgrad Y stellt die bimodalen Merkmale jedes in der Speicherbank gespeicherten Videobilds dar. Dieser Optimierungsprozess maximiert die Fähigkeit der Metatransferfunktion, bimodale Merkmale zu rekonstruieren, und ermöglicht außerdem ein durchgängiges Training des gesamten Frameworks.

Training und Tests: Die im Training verwendete Verlustfunktion ist Lovasz-Verlust, und der Trainingssatz besteht aus zwei Videodatensätzen Ref-DAVIS2017 und Ref-Youtube-VOS und wird über den statischen Datensatz Ref durchgeführt -COCO Zufällige affine Transformation simuliert Videodaten als Hilfstraining. Der Metamigrationsprozess wird während des Trainings und der Vorhersage durchgeführt und das gesamte Netzwerk läuft mit einer Geschwindigkeit von 10 FPS auf 1080ti.

Experimentelle Ergebnisse

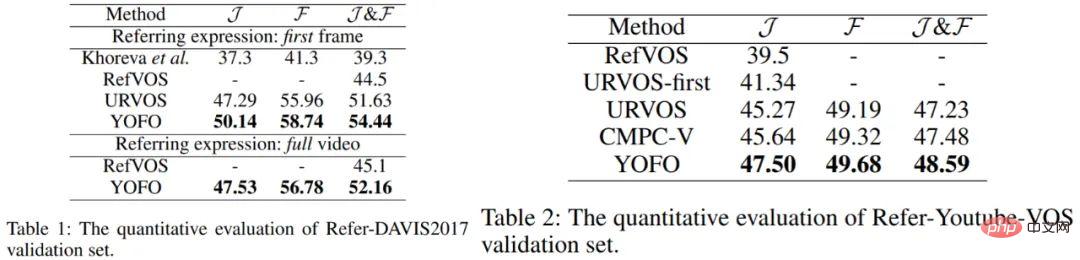

Die in der Forschung verwendete Methode hat bei zwei gängigen RVOS-Datensätzen (Ref-DAVIS2017 und Ref-Youtube-VOS) hervorragende Ergebnisse erzielt:

Abbildung 3: Quantitative Indikatoren für zwei Mainstream-Datensätze.

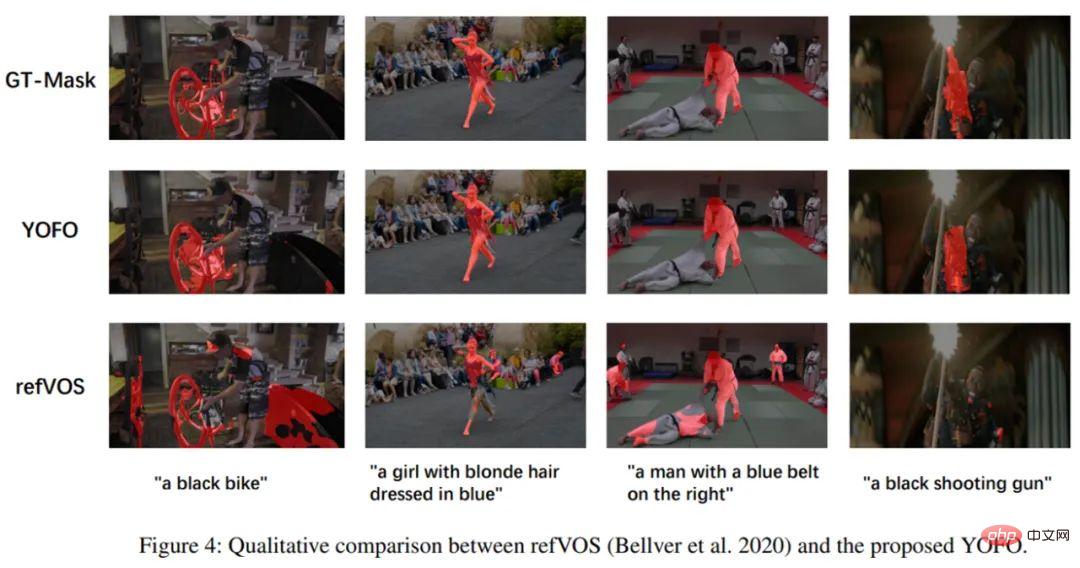

Abbildung 4: Visualisierung auf dem VOS-Datensatz.

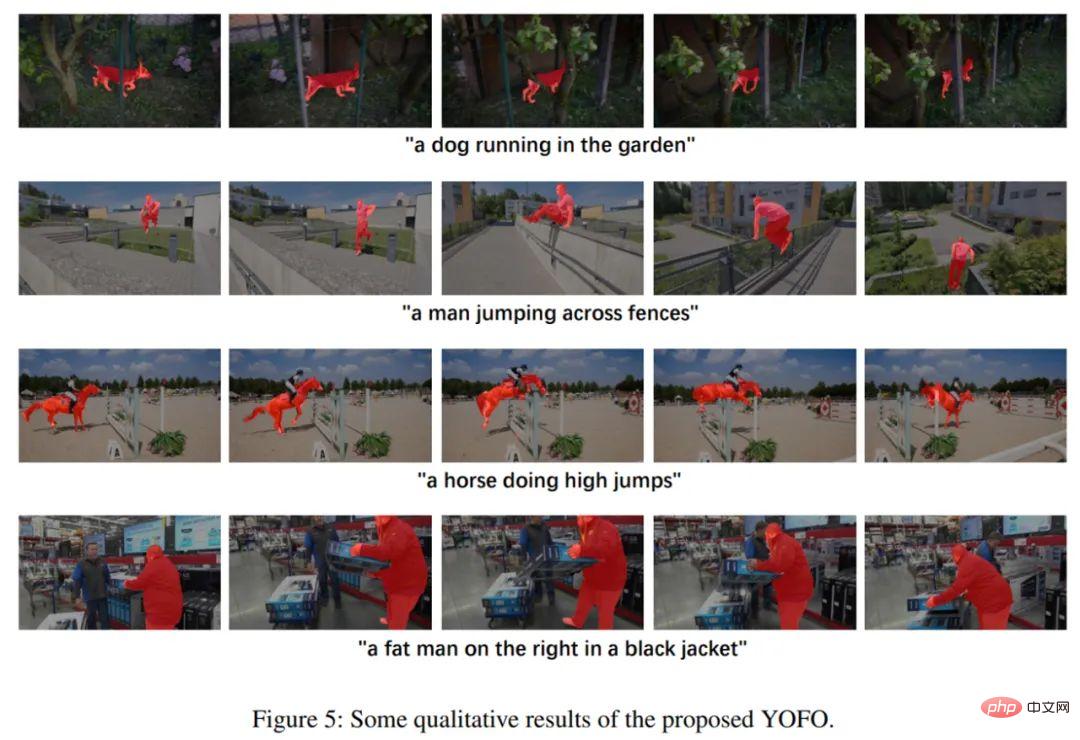

Abbildung 5: Weitere Visualisierungseffekte von YOFO.

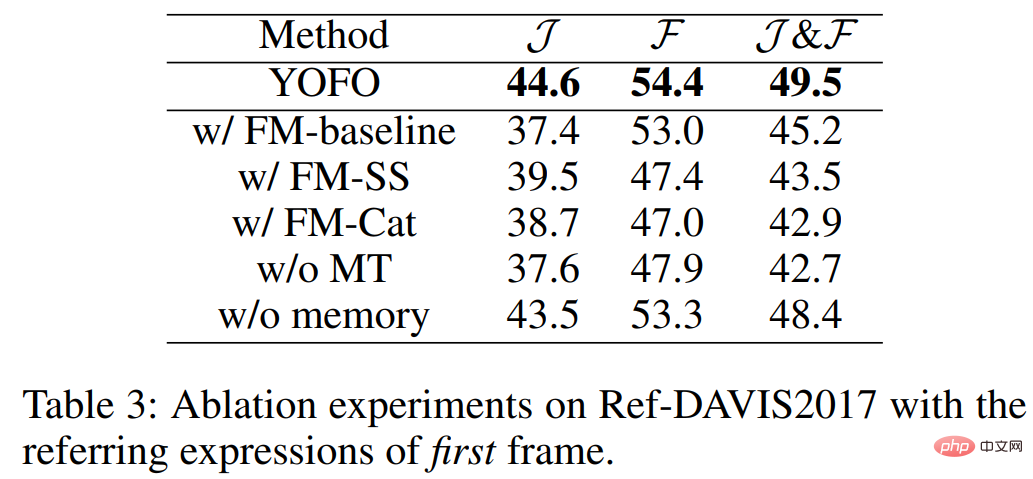

Die Studie führte außerdem eine Reihe von Ablationsexperimenten durch, um die Wirksamkeit des Feature-Mining-Moduls (FM) und des Meta-Transfer-Moduls (MT) zu veranschaulichen.

Abbildung 6: Wirksamkeit des Feature-Mining-Moduls (FM) und des Meta-Transfer-Moduls (MT).

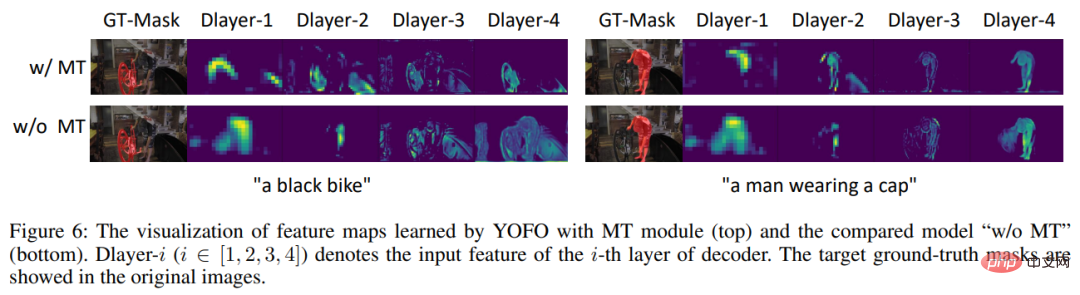

Darüber hinaus wurden in der Studie die Ausgabeeigenschaften des Decoders mithilfe des MT-Moduls und ohne Verwendung des MT-Moduls visualisiert. Es ist deutlich zu erkennen, dass das MT-Modul den durch die Sprache beschriebenen Inhalt korrekt erfassen und Störgeräusche erzeugen kann . filtern.

Abbildung 7: Vergleich der Decoder-Ausgabefunktionen vor und nach Verwendung des MT-Moduls. Über das Forschungsteam

Dieses Papier wurde gemeinsam von Forschern des Meitu Imaging Research Institute (MT Lab) und dem Lu Huchuan-Team der Dalian University of Technology vorgeschlagen. Das Meitu Imaging Research Institute (MT Lab) ist Meitus Team, das sich der Algorithmenforschung, technischen Entwicklung und Produktisierung in den Bereichen Computer Vision, maschinelles Lernen, Augmented Reality, Cloud Computing und anderen Bereichen widmet. Es bildet die Grundlage für Meitus bestehende und zukünftige Produkte. Es bietet Unterstützung für Kernalgorithmen und fördert die Entwicklung von Meitu-Produkten durch Spitzentechnologie. Es hat an führenden internationalen Computer-Vision-Konferenzen wie CVPR, ICCV und ECCV teilgenommen und weitere gewonnen als zehn Meisterschaften und Vizemeisterschaften.

Das obige ist der detaillierte Inhalt vonBasierend auf der modalübergreifenden Elementübertragung erfordert die Referenzvideoobjekt-Segmentierungsmethode der Meitu & Dalian University of Technology nur eine einzige Stufe. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

So bewerten Sie die Kosteneffizienz der kommerziellen Unterstützung für Java-Frameworks

Jun 05, 2024 pm 05:25 PM

Die Bewertung des Kosten-/Leistungsverhältnisses des kommerziellen Supports für ein Java-Framework umfasst die folgenden Schritte: Bestimmen Sie das erforderliche Maß an Sicherheit und Service-Level-Agreement-Garantien (SLA). Die Erfahrung und das Fachwissen des Forschungsunterstützungsteams. Erwägen Sie zusätzliche Services wie Upgrades, Fehlerbehebung und Leistungsoptimierung. Wägen Sie die Kosten für die Geschäftsunterstützung gegen Risikominderung und Effizienzsteigerung ab.

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Wie ist die Lernkurve von PHP-Frameworks im Vergleich zu anderen Sprach-Frameworks?

Jun 06, 2024 pm 12:41 PM

Die Lernkurve eines PHP-Frameworks hängt von Sprachkenntnissen, Framework-Komplexität, Dokumentationsqualität und Community-Unterstützung ab. Die Lernkurve von PHP-Frameworks ist im Vergleich zu Python-Frameworks höher und im Vergleich zu Ruby-Frameworks niedriger. Im Vergleich zu Java-Frameworks haben PHP-Frameworks eine moderate Lernkurve, aber eine kürzere Einstiegszeit.

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Wie wirken sich die Lightweight-Optionen von PHP-Frameworks auf die Anwendungsleistung aus?

Jun 06, 2024 am 10:53 AM

Das leichte PHP-Framework verbessert die Anwendungsleistung durch geringe Größe und geringen Ressourcenverbrauch. Zu seinen Merkmalen gehören: geringe Größe, schneller Start, geringer Speicherverbrauch, verbesserte Reaktionsgeschwindigkeit und Durchsatz sowie reduzierter Ressourcenverbrauch. Praktischer Fall: SlimFramework erstellt eine REST-API, nur 500 KB, hohe Reaktionsfähigkeit und hoher Durchsatz

Leistungsvergleich von Java-Frameworks

Jun 04, 2024 pm 03:56 PM

Leistungsvergleich von Java-Frameworks

Jun 04, 2024 pm 03:56 PM

Laut Benchmarks sind Quarkus (schneller Start, geringer Speicher) oder Micronaut (TechEmpower ausgezeichnet) für kleine, leistungsstarke Anwendungen die ideale Wahl. SpringBoot eignet sich für große Full-Stack-Anwendungen, weist jedoch etwas langsamere Startzeiten und Speichernutzung auf.

Best Practices für die Dokumentation des Golang-Frameworks

Jun 04, 2024 pm 05:00 PM

Best Practices für die Dokumentation des Golang-Frameworks

Jun 04, 2024 pm 05:00 PM

Das Verfassen einer klaren und umfassenden Dokumentation ist für das Golang-Framework von entscheidender Bedeutung. Zu den Best Practices gehört die Befolgung eines etablierten Dokumentationsstils, beispielsweise des Go Coding Style Guide von Google. Verwenden Sie eine klare Organisationsstruktur, einschließlich Überschriften, Unterüberschriften und Listen, und sorgen Sie für eine Navigation. Bietet umfassende und genaue Informationen, einschließlich Leitfäden für den Einstieg, API-Referenzen und Konzepte. Verwenden Sie Codebeispiele, um Konzepte und Verwendung zu veranschaulichen. Halten Sie die Dokumentation auf dem neuesten Stand, verfolgen Sie Änderungen und dokumentieren Sie neue Funktionen. Stellen Sie Support und Community-Ressourcen wie GitHub-Probleme und Foren bereit. Erstellen Sie praktische Beispiele, beispielsweise eine API-Dokumentation.

So wählen Sie das beste Golang-Framework für verschiedene Anwendungsszenarien aus

Jun 05, 2024 pm 04:05 PM

So wählen Sie das beste Golang-Framework für verschiedene Anwendungsszenarien aus

Jun 05, 2024 pm 04:05 PM

Wählen Sie das beste Go-Framework basierend auf Anwendungsszenarien aus: Berücksichtigen Sie Anwendungstyp, Sprachfunktionen, Leistungsanforderungen und Ökosystem. Gängige Go-Frameworks: Gin (Webanwendung), Echo (Webdienst), Fiber (hoher Durchsatz), gorm (ORM), fasthttp (Geschwindigkeit). Praktischer Fall: Erstellen einer REST-API (Fiber) und Interaktion mit der Datenbank (gorm). Wählen Sie ein Framework: Wählen Sie fasthttp für die Schlüsselleistung, Gin/Echo für flexible Webanwendungen und gorm für die Datenbankinteraktion.

Detaillierte praktische Erklärung der Golang-Framework-Entwicklung: Fragen und Antworten

Jun 06, 2024 am 10:57 AM

Detaillierte praktische Erklärung der Golang-Framework-Entwicklung: Fragen und Antworten

Jun 06, 2024 am 10:57 AM

Bei der Go-Framework-Entwicklung treten häufige Herausforderungen und deren Lösungen auf: Fehlerbehandlung: Verwenden Sie das Fehlerpaket für die Verwaltung und Middleware zur zentralen Fehlerbehandlung. Authentifizierung und Autorisierung: Integrieren Sie Bibliotheken von Drittanbietern und erstellen Sie benutzerdefinierte Middleware zur Überprüfung von Anmeldeinformationen. Parallelitätsverarbeitung: Verwenden Sie Goroutinen, Mutexe und Kanäle, um den Ressourcenzugriff zu steuern. Unit-Tests: Verwenden Sie Gotest-Pakete, Mocks und Stubs zur Isolierung sowie Code-Coverage-Tools, um die Angemessenheit sicherzustellen. Bereitstellung und Überwachung: Verwenden Sie Docker-Container, um Bereitstellungen zu verpacken, Datensicherungen einzurichten und Leistung und Fehler mit Protokollierungs- und Überwachungstools zu verfolgen.

Was sind die häufigsten Missverständnisse im Lernprozess des Golang-Frameworks?

Jun 05, 2024 pm 09:59 PM

Was sind die häufigsten Missverständnisse im Lernprozess des Golang-Frameworks?

Jun 05, 2024 pm 09:59 PM

Beim Go-Framework-Lernen gibt es fünf Missverständnisse: übermäßiges Vertrauen in das Framework und eingeschränkte Flexibilität. Wenn Sie die Framework-Konventionen nicht befolgen, wird es schwierig, den Code zu warten. Die Verwendung veralteter Bibliotheken kann zu Sicherheits- und Kompatibilitätsproblemen führen. Die übermäßige Verwendung von Paketen verschleiert die Codestruktur. Das Ignorieren der Fehlerbehandlung führt zu unerwartetem Verhalten und Abstürzen.