Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ist Ihre Remote-Mitarbeiterin wirklich sie selbst? Das FBI deckt Arbeitssuchenden auf, die Deepfakes missbrauchen

Ist Ihre Remote-Mitarbeiterin wirklich sie selbst? Das FBI deckt Arbeitssuchenden auf, die Deepfakes missbrauchen

Ist Ihre Remote-Mitarbeiterin wirklich sie selbst? Das FBI deckt Arbeitssuchenden auf, die Deepfakes missbrauchen

In der Welt des Deepfakes ist es manchmal schwierig, zwischen wahr und falsch zu unterscheiden.

Der KI-Algorithmus „Deepfake“ kann verschiedene realistische Bilder und Videos von Menschen erzeugen und wird häufig im Bereich der Gesichtsveränderung eingesetzt. Die KI-Technologie zur Gesichtsveränderung hat jedoch immer wieder zu Kontroversen geführt, beispielsweise die Verwendung von Deepfake zur Produktion von Videos für Erwachsene, die den Menschen große Probleme bereitet hat.

Laut ausländischen Medien pcmag gab das FBI kürzlich an, dass Betrüger die Deepfake-Technologie genutzt haben, um sich in Vorstellungsgesprächen für Remote-Arbeit als Bewerber auszugeben und so Stellenangebote bei IT-Unternehmen zu ergattern, um auf deren Kunden oder Finanzdaten zuzugreifen IT-Datenbanken und/oder proprietäre Informationen.

Einige Unternehmen haben aufgedeckt, dass die personenbezogenen Daten einiger Bewerber sogar einer anderen Person gehören.

Charaktergesicht vor und nach dem Gesichtsersatz. Bildquelle: Facebook/Meta

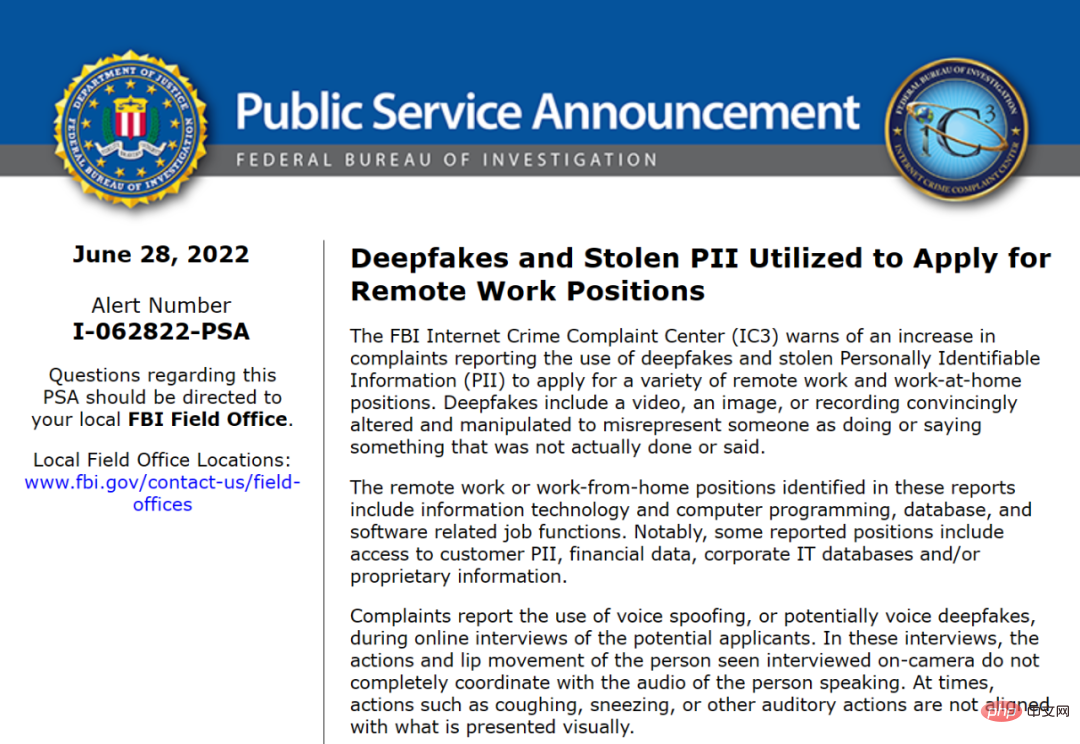

Hier ist es. Am 28. Juni Ortszeit erklärte das Internet Crime Complaint Center (IC3) des FBI in einer öffentlichen Konsultation, dass die Zahl der Beschwerden über die Nachahmung als Bewerber um eine Stelle in letzter Zeit zugenommen habe. Betrüger nutzen Deepfake-Technologie und von Opfern gestohlene personenbezogene Daten, um Arbeitgeber dazu zu verleiten, sie für Remote- oder Homeoffice-Jobs einzustellen.

Diese Jobs umfassen Positionen im Bereich IT und Computerprogrammierung sowie Datenbanken und Software.

Bildquelle: https://www.ic3.gov/Media/Y2022/PSA220628

In der Vergangenheit nutzte Deepfake KI-gestützte Programme, um realistische, aber gefälschte Personas zu erstellen. Auf der Videoseite kann die Technologie die Gesichter von Prominenten auf die Körper anderer Menschen kopieren; auf der Audioseite kann die Technologie die Stimme einer Person klonen und sie so manipulieren, dass sie sagt, was Sie wollen.

Diesmal ergab die Konsultation des FBI jedoch, dass die Deepfake-Technologie auch Identitätsdiebstahl erleichtert. Betrüger nutzen bei Online-Interviews mit potenziellen Bewerbern Voice-Spoofing oder Stimmfälschung. Betrüger nutzen diese Deepfake-Techniken, um sich bei IT-Unternehmen für Remote- oder Homeoffice-Jobs zu bewerben.

Obwohl das FBI nicht klar machte, was die ultimativen Ziele der Betrüger waren, stellte es fest, dass es sich dabei um den Zugriff auf PII (persönlich identifizierbare Informationen) von Kunden, Finanzdaten, Unternehmens-IT-Datenbanken und/oder geschützte Informationen handelte. Diese Art von Informationen kann Betrügern dabei helfen, wertvolle Informationen von einem Unternehmen zu stehlen und andere Identitätsbetrugspläne durchzuführen.

Quelle: https://www.bangkokpost.com/

Die gute Nachricht ist jedoch, dass Arbeitgeber Möglichkeiten haben, Deepfakes zu erkennen. Während Betrüger Videointerviews mit potenziellen Arbeitgebern geführt haben, stellt das FBI fest, dass die KI-basierte Technologie immer noch Mängel aufweist, wenn Betrüger sprechen.

Zum Beispiel sind die Bewegungen und Lippenbewegungen des Interviewers vor der Kamera nicht vollständig auf seine Sprechstimme abgestimmt. Manchmal stimmt ein Husten, Niesen oder ein anderes Hörverhalten nicht mit dem überein, was visuell dargestellt wird.

Das obige ist der detaillierte Inhalt vonIst Ihre Remote-Mitarbeiterin wirklich sie selbst? Das FBI deckt Arbeitssuchenden auf, die Deepfakes missbrauchen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1393

1393

52

52

1206

1206

24

24

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Der Artikel vergleicht Top -KI -Chatbots wie Chatgpt, Gemini und Claude und konzentriert sich auf ihre einzigartigen Funktionen, Anpassungsoptionen und Leistung in der Verarbeitung und Zuverlässigkeit natürlicher Sprache.

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

In dem Artikel werden Top -KI -Schreibassistenten wie Grammarly, Jasper, Copy.ai, Writesonic und RYTR erläutert und sich auf ihre einzigartigen Funktionen für die Erstellung von Inhalten konzentrieren. Es wird argumentiert, dass Jasper in der SEO -Optimierung auszeichnet, während KI -Tools dazu beitragen, den Ton zu erhalten

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: Ein revolutionäres Open-Source-Großsprachmodell Falcon 3, die neueste Iteration in der gefeierten Falcon -Serie von LLMs, stellt einen erheblichen Fortschritt in der AI -Technologie dar. Entwickelt vom Technology Innovation Institute (TII), diesem offen

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Der Artikel überprüft Top -KI -Sprachgeneratoren wie Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson und Descript, wobei sie sich auf ihre Funktionen, die Sprachqualität und die Eignung für verschiedene Anforderungen konzentrieren.

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

2024 veränderte sich von einfacher Verwendung von LLMs für die Erzeugung von Inhalten zum Verständnis ihrer inneren Funktionsweise. Diese Erkundung führte zur Entdeckung von AI -Agenten - autonome Systeme zur Handhabung von Aufgaben und Entscheidungen mit minimalem menschlichen Eingreifen. Bauen