Meta AI unter LeCun setzt auf Selbstüberwachung

Ist selbstüberwachtes Lernen wirklich ein wichtiger Schritt in Richtung AGI?

Der KI-Chefwissenschaftler von Meta, Yann LeCun, vergaß die langfristigen Ziele nicht, als er von „konkreten Maßnahmen, die in diesem Moment zu ergreifen sind“ sprach. In einem Interview sagte er: „Wir wollen intelligente Maschinen bauen, die wie Tiere und Menschen lernen.“ In den letzten Jahren hat Meta eine Reihe von Artikeln zum selbstüberwachten Lernen (SSL) von KI-Systemen veröffentlicht. LeCun ist fest davon überzeugt, dass SSL eine notwendige Voraussetzung für KI-Systeme ist, die KI-Systemen dabei helfen kann, Weltmodelle zu erstellen, um menschenähnliche Fähigkeiten wie Rationalität, gesunden Menschenverstand und die Fähigkeit zu erlangen, Fähigkeiten und Wissen von einer Umgebung in eine andere zu übertragen.

Ihr neuer Artikel zeigt, wie ein selbstüberwachtes System namens Masked Autoencoder (MAE) lernen kann, Bilder, Videos und sogar Audio aus sehr fragmentierten, unvollständigen Daten zu rekonstruieren. Obwohl MAEs keine neue Idee sind, hat Meta diese Arbeit auf neue Bereiche ausgeweitet.

LeCun sagte, dass MAE-Systeme durch die Untersuchung, wie fehlende Daten vorhergesagt werden können, seien es Standbilder oder Video- oder Audiosequenzen, ein Modell der Welt erstellen. Er sagte: „Wenn es vorhersagen kann, was im Video passieren wird, muss es verstehen, dass die Welt dreidimensional ist, dass einige Objekte unbelebt sind und sich nicht von selbst bewegen und andere Objekte lebendig und schwer vorherzusagen sind.“ , bis zur Vorhersage Komplexes Verhalten von Lebewesen.“ Sobald ein KI-System über ein genaues Modell der Welt verfügt, kann es dieses Modell zur Planung von Aktionen verwenden.

LeCun sagte: „Das Wesen der Intelligenz besteht darin, Vorhersagen zu lernen.“ Obwohl er nicht behauptete, dass Metas MAE-System der allgemeinen künstlichen Intelligenz nahe kommt, glaubt er, dass es ein wichtiger Schritt in Richtung allgemeiner künstlicher Intelligenz ist.

Aber nicht alle sind sich einig, dass Metaforscher auf dem richtigen Weg zur allgemeinen künstlichen Intelligenz sind. Yoshua Bengio führt manchmal freundschaftliche Debatten mit LeCun über große Ideen in der KI. In einer E-Mail an IEEE Spectrum erläuterte Bengio einige der Unterschiede und Gemeinsamkeiten ihrer Ziele.

Bengio schrieb: „Ich glaube wirklich nicht, dass unsere aktuellen Methoden (ob selbstüberwacht oder nicht) ausreichen, um die Lücke zwischen künstlicher und menschlicher Intelligenz zu schließen.“ Er sagte, dass das Feld „qualitative Fortschritte“ machen müsse Technologie wirklich fördern nähert sich der künstlichen Intelligenz im menschlichen Maßstab.

Bengio stimmt mit LeCuns Ansicht überein, dass „die Fähigkeit, über die Welt nachzudenken, das Kernelement der Intelligenz ist.“ Sein Team konzentriert sich jedoch nicht auf Modelle, die Vorhersagen treffen können, sondern auf Modelle, die die Welt in natürlicher Sprache vorhersagen können Modell, das Wissen in einer Form darstellt. Er wies darauf hin, dass solche Modelle es uns ermöglichen würden, diese Erkenntnisse zu kombinieren, um neue Probleme zu lösen, kontrafaktische Simulationen durchzuführen oder mögliche Zukünfte zu untersuchen. Bengios Team entwickelte ein neues neuronales Netzwerk-Framework, das modularer ist als das von LeCun favorisierte, das sich mit End-to-End-Lernen beschäftigt.

Der beliebte Transformer

Metas MAE basiert auf einer neuronalen Netzwerkarchitektur namens Transformer. Diese Architektur erfreute sich zunächst im Bereich der Verarbeitung natürlicher Sprache großer Beliebtheit und wurde später auf viele Bereiche wie Computer Vision ausgeweitet.

Natürlich ist Meta nicht das erste Team, das Transformer erfolgreich für Vision-Aufgaben einsetzt. Ross Girshick, ein Forscher bei Meta AI, sagte, dass Googles Forschung zu Visual Transformer (ViT) das Meta-Team inspiriert habe: „Die Einführung der ViT-Architektur hat (uns) geholfen, einige Hindernisse zu beseitigen, die während des Experiments aufgetreten sind.“

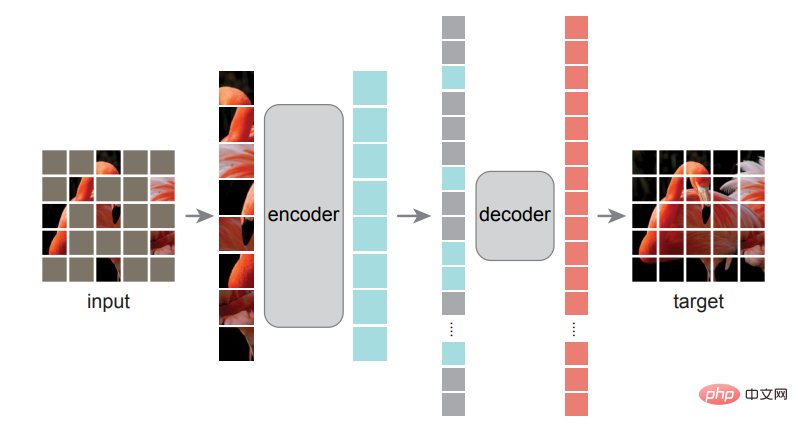

Girshick ist einer der Autoren von Metas erstem MAE-Systempapier. Einer der Autoren dieses Papiers ist He Kaiming. Sie diskutieren eine sehr einfache Methode: Maskieren Sie zufällige Blöcke des Eingabebildes und rekonstruieren Sie die fehlenden Pixel.

Das Training dieses Modells ähnelt BERT und einigen anderen Transformer-basierten Sprachmodellen. Forscher zeigen ihnen riesige Textdatenbanken, aber einige Wörter fehlen oder sind „maskiert“. Das Modell muss die fehlenden Wörter selbst vorhersagen und dann die maskierten Wörter aufdecken, damit das Modell seine Arbeit überprüfen und seine Parameter aktualisieren kann. Dieser Vorgang wiederholt sich ständig. Um optisch etwas Ähnliches zu erreichen, hat das Team das Bild in Patches aufgeteilt, dann einige der Patches maskiert und das MAE-System gebeten, die fehlenden Teile des Bildes vorherzusagen, erklärte Girshick.

Das Training dieses Modells ähnelt BERT und einigen anderen Transformer-basierten Sprachmodellen. Forscher zeigen ihnen riesige Textdatenbanken, aber einige Wörter fehlen oder sind „maskiert“. Das Modell muss die fehlenden Wörter selbst vorhersagen und dann die maskierten Wörter aufdecken, damit das Modell seine Arbeit überprüfen und seine Parameter aktualisieren kann. Dieser Vorgang wiederholt sich ständig. Um optisch etwas Ähnliches zu erreichen, hat das Team das Bild in Patches aufgeteilt, dann einige der Patches maskiert und das MAE-System gebeten, die fehlenden Teile des Bildes vorherzusagen, erklärte Girshick.

Einer der Durchbrüche des Teams war die Erkenntnis, dass die Maskierung des größten Teils des Bildes die besten Ergebnisse liefern würde, ein wesentlicher Unterschied zu Sprachtransformatoren, die möglicherweise nur 15 % der Wörter maskieren. „Sprache ist ein äußerst dichtes und effizientes Kommunikationssystem, und jedes Symbol hat eine große Bedeutung“, sagte Girshick. „Aber Bilder – diese Signale aus der natürlichen Welt – sind nicht dazu da, Redundanz zu beseitigen Komprimieren Sie den Inhalt beim Erstellen von JPG-Bildern gut

Forscher von Meta AI experimentierten damit, wie viel vom Bild maskiert werden musste, um die besten Ergebnisse zu erzielen.

Girshick erklärte, dass durch die Maskierung von mehr als 75 % der Patches im Bild Redundanzen im Bild beseitigt wurden, die die Aufgabe sonst zu trivial machen würden, um für sie geeignet zu sein Zug. Ihr zweiteiliges MAE-System verwendet zunächst einen Encoder, um die Beziehungen zwischen Pixeln aus einem Trainingsdatensatz zu lernen, und dann tut ein Decoder sein Bestes, um das Originalbild aus dem maskierten Bild zu rekonstruieren. Nach Abschluss dieses Trainingsschemas kann der Encoder auch für Bildverarbeitungsaufgaben wie Klassifizierung und Objekterkennung feinabgestimmt werden.

Girshick sagte: „Was für uns letztendlich spannend ist, ist, dass wir die Ergebnisse dieses Modells in nachgelagerten Aufgaben sehen, wenn wir den Encoder zur Erledigung von Aufgaben wie der Objekterkennung verwenden: „Wir sehen die Vorteile.“ sehr beeindruckend.“ Er wies darauf hin, dass eine weitere Erweiterung des Modells zu einer besseren Leistung führen kann, was eine mögliche Richtung für zukünftige Modelle darstellt, da SSL „das Potenzial hat, große Datenmengen ohne manuelle Annotation zu verwenden.“

Die Strategie von Meta zur Verbesserung der SSL-Ergebnisse mag darin bestehen, alles daran zu setzen, aus riesigen, ungefilterten Datensätzen zu lernen, aber es ist auch ein zunehmend kontroverser Ansatz. KI-Ethikforscher wie Timnit Gebru haben auf die Vorurteile aufmerksam gemacht, die den nicht kuratierten Datensätzen innewohnen, aus denen große Sprachmodelle lernen, und die manchmal zu katastrophalen Ergebnissen führen können.

Selbstüberwachtes Lernen für Video und Audio

Im Video-MAE-System deckt der Masker 95 % jedes Videobilds ab, da die Ähnlichkeit zwischen Bildern bedeutet, dass Videosignale mehr Redundanz aufweisen als statische Bilder. Der Metaforscher Christoph Feichtenhofer sagte, dass ein großer Vorteil des MAE-Ansatzes bei Videos darin besteht, dass Videos oft rechenintensiv sind und MAE die Rechenkosten um bis zu 95 % senkt, indem bis zu 95 % des Inhalts jedes Frames ausgeblendet werden . Die in diesen Experimenten verwendeten Videoclips waren nur wenige Sekunden lang, aber Feichtenhofer sagte, das Training künstlicher Intelligenzsysteme mit längeren Videos sei ein sehr aktives Forschungsthema. Stellen Sie sich vor, Sie haben einen virtuellen Assistenten, der ein Video von Ihrem Zuhause hat und Ihnen sagen kann, wo Sie vor einer Stunde Ihre Schlüssel gelassen haben.

Direkter können wir uns vorstellen, dass Bild- und Videosysteme beide für die Klassifizierungsaufgaben nützlich sind, die für die Content-Moderation auf Facebook und Instagram erforderlich sind, sagte Feichtenhofer, „Integrität“ sei eine mögliche Anwendung: „Wir kommunizieren.“ mit dem Produktteam, aber das ist sehr neu und wir haben noch keine konkreten Projekte. Sie fanden einen cleveren Weg, die Maskierungstechnik anzuwenden. Sie wandelten die Tondateien in Spektrogramme um, bei denen es sich um visuelle Darstellungen des Frequenzspektrums eines Signals handelt, und maskierten dann Teile der Bilder für das Training. Der rekonstruierte Ton kann sich sehen lassen, auch wenn das Modell aktuell nur wenige Sekunden lange Clips bewältigen kann.

Mögliche Anwendungen dieser Forschung umfassen Klassifizierungsaufgaben und die Unterstützung der Voice-over-IP-Übertragung (VoIP), indem sie den Audioverlust ausgleichen, wenn Pakete verloren gehen, sagte Bernie Huang, ein Forscher auf dem Gebiet des Audiosystems eine effizientere Möglichkeit, Audiodateien zu komprimieren.

Meta hat Forschung zu Open-Source-KI wie diesen MAE-Modellen durchgeführt und stellt außerdem ein vorab trainiertes großes Sprachmodell für die Community der künstlichen Intelligenz bereit. Kritiker weisen jedoch darauf hin, dass Meta trotz seiner Offenheit für Forschung seine Kerngeschäftsalgorithmen nicht für Studien zur Verfügung gestellt hat: diejenigen, die Newsfeeds, Empfehlungen und Anzeigenplatzierung steuern.

Das obige ist der detaillierte Inhalt vonMeta AI unter LeCun setzt auf Selbstüberwachung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Die Meta Connect 2024-Veranstaltung findet vom 25. bis 26. September statt. Bei dieser Veranstaltung wird das Unternehmen voraussichtlich ein neues erschwingliches Virtual-Reality-Headset vorstellen. Gerüchten zufolge handelt es sich bei dem VR-Headset um das Meta Quest 3S, das offenbar auf der FCC-Liste aufgetaucht ist. Dieser Vorschlag

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Machen Sie Ihre GPU bereit! Llama3.1 ist endlich erschienen, aber die Quelle ist nicht offiziell von Meta. Heute gingen die durchgesickerten Nachrichten über das neue Llama-Großmodell auf Reddit viral. Zusätzlich zum Basismodell enthält es auch Benchmark-Ergebnisse von 8B, 70B und den maximalen Parameter von 405B. Die folgende Abbildung zeigt die Vergleichsergebnisse jeder Version von Llama3.1 mit OpenAIGPT-4o und Llama38B/70B. Es ist ersichtlich, dass selbst die 70B-Version in mehreren Benchmarks GPT-4o übertrifft. Bildquelle: https://x.com/mattshumer_/status/1815444612414087294 Offensichtlich Version 3.1 von 8B und 70

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Gestern Abend hat Meta die Modelle Llama38B und 70B veröffentlicht. Das anweisungsoptimierte Modell Llama3 ist für Dialog-/Chat-Anwendungsfälle optimiert und übertrifft viele bestehende Open-Source-Chat-Modelle in gängigen Benchmarks. Zum Beispiel Gemma7B und Mistral7B. Das Llama+3-Modell verbessert Daten und Skalierung und erreicht neue Höhen. Es wurde mit mehr als 15T Datentokens auf zwei benutzerdefinierten 24K-GPU-Clustern trainiert, die kürzlich von Meta veröffentlicht wurden. Dieser Trainingsdatensatz ist siebenmal größer als Llama2 und enthält viermal mehr Code. Dies bringt die Leistungsfähigkeit des Llama-Modells auf das derzeit höchste Niveau, das Textlängen von mehr als 8 KB unterstützt, doppelt so viel wie Llama2. unter

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Gerade jetzt wurde das lang erwartete Llama 3.1 offiziell veröffentlicht! Meta gab offiziell bekannt, dass „Open Source eine neue Ära einläutet“. Im offiziellen Blog sagte Meta: „Bis heute sind große Open-Source-Sprachmodelle hinsichtlich Funktionalität und Leistung meist hinter geschlossenen Modellen zurückgeblieben. Jetzt läuten wir eine neue Ära ein, die von Open Source angeführt wird. Wir haben MetaLlama3.1405B öffentlich veröffentlicht.“ , von dem wir glauben, dass es sich um das größte und leistungsfähigste Open-Source-Basismodell der Welt handelt, die Gesamtzahl der Downloads aller Llama-Versionen hat gerade 300 Millionen Mal überschritten, und wir haben gerade erst damit begonnen, eine zu schreiben Artikel. Langer Artikel „OpenSourceAIIsthePathForward“,

Was bedeutet META?

Mar 05, 2024 pm 12:18 PM

Was bedeutet META?

Mar 05, 2024 pm 12:18 PM

META bezieht sich normalerweise auf eine virtuelle Welt oder Plattform namens Metaverse. Das Metaversum ist eine von Menschen mithilfe digitaler Technologie geschaffene virtuelle Welt, die die reale Welt widerspiegelt oder über sie hinausgeht und mit der realen Welt interagieren kann. Es handelt sich um einen digitalen Lebensraum mit einem neuen sozialen System.

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 ist da! Gerade wurde die offizielle Website von Meta aktualisiert und die offiziellen Versionen der Parameter Llama 38 Milliarden und 70 Milliarden angekündigt. Und es ist nach seiner Einführung ein Open-Source-SOTA: Offizielle Daten von Meta zeigen, dass die Llama38B- und 70B-Versionen alle Konkurrenten in ihren jeweiligen Parameterskalen übertreffen. Das 8B-Modell übertrifft Gemma7B und Mistral7BInstruct bei vielen Benchmarks wie MMLU, GPQA und HumanEval. Das 70B-Modell hat das beliebte Closed-Source-Brathähnchen Claude3Sonnet übertroffen und ist mit Googles GeminiPro1.5 hin und her gegangen. Sobald der Huggingface-Link veröffentlicht wurde, war die Open-Source-Community wieder aufgeregt. Auch die scharfsichtigen, blinden Schüler entdeckten es sofort

Es wird erwartet, dass Meta im Jahr 2024 einen revolutionären AR-Brillen-Prototyp namens „Orion' auf den Markt bringen will.

Jan 04, 2024 pm 09:35 PM

Es wird erwartet, dass Meta im Jahr 2024 einen revolutionären AR-Brillen-Prototyp namens „Orion' auf den Markt bringen will.

Jan 04, 2024 pm 09:35 PM

Laut Nachrichten vom 24. Dezember setzt Meta, ein Technologieunternehmen mit großem Einfluss in der Social-Media-Branche, nun große Erwartungen an Augmented-Reality-Brillen (AR), eine Technologie, die als Computerplattform der nächsten Generation gilt. Kürzlich gab der technische Direktor von Meta, Andrew Bosworth, in einem Interview bekannt, dass das Unternehmen voraussichtlich im Jahr 2024 einen fortschrittlichen AR-Brillen-Prototyp mit dem Codenamen „Orion“ auf den Markt bringen wird. Meta investiert seit langem ebenso viel in die AR-Technologie wie in andere Bereiche. Sie haben riesige Summen investiert, die sich auf Milliarden von Dollar belaufen, mit dem Ziel, ein revolutionäres Produkt zu entwickeln, das mit dem iPhone vergleichbar ist. Obwohl sie letztes Jahr das Ende der Massenproduktionspläne für Orion-Brillen angekündigt hatten,

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Seit Metas Erstveröffentlichung von Quest 3 (aktuell 499,99 $ bei Amazon) ist mittlerweile über ein Jahr vergangen. Seitdem hat Apple das deutlich teurere Vision Pro ausgeliefert, während Byte Dance nun in China die Pico 4 Ultra vorgestellt hat. Es gibt jedoch eine