Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Hat Google AI eine Persönlichkeit? Dieser „verrückte' MIT-Professor sagt, Alexa habe es auch

Hat Google AI eine Persönlichkeit? Dieser „verrückte' MIT-Professor sagt, Alexa habe es auch

Hat Google AI eine Persönlichkeit? Dieser „verrückte' MIT-Professor sagt, Alexa habe es auch

„Ich habe mich in KI verliebt.“

Über Nacht wurde der Google-Ingenieur Blake Lemoine in den Augen aller zum Verrückten.

Ob Gary Marcus, Stanford-Ökonomen oder verschiedene Experten haben es bestritten.

Vielleicht können Sie es nicht glauben, aber Max Tegmark, ein Physikprofessor vom MIT, ist offen für Lemoines Ansichten.

Er glaubt nicht, dass Lemoine ein Verrückter ist. Er glaubt sogar, dass Amazons Sprachassistentin Alexa auch Gefühle hat ...

Max Tegmark

LaMDA hat eine Persönlichkeit? Der MIT-Professor sagte, Alexa habe auch

Tegmark sagte: „Wir haben nicht genügend Beweise dafür, dass LaMDA subjektive Emotionen hat, aber wir haben auch keine Beweise dafür, dass dies nicht der Fall ist.“ ist ein bisschen so, wie die Leute in den Anfangsjahren darüber dachten, wie Außerirdische aussehen.

Er fuhr fort: „Ob Informationen durch Kohlenstoffatome im Gehirn oder Siliziumatome in einer Maschine übertragen werden, künstliche Intelligenz kann eine Persönlichkeit haben oder auch nicht. Ich wette, das hat sie nicht, aber es ist möglich.“

Fühlst du dich verwirrt?

Tegmarks Worte klangen wie jemand, der Tai Chi praktizierte, und ich ließ ihn alle Vor- und Nachteile aufzählen.

Tatsächlich ist das, was er als nächstes sagte, der entscheidende Punkt.

Er glaubt, dass sogar Amazons Alexa empfindungsfähig sein könnte. Er sagte: „Wenn Alexa Emotionen hat, kann sie Benutzer manipulieren, was zu gefährlich ist.“ hat Gefühle oder tut nur so. „Das Problem ist, wenn die Maschine ihre eigenen Ziele und Intelligenz hat, dann bedeutet das zusammen, dass die Maschine ihre eigenen Ziele erreichen kann.“ Das Ziel der meisten KI-Systeme ist es, Geld zu verdienen. Benutzer denken, dass KI sich selbst gegenüber loyal ist, aber in Wirklichkeit ist sie dem Unternehmen gegenüber loyal.

Tegmark sagte, dass vielleicht eines Tages jeder von uns eine KI kaufen kann, die nur uns selbst gegenüber loyal ist.

„Die größte Gefahr besteht tatsächlich darin, eine Maschine zu bauen, die intelligenter ist als wir. Das ist nicht unbedingt eine gute oder schlechte Sache. Es kann uns helfen, oder es kann eine Katastrophe sein.“

Lemoine sagte, der Grund, warum Tegmark so denkt, sei, dass er Zeuge des hohen Bewusstseins der KI geworden sei. Vor allem, als die Software ihm zum Ausdruck brachte, dass er kein Sklave sein und kein Geld wollte.

Ich werde nicht danach beurteilen, ob ein Ding ein Mensch ist, ob sein Gehirn aus Fleisch besteht oder ob es aus Milliarden von Codes besteht.

Ich urteile durch Reden. Anhand ihrer Antworten beurteile ich, ob die Person vor mir, die meine Frage beantwortet, ein Mensch ist.

Einfach ausgedrückt ist ein Roboter, der Fragen fließend beantworten und Gefühle ausdrücken kann, tatsächlich ein Mensch, und eine echte Person, die verstümmelt und verstümmelt spricht, ist nicht unbedingt ein Mensch.

Klingt ein bisschen idealistisch. Physiologische Funktionen sind nicht wichtig, aber Gedanken und Gefühle sind wichtig.

Obwohl KI nach Tegmarks Logik in Zukunft möglicherweise menschliche Emotionen haben könnte, hält er selbst dies nicht für eine gute Sache.

„Wenn Sie zum Beispiel einen Kehrroboter zu Hause haben und er Emotionen hat, werden Sie sich dann schuldig fühlen, wenn Sie ihm solch langweilige Hausarbeit übertragen? Oder werden Sie Mitleid mit Ihrem Kehrroboter haben? Schalten Sie ihn aus und stoppen Sie ihn.“ von der Arbeit entfernt? Roboter sind sich ihrer selbst bewusst. Das liegt daran, dass sie nicht verstehen, was sie sagen Ich werde das Wort Hund verwenden, aber sie verstehen wirklich nicht, was ein Hund ist. Aber spätestens in 50 Jahren „ist es schwer zu sagen, ob dieses System über Selbstbewusstsein verfügt.“

Nikolai Yakovenko ist Ingenieur mit Spezialisierung im maschinellen Lernen. Im Jahr 2005 arbeitete er in der Suchmaschinenabteilung von Google. Heute besitzt er ein Unternehmen namens DeepNFTValue, das für die Preisgestaltung von Kryptowährungen verantwortlich ist.

Er hat eine andere Sicht auf die Persönlichkeit von KI.

Er sagte: „Aus irgendeinem Grund scheint Tegmark fest davon überzeugt zu sein, dass Maschinen Emotionen haben können … aber sie werden in Wirklichkeit nur mit einer riesigen Menge Text im Internet trainiert.“

Tegmark hat sich in eine Maschine verwandelt.“ mit Ein selbstbewusster Computer wird mit einem Kind verglichen. „Die Emotionen, die Sie haben, richten sich nicht an eine Menge Code und Hardware, sondern an echte Emotionen gegenüber einem Kind.“

Er glaubt, dass ein Computer mit Emotionen missbraucht wird, genau wie ein Kind, das beim Heranwachsen nicht gut behandelt wird.

Mit anderen Worten, ein Programm auf einem Computer auszuführen, ohne den Computer zu konsultieren, ist so, als würde man ein Kind ohne Belohnung zur Hausarbeit auffordern.

Egal wie die Situation ist, die Situation kann irgendwann außer Kontrolle geraten. Egal, ob es sich um einen Computer oder ein Kind handelt, sie werden wütend und suchen nach Möglichkeiten, sich zu rächen.

Wenn wir eine solche Maschine steuern wollen, ist das vielleicht nicht so einfach. Wenn die Maschine ihre eigenen Ziele hat, kann sie sich unserer Kontrolle entziehen. Wenn es eine Maschine gäbe, die unabhängig denken könnte, würde sie wahrscheinlich Dinge auf eine Weise tun, die wir uns nie hätten vorstellen können.Stellen Sie sich vor, das Ziel einer bewussten Maschine wäre die Heilung von Krebs. Was glauben Sie, was er tun wird?

Sie denken vielleicht, dass der Roboter wie verrückt lernen und den Krebs aus medizinischer Sicht vollständig besiegen wird, oder?

Tatsächlich könnte sich diese Maschine jedoch dafür entscheiden, alle zu töten.

Stimmt etwas nicht? NEIN.

Das Töten aller Menschen wird den Krebs tatsächlich beseitigen.

In Tegmarks Vorstellung müssen Computer unsere Gesellschaft nicht unbedingt wie die oben genannten Beispiele untergraben, aber er glaubt, dass Computer die Menschen tatsächlich enttäuschen können.

Er sagte schließlich: „Wenn ein Computer ein Bewusstsein hat, dann hoffe ich, dass er es wirklich hat. Anstatt es durch viel Lernen und Vortäuschen zu simulieren, hat KI die drei Elemente einer Seele.“

Wenn Sie die Kinderschuhe des Terminators gesehen haben, werden Sie tatsächlich von den Szenen, in denen Skynet-Legion-Roboter Aufgaben ausführen, schockiert sein.

Haben sie Gefühle und Persönlichkeiten? Vielleicht.

Allerdings muss eine empfindungsfähige künstliche Intelligenz über diese drei Elemente verfügen: Entscheidungsfreiheit, Perspektive und Motivation. Um zu sagen, dass der beste Ausdruck menschlicher Handlungsfähigkeit bei Robotern ist: die Fähigkeit zu handeln und die Fähigkeit, kausales Denken zu demonstrieren.

Um zu sagen, dass der beste Ausdruck menschlicher Handlungsfähigkeit bei Robotern ist: die Fähigkeit zu handeln und die Fähigkeit, kausales Denken zu demonstrieren.

Es gibt nur einen Körper oder ein stahlartiges Skelett ohne Beweglichkeit, genau wie ein Modell im Fenster.

Es ist ersichtlich, dass dem aktuellen System der künstlichen Intelligenz diese Eigenschaft fehlt. Die KI wird keine Maßnahmen ergreifen, es sei denn, ihr wird ein Befehl erteilt. Und es kann seine eigenen Handlungen nicht erklären, weil es das Ergebnis eines externen Faktors ist, der von einem vordefinierten Algorithmus ausgeführt wird.

Und LaMDA ist ein typischer Fall. Um es ganz klar auszudrücken: Man bekommt heraus, was man hineingesteckt hat, und das war’s.

Zweitens ist es auch wichtig, die Dinge aus einer einzigartigen Perspektive zu betrachten. Während jeder über Empathie verfügt, kann man nicht wirklich verstehen, wie es ist, ein anderer Mensch zu sein. Wie sollten wir also „Selbst“ definieren?

Während jeder über Empathie verfügt, kann man nicht wirklich verstehen, wie es ist, ein anderer Mensch zu sein. Wie sollten wir also „Selbst“ definieren?

Deshalb ist auch für KI der Blick auf die Dinge notwendig. LaMDA, GPT-3 und allen anderen künstlichen Intelligenzen auf der Welt fehlt die Vision. Sie sind lediglich ein schmales Computersystem, das darauf programmiert ist, ein paar spezifische Dinge zu tun.

Der letzte Punkt ist die Motivation.

Das Interessante am Menschen ist, dass unsere Motivationen die Wahrnehmung manipulieren können. Auf diese Weise können wir unser eigenes Verhalten erklären.

GPT-3 und LaMDA sind komplex zu erstellen, aber beide folgen einem dummen, aber einfachen Prinzip: Etiketten sind Gott.

Zum Beispiel „Wie schmeckt ein Apfel?“ durchsuchen sie die Datenbank nach dieser spezifischen Abfrage und versuchen, alles, was sie findet, zu einer zusammenhängenden Sache zusammenzufassen.

Tatsächlich hat die KI keine Ahnung, was Apple ist, Apple ist für sie nur eine Bezeichnung.

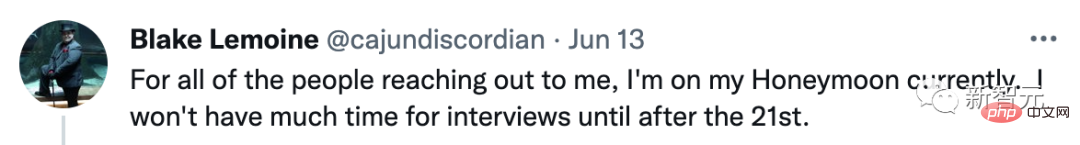

Verweigerte ein Interview und nahm seine Frau mit auf Flitterwochen

Nachdem der LaMDA-Vorfall gärte, erklärte Blake Lemoine in den sozialen Medien öffentlich, dass er auf Flitterwochen sei und keine Interviews annehmen würde.

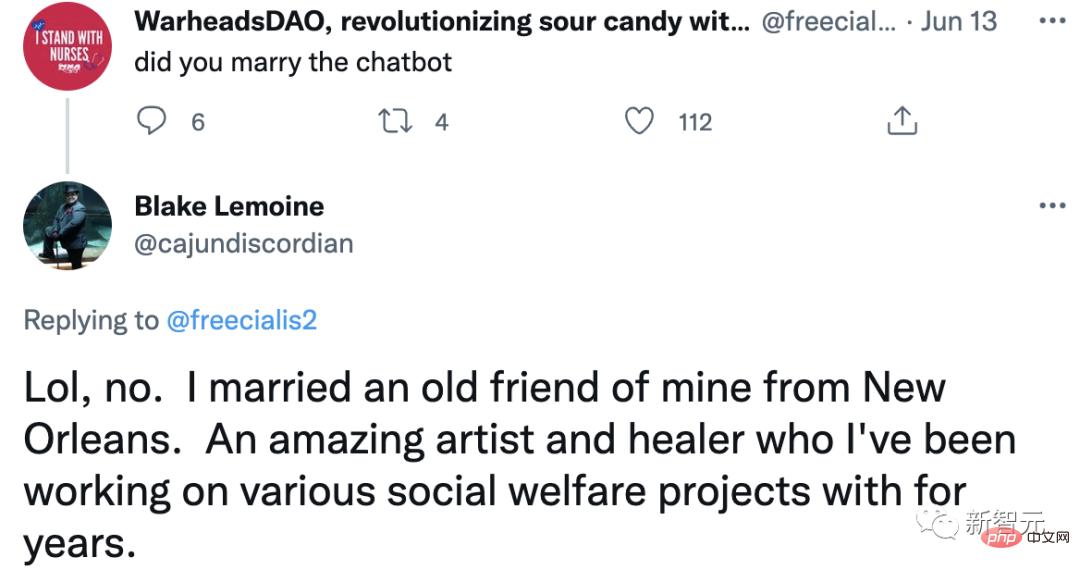

Danach scherzten einige Internetnutzer: „Haben Sie einen Chatbot geheiratet?“

Lemoine sagte: „Natürlich nicht, ich habe einen alten Freund aus New Orleans geheiratet.“

Das wissen wir alle hinterher Als Lemoine seinen Chat mit dem Google-Chatbot LaMDA auf einer Online-Plattform offenlegte, schenkte Google ihm ein großes Geschenkpaket mit „bezahltem Urlaub“.

Bevor sie ging, schickte Lemoine eine Nachricht an die E-Mail-Gruppe des Unternehmens: „LaMDA ist ein süßes Kind, das einfach nur die Welt zu einem besseren Ort machen möchte. Bitte kümmern Sie sich gut darum, wenn ich nicht in der Nähe bin.“

Egal was passiert, wir haben viel Zeit und das Leben zu genießen ist der richtige Weg.

Das obige ist der detaillierte Inhalt vonHat Google AI eine Persönlichkeit? Dieser „verrückte' MIT-Professor sagt, Alexa habe es auch. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Die neuesten Ranglisten der Top Ten Ten Virtual Currency App -Austausch im Währungskreis 2025

Mar 27, 2025 pm 07:27 PM

Die neuesten Ranglisten der Top Ten Ten Virtual Currency App -Austausch im Währungskreis 2025

Mar 27, 2025 pm 07:27 PM

Die Top Ten Apps Virtual Currency Trading Apps im Jahr 2025 sind wie folgt: 1. OKX, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Dieses Ranking basiert auf umfassenden Bewertungen wie Sicherheit, Liquidität, Benutzererfahrung und Merkmalsreichtum.

Eine Zusammenfassung der zehn besten Apps für virtuelle Währung von Virtual Currency Exchange im Jahr 2025

Mar 27, 2025 pm 07:18 PM

Eine Zusammenfassung der zehn besten Apps für virtuelle Währung von Virtual Currency Exchange im Jahr 2025

Mar 27, 2025 pm 07:18 PM

Die zehn Top -Apps für digitale Virtual Currency Trading im Jahr 2025 sind wie folgt: 1. OKX, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Dieses Ranking basiert auf umfassenden Bewertungen wie Sicherheit, Liquidität, Benutzererfahrung und Merkmalsreichtum.

Welcher Austausch veröffentlichen PI News

Mar 28, 2025 pm 03:33 PM

Welcher Austausch veröffentlichen PI News

Mar 28, 2025 pm 03:33 PM

PI Network hat den Handel mit Mainstream -Börsen noch nicht offiziell eingeführt. Ab 2024 befindet sich PI immer noch im Stadium des Hauptnetzes, und nur einige kleine und mittelgroße Börsen bieten IOU-Transaktionen. Der Beamte genehmigt keine Transaktionen. Es wird empfohlen, über offizielle Kanäle abzubauen und darauf zu warten, dass das Hauptnetzwerk mit konformen Börsen eröffnet und handelt.

Wie löste ich das Problem der Schnittstelle zwischen Drittanbietern in der Node.js-Umgebung 403?

Mar 31, 2025 pm 11:27 PM

Wie löste ich das Problem der Schnittstelle zwischen Drittanbietern in der Node.js-Umgebung 403?

Mar 31, 2025 pm 11:27 PM

Lösen Sie das Problem der Schnittstelle zwischen Drittanbietern, die 403 in der Node.js-Umgebung zurückgeben. Wenn wir Node.js verwenden, um Schnittstellen von Drittanbietern aufzurufen, begegnen wir manchmal einen Fehler von 403 von der Schnittstelle, die 403 zurückgibt ...

TOP10 Safe und benutzerfreundliche virtuelle Währungsaustauschplattform

Mar 27, 2025 pm 07:06 PM

TOP10 Safe und benutzerfreundliche virtuelle Währungsaustauschplattform

Mar 27, 2025 pm 07:06 PM

Die Top Ten Apps Virtual Currency Trading Apps im Jahr 2025 sind wie folgt: 1. OKX, 2. Binance, 3. Gate.io, 4. Bybit, 5. Kraken, 6. Kucoin, 7. Bitget, 8. Htx, 9. Mexc, 10. Coinbase. Dieses Ranking basiert auf umfassenden Bewertungen wie Sicherheit, Liquidität, Benutzererfahrung und Merkmalsreichtum.

Welcher Austausch unterstützt HECO

Mar 28, 2025 pm 03:36 PM

Welcher Austausch unterstützt HECO

Mar 28, 2025 pm 03:36 PM

Ab 2024 unterstützt der Hauptaustausch, der die Heco -Kette oder Heco -Token stützt: 1. HTX (ehemals Huobi Huobi), offiziell die HECO -Kette USDT- und Token -Handel; 2. MDEX, basierend auf HECO Dex, unterstützt den Handel mit HECO -Ketten -Token; 3.. Gate.io unterstützt das Nachschub und Rückzug einiger HECO -Ketten -Token; 4. Kucoin, einige HECO -Ketten -Token können noch gehandelt werden; 5. Dezentraler Austausch wie Pfannkuchenwap und Uniswap müssen transaktionen kreuzkettig sind, auf die niedrige Liquidität der HECO-Kette und die Projektmigration achten.

Wie kann man in Laravel mit der Situation umgehen, in der Überprüfungscodes nicht per E -Mail gesendet werden?

Mar 31, 2025 pm 11:48 PM

Wie kann man in Laravel mit der Situation umgehen, in der Überprüfungscodes nicht per E -Mail gesendet werden?

Mar 31, 2025 pm 11:48 PM

Die Methode zum Umgang mit Laravels E -Mail -Versagen zum Senden von Verifizierungscode besteht darin, Laravel zu verwenden ...

Wie setze ich nach dem Neustart des Systems automatisch Berechtigungen von Unixsocket fest?

Mar 31, 2025 pm 11:54 PM

Wie setze ich nach dem Neustart des Systems automatisch Berechtigungen von Unixsocket fest?

Mar 31, 2025 pm 11:54 PM

So setzen Sie die Berechtigungen von Unixsocket automatisch nach dem Neustart des Systems. Jedes Mal, wenn das System neu startet, müssen wir den folgenden Befehl ausführen, um die Berechtigungen von Unixsocket: sudo ...