Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Drahtlose „Seelenkommunikation'! Der Akademiker Cui Tiejun leitet die Entwicklung einer neuen Gehirn-Computer-Superoberfläche, die flexibel und nicht-invasiv ist

Drahtlose „Seelenkommunikation'! Der Akademiker Cui Tiejun leitet die Entwicklung einer neuen Gehirn-Computer-Superoberfläche, die flexibel und nicht-invasiv ist

Drahtlose „Seelenkommunikation'! Der Akademiker Cui Tiejun leitet die Entwicklung einer neuen Gehirn-Computer-Superoberfläche, die flexibel und nicht-invasiv ist

In den letzten Jahren haben Codierungsmetaoberflächen eine Echtzeit- und programmierbare Steuerung elektromagnetischer Funktionen ermöglicht, während frühere elektromagnetische Funktionen in herkömmlichen passiven Geräten entweder statisch oder sehr eingeschränkt waren. Allerdings erfordern solche Metaoberflächen immer noch eine manuelle Bedienung.

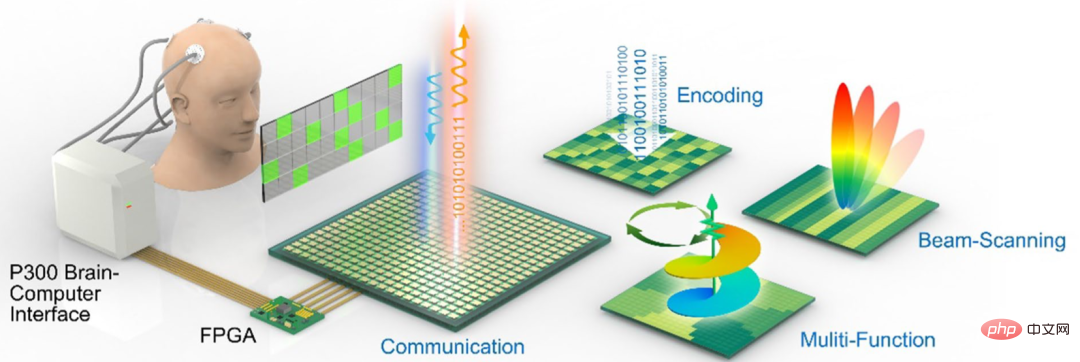

Um die Wünsche von Menschen direkt zu erkennen und zu unterscheiden, schlugen Wissenschaftler anschließend das Konzept der Gehirn-Computer-Schnittstelle (BCI) vor und versuchten, über die Gehirn-Computer-Schnittstelle eine Kommunikation zwischen dem Gehirn und dem Gerät herzustellen und so die Steuerung bereitzustellen programmierbarer Metaoberflächen bietet neue Perspektiven. Durch das Sammeln von Gehirnsignalen aus dem „Spezialhut“ kann die Gehirn-Computer-Schnittstelle die Wünsche des Bedieners entschlüsseln und Befehle an das gesteuerte Objekt senden, ohne dass der Bediener einige komplexe Muskelaktivitäten ausführen muss.

Jetzt ist das Team um Akademiker Cui Tiejun vom State Key Laboratory of Millimeter Waves der Southeast University zusammen mit wissenschaftlichen Forschungseinrichtungen wie der South China University of Technology und der National University of Singapore einen Schritt weiter gegangen und hat ein elektromagnetisches Gerät entwickelt Gehirn-Computer-Metaoberfläche (EBCM).

Berichten zufolge kann diese Metaoberfläche die Informationssynthese und drahtlose Übertragung flexibel und nicht-invasiv steuern, indem sie die Gehirninformationen des Bedieners in Elektroenzephalogramm-Signale (EEG) und dann in verschiedene elektromagnetische Befehle (EM) umwandelt und so eine drahtlose „Gedankenkommunikation“ ermöglicht. zwischen zwei Betreibern.

Wie im Bild unten gezeigt, wird vor dem Bediener ein Monitor mit entsprechenden Befehlen platziert. Durch den einfachen Empfang einfacher Anweisungen kann das EBCM die Absichten des Bedieners verstehen und elektromagnetische Funktionen wie visuelle Strahlabtastung, Wellenmodulationen und Musterkodierung implementieren.

Die entsprechende Forschungsarbeit trägt den Titel „Directly wireless communication of human minds via non-invasive brain-computer-metasurface platform“ und wurde in der Fachzeitschrift eLight veröffentlicht.

Forscher sagten, dass diese Studie den Raum elektromagnetischer Wellen mit einer Gehirn-Computer-Schnittstelle kombiniert, was eine neue Richtung für die Erforschung der tiefen Integration von Metaoberflächen, menschlicher Gehirnintelligenz und künstlicher Intelligenz eröffnet und zum Aufbau einer neuen Generation biointelligenter Technologien beiträgt Metaoberflächensystem.

Verwenden Sie Ihre Gedanken, um „HALLO“ auszugeben

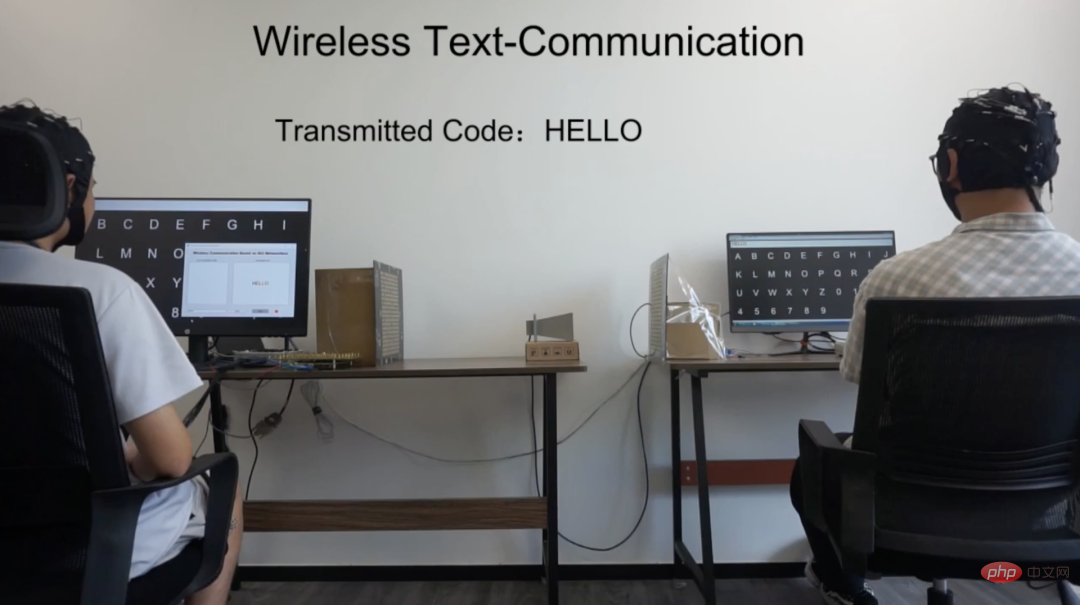

In dieser Studie hat das Forschungsteam drahtlose Textkommunikation auf Basis von EBCM entworfen und experimentell demonstriert.

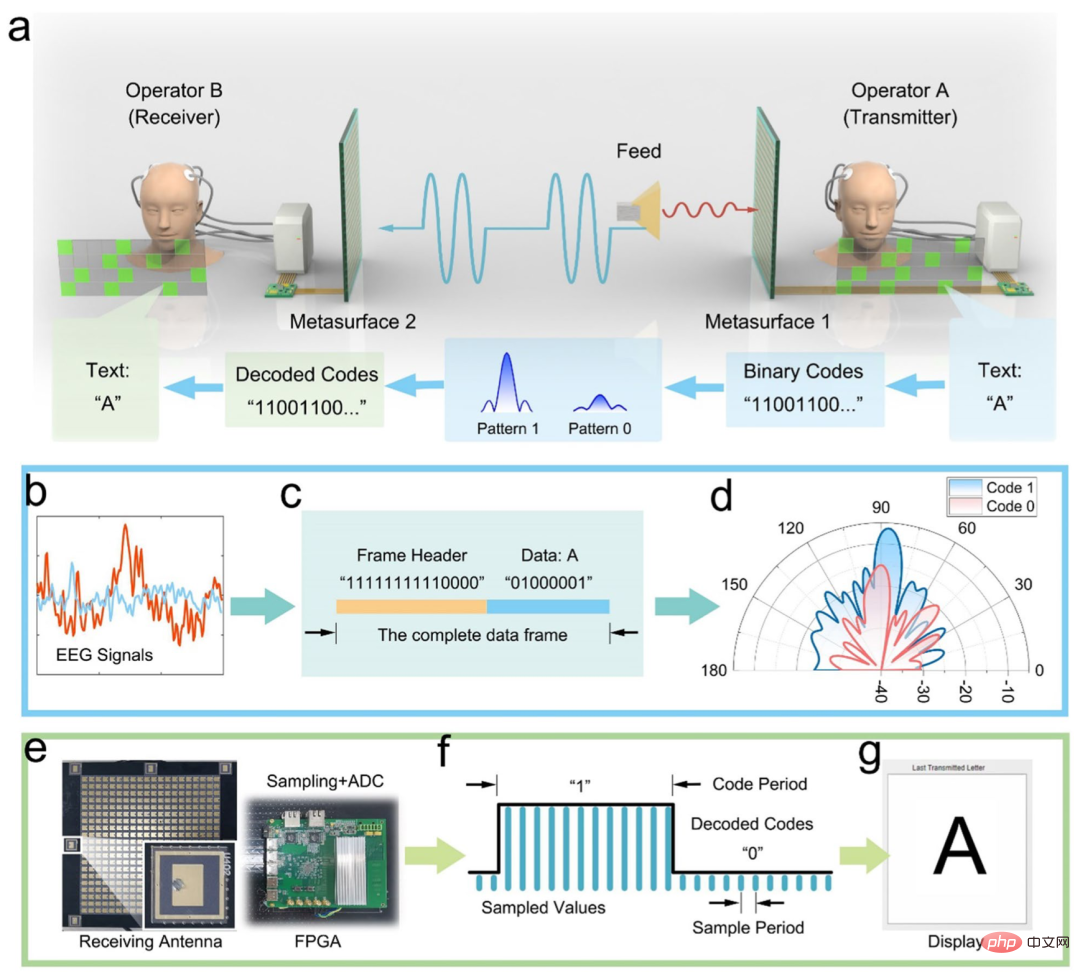

Das Forschungsteam stellt eine textuelle grafische Benutzeroberfläche (GUI) für Bediener von Gehirn-Computer-Schnittstellen bereit, sodass visuelle Schaltflächen direkt in spezifische Kodierungssequenzen bestehend aus „0“ und „1“ kodiert werden können.

Im Experiment wurden ein Einzelstrahlmodus mit hoher Verstärkung und ein Zufallsstreumodus mit niedriger Verstärkung verwendet, um die Amplitude der Metaoberflächenreflexion zu unterscheiden, entsprechend den Codes „1“ (hohe Amplitude) und „0“ (niedrig). ) zur drahtlosen Informationsübertragung verwendet.

Als Demonstration des Prototyps demonstrierten die Forscher die drahtlose Übertragung von Text von einem Bediener zum anderen im EBCM-Kommunikationssystem.

Operator A sendet als Textsender Briefe, indem er die Zeichenschaltflächen auf der EBCM-GUI visuell anzeigt. Beim Dekodieren der Zielbuchstaben aus dem EEG-Signal wird eine ASCII-basierte Kodierungssequenz auf dem FPGA implementiert, um zeitvariable Modi umzuschalten und die Metaoberfläche zu manipulieren, um Informationen in den Raum zu senden, wo sie vom EBCM von Operator B empfangen, demoduliert und präsentiert werden.

Wie im Bild unten gezeigt, zeigte das Forschungsteam den drahtlosen Übertragungsprozess der 5 Buchstaben „HALLO“ und das Wort „HALLO“ wurde erfolgreich auf dem Bildschirm von Operator B angezeigt.

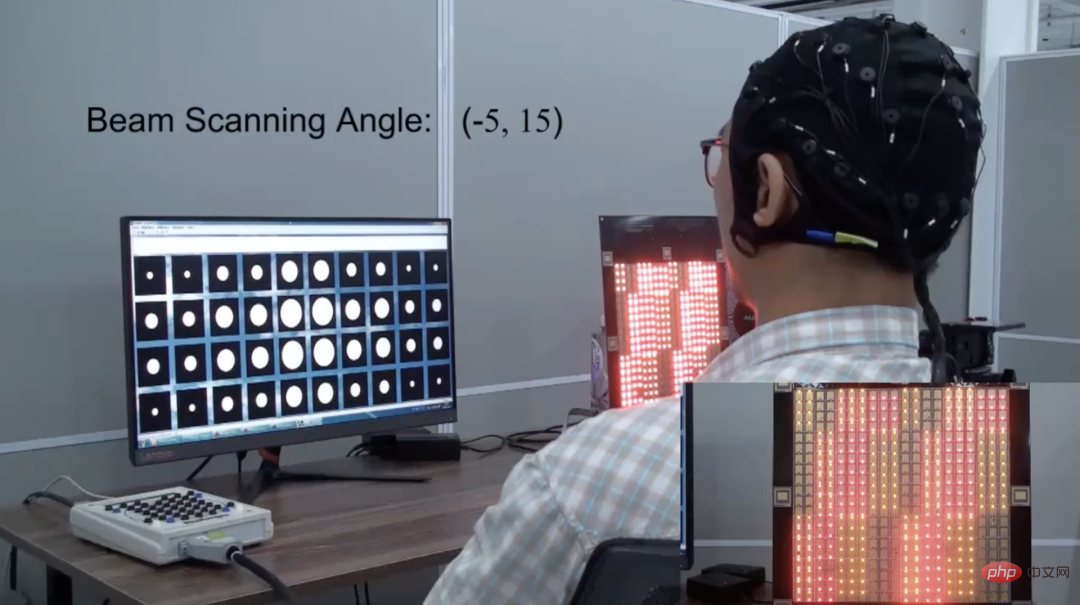

Im visuellen Strahlscanexperiment erreichte der Bediener direkt die gewünschte Strahlscanrichtung, indem er visuell in eine bestimmte Richtung blickte. Nach der Erkennung des EEG des Bedieners kann EBCM das Ausführungskodierungsmuster der relevanten Strahlabtastrichtung anzeigen.

Darüber hinaus demonstrierte das Forschungsteam auch den Musterkodierungsprozess von EBCM. Der Bediener gibt den erforderlichen Code ein, indem er eine bestimmte Taste drückt. Von EBCM erkannte Eingabecodes werden auf dem Bildschirm als gelbe Quadrate angezeigt. Der letzte Code „C4“ ist eine Stoppanweisung, die den Kodierungsprozess beendet und das FPGA anweist, das endgültige Kodierungsmuster zu berechnen. Anschließend führt EBCM die berechneten Kodierungsmuster aus und zeigt sie auf der Metaoberfläche an.

Die oben genannten Experimente zeigen, dass der Bediener keine Bewegungen mehr benötigt, an denen Muskeln beteiligt sind, sondern nur noch auf bestimmte visuelle Tasten starren muss, um eine relevante kontinuierliche Stimulation zu erzielen. EBCM kann diese Stimulationen identifizieren und sie in entsprechende EM-Signale für die Kommunikation umwandeln. .

Was ist eine intelligente Metaoberfläche?

Metaoberfläche bezieht sich auf ein künstliches Schichtmaterial mit einer Dicke, die kleiner als die Wellenlänge ist. Entsprechend der Strukturform in der Ebene können Metaoberflächen in zwei Typen unterteilt werden: Die eine hat eine laterale Subwellenlängen-Feinstruktur und die andere ist eine gleichmäßige Filmschicht. Metaoberflächen können eine flexible und effektive Steuerung der Phase elektromagnetischer Wellen, des Polarisationsmodus, des Ausbreitungsmodus und anderer Eigenschaften realisieren.

Smart Metasurface ist eine wichtige Anwendung von Informationsmetamaterialien im Bereich der Mobilkommunikation. Sein Grundprinzip besteht darin, die elektromagnetischen Eigenschaften von Metamaterialien durch digitale Programmierung zu steuern, die diffuse Reflexion elektromagnetischer Weltraumwellen an gewöhnlichen Wänden zu ändern und die Intelligenz von zu erkennen Die Steuerung und Strahlformung elektromagnetischer Wellen im Weltraum zeichnet sich durch geringen Stromverbrauch und niedrige Kosten aus und wird voraussichtlich eine wichtige Infrastruktur für zukünftige mobile Kommunikationsnetze werden.

Bereits im Jahr 2014 übernahm das Team des Akademikers Cui Tiejun die Führung bei der Realisierung eines intelligenten Metaoberflächen-Hardwaresystems und schuf damit einen Präzedenzfall für die Förderung der Anwendung von Informationsmetamaterialien.

Im Februar dieses Jahres verwendeten das Team des Akademikers Cui Tiejun und seine Mitarbeiter digital codierte Metaoberflächen mit mehrschichtiger Übertragung, um ein vollständig beugendes neuronales Netzwerk (Programmable Artificial Intelligence Machine, PAIM) aufzubauen, das in Echtzeit angepasst werden kann und so erfolgreich Netzwerkparameter erreicht. Echtzeitprogrammierung und Lichtgeschwindigkeitsberechnungseigenschaften, und demonstrierte eine Vielzahl von Anwendungsfällen, einschließlich Bilderkennung, verstärktem Lernen und Kommunikation, Mehrkanalkodierung und -dekodierung usw., zum ersten Mal auf der Welt, einem vollständig diffraktiv einstellbaren neuronalen System Netzwerk im Mikrowellenraum wurde implementiert und demonstriert.

Natürlich beschränken sich die Einsatzszenarien von Metaoberflächen bei weitem nicht darauf.

Die reichen und einzigartigen physikalischen Eigenschaften von Metaoberflächen und ihre Fähigkeit, elektromagnetische Wellen flexibel zu steuern, können ihnen wichtige Anwendungsaussichten in vielen Bereichen wie Stealth-Technologie, Antennentechnologie, Mikrowellen- und Terahertz-Geräten sowie optoelektronischen Geräten eröffnen.

Das obige ist der detaillierte Inhalt vonDrahtlose „Seelenkommunikation'! Der Akademiker Cui Tiejun leitet die Entwicklung einer neuen Gehirn-Computer-Superoberfläche, die flexibel und nicht-invasiv ist. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

3-nm-Prozess, Leistung übertrifft H100! Kürzlich brachten die ausländischen Medien DigiTimes die Nachricht, dass Nvidia die GPU der nächsten Generation, die B100, mit dem Codenamen „Blackwell“ entwickelt, angeblich als Produkt für Anwendungen im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC). Der B100 wird den 3-nm-Prozess von TSMC sowie ein komplexeres Multi-Chip-Modul (MCM)-Design nutzen und im vierten Quartal 2024 erscheinen. Nvidia, das mehr als 80 % des GPU-Marktes für künstliche Intelligenz monopolisiert, kann mit dem B100 zuschlagen, solange das Eisen heiß ist, und in dieser Welle des KI-Einsatzes weitere Herausforderer wie AMD und Intel angreifen. Nach Schätzungen von NVIDIA wird erwartet, dass der Produktionswert dieses Bereichs bis 2027 ungefähr erreicht

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

Die leistungsstarke Kombination aus Diffusions- und Superauflösungsmodellen, der Technologie hinter Googles Bildgenerator Imagen

Apr 10, 2023 am 10:21 AM

In den letzten Jahren hat multimodales Lernen große Aufmerksamkeit erhalten, insbesondere in den beiden Richtungen der Text-Bild-Synthese und des kontrastiven Bild-Text-Lernens. Einige KI-Modelle haben aufgrund ihrer Anwendung bei der kreativen Bilderzeugung und -bearbeitung große öffentliche Aufmerksamkeit erregt, wie beispielsweise die von OpenAI eingeführten Textbildmodelle DALL・E und DALL-E 2 sowie GauGAN und GauGAN2 von NVIDIA. Um nicht zu übertreffen, hat Google Ende Mai sein eigenes Text-zu-Bild-Modell Imagen veröffentlicht, das die Grenzen der untertitelbedingten Bildgenerierung offenbar noch weiter erweitert. Mit nur einer Beschreibung einer Szene kann Imagen eine hohe Qualität und Auflösung erzeugen

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! Es wurde von sieben chinesischen Forschern bei Microsoft verfasst und umfasst 119 Seiten. Es geht von zwei Arten multimodaler Forschungsrichtungen für große Modelle aus, die abgeschlossen wurden und immer noch an der Spitze stehen, und fasst fünf spezifische Forschungsthemen umfassend zusammen: visuelles Verständnis und visuelle Generierung Der vom einheitlichen visuellen Modell LLM unterstützte multimodale Großmodell-Multimodalagent konzentriert sich auf ein Phänomen: Das multimodale Grundmodell hat sich von spezialisiert zu universell entwickelt. Ps. Aus diesem Grund hat der Autor am Anfang des Artikels direkt ein Bild von Doraemon gezeichnet. Wer sollte diese Rezension (Bericht) lesen? Mit den ursprünglichen Worten von Microsoft: Solange Sie daran interessiert sind, das Grundwissen und die neuesten Fortschritte multimodaler Grundmodelle zu erlernen, egal ob Sie ein professioneller Forscher oder ein Student sind, ist dieser Inhalt sehr gut für Sie geeignet.

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

I2V-Adapter aus der SD-Community: keine Konfiguration erforderlich, Plug-and-Play, perfekt kompatibel mit dem Tusheng-Video-Plug-in

Jan 15, 2024 pm 07:48 PM

Die Aufgabe der Bild-zu-Video-Generierung (I2V) ist eine Herausforderung im Bereich Computer Vision, die darauf abzielt, statische Bilder in dynamische Videos umzuwandeln. Die Schwierigkeit dieser Aufgabe besteht darin, dynamische Informationen in der zeitlichen Dimension aus einem einzelnen Bild zu extrahieren und zu generieren und dabei die Authentizität und visuelle Kohärenz des Bildinhalts zu wahren. Bestehende I2V-Methoden erfordern häufig komplexe Modellarchitekturen und große Mengen an Trainingsdaten, um dieses Ziel zu erreichen. Kürzlich wurde ein neues Forschungsergebnis „I2V-Adapter: AGeneralImage-to-VideoAdapter for VideoDiffusionModels“ unter der Leitung von Kuaishou veröffentlicht. Diese Forschung stellt eine innovative Bild-zu-Video-Konvertierungsmethode vor und schlägt ein leichtes Adaptermodul vor, d. h.

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Bekanntgabe des Boltzmann-Preises 2022: Gründer von Hopfield Network gewinnt Auszeichnung

Aug 13, 2023 pm 08:49 PM

Die beiden Wissenschaftler, die den Boltzmann-Preis 2022 gewonnen haben, wurden bekannt gegeben. Diese Auszeichnung wurde vom IUPAP-Komitee für statistische Physik (C3) ins Leben gerufen, um Forscher zu würdigen, die herausragende Leistungen auf dem Gebiet der statistischen Physik erbracht haben. Der Gewinner muss ein Wissenschaftler sein, der zuvor weder einen Boltzmann-Preis noch einen Nobelpreis gewonnen hat. Dieser Preis wurde 1975 ins Leben gerufen und wird alle drei Jahre zum Gedenken an Ludwig Boltzmann, den Begründer der statistischen Physik, verliehen. Grund für die Auszeichnung: In Anerkennung der bahnbrechenden Beiträge von Deepak Dharistheoriginalstatement auf dem Gebiet der statistischen Physik, einschließlich der exakten Lösung selbstorganisierter Systeme kritisches Modell, Schnittstellenwachstum, Störung

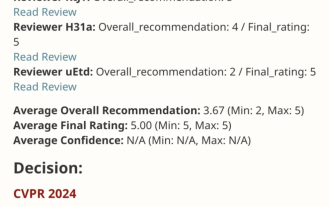

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

VPR 2024 perfektes Ergebnispapier! Meta schlägt EfficientSAM vor: schnell alles aufteilen!

Mar 02, 2024 am 10:10 AM

Diese Arbeit von EfficientSAM wurde mit einer perfekten Bewertung von 5/5/5 in CVPR2024 aufgenommen! Der Autor teilte das Ergebnis in den sozialen Medien mit, wie im Bild unten gezeigt: Der Gewinner des LeCun Turing Award hat dieses Werk ebenfalls wärmstens empfohlen! In einer aktuellen Forschung haben Meta-Forscher eine neue, verbesserte Methode vorgeschlagen, nämlich das Mask Image Pre-Training (SAMI) unter Verwendung von SAM. Diese Methode kombiniert MAE-Vortrainingstechnologie und SAM-Modelle, um hochwertige vorab trainierte ViT-Encoder zu erhalten. Durch SAMI versuchen Forscher, die Leistung und Effizienz des Modells zu verbessern und bessere Lösungen für Sehaufgaben bereitzustellen. Der Vorschlag dieser Methode bringt neue Ideen und Möglichkeiten zur weiteren Erforschung und Entwicklung der Bereiche Computer Vision und Deep Learning. durch die Kombination verschiedener

Der aufstrebende Google-KI-Star wechselt zu Pika: Video-Generation Lumiere fungiert als Gründungswissenschaftler

Feb 26, 2024 am 09:37 AM

Der aufstrebende Google-KI-Star wechselt zu Pika: Video-Generation Lumiere fungiert als Gründungswissenschaftler

Feb 26, 2024 am 09:37 AM

Die Videoproduktion schreitet auf Hochtouren voran und Pika hat einen großartigen General begrüßt: den Google-Forscher Omer Bar-Tal, der als Gründungswissenschaftler von Pika fungiert. Vor einem Monat veröffentlichte Google als Co-Autor das Videogenerierungsmodell Lumiere, und der Effekt war erstaunlich. Damals sagten Internetnutzer: Google beteiligt sich am Kampf um die Videogenerierung und es gibt eine weitere gute Show, die man sich ansehen kann. Einige Leute aus der Branche, darunter der CEO von StabilityAI und ehemalige Kollegen von Google, sandten ihren Segen. Lumieres erstes Werk, Omer Bar-Tal, der gerade seinen Master-Abschluss gemacht hat, schloss 2021 sein Studium an der Fakultät für Mathematik und Informatik der Universität Tel Aviv ab und ging dann zum Weizmann Institute of Science, um einen Master-Abschluss in Computer zu machen Wissenschaft mit Schwerpunkt auf der Forschung im Bereich der Bild- und Videosynthese. Die Ergebnisse seiner Abschlussarbeiten wurden mehrfach veröffentlicht