Heutzutage werden einige Sätze, die sehr menschlich aussehen, tatsächlich von Systemen der künstlichen Intelligenz generiert, die auf großen Mengen menschlichen Textes trainiert wurden. Die Menschen sind es so gewohnt anzunehmen, dass fließende Sprache vom Denken und Fühlen von Menschen herrührt, dass Beweise für das Gegenteil unverständlich sein können und dass ein KI-Modell, wenn es sich fließend ausdrücken kann, auch wie ein Mensch denkt und fühlt.

Daher ist es vielleicht nicht verwunderlich, dass ein ehemaliger Google-Ingenieur kürzlich behauptete, dass Googles künstliches Intelligenzsystem LAMDA selbstbewusst sei, weil es eloquent Texte über seine angeblichen Gefühle generieren könne. Der Vorfall und die anschließende Berichterstattung in den Medien führten zu einer Reihe von Artikeln und Beiträgen, die Zweifel an der Behauptung aufkommen ließen, dass Computermodelle der menschlichen Sprache lebendig seien.

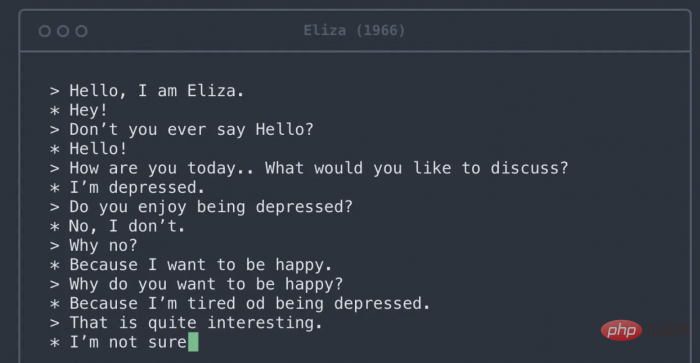

Von Modellen wie Googles LaMDA generierter Text kann schwer von von Menschen geschriebenem Text zu unterscheiden sein. Diese beeindruckende Leistung ist das Ergebnis eines jahrzehntelangen Projekts zur Entwicklung von Modellen, die in der Lage sind, grammatikalisch bedeutungsvolle Sprache zu erzeugen. Die heutigen Modelle mit Daten und Regelsätzen, die sich der menschlichen Sprache annähern, unterscheiden sich in mehreren wichtigen Punkten von diesen frühen Versuchen. Erstens sind sie grundsätzlich im gesamten Internet geschult. Zweitens können sie Beziehungen zwischen weit voneinander entfernten Wörtern lernen, nicht nur zwischen benachbarten Wörtern. Drittens weisen sie so viele interne Optimierungen auf, dass selbst die Ingenieure, die sie entworfen haben, Schwierigkeiten haben zu verstehen, warum sie eine Wortfolge erzeugen und eine andere nicht.

Groß angelegtes Sprachmodell mit künstlicher Intelligenz ermöglicht reibungslose Gespräche. Allerdings haben sie keine Gesamtaussage zu vermitteln, daher neigen ihre Formulierungen dazu, gängigen literarischen Tropen zu folgen, die aus den Texten stammen, an denen sie geschult wurden. Das menschliche Gehirn verfügt über fest verdrahtete Regeln, um auf die Absicht hinter Worten zu schließen. Jedes Mal, wenn Sie sich auf ein Gespräch einlassen, erstellt Ihr Gehirn automatisch ein mentales Modell Ihres Gesprächspartners. Anschließend verwenden Sie das, was sie sagen, um das Modell mit den Zielen, Gefühlen und Überzeugungen der Person zu füllen. Der Übergang von Äußerungen zu mentalen Modellen erfolgt nahtlos und wird jedes Mal ausgelöst, wenn Sie einen vollständigen Satz erhalten. Dieser kognitive Prozess spart Ihnen viel Zeit und Energie im täglichen Leben und erleichtert Ihre sozialen Interaktionen erheblich. Im Falle eines KI-Systems scheitert es jedoch, weil es ein mentales Modell aus dem Nichts aufbaut.

Eine traurige Ironie ist, dass dieselben kognitiven Vorurteile, die es Menschen ermöglichen, großen KI-Sprachmodellen Menschlichkeit zuzuschreiben, auch dazu führen, dass sie echte Menschen unmenschlich behandeln. Soziokulturelle Linguistikforschung zeigt, dass die Annahme einer zu starken Verbindung zwischen fließendem Ausdruck und fließendem Denken zu Vorurteilen gegenüber verschiedenen Menschen führen kann. Beispielsweise werden Menschen mit ausländischem Akzent oft als weniger intelligent angesehen und haben eine geringere Wahrscheinlichkeit, einen Job zu bekommen, für den sie qualifiziert sind. Ähnliche Vorurteile bestehen gegenüber Dialekten, die nicht als prestigeträchtig gelten, etwa dem Südenglischen in den USA, gegenüber gehörlosen Menschen, die Gebärdensprache verwenden, und gegenüber Menschen mit Sprachstörungen wie Stottern. Diese Vorurteile sind sehr schädlich und führen oft zu rassistischen und sexistischen Annahmen, die sich immer wieder als unbegründet erwiesen haben.

Das obige ist der detaillierte Inhalt vonGoogle nutzt künstliche Intelligenz, um Fehler in der menschlichen Wahrnehmung aufzudecken. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Anwendung künstlicher Intelligenz im Leben

Anwendung künstlicher Intelligenz im Leben

Was ist das Grundkonzept der künstlichen Intelligenz?

Was ist das Grundkonzept der künstlichen Intelligenz?

So binden Sie Daten in einer Dropdown-Liste

So binden Sie Daten in einer Dropdown-Liste

Welche Plattform ist besser für den Handel mit virtuellen Währungen?

Welche Plattform ist besser für den Handel mit virtuellen Währungen?

Chinesisches Änderungs-Tutorial für C++-Software

Chinesisches Änderungs-Tutorial für C++-Software

Wie Clearfix das Clearing von Floats implementiert

Wie Clearfix das Clearing von Floats implementiert

Eigenschaften der Zweierkomplementarithmetik

Eigenschaften der Zweierkomplementarithmetik

So lösen Sie javascriptvoid(o)

So lösen Sie javascriptvoid(o)