Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Jeff Deans groß angelegtes Multitasking-Lern-SOTA wurde kritisiert und seine Reproduktion würde 60.000 US-Dollar kosten

Jeff Deans groß angelegtes Multitasking-Lern-SOTA wurde kritisiert und seine Reproduktion würde 60.000 US-Dollar kosten

Jeff Deans groß angelegtes Multitasking-Lern-SOTA wurde kritisiert und seine Reproduktion würde 60.000 US-Dollar kosten

Im Oktober 2021 schrieb Jeff Dean persönlich einen Artikel, in dem er eine neue Architektur für maschinelles Lernen vorstellte – Pathways.

Der Zweck ist ganz einfach: Eine KI soll in die Lage versetzt werden, Zehntausende Aufgaben abzudecken, verschiedene Arten von Daten zu verstehen und dies gleichzeitig mit extrem hoher Effizienz zu erreichen:

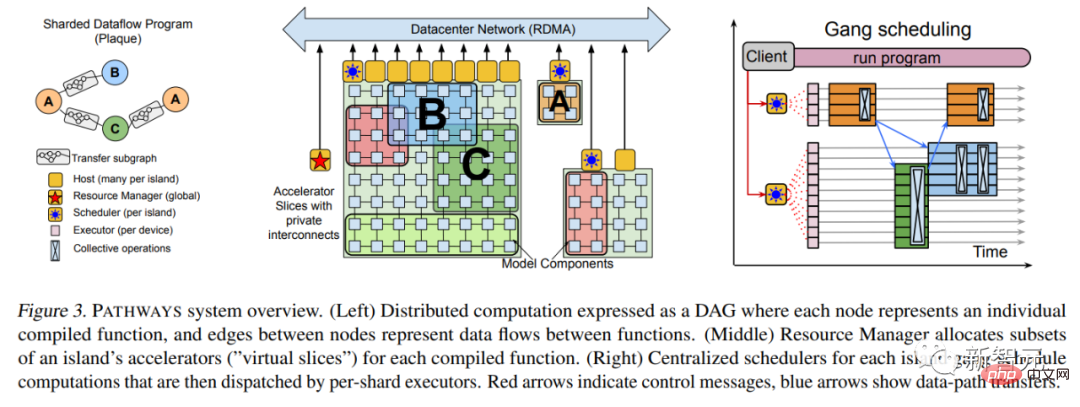

Im März 2022 , mehr als ein halbes Jahr später Im März veröffentlichte Jeff Dean endlich das Pathways-Papier.

Papierlink: https://arxiv.org/abs/2203.12533

Darin werden viele technische Details hinzugefügt, wie zum Beispiel die grundlegendste Systemarchitektur und so weiter.

Im April 2022 nutzte Google das PaLM-Sprachmodell von Pathways und brach die SOTA mehrerer natürlicher Sprachverarbeitungsaufgaben nacheinander. Dieses Transformer-Sprachmodell mit 540 Milliarden Parametern bewies erneut, dass „große Anstrengungen Wunder bewirken können“. ."

Zusätzlich zur Verwendung des leistungsstarken Pathways-Systems stellt das Papier vor, dass das Training von PaLM 6144 TPU v4 verwendet, einen hochwertigen Datensatz von 780 Milliarden Token und einen bestimmten Anteil an nicht-englischem mehrsprachigem Korpus verwendet.

Papieradresse: https://arxiv.org/abs/2204.02311

Kürzlich hat ein neues Werk von Jeff Dean Spekulationen über Pathways ausgelöst.

Ist ein weiteres Teil des Pathways-Puzzles zusammengesetzt?

Es gibt nur zwei Autoren dieses Artikels: den berühmten Jeff Dean und den italienischen Ingenieur Andrea Gesmundo.

Das Interessante ist, dass Gesmundo nicht nur sehr zurückhaltend ist, sondern dass Jeff Dean, der vor zwei Tagen gerade sein eigenes Imagen in die Luft gesprengt hat, es auf Twitter überhaupt nicht erwähnt hat.

Nachdem sie es gelesen hatten, spekulierten einige Internetnutzer, dass dies eine Komponente der KI-Architektur Pathways der nächsten Generation sein könnte.

Papieradresse: https://arxiv.org/abs/2205.12755

Die Idee dieses Artikels ist folgende:

Durch die dynamische Integration neuer Aufgaben in ein großes laufendes System, Spärliche Multidaten können ausgenutzt werden. Modellfragmente für maschinelles Lernen werden zur Verbesserung der Qualität neuer Aufgaben verwendet und können Modellfragmente automatisch zwischen verwandten Aufgaben teilen.

Dieser Ansatz kann die Qualität jeder Aufgabe verbessern und die Modelleffizienz in Bezug auf Konvergenzzeit, Anzahl der Trainingsinstanzen, Energieverbrauch usw. verbessern. Das in diesem Artikel vorgeschlagene Framework für maschinelle Lernprobleme kann als Verallgemeinerung und Synthese standardmäßiger Multitasking- und kontinuierlicher Lernformalisierungen betrachtet werden.

In diesem Rahmen kann die gestellte Aufgabe, egal wie groß sie ist, gemeinsam gelöst werden.

Und im Laufe der Zeit kann das Aufgabenset durch das Hinzufügen eines kontinuierlichen Stroms neuer Aufgaben erweitert werden. Auch die Unterscheidung zwischen Pre-Training-Aufgaben und Downstream-Aufgaben verschwindet.

Denn wenn neue Aufgaben hinzugefügt werden, sucht das System nach Möglichkeiten, vorhandenes Wissen und Darstellungen mit neuen Modellfunktionen zu kombinieren, um für jede neue Aufgabe ein hohes Qualitätsniveau zu erreichen. Das beim Lösen einer neuen Aufgabe erlernte Wissen und die Darstellungen können auch für zukünftige Aufgaben oder zum Weiterlernen an bestehenden Aufgaben verwendet werden.

Diese Methode heißt „Mutation Multi-Task Network“ oder µ2Net. (μ=Mutation)

Zwei Arten von Mutationsmodellen für groß angelegte kontinuierliche Lernexperimente

Einfach ausgedrückt geht es darum, ein großes Multitasking-Netzwerk zu schaffen, um mehrere Aufgaben gemeinsam zu lösen. Es wird nicht nur die Qualität und Effizienz jeder Aufgabe verbessert, sondern das Modell kann auch durch dynamisches Hinzufügen neuer Aufgaben erweitert werden.

Je mehr im System eingebettetes Wissen durch das Erlernen früherer Aufgaben angesammelt wird, desto höher ist die Qualität der Lösungen für Folgeaufgaben.

Darüber hinaus kann durch die Reduzierung der neu hinzugefügten Parameter jeder Aufgabe die Effizienz bei der Lösung neuer Aufgaben kontinuierlich verbessert werden. Das generierte Multitask-Modell wird nur spärlich aktiviert und das Modell integriert einen aufgabenbasierten Routing-Mechanismus. Mit der Erweiterung des Modells ist der Anstieg der Rechenkosten für jede Aufgabe garantiert begrenzt.

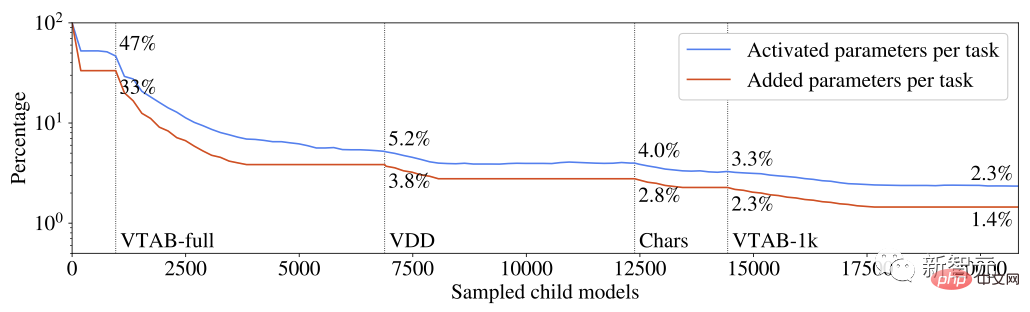

Der Prozentsatz der von jeder Aufgabe aktivierten und erhöhten Parameter an der Gesamtzahl der Parameter des Multitask-Systems

Das aus jeder Aufgabe gelernte Wissen ist in Teile unterteilt, die von mehreren Aufgaben wiederverwendet werden können. Experimente haben gezeigt, dass diese Chunking-Technik häufige Probleme von Multitasking- und kontinuierlichen Lernmodellen vermeidet, wie z. B. katastrophales Vergessen, Gradienteninterferenz und negative Übertragung.

Die Erkundung des Aufgabenroutenraums und die Identifizierung der relevantesten Teilmenge des Vorwissens für jede Aufgabe wird von einem evolutionären Algorithmus geleitet, der das Gleichgewicht zwischen Erkundung und Ausbeutung dynamisch anpasst, ohne dass manuelle Anpassungen der Metaparameter erforderlich sind. Dieselbe Evolutionslogik wird verwendet, um Hyperparameter-Multitask-Modellkomponenten dynamisch anzupassen.

Da es „Mutationsnetzwerk“ heißt, wie erklären Sie sich diese Mutation?

Tiefe neuronale Netze werden oft durch Architektur und Hyperparameter definiert. Die Architektur in diesem Artikel besteht aus einer Reihe neuronaler Netzwerkschichten. Jede Schicht ordnet einen Eingabevektor einem Ausgabevektor mit variabler Dimension zu, und Details der Netzwerkinstanziierung, wie etwa die Konfiguration des Optimierers oder die Datenvorverarbeitung, werden durch Hyperparameter bestimmt.

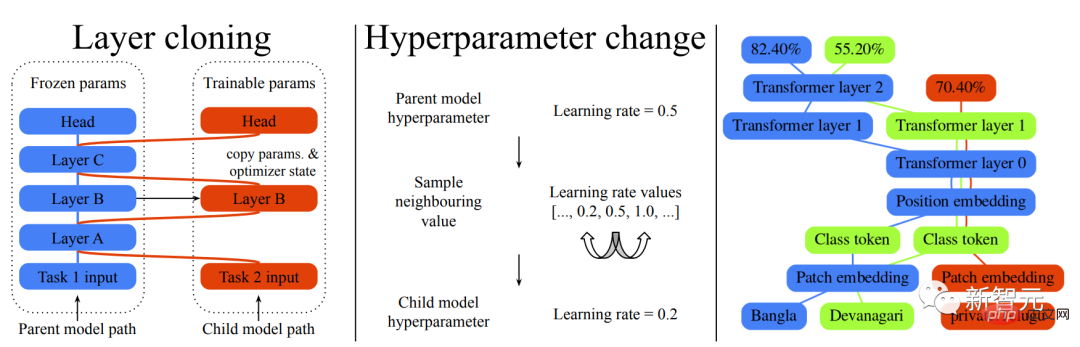

Die hier genannten Mutationen sind also auch in zwei Kategorien unterteilt: Layer-Cloning-Mutationen und Hyperparameter-Mutationen.

Die Layer-Klon-Mutation erstellt eine Kopie jeder übergeordneten Modellebene, die vom untergeordneten Modell trainiert werden kann. Wenn eine Ebene des übergeordneten Modells nicht zum Klonen ausgewählt wird, wird der aktuelle Status eingefroren und mit dem untergeordneten Modell geteilt, um die Invarianz des bereits vorhandenen Modells sicherzustellen.

Hyperparameter-Mutation wird verwendet, um die Konfiguration zu ändern, die die untergeordnete Ebene von der übergeordneten Ebene geerbt hat. Der neue Wert für jeden Hyperparameter kann aus einer Reihe gültiger Werte gezogen werden. Bei numerischen Hyperparametern wird der Satz gültiger Werte als Liste sortiert und die Stichprobe auf benachbarte Werte beschränkt, um eine inkrementelle Änderungsbeschränkung anzuwenden.

Werfen wir einen Blick auf den tatsächlichen Effekt:

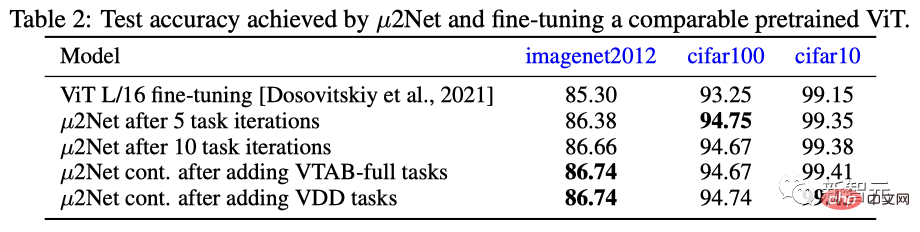

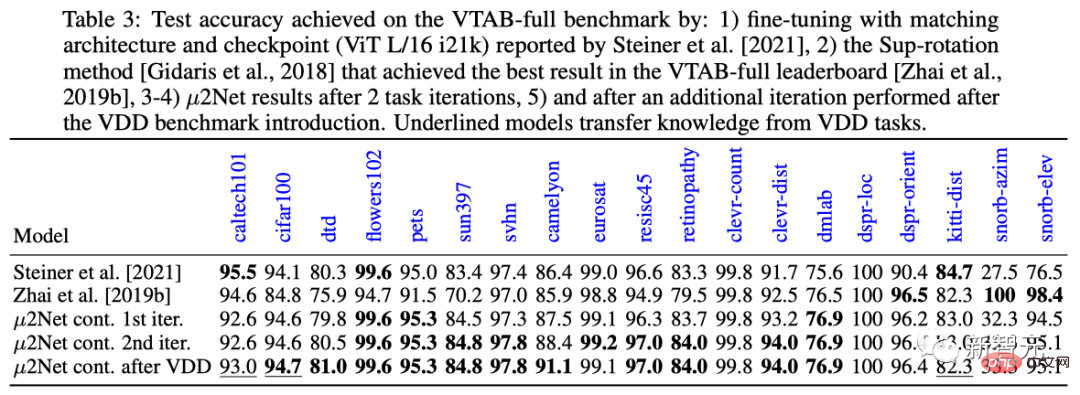

In den drei Datensätzen von ImageNet 2012, cifar100 und cifar10, übertraf die Leistung von µ2Net nach 5 Aufgabeniterationen und 10 Aufgabeniterationen die aktuell allgemeinste und leistungsstärkste Leistung Gutes vorab trainiertes, fein abgestimmtes ViT-Modell.

In Bezug auf die Aufgabenerweiterung wurde die Leistung von µ2Net nach dem Hinzufügen von VTAB-vollständigen und VDD-Lernaufgaben weiter verbessert. Die Leistung der VDD-Lernaufgaben im cifar10-Datensatz hat das beste Ergebnis von 99,43 % erreicht.

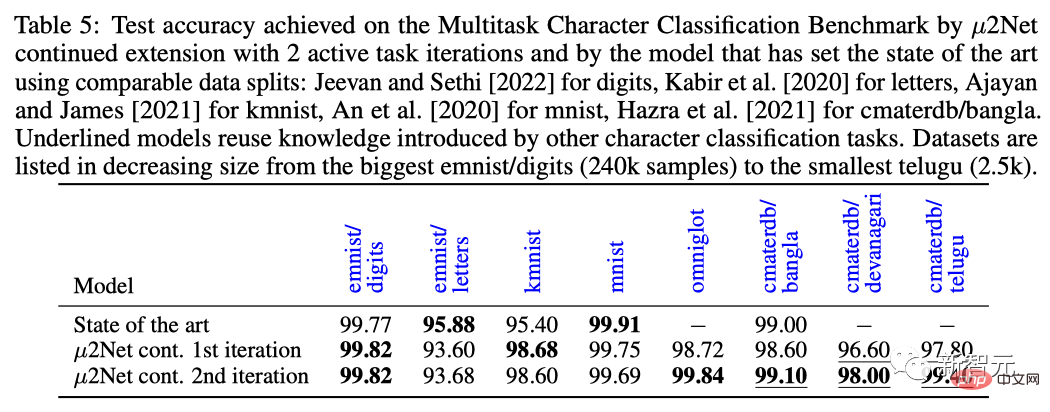

Bei der Multitask-Benchmark-Aufgabe zur Zeichenklassifizierung aktualisierte µ2Net nach zwei Aufgabeniterationen die SOTA-Ebene für die meisten Datensätze, wobei die Datensatzgrößen zwischen 2,5.000 und 240.000 Stichprobengrößen lagen.

Einfach ausgedrückt: Je mehr Aufgaben das Modell lernt, desto mehr Wissen lernt das System und desto einfacher ist es, neue Aufgaben zu lösen.

Zum Beispiel kann sich eine ViT-L-Architektur (307 Millionen Parameter) zu einem Multitask-System mit 130,87 Milliarden Parametern entwickeln und 69 Aufgaben lösen.

Darüber hinaus hält die spärliche Parameteraktivierung den Rechenaufwand und die Speichernutzung jeder Aufgabe konstant, wenn das System wächst. Experimente zeigen, dass die durchschnittliche Anzahl hinzugefügter Parameter für jede Aufgabe um 38 % reduziert wird, während das Multitask-System nur 2,3 % der Gesamtparameter für jede Aufgabe aktiviert.

Natürlich ist es zum jetzigen Zeitpunkt nur eine Architektur und ein Vorversuch.

Netizen: Das Papier ist sehr gut, aber...

Obwohl das Papier großartig ist, scheinen einige Leute es nicht zu kaufen.

Einige Internetnutzer, die es lieben, die neuen Kleider des Kaisers zu enthüllen, haben auf reddit gepostet und gesagt, dass sie nicht mehr an die Liebe glauben ... Oh nein, es ist ein KI-Papier, das von einem „Top-Labor/einer Spitzenforschungseinrichtung“ erstellt wurde.

Der Internetnutzer mit der ID „Mr. Acurite“ sagte, dass er natürlich an die Daten und Modellbetriebsergebnisse in diesen Papieren glaube.

Aber nehmen Sie diesen Artikel von Lehrer Jeff Dean als Beispiel. Der 18-seitige Artikel handelt von einem besonders komplexen evolutionären Faltungs- und Multitasking-Lernalgorithmus. Er ist leistungsstark, auffällig und hochgelobt.

Es müssen jedoch zwei Punkte beachtet werden:

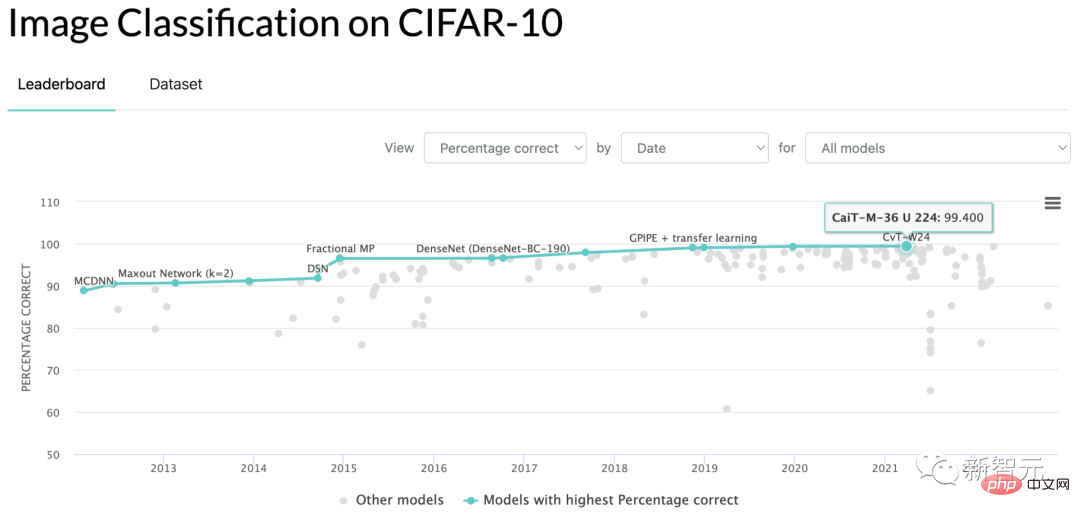

Erstens entsprechen die von Jeff Dean in der Arbeit vorgeschlagenen Running-Score-Ergebnisse, um zu beweisen, dass sie besser als Konkurrenzprodukte sind, der CIFAR-10-Benchmark-Genauigkeit von 99,43, was besser ist, als die aktuellen SOTA-Werte von 99,40 zu übertreffen ...

Ich kann nicht sagen, dass es eine Lüge ist, aber es ist wirklich schwer, es in Worte zu fassen.

Zweitens gibt es am Ende des Artikels eine Zeitverbrauchstabelle für die Verwendung des TPU-Laufalgorithmus, um die Endergebnisse zu erhalten, insgesamt 17810 Stunden.

Angenommen, jemand arbeitet nicht bei Google und möchte die Ergebnisse der Arbeit reproduzieren und mietet eine TPU zum Marktpreis von 3,22 US-Dollar pro Stunde, um sie erneut zu betreiben. Die Kosten betragen 57.348 US-Dollar.

Was bedeutet das? Müssen wir überhaupt eine Schwelle für die Schreibkompetenz in Tageszeitungen festlegen?

Natürlich ist dieser Ansatz mittlerweile ein Trend in der Branche, einschließlich, aber nicht beschränkt auf große Player wie Google und OpenAI. Jeder bringt einige Ideen zur Verbesserung des Status Quo sowie viele vorverarbeitete Daten und Benchmarks in das Modell ein.

Solange das laufende Ergebnis numerisch sogar um zwei Dezimalstellen nach einem Prozentpunkt höher ist als das des Gegners, kann der Forscher getrost eine neue Zeile mit dem Titel der Abschlussarbeit zum Lebenslauf hinzufügen!

Wie wird das akademische Kreise und die Industrie wirklich fördern? Gewöhnliche Doktoranden können es sich nicht leisten, Geld auszugeben, um Ihre Schlussfolgerungen zu überprüfen, und gewöhnliche Unternehmen können solche langweiligen Benchmarks nicht in Projekten verwenden.

Der gleiche Satz, was bedeutet er?

Ist das die akzeptable Komfortzone in der KI-Welt? Eine kleine Gruppe großer Unternehmen und gelegentlich Spitzenschulen geben jeden Tag damit an, dass ich Geld habe und machen kann, was ich will, aber Sie haben kein Geld und müssen zurückbleiben?

Wenn wir so weitermachen, könnten wir genauso gut eine weitere Informatikzeitschrift eröffnen und einfach Artikel sammeln, deren Ergebnisse auf einer eigenständigen Grafikkarte für Endverbraucher in acht Stunden reproduziert werden können.

In dem Thread äußerten Doktoranden mit Abschlussarbeiten ihre Beschwerden.

Ein Internetnutzer mit der ID „Support Vector Machine“ sagte, er sei ein Praktiker in einem kleinen Labor. Aufgrund dieser Dynamik habe er fast vollständig die Motivation verloren, sich weiterhin mit Deep Learning zu beschäftigen.

Denn mit dem Budget meines eigenen Labors kann ich nicht mit diesen Giganten konkurrieren und ich kann keine Benchmark-Ergebnisse erzielen, die die Leistung unter dem Strich zeigen.

Selbst wenn Sie eine neue theoretische Idee haben, ist es schwierig, eine Arbeit zu schreiben, die die Rezension besteht. Dies liegt daran, dass die aktuellen Papierrezensenten aufgrund der Fähigkeit großer Hersteller eine „schöne Bildvoreingenommenheit“ entwickelt haben. Die zum Testen in der Arbeit verwendeten Bilder sehen nicht gut aus und alles ist umsonst.

Es ist nicht so, dass die riesigen Hersteller nutzlos wären, Projekte wie GPT und DALL-E sind wirklich bahnbrechend. Aber wenn meine eigene Maschine nicht laufen kann, warum sollte ich dann aufgeregt sein?

Ein weiterer Internetnutzer, der Doktorand ist, tauchte auf und kommentierte den Beitrag, um „Support Vector Machine“ zu unterstützen.

Ich habe vor zwei Jahren als Doktorand eine Arbeit zum Strömungsmodell eingereicht. Dabei ging es hauptsächlich um die Entdeckung des potenziellen Datenraums, der abgetastet werden kann, und dies hatte keinen Einfluss auf die Qualität der Bilderzeugung des Modells.

Daher lautete der kritische Kommentar des Paper-Scorers: „Das generierte Bild sieht nicht so gut aus wie das von GAN generierte.“

Ein anderer Doktorand mit dem ID-Namen „Uday“ sagte auch, dass der Kritiker, der die von ihm für die Konferenz im Jahr 2021 eingereichte Arbeit bewertete, war: „Die Daten sind nicht ausgefallen genug.“

Es scheint, dass die Die Arbeitskräfte reichen nicht aus. Es ist tatsächlich ein weltweiter Trend, dass die Psychologie des Ostens und des Westens gleich ist und dass chinesischer und ausländischer Taoismus nicht getrennt sind.

Aber in dreißig Jahren Hedong und dreißig Jahren Hexi wird die grundlegende Implementierung von Algorithmen und die universelle Kapitalisierung vielleicht das zweite Wunder bewirken, dass Garagen-Startups IBM besiegen.

Das obige ist der detaillierte Inhalt vonJeff Deans groß angelegtes Multitasking-Lern-SOTA wurde kritisiert und seine Reproduktion würde 60.000 US-Dollar kosten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Wie man Deepseek kommentiert

Feb 19, 2025 pm 05:42 PM

Deepseek ist ein leistungsstarkes Informations -Abruf -Tool. .

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

So suchen Sie Deepseek

Feb 19, 2025 pm 05:39 PM

Deepseek ist eine proprietäre Suchmaschine, die nur schneller und genauer in einer bestimmten Datenbank oder einem bestimmten System sucht. Bei der Verwendung wird den Benutzern empfohlen, das Dokument zu lesen, verschiedene Suchstrategien auszuprobieren, Hilfe und Feedback zur Benutzererfahrung zu suchen, um die Vorteile optimal zu nutzen.

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

In diesem Artikel wird der Registrierungsprozess der Webversion Sesam Open Exchange (GATE.IO) und die Gate Trading App im Detail vorgestellt. Unabhängig davon, ob es sich um eine Webregistrierung oder eine App -Registrierung handelt, müssen Sie die offizielle Website oder den offiziellen App Store besuchen, um die Genuine App herunterzuladen, und dann den Benutzernamen, das Kennwort, die E -Mail, die Mobiltelefonnummer und die anderen Informationen eingeben und eine E -Mail- oder Mobiltelefonüberprüfung abschließen.

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden?

Feb 21, 2025 pm 10:57 PM

Warum kann der Bybit -Exchange -Link nicht direkt heruntergeladen und installiert werden? Bitbit ist eine Kryptowährungsbörse, die den Benutzern Handelsdienste anbietet. Die mobilen Apps der Exchange können aus den folgenden Gründen nicht direkt über AppStore oder Googleplay heruntergeladen werden: 1. App Store -Richtlinie beschränkt Apple und Google daran, strenge Anforderungen an die im App Store zulässigen Anwendungsarten zu haben. Kryptowährungsanträge erfüllen diese Anforderungen häufig nicht, da sie Finanzdienstleistungen einbeziehen und spezifische Vorschriften und Sicherheitsstandards erfordern. 2. Die Einhaltung von Gesetzen und Vorschriften In vielen Ländern werden Aktivitäten im Zusammenhang mit Kryptowährungstransaktionen reguliert oder eingeschränkt. Um diese Vorschriften einzuhalten, kann die Bitbit -Anwendung nur über offizielle Websites oder andere autorisierte Kanäle verwendet werden

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Es ist wichtig, einen formalen Kanal auszuwählen, um die App herunterzuladen und die Sicherheit Ihres Kontos zu gewährleisten.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Dieser Artikel empfiehlt die Top Ten Ten Cryptocurrency -Handelsplattformen, die es wert sind, auf Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI und Xbit -dezentrale Börsen geachtet zu werden. Diese Plattformen haben ihre eigenen Vorteile in Bezug auf Transaktionswährungsmenge, Transaktionstyp, Sicherheit, Konformität und Besonderheiten. Die Auswahl einer geeigneten Plattform erfordert eine umfassende Überlegung, die auf eigener Handelserfahrung, Risikotoleranz und Investitionspräferenzen basiert. Ich hoffe, dieser Artikel hilft Ihnen dabei, den besten Anzug für sich selbst zu finden

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Binance Binance Offizielle Website Neueste Version Anmeldeportal

Feb 21, 2025 pm 05:42 PM

Befolgen Sie diese einfachen Schritte, um auf die neueste Version des Binance -Website -Login -Portals zuzugreifen. Gehen Sie zur offiziellen Website und klicken Sie in der oberen rechten Ecke auf die Schaltfläche "Anmeldung". Wählen Sie Ihre vorhandene Anmeldemethode. Geben Sie Ihre registrierte Handynummer oder E -Mail und Kennwort ein und vervollständigen Sie die Authentifizierung (z. B. Mobilfifizierungscode oder Google Authenticator). Nach einer erfolgreichen Überprüfung können Sie auf das neueste Version des offiziellen Website -Login -Portals von Binance zugreifen.

Die neueste Download -Adresse des Bitgets im Jahr 2025: Schritte zum Erhalten der offiziellen App

Feb 25, 2025 pm 02:54 PM

Die neueste Download -Adresse des Bitgets im Jahr 2025: Schritte zum Erhalten der offiziellen App

Feb 25, 2025 pm 02:54 PM

Dieser Leitfaden enthält detaillierte Download- und Installationsschritte für die offizielle Bitget Exchange -App, die für Android- und iOS -Systeme geeignet ist. Der Leitfaden integriert Informationen aus mehreren maßgeblichen Quellen, einschließlich der offiziellen Website, dem App Store und Google Play, und betont Überlegungen während des Downloads und des Kontoverwaltung. Benutzer können die App aus offiziellen Kanälen herunterladen, einschließlich App Store, offizieller Website APK Download und offizieller Website -Sprung sowie vollständige Registrierung, Identitätsüberprüfung und Sicherheitseinstellungen. Darüber hinaus deckt der Handbuch häufig gestellte Fragen und Überlegungen ab, wie z.