Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Können selbstfahrende Autos Fußgängern ihre Absichten signalisieren?

Können selbstfahrende Autos Fußgängern ihre Absichten signalisieren?

Können selbstfahrende Autos Fußgängern ihre Absichten signalisieren?

Um zu beurteilen, ob eine breite Straße sicher überquert werden kann, sind soziale Hinweise und eine kooperative Kommunikation zwischen Fußgängern und Autofahrern erforderlich. Was passiert also, wenn es sich um ein selbstfahrendes Fahrzeug handelt? Motional, ein Unternehmen für selbstfahrende Autos, glaubt, dass die Verbesserung der Ausdruckskraft von Fahrzeugen der Schlüssel zur Aufrechterhaltung dieser wichtigen Signale sein könnte.

Während er an einem Zebrastreifen wartete, erlebte Paul Schmitt, der leitende Ingenieur von Motional, etwas, was er „einen Tanz mit einem Blick“ nennt. Es ist eine schnelle und fast unbewusste Einschätzung: Wo suchen die Fahrer entgegenkommender Autos? Haben sie ihn bemerkt? „Bei selbstfahrenden Fahrzeugen gibt es die Hälfte dieser Interaktionen nicht“, sagte Schmidt. „Welche Hinweise gibt es also für Fußgänger, um die Absichten des Fahrzeugs zu verstehen?“

Um diese Frage zu beantworten, beauftragte sein Team das Animationsstudio CHRLX builds hochrealistische Virtual-Reality-Erlebnisse, mit denen die Reaktionen von Fußgängern auf verschiedene Signalmechanismen getestet werden sollen. Ihre Forschungsergebnisse wurden in IEEE Robotics and Automation Letters veröffentlicht. Schmidt und sein Team sagen, dass übertriebene Fahrmanöver – frühes Bremsen oder Anhalten vor Fußgängern – die effektivsten Mittel seien, ihre Absichten zu kommunizieren.

Das Unternehmen integriert derzeit die vielversprechendsten Ausdrucksverhaltensweisen in sein Bewegungsplanungssystem und hat auch die Virtual-Reality-Verkehrsumgebung als Open-Source-Lösung für andere Teams zum Experimentieren bereitgestellt.

In der Studie wurden außerdem verschiedene Ausdrucksverhaltensweisen getestet, die Fußgängern implizit signalisieren, dass ein Fahrzeug für sie anhält. Dazu gehört es, das Auto weiter von der Grundlinie entfernt stärker zu bremsen, das Fahrzeug eine Länge weiter entfernt anzuhalten, starkes Bremsen und Geräusche bei niedriger Drehzahl hinzuzufügen und schließlich diese Geräusche mit einem übertriebenen Sturzflug zu kombinieren, als würde das Fahrzeug stark bremsen.

Das Team maß, wie schnell sich Fußgänger zum Überqueren der Fahrspur entschieden, und führte nach jedem Versuch eine kurze Umfrage unter Fußgängern durch, um zu verstehen, wie sicher sie sich fühlten, wie sicher sie sich bei der Entscheidung zum selbstständigen Überqueren der Fahrspur waren und wie sie die Absichten des Autos wahrnahmen Ebene des Verständnisses. Kurze Stopps erzielten die höchste Punktzahl für Sicherheit und Verständnis für die Absichten des Fahrzeugs.

Schmitt sagte, dass kurze Stopps die beste Reaktion hervorriefen, was nicht verwunderlich war, da der Ansatz vom Verhalten menschlicher Fahrer inspiriert war, die vor Fußgängern langsamer wurden. Überraschenderweise, fügte er hinzu, gab es bei den Reaktionen auf dieses Basisszenario mit oder ohne Fahrer keinen großen Unterschied, was darauf hindeutet, dass Fußgänger der Bewegung des Fahrzeugs mehr Aufmerksamkeit schenkten als dem Fahrer hinter dem Lenkrad.

Das obige ist der detaillierte Inhalt vonKönnen selbstfahrende Autos Fußgängern ihre Absichten signalisieren?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

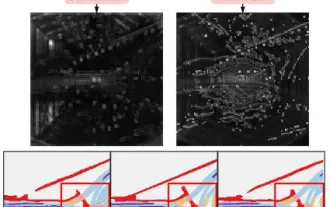

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

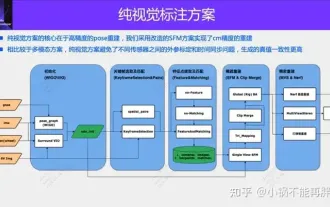

Eine rein visuelle Annotationslösung nutzt hauptsächlich die visuelle Darstellung sowie einige Daten von GPS, IMU und Radgeschwindigkeitssensoren für die dynamische Annotation. Für Massenproduktionsszenarien muss es sich natürlich nicht nur um visuelle Aspekte handeln. Einige in Massenproduktion hergestellte Fahrzeuge verfügen über Sensoren wie Festkörperradar (AT128). Wenn wir aus Sicht der Massenproduktion einen geschlossenen Datenkreislauf erstellen und alle diese Sensoren verwenden, können wir das Problem der Kennzeichnung dynamischer Objekte effektiv lösen. Aber in unserem Plan gibt es kein Festkörperradar. Aus diesem Grund stellen wir diese gängigste Etikettierungslösung für die Massenproduktion vor. Der Kern einer rein visuellen Annotationslösung liegt in der hochpräzisen Posenrekonstruktion. Wir verwenden das Posenrekonstruktionsschema von Structure from Motion (SFM), um die Genauigkeit der Rekonstruktion sicherzustellen. Aber pass

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

Werfen Sie einen Blick auf die Vergangenheit und Gegenwart von Occ und autonomem Fahren! Die erste Rezension fasst die drei Hauptthemen Funktionserweiterung/Massenproduktionsbereitstellung/effiziente Annotation umfassend zusammen.

May 08, 2024 am 11:40 AM

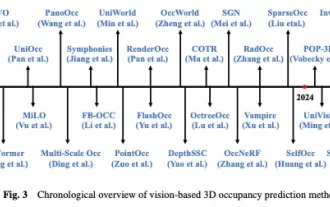

Oben geschrieben und persönliches Verständnis des Autors In den letzten Jahren hat autonomes Fahren aufgrund seines Potenzials, die Belastung des Fahrers zu verringern und die Fahrsicherheit zu verbessern, zunehmende Aufmerksamkeit erhalten. Die visionsbasierte dreidimensionale Belegungsvorhersage ist eine neue Wahrnehmungsaufgabe, die sich für eine kostengünstige und umfassende Untersuchung der Sicherheit autonomen Fahrens eignet. Obwohl viele Studien die Überlegenheit von 3D-Belegungsvorhersagetools im Vergleich zu objektzentrierten Wahrnehmungsaufgaben gezeigt haben, gibt es immer noch Rezensionen, die diesem sich schnell entwickelnden Bereich gewidmet sind. In diesem Artikel wird zunächst der Hintergrund der visionsbasierten 3D-Belegungsvorhersage vorgestellt und die bei dieser Aufgabe auftretenden Herausforderungen erörtert. Als nächstes diskutieren wir umfassend den aktuellen Status und die Entwicklungstrends aktueller 3D-Belegungsvorhersagemethoden unter drei Gesichtspunkten: Funktionsverbesserung, Bereitstellungsfreundlichkeit und Kennzeichnungseffizienz. zu guter Letzt

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

LLM ist fertig! OmniDrive: Integration von 3D-Wahrnehmung und Argumentationsplanung (NVIDIAs neueste Version)

May 09, 2024 pm 04:55 PM

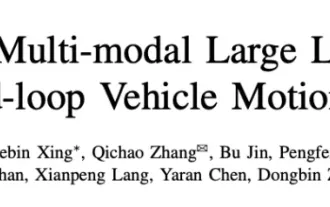

Oben geschrieben und persönliches Verständnis des Autors: Dieses Papier widmet sich der Lösung der wichtigsten Herausforderungen aktueller multimodaler großer Sprachmodelle (MLLMs) in autonomen Fahranwendungen, nämlich dem Problem der Erweiterung von MLLMs vom 2D-Verständnis auf den 3D-Raum. Diese Erweiterung ist besonders wichtig, da autonome Fahrzeuge (AVs) genaue Entscheidungen über 3D-Umgebungen treffen müssen. Das räumliche 3D-Verständnis ist für AVs von entscheidender Bedeutung, da es sich direkt auf die Fähigkeit des Fahrzeugs auswirkt, fundierte Entscheidungen zu treffen, zukünftige Zustände vorherzusagen und sicher mit der Umgebung zu interagieren. Aktuelle multimodale große Sprachmodelle (wie LLaVA-1.5) können häufig nur Bildeingaben mit niedrigerer Auflösung verarbeiten (z. B. aufgrund von Auflösungsbeschränkungen des visuellen Encoders und Einschränkungen der LLM-Sequenzlänge). Allerdings erfordern autonome Fahranwendungen

Auf dem Weg zum „Closed Loop' |. PlanAgent: Neues SOTA für die Closed-Loop-Planung des autonomen Fahrens auf Basis von MLLM!

Jun 08, 2024 pm 09:30 PM

Auf dem Weg zum „Closed Loop' |. PlanAgent: Neues SOTA für die Closed-Loop-Planung des autonomen Fahrens auf Basis von MLLM!

Jun 08, 2024 pm 09:30 PM

Das Deep-Reinforcement-Learning-Team des Instituts für Automatisierung der Chinesischen Akademie der Wissenschaften hat zusammen mit Li Auto und anderen ein neues Closed-Loop-Planungsframework für autonomes Fahren vorgeschlagen, das auf dem multimodalen großen Sprachmodell MLLM basiert – PlanAgent. Bei dieser Methode werden die Szene aus der Vogelperspektive und diagrammbasierte Textaufforderungen als Eingabe betrachtet. Dabei werden die Fähigkeiten des multimodalen Verständnisses und des gesunden Menschenverstandes des multimodalen großen Sprachmodells genutzt, um hierarchische Überlegungen vom Szenenverständnis bis zur Generierung durchzuführen von horizontalen und vertikalen Bewegungsanweisungen und generieren Sie außerdem die vom Planer benötigten Anweisungen. Die Methode wird im groß angelegten und anspruchsvollen nuPlan-Benchmark getestet und Experimente zeigen, dass PlanAgent sowohl in regulären als auch in Long-Tail-Szenarien eine State-of-the-Art-Leistung (SOTA) erreicht. Im Vergleich zu herkömmlichen LLM-Methoden (Large Language Model) bietet PlanAgent

Jenseits von BEVFusion! DifFUSER: Das Diffusionsmodell tritt in die autonome Fahr-Multitask ein (BEV-Segmentierung + Erkennung Dual-SOTA)

Apr 22, 2024 pm 05:49 PM

Jenseits von BEVFusion! DifFUSER: Das Diffusionsmodell tritt in die autonome Fahr-Multitask ein (BEV-Segmentierung + Erkennung Dual-SOTA)

Apr 22, 2024 pm 05:49 PM

Oben geschrieben und persönliches Verständnis des Autors. Da die autonome Fahrtechnologie derzeit ausgereifter wird und die Nachfrage nach autonomen Fahrwahrnehmungsaufgaben zunimmt, hoffen Industrie und Wissenschaft sehr auf ein ideales Wahrnehmungsalgorithmusmodell, das gleichzeitig die dreidimensionale Zielerkennung durchführen kann basierend auf einer semantischen Segmentierungsaufgabe im BEV-Raum. Ein autonom fahrendes Fahrzeug ist in der Regel mit Rundumsichtkamerasensoren, Lidar-Sensoren und Millimeterwellen-Radarsensoren ausgestattet, um Daten in verschiedenen Modalitäten zu sammeln. Auf diese Weise können die komplementären Vorteile zwischen verschiedenen Modaldaten vollständig genutzt werden, sodass die komplementären Vorteile von Daten zwischen verschiedenen Modalitäten erzielt werden können. Beispielsweise können 3D-Punktwolkendaten Informationen für 3D-Zielerkennungsaufgaben liefern, während Farbbilddaten kann mehr Informationen für semantische Segmentierungsaufgaben liefern. Nadel

Überblick über die Pfadplanung: Basierend auf Probenahme, Suche und Optimierung, fertig!

Jun 01, 2024 pm 08:12 PM

Überblick über die Pfadplanung: Basierend auf Probenahme, Suche und Optimierung, fertig!

Jun 01, 2024 pm 08:12 PM

1 Überblick über Entscheidungssteuerung und Bewegungsplanung Aktuelle Methoden zur Entscheidungssteuerung können in drei Kategorien unterteilt werden: sequentielle Planung, verhaltensbewusste Planung und End-to-End-Planung. Sequentielle Planung: Bei der traditionellsten Methode sind die drei Teile Wahrnehmung, Entscheidungsfindung und Kontrolle relativ klar. Verhaltensbewusste Planung: Im Vergleich zur ersten Methode ist der Höhepunkt die Einführung von Mensch-Maschine-Co-Fahren und Fahrzeug-Straße Zusammenarbeit und Fahrzeugrisikoabschätzung der externen dynamischen Umgebung; End-to-End-Planung: DL- und DRL-Technologien nutzen eine große Menge an Datentraining, um sensorische Informationen wie Bilder, Lenkradwinkel usw. zu erhalten.