Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

Ein Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren

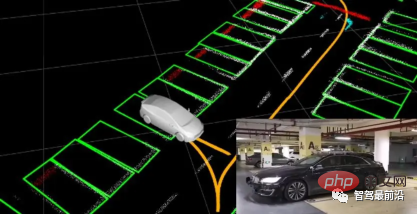

Die Positionierung nimmt beim autonomen Fahren eine unersetzliche Stellung ein und es gibt vielversprechende Entwicklungen für die Zukunft. Derzeit basiert die Positionierung beim autonomen Fahren auf RTK und hochpräzisen Karten, was die Implementierung des autonomen Fahrens mit hohen Kosten und Schwierigkeiten verbunden macht. Stellen Sie sich vor, dass Menschen beim Fahren ihre eigene globale hochpräzise Positionierung und die detaillierte Umgebung nicht kennen müssen. Es reicht aus, einen globalen Navigationspfad zu haben und die Position des Fahrzeugs auf dem Pfad anzupassen SLAM-Schlüsseltechnologien.

Was ist SLAM?

SLAM (Simultaneous Localization and Mapping), auch bekannt als CML (Concurrent Mapping and Localization), Echtzeitpositionierung und Kartenkonstruktion oder gleichzeitige Zuordnung und Positionierung. Das Problem kann wie folgt beschrieben werden: Platzieren Sie einen Roboter an einem unbekannten Ort in einer unbekannten Umgebung. Gibt es eine Möglichkeit für den Roboter, nach und nach eine vollständige Karte der Umgebung zu zeichnen und dabei zu entscheiden, in welche Richtung sich der Roboter bewegen soll? Beispielsweise ist ein Kehrroboter ein sehr typisches SLAM-Problem. Die sogenannte vollständige Karte (eine konsistente Karte) bedeutet, dass er ohne Hindernisse in jede zugängliche Ecke des Raums fahren kann.

SLAM wurde erstmals 1988 von Smith, Self und Cheeseman vorgeschlagen. Aufgrund seines wichtigen theoretischen und praktischen Werts wird es von vielen Wissenschaftlern als Schlüssel zur Verwirklichung eines wirklich vollständig autonomen mobilen Roboters angesehen.

Wenn simulierte Menschen in eine fremde Umgebung kommen, sollten sie Folgendes der Reihe nach tun, um sich schnell mit der Umgebung vertraut zu machen und ihre Aufgaben zu erledigen (z. B. ein Restaurant finden, ein Hotel finden):

a. Beobachten Sie die Umgebung mit Ihren Augen, Sehenswürdigkeiten wie Gebäude, große Bäume, Blumenbeete usw., und merken Sie sich deren Eigenschaften (Merkmalsextraktion)

b. Rekonstruieren Sie die charakteristischen Orientierungspunkte in der dreidimensionalen Karte (dreidimensionale Rekonstruktion)

c Erfassen Sie beim Gehen ständig neue Orientierungspunkte und korrigieren Sie das Kartenmodell in Ihrem Kopf (Bündelanpassung oder EKF)

d. Bestimmen Sie anhand der Merkmale, die Sie durch das Gehen vor einiger Zeit erhalten haben, Ihre Position (Flugbahn).

e Wenn Sie unbeabsichtigt eine lange Strecke zurückgelegt haben, vergleichen Sie sie mit den vorherigen Orientierungspunkten in Ihrem Kopf auf den ursprünglichen Pfad zurückgeführt (Loop-Closure-Erkennung). In Wirklichkeit ist dieser Schritt optional. Die oben genannten fünf Schritte werden gleichzeitig ausgeführt, es handelt sich also um eine gleichzeitige Lokalisierung und Kartierung.

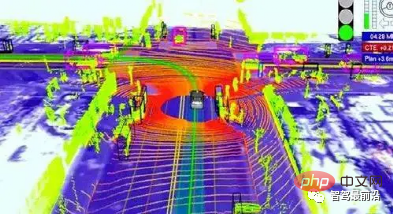

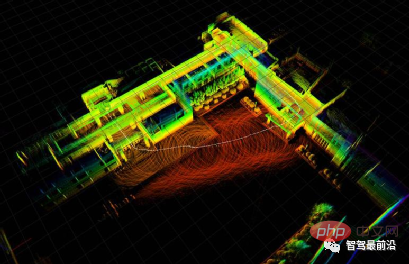

Laser-SLAM und visuelles SLAM

Die derzeit in SLAM verwendeten Sensoren werden hauptsächlich in zwei Kategorien unterteilt: Lidar und Kameras. LiDAR kann in einzeilige und mehrzeilige Typen mit unterschiedlicher Winkelauflösung und Genauigkeit unterteilt werden.

VSLAM wird hauptsächlich mit Kameras implementiert. Es gibt viele Arten von Kameras, die hauptsächlich in monokulares, binokulares, monokulares strukturiertes Licht, binokulares strukturiertes Licht und ToF unterteilt sind. Ihr Kern besteht darin, RGB und Tiefenkarten (Tiefeninformationen) zu erhalten. Aufgrund der Auswirkungen auf die Herstellungskosten erfreut sich visuelles SLAM in den letzten Jahren immer größerer Beliebtheit. Auch die Echtzeitkartierung und -positionierung durch kostengünstige Kameras ist technisch sehr schwierig. Nehmen Sie als Beispiel ToF (Time of Flight), eine vielversprechende Tiefenerfassungsmethode.

Der Sensor sendet moduliertes Nahinfrarotlicht aus, das reflektiert wird, wenn es auf ein Objekt trifft. Der Sensor berechnet die Zeitdifferenz oder Phasendifferenz zwischen Lichtemission und Reflexion, um die Entfernung der fotografierten Szene umzuwandeln und Tiefeninformationen zu generieren. Ähnlich wie Radar oder stellen Sie sich eine Fledermaus vor, verwendet der DS325 von Softkinetic eine ToF-Lösung (entworfen von TI). Allerdings ist die Mikrostruktur des Empfängers mit zwei oder mehr Verschlüssen relativ speziell und kann Zeitunterschiede im ps-Bereich messen. Die Pixelgröße beträgt jedoch normalerweise 100 µm, sodass die aktuelle Auflösung nicht hoch ist.

Nachdem die Tiefenkarte erhalten wurde, beginnt der SLAM-Algorithmus zu arbeiten. Aufgrund unterschiedlicher Sensoren und Anforderungen unterscheidet sich die Darstellungsform von SLAM geringfügig. Es kann grob in Laser-SLAM (auch in 2D und 3D unterteilt) und visuelles SLAM (auch in Sparse, SemiDense, Dense unterteilt) unterteilt werden, die Grundideen sind jedoch ähnlich.

Elemente der SLAM-Algorithmus-Implementierung

SLAM-Technologie ist sehr praktisch, aber auch ziemlich schwierig. Im Bereich des autonomen Fahrens, das jederzeit eine präzise Positionierung erfordert, ist es auch schwierig, SLAM zu implementieren. Im Allgemeinen berücksichtigt der SLAM-Algorithmus bei der Implementierung hauptsächlich die folgenden vier Aspekte:

1. Kartendarstellungsprobleme wie dicht und spärlich sind unterschiedliche Ausdrücke davon. Dies muss entsprechend den tatsächlichen Szenenanforderungen ausgewählt werden

2. Das Sichtfeld der RGBD-Kamera ist normalerweise kleiner, das Problem der Datenzuordnung, verschiedener Sensordatentypen und Koordinaten Systeme haben unterschiedliche Ausdrücke und müssen einheitlich verarbeitet werden.

4 Positionierungs- und Kompositionsprobleme beziehen sich auf die Art und Weise, wie eine Posenschätzung und -modellierung erreicht wird, was viele mathematische Probleme, die Erstellung physikalischer Modelle, die Zustandsschätzung und die Optimierung umfasst Probleme, Erkundungsprobleme (Exploration) und Entführungsprobleme (Entführung).

Das derzeit beliebte visuelle SLAM-Framework umfasst hauptsächlich Front-End und Back-End:

Front-End

Das Front-End entspricht VO (visuelle Odometrie). untersucht die Transformationsbeziehung zwischen Frames.

Extrahieren Sie zunächst die Merkmalspunkte jedes Bildrahmens, verwenden Sie benachbarte Rahmenbilder, um die Merkmalspunkte abzugleichen, verwenden Sie dann RANSAC, um großes Rauschen zu entfernen, und führen Sie dann einen Abgleich durch, um Poseinformationen (Position und Haltung) zu erhalten Gleichzeitig können Sie IMU (Inertial) verwenden. Die Back-End-Filterung und Fusion der von der Messeinheit (Trägheitsmesseinheit) bereitgestellten Lageinformationen optimiert hauptsächlich die Front-End-Ergebnisse mithilfe der Filtertheorie (EKF, UKF, PF) oder der Optimierungstheorie TORO und G2O zur Optimierung von Bäumen oder Diagrammen. Schließlich wird die optimale Posenschätzung erhalten.

Backend

Das Backend hat mehr Schwierigkeiten und erfordert mehr mathematisches Wissen. Im Allgemeinen hat jeder die traditionelle Filtertheorie langsam aufgegeben und sich der Diagrammoptimierung zugewandt.

Denn basierend auf der Filtertheorie steigt die Filterstabilität zu schnell an, was großen Druck auf den PF für EKF (Extended Kalman Filter) ausübt, der eine häufige Umkehrung erfordert.

Graph-basiertes SLAM basiert normalerweise auf Keyframes, um mehrere Knoten und relative Transformationsbeziehungen zwischen Knoten, wie z. B. affine Transformationsmatrizen, einzurichten und Schlüsselknoten kontinuierlich zu pflegen, um sicherzustellen, dass die Kapazität des Diagramms den Rechenaufwand reduziert und gleichzeitig die Genauigkeit gewährleistet .

Die zukünftige Anwendung von SLAM im Bereich des autonomen Fahrens

Die Slam-Technologie hat in vielen Bereichen gute Ergebnisse erzielt, darunter mobile Indoor-Roboter, AR-Szenen, Drohnen usw. Im Bereich des autonomen Fahrens hat die SLAM-Technologie einerseits nicht viel Aufmerksamkeit erhalten, da der Großteil der aktuellen autonomen Fahrbranche durch RTK gelöst wird, andererseits werden nicht zu viele Ressourcen in eingehende Forschung investiert Einerseits hat die SLAM-Technologie nicht viel Beachtung gefunden, weil die aktuelle Technologie noch nicht ausgereift ist. In einem lebensbezogenen Bereich wie dem autonomen Fahren muss jede neue Technologie den Test der Zeit bestehen akzeptiert.

Mit der schrittweisen Verbesserung der Sensorgenauigkeit wird SLAM auch im Bereich des autonomen Fahrens seine Talente unter Beweis stellen und dem autonomen Fahren revolutionäre Vorteile bringen. Da die SLAM-Technologie immer beliebter wird, strömen immer mehr Positionierungstalente in den Bereich des autonomen Fahrens, bringen frischen Wind in das autonome Fahren und bringen neue technische Richtungen und Forschungsbereiche mit sich.

Das obige ist der detaillierte Inhalt vonEin Artikel über die Anwendung der SLAM-Technologie beim autonomen Fahren. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Die herumfliegenden Gesichtszüge, das Öffnen des Mundes, das Starren und das Hochziehen der Augenbrauen können von der KI perfekt nachgeahmt werden, sodass Videobetrug nicht verhindert werden kann

Dec 14, 2023 pm 11:30 PM

Mit solch einer mächtigen KI-Imitationsfähigkeit ist es wirklich unmöglich, dies zu verhindern. Hat die Entwicklung der KI mittlerweile dieses Niveau erreicht? Ihr vorderer Fuß lässt Ihre Gesichtszüge fliegen, und auf Ihrem hinteren Fuß wird genau der gleiche Ausdruck reproduziert. Starren, Augenbrauen hochziehen, schmollen, egal wie übertrieben der Ausdruck ist, alles wird perfekt nachgeahmt. Erhöhen Sie den Schwierigkeitsgrad, heben Sie die Augenbrauen höher, öffnen Sie die Augen weiter, und sogar die Mundform ist schief und der Ausdruck des Avatars kann perfekt reproduziert werden. Wenn Sie die Parameter auf der linken Seite anpassen, ändert der virtuelle Avatar auf der rechten Seite auch seine Bewegungen entsprechend, um eine Nahaufnahme von Mund und Augen zu erhalten. Man kann nicht sagen, dass die Nachahmung genau gleich ist, aber der Ausdruck ist genau derselbe gleich (ganz rechts). Die Forschung stammt von Institutionen wie der Technischen Universität München, die GaussianAvatars vorschlägt

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

nuScenes' neuestes SOTA |. SparseAD: Sparse-Abfrage hilft effizientes durchgängiges autonomes Fahren!

Apr 17, 2024 pm 06:22 PM

Vorab geschrieben und Ausgangspunkt Das End-to-End-Paradigma verwendet ein einheitliches Framework, um Multitasking in autonomen Fahrsystemen zu erreichen. Trotz der Einfachheit und Klarheit dieses Paradigmas bleibt die Leistung von End-to-End-Methoden für das autonome Fahren bei Teilaufgaben immer noch weit hinter Methoden für einzelne Aufgaben zurück. Gleichzeitig erschweren die in früheren End-to-End-Methoden weit verbreiteten Funktionen der dichten Vogelperspektive (BEV) die Skalierung auf mehr Modalitäten oder Aufgaben. Hier wird ein Sparse-Search-zentriertes End-to-End-Paradigma für autonomes Fahren (SparseAD) vorgeschlagen, bei dem die Sparse-Suche das gesamte Fahrszenario, einschließlich Raum, Zeit und Aufgaben, ohne dichte BEV-Darstellung vollständig abbildet. Insbesondere ist eine einheitliche, spärliche Architektur für die Aufgabenerkennung einschließlich Erkennung, Verfolgung und Online-Zuordnung konzipiert. Zudem schwer

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt