Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Xishanju-KI-Technikexperte Huang Hongbo: Praktische Integration von Verstärkungslernen und Verhaltensbäumen in Spielen

Xishanju-KI-Technikexperte Huang Hongbo: Praktische Integration von Verstärkungslernen und Verhaltensbäumen in Spielen

Xishanju-KI-Technikexperte Huang Hongbo: Praktische Integration von Verstärkungslernen und Verhaltensbäumen in Spielen

Am 6. und 7. August 2022 findet die AISummit Global Artificial Intelligence Technology Conference wie geplant statt. Auf dem Unterforum „Artificial Intelligence Frontier Exploration“, das am Nachmittag des 7. stattfand, brachte Huang Hongbo, technischer Experte für künstliche Intelligenz in Xishanju, einen Themenvortrag zum Thema „Praktische Kombination von Verstärkungslernen und Verhaltensbäumen in Spielen“ und erläuterte dabei ausführlich die Auswirkungen der Verstärkung Lernen im Spielbereich.

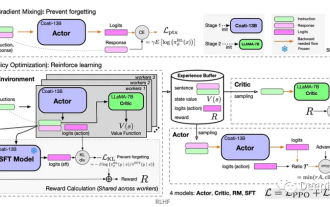

Huang Hongbo sagte, dass die Implementierung der Reinforcement-Learning-Technologie nicht in der Verbesserung des Algorithmus liegt, sondern in der Kombination der Reinforcement-Learning-Technologie mit Deep Learning und Spielplanung, um eine vollständige Lösung zu bilden und diese umzusetzen.

Reinforcement Learning macht Spiele intelligenter

Die Implementierung von Reinforcement Learning in Spielen kann Spiele intelligenter und spielbarer machen. Dies ist der Hauptzweck des Einsatzes von Reinforcement Learning in Spielen.

„Reinforcement Learning ist ein maschinelles Lernparadigma, das die Strategie des Agenten trainiert, damit eine Reihe von Entscheidungen getroffen werden können.“ Huang Hongbo sagte, dass der Zweck des Agenten darin besteht, Aktionen basierend auf Beobachtungen der Umgebung auszugeben. Diese Aktionen führen zu mehr Beobachtungen und Belohnungen. Das Training erfordert viel Versuch und Irrtum, da der Agent mit der Umgebung interagiert, und die Strategie kann mit jeder Iteration verbessert werden.

In einem Spiel ist der Agent, der Maßnahmen ergreift oder ein Verhalten ausführt, der Spielagent. Betrachten Sie einen Charakter oder einen Roboter in einem Spiel. Er muss den Zustand des Spiels verstehen, wo sich der Spieler befindet, und dann sollte auf der Grundlage dieser Beobachtung eine Entscheidung basierend auf der Situation des Spiels getroffen werden. Beim Reinforcement Learning werden Entscheidungen durch Belohnungen gesteuert, die im Spiel als Highscores oder für das Erreichen neuer Levels zur Erreichung bestimmter Ziele bereitgestellt werden können.

Huang Hongbo sagte, das Coolste an der Spielsituation sei, dass die Strategie des Agenten unter dem Druck des Spiels trainiert werde. Es könnte beispielsweise lernen, mit einem Angriff umzugehen oder sich zu verhalten, um ein bestimmtes Ziel zu erreichen.

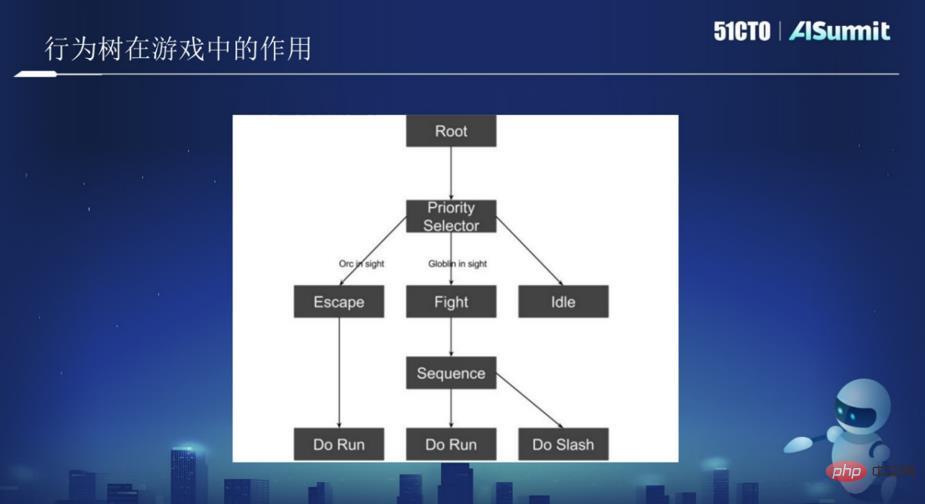

Die Rolle des Verhaltensbaums im Spiel

Ein Verhaltensbaum ist eine Baumstruktur, die logische Knoten und Verhaltensknoten enthält. Normalerweise können Sie jede Situation in einen Knotentyp abstrahieren, die Knoten gemäß den Spezifikationen schreiben und diese Knoten dann zu einem Baum verbinden. Jedes Mal, wenn der Benutzer nach einem Verhalten sucht, beginnt er beim Wurzelknoten des Baums und findet ein Verhalten, das mit den aktuellen Daten jedes Knotens übereinstimmt.

Einfach ausgedrückt: Wenn der Kopplungsgrad jedes KI-Moduls hoch und die Granularität groß ist, erfordert eine Änderung häufig eine große Anzahl von Änderungen, und es kann leicht zu einer großen Menge doppelten Codes kommen. Das Aufkommen von Verhaltensbäumen hat Spieleentwicklern ein „quadratisches Notizbuch“ zur Verfügung gestellt, das es KI-Entwicklern ermöglicht, bequemer eine Reihe von KI-Frameworks zu erstellen, die wiederverwendbar, einfach zu erweitern und zu warten sind. Man kann sagen, dass Verstärkungslernen durch Training erreicht wird und der Verhaltensbaum eine Kombination aus mehreren else- und if-Anweisungen ist.

Wie im Bild oben gezeigt, gibt es im Bild einen Wurzelknoten und darunter einen Baumknoten. Zu den Baumknoten gehören Flucht, Angriff, Wandern usw. Stellen Sie sich das Bild oben als eine KI oder einen Roboter vor und lassen Sie ihn durch den Dschungel patrouillieren. Wenn die KI einen ORC-Ork sieht und feststellt, dass sie den ORC nicht besiegen kann, wenn diese Bedingung ausgelöst wird, rennt die KI weg und führt bei der Flucht die Aktion „Run“ aus. Wenn festgestellt wird, dass das Kämpfen einfacher ist, wird die Kampfoperation ausgeführt.

Im Bild oben gibt es zwei Knoten, einen ist Root, der der Wurzelknoten ist, und einer ist der Selector-Knoten, der der logische Knoten ist. Alle Knoten werden in einer bestimmten Reihenfolge von links nach rechts ausgeführt. Dies ist ein Verhaltensbaum. Daher müssen Sie nur die entsprechende Logik in jeden Knoten schreiben, damit die KI einige verwandte Aktionen ausführen kann. Mehrere Verhaltensbäume bilden schließlich ein Spiel.

Die Kombination aus Verstärkungslernen und Verhaltensbäumen macht das Spiel reicher.

Wie kann man die Kombination aus Verstärkungslernen und Verhaltensbäumen nutzen, um das Spiel reicher zu machen? Dies ist eine schwierige Anwendung, die in vielen Spielen besprochen werden muss.

Lasst uns vorher besprechen, wann es besser ist, Reinforcement Learning einzusetzen und unter welchen Umständen es besser ist, Verhaltensbäume zu nutzen. Huang Hongbo sagte, dass, wenn es keine Möglichkeit gibt, das Ziel mithilfe von Verhaltensbäumen zu erreichen, Verstärkungslernen eingesetzt werden kann. Beispielsweise kann bei FPS (Ego-Shooter) ermittelt werden, wie viel Feuerkraft eingesetzt werden sollte, auf wen geschossen werden sollte und auf welche Art Anzahl der Waffen usw. Es ist schwieriger, Entscheidungen mithilfe von Verhaltensbäumen zu treffen. Im Allgemeinen ist es besser, Verstärkungslernen zu verwenden.

Wann werden Verhaltensbäume verwendet? Wenn Sie beispielsweise im Spiel auf ein Hindernis stoßen und darüber springen müssen, können Sie dafür entweder Verstärkungslernen oder einen Verhaltensbaum verwenden. Aber wenn wir dazu Verstärkungslernen nutzen, wird das Training sehr mühsam sein. Da es in dieser Situation nur eine Möglichkeit gibt, nämlich zu überspringen, ist es einfacher, einen Verhaltensbaum zu verwenden.

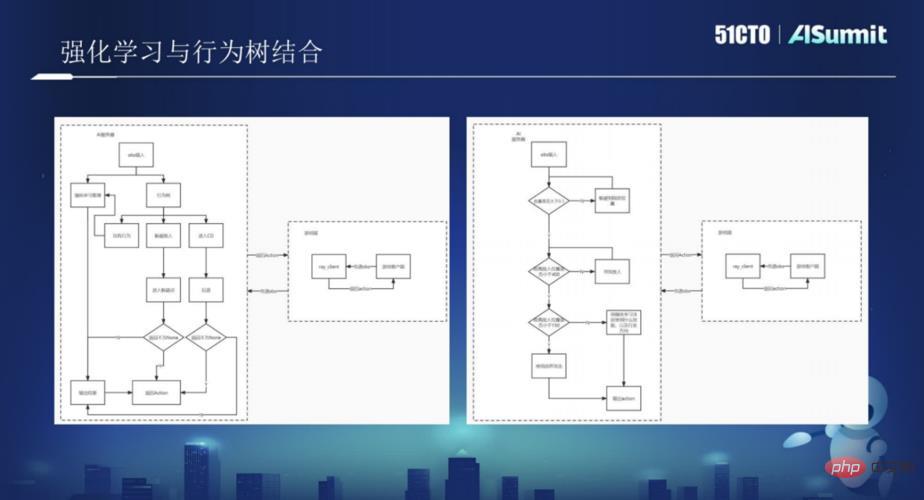

Es ist nicht schwer herauszufinden, dass es eine bessere Lösung ist, wenn Verstärkungslernen und Verhaltensbäume kombiniert und in Spielen verwendet werden. Huang Hongbo sagte, dass es zwei relativ große Implementierungsmethoden für die Kombination von Verstärkungslernen und Verhaltensbäumen gibt: Eine basiert auf Verstärkungslernen und wird durch Verhaltensbäume ergänzt. Die andere basiert auf Verhaltensbäumen und wird durch Verstärkungslernen ergänzt.

Verhaltensbaumseite: Mit dem Verhaltensbaum als Haupt-KI-Bewegungsmethode empfängt der Verhaltensbaum Obs-Eingaben vom Spielclient und schreibt entsprechende Verhaltensbaumverhaltensweisen für Obs entsprechend seiner eigenen Zielsituation in jedem Verhalten des Verhaltensbaums , einige Knoten, die Verstärkungslernen erfordern, um Entscheidungen zu treffen, werden an Verstärkungslernen übergeben. Dann ist hier Verstärkungslernen erforderlich, um entsprechendes Training für einige spezifische Szenarien durchzuführen.

Verstärkungslernseite: Die Gesamtstrategie besteht darin, mehrere Modelle zu trainieren, jedes Modell führt eine Strategie aus und bettet sie dann in den Verhaltensbaum ein.

Huang Hongbo sagte, dass von diesen beiden verschiedenen Implementierungsmethoden, welche besser ist, unterschiedliche Überlegungen basierend auf unterschiedlichen Situationen, unterschiedlichen Anwendungen und unterschiedlichen Spielen erforderlich sind, sodass dies nicht verallgemeinert werden kann.

Im Folgenden stellte Huang Hongbo das von Xishanju übernommene technische Framework für Verstärkungslernen und Verhaltensbäume detailliert vor und stellte in Kombination mit einer großen Anzahl von Spielfällen detailliert vor, wie Verhaltensbäume und Verstärkungslernen verwendet werden Spiele. Kombinieren Sie sie, um das Spiel reicher zu machen. Benutzer, die sich für die Fallpraxis interessieren, sollten sich vielleicht die wunderbaren Sharing-Videos der AISummit Global Artificial Intelligence Technology Conference ansehen. (https://www.php.cn/link/53253027fef2ab5162a602f2acfed431)

Das obige ist der detaillierte Inhalt vonXishanju-KI-Technikexperte Huang Hongbo: Praktische Integration von Verstärkungslernen und Verhaltensbäumen in Spielen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim verstärkenden Lernen

Oct 09, 2023 am 11:58 AM

Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning Einführung Reinforcement Learning ist eine Methode, die optimale Strategien durch die Interaktion zwischen einem Agenten und der Umgebung lernt. Beim verstärkenden Lernen ist die Gestaltung der Belohnungsfunktion entscheidend für den Lerneffekt des Agenten. In diesem Artikel werden Probleme beim Design von Belohnungsfunktionen beim Reinforcement Learning untersucht und spezifische Codebeispiele bereitgestellt. Die Rolle der Belohnungsfunktion und der Zielbelohnungsfunktion sind ein wichtiger Teil des Verstärkungslernens und werden zur Bewertung des Belohnungswerts verwendet, den der Agent in einem bestimmten Zustand erhält. Sein Design hilft dem Agenten dabei, die langfristige Ermüdung durch die Auswahl optimaler Maßnahmen zu maximieren.

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Deep-Reinforcement-Learning-Technologie in C++

Aug 21, 2023 pm 11:33 PM

Die Deep-Reinforcement-Learning-Technologie ist ein Zweig der künstlichen Intelligenz, der viel Aufmerksamkeit erregt hat. Sie hat mehrere internationale Wettbewerbe gewonnen und wird auch häufig in persönlichen Assistenten, autonomem Fahren, Spielintelligenz und anderen Bereichen eingesetzt. Bei der Umsetzung von Deep Reinforcement Learning ist C++ als effiziente und hervorragende Programmiersprache besonders wichtig, wenn die Hardwareressourcen begrenzt sind. Deep Reinforcement Learning kombiniert, wie der Name schon sagt, Technologien aus den beiden Bereichen Deep Learning und Reinforcement Learning. Um es einfach zu verstehen: Deep Learning bezieht sich auf das Lernen von Funktionen aus Daten und das Treffen von Entscheidungen durch den Aufbau eines mehrschichtigen neuronalen Netzwerks.

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Tiefgreifendes Q-Learning-Verstärkungslernen mit der Roboterarmsimulation von Panda-Gym

Oct 31, 2023 pm 05:57 PM

Reinforcement Learning (RL) ist eine Methode des maschinellen Lernens, die es einem Agenten ermöglicht, durch Versuch und Irrtum zu lernen, wie er sich in seiner Umgebung verhält. Agenten werden dafür belohnt oder bestraft, dass sie Maßnahmen ergreifen, die zu den gewünschten Ergebnissen führen. Im Laufe der Zeit lernt der Agent, Maßnahmen zu ergreifen, die seine erwartete Belohnung maximieren. RL-Agenten werden normalerweise mithilfe eines Markov-Entscheidungsprozesses (MDP) trainiert, einem mathematischen Rahmen zur Modellierung sequentieller Entscheidungsprobleme. MDP besteht aus vier Teilen: Zustand: eine Reihe möglicher Zustände der Umgebung. Aktion: Eine Reihe von Aktionen, die ein Agent ausführen kann. Übergangsfunktion: Eine Funktion, die die Wahrscheinlichkeit des Übergangs in einen neuen Zustand anhand des aktuellen Zustands und der aktuellen Aktion vorhersagt. Belohnungsfunktion: Eine Funktion, die dem Agenten für jede Conversion eine Belohnung zuweist. Das Ziel des Agenten besteht darin, eine Richtlinienfunktion zu erlernen.

Wie kann man die Go-Sprache verwenden, um tiefgreifende Forschung zum verstärkten Lernen durchzuführen?

Jun 10, 2023 pm 02:15 PM

Wie kann man die Go-Sprache verwenden, um tiefgreifende Forschung zum verstärkten Lernen durchzuführen?

Jun 10, 2023 pm 02:15 PM

Deep Reinforcement Learning (DeepReinforcementLearning) ist eine fortschrittliche Technologie, die Deep Learning und Reinforcement Learning kombiniert. Sie wird häufig in der Spracherkennung, Bilderkennung, Verarbeitung natürlicher Sprache und anderen Bereichen eingesetzt. Als schnelle, effiziente und zuverlässige Programmiersprache kann die Go-Sprache bei der tiefgreifenden Forschung zum Reinforcement Learning hilfreich sein. In diesem Artikel wird erläutert, wie Sie mithilfe der Go-Sprache tiefgreifende Forschung zum verstärkten Lernen durchführen können. 1. Installieren Sie die Go-Sprache und die zugehörigen Bibliotheken und beginnen Sie mit der Verwendung der Go-Sprache für tiefgreifendes, verstärkendes Lernen.

Steuerung eines doppelgelenkigen Roboterarms mit dem DDPG-Lernalgorithmus von Actor-Critic

May 12, 2023 pm 09:55 PM

Steuerung eines doppelgelenkigen Roboterarms mit dem DDPG-Lernalgorithmus von Actor-Critic

May 12, 2023 pm 09:55 PM

In diesem Artikel stellen wir das Training intelligenter Agenten zur Steuerung eines zweigelenkigen Roboterarms in der Reacher-Umgebung vor, einem Unity-basierten Simulationsprogramm, das mit dem UnityML-Agents-Toolkit entwickelt wurde. Unser Ziel ist es, die Zielposition mit hoher Genauigkeit zu erreichen, daher können wir hier den hochmodernen DeepDeterministicPolicyGradient (DDPG)-Algorithmus verwenden, der für kontinuierliche Zustands- und Aktionsräume entwickelt wurde. Praxisnahe Anwendungen Roboterarme spielen eine entscheidende Rolle in der Fertigung, in Produktionsanlagen, bei der Erforschung des Weltraums sowie bei Such- und Rettungseinsätzen. Es ist sehr wichtig, den Roboterarm mit hoher Präzision und Flexibilität zu steuern. Durch den Einsatz verstärkender Lerntechniken können diese Robotersysteme in die Lage versetzt werden, ihr Verhalten in Echtzeit zu lernen und anzupassen.

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Apr 12, 2023 pm 06:58 PM

Eine weitere Revolution im Reinforcement Learning! DeepMind schlägt eine „Algorithmus-Destillation' vor: einen erforschbaren, vorab trainierten Reinforcement-Learning-Transformer

Apr 12, 2023 pm 06:58 PM

Bei aktuellen Sequenzmodellierungsaufgaben kann Transformer als die leistungsstärkste neuronale Netzwerkarchitektur bezeichnet werden, und das vorab trainierte Transformer-Modell kann Eingabeaufforderungen als Bedingungen oder In-Context-Lernen verwenden, um sich an verschiedene nachgelagerte Aufgaben anzupassen. Die Generalisierungsfähigkeit groß angelegter vorab trainierter Transformer-Modelle wurde in mehreren Bereichen überprüft, z. B. Textvervollständigung, Sprachverständnis, Bilderzeugung usw. Seit letztem Jahr gibt es relevante Arbeiten, die belegen, dass das Modell durch die Behandlung von Offline-Reinforcement-Learning (Offline-RL) als Sequenzvorhersageproblem Richtlinien aus Offline-Daten lernen kann. Aber aktuelle Ansätze lernen Richtlinien entweder aus Daten, die kein Lernen enthalten

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

May 07, 2023 pm 06:31 PM

Wie kann man Reinforcement Learning nutzen, um die Benutzerbindung von Kuaishou zu verbessern?

May 07, 2023 pm 06:31 PM

Das Hauptziel des Kurzvideo-Empfehlungssystems besteht darin, das DAU-Wachstum durch eine verbesserte Benutzerbindung voranzutreiben. Daher ist die Kundenbindung einer der wichtigsten Indikatoren für die Geschäftsoptimierung jeder APP. Bei der Aufbewahrung handelt es sich jedoch um eine langfristige Rückmeldung nach mehreren Interaktionen zwischen Benutzern und dem System, und es ist schwierig, sie in ein einzelnes Element oder eine einzelne Liste zu zerlegen. Daher ist es schwierig, die Aufbewahrung mithilfe herkömmlicher Punkt- und Listenfunktionen direkt zu optimieren. weise Modelle. Methoden des Reinforcement Learning (RL) optimieren langfristige Belohnungen durch die Interaktion mit der Umgebung und eignen sich zur direkten Optimierung der Nutzerbindung. Diese Arbeit modelliert das Aufbewahrungsoptimierungsproblem als Markov-Entscheidungsprozess (MDP) mit unendlicher Horizontanforderungsgranularität. Jedes Mal, wenn der Benutzer das Empfehlungssystem auffordert, über eine Aktion zu entscheiden, wird es verwendet, um mehrere verschiedene kurzfristige Feedbackschätzungen (Beobachtungsdauer,

Lernen Sie, eine Leiterplatte in 20 Minuten zusammenzubauen! Das Open-Source-SERL-Framework weist eine Erfolgsquote bei der Präzisionskontrolle von 100 % auf und ist dreimal schneller als Menschen

Feb 21, 2024 pm 03:31 PM

Lernen Sie, eine Leiterplatte in 20 Minuten zusammenzubauen! Das Open-Source-SERL-Framework weist eine Erfolgsquote bei der Präzisionskontrolle von 100 % auf und ist dreimal schneller als Menschen

Feb 21, 2024 pm 03:31 PM

Jetzt können Roboter Präzisionsaufgaben in der Fabriksteuerung erlernen. In den letzten Jahren wurden auf dem Gebiet der Lerntechnologie zur Verstärkung von Robotern erhebliche Fortschritte erzielt, z. B. beim Gehen im Vierfüßlerstand, beim Greifen, bei der geschickten Manipulation usw., die meisten davon beschränken sich jedoch auf die Labordemonstrationsphase. Die umfassende Anwendung der Robotic Reinforcement Learning-Technologie in tatsächlichen Produktionsumgebungen steht noch vor vielen Herausforderungen, was ihren Anwendungsbereich in realen Szenarien bis zu einem gewissen Grad einschränkt. Im Prozess der praktischen Anwendung der Reinforcement-Learning-Technologie ist es notwendig, mehrere komplexe Probleme zu überwinden, darunter die Einstellung des Belohnungsmechanismus, das Zurücksetzen der Umgebung, die Verbesserung der Probeneffizienz und die Gewährleistung der Aktionssicherheit. Branchenexperten betonen, dass die Lösung der vielen Probleme bei der tatsächlichen Implementierung der Reinforcement-Learning-Technologie ebenso wichtig ist wie die kontinuierliche Innovation des Algorithmus selbst. Vor dieser Herausforderung standen Forscher der University of California, Berkeley, der Stanford University, der University of Washington und