Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Durch die Zusammenführung zweier Modelle ohne Hindernisse dauert die lineare Verbindung großer ResNet-Modelle nur Sekunden und inspiriert neue Forschungen zu neuronalen Netzen

Durch die Zusammenführung zweier Modelle ohne Hindernisse dauert die lineare Verbindung großer ResNet-Modelle nur Sekunden und inspiriert neue Forschungen zu neuronalen Netzen

Durch die Zusammenführung zweier Modelle ohne Hindernisse dauert die lineare Verbindung großer ResNet-Modelle nur Sekunden und inspiriert neue Forschungen zu neuronalen Netzen

Deep Learning hat solche Erfolge dank seiner Fähigkeit erzielt, große nichtkonvexe Optimierungsprobleme relativ einfach zu lösen. Obwohl die nicht-konvexe Optimierung NP-schwer ist, haben einige einfache Algorithmen, normalerweise Varianten des stochastischen Gradientenabstiegs (SGD), überraschende Wirksamkeit bei der tatsächlichen Anpassung großer neuronaler Netze gezeigt.

In diesem Artikel schrieben mehrere Wissenschaftler der University of Washington „Git Re-Basin: Merging Models modulo Permutation Symmetries“. Sie untersuchten den SGD-Algorithmus im Deep Learning. Unangemessene Wirksamkeit bei hochdimensionalen nichtkonvexen Optimierungsproblemen. Sie wurden von drei Fragen inspiriert:

1 Warum schneidet SGD bei der Optimierung hochdimensionaler, nicht-konvexer Deep-Learning-Verlustlandschaften gut ab, während in anderen nicht- Konvexe Optimierungseinstellungen. Beispielsweise wird die Robustheit von Richtlinienlern-, Trajektorienoptimierungs- und Empfehlungssystemen erheblich verringert?

2. Warum nimmt der Verlust gleichmäßig und monoton ab, wenn linear zwischen Initialisierungsgewichten und endgültigen Trainingsgewichten interpoliert wird?

3 Warum erzielen zwei unabhängig voneinander trainierte Modelle mit unterschiedlicher Zufallsinitialisierung und Datenstapelreihenfolge nahezu die gleiche Leistung? Warum sehen ihre Trainingsverlustkurven außerdem gleich aus? arxiv.org/pdf/2209.04836.pdf

Warum ist das so? Im Jahr 2019 stellten Brea et al. fest, dass versteckte Einheiten in neuronalen Netzen eine Anordnungssymmetrie aufweisen. Einfach ausgedrückt: Wir können zwei beliebige Einheiten in der verborgenen Schicht des Netzwerks austauschen, und die Netzwerkfunktionalität bleibt dieselbe. Entezari et al. 2021 spekulierten, dass diese Permutationssymmetrien es uns ermöglichen könnten, Punkte im Gewichtsraum linear zu verbinden, ohne Verluste zu beeinträchtigen.

Im Folgenden verwenden wir ein Beispiel von einem der Autoren des Artikels, um den Zweck des Artikels zu veranschaulichen, damit jeder es klarer versteht.

Angenommen, Sie haben ein A-Modell trainiert und Ihr Freund hat ein B-Modell trainiert. Die Trainingsdaten der beiden Modelle können unterschiedlich sein. Es spielt keine Rolle, mit dem in diesem Artikel vorgeschlagenen Git Re-Basin können Sie die beiden Modelle A + B im Gewichtsraum zusammenführen, ohne den Verlust zu beeinträchtigen.

Der Autor des Papiers gab an, dass Git Re-Basin sein kann Auf jedes neuronale Netzwerk (Network, NN) angewendet, demonstrierten sie erstmals eine barrierefreie lineare Konnektivität zwischen zwei unabhängig trainierten (ohne Vortraining) Modellen (ResNets).

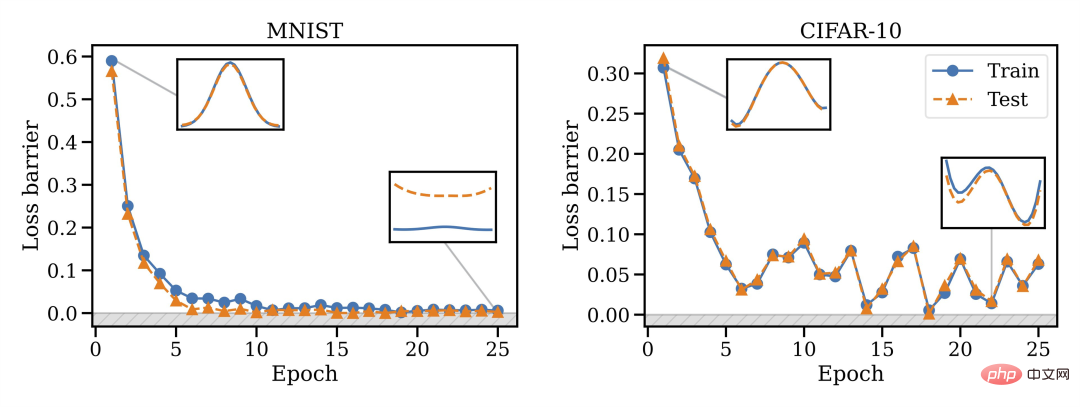

Sie fanden heraus, dass die Zusammenführungsfähigkeit eine Eigenschaft des SGD-Trainings ist. Das Zusammenführen funktioniert nicht bei der Initialisierung, es treten jedoch Phasenänderungen auf, sodass das Zusammenführen mit der Zeit möglich wird. Sie fanden auch heraus, dass die Modellbreite eng mit der Zusammenführungsfähigkeit zusammenhängt, d. h. je breiter, desto besser.

Sie fanden heraus, dass die Zusammenführungsfähigkeit eine Eigenschaft des SGD-Trainings ist. Das Zusammenführen funktioniert nicht bei der Initialisierung, es treten jedoch Phasenänderungen auf, sodass das Zusammenführen mit der Zeit möglich wird. Sie fanden auch heraus, dass die Modellbreite eng mit der Zusammenführungsfähigkeit zusammenhängt, d. h. je breiter, desto besser.

Außerdem können nicht alle Architekturen zusammengeführt werden: VGG scheint es zu sein besser als ResNets Schwieriger zusammenzuführen.

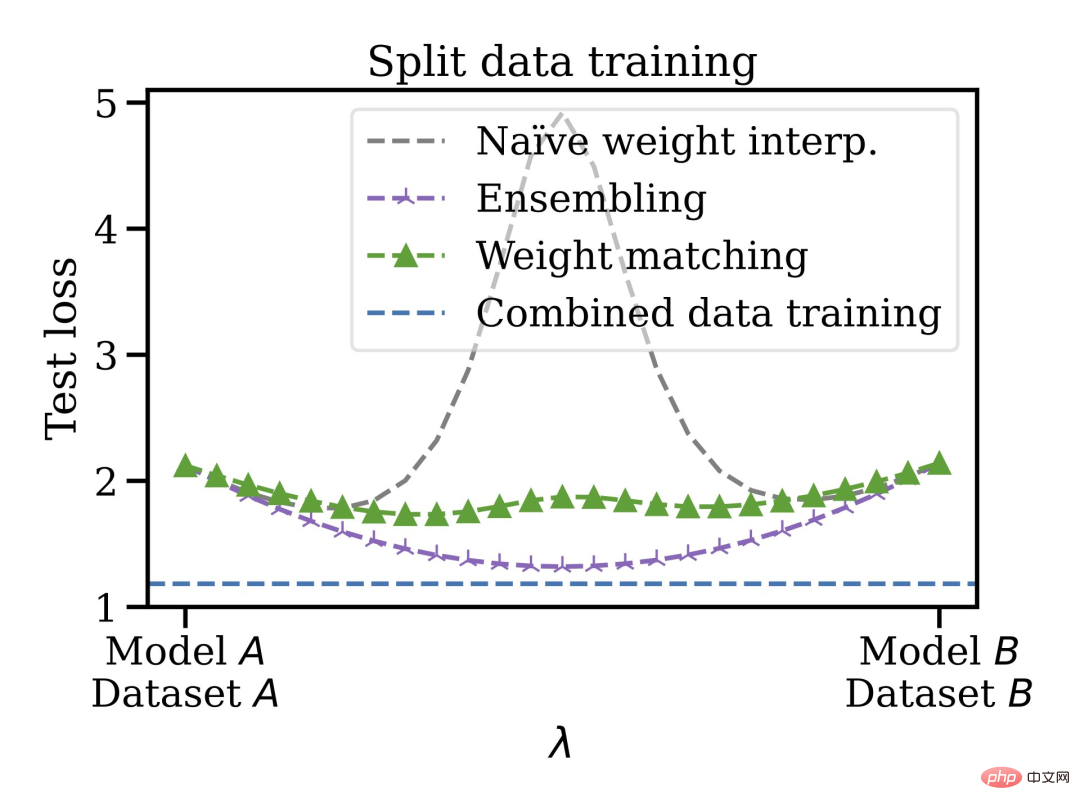

Diese Zusammenführungsmethode hat weitere Vorteile: Sie können das Modell auf disjunkten und voreingenommenen Datensätzen trainieren und diese dann im Gewichtsraum zusammenführen. Beispielsweise liegen einige Daten in den USA und andere in der EU vor. Aus irgendeinem Grund können die Daten nicht gemischt werden. Sie können zunächst separate Modelle trainieren, dann die Gewichte zusammenführen und schließlich auf den zusammengeführten Datensatz verallgemeinern.

Daher können trainierte Modelle gemischt werden, ohne dass eine Vorschulung oder Feinabstimmung erforderlich ist. Der Autor äußerte, dass er daran interessiert sei, die zukünftige Entwicklungsrichtung der linearen Modusverbindung und des Modell-Patches zu kennen, die auf Bereiche wie föderiertes Lernen, verteiltes Training und Deep-Learning-Optimierung angewendet werden könnten.

Abschließend wird auch erwähnt, dass die Ausführung des Gewichtsanpassungsalgorithmus in Kapitel 3.2 nur etwa 10 Sekunden dauert, was viel Zeit spart. In Kapitel 3 des Papiers werden außerdem drei Methoden zum Anpassen von Modell-A- und Modell-B-Einheiten vorgestellt. Freunde, die sich über den Matching-Algorithmus nicht im Klaren sind, können das Originalpapier überprüfen.

Netizen-Kommentare und Fragen des Autors

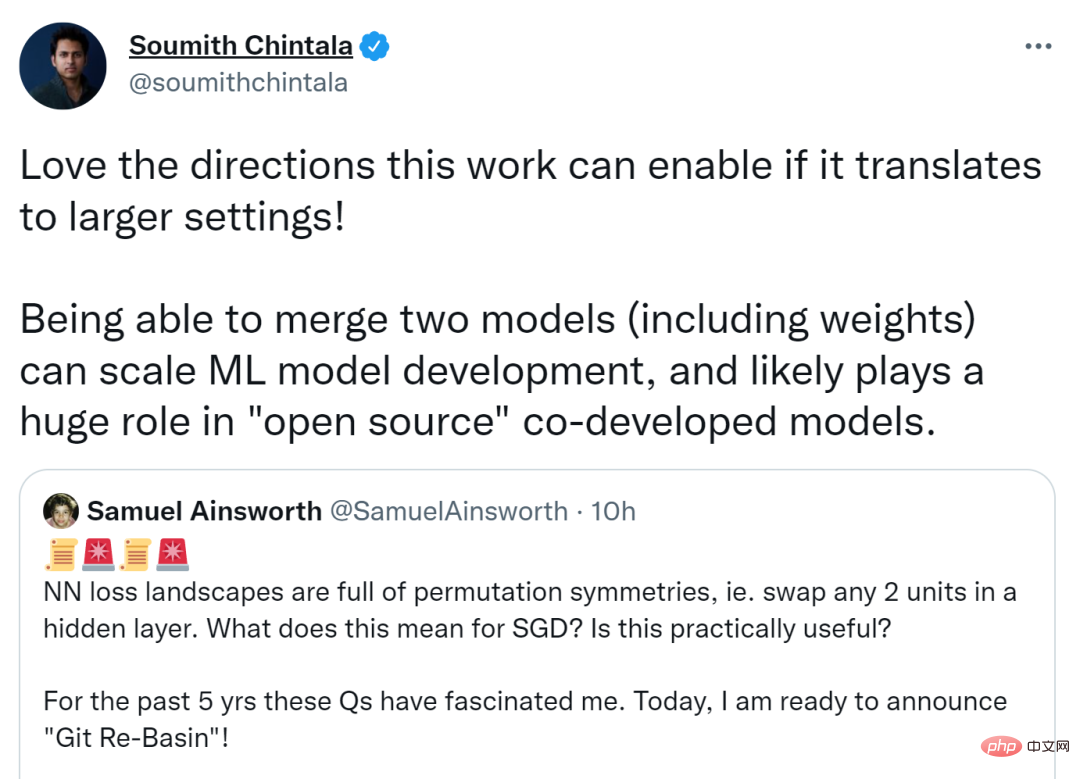

Dieses Papier löste eine hitzige Diskussion auf Twitter aus, sagte Soumith Chintala, Mitbegründer von PyTorch, wenn Je mehr Forschung auf einen größeren Kontext übertragen werden kann, desto besser kann die Richtung sein, in die sie gehen kann. Das Zusammenführen zweier Modelle (einschließlich Gewichtungen) kann die ML-Modellentwicklung erweitern und möglicherweise eine große Rolle bei der gemeinsamen Entwicklung von Modellen unter Open Source spielen.

Andere glauben, dass, wenn Permutationsinvarianz die meisten Äquivalenzen so effizient erfassen kann, neuronale theoretische Forschung zu Netzwerken bereitgestellt wird Inspiration.

Samuel Ainsworth, der Erstautor des Artikels und ebenfalls Ph.D beantwortete einige von Internetnutzern gestellte Fragen.

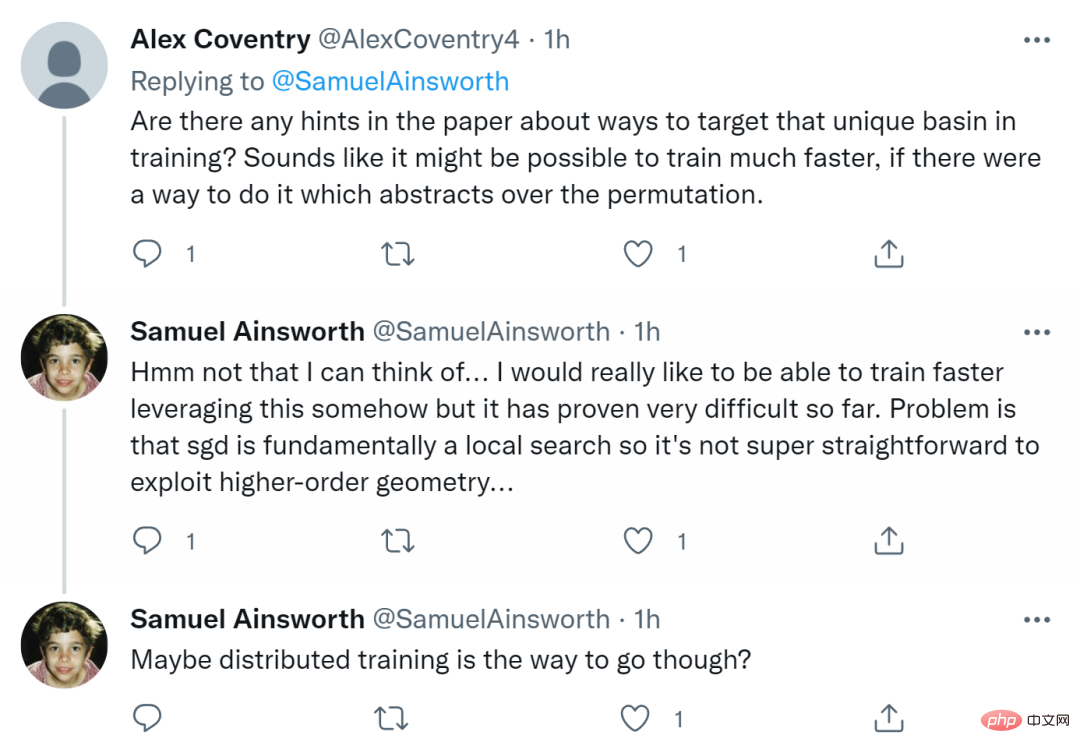

Zuerst fragte jemand: „Gibt es in dem Artikel irgendwelche Tipps zum Anvisieren einzigartiger Becken im Training? Wenn es eine Möglichkeit gibt, die Permutation zu abstrahieren, dann ist Training The Geschwindigkeit kann schneller sein. Er hofft wirklich, irgendwie schneller trainieren zu können, aber bisher hat es sich als sehr schwierig erwiesen. Das Problem besteht darin, dass SGD im Wesentlichen eine lokale Suche ist und es daher nicht so einfach ist, Geometrie höherer Ordnung auszunutzen. Vielleicht ist verteiltes Training der richtige Weg.

Einige Leute fragen auch, ob es auf RNN und Transformers anwendbar ist? Ainsworth sagt, dass es im Prinzip funktioniert, aber er hat noch nicht damit experimentiert. Die Zeit wird es zeigen.

Einige Leute fragen auch, ob es auf RNN und Transformers anwendbar ist? Ainsworth sagt, dass es im Prinzip funktioniert, aber er hat noch nicht damit experimentiert. Die Zeit wird es zeigen.

Schließlich schlug jemand vor: „Das sieht gut aus für verteiltes Training.“ „Ist es sehr wichtig, dass es wahr wird? Verwendet DDPM (Denoising Diffusion Probability Model) nicht ResNet-Restblöcke, aber es wäre sehr aufregend, es für verteiltes Training zu verwenden?“

Schließlich schlug jemand vor: „Das sieht gut aus für verteiltes Training.“ „Ist es sehr wichtig, dass es wahr wird? Verwendet DDPM (Denoising Diffusion Probability Model) nicht ResNet-Restblöcke, aber es wäre sehr aufregend, es für verteiltes Training zu verwenden?“

Das obige ist der detaillierte Inhalt vonDurch die Zusammenführung zweier Modelle ohne Hindernisse dauert die lineare Verbindung großer ResNet-Modelle nur Sekunden und inspiriert neue Forschungen zu neuronalen Netzen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Web3 Trading Platform Ranking_Web3 Globale Top Ten Summary Top Ten Summary

Apr 21, 2025 am 10:45 AM

Binance ist der Overlord des Global Digital Asset Trading -Ökosystems, und seine Merkmale umfassen: 1. Das durchschnittliche tägliche Handelsvolumen übersteigt 150 Milliarden US -Dollar, unterstützt 500 Handelspaare, die 98% der Mainstream -Währungen abdecken. 2. Die Innovationsmatrix deckt den Markt für Derivate, das Web3 -Layout und den Bildungssystem ab; 3. Die technischen Vorteile sind Millisekunden -Matching -Engines mit Spitzenvolumina von 1,4 Millionen Transaktionen pro Sekunde. 4. Compliance Progress hält 15 Länderlizenzen und legt konforme Einheiten in Europa und den Vereinigten Staaten ein.

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) Preisprognose 2025-2031: Wird WLD bis 2031 $ erreichen?

Apr 21, 2025 pm 02:42 PM

Worldcoin (WLD) fällt auf dem Kryptowährungsmarkt mit seinen einzigartigen biometrischen Überprüfungs- und Datenschutzschutzmechanismen auf, die die Aufmerksamkeit vieler Investoren auf sich ziehen. WLD hat mit seinen innovativen Technologien, insbesondere in Kombination mit OpenAI -Technologie für künstliche Intelligenz, außerdem unter Altcoins gespielt. Aber wie werden sich die digitalen Vermögenswerte in den nächsten Jahren verhalten? Lassen Sie uns den zukünftigen Preis von WLD zusammen vorhersagen. Die Preisprognose von 2025 WLD wird voraussichtlich im Jahr 2025 ein signifikantes Wachstum in WLD erzielen. Die Marktanalyse zeigt, dass der durchschnittliche WLD -Preis 1,31 USD mit maximal 1,36 USD erreichen kann. In einem Bärenmarkt kann der Preis jedoch auf rund 0,55 US -Dollar fallen. Diese Wachstumserwartung ist hauptsächlich auf Worldcoin2 zurückzuführen.

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Was bedeutet Cross-Chain-Transaktion? Was sind die Cross-Chain-Transaktionen?

Apr 21, 2025 pm 11:39 PM

Börsen, die Cross-Chain-Transaktionen unterstützen: 1. Binance, 2. Uniswap, 3. Sushiswap, 4. Kurvenfinanzierung, 5. Thorchain, 6. 1inch Exchange, 7. DLN-Handel, diese Plattformen unterstützen Multi-Chain-Asset-Transaktionen durch verschiedene Technologien.

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Warum ist der Anstieg oder Abfall der virtuellen Währungspreise? Warum ist der Anstieg oder Abfall der virtuellen Währungspreise?

Apr 21, 2025 am 08:57 AM

Faktoren der steigenden Preise für virtuelle Währung sind: 1. Erhöhte Marktnachfrage, 2. Verringertes Angebot, 3.. Rückgangsfaktoren umfassen: 1. Verringerte Marktnachfrage, 2. Erhöhtes Angebot, 3. Streik der negativen Nachrichten, 4. Pessimistische Marktstimmung, 5. makroökonomisches Umfeld.

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

So gewinnen Sie Kernel Airdrop -Belohnungen für Binance vollständige Prozessstrategie

Apr 21, 2025 pm 01:03 PM

In der geschäftigen Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Gegenwärtig zieht Kerneldao (Kernel) Airdrop -Aktivität viel Aufmerksamkeit auf sich und zieht die Aufmerksamkeit vieler Investoren auf sich. Also, was ist der Ursprung dieses Projekts? Welche Vorteile können BNB -Inhaber davon bekommen? Machen Sie sich keine Sorgen, das Folgende wird es einzeln für Sie enthüllen.

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist eine Empfehlung, das Aave -Protokoll -Token zu ändern und Token -Rückkauf einzuführen, die die Quorum -Anzahl von Personen erreicht hat.

Apr 21, 2025 pm 06:24 PM

Aavenomics ist ein Vorschlag zur Änderung des Aave -Protokoll -Tokens und zur Einführung von Token -Repos, die ein Quorum für Aavedao implementiert hat. Marc Zeller, Gründer der AAVE -Projektkette (ACI), kündigte dies auf X an und stellte fest, dass sie eine neue Ära für die Vereinbarung markiert. Marc Zeller, Gründer der Aave Chain Initiative (ACI), kündigte auf X an, dass der Aavenomics -Vorschlag das Modifizieren des Aave -Protokoll -Tokens und die Einführung von Token -Repos umfasst, hat ein Quorum für Aavedao erreicht. Laut Zeller ist dies eine neue Ära für die Vereinbarung. AVEDAO -Mitglieder stimmten überwiegend für die Unterstützung des Vorschlags, der am Mittwoch 100 pro Woche betrug

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Rangliste der Hebelbörsen im Währungskreis Die neuesten Empfehlungen der zehn meistgezogenen Börsen im Währungskreis

Apr 21, 2025 pm 11:24 PM

Die Plattformen, die im Jahr 2025 im Leveraged Trading, Security und Benutzererfahrung hervorragende Leistung haben, sind: 1. OKX, geeignet für Hochfrequenzhändler und bieten bis zu 100-fache Hebelwirkung; 2. Binance, geeignet für Mehrwährungshändler auf der ganzen Welt und bietet 125-mal hohe Hebelwirkung; 3. Gate.io, geeignet für professionelle Derivate Spieler, die 100 -fache Hebelwirkung bietet; 4. Bitget, geeignet für Anfänger und Sozialhändler, die bis zu 100 -fache Hebelwirkung bieten; 5. Kraken, geeignet für stetige Anleger, die fünfmal Hebelwirkung liefert; 6. Bybit, geeignet für Altcoin -Entdecker, die 20 -fache Hebelwirkung bietet; 7. Kucoin, geeignet für kostengünstige Händler, die 10-fache Hebelwirkung bietet; 8. Bitfinex, geeignet für das Seniorenspiel

Einen Artikel verstehen: Binance Kernel Airdrop -Prozess

Apr 21, 2025 pm 01:09 PM

Einen Artikel verstehen: Binance Kernel Airdrop -Prozess

Apr 21, 2025 pm 01:09 PM

In der Welt der Kryptowährungen entstehen immer neue Möglichkeiten. Kürzlich hat das von Binance ins Leben gerufene Kerneldao -Megadrop -Projekt (Kernel) weit verbreitete Aufmerksamkeit erregt. Dieses Projekt bietet Anlegern nicht nur neue Anlagemöglichkeiten, sondern bietet BNB -Inhabern auch einzigartige Vorteile. Also, was genau ist Kerneldao? Wie wird dieser Flugdropfen durchgeführt? Lassen Sie es uns in einem Artikel verstehen.