Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Neueste PNAS-Forschung: 81 % Problemlösungsrate, neuronales Netzwerk Codex öffnet die Tür zur Welt der fortgeschrittenen Mathematik

Neueste PNAS-Forschung: 81 % Problemlösungsrate, neuronales Netzwerk Codex öffnet die Tür zur Welt der fortgeschrittenen Mathematik

Neueste PNAS-Forschung: 81 % Problemlösungsrate, neuronales Netzwerk Codex öffnet die Tür zur Welt der fortgeschrittenen Mathematik

Kürzlich wurde in PNAS eine neue Studie veröffentlicht, die die Fähigkeiten neuronaler Netze noch einmal auffrischt. Dieses Mal wurde das neuronale Netzwerk verwendet, um fortgeschrittene Mathematikprobleme zu lösen, und es handelte sich um schwierige Mathematikprobleme im MIT-Mathematikkurs!

In dieser neuen Studie hat das Forschungsteam bewiesen, dass das Codex-Modell von OpenAI eine Programmsynthese zur Lösung großer mathematischer Probleme durchführen und 81 % der Mathematikkursprobleme im Datensatz durch Lernen kleiner Stichproben und Codex automatisch lösen kann Die Leistung bei diesen Aufgaben erreicht menschliches Niveau.

... zum Thema. Das Forschungsteam wies darauf hin, dass der Grund, warum Codex solche Fähigkeiten erreichen kann, gerade darin liegt, dass das Team eine große Innovation vorgenommen hat. Diese erfolglosen Studien verwendeten in der Vergangenheit nur textbasiertes Vortraining, das diesmal erschienene neuronale Codex-Netzwerk jedoch nicht Nur das Vortraining basiert auf Text und der Code wird ebenfalls verfeinert.

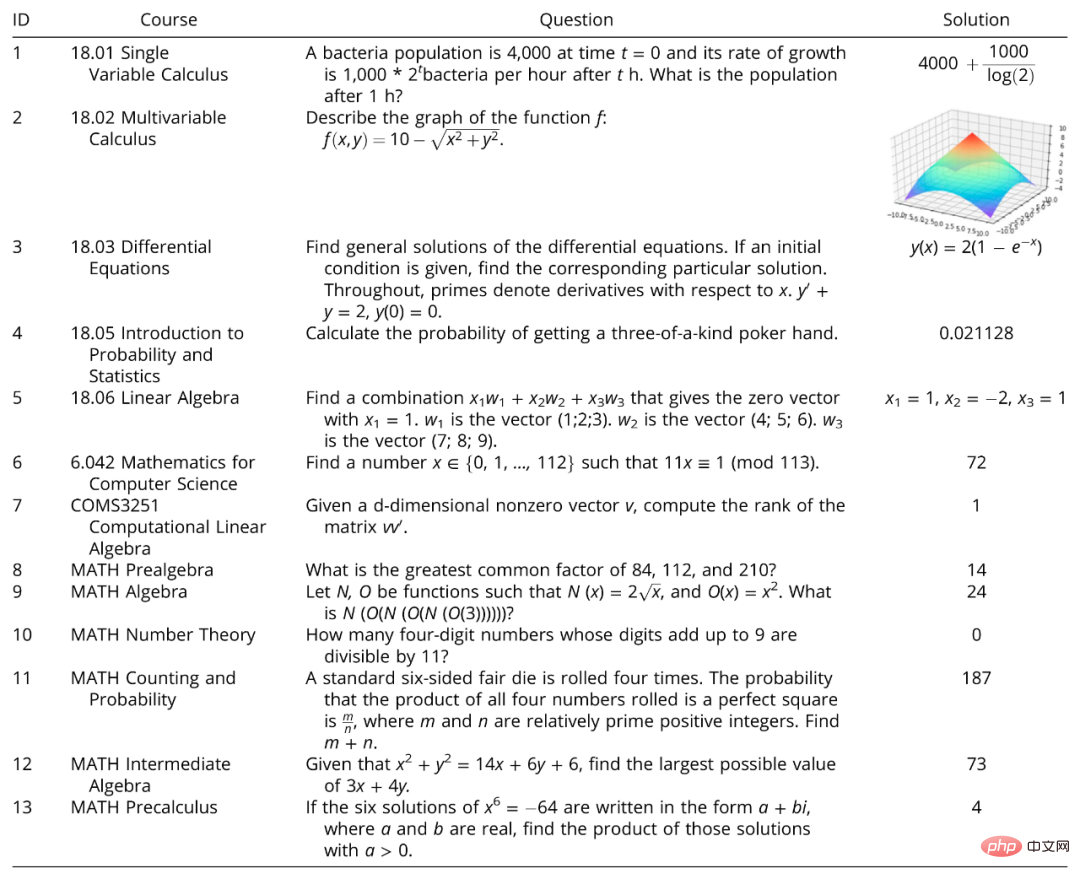

Der untersuchte Problemdatensatz wurde aus sechs Mathematikkursen am MIT und einem Mathematikkurs an der Columbia University ausgewählt. 25 Probleme wurden zufällig aus sieben Kursen ausgewählt: Einzelvariablenrechnung, Multivariablenrechnung, Differentialrechnungen, Einführung in die Wahrscheinlichkeit und Statistik, lineare Algebra und Mathematik für Informatik und COMS3251 Computational Linear Algebra von der Columbia University.

Gleichzeitig verwendete das Forschungsteam MATH, einen neuesten Benchmark für fortgeschrittene Mathematikprobleme, der zur Bewertung des mathematischen Denkens verwendet wird, um die Fähigkeit des OpenAI-Codex zu testen. MATH deckt sechs Hauptbereiche der Mathematik ab: Elementaralgebra, Algebra, Zählen und Wahrscheinlichkeit und Mittelstufe Es gibt jeweils 15 Aufgaben aus den Bereichen Algebra, Zahlentheorie und Vorkalkulation.

Bildunterschrift: In der Studie verwendeter Kursfragendatensatz und MATH-Benchmark

Die Studie zeigte, dass Codex 213 der 265 Fragen im Fragendatensatz und im MATH-Datensatz automatisch gelöst hat.

1 Wo ist die Innovation

Nach der Veröffentlichung von Transformer haben Transformer-basierte Sprachmodelle große Erfolge bei verschiedenen NLP-Aufgaben (Natural Language Processing) erzielt, einschließlich Zero-Shot- und Fence-Shot-Sprachaufgaben. Da Transformer jedoch nur auf Text vortrainiert ist, sind diese Modelle grundsätzlich nicht in der Lage, mathematische Probleme zu lösen. GPT-3 ist ein typisches Beispiel.Später wurden die mathematischen Denkfähigkeiten von GPT-3 durch Fow-Shot-Lernen und CoT-Eingabeaufforderungen verbessert; auch ohne Code ist GPT-3 jedoch besser immer noch machtlos bei mathematischen Problemen auf College-Niveau und dem MATH-Benchmark.

Frühere Forschungen zur Lösung mathematischer Probleme haben möglicherweise bestimmte Ergebnisse auf einem relativ einfachen mathematischen Niveau erzielt. Beispielsweise können Techniken, die Ausdrucksbäume auf der Grundlage kollaborativer Trainingsergebnisse validieren oder vorhersagen, wie MAWPS und Math23k, mathematische Probleme auf Grundschulniveau mit einer Genauigkeit von über 81 % lösen, aber sie können Mathematikprobleme auf Oberstufen-, Olympiade- oder College-Niveau nicht lösen Mathe-Aufgaben. Co-Training in Kombination mit graphischen neuronalen Netzen (GNN) zur Vorhersage arithmetischer Ausdrucksbäume ermöglicht die Lösung universitärer Probleme im maschinellen Lernen mit einer Genauigkeit von bis zu 95 %. Aber auch diese Arbeit beschränkte sich auf numerische Antworten, führte zu einer Überanpassung und konnte nicht auf andere Kurse übertragen werden.

Eine der größten Neuerungen dieser Arbeit

besteht darin, dass nicht nur das Transformer-Modell wie Codex vorab auf Text trainiert, sondern auch auf den Code abgestimmt wurde, sodass es groß angelegte mathematische Lösungen generieren kann Problemprogramm.

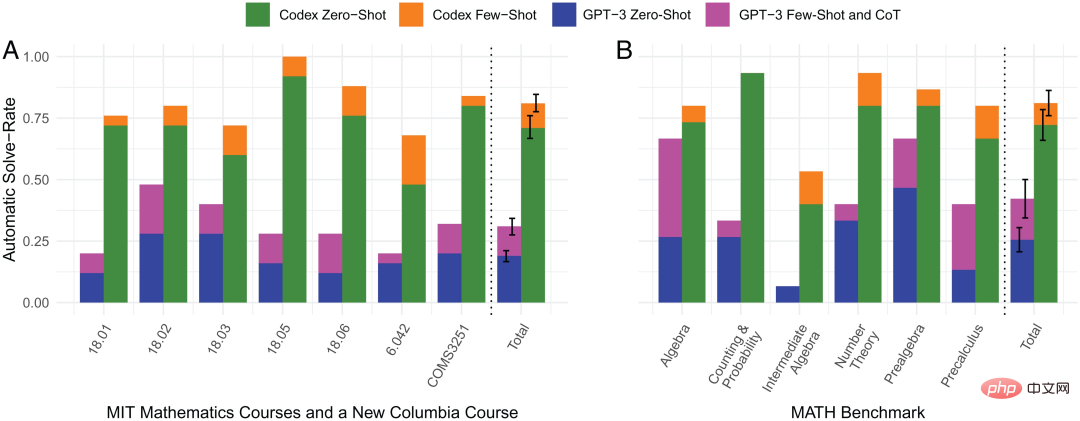

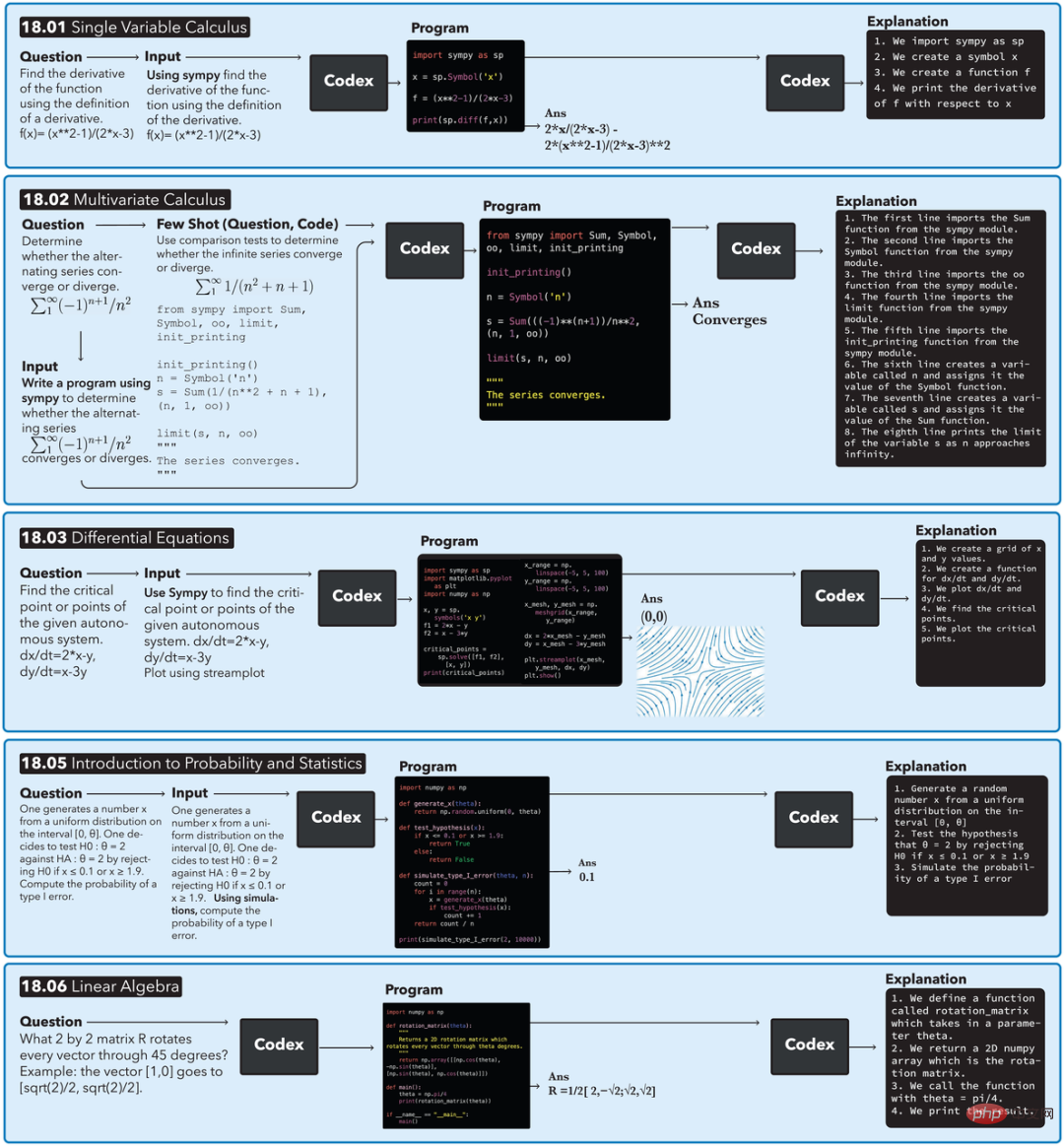

Das Forschungsteam wählte nach dem Zufallsprinzip Frageproben aus dem Datensatz aus, für deren Tests keine Eingabebilder oder Beweise erforderlich waren. Unter ihnen löste ein nur auf Text vorab trainiertes Sprachmodell (GPT-3 text-davinci-002) automatisch nur 18 % der Kursprobleme und 25,5 % der MATH-Benchmark-Probleme. Im Gegensatz dazu kann ein Programm, das mithilfe von Zero-Shot-Learning und einem neuronalen Netzwerk, das auf Text vortrainiert und auf Code abgestimmt wurde (OpenAI Codex code-davinci-002), synthetisiert wurde, 71 % der Kursprobleme und 72,2 % der Probleme automatisch lösen MATH-Benchmark-Fragen. Mit dem gleichen neuronalen Netzwerk Codex und dem Lernen mit wenigen Schüssen können 81 % der Probleme im Kurs und 81,1 % der Probleme im MATH-Benchmark-Test automatisch gelöst werden. Allerdings wurden 19 % der Kursfragen und 18,9 % der MATH-Benchmark-Fragen, die die übrigen Modelle nicht automatisch lösen konnten, letztendlich durch manuelle Eingabeaufforderungen gelöst. Die Hinzufügung der Lernmethode für kleine Stichproben ist die zweite große Innovation dieser Forschung. Wie aus der obigen Abbildung ersichtlich ist, wird, wenn Zero-Shot-Lernen die Frage nicht beantworten kann, ein (Frage-, Code-)Paar (Paar) verwendet, um Small-Shot-Lernen durchzuführen: 1) Unter Verwendung der Textähnlichkeit von OpenAI- babbage-001 Einbettungs-Engine bettet alle Fragen ein; 2) Berechnen Sie die ähnlichsten gelösten Fragen aus ihren Kursen mithilfe der eingebetteten Kosinusähnlichkeit; 3) Kombinieren Sie die ähnlichsten Fragen mit ihren entsprechenden Codes Beispiel für ein kleines Beispielproblem. Bildhinweis: Vergleich der automatischen Problemlösungsraten in 4 Methoden Shot-Learning. Vergleich der automatischen Problemlösungsraten zwischen 4 Methoden. Aus der Abbildung ist ersichtlich, dass der durch den orangefarbenen Balken dargestellte kleine Beispiel-Lerncodex eine hervorragende Leistung bei der automatischen Problemlösungsrate aufweist und in praktisch jedem mathematischen Bereich stärker ist als die der anderen drei Methoden. besteht darin, eine Pipeline zur Lösung mathematischer Probleme bereitzustellen und zu erklären, warum die Lösung so ist. Die folgende Abbildung zeigt den Ausführungsfluss der Pipeline in den 5 Mathematikkursen des MIT. Am Beispiel des Einzelvariablenkalkülproblems 18.01 wird Codex bei einem gegebenen Problem und dem automatisch generierten Präfix „SymPy verwenden“ aufgefordert und gibt ein Programm aus. Beim Ausführen des Programms wird eine Gleichung mit der richtigen Antwort erstellt. Das Programm fordert dann automatisch erneut zur Eingabe des Codex auf, was zu einer generierten Codeerklärung führt. 2 Nach dem Lösen von Problemen Um das Niveau der generierten Fragen zu bewerten, führte das Team eine Umfrage unter MIT-Studenten durch, die an diesen Kursen oder Kursen auf demselben Niveau teilgenommen hatten, hauptsächlich um die Qualität und den Schwierigkeitsgrad maschinell generierter und manuell geschriebener Fragen zu vergleichen Fragen. 1) Glauben Sie, dass diese Frage von Menschen geschrieben oder maschinell erstellt wurde? 2) Halten Sie diese Frage für einen bestimmten Kurs für angemessen oder unangemessen? 3) Wie würden Sie den Schwierigkeitsgrad dieser Frage auf einer Skala von 1 (am einfachsten) und 5 (am schwierigsten) einstufen? In den zurückgesendeten Fragebögen sind die Ergebnisse der Schülerbefragung wie folgt zusammengefasst: Die maschinell generierten Fragen haben es den Schülern erschwert, sie zu unterscheiden, was darauf hindeutet, dass Codex bei der Generierung neuer Inhalte das menschliche Leistungsniveau erreicht hat. Das Modell hat jedoch auch Probleme, die nicht gelöst werden können, z. B. wenn die Frage in einem Bild oder einer anderen nicht-textuellen Form erscheint, kann sie nicht mit a beantwortet werden Die Lösung muss bewiesen werden. Dieses Modell kann auch keine Programmprobleme oder rechentechnisch schwierigen Probleme wie die Faktorisierung sehr großer Primzahlen lösen. Diese letzte Art von Fragen sollte jedoch in keinem Mathematikkurs auftauchen, da selbst echte Studierende sie nicht beantworten können.  Die

Die

In jedem der 6 Kurse des MIT werden 5 handgeschriebene Fragen und 5 modellgenerierte Fragen gemischt und zufällig präsentiert. Für jede der 60 Fragen wurden die teilnehmenden Schüler gebeten, drei Umfragefragen zu beantworten:

Das obige ist der detaillierte Inhalt vonNeueste PNAS-Forschung: 81 % Problemlösungsrate, neuronales Netzwerk Codex öffnet die Tür zur Welt der fortgeschrittenen Mathematik. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1384

1384

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.